基于自注意力机制GAN网络的无参考图像质量评价方法与流程

attention机制,使得生成网络协调好每一个位置的局部细节和远端细节,判别网络能更准确地学习到全局图像结构的几何约束,在生成式对抗网络模型中引入self-attention机制,让生成器和判别器可以自动学习图像中的重要目标,使得网络在每一层都能考虑全局信息,且能够很好地处理图像中长范围、多层次的依赖,在提高感受野和减小参数量之间得到了一个更好的平衡;由于人眼视觉感知系统会把目光聚集在图像的重要patch上,综合考虑图像的局部性和整体性是图像生成的关键,因此我们采用自我注意力生成对抗性网络思想来稳定对抗训练;

[0010]

s2、提出的模型和学习:

[0011]

s2.1、建立模型框架:框架由三个部分组成:图像感知生成网络gn、图像生成判别网络dn和质量评价网络en;图像感知生成网络产生的幻觉参考图像作为失真图像的补偿信息,它们以对抗的方式训练判别网络dn,以帮助生成网络gn产生更合格的结果,并将不良结果的负面影响进行限制;另外,将self-attention机制引入了生成式对抗网络模型的图像生成当中,提升生成式对抗网络模型生成更高分辨率的图片;首先对不重叠的补丁(patch)进行采样,然后对于每一个图像感知生成网络gn将其作为输入,尝试将gx还原为对应的无畸变原始图像,图像生成判别网络dn将恢复后的d(gx)与原始图像进行区分;

[0012]

s2.2、增添自注意力模块:图像隐含层的特征x∈r

c*n

分别映射到两个特征空间f,g,计算注意力;其中:

[0013]

f(x)=w

f

x,g(x)=w

g

x

[0014][0015]

where

[0016]

sij=f(x

i

)

t

g(x

j

)

[0017]

权重β

j,i

表示模型在合成j区域的时候对i区域的关注程度;其中,c是通道的数量,n是上一步隐藏层特征所处的特征位置的数量;注意层的输出为

[0018]

o=(01,02,...,0

j

,...,0

n

)∈r

c*n

[0019]

其中:

[0020][0021]

where

[0022]

h(x

i

)=w

h

x

i

[0023]

在上式中,权重w

f

,w

g

,w

h

进行卷积核大小为1*1的卷积操作

[0024][0025]

其中:

[0026][0027]

将关注层的输出o乘以比例参数γ并添加到特征图,最终的输出为:

[0028]

y

i

=γo

i

+x

i

[0029]

其中,y是一个可学习的标量,初始时y被设置为0,这样网络可以更多地关注邻近

区域,然后将权重分配给非邻近的线索,逐步增加任务的复杂度;

[0030]

s3、基于自注意机制的恢复对抗网络:

[0031]

s3.1、生成网络:在生成块中主要采用残差结构提取特征,每个生成块为2个卷积,3*3滤波器和64个特征映射,并添加频谱归一化层和批处理层,来避免gn参数过多导致梯度异常,提升生成的稳定性;

[0032]

s3.2、对抗网络:感知损失和对抗损失,通过最小化对抗性损失的铰链形式以交替方式进行训练:

[0033][0034][0035]

其中,z为随机采样噪声,y为输入的失真图像,x为无失真图像;

[0036]

s4、评价网络:

[0037]

s4.1、恢复增值:若只用图像感知生成网络gn和图像生成判别网络dn的感知差值aor会损坏图像,所以将提取的特征和aor进行集中保证评价网络更好学习;评价网络将恢复patch和失真patch同时作为输入,与鉴别器结构的目标相似;

[0038]

s4.2、质量评估:由于图像失真不是均匀分布的,不同的局部失真影响不同,因此对每块的质量预测分数求加权和来更好地反映图像的整体感知质量;将失真patch和恢复patch提取的特征向量融合,并送入两个分支分别回归计算感知评分qk和权值wk,然后对它们进行空间汇集,得到最终的图像质量。

[0039]

在一个优选地实施方式中,所述步骤s2.1中质量评价网络en以失真图像gx和生成图像d(gx)为输入,以两者的感知距离aor为指导,融合三者产生预测的质量分数加权和作为输出。

[0040]

在一个优选地实施方式中,所述步骤s3.1中在第五层和第六层之后使用自注意模块,学习特征图中的长程依赖,最后输出为tanh层;生成参考图像对于失真图像的作用是弥补其缺失信息,幻像与真实参考之间的差距aor越小,质量评价网络的评估精度相对就越高;因此图像感知生成网络gn的目标是在失真图像gx的基础上生成高分辨率的恢复参考图像d(gx)。

[0041]

在一个优选地实施方式中,所述步骤s4.2中权重回归模块与质量回归分支并行运行并共享维度,对于图像块i,该分支的输出是,通过relu激活并添加一个小的稳定性项:

[0042][0043]

在一个优选地实施方式中,所述步骤s4.2中整幅图像的质量q计算如下:

[0044]

在一个优选地实施方式中,所述步骤s4.2中对于联合端到端训练,则要使基本事实与加权预测之间的平均误差最小化,则损失函数最小化为:

[0045]

[0046]

本发明的技术效果和优点:

[0047]

本发明在由失真图像产生高分辨率的恢复图像时加入自注意模块,获取一张图片中需要更多关注的关键细节信息,明确定义了失真图像与参考图像的差异值aor,目标是最大化每个输入的aor,nr-ioa的无参考性可以被巧妙地解决;通过融合输入的失真图像、恢复的参考图像以及两者之间特征差异的映射数据aor,作为评价网络的回归学习,最终将patch加权和作为该失真图像的质量评分;在live dataset和tid dataset数据集上我们提出的方法可以比传统卷积网络方法更加符合视觉感知系统(hvs),对图像感知有着较好的一致性和准确性。

附图说明

[0048]

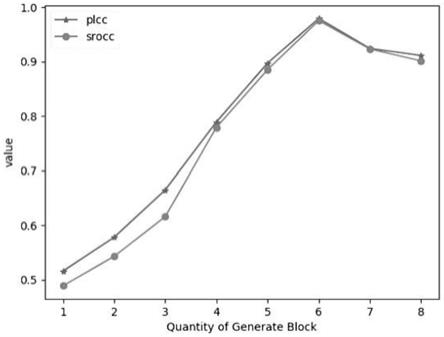

图1为本发明基于不同网络深度的实验结果示意图。

具体实施方式

[0049]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0050]

本发明提供了基于自注意力机制gan网络的无参考图像质量评价方法,具体评价步骤如下:

[0051]

s1、相关工作:

[0052]

s1.1、生成式对抗网络模型:生成式对抗网络模型算法同时训练生成器和鉴别器两个模型,生成器试图绘制更真实的图像来欺骗鉴别器,输入为失真图像(gx),通过卷积和反卷积,生成一张复原图,并将失真图以及失真图与复原图的残差图作为输入输出失真图的质量分数;

[0053]

s1.2、自我注意力生成对抗性网络:在生成式对抗网络模型中引入了self-attention机制,使得生成网络协调好每一个位置的局部细节和远端细节,判别网络能更准确地学习到全局图像结构的几何约束,在生成式对抗网络模型中引入self-attention机制,让生成器和判别器可以自动学习图像中的重要目标,使得网络在每一层都能考虑全局信息,且能够很好地处理图像中长范围、多层次的依赖,在提高感受野和减小参数量之间得到了一个更好的平衡;由于人眼视觉感知系统会把目光聚集在图像的重要patch上,综合考虑图像的局部性和整体性是图像生成的关键,因此我们采用自我注意力生成对抗性网络思想来稳定对抗训练;

[0054]

s2、提出的模型和学习:

[0055]

s2.1、建立模型框架:框架由三个部分组成:图像感知生成网络gn、图像生成判别网络dn和质量评价网络en;图像感知生成网络产生的幻觉参考图像作为失真图像的补偿信息,它们以对抗的方式训练判别网络dn,以帮助生成网络gn产生更合格的结果,并将不良结果的负面影响进行限制;另外,将self-attention机制引入了生成式对抗网络模型的图像生成当中,提升生成式对抗网络模型生成更高分辨率的图片;首先对不重叠的补丁(patch)进行采样,然后对于每一个图像感知生成网络gn将其作为输入,尝试将gx还

原为对应的无畸变原始图像,图像生成判别网络dn将恢复后的d(gx)与原始图像进行区分,质量评价网络en以失真图像gx和生成图像d(gx)为输入,以两者的感知距离aor为指导,融合三者产生预测的质量分数加权和作为输出;

[0056]

s2.2、增添自注意力模块:图像隐含层的特征x∈r

c*n

分别映射到两个特征空间f,g,计算注意力;其中:

[0057]

f(x)=w

f

x,g(x)=w

g

x

[0058][0059]

where

[0060]

sij=f(x

i

)

t

g(x

j

)

[0061]

权重β

j,i

表示模型在合成j区域的时候对i区域的关注程度;其中,c是通道的数量,n是上一步隐藏层特征所处的特征位置的数量;注意层的输出为

[0062]

o=(01,02,...,0

j

,...,0

n

)∈r

c*n

[0063]

其中:

[0064][0065]

where

[0066]

h(x

i

)=w

h

x

i

[0067]

在上式中,权重w

f

,w

g

,w

h

进行卷积核大小为1*1的卷积操作

[0068][0069]

其中:

[0070][0071]

将关注层的输出o乘以比例参数γ并添加到特征图,最终的输出为:

[0072]

y

i

=γo

i

+x

i

[0073]

其中,y是一个可学习的标量,初始时y被设置为0,这样网络可以更多地关注邻近区域,然后将权重分配给非邻近的线索,逐步增加任务的复杂度;

[0074]

s3、基于自注意机制的恢复对抗网络:

[0075]

s3.1、生成网络:在生成块中主要采用残差结构提取特征,每个生成块为2个卷积,3*3滤波器和64个特征映射,在第五层和第六层之后使用自注意模块,学习特征图中的长程依赖,最后输出为tanh层;生成参考图像对于失真图像的作用是弥补其缺失信息,幻像与真实参考之间的差距aor越小,质量评价网络的评估精度相对就越高;因此图像感知生成网络gn的目标是在失真图像gx的基础上生成高分辨率的恢复参考图像d(gx),并添加频谱归一化层和批处理层,来避免gn参数过多导致梯度异常,提升生成的稳定性;

[0076]

s3.2、对抗网络:感知损失和对抗损失,通过最小化对抗性损失的铰链形式以交替方式进行训练:

[0077][0078]

[0079]

其中,z为随机采样噪声,y为输入的失真图像,x为无失真图像;

[0080]

s4、评价网络:

[0081]

s4.1、恢复增值:若只用图像感知生成网络gn和图像生成判别网络dn的感知差值aor会损坏图像,所以将提取的特征和aor进行集中保证评价网络更好学习;计算器将恢复patch和失真patch同时作为输入,与鉴别器结构的目标相似;

[0082]

s4.2、质量评估:由于图像失真不是均匀分布的,不同的局部失真影响不同,因此对每块的质量预测分数求加权和来更好地反映图像的整体感知质量;将失真patch和恢复patch提取的特征向量融合,并送入两个分支分别回归计算感知评分qk和权值wk,然后对它们进行空间汇集,得到最终的图像质量,其中权重回归模块与质量回归分支并行运行并共享维度;对于图像块i,该分支的输出是α,通过relu激活并添加一个小的稳定性项e:

[0083][0084]

则整幅图像的质量q计算如下:

[0085][0086]

对于联合端到端训练,则要使基本事实与加权预测之间的平均误差最小化,则损失函数最小化为:

[0087][0088]

实施方式具体为:在两个被广泛使用的基准数据集live和tid2013上进行实验;

[0089]

live:live数据库是最为广泛应用的共享数据库,包括29幅参考图像和779张失真样本,其中包含jpeg2000、jpeg、白噪声、高斯模糊和快速褪色5种失真类型;每幅图像的主观分数dmos范围为(0-100);dmos值越低表示该图像有着更高的质量分数;

[0090]

tid2013:tid2013 is an extended version of tid2008(ponomarenko et al.2009);其中包含3000幅失真图像、24种失真类型;每幅图像的平均意见分数mos范围为(0-9),更高的mos意味着更高的质量评分;

[0091]

评估指标:我们采用两个指标来衡量sa-ran的性能:spearman秩序相关系数(srocc)和pearson线性相关系数(plcc);srocc衡量算法的单调性,即srocc值越大表示两个序列之间的单调性越强,反之越弱;plcc用来衡量算法预测值与主观评分之间的线性相关性,该值越大表示线性相关性越强,反之越弱;

[0092]

基于不同网络深度的模型性能对比

[0093]

自我注意力生成对抗性网络网络使用了六个生成块的残差网络来生成恢复d(gx),为了验证生成块数量继续增加对模型准确率是否有提高的作用,我们在live数据库上进行了测试,试验结果如图1所示;从图可知,随着网络的加深,模型性能越来越好,iqa的评价能力也越来越准确,但生成块数量到6个之后,网络的进一步加深,模型的性能出现下降趋势,且随着网络加深,带来了更加复杂的网络优化问题,因此本文使用6个生成块的残差结构来构建生成网络;

[0094]

交叉试验:在该部分,将提出的自我注意力生成对抗性网络算法和具有代表性的

公开iqa方法在live数据集上做性能比较;随机选取60%作为训练集,20%作为验证集,剩余的20%作为测试集;从下表1、表2可以看出,在live数据集上,除了快速衰落失真(ff)外,对于其它四种失真类型,自我注意力生成对抗性网络都比其他方法展示了更高value的sorcc和plcc,表明saran的表现优于大多数评估的最先进的方法,表明使用自注意模块明显提高了性能;

[0095]

表1:live数据库中基于不同失真类型的srocc

[0096][0097][0098]

表2:live数据库中基于不同失真类型的plcc

[0099]

sroccjp2kjpegwnblurffalldivine0.9130.910.9840.9210.8630.916blinds

-ⅱ

0.9290.9420.9690.9230.8990.931brisque0.9140.9650.9790.9510.8770.940cnn0.9520.9770.9780.9620.9080.956dnn0.9430.9550.9760.9690.9060.942ran4

-----

0.972saran0.9560.9790.980.9710.8970.975

[0100]

另外评估者分别在tid2013和live上进行交叉验证;评估者结果显示在表3中;在tid2013数据集上,saran算法也表现出了较好的评估指标,这显示了它的健壮性和跨数据集的泛化性;

[0101]

表3

[0102]

[0103][0104]

模型对输入的失真图像进行恢复,并基于aor对失真图像和恢复图像进行特征提取,通过融合特征向量来评价图像的感知质量;实验结果在live和tid数据集上都显示它在iqa方法中的优越性,更加符合人类视觉感知系统。

[0105]

最后应说明的几点是:首先,在本申请的描述中,需要说明的是,除非另有规定和限定,术语“安装”、“相连”、“连接”应做广义理解,可以是机械连接或电连接,也可以是两个元件内部的连通,可以是直接相连,“上”、“下”、“左”、“右”等仅用于表示相对位置关系,当被描述对象的绝对位置改变,则相对位置关系可能发生改变;

[0106]

其次:本发明公开实施例附图中,只涉及到与本公开实施例涉及到的结构,其他结构可参考通常设计,在不冲突情况下,本发明同一实施例及不同实施例可以相互组合;

[0107]

最后:以上所述仅为本发明的优选实施例而已,并不用于限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1