一种面向测试装配过程的安全模型表征和量化评价方法

1.本发明属于安全监控领域,特别是一种面向测试装配过程的安全模型表征和量化评价方法。

背景技术:

2.在智能制造快速发展的背景之下,传统导弹制造业也在向智能制造转型。由于导弹生产过程中带有火工品,具有易燃易爆的特性,因此对导弹的生产过程进行智能化管理显得格外重要。在导弹总装测试生产过程中导弹若出现大幅度摆动和碰撞,容易引发安全事故,一旦发生安全事故,不仅仅会造成经济损失,车间人员也会有生命危险,后果严重,难以想象。因此,需要对导弹总装测试生产过程进行安全有效的管理。

3.然而目前在这方面的管理完全取决于人员的操作判断,难以准确的估计导弹的位姿以保障安全,对导弹是否处于危险状态缺乏智能化的判断和预警,因此需要在导弹总装测试生产过程中对导弹进行监控,实时检测并完成空间位置和姿态的估计,对导弹安全模型进行表征,构建安全模型量化评价方法,保证安全生产的有效进行。

4.传统方法获取导弹空间位置和姿态信息需要在导弹表面附加各类传感器来进行数据采集,由于传感器需要进行接触式测量,安装拆除过程复杂且容易对导弹表面造成破坏,难以满足安全生产需求。另外目前基于计算机视觉技术对物体进行空间位置的确定和姿态估计的工作大部分都是基于二维彩色图像进行处理,二维图像在投影过程中会损失很多空间位置信息,位姿估计的准确度有限,此外还有基于模板匹配的方法,该方法需要建立准确的模板和不同视角的投影图,数据集的形成较为复杂,还需要在物体周围布有用于坐标定位的标记,而实际导弹体积较大且处于转移运输过程,难以布置标记。

技术实现要素:

5.为了解决上述问题,本发明提供了一种面向测试装配过程的安全模型表征和量化评价方法,该方法可以实现对导弹总装测试生产过程中的有效管控。

6.为了实现上述目的,本发明采用的技术方案如下:

7.一种面向测试装配过程的安全模型表征和量化评价方法,所述方法包括以下步骤:

8.步骤1、对智能深度传感器的彩色摄像头和深度摄像头进行离线标定,完成彩色图像到深度图像的映射关系;

9.步骤2、利用深度卷积神经网络对所述彩色图像进行目标物体的识别和检测;

10.步骤3、将所述彩色图像的识别和检测结果映射到所述深度图像中获取关键点的深度信息;

11.步骤4、利用关键点深度信息和深度摄像头的内参矩阵得到关键点在相机坐标系下的三维坐标;

12.步骤5、利用关键点的三维坐标计算目标物体的空间位置和姿态信息;

13.步骤6、根据装配要求确定安全模型表征和量化评价标准。

14.优选地,步骤1中所述对智能深度传感器的彩色和深度摄像头进行离线标定包括:

15.步骤1.1、制作黑白棋盘格标定板,所述标定板为7

×

10个黑白相间的正方形棋盘格,正方形边长在10mm到30mm之间;

16.步骤1.2、将所述标定板放到摄像头成像区域内,从摄像头中获取待标定图片,标定图片需要从不同角度拍摄20张以上;

17.步骤1.3、利用张正友标定法进行摄像头标定,标定完成后将彩色摄像头内参矩阵记为k_rgb,深度摄像头内参矩阵记为k_ir;

18.步骤1.4、根据摄像头的标定参数调用opencv开源工具中的矫正函数矫正图像。

19.优选地,步骤1中所述完成彩色图像到深度图像的映射关系包括:

20.步骤1.5、将彩色图像到深度图像统一分辨率;

21.步骤1.6、将彩色摄像头和深度摄像头的内参矩阵联合求解,得到转换矩阵t_rgb2ir=k_rgb

×

k_ir;

22.步骤1.7、深度摄像头与彩色摄像头在空间上不重合,计算两者的偏移量s=(xs,ys,zs);

23.步骤1.8、记深度图像上点坐标为p'(x

ir

,y

ir

,z

ir

),彩色图像上点坐标为p(x

rgb

,y

rgb

,z

rgb

),则两者的映射关系为:p

't

=p

t

×

t_rgb2ir+s

t

。

24.优选地,步骤2中所述利用深度卷积神经网络对所述彩色图像进行目标物体的识别和检测包括:

25.步骤2.1、同步采集目标物体空间不同位置和姿态的图像数据,将采集到的图像经过矫正畸变后输出保存;

26.步骤2.2、在彩色图像中对目标物体及其关键部分进行人工标记,形成数据集;

27.步骤2.3、将所述数据集送入yolo检测网络模型进行训练直至收敛;

28.步骤2.4、利用收敛的yolo检测网络模型对智能深度传感器的彩色摄像头的视频帧图像进行目标检测,计算出目标物体及其关键部分在图像中的位置。

29.优选地,步骤3中所述将所述彩色图像的识别和检测结果映射到所述深度图像中获取关键点的深度信息包括:

30.步骤3.1、计算目标物体及其关键部分中心点在彩色图像上的坐标;

31.步骤3.2、计算彩色图像上中心点在深度图像上的坐标;

32.步骤3.3、读取深度图像上以中心点坐标为中心,边长为6个像素单位的正方形squareroi[i]中的每个像素点的深度值;

[0033]

步骤3.4、利用正态分布方法剔除squareroi[i]中的异常值,计算均值作为该中心点的深度值,存入数组depth。

[0034]

优选地,步骤4中所述利用关键点深度信息和深度摄像头的内参矩阵得到关键点在相机坐标系下的三维坐标包括:

[0035]

步骤4.1、根据所述数组depth中的深度值求解关键点在相机坐标系下的z坐标值存入数组zall;

[0036]

步骤4.2、根据相机成像原理得到图像上点a(u,v)到相机坐标系下点a'(x,y,z)的

映射关系:计算得到a'(x,y,z);

[0037]

步骤4.3、根据步骤4.2提供的方法计算所有的关键点三维坐标,存入数组aall。

[0038]

优选地,步骤5中所述利用关键点的三维坐标计算目标物体的空间位置和姿态信息包括:

[0039]

步骤5.1、选取目标物体的整体中心点三维坐标作为目标物体的空间位置信息;

[0040]

步骤5.2、选取目标物体的头部和尾部中心点构成线段表示目标物体的中心线,用所述中心线在相机坐标系下的投影角度表示目标物体的空间姿态信息,投影角度的计算公式如下:

[0041][0042][0043][0044]

其中头部中心点坐标(x1,y1,z1),尾部中心点坐标(x2,y2,z2);

[0045]

步骤5.3、在彩色图像上输出位置信息和姿态信息,将图像转换成视频作为最终输出。

[0046]

优选地,步骤6中所述根据装配要求确定安全模型表征和量化评价标准包括:

[0047]

步骤6.1、结合实际目标物体致险行为,设计采用目标物体的摆动角度、起吊高度、运动速度、运动加速度四个指标来表征目标物体的安全模型;

[0048]

步骤6.2、针对目标物体的摆动角度、起吊高度、运动速度、运动加速度分别结合生产实际划定不同危险等级的取值范围,根据四个不同指标的危险等级来对目标物体测试装配过程进行量化评价,将四个部分求和并进行归一化处理,得到综合危险等级指数,归一化公式如下:

[0049][0050]

其中,d代表综合危险等级指数,di代表各个指标的危险等级,根据综合危险等级指数的数值及概率分布得到综合危险等级。

[0051]

本发明与现有技术相比,其显著优点为:

[0052]

1、本发明提出了一种无需接触就可以获得目标物体空间位置和姿态的方法,该方法除了智能深度传感器以外,无需在生产现场布置任何设备,且不需频繁拆装。

[0053]

2、本发明通过深度神经网络对彩色图像进行识别,无需人工参与即可自动实时识别目标物体,从而进一步估计目标物体的位姿;并通过深度图像进行目标物体位姿的估计,充分利用了目标物体的空间信息,估计结果精度较高。

附图说明

[0054]

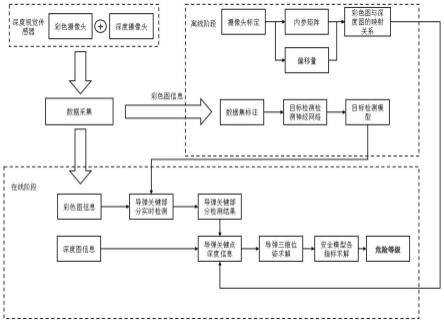

图1为本发明中面向导弹总装测试生产过程的安全模型表征和量化评价方法的实

施流程图。

[0055]

图2为导弹生产车间吊装示意图。

[0056]

图3为yolo检测网络模型结构图。

具体实施方式

[0057]

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

[0058]

以下结合具体实施例对本发明的实现进行详细的描述。

[0059]

结合图1-3,本发明中面向导弹总装测试生产过程的安全模型表征和量化评价方法包括以下步骤:

[0060]

步骤1、对智能深度传感器的彩色摄像头和深度摄像头进行离线标定,完成彩色图像到深度图像的映射关系。具体步骤如下:

[0061]

步骤1.1、制作黑白棋盘格标定板,所述标定板为7

×

10个黑白相间的正方形棋盘格,正方形边长在10mm到30mm之间;

[0062]

步骤1.2、将所述标定板放到摄像头成像区域内,从摄像头中获取待标定图片,标定图片需要从不同角度拍摄20张以上;

[0063]

步骤1.3、利用张正友标定法进行摄像头标定,标定完成后将彩色摄像头内参矩阵记为k_rgb,深度摄像头内参矩阵记为k_ir;

[0064]

步骤1.4、根据摄像头的标定参数调用opencv开源工具中的矫正函数矫正图像;

[0065]

步骤1.5、将彩色图像到深度图像统一分辨率;

[0066]

步骤1.6、将彩色摄像头和深度摄像头的内参矩阵联合求解,得到转换矩阵t_rgb2ir=k_rgb

×

k_ir;

[0067]

步骤1.7、深度摄像头与彩色摄像头在空间上不重合,计算两者的偏移量s=(xs,ys,zs);

[0068]

步骤1.8、记深度图像上点坐标为p'(x

ir

,y

ir

,z

ir

),彩色图像上点坐标为p(x

rgb

,y

rgb

,z

rgb

),则两者的映射关系为:p

't

=p

t

×

t_rgb2ir+s

t

。

[0069]

步骤2、利用深度卷积神经网络对所述彩色图像进行导弹的识别和检测。具体步骤如下:

[0070]

步骤2.1、同步采集导弹空间不同位置和姿态的图像数据,将采集到的图像经过矫正畸变后输出保存;

[0071]

步骤2.2、在彩色图像中对导弹及其关键部分进行人工标记,形成数据集;

[0072]

步骤2.3、将所述数据集送入yolo检测网络模型进行训练直至收敛,yolo检测网络模型相关代码已开源,其训练的流程在官网上已经给出,修改部分参数就可以应用于导弹的检测,修改如下:首先将yolo的分类数量由原来的20改为3,因为官方的yolo可以检测20种不同的物体,而现在我们只需要检测三个类目标:导弹,导弹头部,导弹尾部。其次,修改yolo的学习率,一般设为0.1即可,当迭代到总轮数的一半时,减小到0.01;最后,修改训练迭代次数,一般设为40000轮或者更多,直至yolo的损失下降到收敛;

[0073]

步骤2.4、利用收敛的yolo检测网络模型对智能深度传感器的彩色摄像头的视频

帧图像进行目标检测,计算出导弹及其关键部分在图像中的位置,用box(x,y,w,h)表示。其中(x,y)表示box的左上角在像素坐标系中的位置,w表示box的宽度,h表示box的高度,总计获得三个box。

[0074]

步骤3、将所述彩色图像的识别和检测结果映射到所述深度图像中获取关键点的深度信息。具体步骤如下:

[0075]

步骤3.1、计算导弹及其关键部分中心点在彩色图像上的坐标;

[0076]

步骤3.2、计算彩色图像上中心点在深度图像上的坐标;

[0077]

步骤3.3、读取深度图像上以中心点坐标为中心,边长为6个像素单位的正方形squareroi[i]中的每个像素点的深度值;

[0078]

步骤3.4、利用正态分布方法剔除squareroi[i]中的异常值,计算均值作为该中心点的深度值,存入数组depth。

[0079]

步骤4、利用关键点深度信息和深度摄像头的内参矩阵得到关键点在相机坐标系下的三维坐标。具体步骤如下:

[0080]

步骤4.1、根据所述数组depth中的深度值求解关键点在相机坐标系下的z坐标值存入数组zall;

[0081]

步骤4.2、根据相机成像原理得到图像上点a(u,v)到相机坐标系下点a'(x,y,z)的映射关系:计算得到a'(x,y,z);

[0082]

步骤4.3、根据步骤4.2提供的方法计算所有的关键点三维坐标,存入数组aall。

[0083]

步骤5、利用关键点的三维坐标计算导弹的空间位置和姿态信息。具体步骤如下:

[0084]

步骤5.1、选取导弹的整体中心点三维坐标作为导弹的空间位置信息;

[0085]

步骤5.2、选取导弹的头部和尾部中心点构成线段表示导弹的中心线,用所述中心线在相机坐标系下的投影角度表示导弹的空间姿态信息,投影角度的计算公式如下:

[0086][0087][0088][0089]

其中头部中心点坐标(x1,y1,z1),尾部中心点坐标(x2,y2,z2);

[0090]

步骤5.3、在彩色图像上输出位置信息和姿态信息,将图像转换成视频作为最终输出。

[0091]

步骤6、根据装配要求确定安全模型表征和量化评价标准。具体步骤如下:

[0092]

步骤6.1、结合实际导弹致险行为,设计采用导弹的摆动角度、起吊高度、运动速度、运动加速度四个指标来表征导弹的安全模型;

[0093]

步骤6.2、针对导弹的摆动角度、起吊高度、运动速度、运动加速度分别结合生产实际划定不同危险等级的取值范围(参见表1),根据四个不同指标的危险等级来对导弹测试装配过程进行量化评价,将ⅰ、ⅱ、ⅲ分别对应1、2、3,将四个部分求和并进行归一化处理,得到综合危险等级指数,归一化公式如下:

[0094][0095]

其中,d代表综合危险等级指数,di代表各个指标的危险等级,根据综合危险等级指数的数值及概率分布得到综合危险等级(参见表2)。

[0096]

表1各个指标不同危险等级的取值范围

[0097][0098][0099]

表2综合危险等级

[0100]

综合危险等级指数取值范围综合危险等级d《0.42ⅰ级0.42《=d《=0.67ⅱ级d》0.67ⅲ级

[0101]

以上显示和描述了本发明的基本原理、主要特征及优点。本行业的技术行为人应该了解,本发明不受上述实施例的限制,上述实施例和说明书中描述的只是说明本发明的原理,在不脱离本发明精神和范围的前提下,本发明还会有各种变化和改进,这些变化和改进都落入要求保护的本发明范围内。本发明要求保护范围由所附的权利要求书及其等效物界定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1