一种基于边缘主体融合信息的遥感目标显著性检测方法与流程

1.本发明属于计算机视觉领域,涉及显著目标检测、遥感图像检测领域。具体涉及一种基于边缘主体融合信息的遥感目标显著性检测方法。

背景技术:

2.随着深度学习、神经网络的飞速发展,计算机视觉领域实现了前所未有的跨越。目标检测作为计算机视觉领域一个经典大类,受到广泛的研究和探讨,在显著目标检测、行人重识别、图像数据评估等各个方向都取得了巨大进步。在生活中,面部扫描、车牌扫描、天网工程等都利用到了目标检测的相关技术。

3.人类视觉系统在面对自然场景时具有快速搜索和定位感兴趣目标的能力,这种视觉注意机制是人们日常生活中处理视觉信息的重要机制。随着互联网带来的大数据量的传播,如何从海量的图像和视频数据中快速地获取重要信息,已经成为计算机视觉领域一个关键的问题。通过在计算机视觉任务中引入这种视觉注意机制,即视觉显著性,可以为视觉信息处理任务带来一系列重大的帮助和改善。显著性物体检测的目的即是从图像中定位最有吸引力和视觉上独特的物体或区域,大量应用于图像分割、目标重定位、目标图像前景注释等邻域。遥感图像的显著目标检测在检测上又不同于常规显著性检测任务,遥感图像通过航空摄影、航空扫描、微波雷达等手段,以飞机、轮船等交通工具,公路、河流、运动场馆等目标物体为主要分割对象,目标在图像中往往较小且复杂。遥感图像的显著目标检测在自然保护、雷达检测等邻域有巨大作用。

4.u-net是现在最为流行的图像分割网络,网络主要包括下采样和上采样两个部分,通过下采样对图片特征进行提取处理,而上采样则可以将特征信息进行还原,使得网络最后输出为一个完整图像。

5.随着深度神经网络的飞速发展,遥感图像的显著目标检测在检测精度以及检测速度上都有巨大进步,人们也发现在目标检测中加入边缘信息后能够使得检测结果有进一步提升。但是现存的方法只是单纯地将边缘信息加入到主体检测中,几乎没人关注到主体检测和边缘检测的协同优化效果。本文有效利用了边缘信息和主体信息,利用边缘信息指导主体,同时利用主题信息反馈指导边缘,使得显著目标检测,尤其是遥感目标的显著目标检测结果有了巨大提升。

技术实现要素:

6.针对现有技术存在的问题,本发明提供一种基于边缘主体融合信息的遥感目标显著性检测方法。

7.本发明解决其技术问题所采用的技术方案包括如下步骤:

8.步骤1、图像数据预处理,获得预处理后的图像训练集:

9.训练数据集采用orssd图像数据集。对待训练数据集进行图像预处理,首先去除图像相关噪声干扰使数据更加精确,并利用matlab工具获得只含边缘轮廓的图像训练集,然

后对获取的图像训练集进行扩增,从而获得更好的训练效果。

10.步骤2、网络搭建:

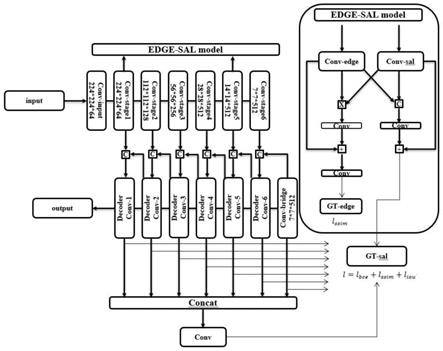

11.网络主要结构如图1,本方法采用encoder-decoder办法,网络结构主体参考u-net,具体的:u-net的encoder部分包括一个输入卷积层和六个卷积块,其中前四个卷积块采用resnet34,为了得到和传统resnet34相同的感受野,在四个卷积块后又添加了两个卷积块。为了更好的获得全局信息,在网络的encoder和decoder之间添加3个3*3的卷积层作为桥接。

12.decoder部分与encoder部分为对称结构,与传统u-net不同的是,每个解码块除了与对应encoder部分concat之外,还将前一个解码块concat进来从而获得更丰富的全局信息。每个解码块都获得其边缘输出,用loss函数进行约束。

13.边缘主体融合模块作用于encoder部分,由于底层信息有更丰富的边缘信息,高层信息则含有更丰富的主体信息,因此选择提取第二个卷积块的边缘信息以及第五个卷积块的主体信息进行交互,并用loss进行约束。

14.边缘主体融合模块作用于decoder部分,一方面:首先对每个解码块的边缘输出进行loss约束,然后对六个解码块和桥接的边缘输出进行loss约束;另一方面:将六个解码块的边缘输出和桥接的边缘输出进行concat,然后输入3层3*3的卷积层当中再用相同的loss函数进行约束。

15.步骤3、数据输入和训练:

16.网络采用adam优化器,学习率设置为0.001,beta=(0.9,0.999),eps=1e-8,weight_decay=0。我们将输入图像resize为256*256,epoch设置为200,batch size为4。

17.本发明有益效果如下:

18.本发明有效利用了编码阶段的边缘信息和主体信息,并选择使用多loss融合的模式对u-net解码部分的各个边缘输出进行约束,同时对各个边缘输出进行融合,使得遥感目标的检测取得了显著提升。

附图说明

19.图1整体网络结构图

具体实施方式

20.下面结合具体实施方式对本发明进行详细的说明。

21.如图1所示,一种基于边缘主体融合信息的遥感目标显著性检测方法,具体实现步骤如下:

22.步骤1:对待训练数据集进行图像预处理,数据集选择orssd,为了得到较好的训练结果我们通过旋转、翻转将数据集扩充为4800张,同时获得对应边缘轮廓图片,除去不必要的图像噪声使数据更加精确。

23.步骤2-网络搭建:

24.网络主要结构如图1,本方法采用encoder-decoder办法,网络结构主体参考u-net,将u-net的encoder部分有一个输入卷积层和六个卷积块组合而成,其中前四个卷积块采用resnet34,为了得到和传统resnet34相同的感受野,我们在四个卷积块后又添加了两

个卷积块。为了更好的获得全局信息,在网络的encoder和decoder之间我们添加了3个3*3的卷积层作为桥接。

25.decoder部分与encoder部分为对称结构,与传统u-net不同的是,每个解码块除了与对应encoder部分联结之外,还将前一个解码块联结进来从而获得更丰富的全局信息。每个解码块我们都获得其边缘输出,用loss函数进行约束。

26.边缘主体融合模块作用于encoder部分,由于底层信息有更丰富的边缘信息,高层信息则含有更丰富的主体信息,我们利用两个卷积模块(均为三个3*3的conv+bn+relu)分别对第二层的边缘信息和第五层的主体信息进行提取,进行交互后分别利用边缘gt和主体gt进行约束。

27.值得注意的是在对边缘信息进行约束时,我们只采用ssim loss作为约束,主体则使用联合loss进行约束。

28.融合模块作用于decoder部分,我们将所有解码块的边缘输出和上文提到的边缘信息进行联结,将其输入到3层3*3的卷积层当中再用相同的loss函数进行约束。

29.值得注意的是对于每个卷积层,我们都在其后添加了bn层和relu层,使用的loss函数如下:

30.l=l

bce

+l

ssim

+l

iou

[0031][0032][0033][0034]

其中g(x,y),t(x,y)分别为ground truth和预测结果在各个位置的数值。参数解释,μ和σ分别为均值和标准差,h,w为图片的高和宽,c1=0.012,c2=0.032,用于防止分母为零。

[0035]

步骤3-数据输入、训练:

[0036]

网络采用adam优化器,学习率设置为0.001,beta=(0.9,0.999),eps=1e-8,weight_decay=0。我们将输入图片resize为256*256,epoch设置为200,batch size为4。

[0037]

本发明充分研究优化了u-net网络的常规结构,充分利用了decoder部分的信息,通过更加丰富的联结手段使每个解码模块获得了更加丰富的全局信息,同时通过添加融合模块,使得小目标检测更加完整,细节部分更加清晰完整。在遥感数据集上取得了显著的效果。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1