三维面部扫描增强的制作方法

1.本说明书描述了使用神经网络增强三维面部数据的方法,以及训练神经网络增强三维面部数据的方法。

背景技术:

2.图像到图像转换是图像处理中普遍存在的问题,在图像到图像转换中,输入图像被转换为保持原始输入图像某些属性的合成图像。图像到图像转换的示例包括将图像从黑白转换为彩色,将白天场景转换为夜间场景,从而提高图像质量和/或处理图像的面部属性。然而,当前执行图像到图像转换的方法仅限于二维(two

‑

dimension,2d)纹理图像。

3.随着深度摄像机的引入,三维(three

‑

dimension,3d)图像数据的捕获和使用变得越来越普遍。然而,在此类3d图像数据上使用形状到形状转换(图像到图像转换的3d模拟)受到几个因素的限制,包括许多深度摄像机的低质量输出。这在非线性经常存在的3d面部数据中尤其如此。

技术实现要素:

4.根据本发明的第一方面,描述了一种训练生成器神经网络以将低质量三维面部扫描转换为高质量三维面部扫描的方法,所述方法包括联合训练鉴别器神经网络和生成器神经网络,所述联合训练包括:将所述生成器神经网络应用于低质量空间uv图,生成候选高质量空间uv图;将所述鉴别器神经网络应用于所述候选高质量空间uv图,生成重建的候选高质量空间uv图;将所述鉴别器神经网络应用于高质量地面真值空间uv图,生成重建的高质量地面真值空间uv图,其中,所述高质量地面真值空间uv图对应于所述低质量空间uv图;根据所述候选高质量空间uv图和所述重建的候选高质量空间uv图的比较,更新所述生成器神经网络的参数;根据所述候选高质量空间uv图和所述重建的候选高质量空间uv图的比较以及所述高质量地面真值空间uv图和所述重建的高质量地面真值空间uv图的比较,更新所述鉴别器神经网络的参数。在更新所述参数时,还可以使用所述候选高质量空间uv图和所述对应的地面真值高质量空间uv图之间的比较。

5.所述生成器神经网络和/或所述鉴别器神经网络可以包括一组编码层和一组解码层,其中,所述编码层用于将输入空间uv图转换为嵌入,所述解码层用于将所述嵌入转换为输出空间uv图。在所述生成器神经网络和所述鉴别器神经网络的所述联合训练期间,一个或多个所述解码层的参数可以是固定的。所述生成器神经网络和/或所述鉴别器神经网络的所述解码层可以包括所述解码层的初始层中的一个或多个跳跃连接。

6.所述生成器神经网络和/或所述鉴别器神经网络包括可以多个卷积层。所述生成器神经网络和/或所述鉴别器神经网络可以包括一个或多个全连接层。所述生成器神经网络和/或所述鉴别器神经网络可以包括一个或多个上采样层和/或子采样层。所述生成器神经网络和/或所述鉴别器神经网络的网络结构可以相同。

7.更新所述生成器神经网络的参数还可以根据所述候选高质量空间uv图和所述对

应的高质量地面真值空间uv图之间的比较。

8.更新所述生成器神经网络的参数可以包括:根据所述候选高质量空间uv图与所述对应的重建的候选高质量空间uv图之间的差值,使用生成器损失函数计算生成器损失;将优化过程应用于所述生成器神经网络,以根据所述计算出的生成器损失更新所述生成器神经网络的所述参数。所述生成器损失函数还可以根据所述候选高质量空间uv图与所述对应的高质量地面真值空间uv图之间的差值,计算所述生成器损失。

9.更新所述鉴别器神经网络的参数可以包括:根据所述候选高质量空间uv图与所述重建的候选高质量空间uv图之间的差值以及所述高质量地面真值空间uv图与所述重建的高质量地面真值空间uv图之间的差值,使用鉴别器损失函数计算鉴别器损失;将优化过程应用于所述鉴别器神经网络,以根据所述计算出的鉴别器损失更新所述鉴别器神经网络的所述参数。

10.所述方法还可以包括预训练所述鉴别器神经网络,以根据输入高质量地面真值空间uv图重建高质量地面真值空间uv图。

11.根据本发明的另一方面,描述了一种将低质量三维面部扫描转换为高质量三维面部扫描的方法,所述方法包括:接收面部扫描的低质量空间uv图;将神经网络应用于所述低质量空间uv图;从所述神经网络输出所述面部扫描的高质量空间uv图,其中,所述神经网络是使用根据本文所述的任一种训练方法训练的生成器神经网络。

12.根据本发明的另一方面,描述了一种装置,包括:一个或多个处理器;存储器,其中,所述存储器包括计算机可读指令,当由一个或多个处理器执行时,所述计算机可读指令使得所述装置执行根据本文描述的方法中的一个或多个方法。

13.根据本发明的另一方面,描述了一种包括计算机可读指令的计算机程序产品,当由计算机执行时,所述计算机可读指令使得所述计算机执行本文描述的方法中的一个或多个方法。

14.本文所使用的术语“质量”可以优选地用于表示以下任一个或多个:噪音水平(例如,峰值信噪比);纹理质量;相对于地面真值扫描的误差;3d形状质量(例如,可以指眼睑和/或嘴唇变化等高频细节在3d面部数据中的保留程度)。

附图说明

15.现在参考附图通过非限制性示例来描述实施例,其中:

16.图1示出了使用神经网络增强3d面部数据的示例性方法的概述;

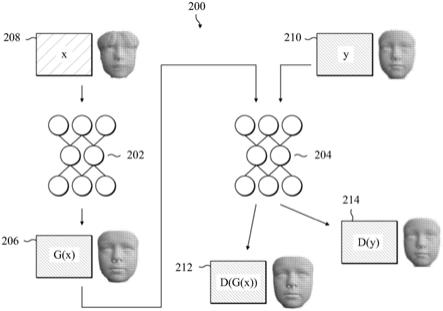

17.图2示出了训练神经网络增强3d面部数据的示例性方法的概述;

18.图3示出了训练神经网络增强3d面部数据的示例性方法的流程图;

19.图4示出了预处理3d面部数据的示例性方法的概述;

20.图5示出了预训练鉴别器神经网络的示例性方法的概述;

21.图6示出了用于增强3d面部数据的神经网络的结构的示例;

22.图7示出了计算系统的示意图示例。

具体实施方式

23.一些3d摄像机系统捕获到的原始3d面部扫描通常质量较低,例如,表面细节较少

和/或比较嘈杂。例如,这可能是摄像机用于捕获3d面部扫描的方法的结果,或者是由于3d摄像机系统的技术限制。但是,使用面部扫描的应用程序可以要求扫描的质量高于3d摄像机系统捕获到的面部扫描。

24.图1示出了使用神经网络增强3d面部数据的示例性方法的概述。所述方法还包括接收低质量3d面部数据102,并使用神经网络106根据低质量3d面部数据102生成高质量3d面部数据104。

25.低质量3d面部数据102可以包括低质量3d面部扫描的uv图。或者,低质量3d面部数据102可以包括表示低质量3d面部扫描的3d网格。在预处理步骤108中,3d网格可以转换成uv图。下面结合图4描述这种预处理步骤的示例。

26.空间uv图是3d表面或网格的二维表示。3d空间中的各点(例如,由坐标(x,y,z)描述)映射到二维空间(由坐标(u,v)描述)上。uv图可以是通过将3d空间中的3d网格展开到二维uv空间中的u

‑

v平面上形成的。在一些实施例中,3d空间中的3d网格的坐标(x,y,z)存储为uv空间中相应点的rgb值。使用空间uv图可以有利于在提高3d扫描质量时使用二维卷积,而不是使用几何深度学习方法,这样往往主要保留3d网格的低频细节。

27.神经网络106包括多层节点,每个节点与一个或多个参数相关联。神经网络的每个节点的参数可以包括一个或多个权重和/或偏差。节点取上一层中节点的一个或多个输出作为输入。上一层中节点的一个或多个输出由节点用来通过激活函数和神经网络的参数生成激活值。

28.神经网络106可以具有自动编码器架构。下面结合图6描述神经网络架构的各个示例。

29.神经网络106的参数可以使用生成对抗训练进行训练,并且神经网络106因此可以称为生成对抗网络(generative adversarial network,gan)。神经网络106可以是生成对抗训练的生成网络。下面结合图3至图5描述训练方法的各个示例。

30.神经网络使用低质量3d面部扫描的uv图生成高质量3d面部数据104。高质量3d面部数据104可以包括高质量uv图。高质量uv图可以在后处理步骤110中转换为高质量3d空间网格。

31.图2示出了训练神经网络增强3d面部数据的示例性方法的概述。方法200包括以对抗方式联合训练生成器神经网络202和鉴别器神经网络204。在训练期间,生成器神经网络202的目的是学习根据输入低质量uv面部图(在本文中也称为低质量空间uv图)208生成高质量uv面部图206,这些低质量uv面部图208接近对应的地面真值uv面部图(在本文中也称为真实高质量uv面部图和/或高质量地面真值空间uv图)210。低质量空间uv图x和高质量地面真值空间uv图y的对集{(x,y)}可以称为训练集/数据。可以使用预处理方法根据原始面部扫描构建训练数据集,如下文结合图4更详细地描述。

32.在训练期间,鉴别器神经网络204的目的是学习区分地面真值uv面部图210和生成的高质量uv面部图206(在本文中也称为假高质量uv面部图或候选高质量空间uv图)。鉴别器神经网络204可以具有自动编码器结构。

33.在一些实施例中,鉴别器神经网络204可以对预训练数据进行预训练,如下文结合图5所述。在鉴别器神经网络204和生成器神经网络202的结构相同的实施例中,经过预训练的鉴别器神经网络204的参数可用于初始化鉴别器神经网络204和生成器神经网络202两

者。

34.在训练过程中,生成器神经网络202和鉴别器神经网络204相互竞争,直到它们达到阈值/平衡条件。例如,生成器神经网络202和鉴别器神经网络204相互竞争,直到鉴别器神经网络204不能再区分真假uv面部图。

35.在训练过程中,生成器神经网络202应用于从训练数据中获取的低质量空间uv图208,x。生成器神经网络的输出是对应的候选高质量空间uv图206,g(x)。

36.鉴别器神经网络204应用于候选高质量空间uv图206,生成重建的候选高质量空间uv图212,d(g(x))。鉴别器神经网络204还应用于对应于低质量空间uv图208,x的高质量地面真值空间uv图210,y,生成重建的高质量地面真值空间uv图214,d(y)。

37.将候选高质量空间uv图206,g(x)和重建的候选高质量空间uv图212,d(g(x))进行比较,并使用所述比较结果更新生成器神经网络的参数。还可以将高质量地面真值空间uv图210,y和重建的高质量地面真值空间uv图214,d(y)进行比较,并将候选高质量空间uv图206和重建的候选高质量空间uv图212进行比较,两种比较结果一起用于更新鉴别器神经网络的参数。可以使用一个或多个损失函数执行比较。在一些实施例中,使用将生成器神经网络202和鉴别器神经网络204应用于多对低质量空间uv图208和高质量地面真值空间uv图210的结果计算损失函数。

38.在一些实施例中,可以使用对抗损失函数。对抗损失的一个示例是began损失。生成器神经网络的损失函数(在本文中也称为生成器损失)和鉴别器神经网络的损失函数(在本文中也称为鉴别器损失)可以由以下公式给出:

[0039][0040][0041][0042]

其中,t标记更新迭代(例如,对于网络的第一次更新,t=0,对于网络的第二组更新,t=1),表示将鉴别器的输入z与对应输出d(z)相比较的度量,k

t

是控制应该对£(g(x))施加多少权重的参数,λ

k

是k

t

的学习率,γ∈[0,1]是控制平衡的超参数。超参数可以取值γ=0.5和λ=10,k

t

的值初始化为0.001。但是,也可以使用其它值。在一些实施例中,度量£(z)由给出,尽管将理解其它示例是可能的。表示训练数据集合的期望值。

[0043]

在训练期间,鉴别器神经网络204经过训练以将减至最小,而生成器神经网络202经过训练将减至最小。有效地,生成器神经网络202经过训练以“戏弄”鉴别器神经网络204。

[0044]

在一些实施例中,更新生成器神经网络的参数还可以根据候选高质量空间uv图206和高质量地面真值空间uv图210之间的比较。可以使用生成器损失中的附加项来执行比较,附加项在本文中称为重建损失然后,完全生成器损失可由以下公式给出:

[0045][0046]

其中,λ是一个超参数,控制对重建损失的重视程度。重建损失的一个示例是

可以理解,其它示例也是可能的。

[0047]

比较可用于使用旨在将上述损失函数减至最小的优化过程/方法更新生成器和/或鉴别器神经网络的参数。这种方法的一个示例是梯度下降算法。优化方法的特征可以是学习率,该学习率表征了在算法每次迭代期间所用步长的“大小”。在使用梯度下降的一些实施例中,对于生成器神经网络和鉴别器神经网络,学习率最初可以设置为5e(

‑

5)。

[0048]

在训练期间,训练过程的学习率可以在阈值数量的周期(epoch)和/或迭代之后改变。每n次迭代后,学习率可能会下降给定的因子。例如,每30个训练周期后,学习率可能会下降5%。

[0049]

不同的学习率可用于神经网络202、204的不同层。例如,在鉴别器神经网络204已经经过预先训练的实施例中,鉴别器神经网络204和/或生成器神经网络202的一个或多个层可以在训练过程中被冻结(即,学习率为0)。鉴别器神经网络204和/或生成器神经网络202的解码器层可以在训练过程中被冻结。神经网络202、204的编码器和瓶颈部分可以具有小的学习率,以防止它们的值与预训练中发现的值偏差很大。这些学习率可以减少训练时间并提高经过训练的生成器神经网络106的精度。

[0050]

训练过程可以是迭代的,直到满足阈值条件。例如,阈值条件可以是迭代和/或周期的阈值数量。例如,可以针对300个周期执行训练。可选地或另外地,阈值条件可以是损失函数各自被优化到其最小值的阈值内。

[0051]

图3为训练神经网络以将低质量3d面部扫描转换为高质量3d面部扫描的示例性方法的流程图。流程图对应于上述结合图2描述的方法。

[0052]

在操作3.1中,将生成器神经网络应用于低质量空间uv图,生成候选高质量空间uv图。生成器神经网络可以具有自动编码器结构,并包括一组编码器层和一组解码器层,其中,所述编码器层用于生成低质量空间uv图的嵌入,所述解码器层用于根据嵌入生成候选高质量空间uv图。生成器神经网络由生成器神经网络参数(例如,生成器神经网络中神经网络节点的权重和偏差)集描述。

[0053]

在操作3.2中,将鉴别器神经网络应用于候选高质量空间uv图,生成重建的候选高质量空间uv图。鉴别器神经网络可以具有自动编码器结构,并包括一组编码器层和一组解码器层,其中,所述编码器层用于生成输入空间uv图的嵌入,所述解码器层用于根据嵌入生成输出高质量空间uv图。鉴别器神经网络由鉴别器神经网络参数(例如,鉴别器神经网络中神经网络节点的权重和偏差)集描述。

[0054]

在操作3.3中,将所述鉴别器神经网络应用于高质量地面真值空间uv图,生成重建的高质量地面真值空间uv图,其中,高质量地面真值空间uv图对应于低质量空间uv图。高质量地面真值空间uv图和低质量空间uv图可以是来自训练数据集中的训练对,两者都代表相同的对象,但以不同的质量捕获(例如,由不同的3d摄像机系统捕获)。

[0055]

在操作3.4中,根据所述候选高质量空间uv图和所述重建的候选高质量空间uv图的比较,更新所述生成器神经网络的参数。比较可以通过生成器损失函数执行。优化过程,如梯度下降,可以应用于损失函数,以确定对生成器神经网络参数进行更新。在更新生成器神经网络的参数时,还可以使用所述候选高质量空间uv图与所述对应的地面真值高质量空间uv图之间的比较。

[0056]

在操作3.5中,根据所述候选高质量空间uv图和所述重建的候选高质量空间uv图

的比较以及所述高质量地面真值空间uv图和所述重建的高质量地面真值空间uv图的比较,更新所述鉴别器神经网络的参数。上述比较可以由鉴别器损失函数执行。优化过程,如梯度下降,可以应用于损失函数,以确定对鉴别器神经网络参数进行更新。

[0057]

操作3.1至操作3.5可以是迭代的,直到满足阈值条件。在每次迭代期间,可以使用来自训练数据集的不同空间uv图。

[0058]

图4示出了预处理3d面部数据的示例性方法的概述。在一些实施例中,原始3d面部数据不能由本文描述的神经网络直接处理。预处理步骤400用于将该原始3d数据转换为可由生成器和/或鉴别器神经网络处理的uv面部图。下面的描述将从预处理训练数据的角度描述预处理方法,但很明显,该方法的元素可以同样地应用于增强3d面部数据的方法,例如,如上文结合图1所述。

[0059]

在训练神经网络之前,在训练数据集中识别高质量原始扫描(y

r

)和低质量原始扫描(x

r

)402对。相应的网格对描绘了相同的主题,但在顶点数和三角测量方面具有不同的结构(例如,拓扑)。请注意,高质量原始扫描的顶点数不一定大于低质量原始扫描的顶点数;正确体现人脸特征是决定整体扫描质量的关键。例如,一些生成具有大量顶点的扫描的扫描仪可能会使用导致不必要点相互叠加的方法,从而生成表面细节较少的复杂图形。在一些实施例中,高质量的原始扫描(y

r

)也以这种方式进行预处理。3d

[0060]

高质量原始扫描(y

r

)和低质量原始扫描(x

r

)(402)各自映射到模板404(t),该模板404(t)以相同的拓扑描述这两个扫描。这些模板的一个示例是lsfm模型。模板包括多个顶点,足以描绘高层次的面部细节(在lsfm模型的示例中,有54000个顶点)。

[0061]

在训练期间,高质量原始扫描(y

r

)和低质量原始扫描(x

r

)402的原始扫描通过将模板网格404非刚性地变成每个原始扫描,从而具有对应关系。模板网格的非刚性变形可以使用最优步长非刚性迭代最近点(non

‑

rigid iterative closest point,nicp)算法等执行。例如,顶点可以根据从面部扫描中的给定特征(例如鼻尖)测量的欧几里德距离加权。例如,从鼻尖到给定顶点的距离越大,分配给该顶点的权重就越大。这样可以帮助删除原始扫描外部区域内的面部扫描中记录的嘈杂信息。

[0062]

然后,面部扫描的网格被转换为稀疏空间uv图406。uv图通常用于存储纹理信息。在此方法中,网格每个顶点的空间位置表示为uv空间中的rbg值。网格将展开到uv空间中,以获取网格顶点的uv坐标。例如,可以使用最佳的圆柱形展开技术来展开网格。

[0063]

在一些实施例中,在将3d坐标存储在uv空间中之前,通过执行通用普氏分析(generalprocrustes analysis,gpa)来对齐网格。网格也可以归一化为[

‑

1,1]比例。

[0064]

然后,稀疏空间uv图406转换为具有更多顶点数的插值uv图408。可以在uv域中使用二维插值来填充缺失区域,以产生最初稀疏uv图406的密集图示。这种插值方法的示例包括二维最近点插值或重心插值。

[0065]

在顶点数大于50000的实施例中,uv图大小可以选择为256

×

256

×

3,这样可以帮助检索具有可忽略的重采样误差的高精度点云。

[0066]

图5示出了预训练鉴别器神经网络500的示例性方法的概述.在一些实施例中,鉴别器神经网络204在与生成器神经网络202进行对抗训练之前经过预训练。预训练鉴别器神经网络204可以减少生成对抗训练中模式崩溃的发生。

[0067]

鉴别器神经网络204在高质量的真实面部uv图502上进行预训练。将真实高质量空

间uv图502输入到鉴别器神经网络204中,鉴别器神经网络204生成真实高质量空间uv图502的嵌入,并根据嵌入生成重建的真实高质量空间uv图504。根据真实高质量空间uv图502和重建的真实高质量空间uv图504的比较,更新鉴别器神经网络204的参数。鉴别器损失函数506可以用于将真实高质量空间uv图502和重建的真实高质量空间uv图504进行比较,例如,

[0068]

鉴别器神经网络204经过预训练的数据(即,预训练数据)可以与上述对抗训练中使用的训练数据不同。例如,预训练期间使用的批处理大小可以是16。

[0069]

可以执行预训练,直到满足阈值条件。阈值条件可以是训练周期的阈值数量。例如,可以针对300个周期执行预训练。学习率可能会在小于阈值的数量的周期后改变,例如每30个周期改变一次。

[0070]

可以根据经过预训练的鉴别器神经网络的参数选择鉴别器神经网络204和生成器神经网络202的初始参数。

[0071]

图6示出了用于增强3d面部数据的神经网络的结构的示例。这样的神经网络架构可用于鉴别器神经网络204和/或生成器神经网络202。

[0072]

在这个示例中,神经网络106的形式是自动编码器。神经网络包括一组编码器层600,用于根据面部扫描的输入uv图604生成嵌入602。神经网络还包括一组解码器层608,用于根据嵌入602生成面部扫描的输出uv图610。

[0073]

编码器层600和解码器层608各自包括多个卷积层612。每个卷积层612可用于将一个或多个卷积滤波器应用到卷积层612的输入。例如,一个或多个卷积层612可以应用内核大小为3、步长为1和填充大小为1的二维卷积块。但是,可以选择或替代地使用其它内核大小、步长和填充大小。在所示的示例中,编码层600中总共有12个卷积层612,解码层608中总共有13个卷积层612。也可以使用其它数量的卷积层612。

[0074]

与编码器层600的卷积层612交错的是多个子采样层614(在本文中也称为下采样层)。一个或多个卷积层612可以位于各个子采样层614之间。在所示的示例中,各子采样层614之间放置两个卷积层612。每个子采样层614可用于减小到该子采样层的输入的尺寸。例如,一个或多个子采样层可以应用内核大小和步长大小为2的平均二维池化。然而,可以选择或替代地使用其它子采样方法和/或子采样参数。

[0075]

一个或多个全连接层616也可以存在于编码器层600中,例如作为输出嵌入602的编码器层的最后一层(即,在自动编码器的瓶颈处)。全连接层616将输入张量投射到本征向量,或者反之亦然。

[0076]

通过执行一系列卷积和子采样操作,然后由全连接层616生成大小为h(瓶颈大小为h)的嵌入602,编码器层600作用于面部扫描的输入uv图604(在此示例中,包括256

×

256

×

3张量,即256

×

256个rbg值,尽管也可能是其它大小)上。在所示的示例中,h等于128。

[0077]

与解码器层608的卷积层612交错的是多个上采样层618。一个或多个卷积层612可以位于各个上采样层618之间。在所示的示例中,在上采样层618之间应用两个卷积层612。每个上采样层618用于增大该上采样层的输入维度。例如,上采样层618中的一个或多个上采样层可以应用具有比例因子2的最近邻方法。然而,可以选择或替代地使用其它上采样方法和/或上采样参数(例如,比例因子)。

[0078]

一个或多个全连接层616也可以存在于解码器层608中,例如将嵌入602作为输入

的编码器层的初始层(即,在自动编码器的瓶颈处)。

[0079]

解码器层608还可以包括一个或多个跳跃连接620。跳跃连接620将给定层的输出/输入注入(inject)到后一层的输入中。在所示的示例中,跳跃连接将初始全连接层616的输出注入到第一上调层618a和第二上调层618b中。当使用神经网络106的输出uv图602时,可以产生更引人注目的视觉结果。

[0080]

一个或多个激活函数用于神经网络106的各层中。例如,可以使用elu激活函数。此外或替代地,可以在一个或多个层中使用tanh激活函数。在一些实施例中,神经网络的最后一层可以使用tanh激活函数。此外或替代地,可以使用其它激活功能。

[0081]

图7示出了用于执行本文描述的任何方法的系统/装置的示意性示例。所示的系统/装置是计算设备的示例。本领域技术人员将理解,其它类型的计算设备/系统可替代地用于实现本文所述的方法,例如分布式计算系统。

[0082]

装置(或系统)700包括一个或多个处理器702。一个或多个处理器控制系统/装置700的其它组件的操作。一个或多个处理器702例如可以包括通用处理器。一个或多个处理器702可以是单核设备或多核设备。一个或多个处理器702可以包括中央处理单元(central processing unit,cpu)或图形处理单元(graphical processing unit,gpu)。或者,一个或多个处理器702可以包括专用处理硬件,例如risc处理器或具有嵌入式固件的可编程硬件。可以包括多个处理器。

[0083]

系统/装置包括工作或易失性存储器704。一个或多个处理器可以访问易失性存储器704,以便处理数据,并且可以控制将数据存储在存储器中。易失性存储器704可以包括任何类型的ram,例如静态ram(static ram,sram)、动态ram(dynamic ram,dram),或者可以包括闪存,例如sd卡。

[0084]

系统/装置包括非易失性存储器706。非易失性存储器706存储一组操作指令708,用于以计算机可读指令的形式控制处理器702的操作。非易失性存储器706可以是任何类型的存储器,例如只读存储器(read only memory,rom)、闪存或磁驱动存储器。

[0085]

一个或多个处理器702用于执行操作指令408以使系统/装置执行本文所述的任何方法。操作指令708可以包括与系统/装置700的硬件组件有关的代码(即,驱动程序),以及与系统/装置700的基本操作有关的代码。一般来说,一个或多个处理器702使用易失性存储器704来临时存储在执行所述操作指令708期间生成的数据,从而执行永久或半永久存储在非易失性存储器706中的操作指令708的一个或多个指令。

[0086]

本文描述的方法的实现可以在数字电子电路、集成电路、专门设计的专用集成电路(application specific integrated circuit,asic)、计算机硬件、固件、软件和/或其组合中实现,这些可以包括计算机程序产品(例如,存储在例如磁盘、光盘、存储器、可编程逻辑器件上的软件),包括计算机可读指令,当由计算机(例如结合图7描述的计算机)执行时,使所述计算机执行本文所述的一个或多个方法。

[0087]

本文描述的任何系统特征也可以作为方法特征提供,反之亦然。如本文所使用,装置加功能特征可以根据它们的相应结构来表示。具体地,方法方面可以应用于系统方面,反之亦然。

[0088]

此外,一个方面中的任何、一些和/或所有特征可以以任何适当的组合应用于任何其它方面中的任何、一些和/或所有特征。还应理解,在本发明的任何方面中描述和定义的

各种特征的特定组合可以独立地实现和/或提供和/或使用。

[0089]

虽然已经示出和描述了几个实施例,但本领域技术人员将理解,在不背离本公开的原理的情况下,可以在这些实施例中进行改变,其范围在权利要求中定义。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1