一种基于多视点RGBD相机高分辨率人体三维重建方法与流程

一种基于多视点rgbd相机高分辨率人体三维重建方法

技术领域

1.本发明涉及到计算机视觉中的三维重建技术领域,尤其涉及到一种基于多视点rgbd相机高分辨率人体三维重建方法。

背景技术:

2.近年来随着计算机视觉技术的发展与计算硬件性能的提高,计算机视觉逐步从二维图像处理转向三维重建领域,其中人体模型三维重建是一个研究热点。精确的重建三维人体模型能够为未来的ar/vr交互打下坚实基础。

3.从使用的硬件设备上来看,现有的人体模型三维重建方法大多依赖于rgb相机或者rgbd相机,其中rgb相机无法提供深度信息,不可避免地会出现深度模糊现象,重建质量不高;相较之下,rgbd相机能够提供准确的图像深度信息,模型重建效果更好。

4.从使用相机的数量上来看,多视点相机标定较为复杂但是能够提供更多信息,重建质量高;单视角相机使用方便,但是信息较少。

5.从生成模型的存储方式来看,传统的人体重建大多基于体素(voxel) 表达,是一种显示表达,随着分辨率的提升对存储空间的需求也大幅提升,限制了其模型重建分辨率。

6.还有一些人体重建是基于已有的参数化人体模型,例如smpl模型,具有较强的鲁棒性。但是这些参数化模型只能生成人体模型,无法生成表面的衣物,需要单独计算衣物与人体模型的耦合方式,后续处理复杂。

7.为克服传统人体三维重建分辨率低、内存消耗大等问题,本发明提出了一种基于多视点rgbd相机高分辨率人体三维重建方法。

技术实现要素:

8.本发明的目的是为了克服现有技术的不足,提供了一种基于多视点 rgbd相机高分辨率人体三维重建方法及系统。

9.本发明是通过以下技术方案实现:

10.本发明提供了一种基于多视点rgbd相机高分辨率人体三维重建方法,该方法应用于多视点rgbd相机重建人体模型时,包括以下步骤:

11.s1:准备数据训练集,即利用深度摄像机采集真实人体三维模型并进行预处理,对模型进行不同视角、不同光照、不同背景下的渲染,得到二维图像作为网络训练时的输入;

12.s2:提取图像特征,即将多视点相机捕捉的一组图像作为输入,利用卷积神经网络得到每张图像对应的特征图;

13.s3:对空间点进行采样,即在空间中采用基于高斯曲率采样的方式采样n个点;

14.s4:计算每个采样点投影在多视点相机采集到的图像上的位置,并计算所对应的特征;

15.s5:结合深度摄像机的空间点深度信息,计算每个采样点的psdf作为该采样点对应不同图像特征值融合的权重;

16.s6:利用每个采样点的psdf作为权重对采样点的特征值进行融合,并作为mlp神经网络的输入;

17.s7:通过mlp神经网络预测每个采样点在空间中处于模型表面的概率。

18.优选的,步骤s2中,利用多视点相机捕捉的一组图像数量为k。

19.优选的,步骤s4中,每个采样点共有k组特征。

20.优选的,步骤s2中,使用hrnet提取图像特征。

21.优选的,步骤s3中,采用的高斯曲率采样方法属于自适应采样。

22.优选的,步骤s5中,计算每个采样点的psdf的表达式为: psdf=vz

‑

depth;其中,vz是空间点在相机坐标系下的z轴坐标,depth是深度相机测得的深度。

附图说明

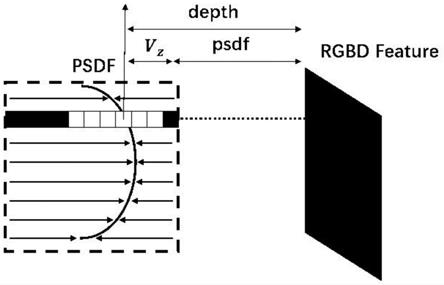

23.图1是psdf方法计算空间点深度的示意图;

24.图2是基于高斯曲率的采样方法的示意图;

25.图3是图片特征融合方法的示意图。

具体实施方式

26.为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

27.为了方便理解本发明实施例提供的基于多视点rgbd相机高分辨率人体三维重建方法及系统,下面结合附图及具体的实施例对其进行详细说明。

28.本发明实施例提供了一种基于多视点rgbd相机高分辨率人体三维重建方法,该方法应用于多视点rgbd相机重建人体模型时,包括以下步骤:

29.s1:准备数据训练集,即利用深度摄像机采集真实人体三维模型并进行预处理,对模型进行不同视角、不同光照、不同背景下的渲染,得到二维图像作为网络训练时的输入。

30.s2:提取图像特征,即将多视点相机捕捉的一组图像作为输入,利用卷积神经网络得到每张图像对应的特征图。该步骤中,利用多视点相机捕捉的一组图像数量为k。该步骤中,具体使用hrnet提取图像特征。

31.s3:对空间点进行采样,即在空间中采用基于高斯曲率采样的方式采样n个点。该步骤中,采用的高斯曲率采样方法属于自适应采样。

32.s4:计算每个采样点投影在多视点相机采集到的图像上的位置,并计算所对应的特征。该步骤中,每个采样点共有k组特征。

33.s5:结合深度摄像机的空间点深度信息,计算每个采样点的psdf作为该采样点对应不同图像特征值融合的权重。

34.s6:利用每个采样点的psdf作为权重对采样点的特征值进行融合,并作为mlp神经网络的输入。

35.s7:通过mlp神经网络预测每个采样点在空间中处于模型表面的概率。

36.上述步骤重建了人体三维模型的几何表面,模型表面的纹理推断步骤与之类同,只是隐函数预测的值转换为空间点对应的rgb颜色,在此不再赘述。

37.上述步骤s5中计算每个采样点的psdf时,采用如图1所示的计算方法,图1是psdf方法计算空间点深度的示意图。如图1所示,图中左侧弧形曲线为三维模型表面,vz是空间点在相机坐标系下的z轴坐标,depth是深度相机测得的深度,则:psdf=vz

‑

depth,替代深度值作为特征值输入。若空间点vz在三维模型表面上,则psdf趋近于0;若空间点vz在三维模型表面内侧或外侧远离三维模型表面,则psdf绝对值会变大。

38.采用上方法应用于多视点rgbd相机重建人体模型时,下面我们以具体的实施例进行举例说明,具体如下:

39.s1:准备数据训练集,数据训练集可来源于商业公司(twindom inc),训练集共包含500个高质量人体三维模型,每个模型渲染60个不同视点,共有30000张二维图像,训练网络输入图像分辨率为512

×

512,包含rgbd 四个通道。

40.s2:使用hrnet提取图像特征,多视点相机共k个视点,单个人体对应k张二维图像输入,经hrnet得到k张特征图。特征图尺寸为64,通道数为256,k取4。

41.s3:对空间点进行采样,具体使用基于高斯曲率的采样方法对空间点进行采样,如图2所示,图2是基于高斯曲率的采样方法的示意图。图2 显示了基于高斯曲率的采样方法。高斯曲率采样方法属于自适应采样,在平滑的表面高斯曲率较小,在高斯曲率小的平滑表面采样点密度低;在复杂的表面附近,例如衣服褶皱、面部等,高斯曲率较大,在高斯曲率大的复杂表面采样点密度大,保留更多的高频成分,能够较好的保存三维重建表面细节。采样点个数为5000,高斯曲率值大小的判断阈值为0.005。

42.s4:计算每个采样点投影在多视点相机采集到的图像上的位置,并计算所对应的特征。具体的,将步骤s3中的采样点投影到k张特征图上,插值得到该点的k组特征值,计算该点的psdf=vz

‑

depth,则该点特征值可以表示为:

43.s5:结合深度摄像机的空间点深度信息,计算每个采样点的psdf作为该采样点对应不同图像特征值融合的权重,即计算空间点特征值。将步骤 s4中计算得到的图片特征与空间点的坐标值与psdf值结合,得到该点的特征值为:f=(f,x,y,z,psdf)。

44.s6:利用每个采样点的psdf作为权重对采样点的特征值进行融合,并作为mlp神经网络的输入,具体来说是将空间点特征值作为mlp网络的输入。如图3所示,图3是图片特征融合方法的示意图,图3显示了图片特征融合方法。对每个空间点对应的一组特征(由k张图片得到k个特征) 进行加权平均,采用每个空间点在k张图片上对应的psdf作为权重。空间点为v,两个相机camera 0,camera 1位于空间不同位置,object为被观测物体,将点v分别投影到camera 0,camera 1捕捉图像的特征图上,得到两组特征f1,f2, 则最终点v的特征值可以表示为:

[0045][0046]

拓展到k个相机:

[0047][0048]

s7:通过mlp神经网络预测每个采样点在空间中处于模型表面的概率,即mlp输出

该空间点是三维重建表面的概率。

[0049]

mlp输出该空间点在三维重建表面的概率之后,计算损失函数。损失函数使用标准最小均方误差(mse)。

[0050]

然后设置训练参数。优化器使用adam优化器,学习率1e

‑

4,每个batch 大小为3,epoch为200,每训练50个epoch学习率下降为原来的十分之一。

[0051][0052]

本发明利用隐式函数表达三维重建后的人体模型,预测空间中各点为重建模型表面的可能性,理论上可以重建任意分辨率模型。利用卷积神经网络提取相机采集到的图像特征并进行融合,结合深度相机采集到的深度信息计算每个空间点的psdf,之后采用全连接层进行预测,从而得到高分辨率的人体三维模型。

[0053]

通过上述描述不难发现,本发明提供的方法能完成人体三维模型几何表面重建,采用相同的步骤同样可完成人体三维模型表面纹理重建,从而得到具有高分辨的的人体三维重建模型,该技术可应用于ar/vr交互与远距离交流等领域。

[0054]

以上仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1