基于深度学习的空间目标相对位姿估计方法与流程

1.本发明涉及一种基于深度学习的空间目标相对位姿估计方法。

背景技术:

2.在空间在轨服务、交会对接和碎片清除的在轨接近操作中,需要精确和鲁棒的位置和姿态估计。然而,空间环境往往非常复杂。例如,空间中的光线强度较高,或出现低光、反射等。另外,在不同视角成像,飞行器有时也会出现在复杂纹理的地球背景中,从而对位姿估计造成干扰。

3.传统的6d目标姿态可以用基于三维模型与图像的局部特征匹配pnp(perspective

‑

n

‑

point)方法,但不适合纹理不足的对象。虽然模板匹配或者密集特征学习方法可以解决纹理不足问题,但对于光照和遮挡比较敏感。并且,密集特征学习方法的特征提取和姿态测量耗时也较长。

4.在轨航天器姿态估计只能依靠诸如单目视觉或红外摄像机、立体摄像机和激光雷达(lidar)等传感器来实现。基于单目相机的姿态估计由于传感器简单,在航天器中具有一定的优势。航天器跟踪和姿态估计的单目解决方案包括:

5.【b.naasz,j.v.eepoel,s.queen,c.m.southward,andj.hannah,“flightresultsfromthehstsm4relativenavigationsensorsystem,”2010】;

6.【j.m.kelsey,j.byrne,m.cosgrove,s.seereeram,andr.k.mehra,“vision

‑

basedrelativeposeestimationforautonomousrendezvousanddocking,”inieeeaerospaceconference,2006】;

7.【c.liuandw.hu,“relativeposeestimationforcylinder

‑

shapedspacecraftsusingsingleimage,”ieeetransactionsonaerospaceandelectronicsystems,vol.50,no.4,2014】;

8.依赖于基于模型的方法,该方法基于启发式将航天器(部件)的线框模型与真实航天器(部件)的边缘图像对齐。

9.基于深度学习算法的姿态估计技术在地面应用中取得了新的进展。这类算法克服了传统的基于图像处理方法,而是试图以端到端的方式学习二维输入图像和6d输出姿态之间的非线性变换。例如:

10.bb8radm.,lepetitv.,bb8:ascalable,accurate,robusttopartialocclusionmethodforpredictingthe3dposesofchallengingobjectswithoutusingdepth,iccv,2017】预测3d物体所构成的3d边界框的8个角点在2d上的投影坐标,得到2d坐标后,使用pnp算法直接得到3d旋转向量和平移向量。

11.sharmas.sharma,c.beierle,ands.d’amico,“poseestimationfornoncooperativespacecraftrendezvoususingconvolutionalneuralnetworks,”inieeeaerospaceconference,pp.1

‑

12,2018】第一次提出了利用卷积神经网络进行航天器姿态估计,该方法基于包围盒检测的位置估计和基于软分类的姿态估计。但是,当目标的一

部分不在视场范围内时,该定位方法失败。

技术实现要素:

12.本发明的目的在于提供一种基于深度学习的空间目标相对位姿估计方法。

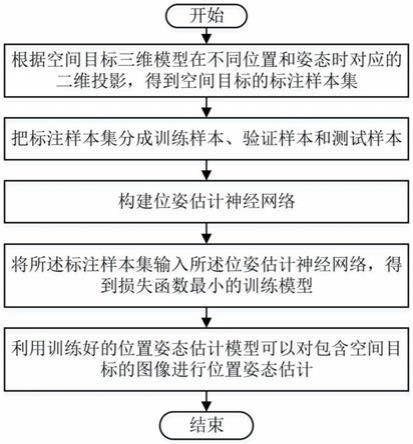

13.为实现上述发明目的,本发明提供一种基于深度学习的空间目标相对位姿估计方法,包括以下步骤:

14.a、利用空间目标三维模型在不同位置及姿态下的二维投影构建标注样本集;

15.b、将标注样本集进行训练集、验证集和测试集的划分,并构建位姿估计神经网络;

16.c、将训练集和验证集输入至构建的位姿估计神经网络中进行训练,得到位姿估计模型;

17.d、利用训练得到的位姿估计模型对测试集进行测试,得到测试集中每个样本的空间目标的位姿信息。

18.根据本发明的一个方面,在所述步骤(a)中,所述标注样本集中的每个样本包括位置(x,y,z)、姿态以及所述位置和所述姿态对应的图像,所述姿态用四元数表示。

19.根据本发明的一个方面,在所述步骤(a)中,将空间目标三维模型输入到3dsmax软件,在3dsmax软件中加入相机,并设定相机的位置、姿态以及视场角、图像的宽度和高度,将相机的位置和姿态作为基准,调整三维模型相对于相机的位置和姿态,相机对三维模型进行二维成像,保存三维模型相对于相机的位置和姿态以及该位置和姿态下对应的图像,生成所述标注样本集;

20.或者,将空间目标三维模型输入到成像仿真软件中,在成像仿真软件中加入相机,并设定相机的位置、姿态以及视场角、图像的宽度和高度,将相机的位置和姿态作为基准,调整三维模型相对于相机的位置和姿态,相机对三维模型进行二维成像,保存三维模型相对于相机的位置和姿态以及该位置和姿态下对应的图像,生成所述标注样本集;

21.所述成像仿真软件为基于osg开发的成像仿真软件,并在所述成像仿真软件中给定相机参数和空间目标三维模型参数,通过相机对空间目标三维模型成像生成二维图像;其中,

22.相机参数包括相机位置(x

cam

,y

cam

,z

cam

)、相机三轴姿态角(pitch

cam

,yaw

cam

,roll

cam

)、相机视场角和图像的宽度和高度;

23.空间目标三维模型参数包括空间目标三维模型位置(x

obj

,y

obj

,z

obj

)和空间目标三维模型三轴姿态角(pitch

obj

,yaw

obj

,roll

obj

)。

24.根据本发明的一个方面,在所述步骤(b)中,将所述标注样本集按照7:2:1的比例随机划分出训练集、验证集和测试集。

25.根据本发明的一个方面,在所述步骤(b)中,基于深度卷积残差网络resnet构建位姿估计神经网络;

26.在构建网络时,将样本图像输入到以残差卷积神经网络为骨干网络构成的网络,然后将输出的二维特征图输入到可变维度的瓶颈层中,进行降维卷积处理,最终将特征图经过拉平成一维数组后,再通过两个分支分别输出位置和姿态信息。

27.根据本发明的一个方面,将所述骨干网络分为stage1,stage2,stage3,stage4,stage5五个部分;

28.stage1由1个卷积层和1个最大池化层构成;

29.stage1中卷积层的卷积核大小为(7,7)、卷积步长为(2,2)、通道数为64,最大池化层下采样因子为(3,3),步长为(2,2);

30.stage2由1个conv_block和2个identity_block构成;stage2中conv_block和identity_block的三个通道数均为64,64,256;

31.stage3由1个conv_block和4个identity_block构成;stage3中conv_block和identity_block的三个通道数均为128,128,512;

32.stage4由1个conv_block和8个identity_block构成;stage4中conv_block和identity_block的三个通道数均为256,256,1024;

33.stage5由1个conv_block和2个identity_block构成;stage5中conv_block和identity_block的三个通道数均为512,512,2048。

34.根据本发明的一个方面,将stage5的输出特征输入到bottleneck层,bottleneck层是由可调节通道数的3

×

3卷积核进行二维卷积,步长为(2,2)。

35.根据本发明的一个方面,将bottleneck层的输出特征分别输入到位置估计结构和姿态估计结构。

36.根据本发明的一个方面,将bottleneck层的输出特征输入到位置估计结构,并采取两层全连接层结构以回归方式输出三维信息;

37.第一个全连接层用于将拉平后的特征图信息再进行降维操作,压缩至1024个维度,经过relu激活函数后,再将该层输出数据输入到下一个全连接层,最终输出为三维坐标信息(x,y,z);

38.将bottleneck层的输出特征输入到姿态估计结构,并采取两层全连接层结构以回归方式输出估计的四元数;

39.第一个全连接层用于将拉平后的特征图信息再进行降维操作,压缩至1024个维度,经过relu激活函数后,再将该层输出数据输入到下一个全连接层,最终输出为用四元数表示的姿态信息。

40.根据本发明的一个方面,在所述步骤(c)的训练网络的过程中,将所述标注样本集中的训练样本和验证样本输入位姿估计神经网络进行训练,选取损失函数最小的模型作为训练模型;

41.其中,损失函数由位置损失项和姿态损失项加和得到:

42.loss=loss

位置

+loss

姿态

;

43.其中,loss为总损失函数,采取相对误差形式,loss

位置

为位置损失项,loss

姿态

为姿态损失项;

44.位置损失函数loss

位置

为:

[0045][0046]

姿态损失函数loss

姿态

为:

[0047][0048]

其中,m为训练样本数,i=1,2,

…

,m,位置估计值

(i)

、位置真值

(i)

分别表示第i个样本的位置估计值、标注位置值,姿态估计值四元数

(i)

、姿态真值四元数

(i)

分别表示第i个样本的用四元数表示的姿态估计值、标注姿态值。

[0049]

根据本发明的构思,先对三维模型的空间目标进行样本标注,标注时获得空间目标三维模型在不同位置和姿态的二维投影,并记录空间目标对应位置和姿态的信息,从而得到含有位置和姿态信息的标注样本集。然后构建位姿估计神经网络,并将标注样本集输入位姿估计神经网络后对其进行训练,得到损失函数最小的训练模型。最后将空间目标图像输入到训练模型中,得到空间目标的位置和姿态信息。由此,本发明实现了通过单幅图像、简单的回归模型就能够同时估计出空间目标的位置和姿态信息,适用于空间目标的位姿估计。

附图说明

[0050]

图1示意性表示本发明的一种实施方式的基于深度学习的空间目标相对位姿估计方法的流程图;

[0051]

图2示意性表示本发明的一种实施方式的位姿估计神经网络的结构图;

[0052]

图3示意性表示本发明的一种实施方式的测试样本的姿态估计精度统计结果图;

[0053]

图4示意性表示本发明的一种实施方式的测试样本的位置估计精度统计结果图;

[0054]

图5和图6分别示意性表示本发明的两种示例的位姿真值和估计值图。

具体实施方式

[0055]

为了更清楚地说明本发明实施方式或现有技术中的技术方案,下面将对实施方式中所需要使用的附图作简单地介绍。显而易见地,下面描述中的附图仅仅是本发明的一些实施方式,对于本领域普通技术人员而言,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0056]

下面结合附图和具体实施方式对本发明作详细地描述,实施方式不能在此一一赘述,但本发明的实施方式并不因此限定于以下实施方式。

[0057]

参见图1,本发明的基于深度学习的空间目标相对位姿估计方法,首先对三维模型的空间目标进行样本标注,具体为利用空间目标三维模型在不同位置及姿态下的二维投影构建含有位置和姿态信息的标注样本集。然后将标注样本集进行训练集、验证集和测试集的划分,并构建位姿估计神经网络。并将训练集和验证集输入至构建的位姿估计神经网络中进行训练,得到位姿估计模型。最终将利用训练得到的位姿估计模型对测试集进行测试,得到测试集中每个样本的空间目标的位姿信息。

[0058]

本发明中,标注样本集中的每个样本包括用三个平移量表示的位置(x,y,z)、姿态以及当前位置和姿态对应的图像,姿态用四元数表示。本发明对于空间目标的三个位置和姿态的选取视角不作特别限定,只要能够利用之确定空间目标的位姿即可,例如,可以使x,y,z形成三维直角坐标系。在提取样本时,可将空间目标三维模型输入到成像仿真软件中,

在成像仿真软件中加入相机,并设定相机的位置、姿态以及视场角、图像的宽度和高度,将相机的位置和姿态作为基准,调整三维模型相对于相机的位置和姿态,相机对三维模型进行二维成像,保存三维模型相对于相机的位置和姿态以及该位置和姿态下对应的图像,生成标注样本集。本发明中,成像仿真软件是基于osg开发的成像仿真软件,在该软件中需要给定相机参数和空间目标三维模型参数,其中,相机参数包括相机位置(x

cam

,y

cam

,z

cam

)、相机三轴姿态角(pitch

cam

,yaw

cam

,roll

cam

)、相机视场角、图像的宽度和高度,空间目标三维模型参数包括空间目标三维模型位置(x

obj

,y

obj

,z

obj

)、空间目标三维模型三轴姿态角(pitch

obj

,yaw

obj

,roll

obj

);通过相机对空间目标三维模型成像生成二维图像。或者,也可将空间目标三维模型输入到3dsmax软件,在3dsmax软件中加入相机,并设定相机的位置、姿态以及视场角、图像的宽度和高度,将相机的位置和姿态作为基准,调整三维模型相对于相机的位置和姿态,相机对三维模型进行二维成像,保存三维模型相对于相机的位置和姿态以及该位置和姿态下对应的图像,生成标注样本集。

[0059]

按照上述任意方法即可提取出空间目标的二维投影图像并利用这些图像完成标注样本集的构建。随后,可对构建的标注样本集进行训练集、验证集和测试集的划分。在本实施方式中,将标注样本集按照7:2:1的比例随机划分出训练集、验证集和测试集,即按70%、20%和10%的比例将标注样本集随机分成训练样本、验证样本和测试样本。

[0060]

完成上述样本集的划分以后,即可利用标注样本集构建位姿估计神经网络。本发明中,位姿估计神经网络基于深度卷积残差网络resnet所修改的网络模型进行构建。由于残差网络中的基本单元残差块具有良好的特性,解决了深度增大而损失函数增大的现象,因此本发明采取该网络为基本模型进行设计。总体来说,在构建网络时,首先将样本图像输入到以残差卷积神经网络为骨干网络构成的网络,然后将输出的二维特征图输入到可变维度的瓶颈层中,进行降维卷积处理,最终将特征图经过拉平成一维数组后,再通过两个分支分别输出位置和姿态信息。

[0061]

如图2所示,基于残差卷积神经网络构建的骨干网络(backbone)可以分为stage1,stage2,stage3,stage4,stage5五个部分,每部分的组成及相应参数如下:

[0062]

stage1由1个卷积层和1个最大池化层构成;

[0063]

stage1中卷积层的卷积核大小为(7,7)、卷积步长为(2,2)、通道数为64,最大池化层下采样因子为(3,3),步长为(2,2);

[0064]

stage2由1个conv_block和2个identity_block构成;stage2中conv_block和identity_block的三个通道数均为64,64,256;

[0065]

stage3由1个conv_block和4个identity_block构成;stage3中conv_block和identity_block的三个通道数均为128,128,512;

[0066]

stage4由1个conv_block和8个identity_block构成;stage4中conv_block和identity_block的三个通道数均为256,256,1024;

[0067]

stage5由1个conv_block和2个identity_block构成;stage5中conv_block和identity_block的三个通道数均为512,512,2048。

[0068]

按照上述构建网络的步骤可知,本发明将stage5的输出特征输入到bottleneck层,bottleneck层是由可调节通道数的3

×

3卷积核进行二维卷积,步长为(2,2)。从而降低输出维度,为后面全连接层的运算极大地减少了参数量,从而降低了训练时间。随后即可将

bottleneck层的输出特征分别输入到位置估计结构和姿态估计结构两个分支。

[0069]

在将bottleneck层的输出特征输入到位置估计结构步骤中,本发明采取了两层全连接层结构直接以回归方式输出三维信息。其中,第一个全连接层用于将拉平后的特征图信息再进行降维操作,压缩至1024个维度,经过relu激活函数后,再将该层输出数据输入到下一个全连接层,最终输出为三维坐标信息(x,y,z)。在将bottleneck层的输出特征输入到姿态估计结构的步骤中,本发明采取了两层全连接层结构直接以回归方式输出估计的四元数。其中,第一个全连接层用于将拉平后的特征图信息再进行降维操作,压缩至1024个维度,经过relu激活函数后,再将该层输出数据输入到下一个全连接层,最终输出为用四元数表示的姿态信息(q1,q2,q3,q4)。

[0070]

经过上述步骤即可构建出基本的位姿估计神经网络,随后需要对该网络进行训练,使其能够成为位姿估计模型。在训练网络的过程中,将标注样本集中的训练样本和验证样本输入位姿估计神经网络,对其进行训练,并选取损失函数最小的模型作为最终的训练模型。随后将测试样本(即测试集)输入到位姿估计神经网络中,利用训练的模型对测试样本进行测试,从而得到空间目标的位姿测试结果,即每个样本的位姿信息。本发明中,损失函数为位置损失项和姿态损失项加和得到。另外,由于所得的位置和姿态信息相互独立,属于不同类别,因此需设计两个分支结构,即图2中下方用两个箭头分出的两个分支,并对两个分支设计相应的损失函数,再进行加和,从而得到损失函数为:

[0071]

loss=loss

位置

+loss

姿态

;

[0072]

其中,loss为总损失函数,采取相对误差形式,loss

位置

为位置损失项,loss

姿态

为姿态损失项。

[0073]

位置损失函数loss

位置

为:

[0074][0075]

姿态损失函数loss

姿态

为:

[0076][0077]

在位置和姿态的表达式中,m为训练样本数,i=1,2,

…

,m,其为循环变量,位置估计值

(i)

、位置真值

(i)

分别表示第i个样本的位置估计值、标注位置值,姿态估计值四元数

(i)

、姿态真值四元数

(i)

分别表示第i个样本的用四元数表示的姿态估计值、标注姿态值。

[0078]

训练得到最终的训练模型后,即可利用之对包含空间目标的图像进行位置姿态估计,从而得到空间目标的位置和姿态信息。

[0079]

图3示出了100幅测试样本的姿态估计精度统计结果图,平均值为3.71

°

,图4示出了100幅测试样本的位置估计精度统计结果图,平均值为0.389m。图5和图6示出了目标姿态标注值与估计值的比较。图5左侧图像是位姿标注的真值,位置真值为(

‑

0.9979,0.3473,65.5559),姿态四元数真值为(

‑

0.6179,0.1311,0.0299,0.7747);图5右侧图像是位姿估计值,位置估计值为(

‑

0.9779,0.288,65.1297),姿态四元数估计值为(

‑

0.6248,0.146,0.022,0.7666);得到位置误差为0.44m,姿态误差为2.28

°

。图6左侧图像是位姿标注的真

值,位置真值为(

‑

3.9179,

‑

16.5673,65.974),姿态四元数真值为(

‑

0.8,0.15,

‑

0.059,0.5778);图6右侧图像是位姿估计值,位置估计值为(

‑

3.8477,

‑

16.3197,65.7765),姿态四元数估计值为(

‑

0.7933,0.1419,

‑

0.0296,0.591);得到位置误差为0.32m,姿态误差为3.93

°

。

[0080]

总体来讲,利用本发明的空间目标相对位姿估计方法对空间目标的位置和姿态的估计值与真值相差较小,精度较高,适用于空间目标位姿估计技术领域。实现了通过单幅图像的回归模型就能够同时估计出空间目标的位置和姿态信息,适用于空间复杂光照条件下的目标位姿估计。从而解决了空间目标位姿估计难的技术问题。

[0081]

以上所述仅为本发明的一个实施方式而已,并不用于限制本发明,对于本领域的技术人员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1