一种基于点云预处理和ShuffleNet的移动端三维位姿估计方法

一种基于点云预处理和shufflenet的移动端三维位姿估计方法

技术领域

1.本发明属于计算机技术领域,涉及一种基于点云预处理和shufflenet的移动端三维位姿估计方法,可以广泛应用于机器人抓取、车辆智能导航、增强现实和医学诊断等领域。

背景技术:

2.三维位姿估计在机器人抓取、车辆智能导航、增强现实和医学诊断等领域中起着十分关键的作用。目前主流位姿估计方法分为两大类,一类是基于二维图像的识别方法,这种方法对输入的rgb或rgb

‑

d图像预测物体的1个中心点和8 个角点,然后通过pnp或epnp算法得到物体的6d姿态。该类算法实时性较好但准确度较低。另一类则基于点云数据进行定位,这种方法首先使用深层网络在 3d点云数据与2d图像之间建立对应关系,然后通过pnp或epnp算法得到物体的6d姿态。由于使用了点云数据,因此精度比第一类更高,但比较而言速度更低。

3.手机移动端具有普及率高携带方便的优点,但由于硬件配置远低于pc,采用常规算法识别速度难以满足要求。而配置需要外接的激光雷达和深度摄像头将削弱其便携优势,移动端只能采用rgb视频流识别方案,导致位姿分析的准确度不高。

[0004][0005]

本发明主要针对移动端在辅助工业应用领域对目标位姿估计的需求,提供了一种基于点云预处理和shufflenet的移动端三维位姿估计方法。

[0006]

本发明所采用的设计方案是:一种基于点云预处理和shufflenet的移动端三维位姿估计方法,包括以下步骤:

[0007]

步骤1:对激光扫描得到的目标点云数据进行三维重建;将三维重建获得的三维模型导入渲染引擎以供拍照;

[0008]

步骤2:采用定位旋转拍照算法分别获取目标在不同视角下的二维照片及相机位姿;通过sift提取二维照片特征点并计算对应三维特征点,将目标模型划分为大小相等的体素块,根据三维特征点数量筛选目标关键体素块;生成关键体素块在照片集上的二维投影并建立训练数据集;通过shufflenetv2

‑

yolov3轻量级网络训练针对目标的shufflenet特征检测模型;

[0009]

步骤3:将视频流输入训练好的shufflenetv2

‑

yolov3目标关键体素块的检测模型,识别关键体素块得到2d

‑

3d匹配点对,结合ransac和epnp算法计算目标相对位姿;

[0010]

步骤4:结合移动端gps和imu信息计算目标在三维世界中的绝对位姿。

[0011]

本发明结合两类三维位姿估计算法的优点,首先在pc端进行预处理。为目标点云数据通过delaulay算法重建三维模型。本发明采用定位旋转拍照和关键体素块提取算法自动生成目标体素特征检测数据集,采用具备轻量级高性能优势适用于移动端计算的shufflenetv2

‑

yolov3训练特征检测模型。

[0012]

本发明在识别阶段充分利用移动端硬件设备优势,引入gps和imu数据定位移动端位姿。通过训练好的shufflenetv2

‑

yolov3模型检测目标关键体素块,再采用ransac和epnp算法计算得到目标的与移动端摄像头间的相对位姿。最后计算出目标在三维世界的绝对位姿。在手机移动端普及率超90%的今日,本发明能在移动端提供不依赖于深度摄像头和激光设备,实时性和准确度达到工业辅助应用要求的位姿估计,具有便携实用易推广的优势。

附图说明

[0013]

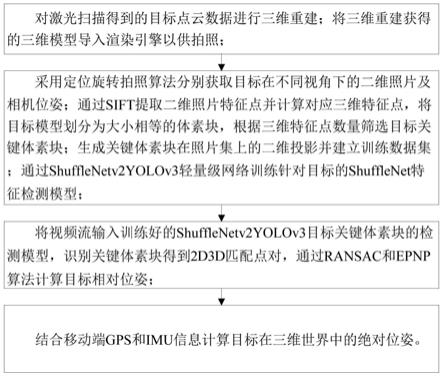

图1为本发明实施例的流程图。

[0014]

图2为本发明实施例的原理框图。

具体实施方式

[0015]

为了便于本领域普通技术人员理解和实施本发明,下面结合附图及实施例对本发明作进一步的详细描述,应当理解,此处所描述的实施示例仅用于说明和解释本发明,并不用于限定本发明。

[0016]

请见图1和图2,本发明提供的一种基于点云预处理和shufflenet的移动端三维位姿估计方法,包括以下步骤:

[0017]

步骤1:对激光扫描得到的目标点云数据进行三维重建;将三维重建获得的三维模型导入渲染引擎以供拍照;

[0018]

本实施例的具体实现包括以下子步骤:

[0019]

步骤1.1:通过delaulay算法对激光扫描得到目标点云数据进行三维重建,得到目标三维模型;

[0020]

步骤1.2:将目标三维模型导入渲染引擎,计算目标三维模型包围盒及中心点,移动目标三维模型使中心点至原点。

[0021]

步骤2:采用定位旋转拍照算法分别获取目标在不同视角下的二维照片及相机位姿;通过sift提取二维照片特征点并计算对应三维特征点,将目标模型划分为大小相等的体素块,根据三维特征点数量筛选目标关键体素块;生成关键体素块在照片集上的二维投影并建立训练数据集;通过shufflenetv2

‑

yolov3轻量级网络训练针对目标的shufflenet特征检测模型;

[0022]

本实施例的具体实现包括以下子步骤:

[0023]

步骤2.1:在三维引擎中对目标拍照得到目标照片;

[0024]

步骤2.2:通过sift算法检测目标照片中的二维特征点,得到特征点集 k={k1,...,k

n

};

[0025]

步骤2.3:通过屏幕射线投影算法计算每个特征点k

i

对应的三维坐标点p

i

,将二维特征点对应的三维特征点集记为p={p1,...,p

n

};

[0026]

步骤2.4:相机围绕目标旋转并继续为目标拍照,重复步骤2.2和步骤2.3直到得到目标的多视角照片并计算得到三维特征点集ps={p1,...,p

n

},其中,n为照片数量,p为每张照片的三维特征点集;

[0027]

步骤2.5:将目标三维体素(volume pixel)划分为m个相同体素大小的块 b={b1,...,b

m

};将三维特征点出现在每个体素块中的频率设置为体素块权值q,筛选权值最大

的m个块kb={b1,...,b

m

}作为关键体素块,其中m<m;

[0028]

步骤2.6:将关键体素块作为类别,根据投影变换公式计算其在二维照片集上的区域,生成标注信息,得到训练数据集;

[0029]

步骤2.7:通过生成的数据集训练shufflenetv2

‑

yolov3,得到针对目标关键体素块的检测模型。

[0030]

步骤3:将视频流输入训练好的shufflenetv2

‑

yolov3目标关键体素块的检测模型,识别关键体素块得到2d

‑

3d匹配点对,结合epnp算法计算目标相对位姿;

[0031]

本实施例的具体实现包括以下子步骤:

[0032]

步骤3.1:读取视频流,输入训练好的shufflenetv2

‑

yolov3关键体素块的检测模型,输出为若干关键体素块对应的二维区域;

[0033]

步骤3.2:计算检测到的二维区域中心点,和对应关键体素块中心点组成 2d

‑

3d匹配点对;

[0034]

步骤3.3:通过ransac及epnp算法计算目标与移动端摄像头间的相对位姿。

[0035]

步骤4:通过移动端gps和imu信息计算移动端摄像头在三维世界中的位姿,结合目标与移动端摄像头间的相对位置计算得到目标在三维世界中的绝对位姿;

[0036]

本实施例的具体实现包括以下子步骤:

[0037]

步骤4.1:读取移动端gps和imu数据;

[0038]

步骤4.2:通过步骤4.1获取的数据计算移动端在三维世界中的定位;

[0039]

步骤4.3:通过步骤4.2中计算的移动端位姿和步骤3中计算的目标相对位姿计算出目标在三维世界中的绝对位姿。

[0040]

本发明实时位姿估计在移动端,从移动端摄像头读取视频流,使用shufflenet 模型得到目标在rgb图像中的特征点,再通过ransac和epnp算法得到相对位姿。本发明充分利用移动端优势,通过移动端gps和imu提供的定位信息,结合相对位姿计算目标在实际三维世界中的位姿。

[0041]

应当理解的是,本说明书未详细阐述的部分均属于现有技术。

[0042]

应当理解的是,上述针对较佳实施例的描述较为详细,并不能因此而认为是对本发明专利保护范围的限制,本领域的普通技术人员在本发明的启示下,在不脱离本发明权利要求所保护的范围情况下,还可以做出替换或变形,均落入本发明的保护范围之内,本发明的请求保护范围应以所附权利要求为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1