一种情绪分析方法、装置、设备及存储介质与流程

1.本技术涉及数据处理技术领域,尤其涉及一种情绪分析方法、装置、设备及存储介质。

背景技术:

2.在某些场景下,工作人员需要对目标对象在问答过程中的情绪进行分析。例如:目标对象经历了特定事件,目标对象在问答过程中的情绪可以提供关于特定事件的信息,工作人员通过分析目标对象在问答过程中的情绪可以获知目标对象在问答过程中所提供的事件信息的可信度。

3.目前,计算机在获取到目标对象在问答过程中拍摄的视频后,对该视频进行分析,确定并显示情绪信息(该情绪信息用于表征目标对象在问答过程中的情绪)。这样,工作人员即可根据计算机显示的情绪信息,分析确定目标对象提供的事件信息的可信度。

4.但是,上述方案工作人员依旧无法直接确定出目标对象在问答过程中何时、受哪些话语触发产生可信度低/波动的情绪或行为,换言之,上述方案工作人员依旧无法及时、准确地发现事件调查突破口。而调查突破口的及时、准确发现对工作人员准确、全面了解事件是很关键的。

技术实现要素:

5.本技术实施例提供一种情绪分析方法、装置、设备及存储介质,可以自动分析目标对象的目标信息并关联显示目标信息和与目标信息关联的语音文本,解决目前的方案无法使工作人员及时、准确地发现事件调查突破口的问题。

6.为达到上述目的,本技术的实施例采用如下技术方案:

7.第一方面,提供了一种情绪分析方法,该情绪分析方法包括:获取待分析视频,待分析视频记录了语音数据和图像数据;并确定待分析视频中目标对象的目标信息,其中,目标信息包括目标情绪信息、目标行为特征中至少一项信息;然后关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

8.本技术提供的情绪分析方法,可以自动分析出目标对象的目标信息,并关联显示目标信息和与目标信息关联的目标语音文本,可以使工作人员直观且方便地根据关联显示的目标信息与目标语音文本及时、准确地发现事件调查突破口,进而准确、全面了解事件,为工作人员做出准确判断提供直接、强有力的支持。

9.结合上述第一方面,在一种可能的实现方式中,关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本,包括:按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本;或者,将目标信息、与目标信息关联的语音数据对应的目标语音文本显示在同一显示区域;或者,以同一显示方式显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

10.结合上述第一方面,在一种可能的实现方式中,该情绪分析方法还包括:显示目标

信息的标签;标签用于指示目标信息的类型;或标签用于指示与目标信息对应的处理信息。

11.可以通过显示的标签直观提示工作人员目标信息的类型或与目标信息对应的处理信息。

12.结合上述第一方面,在一种可能的实现方式中,关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本,包括:以时间轴的形式按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本;显示目标信息的标签,包括:在时间轴上显示目标信息的标签。

13.结合上述第一方面,在一种可能的实现方式中,该情绪分析方法还包括:以第一显示方式显示除目标语音文本之外的其他语音文本;以第二显示方式显示目标语音文本。

14.以不同的显示方式显示目标语音文本和其他语音文本,可以方便工作人员区分目标语音文本和其他语音文本。

15.结合上述第一方面,在一种可能的实现方式中,该情绪分析方法还包括:确定所述目标信息的类型;对于同一种类型目标信息,每一目标信息与对应的所述目标语音文本之间的关联显示方式相同;或者,确定所述目标信息对应的处理信息的类型;对于同一种类型处理信息,每一处理信息对应的目标信息与该目标信息对应的所述目标语音文本之间的关联显示方式相同。

16.可以方便工作人员直观地根据显示方式确定和区分不同类型的或对应不同处理信息的目标信息、以及与目标信息关联的目标语音文本。

17.结合上述第一方面,在一种可能的实现方式中,确定待分析视频中目标对象的目标情绪信息,包括:利用预设的识别算法,对待分析视频中目标对象的对象特征进行分析,确定参数;参数包括:眼动频率、眨眼频率、异常行为中至少之一;异常行为包括:撅嘴、咬嘴唇、吐舌头中至少之一;根据参数,确定目标对象的情绪信息;从情绪信息中确定待分析视频中目标对象的目标情绪信息。

18.结合上述第一方面,在一种可能的实现方式中,参数还包括以下一项或多项信息:目标对象的情绪波动频率信息、目标对象的负面情绪占比信息、目标对象的声强信息、目标对象的音调信息、目标对象的语速信息;根据参数,确定目标对象的情绪信息,包括:根据所述参数,确定综合指标,并将综合指标作为情绪信息。

19.第二方面,本技术提供一种情绪分析装置,包括:通信单元、处理单元和显示单元。

20.上述通信单元,用于获取待分析视频,待分析视频记录了语音数据和图像数据;上述处理单元,用于确定待分析视频中目标对象的目标信息,其中,目标信息包括目标情绪信息、目标行为特征中至少一项信息;上述显示单元,用于关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

21.结合上述第二方面,在一种可能的实现方式中,上述显示单元具体用于:按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本;或者,将目标信息、与目标信息关联的语音数据对应的目标语音文本显示在同一显示区域;或者,以同一显示方式显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

22.结合上述第二方面,在一种可能的实现方式中,上述显示单元还用于:显示目标信息的标签;标签用于指示目标信息的类型;或标签用于指示与目标信息对应的处理信息。

23.结合上述第二方面,在一种可能的实现方式中,上述显示单元,具体用于:以时间

轴的形式按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本;上述显示单元,具体用于:在时间轴上显示目标信息的标签。

24.结合上述第二方面,在一种可能的实现方式中,上述显示单元还用于:以第一显示方式显示除目标语音文本之外的其他语音文本;以第二显示方式显示目标语音文本。

25.结合上述第二方面,在一种可能的实现方式中,上述处理单元还用于:确定所述目标信息的类型;对于同一种类型目标信息,每一目标信息与对应的所述目标语音文本之间的关联显示方式相同;或者,确定所述目标信息对应的处理信息的类型;对于同一种类型处理信息,每一处理信息对应的目标信息与该目标信息对应的所述目标语音文本之间的关联显示方式相同。

26.结合上述第二方面,在一种可能的实现方式中,上述处理单元具体用于:利用预设的识别算法,对待分析视频中目标对象的对象特征进行分析,确定参数;参数包括:眼动频率、眨眼频率、异常行为中至少之一;异常行为包括:撅嘴、咬嘴唇、吐舌头中至少之一;根据参数,确定目标对象的情绪信息;从情绪信息中确定待分析视频中目标对象的目标情绪信息。

27.结合上述第二方面,在一种可能的实现方式中,参数还包括以下一项或多项信息:目标对象的情绪波动频率信息、目标对象的负面情绪占比信息、目标对象的声强信息、目标对象的音调信息、目标对象的语速信息;上述处理单元具体用于:根据参数,确定综合指标,并将综合指标作为情绪信息。

28.第三方面,本技术提供一种电子设备,该电子设备包括存储器和处理器。存储器和处理器,所述存储器用于存储计算机程序,所述处理器用于执行所述计算机程序,以执行如第一方面及其任一种可能的实现方式所述的情绪分析方法。

29.第四方面,本技术提供一种芯片系统,该芯片系统应用于情绪分析装置;所述芯片系统包括一个或多个接口电路,以及一个或多个处理器。所述接口电路和所述处理器通过线路互联;所述接口电路用于从所述情绪分析装置的存储器接收信号,并向所述处理器发送所述信号,所述信号包括所述存储器中存储的计算机指令。当所述处理器执行所述计算机指令时,所述情绪分析装置执行如第一方面及其任一种可能的实现方式所述的情绪分析方法。

30.第五方面,本技术提供一种计算机可读存储介质,该计算机可读存储介质包括计算机指令,当所述计算机指令在计算机上运行时,使得所述计算机执行如第一方面及其任一种可能的实现方式所述的情绪分析方法。

31.第六方面,本技术提供一种计算机程序产品,该计算机程序产品包括计算机指令,当所述计算机指令在情绪分析装置上运行时,使得所述情绪分析装置执行如第一方面及其任一种可能的实现方式所述的情绪分析方法。

32.本技术中第二方面到第六方面及其各种实现方式的具体描述,可以参考第一方面及其各种实现方式中的详细描述;并且,第二方面到第六方面及其各种实现方式的有益效果,可以参考第一方面及其各种实现方式中的有益效果分析,此处不再赘述。

33.本技术的这些方面或其他方面在以下的描述中会更加简明易懂。

附图说明

34.图1为本技术实施例提供的一种分析系统的结构示意图;

35.图2a为本技术实施例提供的另一种分析系统的结构示意图;

36.图2b为本技术实施例提供的一种情绪分析方法的原理图;

37.图3a为本技术实施例提供的又一种分析系统的结构示意图;

38.图3b为本技术实施例提供的另一种情绪分析方法的原理图;

39.图3c为本技术实施例提供的一种分析系统中各设备的部署示意图;

40.图4为本技术实施例提供的一种电子设备的硬件结构图;

41.图5为本技术实施例提供的一种情绪分析方法的流程示意图;

42.图6为本技术实施例提供的一种紧张度综合值示意图;

43.图7为本技术实施例提供的一种文本信息示意图;

44.图8a为本技术实施例提供的一种位于同一区域的文本信息示意图;

45.图8b为本技术实施例提供的另一种位于同一区域的文本信息示意图;

46.图9为本技术实施例提供的另一种情绪分析方法的流程示意图;

47.图10为本技术实施例提供的另一种文本信息示意图;

48.图11为本技术实施例提供的又一种情绪分析方法的流程示意图;

49.图12为本技术实施例提供的再一种情绪分析方法的流程示意图;

50.图13为本技术实施例提供的又一种文本信息示意图;

51.图14为本技术实施例提供的情绪分析装置的一种结构示意图。

具体实施方式

52.以下,术语“第一”、“第二”仅用于描述目的,而不能理解为指示或暗示相对重要性或者隐含指明所指示的技术特征的数量。由此,限定有“第一”、“第二”的特征可以明示或者隐含地包括一个或者更多个该特征。在本实施例的描述中,除非另有说明,“多个”的含义是两个或两个以上。

53.目前,计算机可以在获取到目标对象在问答过程中拍摄的视频后,对该视频进行分析,确定并显示情绪信息(该情绪信息用于表征目标对象在问答过程中的情绪)。这样,工作人员即可根据计算机显示的情绪信息,分析确定目标对象提供的事件信息的可信度。

54.但是,上述方案工作人员依旧无法直接确定出目标对象在问答过程中何时、受哪些话语触发产生可信度低/波动的情绪或行为,换言之,上述方案工作人员依旧无法及时、准确地发现事件调查突破口。而调查突破口的及时、准确发现对工作人员准确、全面了解事件是很关键的。针对上述问题,本技术实施例提供一种情绪分析方法,可以基于待分析视频中的图像数据和语音数据,确定待分析视频中目标对象的目标信息,其中,目标信息包括目标情绪信息、目标行为特征中至少一项信息,并关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本,使得工作人员可以通过显示的语音文本,直观且方便地确定出与显示的语音文本关联的目标信息。

55.本技术实施例提供的情绪分析方法可以适用于分析系统。该分析系统可以包括一体机设备以及显示器。其中,一体机设备可以为一体式个人计算机(personal computer,pc)或者一体式服务器。图1示出了该分析系统的结构。如图1所示,该分析系统包括一体式

设备10和与一体式设备10连接的显示器11。

56.该分析系统中,一体式设备10用于获取待分析视频,待分析视频记录了语音数据和图像数据;还用于确定待分析视频中目标对象的目标信息,其中,目标信息包括目标情绪信息、目标行为特征中至少一项信息。其中,获取的待分析视频可以是实时的,也可以是非实时的。

57.该分析系统中,显示器11用于关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

58.可选的,该分析系统还包括:至少一个用于采集待分析视频中图像数据的第一采集设备、至少一个用于采集待分析视频中语音数据的第二采集设备。其中,第一采集设备和第二采集设备可以集成在一个设备中,也可以位于相互独立的两个设备中,本技术实施例对第一采集设备和第二采集设备的位置关系不作任何限定。

59.可选的,第一采集设备或第二采集设备可以与一体式设备连接。

60.示例性的,图2a示出了上述一体机设备为一体式pc、且还包括第一采集设备和第二采集设备的分析系统的结构。如图2a所示,该分析系统包括一体式pc 20、第一采集设备21、第二采集设备22以及显示器13。其中,一体式pc 20与第一采集设备21、第二采集设备22以及显示器23均连接。本技术实施例对各设备间的连接方式不作具体限定。

61.示例性的,一体式pc 20可以通过通用串行总线(universal serial bus,usb)或以太网等方式与第一采集设备21连接。一体式pc 20可以通过usb或网络连接等方式与第二采集设备22连接。一体式pc 20可以通过视频图形阵列(video graphics array,vga)接口或高清晰度多媒体接口(high definition multimedia interface,hdmi)与显示器23连接。

62.上述一体式pc 20可以为各种个人计算机、笔记本电脑、平板电脑等计算设备。第一采集设备21可以为用于获取图像数据的设备,例如:摄像机、特写摄像机等。第二采集设备22可以为用于获取语音数据的设备,例如拾音器等。

63.在一体式pc 20连接一个第一采集设备21的场景中,一体式pc 20和第一采集设备21可以集成在一个设备中,也可以位于相互独立的两个设备中,本技术实施例对一体式pc 20和第一采集设备21的位置关系也不作任何限定。

64.在一体式pc 20连接一个第二采集设备22的场景中,一体式pc 20和第二采集设备22可以集成在一个设备中,也可以位于相互独立的两个设备中,本技术实施例对一体式pc 20和第二采集设备22的位置关系也不作任何限定。

65.同理,在一体式pc 20连接一个显示器23的场景中,一体式pc 20和显示器23可以集成在一个设备中,也可以位于相互独立的两个设备中,本技术实施例对一体式pc 20和显示器23的位置关系也不作任何限定。

66.现结合图2b对本技术实施例提供的情绪分析方法的原理进行说明。

67.如图2b所示,本技术实施例中,第一采集设备21可以获取待分析视频中的图像数据并将获取的图像数据发送给一体式pc 20。第二采集设备22可以获取待分析视频中的语音数据并将获取的语音数据发送给一体式pc 20。一体式pc 20根据来自第一采集设备21和第二采集设备22的数据,获取待分析视频,该待分析视频记录了语音数据和图像数据。之后,一体式pc 20确定待分析视频中目标对象的目标信息,其中,目标信息包括目标情绪信

息、目标行为特征中至少一项信息。最后,一体式pc 20在连接的显示器23上,关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

68.示例性的,图3a示出了上述一体机设备为一体式服务器、且还包括第一采集设备和第二采集设备的分析系统的结构。如图3a所示,该分析系统包括一体式服务器30、至少一个第一采集设备31、至少一个第二采集设备32以及至少一个运行有万维网(world wide web,web)应用的pc 33。其中,pc 33具有显示屏。

69.一个第一采集设备31可以与一个对应的pc 33连接,一个第二采集设备32可以与一个对应的pc 33连接。一体式服务器30可以与至少一个pc 33中每个pc 33均连接。可选的,该系统包括多个pc 33时,多个pc 33可以通过运行的万维网应用相互连接。

70.在实际应用中,第一采集设备31和第二采集设备32可以集成在一个设备中,也可以位于相互独立的两个设备中,本技术实施例对第一采集设备31和第二采集设备32的位置关系不作任何限定。

71.在一个pc 33连接一个第一采集设备31的场景中,pc 33和第一采集设备31可以集成在一个设备中,也可以位于相互独立的两个设备中,本技术实施例对pc 33和第一采集设备31的位置关系也不作任何限定。

72.在一个pc 33连接一个第二采集设备32的场景中,pc 33和第二采集设备32可以集成在一个设备中,也可以位于相互独立的两个设备中,本技术实施例对pc 33和第二采集设备32的位置关系也不作任何限定。

73.现结合图3b对本技术实施例提供的情绪分析方法的原理进行说明。

74.如图3b所示,本技术实施例中,若第一采集设备31不能与一体式服务器30连接,第一采集设备31可以获取待分析视频中的图像数据并将获取的图像数据发送给连接的pc 33。若第一采集设备31与一体式服务器30连接,第一采集设备31可以获取待分析视频中的图像数据并将获取的图像数据发送给一体式服务器30。若第二采集设备32不能与一体式服务器30连接,第二采集设备32可以获取待分析视频中的语音数据并将获取的语音数据发送给连接的pc 33。若第二采集设备32与一体式服务器30连接,第二采集设备32可以获取待分析视频中的语音数据并将获取的语音数据发送给一体式服务器30。pc 33可以将来自第一采集设备31的图像数据和/或第二采集设备32的语音数据发送给一体式服务器30。一体式服务器30根据来自pc 33的图像数据和语音数据、或者根据来自pc33的图像数据和来自第二采集设备32的语音数据,或者根据来自pc33的语音数据和来自第一采集设备31的图像数据,或者根据来自第一采集设备31的图像数据和来自第二采集设备32的语音数据,获取待分析视频,待分析视频记录了语音数据和图像数据。之后,一体式服务器30确定待分析视频中目标对象的目标信息,其中,目标信息包括目标情绪信息、目标行为特征中至少一项信息。最后,一体式服务器30在连接的pc 33上,关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

75.可以理解的是,因为一体式服务器30可以获取每个pc 33发送的图像与语音数据,所以,在pc 33有多个的情况下,一体式服务器30可以获取多个包含不同目标对象的待分析视频,并确定多个目标对象的目标信息。相应地,在每个pc 33上关联显示与每个pc 33对应的目标信息、与目标信息关联的语音数据对应的目标语音文本。

76.在实际应用中,上述pc 33可以与其连接的第一采集设备31、第二采集设备32被部

署于同一区域,也可以被部署于不同的区域,其中,区域可以理解为地理上一定范围内,例如房间,本技术实施例对此不作具体限定。

77.以一个具体的示例进行解释。如图3c所示,pc 33a分别和第一采集设备31a、第二采集设备32a连接,这三个设备共同被部署于房间a中。pc 33b分别和第一采集设备31b、第二采集设备32b连接,这三个设备共同被部署于房间b中。pc 33c被部署于房间c中。一体式服务器30被部署于房间d中,可以通过网络与pc 33a、pc 33b和pc 33c进行数据交互。可选的,房间c中,还可以包括与pc 33c连接的音箱34。pc 33c可以通过网络,从一体化服务器30获取所有待分析视频的语音数据,或者通过网络从pc 33a获取pc 33a提供的待分析视频的语音数据,或者通过网络从pc 33b获取pc 33b提供的待分析视频的语音数据,并通过与pc 33c连接的音箱34播放工作人员选择的待分析视频的语音数据。

78.上述一体式pc 20和一体式服务器30的基本硬件结构类似,都包括图4所示电子设备所包括的元件。下面以图4所示的电子设备为例,介绍一体式pc 20和一体式服务器30的硬件结构。

79.如图4所示,电子设备可以包括处理器41,存储器42、通信接口43、总线44。处理器41,存储器42以及通信接口43之间可以通过总线44连接。

80.处理器41是电子设备的控制中心,可以是一个处理器,也可以是多个处理元件的统称。例如,处理器41可以是一个通用中央处理单元(central processing unit,cpu),也可以是其他通用处理器等。其中,通用处理器可以是微处理器或者是任何常规的处理器等。

81.作为一种实施例,处理器41可以包括一个或多个cpu,例如图4中所示的cpu 0和cpu 1。

82.存储器42可以是只读存储器(read

‑

only memory,rom)或可存储静态信息和指令的其他类型的静态存储设备,随机存取存储器(random access memory,ram)或者可存储信息和指令的其他类型的动态存储设备,也可以是电可擦可编程只读存储器(electrically erasable programmable read

‑

only memory,eeprom)、磁盘存储介质或者其他磁存储设备、或者能够用于携带或存储具有指令或数据结构形式的期望的程序代码并能够由计算机存取的任何其他介质,但不限于此。

83.一种可能的实现方式中,存储器42可以独立于处理器41存在,存储器42可以通过总线44与处理器41相连接,用于存储指令或者程序代码。处理器41调用并执行存储器42中存储的指令或程序代码时,能够实现本技术下述实施例提供的情绪分析方法。

84.另一种可能的实现方式中,存储器42也可以和处理器41集成在一起。

85.通信接口43,用于电子设备与其他设备通过通信网络连接,所述通信网络可以是以太网,无线接入网(radio access network,ran),无线局域网(wireless local area networks,wlan)等。通信接口43可以包括用于接收数据的接收单元,以及用于发送数据的发送单元。

86.总线44,可以是工业标准体系结构(industry standard architecture,isa)总线、外部设备互连(peripheral component interconnect,pci)总线或扩展工业标准体系结构(extended industry standard architecture,eisa)总线等。该总线可以分为地址总线、数据总线、控制总线等。为便于表示,图4中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

87.需要指出的是,图4中示出的结构并不构成对该电子设备的限定,除图4所示部件之外,该电子设备可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置。

88.本技术实施例提供的情绪分析方法的执行主体为情绪分析装置。该情绪分析装置可以是上述一体式pc 20或者一体式服务器30,也可以是上述一体式pc 20或者一体式服务器30中的cpu,还可以是上述一体式pc 20或者一体式服务器30中用于确定目标信息的控制模块。本技术实施例以情绪分析装置执行情绪分析方法为例,对本技术提供的情绪分析方法进行说明。

89.下面结合附图对本技术实施例提供的情绪分析方法进行描述。

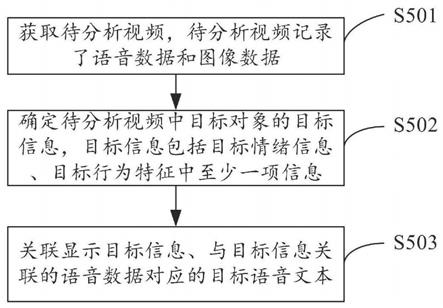

90.如图5所示,本技术实施例提供的情绪分析方法包括步骤s501

‑

s503。

91.s501、情绪分析装置获取获取待分析视频,待分析视频记录了语音数据和图像数据。

92.s502、情绪分析装置确定待分析视频中目标对象的目标信息,目标信息包括目标情绪信息、目标行为特征中至少一项信息。

93.s503、情绪分析装置在与情绪分析装置连接的显示器上关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

94.对于步骤s501,情绪分析装置可以采用下述实现方式一或实现方式二获取待分析视频。

95.实现方式一:情绪分析装置实时获取到第一采集设备采集到的图像数据和第二采集设备采集到的语音数据。本技术涉及到的待分析视频包括情绪分析装置获取到的图像数据和语音数据。这种场景中,可以将待分析视频理解为直播视频或者直播流。

96.其中,第一采集设备与第二采集设备采集数据的时间保持同步。换言之,待分析视频的图像数据需要与语音数据在时间上保持同步。

97.该实现方式中,第一采集设备可以实时获取待分析视频中的图像数据,其中包括目标对象的图像数据。例如摄像机对目标对象进行拍摄,可以获取目标对象实时的视频。第二采集设备可以实时获取待分析视频中的语音数据,其中包括目标对象的语音数据。例如拾音器在目标对象发言时,实时采集目标对象的声音。

98.第一采集设备与第二采集设备获取了对应的数据后,将获取的数据发送给情绪分析装置。情绪分析装置在接收来自第一采集设备的图像数据和第二采集设备的语音数据后,可以将图像数据与语音数据根据时间进行对应,获取记录了语音数据和图像数据的待分析视频。

99.实现方式二:情绪分析装置从网络或本地获取到待分析视频。这种场景中,待分析视频并非实时的直播视频。

100.该实现方式中,可以由情绪分析装置直接从网络或本地获取待分析视频,例如,情绪分析装置为一体式pc时,工作人员可以操作一体式pc从网络获取待分析的视频。

101.或者,由第一采集装置或第二采集装置采集待分析视频中的数据,并将采集的数据存入网络或本地,情绪分析装置从网络或本地获取第一采集设备或第二采集设备存入的数据,进而获取待分析视频。

102.本技术实施例中,待分析视频中可以包括多个对象或一个对象。其中,包括多个对

象时,多个对象中可以包括一个或多个目标对象,包括一个对象时,该对象即为目标对象,本技术实施例对此不做限制。

103.可以理解的是,待分析视频包括多个对象时,待分析视频可以包括多个对象的图像数据,或者,待分析视频可以包括多个对象的语音数据。

104.需要说明的是,本技术实施例中,待分析视频中的图像数据对应的对象可以不与语音数据对应的对象保持一致。示例性的,在通过第一采集设备采集图像数据,第二采集设备采集语音数据的场景中,目标对象为一人时,第一采集设备仅对目标对象一人进行拍摄,图像数据仅包括目标对象,但是,第二采集设备采集了目标对象与另一对象对话时两方的语音数据,因此,该待分析视频中,包括了目标对象的图像数据,以及目标对象与另一对象的语音数据。

105.对于步骤s502,情绪分析装置需要根据待分析视频,确定进行分析的目标对象。

106.对于待分析视频中,仅包括了一个对象的图像数据或语音数据的场景,情绪分析装置将图像数据或语音数据对应的一个对象确定为目标对象。

107.对于待分析视频包括了多个对象的图像数据的场景,可以通过工作人员人工确定的方式确定目标对象。例如,工作人员在与情绪分析装置连接的pc上,操作pc上运行的web应用,在画面中包括的多个对象里选择分析的目标对象。

108.对于待分析视频包括多个对象的语音数据的场景,可以通过拾音器采用麦克风阵列分离式采集多个对象的语音数据,并根据多个对象中每个对象对于拾音器的方位以及目标对象对于拾音器的方位,确定出多个对象的语音数据中目标对象的语音数据。

109.对于步骤s502,情绪分析装置在确定出目标对象后,需要确定目标对象的目标信息,其中,目标信息包括目标情绪信息、目标行为特征中的至少一项信息。本技术实施例中,目标信息包括的信息可以由用户根据实际需求在情绪分析装置中进行配置。

110.本技术实施例中,目标情绪信息可以认为是值得用户关注的情绪信息,目标行为特征可以认为是值得用户关注的行为特征信息。其中,情绪信息是情绪分析装置根据待分析视频中记录的目标对象的语音数据和/或图像数据,对目标对象的情绪进行分析得到的信息。行为特征信息是情绪分析装置根据待分析视频中记录的目标对象的语音数据和/或图像数据,对目标对象的行为进行分析得到的信息。

111.以下对目标情绪信息的确定方式进行具体介绍。

112.对于确定目标对象的目标情绪信息,一种可能的实现方式中,情绪分析装置在确定出目标对象后,可以确定待分析视频中目标对象的情绪信息,再从情绪信息中确定出目标对象的目标情绪信息。

113.以下对本技术实施例中的情绪信息以及确定目标对象情绪信息的方式进行具体阐述。

114.可选的,情绪信息可以包括基本的情绪类型或情绪属性。示例性的,情绪类型可以包括但不限于高兴、惊讶、平静、厌恶、愤怒、恐惧或悲伤等情绪类型。情绪属性可以包括正面、中性或负面等。情绪属性可以与情绪类型有对应关系。例如,高兴和兴奋等类型的情绪属性为正面(可以称为正面情绪);愤怒、悲伤、厌恶以及害怕等类型的情绪属性为负面(可以称为负面情绪);平静、惊讶等类型的情绪属性为中性(可以称为中性情绪)。

115.示例性的,对于确定目标对象的情绪类型或情绪属性,本技术实施例中,情绪分析

装置可以根据待分析视频中的图像数据,识别出目标对象面部的图像数据,进而通过面部运动单元(action unit,au)计算确定目标对象的情绪类型。本技术实施例中,au可以包括40多种,例如眉毛抬起,嘴角上升等细微动作,目标对象的情绪类型和/或用于通过au计算情绪类型的计算模型可以根据实际需求进行配置。进一步地,情绪分析装置确定出情绪类型后,还可以根据预设的情绪类型与情绪属性的映射关系,确定出情绪属性。

116.可选的,情绪信息还可以包括利用基本的情绪类型或情绪属性计算得到的第一情绪特征。示例性的,第一情绪特征可以包括情绪波动频率、负面情绪占比等信息。其中,情绪波动指由一种情绪变化为另一种情绪,负面情绪可以参考上文对情绪属性的解释。

117.示例性的,对于确定目标对象的情绪波动频率信息,本技术实施例中,情绪分析装置可以在预设时间段内识别目标对象出现过的情绪类型,再根据目标对象的情绪类型是否变化确定目标对象是否出现情绪波动,若情绪类型变化,则出现情绪波动,情绪分析装置可以在预设时间段段内,确定情绪波动的次数,并将波动次数作为情绪波动频率。

118.需要说明的是,本技术实施例中,预设时间段可以是预配置在情绪分析装置中的。可选的,工作人员可以根据实际需求,配置不同的预设时间段。在此统一说明,以下不再赘述。

119.示例性的,对于确定目标对象的负面情绪占比信息,本技术实施例中,情绪分析装置可以在预设时间段内,确定目标对象出现过的情绪类型的属性,并确定负面属性的情绪类型持续时间在预设时间段的占比。例如,预设时间段为5秒,某一预设时间段内,待分析视频共有150图像帧,其中,情绪分析装置确定有30图像帧目标对象处于负面情绪,情绪分析装置由此可以确定该预设时间段内,目标对象的负面情绪占比信息为20%。

120.可选的,情绪信息还可以包括综合第一情绪特征和行为特征计算出来的第二情绪特征,例如情绪信息为综合指标,是衡量目标对象综合情绪状态的一个统一的量化指标。可选的,综合指标用于表征目标对象的紧张状态时,综合指标可以称之为紧张度综合值。

121.图6为本技术实施例提供的紧张度综合值示意图。如图6所示,紧张度综合值可以以数值表示。其中,目标对象的紧张状态可以包括目标对象出现紧张状态的可能性或目标对象的紧张程度,当紧张度综合值的数值越大,若目标对象的紧张状态包括目标对象出现紧张状态的可能性,代表目标对象紧张的可能性越高,若目标对象的紧张状态包括目标对象的紧张程度,代表目标对象的紧张程度更强烈,因此紧张度综合值的数值越大,也就越值得工作人员关注目标对象当前的行为或发言。

122.除上述介绍的确定情绪信息的方式,本技术实施例中,情绪分析装置还可以采用如下步骤确定目标对象的情绪信息。

123.步骤一:情绪分析装置利用预设的识别算法,对待分析视频中目标对象的对象特征进行分析,确定参数;其中,参数包括:眼动频率、眨眼频率、异常行为中至少之一项信息;异常行为包括:撅嘴、咬嘴唇、吐舌头中至少之一。

124.其中,对象特征为用于确定情绪信息的特征信息。上述参数中,眼动频率或眨眼频率可以统称为眼部特征信息。目标对象的异常行为可以是预配置的,代表了一些异常心理反应的行为。例如,目标对象噘嘴,该异常动作显示目标对象心理上有抵触,不认同等心理反应。异常行为可以包括撅嘴、舔嘴唇、咬嘴唇、伸舌头中的一个或多个,也可以包括其他预设行为。

125.对于确定目标对象的眨眼频率、眼动频率,可选的,情绪分析装置可以根据待分析视频中的图像数据识别出目标对象眼部的图像数据,进而通过预设的识别算法确定目标对象的眼动频率、眨眼频率。示例性的,预设的识别算法可以为人脸视频算法。

126.示例性的,情绪分析装置确定目标对象的眼动频率,可以包括以下步骤:

127.首先,情绪分析装置通过预设的识别算法,识别预设时间段内待分析视频的每一图像帧中的眼睛区域,进而获取预设时间段内待分析视频的每一图像帧中目标对象的眼睛姿态信息;眼睛姿态信息包括眼睛偏航角(pitch)和/或俯仰角(yaw),其中,偏航角和俯仰角具体可参考现有定义,在此不再赘述。

128.示例性的,情绪分析装置在获取目标对象的眼睛姿态信息时,可以输出以下形式的数据:

129."eyepose":{"isvalid":true,"pitch":0.0299550,"yaw":

‑

0.1152140};

130.然后,情绪分析装置确定每相邻两个图像帧中眼睛姿态信息的变化程度。示例性的,情绪分析装置可以根据之前确定的每一图像帧中目标对象的眼睛姿态信息,确定相邻两个图像帧中眼睛姿态信息的变化程度。

131.示例性的,情绪分析装置在确定相邻两个图像帧中眼睛姿态信息的变化程度时,可以输出以下形式的数据:

132."eyeposechange":{"angvelmix":0.2251902032865774,"angvelpitch":0.16138750,"angvelyaw":0.1570500000000001,"isvalidangvel":true};

133.最后,情绪分析装置在确定相邻两个图像帧中眼睛姿态信息的变化程度后,将预设时间段内相邻两个图像帧中目标对象的眼睛姿态信息的变化程度大于第一阈值的次数确定为眼动频率。

134.示例性的,第一阈值可以是一个预配置的阈值,若相邻两个图像帧中眼睛姿态信息的变化程度大于第一阈值,可以认为相邻两个图像帧中眼睛姿态变化较大。情绪分析装置在预设时间段内,确定总共出现多少次相邻两个图像帧中眼睛姿态变化程度大于第一阈值,并将眼睛姿态变化程度大于第一阈值的次数作为眼动频率。

135.示例性的,情绪分析装置确定目标对象的眨眼频率,可以包括以下步骤:

136.首先,情绪分析装置通过预设的识别算法,识别预设时间段内待分析视频的每一图像帧中的眼睛区域,进而获取预设时间段内待分析视频的每一图像帧中目标对象的眼睛开合程度信息;眼睛开合程度信息包括左眼睛开合程度信息和右眼睛开合程度信息。其中,眼睛的开合程度可以以一个对应的数值表示。例如眼睛完全睁开,开合程度为100,眼睛闭上,开合程度为0。

137.示例性的,情绪分析装置在确定眼睛开合程度信息时,可以输出以下形式的数据:

138."eyeopen":{"lefteyeopen":0.654590,"righteyeopen":0.7131350};

139.然后,情绪分析装置可以根据之前确定的每一图像帧中的目标对象的眼睛开合程度信息,确定相邻两个图像帧中眼睛姿态信息的变化程度。

140.最后,情绪分析装置在确定相邻两个图像帧中眼睛开合程度的变化程度后,将预设时间段内相邻两个图像帧中目标对象的眼睛开合程度的变化程度大于第二阈值的次数确定为眨眼频率。

141.示例性的,第二阈值可以是一个预配置的阈值,若相邻两个图像帧中,左眼睛、右

眼睛或左右眼(左眼睛和右眼睛)的眼睛开合程度的变化程度大于第二阈值,可以认为这是一次眨眼动作(blink)。例如,第二阈值为70,前一帧中左眼的眼睛开合程度为80,后一帧中左眼的眼睛开合程度为0,则相邻两帧左眼的眼睛开合程度的变化程度为80,超过第二阈值,情绪分析装置认为这是一次眨眼动作。情绪分析装置在预设时间段内,确定总共出现多少次相邻两个图像帧中目标对象的眼睛开合程度变化程度大于第二阈值,即认为目标对象出现多少次眨眼,并将眨眼次数作为眨眼频率。

142.示例性的,情绪分析装置在确定相邻两个图像帧中眼睛开合程度信息的变化程度以及确定预设时间段内眼睛开合程度的变化程度大于第二阈值的次数时,可以输出以下形式的数据:

143."eyeblink":{"cureyeopen":{"lefteyeopen":0.654590,"righteyeopen":0.7131350},"lefteyeblink":0,"mixeyeblink":0,"preeyeopen":{"lefteyeopen":0.6355050,"righteyeopen":0.6984920},"righteyeblink":0};

144.需要说明的是,本技术实施例中,情绪分析装置确定目标对象眼部特征信息的预设时间段和情绪分析装置更新目标对象眼部特征信息的时间间隔可以不同。例如,用于确定眨眼频率的预设时间段为5秒,情绪分析装置确定的目标对象在9:00的眨眼频率是8:55至9:00这5秒内目标对象的眨眼次数。更新目标对象眨眼频率的时间间隔为1秒,情绪分析装置在9:01更新目标对象的眨眼频率,9:01更新的眨眼频率是8;56至9:01这5秒内目标对象的眨眼次数。

145.对于确定目标对象的异常行为,可选的,情绪分析装置可以根据获取的待分析视频中目标对象的图像数据,以及预设的识别算法(例如通过面部au)确定目标对象是否出现异常行为。

146.示例性的,情绪分析装置可以量化目标对象的异常行为信息并将量化后的异常行为信息作为确定的参数。例如情绪分析装置统计在预设时间段内目标对象出现几次异常行为信息,并将统计的次数作为参数中的异常行为信息。

147.步骤二:情绪分析装置根据上述参数,确定目标对象的情绪信息。

148.情绪分析装置在确定参数后,可以根据预配置的算法或模型,进一步确定情绪信息。示例性的,以下以情绪信息为第二情绪特征:紧张度综合指标为例,对情绪分析装置如何根据参数确定情绪信息进行说明。

149.可选的,参数还可以包括以下一项或多项信息:目标对象的情绪波动频率信息、目标对象的负面情绪占比信息、目标对象的声强信息、目标对象的音调信息、目标对象的语速信息。

150.其中,目标对象的情绪波动频率信息、目标对象的负面情绪占比信息和这两者的确定方式可参考上文的介绍,在此不再赘述。

151.对于确定目标对象的声强信息、目标对象的音调信息或目标对象的语速信息,具体地,情绪分析装置可以根据待分析视频中记录的目标对象的语音数据,获取目标对象的声强信息、音调信息或语速信息。

152.情绪分析装置在获取了上述参数后,情绪分析装置可以通过以下步骤,根据获取的上述参数,确定综合指标。以下以综合指标为紧张度综合值为例,对确定综合指标的步骤进行具体介绍。

153.首先,预处理数据阶段。情绪分析装置在该阶段获取基本统计信息,基本统计信息包括计算每类数据的最小值(min)、最大值(max)、平均值(mean)等信息,其中,上述确定的参数中包括的每项信息对应一类型的数据。该阶段又称为建立基线数据(baseline data),是为了获取目标对象在表情、眼动或语音等方面的数据特征。该阶段可以在目标对象处于平静状态时进行,例如工作人员与目标对象进行一些轻松的谈话时,或者在工作人员与目标对象谈话的初始阶段,或者分析从网络或本地获取的目标人员处于平静状态下的视频。

154.其次,筛选数据阶段。情绪分析装置在该阶段,可以在获取的每类数据中,筛选可以表现目标对象处于紧张状态(或者说目标对象偏离正常情况)的数据。具体地,情绪分析装置在该阶段获取每类数据后,情绪分析装置可以根据预配置的目标对象处于紧张状态时每类数据的值的变化趋势,将获取的每一类数据的值与在预处理数据阶段确定的对应的平均值进行比较,若某一类数据与对应的平均值的比较结果符合紧张状态下该类数据的变化趋势,情绪分析装置可以将该类数据确定为表现目标对象处于紧张状态的数据。例如,参数包括目标对象的情绪波动频率和目标对象的音调,其中,这两类数据在目标对象处于紧张状态时均呈升高趋势,情绪分析装置在本阶段获取的目标对象的情绪波动频率比对应的平均值高,在本阶段获取的目标对象的音调比对应的平均值低,情绪分析装置筛选出情绪波动频率作为表现目标对象处于紧张状态的数据。

155.其次,数据处理阶段。情绪分析装置在这一阶段,对在筛选数据阶段获取的各类数据进行归一化处理,示例性的,情绪分析装置可以采用离差(min

‑

max)标准化方法对筛选出的各类数据进行归一标准化处理,使得所有数据都映射到[0,1]范围中。离差标准化后的数据满足如下关系:

[0156][0157]

其中,x*代表归一化后某一类型的数据,x代表情绪分析装置在该阶段获取的该类型的原始数据,min为在预处理数据阶段获取的该类型数据的最小值,max代表预处理数据阶段获取的该类型数据的最大值。

[0158]

然后,加权计算紧张度综合值阶段。情绪分析装置在该阶段中,根据在数据处理阶段获取的归一化后的数据,计算m时刻(根据视频帧)的紧张度综合值示例性的,情绪分析装置可以根据如下公式(2),求解各个数据类型(n种类型数据)的加权和来确定紧张度综合值。公式(2)满足如下关系:

[0159][0160]

其中,表示m时刻第i类数据的归一化数值,即m时刻第i类数据的x*,其中,1≤i≤n;w

i

表示第i类数据的的权重值,且本技术实施例中,w

i

可以是根据实际需求进行配置的。

[0161]

可选的,本技术实施例中,情绪分析装置还可以根据参与确定紧张度综合值的数据中表现出紧张状态的数据维度(或者说数据模态)的数量,或者表现出紧张状态的数据类型的数量,来确定紧张度综合值的可信度。

[0162]

示例性的,假设紧张度综合值可以通过情绪波动频率信息、负面情绪占比信息、目

标对象的声强信息、音调信息、眼动频率和眨眼频率这六类数据来确定。其中,情绪波动频率信息和负面情绪占比信息对应表情维度数据。声强信息和音调信息对应语音维度数据。眼动频率和眨眼频率对应眼动维度数据,因此,这六类数据共对应三个维度。

[0163]

示例性的,当根据参与确定紧张度综合值的数据维度的数量确定紧张度综合值的可信度时,若仅单一维度的数据(例如仅表情维度的数据)表现出紧张状态,此时紧张度综合值的可信度为低档。若有两个维度的数据(例如表情维度的情绪波动频率信息和语音维度的音调信息)表现出紧张状态,此时紧张度综合值的可信度为中档。若三个维度的数据均表现出紧张状态,此时紧张度综合值的可信度为高档。

[0164]

示例性的,当根据参与确定紧张度综合值的数据类型的数量确定紧张度综合值的可信度时,若表现出紧张状态的数据类型的数量不超过二,此时紧张度综合值的可信度为低档。若表现出紧张状态的数据类型的数量超过二不超过四,此时紧张度综合值的可信度为中档。若表现出紧张状态的数据类型的数量超过四,此时紧张度综合值的可信度为高档。

[0165]

需要说明的是,本技术实施例不限定用于确定紧张度综合值的方式,以上示例中数据维度或数量与可信度档次之间的对应关系为示例说明,实际应用中可以根据实际需求进行配置。

[0166]

进一步地,情绪分析装置还可以在与情绪分析装置连接的显示器上,显示用于表征紧张度综合值的可信度的提示信息。例如,如图6所示的紧张度综合值示意图,当有两种类型的数据表现出紧张状态时,亮起两个代表紧张度综合值可信度的格子。

[0167]

可选的,情绪分析装置还可以根据紧张度综合值的可信度,显示不同形式的用于表征紧张度综合值的可信度的提示信息。例如,当可信度为低档时,亮起的代表紧张度综合值可信度的两个格子是绿色的,当可信度为中档时,亮起的代表紧张度综合值可信度的四个格子是橙色的。

[0168]

以上介绍了确定情绪信息的实现方式,本技术实施例中,在确定了情绪信息后,情绪分析装置需要从情绪信息中确定目标对象的目标情绪信息。可选的,本技术实施例中,情绪分析装置可以通过如下实现方式确定目标情绪信息:

[0169]

情绪分析装置从识别到的情绪信息中确定用于表征情绪异常的情绪信息。

[0170]

情绪分析装置将用于表征情绪异常的情绪信息作为目标情绪信息。

[0171]

具体地,本技术实施例中,情绪分析装置可以确定情绪信息所表征的情绪异常程度,并将情绪异常程度高于预设程度的情绪信息确定为用于表征情绪异常的情绪信息,进而将用于表征情绪异常的情绪信息作为目标情绪信息。

[0172]

可选的,情绪分析装置可以根据情绪信息的种类,预配置与不同的情绪信息对应的不同的预设程度。

[0173]

可选的,情绪信息所表征的情绪异常程度高于预设程度时,情绪分析装置可以根据情绪信息表征的情绪异常程度高于预设程度的程度,确定目标情绪信息的类型。示例性的,情绪分析装置可以为情绪异常程度高于预设程度的程度设置不同的阈值,并将不同的阈值对应不同的目标情绪信息的类型。

[0174]

以一个具体的示例性进行解释,情绪信息为紧张度综合值,情绪分析装置可以根据目标对象紧张度综合值的数值,确定紧张度综合值所表征的情绪异常程度。如下表1所示,为一个示例中,紧张度综合值表征的情绪异常程度的不同档次和对应的数值分布。

[0175]

表1

[0176][0177]

如表1所示,紧张度综合值的数值可以用于表征情绪异常程度,其中预设程度为50,若紧张度综合值不超过50,情绪分析装置认为紧张度综合值表征的情绪异常程度在正常范围,不用于表征情绪异常,即无紧张状态表现。若紧张度综合值超过50,情绪分析装置认为紧张度综合值表征的情绪异常程度超过正常范围,用于表征情绪异常,即出现紧张状态,换言之,超过50的紧张度综合值可以作为目标情绪信息。其中,若紧张度综合值超过预设程度的程度不超过30(即紧张度综合值为51~80),情绪分析装置认为紧张度综合值作为目标情绪信息,其类型为“关注”,紧张状态为中等强度。若紧张度综合值超过预设程度的程度大于30(即紧张度综合值为81~100)。情绪分析装置认为紧张度综合值作为目标情绪信息,其类型为“异常”,紧张状态强烈。

[0178]

以下对目标行为特征的确定方式进行具体介绍。

[0179]

对于确定目标对象的目标行为特征,本技术实施例中,目标行为特征可以是从获取的行为特征信息中筛选出来的,或者,还可以就是获取的行为特征信息,具体的确定目标行为特征的方式可以根据实际需求进行配置。示例性的,行为特征信息可以包括眨眼频率、眼动频率、异常行为等信息。可选的,用户可以根据实际需求,配置情绪分析装置需要识别的行为特征。

[0180]

示例性的,若目标行为特征是从获取的行为特征信息中筛选出来的,情绪分析装置可以为不同的行为特征信息设置阈值,若获取的行为特征信息的值超过对应的预设阈值,情绪分析装置将超过对应阈值的行为特征信息作为目标行为特征。例如,行为特征包括眼动频率,若情绪分析装置识别到目标对象的眼动频率超过60/min,情绪分析装置将识别到的眼动频率作为目的行为特征。

[0181]

示例性的,若目标行为特征是获取的行为特征信息,情绪分析装置可以预设一部分行为信息作为目标行为特征,若情绪分析装置识别到预设的行为特征信息,便将识别到的行为特征信息作为目标行为特征。例如,预设的行为特征信息包括异常行为信息,若情绪分析装置识别到噘嘴、咬嘴唇等异常行为,便将识别到的异常行为作为目标行为特征。

[0182]

可选的,若目标行为特征为超过对应的预设阈值的行为特征信息,情绪分析装置可以根据行为特征信息高于预设阈值的值,确定目标行为特征的类型。示例性的,情绪分析装置可以为行为特征信息高于预设阈值的值设置不同的阈值,并将不同的阈值对应不同的目标行为特征的类型。例如行为特征包括眼动频率,眼动频率的预设阈值为60/min,若眼动频率超过60/min的值不超过10/min,(眼动频率为60/min~70/min),情绪分析装置认为眼动频率的类型为“关注”。若眼动频率超过60/min的值大于10/min,(眼动频率大于等于71/min),情绪分析装置认为眼动频率的类型为“异常”。

[0183]

对于步骤s503,情绪分析装置可以在与情绪分析装置连接的显示器上,关联显示

确定的目标信息,以及与目标信息关联的语音数据对应的目标语音文本。

[0184]

其中,与语音数据对应的目标语音文本是情绪分析装置采用语音转写能力将待分析视频中记录的语音数据自动转换形成的文本。

[0185]

示例性的,与目标信息关联的目标语音数据,包括:识别到目标信息时记录的语音数据、识别到目标信息之后一段预设时间内记录的语音数据、或者识别到目标信息之前一段预设时间内记录的语音数据。示例性的,工作人员a与目标对象对话,工作人员a说完话后3秒之内,情绪分析装置识别到目标对象出现目标信息1,则情绪分析装置确定工作人员a说话的语音数据与识别到的目标信息1相关联,为识别到目标信息1之前记录的语音数据,并关联显示工作人员a说话的语音数据转换成的语音文本和目标对象的目标信息1。

[0186]

示例性的,情绪分析装置可以采用如下实现方式i、实现方式ii或实现方式iii关联显示目标信息,以及与目标信息关联的语音数据对应的目标语音文本。当然,除下述实现方式i、实现方式ii、实现方式iii以外,还可以是采用别的实现方式关联显示,本技术实施例对此不再一一列举。

[0187]

实现方式i:情绪分析装置按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本。该实现方式中,情绪分析装置根据识别到目标信息的时间,以及识别到与目标信息关联的语音数据的时间,按照时间先后顺序,关联显示目标信息和与语音数据对应的目标语音文本。

[0188]

示例性的,图7为本技术实施例提供的一种文本信息示意图。如图7所示,目标语音文本701为工作人员问话的语音文本,工作人员问这句话的时间为12:13:30。情绪分析装置在工作人员问完这句话后,在12:13:33识别到目标对象的情绪波动频率高过预设程度,表征目标对象情绪异常,即识别到目标对象的目标行为特征信息:情绪波动频率。情绪分析装置确定此目标信息与工作人员的问话相关联,情绪分析装置按照时间先后顺序,在连接的显示屏上先后显示工作人员的目标语音文本701和与目标语音文本701关联的目标信息702。

[0189]

可选的,情绪分析装置还可以以时间轴的形式按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

[0190]

示例性的,如图7所示,情绪分析装置在显示目标语音文本701和关联的目标信息702时,可以根据识别到目标语音文本701的时间,以及识别到目标信息702的时间,按照时间先后顺序,以时间轴的形式显示识别到这两者的时间,以及与时间分别对应的文本。

[0191]

实现方式ii:情绪分析装置将目标信息、与目标信息关联的语音数据对应的目标语音文本显示在同一显示区域。

[0192]

该实现方式中,一个目标信息和与之关联的目标语音文本可以构成一个显示区域。在显示区域中,目标信息可以位于目标语音文本的左右方,或者,目标信息可以位于目标语音文本的上下方,本技术实施例并不限定目标信息与目标语音文本的位置关系。

[0193]

示例性的,如图8a所示,目标语音文本801下方是与目标语音文本关联的目标信息802,目标语音文本801和与目标语音文本801关联的目标信息802处于同一显示区域,目标语音文本803下方是与目标语音文本803关联的目标信息804,目标语音文本803和与目标语音文本803关联的目标信息804处于同一显示区域。

[0194]

或者,示例性的,如图8b所示,目标语音文本801右方是与目标语音文本801关联的

目标信息802,目标语音文本801和与目标语音文本801关联的目标信息802处于同一显示区域。目标语音文本803右方是与目标语音文本803关联的目标信息804,目标语音文本803和与目标语音文本803关联的目标信息804处于同一显示区域。

[0195]

实现方式iii:情绪分析装置以同一显示方式显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

[0196]

示例性的,本技术实施例中,同一显示方式可以是采用相同的文本颜色进行显示,或者,可以是采用相同的文本边框进行显示,或者,可以是采用相同的字体进行显示,或者,可以是采用相同的字体大小进行显示等可以让用户通过相同的显示形式,直观注意到目标语音文本和与目标语音文本关联的目标信息的显示方式。例如,如图8a所示,目标语音文本801和与目标语音文本801关联的目标信息802采用相同的曲线文本边框这一显示方式进行显示。

[0197]

可选的,如图9所示,本技术实施例提供的情绪分析方法还包括步骤s901:

[0198]

s901、情绪分析装置确定目标信息的类型;对于同一种类型目标信息,每一目标信息与对应的所述目标语音文本之间的关联显示方式相同;或者,情绪分析装置确定目标信息对应的处理信息的类型;对于同一种类型处理信息,每一处理信息对应的目标信息与该目标信息对应的所述目标语音文本之间的关联显示方式相同。

[0199]

其中,目标信息的类型可以参考上文的介绍,在此不再赘述。处理信息可以理解为情绪分析装置根据识别到的目标信息,提供给用户的与目标信息对应的处理建议信息。示例性的,处理信息可以与目标信息的类型对应,若目标信息的类型为“关注”,与该目标信息对应的处理信息可以为“建议关注”,若目标信息的类型为“异常”,与该目标信息对应的处理信息可以为“建议重点关注”。

[0200]

情绪分析装置在确定目标信息的类型或对应的处理信息后,可以将同一类型的目标信息,或者对应同一类型处理信息的目标信息,与目标语音文本的关联显示方式确定为相同的,换言之,不同类型的目标信息或不同类型处理信息对应的关联显示方式不同。

[0201]

示例性的,如图10所示,情绪分析装置确定目标信息1002的类型为“关注”,目标信息1002和与目标信息1002关联的目标语音文本1001采用相同的直线文本边框这一显示方式进行关联显示。情绪分析装置确定目标信息1004的类型为“异常”,目标信息1004和与目标信息1004关联的目标语音文本1003采用相同的曲线文本边框这一显示方式进行关联显示。

[0202]

可选的,如图11所示,本技术实施例提供的情绪分析方法还包括步骤s1101:

[0203]

s1101、情绪分析装置显示目标信息的标签;标签用于指示目标信息的类型;或标签用于指示与目标信息对应的处理信息。

[0204]

情绪分析装置在确定目标信息的类型或与目标信息对应的处理信息后,可以进而确定用于指示目标信息类型或处理信息的标签并显示。

[0205]

示例性的,如图10所示,情绪分析装置确定目标信息1002的类型为“关注”,相对应的,情绪分析装置根据目标信息1002的类型确定目标信息1002的标签1005为“关注”并显示,情绪分析装置确定目标信息1004的类型为“异常”,相对应的,情绪分析装置根据目标信息1004的类型确定目标信息1004的标签1006为“异常”并显示。

[0206]

可选的,情绪分析装置还可以显示与目标信息对应的处理信息。

[0207]

可选的,情绪分析装置还可以在目标信息1002的后方显示与目标信息1002对应的处理信息1007:“建议关注”。

[0208]

可选的,情绪分析装置还可以在时间轴上显示目标信息的标签。具体地,情绪分析装置根据识别到目标信息的时间先后顺序,以时间轴的形式显示目标信息的标签。

[0209]

示例性的,如图10所示,情绪分析装置识别到目标信息1002的时间是12:13:33,目标信息1002的标签1005为“关注”,情绪分析装置识别到目标信息1004的时间是12:14:10,目标信息1004的标签906为“异常”,情绪分析装置根据识别到目标信息1003和目标信息1004的时间,按照时间轴的形式显示识别到目标信息的时间和与目标信息分别对应的标签1005和标签1006。

[0210]

可选的,本技术实施例中,情绪分析装置还可以显示待分析视频中除目标语音文本之外的其他语音文本。可以理解的是,除目标语音文本之外的语音文本为与目标对象的目标信息没有关联关系的语音文本。例如,工作人员a在说话期间,以及说话后一段时间内,都没有识别到目标对象出现目标信息,则认为工作人员a说话时记录的工作人员a的语音数据对应的语音文本为除目标语音文本之外的其他语音文本。

[0211]

可选的,如图12所示,本技术实施例提供的情绪分析方法还包括步骤s1201~s1202:

[0212]

s1201、情绪分析装置以第一显示方式显示除目标语音文本之外的其他语音文本。

[0213]

s1202、情绪分析装置以第二显示方式显示目标语音文本。

[0214]

可以理解的是,目标语音文本的显示方式与除目标语音文本之外的其他语音文本的显示方式不同,以便于用户区分目标语音文本和其他语音文本。

[0215]

进一步地,显示方式不同还可以实现突出显示目标语音文本,引起用户对突出显示的目标语音文本的关注。本技术实施例对突出显示的具体形式不做限制。

[0216]

可选的,本技术实施例中,突出显示可以是采用不同颜色,不同形式进行突出显示,例如正常语音文本颜色是灰色,突出显示的语音文本颜色是红色,正常语音文本的形式是直线边框,突出显示的语音文本是曲线边框等。或者,突出显示还可以是在突出显示的语音文本旁边加上告警信息,例如加上注意标志。或者,突出显示还可以是弹窗显示突出显示的语音文本。或者,还可以是在第一次显示突出显示的语音文本时,发出告警声音。

[0217]

示例性的,如图13所示,工作人员在问话时,情绪分析装置没有识别到目标对象的目标信息,因此工作人员的问话文本1301为除目标语音文本之外的其他语音文本,情绪分析装置以普通粗度的边框显示语音文本1301。目标对象在说“我今天心情很棒”的期间,情绪分析装置识别到目标对象的目标信息,因此情绪分析装置在显示对应的语音文本1302时,将语音文本1302的边框进行加粗,以突出显示语音文本1302。

[0218]

可选的,本技术实施例中,情绪分析装置还可以显示用于指示语音文本所属发言人的标签。示例性的,若工作人员a与目标对象对话,工作人员一直询问目标对象问题,则情绪分析装置确定工作人员a的语音数据属于问话,相对应的,情绪分析装置将工作人员a的语音数据对应的语音文本的标签确定为“问”标签。情绪分析装置确定目标对象的语音数据属于回答,相对应的,情绪分析装置将目标对象的语音数据对应的语音文本的标签确定为“答”标签。如图13所示,工作人员a的语音文本1301的标签1303为“问”,目标对象的语音文本1302的标签为1304“答”。

[0219]

可选的,情绪信息为综合指标时,情绪分析装置还可以实时显示目标对象的综合指标。

[0220]

可选的,情绪分析装置还可以显示目标对象的情绪状态。其中,情绪状态与目标对象的情绪信息所表征的情绪异常程度对应。示例性的,若情绪信息为紧张度综合值,若情绪异常程度高于预设程度一定程度,情绪状态为“情绪紧张”,若情绪异常程度不超过预设程度,情绪状态为“情绪稳定”。

[0221]

示例性的,如图6所示,综合指标为紧张度综合值,显示当前该值为18。相对应的,显示用户的情绪状态为情绪稳定。

[0222]

可选的,情绪信息为综合指标时,情绪分析装置还可以显示用于确定综合指标的参数和/或参数的变化情况。

[0223]

示例性的,如图6所示,假设用于确定综合指标的参数包括:目标对象的情绪波动频率、目标对象的负面情绪占比、目标对象的声强、目标对象的音调、目标对象的语速信息、目标对象的眼动频率、目标对象的眨眼频率和目标对象的异常行为信息。情绪分析装置可以在连接的显示屏上实时显示当前获取的参数的值和参数的变化情况,例如显示当前目标对象的眨眼频率为48/min,变化情况为升高,显示当前目标对象的眨眼频率为48/min,变化情况为升高,当前目标对象的声强为61.52db,变化情况为升高,当前目标对象的音调为239.59hz,变化情况为降低,当前目标对象的语速为3字/秒,变化情况为降低,当前目标对象的情绪波动频率为2/min,负面情绪占比为0%,当前目标对象的异常行为有咬嘴唇,噘嘴,舔嘴唇,伸舌头。

[0224]

可选的,情绪分析装置还可以显示待分析视频。需要说明的是,情绪分析装置可以在显示包含多个对象的待分析视频时,裁剪待分析视频至待分析视频中仅包括目标对象,也可以显示原本的包含多个对象的待分析视频。

[0225]

可选的,若待分析视频包括多个目标对象,本技术实施例中,情绪分析装置还可以按照待分析视频中包括的多个目标对象,分界面显示各个目标对象的情绪信息和目标对象的语音文本。

[0226]

可选的,本技术实施例中,情绪分析装置连接的显示屏在显示信息时,工作人员可以通过操作应用或平台,管理或选择界面上显示的信息。

[0227]

可选的,若工作人员需要与目标对象进行对话,且需要将对话期间的视频作为待分析视频,本技术实施例提供的情绪分析方法还包括:

[0228]

情绪分析装置根据工作人员选择的对话目的,向工作人员提供对话模板,供工作人员参考借鉴与目标对象如何对话。

[0229]

可选的,本技术实施例提供的情绪分析方法中,情绪分析装置还可以获取目标对象的心率数据或语音情绪数据来确定情绪信息。示例性的,心脏收缩和舒张的动作,导致血液在血管中的充盈程度不一样,这种血管充盈程度的来回变化会反应到人皮肤表面反射光线的变化(通过血管的血液量越大,被血液吸收的光线也越多,人皮肤表面反射的光线就越少),进而面部红色深浅会出现极其微弱的变化,因此情绪分析装置可以根据待分析视频中目标对象的图像数据,确定目标对象的面部数据,并通过预设算法识别目标对象面部颜色的变化进而识别目标对象的心率数据。进一步地,情绪分析装置可以将心率数据作为确定综合指标的参数之一。对于目标对象的语音情绪数据,情绪分析装置可以通过预设算法,将

语音数据中的语音特征信息,例如梅尔倒谱系数(mel

‑

scalefrequency cepstral coefficients,mfcc)、共振峰等信息与情绪类型进行联系,进而根据目标对象的语音数据确定目标对象的情绪信息。

[0230]

上述主要从方法的角度对本技术实施例提供的方案进行了介绍。为了实现上述功能,其包含了执行各个功能相应的硬件结构和/或软件模块。本领域技术人员应该很容易意识到,结合本文中所公开的实施例描述的各示例的单元及算法步骤,本技术能够以硬件或硬件和计算机软件的结合形式来实现。某个功能究竟以硬件还是计算机软件驱动硬件的方式来执行,取决于技术方案的特定应用和设计约束条件。专业技术人员可以对每个特定的应用来使用不同方法来实现所描述的功能,但是这种实现不应认为超出本技术的范围。

[0231]

本技术实施例还提供一种情绪分析装置。该情绪分析装置可以为上述电子设备,也可以是上述电子设备中的cpu,还可以是上述电子设备中用于确定情绪信息的控制模块。

[0232]

如图14所示,为本技术实施例提供的一种情绪分析装置140的结构示意图。情绪分析装置140用于执行图5、图9、图11或图12所示的情绪分析方法。情绪分析装置140可以包括通信单元1401、处理单元1402和显示单元1403。

[0233]

通信单元1401,用于获取待分析视频,待分析视频记录了语音数据和图像数据。例如,结合图5、图9、图11或图12,通信单元1401可以用于执行s501。

[0234]

处理单元1402,用于确定待分析视频中目标对象的目标信息,其中,目标信息包括目标情绪信息、目标行为特征中至少一项信息。例如,结合图5、图9、图11或图12,处理单元1402可以用于执行s502。

[0235]

显示单元1403,用于关联显示目标信息、与目标信息关联的语音数据对应的目标语音文本。例如,结合图5、图9、图11或图12,显示单元1403可以用于执行s503。

[0236]

可选的,显示单元1403具体用于:按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本;或者,将目标信息、与目标信息关联的语音数据对应的目标语音文本显示在同一显示区域;或者,以同一显示方式显示目标信息、与目标信息关联的语音数据对应的目标语音文本。

[0237]

可选的,显示单元1403还用于:显示目标信息的标签;标签用于指示目标信息的类型;或标签用于指示与目标信息对应的处理信息。

[0238]

可选的,显示单元1403具体用于:以时间轴的形式按照时间先后顺序显示目标信息、与目标信息关联的语音数据对应的目标语音文本;上述显示单元,具体用于:在时间轴上显示目标信息的标签。

[0239]

可选的,显示单元1403还用于:以第一显示方式显示除目标语音文本之外的其他语音文本;以第二显示方式显示目标语音文本。

[0240]

可选的,处理单元1402还用于:确定目标信息的类型;对于同一种类型目标信息,每一目标信息与对应的目标语音文本之间的关联显示方式相同;或者,确定目标信息对应的处理信息的类型;对于同一种类型处理信息,每一处理信息对应的目标信息与该目标信息对应的目标语音文本之间的关联显示方式相同。

[0241]

可选的,处理单元1402具体用于:利用预设的识别算法,对待分析视频中目标对象的对象特征进行分析,确定参数;参数包括:眼动频率、眨眼频率、异常行为中至少之一;异常行为包括:撅嘴、咬嘴唇、吐舌头中至少之一;根据参数,确定目标对象的情绪信息;从情

绪信息中确定待分析视频中目标对象的目标情绪信息。

[0242]

可选的,参数还包括以下一项或多项信息:目标对象的情绪波动频率信息、目标对象的负面情绪占比信息、目标对象的声强信息、目标对象的音调信息、目标对象的语速信息;处理单元1402具体用于:根据参数,确定综合指标,并将综合指标作为情绪信息。

[0243]

当然,本技术实施例提供的情绪分析装置140包括但不限于上述模块。

[0244]

在实际实现时,通信单元1401、处理单元1402、显示单元1403可以由图3所示的处理器41调用存储器42中的程序代码来实现。其具体的执行过程可参考图5、图9、图11或图12所示的情绪分析方法部分的描述,这里不再赘述。

[0245]

本技术另一实施例还提供一种计算机可读存储介质,该计算机可读存储介质中存储有计算机指令,当计算机指令在电子设备上运行时,使得电子设备执行上述方法实施例所示的方法流程中电子设备执行的各个步骤。

[0246]

本技术另一实施例还提供一种芯片系统,该芯片系统应用于电子设备。所述芯片系统包括一个或多个接口电路,以及一个或多个处理器。接口电路和处理器通过线路互联。接口电路用于从电子设备的存储器接收信号,并向处理器发送所述信号,所述信号包括所述存储器中存储的计算机指令。当处理器执行计算机指令时,电子设备执行上述方法实施例所示的方法流程中电子设备执行的各个步骤。

[0247]

在本技术另一实施例中,还提供一种计算机程序产品,该计算机程序产品包括指令,当指令在电子设备上运行时,使得电子设备执行上述方法实施例所示的方法流程中电子设备执行的各个步骤。

[0248]

在上述实施例中,可以全部或部分地通过软件、硬件、固件或者其任意组合来实现。当使用软件程序实现时,可以全部或部分地以计算机程序产品的形式来实现。该计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行计算机执行指令时,全部或部分地产生按照本技术实施例的流程或功能。计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一个计算机可读存储介质传输,例如,计算机指令可以从一个网站站点、计算机、服务器或者数据中心通过有线(例如同轴电缆、光纤、数字用户线(digital subscriber line,dsl))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、服务器或数据中心进行传输。计算机可读存储介质可以是计算机能够存取的任何可用介质或者是包含一个或多个可以用介质集成的服务器、数据中心等数据存储设备。可用介质可以是磁性介质(例如,软盘、硬盘、磁带),光介质(例如,dvd)、或者半导体介质(例如固态硬盘(solid state disk,ssd))等。

[0249]

以上所述,仅为本技术的具体实施方式。熟悉本技术领域的技术人员根据本技术提供的具体实施方式,可想到变化或替换,都应涵盖在本技术的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1