一种基于本地化差分隐私的图像数据隐私保护方法

1.本发明属于信息系统安全技术领域,更具体的说,涉及在深度学习图像识别任务中对图像进行隐私保护的方法。

背景技术:

2.互联网技术的发展使得人工智能相关技术得到了广泛的应用,比如人脸识别系统,推荐系统等,大大的提升了生活的便捷度。这些技术大多是基于深度神经网络而发展的,神经网络的训练过程需要大量数据,而由于神经网络的不可解释性,模型在训练过程中保留了部分用户隐私信息,这些信息对于具有强背景知识的攻击者来说可以轻易获取。因此,为了防止用户数据泄露和模型遭受到攻击,在深度学习中进行隐私保护是很有必要的。

3.差分隐私(differential privacy)是一种能提供严格隐私保证的隐私保护方法,对于防御具有背景知识的攻击很有效。现有的技术包含了不少利用差分隐私来解决深度学习中隐私泄露问题的方法,这些方法大多是通过在模型的梯度下降过程中添加高斯噪声来实现的。但是,这种方式需要一个可信的服务器来进行,然而现实生活中,可信的第三方几乎不存在。

4.对于图像数据,其像素值是0~255的整数,且数据量大,现有技术不能很好的对此类数据进行扰动。一些直接对图像加噪的方法效果不是很好,这是由于图像数据量大,数据敏感度大,扰动所需要的噪声多,导致数据可用性下降,用这种方式加噪后的数据训练的神经网络模型准确率低。还有一些方法对像素值进行转换,使用随机响应机制来进行扰动,效果较好,但是训练时模型收敛速度非常慢。因此,使用现有的技术无法保证在对图像数据进行扰动后,数据仍具有良好的可用性,同时使神经网络能够快速收敛。

技术实现要素:

5.为了解决上述技术问题,本发明提出了一种基于本地化差分隐私的图像隐私保护方法,用来解决在深度学习图像分类任务中,图像数据加噪后可用性低以及可信数据收集方不存在的问题,在实现隐私保护效果的同时,保证数据可用性,同时保证模型能快速收敛。

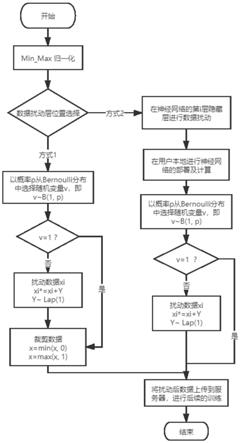

6.本发明的技术方案为一种基于本地化差分隐私(local differential privacy)的图像数据隐私保护方法,本地化差分隐私要求用户在本地进行实施数据扰动算法,然后再上传扰动后的数据。这种方式通常用在数据发布和数据分析过程中,多用于对数值型数据的收集。本地化差分隐私通常使用随机响应机制来实现,其主要思想是,在扰动之前随机抛掷一枚硬币,若正面朝上,就保留原始数据;否则就再次抛掷硬币,当出现反面时才对数据进行加噪操作。如图1所示,包含以下步骤:

7.步骤1,对图像数据进行归一化处理,使得数据范围为(0,1);

8.步骤2,确定数据扰动层的位置,数据扰动层添加在图像数据与第一层神经网络之间,或者添加在神经网络模型中第i个隐藏层之后,其中i<n,n为隐藏层个数;

9.第一种方式在数据归一化后直接对数据进行扰动,然后上传到服务器,此时扰动后的数据仍然是图像数据,数据范围应该在(0,1)之间,因此需要对数据进行裁剪操作;

10.第二种方式在神经网络模型隐藏层中进行扰动,此时数据已经不可读,因此不需要对数据进行裁剪;

11.步骤3,设置数据扰动层;结合随机响应机制和laplace机制对图像数据进行加噪,提出了rrn算法,通过对隐私预算ε和随机响应机制中抽样概率p的设置来保证算法rrn算法差分隐私的定义,rrn算法首先以概率p随机在二项分布中抽取变量,然后判断变量的值,若变量为1则保留数据,否则向数据中添加laplace随机噪声;

12.步骤4,前面步骤的所有操作在用户本地进行,若步骤2中选择了第二种方式,则数据扰动层之前的所有步骤都需要在本地进行,完成这些步骤后,将数据上传到服务器,由服务器进行后续的神经网络模型训练步骤。

13.进一步的,步骤1中使用min_max归一化方法进行归一化处理,计算公式如下:

[0014][0015]

其中,x

max

表示所有数据中的最大值,x

min

表示所有数据中的最小值,此方法归一化后的数据范围为(0,1)。

[0016]

进一步的,步骤3中差分隐私的定义是,若一个随机算法k满足下式,则随机算法k满足ε

‑

dp;

[0017]

pr[k[d]∈s]≤exp(ε)

×

pr[k[d

′

]∈s]

[0018]

其中,d,d

′

表示只相差一个数据的相邻数据集;s表示随机算法k的所有可能输出;pr表示事件发生的概率;ε表示隐私预算,其值代表了隐私保护的等级,ε越小,隐私保护等级越高,数据可用性越低;

[0019]

为了满足上述差分隐私的定义,设置选取1的概率为了使扰动机制尽量简单可行,在对数据进行扰动时向其中添加符合laplace分布的随机噪声,laplace噪声的概率密度为:

[0020][0021]

其中,x表示符合该分布的数据,μ是laplace分布的位置参数,b表示laplace分布的尺度参数,该分布的期望为μ,方差为2b2;

[0022]

提出的rrn算法设置laplace噪声的期望μ=0,b=1,因此,rrn算法的扰动机制如下所示:

[0023][0024][0025]

其中,表示扰动图像数据的概率,ε表示隐私预算,t

i

表示图像像素值,

y表示符合μ=0,b=1时的laplace分布lap(1)的随机变量,表示扰动之后的图像像素值。

[0026]

进一步的,步骤4的具体实现方式如下,

[0027]

根据用户在步骤2中做的选择不同,服务器端的功能也进行相应调整;当选择第一种方式时,服务器端需要设计好完整的神经网络模型来训练数据,或者采用现有的在图像分类方面准确率高的模型来进行训练;

[0028]

当选择第二种方式时,对图像进行特征提取的那部分神经网络计算需要在客户端进行,服务器只需要设计后续的神经网络模型,然后接收到用户的训练结果来进行训练。

[0029]

与现有技术相比,本发明的优点和有益效果如下:

[0030]

本发明利用本地化差分隐私中常用的随机响应机制的思想对图像数据进行扰动,由于在人脸识别等应用场景中,不关注图像数据的统计特征,因此可以使用随机响应机制直接对图像数据进行加噪。本发明用于扰动图像数据,扰动后的数据人眼不可识别,但是神经网络仍然可以识别。本发明可以在保护图像数据隐私的同时使模型具有较高准确率,使用扰动后数据训练的模型收敛速度快。

附图说明

[0031]

图1是本发明实施例的算法流程图。

[0032]

图2是本发明实施例的模型框架图。

具体实施方式

[0033]

本发明主要基于本地化差分隐私,通过向图像数据中添加随机噪声使得图像对人不可识别,但对机器可识别,以此来保护图像数据隐私。通过本发明获得的数据用来训练神经网络也可以有很高的准确率。为了更好的说明本发明的目的和优点,下面结合实施例对本发明方法的实施方式做进一步详细说明。在此,本发明的示意性实施用例及其中说明用于解释本发明,但并不作为对本发明的限定。具体流程为:

[0034]

本发明的技术方案为一种基于本地化差分隐私的图像数据隐私保护方法,如图1所示,包含以下步骤:

[0035]

步骤1,对图像数据进行归一化处理,使得数据范围为(0,1)。实施例具体的实施过程说明如下:

[0036]

图像数据范围是0~255的整数,为了便于计算,使用min_max归一化方法进行归一化处理,如下:

[0037][0038]

其中,x

max

表示所有数据中的最大值,x

min

表示所有数据中的最小值。此方法归一化后的数据范围为(0,1)。

[0039]

步骤2,确定数据扰动层的位置。数据扰动层可以添加在图像数据与第一层神经网络之间,也可以添加在第i个隐藏层之后(i<n,n为隐藏层个数),如图2所示。这两种方式都能对图像进行隐私保护,但不同的方式具有不同的要求。第一种方式要求数据范围在(0,1)之间,扰动后需要对数据进行裁剪。实施例具体的实施过程说明如下:

[0040]

第一种方式在数据归一化后直接对数据进行扰动,然后上传到服务器。此时扰动

后的数据仍然是图像数据,数据范围应该在(0,1)之间,因此需要对数据进行裁剪操作。这种方法只需要在本地进行数据扰动操作,所需的计算资源少。

[0041]

第二种方式在神经网络隐藏层中进行扰动,此时数据已经不可读,因此不需要对数据进行裁剪。这种方式需要在本地进行部分神经网络的计算和数据扰动算法,所需的计算资源较多,但隐私保护效果更好。

[0042]

这两种方式可以根据不同应用场景进行选择,若对隐私保护有较高的要求则可以使用方法2;若对计算性能有较高要求,则可以选择方式1,方式1的隐私保护效果可以通过设置不同的隐私预算来控制。

[0043]

步骤3,设置数据扰动层。本发明结合随机响应机制和laplace机制对图像数据进行加噪,提出了rrn算法,通过对隐私预算ε和随机响应机制中抽样概率p的设置来保证rrn算法满足差分隐私的定义。rrn算法首先以概率p随机在二项分布中抽取变量,然后判断变量的值,若变量为1则保留图像数据值,否则向图像数据中添加laplace随机噪声。实施例具体的实施过程说明如下:

[0044]

差分隐私的定义是,若一个随机算法k满足下式,则算法k满足ε

‑

dp。

[0045]

pr[k[d]∈s]≤exp(ε)

×

pr[k[d

′

]∈s]

[0046]

其中,d,d

′

表示最多只相差一个数据的相邻数据集;s表示算法k的所有可能输出;pr表示事件[k[d]∈s]发生的概率;ε表示隐私预算,其值代表了隐私保护的等级,ε越小,隐私保护等级越高,数据可用性越低。

[0047]

本发明是基于本地化差分隐私来实现图像数据隐私保护,利用随机响应机制进行数据的扰动来满足差分隐私的定义。随机响应机制的大致思想是,以一定的概率在数据集合{0,1}进行选择,选取数据为1的概率为p。若所选的数据为1,则保留原始数据;若数据为0,则对数据进行扰动。

[0048]

基于上述扰动思想,本发明对图像中的每一个像素点数据进行扰动。本发明首先从伯努利分布中进行数据的随机选择,设置选取1的概率为p。

[0049]

为了满足上述差分隐私的定义,本发明设置选取1的概率为了使扰动机制尽量简单可行,本发明在对数据进行扰动时向其中添加符合laplace分布的随机噪声。laplace噪声的概率密度为:

[0050][0051]

其中,x表示符合该分布的数据,μ是laplace分布的位置参数,b表示laplace分布的尺度参数。该分布的期望为μ,方差为2b2;

[0052]

本发明提出的rrn算法设置laplace噪声的期望μ=0,b=1。因此,该算法的扰动机制如下所示:

[0053][0054]

[0055]

其中,表示扰动图像数据的概率,t

i

表示图像像素值;表示扰动之后的图像像素值;ε表示隐私预算;y表示符合μ=0,b=1时的laplace分布lap(1)的随机变量。

[0056]

根据差分隐私的定义,由该扰动机制可得:

[0057][0058]

因此,本发明提出的rrn算法满足ε

‑

dp。

[0059]

步骤4,前面步骤的所有操作需要在用户本地进行,若步骤2中选择了方式2,则数据扰动层之前的所有步骤(神经网络计算)都需要在本地进行。完成这些步骤后,将数据上传到服务器,由服务器进行后续的神经网络训练步骤。实施例具体的实施过程说明如下:

[0060]

根据用户在步骤2中做的选择不同,服务器端的功能也进行相应调整。当选择方式1时,服务器端需要设计好完整的神经网络模型来训练数据,也可以采用现有的在图像分类方面准确率高的模型来进行训练。

[0061]

当选择方式2时,对图像进行特征提取的那部分神经网络计算需要在客户端进行,服务器只需要设计后续的神经网络模型,然后接收到用户的训练结果来进行训练,会有较高的通信代价和本地计算资源开销。

[0062]

训练结束后,模型的准确率相对原始模型会有降低,这是由于训练数据中加入了噪声来保护隐私所导致的,但是总体来说模型精度比较高,隐私保护效果较好。本发明在经典图像分类模型vgg上进行实验,加噪前该模型在ε=0.5,cifar

‑

10数据集上的准确率为96.4%。实施了本发明的隐私保护算法后,该模型准确率为83%。现有的模型中,adabi提出的dp

‑

sgd模型在eps=2时在cifar

‑

10数据集上的准确率为67%,相比于dp

‑

sgd模型,本发明的rrn算法使得模型准确率提高了16%左右。

[0063]

本文中所描述的具体实施例仅仅是对本发明精神作举例说明。本发明所属技术领域的技术人员可以对所描述的具体实施例做各种各样的修改或补充或采用类似的方式替代,但并不会偏离本发明的精神或者超越所附权利要求书所定义的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1