车辆车道偏移的测量方法

1.本公开涉及智能交通技术领域,尤其涉及一种车辆车道偏移的测量方法。

背景技术:

2.对于现有的adas(advanced driving assistance system,高级驾驶辅助系统)和智能驾驶汽车,车道线检测和车辆车道定位是车辆环境感知能力中的关键任务。车辆车道定位方法包括两个部分,一是对车道线的检测,二是对车辆相对车道的位置进行定位。

3.车道线的检测方法有很多种,可以从传感器获取到的信息的角度分为:基于数字图像的车道线识别方法和基于激光点云数据的车道线识别方法,前者是利用数字图像处理技术或深度学习技术对道路样张进行处理,以获取车道线信息;后者是利用激光雷达生成的点云数据进行处理,以获取车道区域信息。一般来说,车道信息的三维特征不甚明显,且使用激光雷达设备的成本较高,设备可靠性相对不足,因此主要用于特殊的道路环境,在车道线检测和车道定位上应用不多。

4.基于数字图像处理技术的车道线检测是车道线检测领域的主流手段,常见的处理方法包括:利用sobel、canny算子进行卷积获取边缘特征、利用霍夫变换识别图像内直线、利用ransac算法提取图像内特征点等。如刘兰馨等做了基于机器视觉的车道线检测和交通标志识别的研究,针对公路模型中的直线车道线利用基于极角、极径约束的改进霍夫变换实现了较好的直线识别效果;江苏大学蔡英凤等提出的一种基于形态学特征的车道线识别方法,定义图像中的脊度量反应车道线的特征,再利用聚类方法筛选出表征车道线的点,最后利用霍夫变换确定车道线,方法对于虚线型车道线也具有识别的能力;吉林大学的曲峰提出一种区分远、近视场,分别利用极坐标聚类和双曲线模型拟合的车道线识别方法。

5.也有学者开始应用深度学习技术对相机采集的样张进行处理以实现道路识别的工作。如华南理工大学的姜立标等面对当前在复杂场景下车道线检测存在精度不高、鲁棒性较差等问题,提出一种基于vgg

‑

16卷积神经网络实现的利用实例分割方法完成复杂场景下车道线检测。算法首先对道路图像进行二值化语义分割,得到离散的车道线像素点,再利用mean

‑

shift聚类方法确定属于同一条车道线的像素点,形成相应的车道线实例;电子科技大学的罗森在实现了基于全卷积神经网络的车道线分割网络的基础上增加了基于条件随机场的后处理方法,有效实现了车道线的像素级分割任务。

6.在车辆车道定位领域,目前的技术还相对比较复杂,一是依赖全球定位系统,其精度和定位成本成反比;二是利用智能交通系统,通过高精度地图实现车辆定位,此方法难度大成本高,技术推广还需要很长时间。三是利用地图信息、全球定位和车载传感器的组合定位方法,这种方式相对前两者有更好的实现条件和定位效果。

7.因此,如何利用车辆感知技术的车辆车道定位以降低车道定位的成本并提高定位精度是亟需解决的问题。

技术实现要素:

8.本公开提供了一种车辆车道偏移的测量方法,其技术目的是降低车辆车道定位的成本并提高定位的精度。

9.本公开的上述技术目的是通过以下技术方案得以实现的:

10.一种车辆车道偏移的测量方法,包括:

11.s1:通过车载相机采集车辆行驶前方的道路样张,获取第一关键帧和当前帧;其中,关键帧表示一段时间内画面特点的视频帧;

12.s2:将当前帧和第一关键帧输入到光流估计网络,得到特征图f1,通过所述特征图f1获得从第一关键帧变化到当前帧的光流估计矩阵m1;

13.s3:将所述特征图f1输入到关键帧判别算法,得到当前帧可以作为关键帧的置信度;

14.s4:判断当前帧是否可以更新为关键帧,若是则转至步骤s41,否则转至步骤s42;

15.s41:调用全卷积神经网络fcn

‑

8s对所述当前帧进行语义分割生成第一识别掩膜r1;

16.s42:通过所述第一关键帧的语义分割结果和光流估计矩阵m1生成光流估计后的第二识别掩膜r2;

17.s5:对所述第一识别掩膜或所述第二识别掩膜进行处理,拟合出表征车道线的二次曲线方程;

18.s6:将范围内的行像素逐行代入行坐标到车道线的二次曲线方程中,得到两个列坐标点,并求这两个列坐标点的算术平均值,最终得到一组中点坐标,所述中点坐标即为理想轨迹点;

19.s7:定义世界坐标系、相机坐标系、像素坐标系和成像坐标系,将所述理想轨迹点变换到世界坐标系下;

20.s8:在世界坐标系下对所述理想轨迹点进行二次曲线拟合,生成理想轨迹线,通过所述理想轨迹线方程的常数项参数确定当前车辆的车道偏移情况。

21.本公开的有益效果在于:与现有技术相比,本技术采用基于数字图像的车道线检测和车辆车道定位的方法,关键帧的视频帧会调用全卷积神经网络进行语义分割处理生成关键帧对应的车道线结果,不是关键帧的视频帧不通过语义分割,因而可以利用关键帧判别算法减少调用复杂的全卷积神经网络的次数。对硬件平台的要求较低,方法可实施性高;同时具备较好的鲁棒性,提高了车辆车道定位精度,在提高驾驶者行驶安全性的同时,也在一定程度上降低了驾驶者的劳动强度。

附图说明

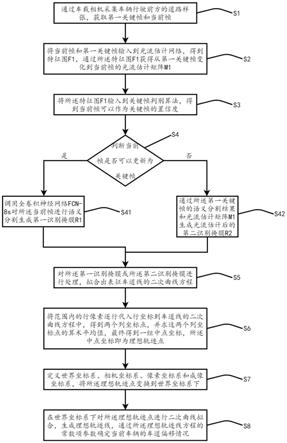

22.图1为本技术所述方法的流程图;

23.图2为本技术训练神经网络时的标签样例;

24.图3为本技术中使用的fcn

‑

8s网络结构示意图;

25.图4为本技术中fcn

‑

8s输出的语义分割掩膜;

26.图5为本技术中得到的基于原图灰度图像的语义分割结果;

27.图6为本技术对车道线的最终识别结果;

28.图7为本技术生成的图像上理想轨迹点可视化结果;

29.图8为本技术定义的世界坐标系、相机坐标系、成像坐标系和像平面位置关系示意图;

30.图9为本技术定义的成像坐标系和像素坐标系位置关系示意图;

31.图10为本技术所述方法在仿真环境的示意图。

具体实施方式

32.下面将结合附图对本公开技术方案进行详细说明。在本技术描述中,需要理解地是,术语“第一”、“第二”仅用于描述目的,而不能理解为指示或暗示相对重要性或者隐含指明所指示的技术特征的数量,仅用来区分不同的组成部分。

33.图1为本技术所述方法的流程图,如图1所示,该方法包括:步骤s1:通过车载相机采集车辆行驶前方的道路样张,获取第一关键帧和当前帧;其中,关键帧表示一段时间内画面特点的视频帧。

34.关键帧可以理解为最能代表一段时间内画面特点的视频帧,通常减轻语义分割工作量,抽取关键帧的方法往往是定步长,经过k帧后,取k+1帧作为新的关键帧,本技术相当于提供了一个动态调整的方法。

35.本技术实施例中,图像采集装置被布置在车辆顶部中央位置,以能够拍到车辆所在车道两侧的车道线为宜。车载相机包括但不限于可以输出rgb彩色图像的相机、可以输出灰度图像的摄像机等。

36.步骤s2:将当前帧和第一关键帧输入到光流估计网络,得到特征图f1,通过所述特征图f1获得从第一关键帧变化到当前帧的光流估计矩阵m1。

37.具体地,光流估计网络包括编码器和解码器,将所述当前帧和第一关键帧按通道叠加输入到所述编码器,通过连续的卷积操作提取特征获得特征图f1,所述解码器对所述特征图f1进行采样得到光流估计矩阵m1。

38.步骤s3:将所述特征图f1输入到关键帧判别算法,得到当前帧可以作为关键帧的置信度。

39.具体地,将所述特征图f1输入到所述关键帧判别算法,则所述当前帧可以作为关键帧的置信度定义为:

[0040][0041]

其中,c

i

表示当前帧中识别正确的像素点,p

all

表示当前帧的像素点总数;所述关键帧判别算法包括五层神经网络,第一层为卷积层,第二层至第五层均为全连接层。

[0042]

置信度可以理解为:当前帧识别结果和关键帧识别结果的重合程度,如果置信度低,说明场景变化比较大,关键帧不能代替当前帧的特征,需要把当前帧重新置为关键帧。

[0043]

步骤s4:判断当前帧是否可以更新为关键帧,若是则转至步骤s41,否则转至步骤s42。

[0044]

步骤s41:调用全卷积神经网络对所述当前帧进行语义分割生成第一识别掩膜r1。

[0045]

步骤s42:通过所述第一关键帧的语义分割结果和光流估计矩阵m1生成光流估计后的第二识别掩膜r2。

[0046]

本技术中,设置置信度的阈值为90%,则步骤s41包括:当置信度小于90%时,则当前帧被更新为新的关键帧,即得到第二关键帧,然后通过全卷积神经网络fcn

‑

8s对第二关键帧进行语义分割得到第一识别掩膜r1。

[0047]

具体地,全卷积神经网络fcn

‑

8s的特征在于:在标记训练神经网络使用的图像时,只标记车辆所在车道的车道线,如图2所示,将左右车道线不加区分的统一标注为车道线标签,且对线型不做区分,将车道线识别任务设计成一个二分类问题。

[0048]

被训练用于识别车道线的全卷积神经网络为fcn

‑

8s网络,fcn

‑

8s网络的结构示意图如图3所示,其包括七个卷积层,其中前五个卷积层内部又包括了卷积和最大池化操作,后两个卷积层为dropout层;在经过第一卷积层后输入图像的宽度和高度分别减半,在经过第二卷积层后输出图像的宽度和高度为原图的四分之一,以此类推到第五卷积层输出图像的宽度和高度为原图的三十二分之一;在eltwise1层将第五卷积层的输出结果反卷积进行两倍上采样并和第四卷积层的输出做逐像素值相加的特征融合,将这一融合结果再做两倍上采样,在eltwise2层中和第三卷积层的输出做逐像素相加的特征融合;最后将经过了两次特征融合后的结果做八倍上采样恢复到输入图像尺寸,得到语义分割结果。

[0049]

全卷积神经网络fcn在训练时使用640

×

480像素分辨率的rgb彩色图像作为输入,首先训练了fcn

‑

32s网络并得到一个训练结果,用这一训练结果作为fcn

‑

16s的初始化权重再训练fcn

‑

16s,最后用fcn

‑

16s的训练结果作为初始化权重训练fcn

‑

8s得到最终用于识别车道线的全卷积神经网络fcn

‑

8s,fcn

‑

8s输出的语义分割掩膜如图4所示。

[0050]

步骤s42包括:当置信度大于90%时,当前帧不会被更新为关键帧,若当前帧上的目标像素点坐标为(u0,v0),则所述目标像素点(u0,v0)在所述光流估计矩阵m1上对应的相对于第一关键帧的在水平方向u轴和垂直方向v轴上的位移是x(u,v)和y(u,v),通过式(2)计算目标像素点(u0,v0)的像素值,生成当前帧的第二识别掩膜r2。

[0051]

f(u0,v0)=q(u1,v1)

·

w1+q(u1,v2)

·

w2+q(u2,v1)

·

w3+q(u2,v2)

·

w4;

ꢀꢀ

(2);

[0052]

其中,q(u,v)表示第一识别掩膜r1中像素点(u,v)的像素值,w

j

表示权重,j∈[1,4];4];

[0053]

本技术中,被定义为关键帧的视频帧会调用全卷积神经网络进行语义分割处理生成关键帧对应的车道线结果,不是关键帧的视频帧不通过语义分割,因而可以利用关键帧判别算法减少调用复杂的全卷积神经网络的次数。

[0054]

步骤s5:对所述第一识别掩膜或所述第二识别掩膜进行处理,拟合出表征车道线的二次曲线方程。

[0055]

具体包括:选取第一识别掩膜r1或第二识别掩膜r2中的r通道图像,并将r通道图像中非零灰度值像素点的灰度值置1。

[0056]

将当前帧进行灰度化处理得到一张单通道的第一灰度图像,通过设置r、g、b三个通道灰度值的不同权重,将所述第一灰度图像的每个像素在三个通道上的灰度合并为一个灰度值,得到第二灰度图像,换算关系如式(3)所示:

[0057]

gray=r

×

0.299+g

×

0.587+b

×

0.114;

ꢀꢀꢀ

(3);

[0058]

其中,gray表示换算后的灰度值,即第二灰度图像的灰度值。

[0059]

将所述第二灰度图像和所述r通道图像逐像素相乘,获得基于所述当前帧的语义分割结果,该语义分割结果如图5所示。

[0060]

将所述语义分割结果的全局灰度值放大五倍,此时表示车道线的像素点灰度值将首先达到灰度值上限255,再将全局灰度值除以255并向下取整,则过滤掉了非车道线像素而留下了表征车道线的像素点,如图6所示,从而得到新的得到表征车道线的图像。

[0061]

分别对所述图像0到320列像素和321到640列像素这两个区域做最小二乘法拟合,得到表征车道线的二次曲线方程,即:

[0062][0063]

其中,x

i

、y

i

分别表示所述图像上表示车道线像素点的行坐标、列坐标,i∈[0,640],n=640,a、b、c都表示二次曲线方程的参数。

[0064]

步骤s6:将范围内的行像素逐行代入行坐标到车道线的二次曲线方程中,得到两个列坐标点,并求这两个列坐标点的算术平均值,最终得到一组中点坐标,所述中点坐标即为理想轨迹点。

[0065]

具体地,根据式(4),将所述图像的第260行到第480行像素范围内逐行代入行数值到式(4)求解中点坐标,计算过程为:

[0066][0067]

其中,i

′

∈[260,480],middlepoint(i

′

)表示对应第i

′

行上的中点坐标的列数值,即所述图像上的理想轨迹点,leftline(i

′

)和rightline(i

′

)分别表示左侧和右侧车道线的二次曲线方程对应的第i

′

行上的列数值。由式(5)得到的一组middlepoint点定义为图像上的理想轨迹点,将这一过程可视化如图7所示。

[0068]

步骤s7:根据透视变换的需要,定义世界坐标系、相机坐标系、像素坐标系和成像坐标系,如图8、图9所示,将所述理想轨迹点变换到世界坐标系下。

[0069]

具体地,包括:

[0070]

s71:定义世界坐标系o

w

‑

uvw,世界坐标系的原点可以任意给定,其意义在于能够在真实的三维物理世界中给定一个坐标系以描述物理世界中任一点;世界坐标系通常以所感兴趣的物体为中心建立。本技术中,以汽车相机安装位置在地面上的投影点为世界坐标系的原点,汽车行驶方向为u轴正方向,汽车行驶方向左侧为v轴正方向,汽车行驶方向垂直向上为w轴正方向。特别地,将去掉w方向的二维平面坐标系称为地面坐标系。

[0071]

定义相机坐标系o

c

‑

xyz,相机坐标系由汽车相机的位置唯一确定,一旦汽车相机的光轴和光心确定后,相机坐标系的三个轴就给定了,用来描述真实物理世界中的点在相机坐标系下的坐标。一般忽略相机成像结构尺寸,认为安装位置点就是相机的光心位置。本技术中,汽车相机安装位置点即是原点,原点水平向右为x轴,原点水平向下为y轴,汽车行驶方向为z轴。

[0072]

定义像素坐标系o

p

‑

uv,像素坐标系是按照数字图像处理技术中常见的规定方法规定的,本技术中,以图像左上角为原点,向右为u轴正方向,向下为v轴正方向。

[0073]

定义成像坐标系o

f

‑

xy,成像坐标系由相机的成像平面唯一确定,表示将相机坐标系中的点投影到感光器件上成像得到二维坐标点。成像坐标系是一个二维坐标系,本技术中,原点是光心在感光元件上的投影点,x和y轴的正方向和像素坐标系的约定一致。

[0074]

s72:根据汽车相机的布置情况,确定相机坐标系和世界坐标系之间的变换关系,如式(6)所示:

[0075][0076]

式(6)中,r表示三维旋转变换矩阵,t表示三维平移变换矩阵。

[0077]

s73:建立成像坐标系和相机坐标系之间的变换关系,如式(7)所示:

[0078][0079]

式(7)中,f表示相机的焦距。

[0080]

s74:建立像素坐标系和成像坐标系之间的变换关系,如式(8)所示:

[0081][0082]

式(8)中,d

x

、d

y

表示像素点的实际物理尺寸,一般d

x

=d

y

。

[0083]

s75:由式(6)、式(7)、式(8)联立得到像素坐标系和世界坐标系之间的变换关系,如式(9)所示:

[0084][0085]

事实上,由于需要识别的车道线全部位于地面坐标系上,即w=0;且相机坐标系原点在地面上的投影和世界坐标系相重合,因此z和u坐标值之间满足相机俯仰角的余弦关系。通过给定一个地面坐标系上的感兴趣区域,如u∈[2,15],v∈[

‑

2,2],步进u和v的数值遍历该区域内各离散点并对应到像素坐标系下的u、v值。

[0086]

s76:通过像素坐标系和世界坐标系之间的变换关系,将所述理想轨迹点变换到世界坐标系上。

[0087]

步骤s8:在世界坐标系下对所述理想轨迹点进行二次曲线拟合,生成理想轨迹线,通过所述理想轨迹线方程的常数项参数确定当前车辆的车道偏移情况。

[0088]

具体地,对理想轨迹点利用最小二乘法进行二次曲线拟合即可得到车辆运动的理想轨迹新,理想轨迹线方程为v=au2+bu+c。

[0089]

其中,常数项系数c表示车辆(地面坐标系原点,亦即相机安装位置在地面投影点)偏离车道中心线的程度,当c大于0时表示车辆位置偏右,当c小于0时表示车辆位置偏左。利用虚拟环境中的车辆,展示车道偏移测量方法的识别结果如图10所示,图10的仿真结果显示,当前车辆左偏移0.76米。

[0090]

以上为本公开示范性实施例,本公开的保护范围由权利要求书及其等效物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1