短文本分类方法、装置、设备及存储介质

1.本技术涉及文本识别技术领域,具体而言,本技术涉及一种短文本分类方法、装置、设备及存储介质。

背景技术:

2.近些年来,随着中国医院信息化建设及中国医疗信息化的快速发展,中文电子健康医疗数据急剧增加,且大多呈现是非结构化文本。为大量、便捷地提取结构化文本用于临床试验,通过自然语言处理和机器学习的方法并依据临床试验筛选标准进行文本分类。

3.临床试验是指通过人体志愿者也称为受试者进行的科学研究,根据试验目的等不同,受试者可能是患者或健康志愿者。筛选标准是临床试验负责人拟定的鉴定受试者是否满足某项临床试验的主要指标,分为入组标准和排出标准,一般为无规则的自由文本形式。临床试验的受试者招募一般是通过人工比较病历记录表和临床试验筛选标准完成,这种方式费时费力且效率低下。因此,通过现有的一些自然语言处理技术来进行对临床试验筛选标准进行分类具有重要的意义。

技术实现要素:

4.本技术的目的旨在至少能解决上述的技术缺陷之一,特别是现有技术受试者招募一般是通过人工比较病历记录表和临床试验筛选标准完成,这种方式费时费力且效率低下的技术问题。

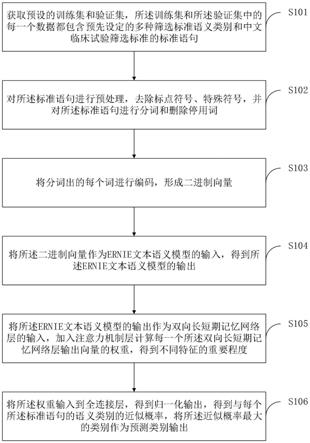

5.第一方面,提供了一种短文本分类方法,包括:

6.获取预设的训练集和验证集,所述训练集和所述验证集中的每一个数据都包含预先设定的多种筛选标准语义类别和中文临床试验筛选标准的标准语句;

7.对所述标准语句进行预处理,去除标点符号、特殊符号,并对所述标准语句进行分词和删除停用词;

8.将分词出的每个词进行编码,形成二进制向量;

9.将所述二进制向量作为ernie文本语义模型的输入,得到所述ernie文本语义模型的输出;

10.将所述ernie文本语义模型的输出作为双向长短期记忆网络层的输入,加入注意力机制层计算每一个所述双向长短期记忆网络层输出向量的权重,得到不同特征的重要程度;

11.将所述权重输入到全连接层,得到归一化输出,得到与每个所述标准语句的语义类别的近似概率,将所述近似概率最大的类别作为预测类别输出。

12.作为本技术一种可能的实施方式,在该实施方式中,所述将所述二进制向量作为ernie文本语义模型的输入,得到所述ernie文本语义模型的输出,包括:

13.为所述二级制向量添加用于任务分类的分隔符,形成词向量;

14.将所述词向量输入到第一encoder层,并将所述第一encoder层的输出结果作为第

二encoder层的输入,得到所述ernie文本语义模型的输出,其中,每层所述encoder层都采用self

‑

attention和feed

‑

word network。

15.作为本技术一种可能的实施方式,在该实施方式中,所述将所述ernie文本语义模型的输出作为双向长短期记忆网络层的输入,包括:

16.所述双向长短期记忆网络层包括前向lstm和后向lstm,每个所述lstm都包括输入门、输出门以及遗忘门;

17.采用如下公式计算所述双向长短期记忆网络层的输出向量:

18.f

t

=σ(w

f

·

[h

t

‑1,x

t

]+b

f

)

[0019]

i

t

=σ(w

i

·

[h

t

‑1,x

t

])+b

i

[0020][0021][0022]

o

t

=σ(w

o

·

[h

t

‑1,x

t

])+b

o

[0023]

h

t

=o

t

⊙

tanh(c

t

)

[0024][0025]

v={v1,v2,

…

,v

t

,,v

t

}

[0026]

其中,f

t

、i

t

、c

t

和o

t

分别表示遗忘门、输入门、候选的单元状态、当前单元状态和输出门;w

f

、w

i

、w

o

和w

c

为对应的权重矩阵;b

f

、b

i

、b

c

和b

o

为对应的偏置;h

t

‑1和h

t

分别表示上一层的隐层状态和当前隐层状态;x

t

为t时刻的输入;σ为非线性激活函数;和分别表示t时刻前向lstm和后向lstm的隐藏层向量,v表示所述双向长短期记忆网络层包的输出向量。

[0027]

作为本技术一种可能的实施方式,在该实施方式中,所述加入注意力机制层计算每一个所述双向长短期记忆网络层输出向量的权重,得到不同特征的重要程度,包括:

[0028]

采用如下公式每一个所述双向长短期记忆网络层输出向量的权重:

[0029]

s(query,key

i

)=query

·

key

i

[0030][0031]

其中,query表示查询矩阵;key

i

表示为第i个键;s

i

表示为第i个词向量的权值;α

i

表示为第i个词向量的权重;t

x

表示为文本向量的长度;v

i

表示第i个输入向量。

[0032]

作为本技术一种可能的实施方式,在该实施方式中,所述将所述权重输入到全连接层,得到归一化输出,包括:

[0033]

采用如下公式计算所述归一化输出:

[0034]

y=tanh(w

c

·

a+b

c

)

[0035]

其中,a表示注意力机制层的输出;w

c

表示全连接层的权重矩阵,b

c

表示全连接层的偏置向量。

[0036]

作为本技术一种可能的实施方式,在该实施方式中,所述得到与每个所述标准语

句的语义类别的近似概率,将所述近似概率最大的类别作为预测类别输出,包括:

[0037]

采用如下公式计算与每个所述标准语句的语义类别的近似概率:

[0038]

y=softmax(w

·

y+b)

[0039]

其中,w表示输出层的权重矩阵,b表示输出层的偏置向量;y表示近似概率。

[0040]

第二方面,提供了一种短文本分类装置,该装置包括:

[0041]

数据获取模块,用于获取预设的训练集和验证集,所述训练集和所述验证集中的每一个数据都包含预先设定的多种筛选标准语义类别和中文临床试验筛选标准的标准语句;

[0042]

数据预处理模块,用于对所述标准语句进行预处理,去除标点符号、特殊符号,并对所述标准语句进行分词和删除停用词;

[0043]

编码模块,用于将分词出的每个词进行编码,形成二进制向量;

[0044]

模型识别模块,用于将所述二进制向量作为ernie文本语义模型的输入,得到所述ernie文本语义模型的输出;

[0045]

重要性识别模块,用于将所述ernie文本语义模型的输出作为双向长短期记忆网络层的输入,加入注意力机制层计算每一个所述双向长短期记忆网络层输出向量的权重,得到不同特征的重要程度;

[0046]

分类模块,用于将所述权重输入到全连接层,得到归一化输出,得到与每个所述标准语句的语义类别的近似概率,将所述近似概率最大的类别作为预测类别输出。

[0047]

第三方面,提供了一种电子设备,该电子设备包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,其特征在于,所述处理器执行所述程序时实现上述的短文本分类方法。

[0048]

第四方面,提供了一种计算机可读存储介质,所述存储介质存储有至少一条指令、至少一段程序、代码集或指令集,所述至少一条指令、所述至少一段程序、所述代码集或指令集由所述处理器加载并执行以实现上述的短文本分类方法。

[0049]

本技术实施例首先将描述中文临床试验筛选标准句子中的每个词进行one

‑

hot编码,将词转换为向量的形式,输入到预训练层erine模型,将其最后transformer层的输出结果输入到bilstm中,以充分考虑当前词的上下文语义信息,再引入attention机制层来计算每个词向量应分配的权重概率,进而捕获到相对重要的文本信息,然后经过全连接层,将分布式特征映射到样本标记空间,最后利用softmax函数对全连接层的输出进行归一化,得到44个筛选标准语义类别的近似概率值,并选取概率最大的作为预测类别输出,能够有效对短文本进行语义识别,自动对病历表进行筛选识别,节约医护人员工作时间,提高效率。

附图说明

[0050]

为了更清楚地说明本技术实施例中的技术方案,下面将对本技术实施例描述中所需要使用的附图作简单地介绍。

[0051]

图1为本技术实施例提供的一种短文本分类方法的流程示意图;

[0052]

图2为本技术实施例提供的一种知识增强语义表示模型的结构示意图;

[0053]

图3为本技术实施例提供的一种双向长短期记忆网络层的结构示意图;

[0054]

图4为本技术实施例提供的一种引入注意力机制attention层的结构示意图;

[0055]

图5为本技术实施例提供的一种短文本分类装置的结构示意图;

[0056]

图6为本技术实施例提供的一种电子设备的结构示意图。

[0057]

结合附图并参考以下具体实施方式,本技术各实施例的上述和其他特征、优点及方面将变得更加明显。贯穿附图中,相同或相似的附图标记表示相同或相似的元素。应当理解附图是示意性的,原件和元素不一定按照比例绘制。

具体实施方式

[0058]

下面详细描述本技术的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,仅用于解释本技术,而不能解释为对本技术的限制。

[0059]

本技术领域技术人员可以理解,除非特意声明,这里使用的单数形式“一”、“一个”、“所述”和“该”也可包括复数形式。应该进一步理解的是,本技术的说明书中使用的措辞“包括”是指存在所述特征、整数、步骤、操作、元件和/或组件,但是并不排除存在或添加一个或多个其他特征、整数、步骤、操作、元件、组件和/或它们的组。应该理解,当我们称元件被“连接”或“耦接”到另一元件时,它可以直接连接或耦接到其他元件,或者也可以存在中间元件。此外,这里使用的“连接”或“耦接”可以包括无线连接或无线耦接。这里使用的措辞“和/或”包括一个或更多个相关联的列出项的全部或任一单元和全部组合。

[0060]

为使本技术的目的、技术方案和优点更加清楚,下面将结合附图对本技术实施方式作进一步地详细描述。

[0061]

本技术提供的短文本分类方法、装置、设备及存储介质,旨在解决现有技术的如上技术问题。

[0062]

下面以具体地实施例对本技术的技术方案以及本技术的技术方案如何解决上述技术问题进行详细说明。下面这几个具体的实施例可以相互结合,对于相同或相似的概念或过程可能在某些实施例中不再赘述。下面将结合附图,对本技术的实施例进行描述。

[0063]

本技术实施例中提供了一种短文本分类方法,如图1所示,该方法包括:

[0064]

步骤s101,获取预设的训练集和验证集,所述训练集和所述验证集中的每一个数据都包含预先设定的多种筛选标准语义类别和中文临床试验筛选标准的标准语句。

[0065]

在本技术实施例中,在对目标短文本进行识别之前,需要先获取到数据集,数据集包括训练集和验证集,数据集可以是中国健康信息处理会议(chip2019)评测数据集chip

‑

ctc,其中每一条训练集和验证集中的数据都包含事先给定的44种筛选标准语义类别和中文临床试验筛选标准的描述句子。

[0066]

步骤s102,对所述标准语句进行预处理,去除标点符号、特殊符号,并对所述标准语句进行分词和删除停用词。

[0067]

在本技术实施例中,在获取到上述数据集中的标准语句之后,对所述标准语句进行预处理,其中,预处理包括但不限于去除标点符号、去除特殊符号,分词以及删除停用词。

[0068]

步骤s103,将分词出的每个词进行编码,形成二进制向量。

[0069]

在本技术实施例中,在对标准语句进行预处理之后,对分词形成的每个词汇进行one

‑

hot编码,将每个词w

t

表示为二进制向量e

t

,即把文本信息转换为计算机可识别的向量形式。

[0070]

步骤s104,将所述二进制向量作为ernie文本语义模型的输入,得到所述ernie文本语义模型的输出。

[0071]

在本技术实施例中,如图2所示,为知识增强语义表示模型的结构示意图,是基于多层transformer编码器构建的语言模型,其结构主要分为transformer编码和知识整合两个部分。前者使用transformer编码器encoder生成词向量表示,通过self

‑

attention机制获取该词向量所对应文本的上下文信息。后者则通过随机隐藏15%的短语和实体级别的知识进行整合保存到文本表示中。为所述二级制向量添加用于任务分类的分隔符,形成词向量;将所述词向量输入到第一encoder层,并将所述第一encoder层的输出结果作为第二encoder层的输入,得到所述ernie文本语义模型的输出,其中,每层所述encoder层都采用self

‑

attention和feed

‑

word network。在预训练文本语义模型层中使用ernie模型,得到起始输入为标记分类任务的分隔符[cls]的词向量,再将输入到encoder层,然后把结果传入到下一个encoder层,其中每层都使用self

‑

attention和feed

‑

word network,最后得到最终的输出,并作为输入传入到bilstm层。知识增强语义表示模型(enhanced representation through knowledge integr

‑

ation,ernie)是基于多层transformer编码器构建的语言模型,其结构主要分为transformer编码和知识整合两个部分。前者使用transformer编码器encoder生成词向量表示,通过self

‑

attention机制获取该词向量所对应文本的上下文信息。后者则通过随机隐藏15%的短语和实体级别的知识进行整合保存到文本表示中。ernie模型主要通过对海量数据中的词、实体和实体关系进行建模来学习现实世界的语义知识。其直接对先验语义知识单元进行建模,增强了模型的语义表示能力,可以捕获训练语料中的潜在信息,如词法、语法和语义。通过预训练,结合一个简单的输出层,得到一个通用的语义表示。

[0072]

步骤s105,将所述ernie文本语义模型的输出作为双向长短期记忆网络层的输入,加入注意力机制层计算每一个所述双向长短期记忆网络层输出向量的权重,得到不同特征的重要程度。

[0073]

在本技术实施中,如图3所述,为双向长短期记忆网络层的结构示意图,所述双向长短期记忆网络层包括前向lstm和后向lstm,每个所述lstm都包括输入门、输出门以及遗忘门;

[0074]

采用如下公式计算所述双向长短期记忆网络层的输出向量,bilstm是由前向lstm和后向lstm组成,可以更好的捕捉双向的语义依赖。lstm是由多个储存单元连接而成。每个单元中包含输入门、输出门和遗忘门,其用于记录和更新记忆单元的信息。其中各个门t时刻的状态更新状态如下:

[0075]

计算遗忘门,有一定概率选择是否遗忘掉上一层的隐藏细胞状态:

[0076]

f

t

=σ(w

f

·

[h

t

‑1,x

t

]+b

f

);

[0077]

计算输入门和候选的单元状态:

[0078]

i

t

=σ(w

i

·

[h

t

‑1,x

t

])+b

i

;

[0079][0080]

计算当前时刻单元状态:

[0081]

[0082]

计算输出门和当前时刻的隐层状态:

[0083]

o

t

=σ(w

o

·

[h

t

‑1,x

t

])+b

o

[0084]

h

t

=o

t

⊙

tanh(c

t

);

[0085]

bilstm的隐藏层由正、反两个不同方向的lstm结合而成,其中在t时刻,正向隐藏层向量为反向隐藏层向量为然后将这两个不同方向的隐藏层向量合并得到t时刻隐藏层输出的向量v

t

,最终连接所有时刻的隐藏层向量得到bilstm层的输出和注意力机制层的输入向量v。

[0086][0087]

v={v1,v2,

…

,v

t

,

……

v

t

}

[0088]

其中,f

t

、i

t

、c

t

和o

t

分别表示遗忘门、输入门、候选的单元状态、当前单元状态和输出门;w

f

、w

i

、w

o

和w

c

为对应的权重矩阵;b

f

、b

i

、b

c

和b

o

为对应的偏置;h

t

‑1和h

t

分别表示上一层的隐层状态和当前隐层状态;x

t

为t时刻的输入;σ为非线性激活函数;和分别表示t时刻前向lstm和后向lstm的隐藏层向量,v表示所述双向长短期记忆网络层包的输出向量。

[0089]

步骤s106,将所述权重输入到全连接层,得到归一化输出,得到与每个所述标准语句的语义类别的近似概率,将所述近似概率最大的类别作为预测类别输出。

[0090]

在本技术实施例中,如图4所示,为引入注意力机制attention层的结构示意图,计算每一个bilstm输出向量v应分配的权重概率,得到不同特征之间的重要程度。

[0091]

对query和key进行相似度计算得到权值,相似性的常用计算方式有向量点积、余弦相似性、多层感知机网络等,其中向量点积相似度计算为:

[0092]

s(query,key

i

)=query

·

key

i

[0093]

利用softmax函数对步骤6.1中的权值进行归一化处理,将其转换为对应的权重:

[0094][0095]

将权重系数与相应的value进行加权求和最终得到attention值。其公式为:

[0096][0097]

其中:query表示查询矩阵;key

i

表示为第i个键;s

i

表示为第i个词向量的权值;α

i

表示为第i个词向量的权重;t

x

表示为文本向量的长度;v

i

表示第i个输入向量;

[0098]

将注意力机制层的输出attention输入到全连接层,并输出为y,计算公式如下:

[0099]

y=tanh(w

c

·

a+b

c

)

[0100]

其中:a表示注意力机制层的输出;w

c

表示全连接层的权重矩阵,b

c

表示全连接层的偏置向量

[0101]

利用softmax函数对全连接层的输出y进行归一化,得到44个筛选标准语义类别的近似概率值y,并选取概率最大的作为预测类别输出。计算公式如下:

[0102]

y=softmax(w

·

y+b)

[0103]

其中:w表示输出层的权重矩阵,b表示输出层的偏置向量。

[0104]

本技术实施例首先将描述中文临床试验筛选标准句子中的每个词进行one

‑

hot编码,将词转换为向量的形式,输入到预训练层erine模型,将其最后transformer层的输出结果输入到bilstm中,以充分考虑当前词的上下文语义信息,再引入attention机制层来计算每个词向量应分配的权重概率,进而捕获到相对重要的文本信息,然后经过全连接层,将分布式特征映射到样本标记空间,最后利用softmax函数对全连接层的输出进行归一化,得到44个筛选标准语义类别的近似概率值,并选取概率最大的作为预测类别输出,能够有效对短文本进行语义识别,自动对病历表进行筛选识别,节约医护人员工作时间,提高效率。

[0105]

本技术实施例提供了一种短文本分类装置,如图5所示,该短文本分类装置50可以包括:数据获取模块501、数据预处理模块502、编码模块503、模型识别模块504、重要性识别模块505、以及分类模块506,其中,

[0106]

数据获取模块501,用于获取预设的训练集和验证集,所述训练集和所述验证集中的每一个数据都包含预先设定的多种筛选标准语义类别和中文临床试验筛选标准的标准语句;

[0107]

数据预处理模块502,用于对所述标准语句进行预处理,去除标点符号、特殊符号,并对所述标准语句进行分词和删除停用词;

[0108]

编码模块503,用于将分词出的每个词进行编码,形成二进制向量;

[0109]

模型识别模块504,用于将所述二进制向量作为ernie文本语义模型的输入,得到所述ernie文本语义模型的输出;

[0110]

重要性识别模块505,用于将所述ernie文本语义模型的输出作为双向长短期记忆网络层的输入,加入注意力机制层计算每一个所述双向长短期记忆网络层输出向量的权重,得到不同特征的重要程度;

[0111]

分类模块506,用于将所述权重输入到全连接层,得到归一化输出,得到与每个所述标准语句的语义类别的近似概率,将所述近似概率最大的类别作为预测类别输出。

[0112]

本技术实施例首先将描述中文临床试验筛选标准句子中的每个词进行one

‑

hot编码,将词转换为向量的形式,输入到预训练层erine模型,将其最后transformer层的输出结果输入到bilstm中,以充分考虑当前词的上下文语义信息,再引入attention机制层来计算每个词向量应分配的权重概率,进而捕获到相对重要的文本信息,然后经过全连接层,将分布式特征映射到样本标记空间,最后利用softmax函数对全连接层的输出进行归一化,得到44个筛选标准语义类别的近似概率值,并选取概率最大的作为预测类别输出,能够有效对短文本进行语义识别,自动对病历表进行筛选识别,节约医护人员工作时间,提高效率。

[0113]

本技术实施例中提供了一种电子设备,该电子设备包括:存储器和处理器;至少一个程序,存储于存储器中,用于被处理器执行时,获取预设的训练集和验证集,所述训练集和所述验证集中的每一个数据都包含预先设定的多种筛选标准语义类别和中文临床试验筛选标准的标准语句;对所述标准语句进行预处理,去除标点符号、特殊符号,并对所述标准语句进行分词和删除停用词;将分词出的每个词进行编码,形成二进制向量;将所述二进制向量作为ernie文本语义模型的输入,得到所述ernie文本语义模型的输出;将所述ernie文本语义模型的输出作为双向长短期记忆网络层的输入,加入注意力机制层计算每一个所述双向长短期记忆网络层输出向量的权重,得到不同特征的重要程度;将所述权重输入到全连接层,得到归一化输出,得到与每个所述标准语句的语义类别的近似概率,将所述近似

概率最大的类别作为预测类别输出。

[0114]

与现有技术相比可实现:本技术实施例首先将描述中文临床试验筛选标准句子中的每个词进行one

‑

hot编码,将词转换为向量的形式,输入到预训练层erine模型,将其最后transformer层的输出结果输入到bilstm中,以充分考虑当前词的上下文语义信息,再引入attention机制层来计算每个词向量应分配的权重概率,进而捕获到相对重要的文本信息,然后经过全连接层,将分布式特征映射到样本标记空间,最后利用softmax函数对全连接层的输出进行归一化,得到44个筛选标准语义类别的近似概率值,并选取概率最大的作为预测类别输出,能够有效对短文本进行语义识别,自动对病历表进行筛选识别,节约医护人员工作时间,提高效率。

[0115]

在一个可选实施例中提供了一种电子设备,如图6所示,图6所示的电子设备4000包括:处理器4001和存储器4003。其中,处理器4001和存储器4003相连,如通过总线4002相连。可选地,电子设备4000还可以包括收发器4004。需要说明的是,实际应用中收发器4004不限于一个,该电子设备4000的结构并不构成对本技术实施例的限定。

[0116]

处理器4001可以是cpu(central processing unit,中央处理器),通用处理器,dsp(digital signal processor,数据信号处理器),asic(application specific integrated circuit,专用集成电路),fpga(field programmable gate array,现场可编程门阵列)或者其他可编程逻辑器件、晶体管逻辑器件、硬件部件或者其任意组合。其可以实现或执行结合本技术公开内容所描述的各种示例性的逻辑方框,模块和电路。处理器4001也可以是实现计算功能的组合,例如包含一个或多个微处理器组合,dsp和微处理器的组合等。

[0117]

总线4002可包括一通路,在上述组件之间传送信息。总线4002可以是pci(peripheral component interconnect,外设部件互连标准)总线或eisa(extended industry standard architecture,扩展工业标准结构)总线等。总线4002可以分为地址总线、数据总线、控制总线等。为便于表示,图6中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

[0118]

存储器4003可以是rom(read only memory,只读存储器)或可存储静态信息和指令的其他类型的静态存储设备,ram(random access memory,随机存取存储器)或者可存储信息和指令的其他类型的动态存储设备,也可以是eeprom(electrically erasable programmable read only memory,电可擦可编程只读存储器)、cd

‑

rom(compact disc read only memory,只读光盘)或其他光盘存储、光碟存储(包括压缩光碟、激光碟、光碟、数字通用光碟、蓝光光碟等)、磁盘存储介质或者其他磁存储设备、或者能够用于携带或存储具有指令或数据结构形式的期望的程序代码并能够由计算机存取的任何其他介质,但不限于此。

[0119]

存储器4003用于存储执行本技术方案的应用程序代码,并由处理器4001来控制执行。处理器4001用于执行存储器4003中存储的应用程序代码,以实现前述方法实施例所示的内容。

[0120]

本技术实施例提供了一种计算机可读存储介质,该计算机可读存储介质上存储有计算机程序,当其在计算机上运行时,使得计算机可以执行前述方法实施例中相应内容。与现有技术相比,本技术实施例首先将描述中文临床试验筛选标准句子中的每个词进行one

‑

hot编码,将词转换为向量的形式,输入到预训练层erine模型,将其最后transformer层的输出结果输入到bilstm中,以充分考虑当前词的上下文语义信息,再引入attention机制层来计算每个词向量应分配的权重概率,进而捕获到相对重要的文本信息,然后经过全连接层,将分布式特征映射到样本标记空间,最后利用softmax函数对全连接层的输出进行归一化,得到44个筛选标准语义类别的近似概率值,并选取概率最大的作为预测类别输出,能够有效对短文本进行语义识别,自动对病历表进行筛选识别,节约医护人员工作时间,提高效率。

[0121]

应该理解的是,虽然附图的流程图中的各个步骤按照箭头的指示依次显示,但是这些步骤并不是必然按照箭头指示的顺序依次执行。除非本文中有明确的说明,这些步骤的执行并没有严格的顺序限制,其可以以其他的顺序执行。而且,附图的流程图中的至少一部分步骤可以包括多个子步骤或者多个阶段,这些子步骤或者阶段并不必然是在同一时刻执行完成,而是可以在不同的时刻执行,其执行顺序也不必然是依次进行,而是可以与其他步骤或者其他步骤的子步骤或者阶段的至少一部分轮流或者交替地执行。

[0122]

以上所述仅是本技术的部分实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本技术原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视为本技术的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1