多熊猫跟踪方法、系统、终端设备及可读存储介质与流程

1.本发明属于计算机视觉技术领域,特别涉及一种多熊猫跟踪方法、系统、终端设备及可读存储介质。

背景技术:

2.目前的多目标跟踪工作主要是针对行人和汽车,也有少部分针对动物甚至是细胞。目前,尚没有针对熊猫这种外观极其相似和姿态多样化的动物的视频跟踪工作;同时,多熊猫跟踪任务由于熊猫的姿态多样化和极其相似的外观,具有不同于行人和汽车跟踪的技术难点。

3.目前传统的基于深度学习的跟踪方法可以把跟踪任务分成目标检测和数据关联两个步骤,为每个步骤开发最适合的模型能够达到最好的跟踪精度。其中,对于目标检测阶段的遮挡问题,现有方法一般采用运动建模的方式来进行轨迹预测来补充目标检测中的漏检;对于数据关联阶段的身份标签转换问题,现有方法一般使用重识别网络来提取目标的外观特征,用于计算上下帧目标之间的外观相似度来关联上下帧的目标。

4.对于多熊猫跟踪任务,在目标检测过程中,不同于普遍站立的行人和不会形变的汽车,姿势多样化熊猫之间的遮挡是一个更大挑战,会影响目标检测阶段的准确性。熊猫的运动方向和运动模式相比于行人和车辆来说更加复杂,难以进行运动建模;同时,对于外观相似度极高的熊猫来说,通过现有工作中使用的普通的外观特征将上下帧的同一只熊猫个体关联起来是一个极大的挑战。

5.综上,亟需一种新的基于细粒度外观特征的多熊猫跟踪方法及系统。

技术实现要素:

6.本发明的目的在于提供一种多熊猫跟踪方法、系统、终端设备及可读存储介质,以解决上述存在的一个或多个技术问题。本发明中能够实现多熊猫跟踪,可以提高多熊猫跟踪的跟踪准确率和轨迹持久性。

7.为达到上述目的,本发明采用以下技术方案:

8.本发明的一种多熊猫跟踪方法,包括以下步骤:

9.获取待多熊猫跟踪的视频中每个视频帧的熊猫个体检测结果集合;基于所述每个视频帧的熊猫个体检测结果集合,获得轨迹集合;

10.基于短期预测网络,获得视频中每个视频帧的熊猫轨迹预测位置集合;

11.基于过滤算法,通过所述每个视频帧的熊猫轨迹预测位置集合中的熊猫轨迹预测位置对所述每个视频帧的熊猫个体检测结果集合中的熊猫个体检测结果进行置信度优化,获得关联候选目标集合;

12.每个视频帧中,提取所述关联候选目标集合中关联候选目标的局部特征和全局特征,利用局部特征和全局特征获得融合外观特征;

13.每个视频帧中,基于所述融合外观特征将关联候选目标集合中的关联候选目标与

轨迹集合中的轨迹关联,实现多熊猫跟踪。

14.本发明的进一步改进在于,所述基于所述每个视频帧的熊猫个体检测结果集合,获得轨迹集合的步骤具体包括:

15.视频中的第一视频帧,通过预设置信度阈值过滤掉置信度低于预设置信度阈值的熊猫个体检测结果,将剩余的熊猫个体检测结果初始化为轨迹,添加到轨迹集合;

16.视频中的剩余视频帧,对每一帧的熊猫个体检测结果进行上下帧关联,关联在一起的熊猫个体检测结果形成轨迹,添加到轨迹集合。

17.本发明的进一步改进在于,所述短期预测网络为siamese网络。

18.本发明的进一步改进在于,所述基于过滤算法,通过所述每个视频帧的熊猫轨迹预测位置集合中的熊猫轨迹预测位置对所述每个视频帧的熊猫个体检测结果集合中的熊猫个体检测结果进行置信度优化,获得关联候选目标集合的步骤具体包括:

19.对于熊猫轨迹预测位置集合和熊猫个体检测结果集合计算iou代价矩阵f

c

,计算方式如下:

20.f

c

=1

‑

iou(s

t

,d

t

),

21.式中,iou表示的是两个bounding box之间的交并比;

22.基于所述iou代价矩阵f

c

通过匈牙利算法寻找熊猫轨迹预测位置和熊猫个体检测结果之间的最佳匹配,获得关联候选目标集合。

23.本发明的进一步改进在于,所述基于所述iou代价矩阵f

c

通过匈牙利算法寻找熊猫轨迹预测位置和熊猫个体检测结果之间的最佳匹配,获得关联候选目标集合的步骤具体包括:

24.熊猫轨迹预测位置和熊猫个体检测结果之间的iou大于阈值0.5时,表示二者之间不能匹配,通过匈牙利算法得到匹配的检测框和预测框对、未匹配检测框和未匹配预测框;

25.如果一个熊猫个体检测结果能匹配到熊猫轨迹预测位置,将所述熊猫个体检测结果的置信度设置为0.9;将未匹配的熊猫轨迹预测位置加入到关联候选目标集合中;将置信度低于0.4的熊猫个体检测结果删除掉。

26.本发明的进一步改进在于,所述提取所述关联候选目标集合中关联候选目标的局部特征和全局特征的步骤具体包括:

27.通过resnet50获取关联候选目标的特征图,通过全局平均池化获得全局特征f

global

;

28.将resnet50的中层特征图利用一个卷积核为1

×

1的卷积滤波器和全局最大池化获得局部特征f

local

;

29.在训练的时候,针对全局特征提取和局部特征提取这两个分支,提取到全局特征和局部特征之后,分别通过全连接层进行分类;其中,采用交叉熵损失作为识别损失,损失函数如下:

30.l

id

=l

local

+l

global

,

[0031][0032]

式中:其中n代表熊猫个体的数量;p(y

n

|x

n

)表示第n只熊猫个体被正确识别的概率;通过优化l

id

具有辨别力的细粒度特征被隐式学习;

[0033]

所述利用局部特征和全局特征获得融合外观特征的步骤具体包括:

[0034]

融合外观特征f

fusion

通过全局特征和局部特征元素相乘获得,表达式为:

[0035]

f

fusion

=f

global

⊙

f

local

,

[0036]

式中:

⊙

表示的哈达玛积或称基本集。

[0037]

本发明的进一步改进在于,所述基于所述融合外观特征将关联候选目标集合中的关联候选目标与轨迹集合中的轨迹关联,实现多熊猫跟踪的步骤具体包括:

[0038]

计算获得轨迹的外观特征f

trk

,计算方式为通过轨迹中的目标的外观特征组合形成;

[0039]

计算轨迹的外观特征f

trk

和熊猫个体检测结果外观特征f

d

的距离矩阵,通过距离矩阵利用匈牙利算法进行轨迹和熊猫个体检测结果的关联;

[0040]

将剩余未匹配到的轨迹的外观特征f

rtrk

和熊猫轨迹预测位置的外观特征f

s

计算距离矩阵,通过距离矩阵利用匈牙利算法进行熊猫轨迹预测位置和剩余未匹配到的轨迹关联。

[0041]

本发明的一种多熊猫跟踪系统,包括:

[0042]

检测结果和轨迹获取模块,用于获取待多熊猫跟踪的视频中每个视频帧的熊猫个体检测结果集合;基于所述每个视频帧的熊猫个体检测结果集合,获得轨迹集合;

[0043]

预测结果获取模块,用于基于短期预测网络,获得视频中每个视频帧的熊猫轨迹预测位置集合;

[0044]

关联候选目标获取模块,用于基于过滤算法,通过所述每个视频帧的熊猫轨迹预测位置集合中的熊猫轨迹预测位置对所述每个视频帧的熊猫个体检测结果集合中的熊猫个体检测结果进行置信度优化,获得关联候选目标集合;

[0045]

特征获取模块,用于在每个视频帧中,提取所述关联候选目标集合中关联候选目标的局部特征和全局特征,利用局部特征和全局特征获得融合外观特征;

[0046]

关联跟踪模块,用于在每个视频帧中,基于所述融合外观特征将关联候选目标集合中的关联候选目标与轨迹集合中的轨迹关联,实现多熊猫跟踪。

[0047]

本发明的一种终端设备,包括:处理器;存储器,用于存储计算机程序指令;所述计算机程序指令由所述处理器加载并运行时,所述处理器执行本发明任一项上述的多熊猫跟踪方法。

[0048]

本发明的一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序指令,所述计算机程序指令被处理器加载并运行时,所述处理器执行本发明任一项上述的多熊猫跟踪方法。

[0049]

与现有技术相比,本发明具有以下有益效果:

[0050]

本发明提供了一种基于细粒度外观特征的多熊猫跟踪方法,具体针对现有多目标跟踪方法用于多熊猫跟踪任务所存在的不准确的检测问题和身份标签转换问题,提出了基于细粒度外观特征的多熊猫跟踪方法,有效利用短期预测过滤算法对不准确检测进行优化,针对身份标签转换问题采用熊猫细粒度特征学习网络和特征融合来获得熊猫具有辨别力的外观特征用于计算熊猫个体之间的外观相似度,可以提高多熊猫跟踪的跟踪准确率和轨迹持久性。

[0051]

本发明中,利用短期预测过滤算法进行轨迹预测并对目标检测结果进行优化可以

补充漏检删除误检,同时利用熊猫细粒度特征学习网络和特征融合来获得熊猫具有辨别力的外观特征减少数据关联阶段中的身份标签转换,能够实现多熊猫跟踪,可以提高多熊猫跟踪的跟踪准确率和轨迹持久性。

附图说明

[0052]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面对实施例或现有技术描述中所需要使用的附图做简单的介绍;显而易见地,下面描述中的附图是本发明的一些实施例,对于本领域普通技术人员来说,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0053]

图1是本发明实施例的一种基于细粒度外观特征的多熊猫跟踪方法的流程示意图;

[0054]

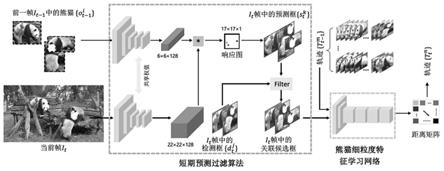

图2是本发明实施例中,熊猫细粒度特征学习网络的结构示意图;

[0055]

图3是本发明实施例中,本发明实施例的方法与已有四种多目标跟踪方法在panda2021数据集的实验结果对比示意图。

具体实施方式

[0056]

为使本发明实施例的目的、技术效果及技术方案更加清楚,下面结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述;显然,所描述的实施例是本发明一部分实施例。基于本发明公开的实施例,本领域普通技术人员在没有做出创造性劳动的前提下所获得的其它实施例,都应属于本发明保护的范围。

[0057]

请参阅图1,本发明实施例的一种基于细粒度外观特征的多熊猫跟踪方法,具体包括如下步骤:

[0058]

步骤1,获取视频中每个视频帧的熊猫个体检测结果集合;基于每个视频帧的熊猫个体检测结果集合,获得初始轨迹集合。具体的,对于每个视频序列的第一帧i0,通过阈值φ

um

过滤掉置信度较低的检测框将剩余的检测框初始化为轨迹,并添加到轨迹集合中。然后对每一帧的检测结果进行上下帧的关联,最后各个关联在一起的检测形成了轨迹,加入到轨迹集合中。

[0059]

步骤2,通过短期预测网络进行轨迹预测获得目标预测位置:

[0060]

1)短期预测网络是基于相似学习提出来的siamese网络,其骨架网络一个修改过的alexnet网络。该网络去掉了padding和全连接层,添加了batchnorm层,形成一个全卷积网络。

[0061]

2)输入的模板图片是在i

t

‑1帧中更新过的轨迹中的熊猫个体其中k表示在i

t

‑1帧更新过的轨迹数量;表示的是第k个熊猫图像块。输入的搜索区域为

[0062]

3)在视频序列第t帧时,熊猫个体和当前帧的相似度度量方法f

s

可以定义为:

[0063][0064]

式中:表示的是深度特征提取操作;*表示的是互相关操作,在这里是卷积操

作;表示的是在每个位置上相等的相似性的偏移量。

[0065]

4)相似性度量方法f

s

的输出不是一个值而是一个相似性响应图。将响应矩阵的最大点映射到原始图像i

t

上,得到当前帧该目标的预测结果对于所有轨迹中的目标o

t

‑1,可以通过短期预测算法产生预测框集合

[0066]

5)短期预测网络是利用正负样本图像对来训练siamese网络,采用的loss为:

[0067]

l(y,v)=log(1+exp(

‑

yv)),

[0068]

式中:其中v表示的是模板图片和候选图片对的预测分数;y∈{+1,

‑

1},y表示的是实际类别,如果图像对是同一个目标,那么y的取值为1,否则取值为

‑

1。

[0069]

步骤3:使用过滤算法对目标检测结果进行优化获得关联候选目标:

[0070]

1)首先对于预测框集合和检测框集合计算iou代价矩阵f

c

,计算方式如下:

[0071]

f

c

=1

‑

iou(s

t

,d

t

),

[0072]

式中:iou表示的是两个bounding box之间的交并比(intersection over unions)。iou的计算是使用两个bounding box的相交面积除以两个bounding box的并集面积。

[0073]

2)利用预测框和检测框之间的iou代价矩阵f

c

来通过匈牙利算法来寻找预测框和检测框之间的最佳匹配。

[0074]

3)当检测框和预测框之间的iou大于阈值α=0.5时,表示该检测框和预测框之间不能匹配。最后可以通过匈牙利算法得到匹配的检测框和预测框对,未匹配检测框和未匹配预测框。

[0075]

4)如果一个检测框能匹配到预测框,将这个检测框的置信度设置为φ

m

=0.9。对于未匹配的预测框,会被认为是一个漏检,加入到后续的关联候选框中。置信度低于φ

um

=0.4的检测框被认为是误检,将被删除掉。

[0076]

步骤4:提取关联候选目标的局部特征和全局特征:

[0077]

1)通过关联候选框在当前帧裁剪出的图片块然后将大小统一调整到尺寸为3

×

128

×

128的关联候选目标。

[0078]

2)通过resnet50获得512

×8×

8的特征图,然后通过全局平均池化(global average pooling,gap)获得全局特征f

global

。

[0079]

3)将resnet50的中层特征图利用一个卷积核为1

×

1的卷积滤波器(块检测器)和全局最大池化(global max pooling,gmp)来获得具有辨别力的局部特征f

local

。

[0080]

4)在训练的时候,针对全局特征提取和局部特征提取这两个分支,提取到全局特征和局部特征之后,分别通过全连接层进行分类。本发明采用交叉熵损失作为识别损失,分别增强两个分支的识别能力,损失函数如下:

[0081]

l

id

=l

local

+l

global

,

[0082][0083]

式中:其中n代表熊猫个体的数量;p(y

n

|x

n

)表示第n只熊猫个体被正确识别的概率。最后通过优化l

id

具有辨别力的细粒度特征会被隐式学习。

[0084]

步骤5:利用局部特征和全局特征获得融合外观特征:

[0085]

1)融合外观特征融合特征f

fusion

的可以通过全局特征和局部特征元素相乘获得:

[0086]

f

fusion

=f

global

⊙

f

local

,

[0087]

式中:

⊙

表示的哈达玛积(hadamard product)或称基本集。

[0088]

2)关联候选框集合中包含的预测框和检测框分别通过熊猫细粒度特征学习网络和特征融合获得每框对应目标的外观特征分别记为f

d

和f

s

。

[0089]

步骤6:轨迹和关联候选目标的关联:

[0090]

1)轨迹的外观特征f

trk

的计算方式是通过轨迹中的目标的外观特征的组合形成。

[0091]

2)先计算轨迹外观特征f

trk

和检测框外观特征f

d

的距离矩阵,然后通过距离矩阵利用匈牙利算法进行轨迹和检测框的关联,获得匹配到的候选目标和轨迹对、未匹配候选目标以及未匹配轨迹。

[0092]

3)利用剩下的未匹配到的轨迹的外观特征f

rtrk

和预测框的外观特征f

s

计算距离矩阵,然后进行预测框和剩余轨迹的关联。其中,未匹配候选目标被看作是新出现的目标,初始化为轨迹。对于匹配到的候选目标和轨迹对,将候选目标位置信息和当前帧时间戳加入放到轨迹,并且把候选目标的外观特征加入到轨迹的外观特征中。

[0093]

本发明实施例中,采用的方法遵循检测跟踪(tracking

‑

by

‑

detection)范式,首先获得检测结果,然后对每一帧的检测结果进行上下帧的关联,最后各个关联在一起的检测形成了轨迹。本发明中的短期预测过滤算法,可以通过单目标跟踪网络对轨迹进行短期预测,然后通过预测框(对检测框进行过滤和补充,然后得到较为准确的关联候选框。在后面的数据关联阶段,本发明利用熊猫细粒度特征学习网络和特征融合,通过候选框中目标的融合外观特征计算目标和轨迹之间的距离矩阵,最后通过距离矩阵对目标和轨迹进行关联。

[0094]

请参阅图2,图2是本发明中熊猫细粒度特征学习网络的结构示意图。本发明通过非对称双流结构分别来获得全局特征和局部特征。将本发明所提出的具有非对称双流结构的熊猫细粒度特征提取网络看作全局流(global stream)和局部流(local stream)。其中全局流是通过resnet50获取特征图然后经过全局平均池化(gmp)和分类层输出分类信息,然后使用分类损失来进行优化。局部流就通过resnet50的中间层获得特征图,然后利用1

×

1卷积滤波器进行特征过滤,获得具有辨别力的局部特征,然后通过全局最大池化(gmp)和分类层获得分类信息,最后使用分类损失来进行网络优化。

[0095]

请参阅图3,图3为本发明方法和已有四种多目标跟踪方法在panda2021数据集的实验结果示意图。可以清楚地看到,本发明所提出的多熊猫跟踪方法能够更好地缓解由于依偎在一起导致的漏检,能够在一定程度上准确地跟踪未被检测到的熊猫。此外,本发明提出的多熊猫跟踪方法可以产生更持久的轨迹,具有更少的短轨迹碎片和更少的身份转换。

[0096]

表1为在panda2021数据集下该方法的实验结果。panda2021是一个针对多熊猫跟踪任务的数据集。这里针对panda2021数据集进行实验,对各方法的预测轨迹进行评估。

[0097]

表1.在panda2021数据集下该方法的实验结果

[0098][0099]

本发明实施例中,实验的评测指标包含多种,各个指标的解释如下:

[0100]

1)fp:假正例(false positives)总数,这里表示的是误检目标数。

[0101]

2)fn:假反例(false negatives)总数,这里表示的是漏检目标数。

[0102]

3)recall:正确检测与ground

‑

truth bounding boxes总数之比。

[0103]

4)ids:身份转换(identity switches)总数。

[0104]

5)mota:多目标跟踪准确率(multiple object tracking accuracy),这种方法综合考虑了三个错误来源:误检、漏检目标和身份转换,计算公式为:式中:gt是ground

‑

truth box的数目。

[0105]

6)frag.:一个轨迹被分割的总次数。

[0106]

7)mt:大部分被跟踪到的目标(mostly tracked targets)。至少在其各自生命周期的80%内被预测轨迹覆盖的ground

‑

truth轨迹的比率。

[0107]

8)ml:大部分未被跟踪到的目标(mostly lost targets)。最长不超过其各自寿命的20%假设轨迹所涵盖的ground

‑

truth轨迹的比例。

[0108]

9)motp:多目标跟踪精度(multi

‑

object tracking precision),ground

‑

truth bounding box与预测轨迹中框之间的不对齐,计算公式为:式中:c

t

表示第t帧中的匹配数,而d

t,i

是预测i与匹配的ground

‑

truth目标之间的bounding box重叠。

[0109]

10)idr:识别召回率(identification recall),计算公式为:式中:idtp是选择为真正id匹配的百分比。idfn是所选假反id匹配的百分比,idfp是所选假正id匹配的百分比。

[0110]

11)idp:识别准确率(identification precision),计算公式为:

[0111]

12)idf1:id的f1分数(identification f1 score)。正确识别的检测与ground

‑

truth和计算检测的平均数量之比,计算公式为:

[0112]

mota和idf1是衡量跟踪质量的最重要的综合指标。和mota相比,idf1对id转换更加敏感,更能表示轨迹的持久性。而和idf1相比,mota考虑到了误检和漏检。从表1的实验结果可以看出,本发明提出的多熊猫跟踪方法与对比的方法相比具有一定的优势,从mota和idf1性能上可以看出。本发明实施例提出的方法在idf1和mota中分别比第二名和提高了7.2%和2.4%。就idp和idr而言,本发明实施例提出的多熊猫跟踪方法比第二名分别高出

4.2%和8.6%。此外,本发明实施例提出的方法在panda2021上的身份转换(ids)次数最少,而其他方法的身份转换次数是该方法的1.7~5.9倍。在recall和mt指标上,本发明实施例所提出的方法是次优的,比最优方法降了2.6%和3%。

[0113]

综上,本发明实施例公开了一种基于细粒度外观特征的多熊猫跟踪方法,属于计算机视觉领域,主要应用于视频序列中的多熊猫跟踪任务。针对由于熊猫姿势和遮挡导致的不准确检测问题,本发明使用短期预测过滤算法对检测结果进行过滤,可以在一定程度上补充漏检的熊猫和过滤掉误检。针对熊猫个体由于外观相似导致的身份标签转换问题,本发明使用了针对熊猫的细粒度特征,可以用来作为熊猫个体的外观表示,用于在时间和空间上区别具有相似外观和细微差别的不同熊猫个体。

[0114]

本领域内的技术人员应明白,本技术的实施例可提供为方法、系统、或计算机程序产品。因此,本技术可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd

‑

rom、光学存储器等)上实施的计算机程序产品的形式。

[0115]

本技术是参照根据本技术实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0116]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0117]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

[0118]

以上实施例仅用以说明本发明的技术方案而非对其限制,尽管参照上述实施例对本发明进行了详细的说明,所属领域的普通技术人员依然可以对本发明的具体实施方式进行修改或者等同替换,这些未脱离本发明精神和范围的任何修改或者等同替换,均在申请待批的本发明的权利要求保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1