一种基于特征映射的多角度侧脸正面化方法

1.本发明涉及一种基于特征映射的多角度侧脸正面化方法,属于侧脸正面化方法领域。

背景技术:

2.随着人工智能的不断发展,人脸识别已经广泛应用于安防系统、视频监控等领域。监控场景下的人脸会存在多种姿态变化,如正脸、偏转角度侧脸和同时包含偏转和俯角变化的侧脸。由于侧脸存在自遮挡问题使得面部中部分关键身份特征缺失,直接使用侧脸与正脸进行识别难度较大。为了缓解这一问题,一般会采用正面化方法,即利用单张或多张侧脸图像恢复出虚拟正脸,再进行识别。这种方法可以作为一种预处理过程,嵌套到现有人脸识别模型中,从而不需要重新训练识别模型,并且在某些场景中,正面化的结果可以作为关键的参考材料,例如在刑侦领域,可以为办案人员提供参考。

3.现有主要方法有基于三维模型的方法和基于二维图像的方法。基于三维模型的方法主要根据人脸的三维模型进行建模,计算出不同姿态下图像之间像素点的位移关系(形变场),再作用于二维图像得到正面化图像。比如中国专利201710120029.7提出一种可学习形变场的人脸正面化方法,实现了偏转方向上的人脸正面化,但在多角度侧脸图像上效果较差,容易出现人工伪影。基于二维图像的方法是直接利用正面图像作为训练目标,得到生成的正面化图像。

4.基于三维模型的方法需要二维图像和三维模型之间的相互映射,这一过程会引入一些误差,且正面化结果通常不够真实,会出现人工伪影和严重的面部纹理信息丢失情况。基于二维的方法恢复出的结果虽然较为平滑,但得到的正面图像身份信息保留较低。此外,现有方法主要针对偏转方向上的侧脸进行正面化,对监控视角下同时包含偏转和俯角变化的侧脸关注较少。

技术实现要素:

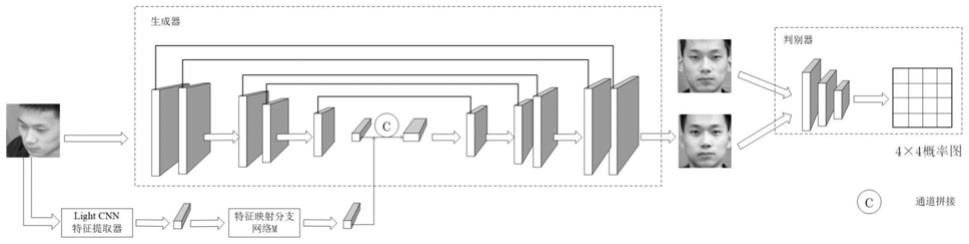

5.为了解决上述问题中的不足之处,提高现有人脸识别模型在多角度侧脸图像上的识别能力,,本发明提出了一种基于特征映射的多角度侧脸正面化方法,可以实现包括偏转方向及偏转

‑

俯角方向的22个角度变化的侧脸正面化,其中偏转方向从

‑

90度到90度以15度为间隔共13个角度,在偏转角为0度、

±

30度和

±

60度处加入30度和45度俯角的10个偏转

‑

俯角。该方法加入了特征映射模块和眼周像素级保留损失,可以生成视觉效果更好,身份信息保留更多的正面人脸图像。

6.本发明中,采用人脸正面化方法(将侧脸图像矫正为正脸图像,利用矫正后的正脸进行识别)以提高现有人脸识别模型在多姿态人脸图像上的识别能力。

7.生成对抗网络的生成器由编码器和解码器组成,其中编码器包括两部分:一部分利用light cnn提取输入侧脸图像特征,通过模型m将侧脸特征转换为正脸特征;另一部分利用原始生成对抗网络gan的编码器提取输入侧脸图像特征,将两部分得到的特征在通道

维度上拼接,输入到生成对抗网络的解码器,输出虚拟正脸图像。

8.为了使虚拟正脸图像保留较多输入侧脸图像的身份信息,在现有全局身份保留损失基础上,本发明加入眼周区域像素级保留损失,以提高虚拟正脸眼周区域的身份保留。

9.生成对抗网络的判别器输入真实正脸图像和虚拟正脸图像,判别生成图像和真实图像为真的概率值,从而对生成器造成一定的惩罚,使得生成器生成的结果更接近真实图像。

10.本发明所使用的服务器硬件配置,为nvidiatesla p

‑

100高性能gpu服务器,显存为16g,所采用的操作系统为ubuntu18.0.4,代码采用python编程语言实现。

11.本发明提供了一种基于特征映射的多角度侧脸正面化方法,包括以下步骤:

12.(1)构建训练样本:获取一批有姿态标注的人脸图像数据集作为训练集/测试集,每个人包含多种偏转角度和偏转

‑

俯仰角度下的姿态;

13.所述姿态包括偏转方向从

‑

90度到90度以15度为间隔共13个角度,在偏转角为0度、

±

30度和

±

60度处加入30度和45度(因为监控视角下的人脸受到的俯角大致位于这两个角度范围内,这两个俯角更符合现实监控场景中人脸受到的俯角)俯角的10个偏转

‑

俯角。

14.(2)将侧脸图像作为输入图像,基准正脸图像作为目标图像,开源的人脸识别模型light cnn作为特征提取器,学习侧脸特征到正脸特征之间的映射关系,得到模型m;

15.(3)利用生成对抗网络(generative adversarial network,gan)作为侧脸正面化模型主干网络,以侧脸图像作为输入图像,利用步骤(2)中的模型m将侧脸特征映射为正脸特征,同时gan网络中的编码器提取侧脸图像特征,将两部分特征在通道维度上进行拼接,作为解码器的输入特征,该网络最终输出逼真的虚拟正面人脸图像;

16.(4)利用处理好的训练样本训练侧脸正面化模型;

17.(5)将新获取的侧面人脸图像输入训练好的侧脸正面化模型中,输出和目标图像接近的虚拟正面人脸图像。

18.具体地,训练好的模型包括用于将侧脸特征映射为正脸特征的特征映射分支网络,用于特征提取、正脸生成和判别真假的gan网络,最终生成和目标图像接近的虚拟正脸图像。

19.本发明的特征提取模块包括两路,以预处理的侧脸图像作为输入,一路将侧脸特征经过特征映射分支网络m获得映射后的正脸特征;另一路通过gan中的编码器网络,获得相应的侧脸特征,再将两路得到的特征在通道维度上进行拼接,作为gan网络中解码器的输入,经过解码器的多次反卷积上采样最终生成和目标图像接近的虚拟正脸图像。

20.人脸正面化模型可以作为一种预处理方法,嵌套到现有人脸识别模型中,因此,为了提高生成图像身份信息保留能力,本发明在全局身份保留损失的基础上,加入了眼周区域像素级保留损失来训练网络,通过同时关注面部全局深层特征和眼周局部像素级特征,使得生成正脸图像保留更多关键身份信息。

21.具体的,所述的全局身份保留损失和局部眼周像素级保留损失的表达式为:

[0022][0023]

其中表示利用预训练的人脸识别网络light cnn提取的最后一层全连接层

的特征,由于light cnn是在大规模数据集上训练,因此它可以捕捉到更显著的人脸特征。该损失函数l

ip

用于在深层特征空间降低生成图和基准图的距离,从而使得生成图像保留身份信息。其中i

gen

表示生成图像,i

gt

表示基准正脸图像,表示向量2范数。

[0024][0025]

其中i表示第i个图像尺寸(分辨率分别为128

×

128和64

×

64),i

gen

表示生成图像,i

gt

表示基准正脸图像,w

i

和h

i

分别表示每个眼周图像的宽和高,c表示图像的通道数,l

e

表示眼周区域像素级保留损失,w、h、c分别表示对应像素的宽、高和通道。上述公式用于最小化分辨率为128和64的生成图像i

gen

和目标图像i

gt

对在眼周区域(包括眉毛和眼睛)上的像素值距离。

[0026]

l

ip

表示身份保持损失,确定是否为同一个人,关注人脸全局。le表示眼周损失,计算两张图片眼周区域差距,关注局部损失。

[0027]

本发明的有益效果:

[0028]

本发明不仅能对监控视角下的多角度侧脸图像恢复出视觉效果逼真的正面人脸图像,且训练过程比基于三维的方法简单,人工伪影少,同时相比基于二维的方法,可以从全局和局部两个角度上保留更多的身份特征信息,对于识别更有帮助,特别是在多角度变化的人脸上,识别率得到提升。此外,生成结果也可作为参考材料用于特定场景。

附图说明

[0029]

图1所示为本发明构建的侧脸正面化模型图;

[0030]

图2所示为本发明的逻辑图;

[0031]

图3为训练好的侧脸正面化模型在不同角度下输入图像、生成图像和目标图像的对比图。

具体实施方式

[0032]

下面通过实施例来进一步说明本发明,但不局限于以下实施例。

[0033]

实施例1:

[0034]

本发明提出一种基于特征映射的多角度侧脸正面化方法,包括以下步骤:

[0035]

(1)构建训练样本:获取一批有姿态标注的人脸图像数据集作为训练集/测试集,每个人包含多种偏转角度和偏转

‑

俯仰角度下的姿态;

[0036]

(2)将侧脸图像作为输入图像,正脸图像作为目标图像,开源的人脸识别模型light cnn作为特征提取器,学习侧脸特征到正脸特征之间的映射关系,得到模型m;

[0037]

(3)利用gan网络作为侧脸正面化模型主干网络,以侧脸图像作为输入图像,利用步骤(2)中的模型m将侧脸特征映射为正脸特征,同时gan网络中的编码器提取侧脸图像特征,将两部分特征在通道维度上进行拼接,作为解码器的输入特征,该网络最终输出逼真的虚拟正面人脸图像;

[0038]

(4)利用处理好的训练样本训练侧脸正面化模型;

[0039]

(5)将新获取的侧面人脸图像输入训练好的侧脸正面化模型中,输出和目标图像

尽量接近的正面人脸图像。

[0040]

如图1所示,根据本发明的基于特征映射的多角度侧脸正面化方法示意框图。

[0041]

主要包括两个网络:用于将侧脸特征映射为正脸特征的特征映射分支网络和用于特征提取、正脸生成和判别真假的gan网络。

[0042]

特征映射分支网络以侧脸图像和基准正脸图像作为输入图像,利用开源的性能较强的人脸识别网络light cnn作为特征提取器分别得到256维度的特征向量,以正脸特征作为目标,训练分支网络学习侧脸特征和正脸特征之间存在的一种内在映射关系,将侧脸特征映射为正脸特征,以过滤角度干扰和图像噪声。

[0043]

gan网络包括生成器和判别器两部分,生成器由编码器

‑

解码器组成,编码器以侧脸图像作为输入,由5个卷积层+relu激活层+卷积层+relu激活层块组成,接着通过一个全连接层得到256维度的侧脸图像的深层特征向量,之后将该侧脸特征和特征映射分支网络得到的正脸特征在通道维度上进行拼接,使得进入解码器的深层人脸特征向量在一定程度上进行补全,以缓解自遮挡问题。然后将拼接的特征作为解码器的输入,经过5次反卷积层+relu激活层+反卷积层+relu激活层块的上采样后,输出虚拟正脸图像。其中在上采样过程中利用了跳层拼接,将编码器下采样过程中对应尺度的特征图和解码器上采样过程中相同尺度的特征图在通道上进行拼接,共同作为下次上采样的输入特征图,跳层拼接可以提供上下文信息,从而提高生成图像的细节效果。

[0044]

判别器用于学习区分生成图像和真实图像的真假性,使得生成器生成的结果更接近真实图像。判别器由5层级联的卷积层+relu激活层组成,用1

×

1卷积核代替全连接层降低特征通道,最后输出4

×

4概率图。采用1

×

1卷积核可以保证在降低特征图维度的同时不改变图像的空间结构。输出4

×

4概率图,其中每一个概率值对应图像中一个局部感受野,可以将人脸五官位置进行分离判别,采用这种方法可以提高判别器对局部细节的判别能力,从而促使生成器生成高细节保留、高分辨率的正面人脸图像。

[0045]

该模型的训练由生成器和判别器交替循环训练,即先训练一次生成器,再训练一次判别器,然后依次循环,直到两者达到动态平衡。其中损失函数公式如下:

[0046]

l

syn

=λ1l

pixel

+λ2l

adv

+λ3l

ip

+λ4l

e

+λ5l

sym

+λ6l

tv

[0047]

其中,l

pixel

表示多尺度像素级损失,l

adv

表示对抗损失,l

ip

表示身份保留损失,l

e

表示眼周区域像素级保留损失,l

sym

表示对称损失,l

tv

表示总差分正则化,是权重参数。

[0048][0049]

其中i表示第i个图像尺寸,即分别在分辨率为128,64,32大小的生成图和目标图上计算像素值的l1距离。c表示图像的通道数,和分别表示为每个图像尺寸的宽和高。

[0050][0051]

其中g表示生成器,d表示判别器,e表示期望,表示生成图,表示目标图,θ

g

表示生成器的参数,θ

d

表示判别器的参数。

[0052]

[0053]

其中定义为预训练的人脸识别网络light cnn提取的最后一层全连接层的特征,由于light cnn是在大规模数据集上训练,因此,它可以捕捉到更显著的人脸特征。该损失可以在深层特征空间降低生成图和基准图的距离,使得生成图保留身份信息。i

gen

表示生成图,i

gt

表示目标图像,表示向量2范数。

[0054][0055]

其中i表示第i个图像尺寸(分辨率分别为128

×

128和64

×

64),i

gen

表示生成图像,i

gt

表示基准正脸图像,w

i

和h

i

分别表示每个眼周图像的宽和高,c表示图像的通道数,上述公式用于最小化分辨率为128和64的生成图像i

gen

和目标图像i

gt

对在眼周区域(包括眉毛和眼睛)上的像素值距离,眼周区域大小选取数据集中眼周矩形框的平均尺寸。

[0056][0057]

其中w

‑

(w

‑

1)表示生成图i

gen

中w位置的对称横坐标。

[0058][0059]

其中w和h表示生成图像的宽和高,i

gen

表示生成图像,c表示图像的通道数。

[0060]

经过实验,权重参数分别设置为100,0.1,0.01,1,0.01,0.05。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1