一种增量式图像分类方法及系统

1.本发明涉及图像分类技术领域,特别是涉及一种增量式图像分类方法及系统。

背景技术:

2.深度神经网络已经在图像分类领域取得了巨大成功。但是,如今大部分的深度网络都是以批量的模式对图像进行识别和分类,即需要将所有图像样本作为一个整体输入模型中进行训练并分类。当面对可能随时出现新样本的增量式场景时,模型参数会为了适应新的图像样本而进行调整,这就会导致训练后的模型对旧图像的识别能力下降。为了使模型能够在增量式学习场景中也能保持较高的图像分类性能,需要尽量克服或缓解增量学习过程中的灾难性遗忘问题(catastrophic forgetting)。

3.早在上世纪,就已经出现了针对灾难性遗忘的研究,但由于当时的资源和条件限制,克服灾难性遗忘的问题取得的进展有限。近年来随着深度学习技术的发展以及大数据时代的到来,持续学习也开始获得更多关注,许多基于深度学习的持续学习方法相继涌现。kirkpatrick等提出对网络权值进行弹性约束(elastic weight consolidation,ewc),他们通过费雪信息评估每个权值与历史任务的关联程度,并通过在损失函数中增加一个额外的正则项来控制关联性较大的权重的调整速度,缓解了灾难性遗忘的程度。之后的很多方法都沿用了ewc的思想,主要区别在于对权值重要性的衡量标准上,例如aljundi等人根据模型的预测输出对权值扰动的敏感性来判断权值的重要度;zenke等人提出沿着参数的学习轨迹测量参数变化量的路径积分方法,最后根据每个权值的变化量决定每个权值的重要性。贝叶斯增量学习是该类方法的另一种应用场景,它的基本框架从传统神经网络变为贝叶斯神经网络,在这样的框架下,网络权值不再是定值,而是由均值和方差定义的概率分布。vcl结合了变分推理,将旧任务的后验分布作为新任务的先验,通过最小化新任务后验与先验间的kl散度来限制模型的调整;ebrahimi等将正则化约束施加在学习率上,通过限制重要权值的学习率来达到限制权值调整的目的。

4.以上方法都在增量学习领域取得了很好的成果,但仍然存在改进空间。首先,它们大多是对单个权值的重要性进行判别,但这样做会出现同一节点的不同权值被施加不同强度的正则化的现象,这种现象会使得通过权值流向节点的信息发生改变,从而导致节点学习到的特征受到干扰。其次,当处于模型容量固定而无法进行扩展的场景下时,以上方法为了巩固从旧数据中获取的知识会不断积累模型参数的重要性,这样的方法会严重削弱模型的学习能力导致新任务因无法获得充足的学习资源而出现性能下降。

技术实现要素:

5.本发明的目的是提供一种增量式图像分类方法及系统,引入权值选择机制,对权值进行筛选后有针对性地稀释部分权值的正则强度,从而提高模型对图像分类的准确性。

6.为实现上述目的,本发明提供了如下方案:

7.一种增量式图像分类方法,包括:

8.步骤10:将获取到的训练样本集分为多组;

9.步骤20:通过多组训练样本对贝叶斯神经网络模型进行训练;

10.步骤30:通过训练好的贝叶斯神经网络模型对图像进行分类;

11.其中,贝叶斯神经网络模型的训练过程为:

12.步骤200:以神经元为单位对权值进行分组,并将组内权值的标准差限制为一个统一的变量;

13.步骤201:初始化贝叶斯神经网络模型中各组权重的均值和标准差;

14.步骤202:通过重参数方法获取用于前向传播的权值;

15.步骤203:在训练第一组训练样本时,根据初始化标准差的倒数对权值的均值进行正则化处理;

16.步骤204:根据比例因子随机选取几组正则化处理后的权值,并进行标准差正则化强度稀释;

17.步骤205:在训练第二组训练样本时,通过正则化强度稀释后的标准差的倒数对权值的均值进行再次正则化处理;

18.步骤206:根据正则化强度稀释后的标准差的大小筛选出几组再次正则化处理后的权值,并进行再次标准差正则化强度稀释;

19.在训练下一组样本时,重复步骤205-206,直至所有训练样本训练完成。

20.进一步地,在将获取到的训练样本集分为多组,之后还包括:

21.根据训练样本的均值和标准差对训练样本进行预处理。

22.进一步地,通过重参数方法获取用于前向传播的权值的公式如下:

[0023][0024]

式中:μ

l,(i,j)

和分别表示权值概率分布的均值和标准差,ε

(i,j)

为一个从标准高斯分布中采样得到的随机因子,z

l,(i,j)

表示用于前向传播的第l层第i个节点的第j个权值,z

l,(i)

=[z

l,(i,1)

,z

l,(i,2)

,

···

,z

l,(i,j)

]表示第l层第i个节点的权值组成的向量。

[0025]

进一步地,正则化处理的公式如下:

[0026][0027]

式中,l(μk)表示针对当前均值的正则项,l表示神经网络的层数,i表示一层中的神经元数目,λ为均值平衡系数,μ

l,(i)

·

=[μ

l,(i,1)

,

···

,μ

l,(i,m)

]表示第l层第i组权值

的均值向量,和分别表示μ

l,(i)

·

在先前任务学习到的均值和当前任务需要优化的均值,表示一层中所有构成的向量,而则表示第i组权值在前一任务学习到的方差。

[0028]

进一步地,正则化强度稀释的公式如下:

[0029][0030]

式中:表示针对当前标准差的正则项,l表示神经网络的层数,i表示一层中的神经元数目,γ为标准差平衡系数,η为用于调整正则化强度的动态因子,和分别表示模型在先前任务学习到的标准差参数和当前任务需要优化的标准差参数。

[0031]

本发明还提供了一种增量式图像分类系统,包括:

[0032]

分组模块,用于将获取到的训练样本集分为多组;

[0033]

训练模块,用于通过多组训练样本对贝叶斯神经网络模型进行训练;

[0034]

分类模块,用于通过训练好的贝叶斯神经网络模型对图像进行分类;

[0035]

其中,训练模块具体包括:

[0036]

分组单元,用于以神经元为单位对权值进行分组,并将组内权值的标准差限制为一个统一的变量;

[0037]

初始化单元,用初始化贝叶斯神经网络模型中各组权重的均值和标准差;

[0038]

权值获取单元,用于通过重参数方法获取用于前向传播的权值;

[0039]

第一正则化处理单元,用于在训练第一组训练样本时,根据初始化标准差的倒数对权值的均值进行正则化处理;

[0040]

第一正则化强度稀释单元,用于根据比例因子随机选取几组正则化处理后的权值,并进行标准差正则化强度稀释;

[0041]

第二正则化处理单元,用于在训练第二组训练样本时,通过正则化强度稀释后的标准差的倒数对权值的均值进行再次正则化处理;

[0042]

第二正则化强度稀释单元,用于根据正则化强度稀释后的标准差的大小筛选出几组再次正则化处理后的权值,并进行再次标准差正则化强度稀释。

[0043]

进一步地,还包括:

[0044]

预处理模块,用于根据训练样本的均值和标准差对训练样本进行预处理。

[0045]

根据本发明提供的具体实施例,本发明公开了以下技术效果:

[0046]

本发明提供了一种增量式图像分类方法及系统,该方法包括:将获取到的训练样本集分为多组;通过多组训练样本对贝叶斯神经网络模型进行训练,通过训练好的贝叶斯神经网络模型对图像进行分类;在贝叶斯神经网络模型的训练过程中,本发明为了缓解由于权值重要性累积所导致的模型分类能力下降问题,引入一个权值选择机制,对权值进行筛选后有针对性地稀释部分权值的正则强度。这种方法在容量固定的场景下,能最大限度地维持了模型对未来图像样本的分类能力,同时又能保护旧任务的分类精度,有效地缓解了基于正则化的增量式图像分类模型的分类能力无法长久保持的问题。

附图说明

[0047]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

[0048]

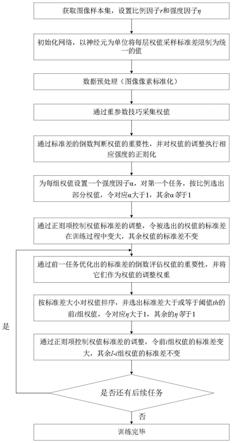

图1为本发明实施例贝叶斯神经网络模型的训练流程图;

[0049]

图2为贝叶斯神经网络结构图;

[0050]

图3为标准差矩阵范数变化趋势;

[0051]

图4为split-mnist上的分类精度(%)。

具体实施方式

[0052]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0053]

本发明的目的是提供一种增量式图像分类方法及系统,引入权值选择机制,对权值进行筛选后有针对性地稀释部分权值的正则强度,从而提高模型对图像分类的准确性。

[0054]

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

[0055]

本发明提供的一种增量式图像分类方法,包括以下步骤:

[0056]

步骤10:将获取到的训练样本集分为多组;

[0057]

步骤20:通过多组训练样本对贝叶斯神经网络模型进行训练;

[0058]

步骤30:通过训练好的贝叶斯神经网络模型对图像进行分类;

[0059]

其中,贝叶斯神经网络模型的训练过程为:

[0060]

步骤201:初始化贝叶斯神经网络模型中各组权重的均值和标准差;

[0061]

步骤202:通过重参数方法获取用于前向传播的权值;

[0062]

步骤203:在训练第一组训练样本时,根据初始化标准差的倒数对权值的均值进行正则化处理;

[0063]

步骤204:根据比例因子随机选取几组正则化处理后的权值,并进行标准差正则化强度稀释;

[0064]

步骤205:在训练第二组训练样本时,通过正则化强度稀释后的标准差的倒数对权值的均值进行再次正则化处理;

[0065]

步骤206:根据正则化强度稀释后的标准差的大小筛选出几组再次正则化处理后的权值,并进行再次标准差正则化强度稀释;

[0066]

在训练下一组样本时,重复步骤205-206,直至所有训练样本训练完成。

[0067]

在将获取到的训练样本集分为多组,之后还包括:

[0068]

根据训练样本的均值和标准差对训练样本进行预处理。

[0069]

下面对上述方法的原理进行详细介绍:

[0070]

例如,现有一批标签为0~9的手写字符样本集,传统的批量学习模式为将所有图

像样本作为一个整体输入网络进行特征提取并识别。但在增量学习场景下,现将该样本集按类别划分为5个独立的子集,每个子集包含两个不同的类别,然后分别将这5个子集按顺序逐个输入网络进行分类。这就要求神经网络在训练过程中能保留从旧样本集中提取到的特征,并在所有样本集上都具有较高的分类准确率。如图1所示,这一过程包括如下步骤:

[0071]

(1)首先,获取训练样本集,并设置比例因子r和强度因子η;

[0072]

(2)构建l层贝叶斯神经网络。贝叶斯神经网络架构,包括以下部分:以3层全连接神经网络为例,如图2所示,x'n表示经过标准化处理的图像像素,l表示网络层的数目,i表示一层中的节点数目,l∈{1,

···

,l}表示其中某一层网络,i∈{1,

···

,i}表示某一层的第i个节点,对于卷积神经网络,则表示第i个卷积核,j∈{1,

···

,j}表示节点的第j个权值。z表示所有网络权值的集合,z

l

表示第l层权值的集合,而z

l,(i)

=[z

l,(i,1)

,z

l,(i,2)

,

···

,z

l,(i,j)

]则表示第l层第i个节点的权值组成的向量,例如z

1,(1)

表示第1层第1个节点下的权值构成的向量。

[0073]

在初始化阶段将权值的采样分布设为均值为零,标准差为(卷积神经网络则为)的高斯分布。将每个神经元下的权值归为一组,记为z

l,(i)

,根据公式(1)将z

l,(i)

内的权值的标准差都限制为统一的值:

[0074][0075]

(3)数据预处理阶段,通过公式对步骤(1)中的输入图像的像素进行标准化处理,其中x表示原图像的像素,μ和σ分别表示图像像素的均值与标准差,x'表示经过标准化后的像素。在经过标准化后,将x'输入步骤(2)中的网络进行训练;

[0076]

(4)通过重参数技巧获取用于前向传播的具体权值:

[0077][0078]

式中:μ

l,(i,j)

和分别表示定义权值概率分布的均值和标准差,ε

(i,j)

为一个从标准高斯分布中采样得到的随机因子,它的存在能保持系统采样的随机性,z

l,(i,j)

表示用于前向传播的具体权值,而z

l,(i)

=[z

l,(i,1)

,z

l,(i,2)

,

···

,z

l,(i,j)

]则表示第l层第i个节点的权值组成的向量。

[0079]

(5)训练第一批样本时,取步骤(2)中每组权值的标准差的倒数,通过公式(3)对权值的调整施加相应强度的正则化:

[0080][0081]

式中:l(μk)表示针对当前均值的正则项,l表示神经网络的层数,i表示一层中的神经元数目,λ为平衡系数,它决定了公式在损失函数中的作用比重,μ

l,(i)

·

=[μ

l,(i,1)

,

···

,μ

l,(i,m)

]表示第l层第i组权值的均值向量,和分别表示μ

l,(i)

·

在先前任务学习到的均值和当前任务需要优化的均值,表示一层中所有构成的向量,而则表示第i组权值在前一任务学习到的方差。

[0082]

(6)为了在类增量场景下维持模型对图像样本的分类能力,为模型加入一个筛选机制。由于在训练第一批样本时,每层权值的初始标准差一致,所以根据一个固定比例r随机选择几组权值,并令它们对应的强度因子η大于1,而其余权值对应的η等于1。然后通过对公式(4)进行梯度求导,令η大于1的权值的标准差升高,从而使它们的正则强度得到稀释;而η等于1的权值则维持原来的正则强度;

[0083][0084]

式中:表示针对当前标准差的正则项,l表示神经网络的层数,i表示一层中的神经元数目,γ为平衡系数,它决定了该公式在损失函数中的作用比重,η为用于调整正则化强度的动态因子,和分别表示模型在先前任务学习到的标准差参数和当前任务需要优化的标准差参数。

[0085]

(7)在训练第二批图像样本时,记录下在步骤(6)中优化得到的标准差,并把它们的倒数作为均值的更新权重,通过公式(3)为权值的更新施加相应强度的限制;

[0086]

(8)同样地,也为模型引入一个筛选机制。但与步骤(5)不同的是,这一次首先将权值按标准差大小排序,接着根据一个步骤(5)中的比例r选出标准差最大的i组权值,令对应的η大于1,其余标准差较小的权值对应的η等于1。

[0087]

(9)在优化时,η大于1的权值通过公式(4)稀释它们的正则强度,η等于1的权值则通过公式(3)继续维持它们的重要性。

[0088]

(10)后续的样本在分类时重复步骤(7)-(9),直至将5个样本子集全部训练完毕。

[0089]

本发明以贝叶斯神经网络为基本框架;以节点为单位对权值进行分组并按组将权值的标准差限制为相同的值;将统一后的标准差作为重要性判别依据,用于识别在先前的训练中获取了旧图像样本重要特征的权值,并在当前优化过程中对每组权值执行相应强度的正则。为了缓解由于权值重要性累积所导致的模型分类能力下降问题,引入一个权值选

择机制,对权值进行筛选后有针对性地稀释部分权值的正则强度。这种方法在容量固定的场景下,能最大限度地维持了模型对未来图像样本的分类能力,同时又能保护旧任务的分类精度,有效地缓解了基于正则化的增量式图像分类模型的分类能力无法长久保持的问题。

[0090]

图3将一层中所有节点的权值的标准差以2范数的形式展示。因为范数一定程度上可以反映矩阵内元素的大小,所以如图3(a)所示,当不加入筛选式点正则机制时,权值的标准差呈单调减小趋势,这是因为模型的训练过程也是一个降低不确定性(概率分布的方差)令权值的取值趋于稳定的过程,但如图3.(b)所示,当加入筛选式点正则机制后,标准差的取值分布不再呈严格的单调趋势,这是因为有部分标准差的取值会因为筛选机制的作用而提高,这表明它们有能力更好地适应新任务。

[0091]

如附4所示,在第2节所述的类增量场景下,将本实施例(图中用ours表示)与目前最常用的几种基于正则化的增量图像分类方法进行比较。实验使用含两个隐藏层的全连接神经网络,为了更准确地评估实施例的性能,对网络每层的节点数目进行了不同设置,以评估实施例在不同规模网络下的分类性能。由图4可知,本实施例的分类性能在几种增量图像分类方法中均位列第一。而且随着网络规模的减小,本实施例的分类性能与其他方法呈现扩大的趋势,例如,如图4(a)所示,当每层节点数目为256个时,实施例对手写字符的分类精度达到99.5%,而ucb为98.11%,两者相差1.93%,如图4(b)所示,但当节点数目减少到150个时,实施例的分类精度为99.08%,ucb为96.95%,差距拉大到2.13%。

[0092]

本发明还提供了一种增量式图像分类系统,包括:

[0093]

分组模块,用于将获取到的训练样本集分为多组。

[0094]

训练模块,用于通过多组训练样本对贝叶斯神经网络模型进行训练。

[0095]

分类模块,用于通过训练好的贝叶斯神经网络模型对图像进行分类。

[0096]

还包括:预处理模块,用于根据训练样本的均值和标准差对训练样本进行预处理。

[0097]

其中,训练模块具体包括:

[0098]

分组单元,用于以神经元为单位对权值进行分组,并将组内权值的标准差限制为一个统一的变量;

[0099]

初始化单元,用初始化贝叶斯神经网络模型中各组权重的均值和标准差;

[0100]

权值获取单元,用于通过重参数方法获取用于前向传播的权值;

[0101]

第一正则化处理单元,用于在训练第一组训练样本时,根据初始化标准差的倒数对权值的均值进行正则化处理;

[0102]

第一正则化强度稀释单元,用于根据比例因子随机选取几组正则化处理后的权值,并进行标准差正则化强度稀释;

[0103]

第二正则化处理单元,用于在训练第二组训练样本时,通过正则化强度稀释后的标准差的倒数对权值的均值进行再次正则化处理;

[0104]

第二正则化强度稀释单元,用于根据正则化强度稀释后的标准差的大小筛选出几组再次正则化处理后的权值,并进行再次标准差正则化强度稀释。

[0105]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说

明即可。

[0106]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1