融合词屏蔽数据增强与对抗学习的特定目标情感分析方法

1.本发明涉及自然语言处理领域,尤其涉及一种融合词屏蔽数据增强与对抗学习的特定目标情感分析方法。

背景技术:

2.随着社交媒体(microblog、twitter、facebook等)的快速发展,情感分析变成了一项极其重要的任务。特定目标情感分析(aspect

‑

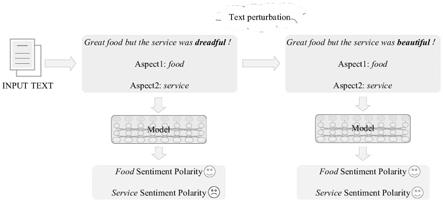

based sentiment analysis,absa)是文本分类领域的基础任务,目的是利用深度学习及自然语言处理(natural language processing,nlp)技术分析在线社交网络文本数据细粒度情感倾向,方便用户对在线社交网络评论数据特定实体(aspect)隐藏的情感极性(sentiment polarity)和态度(attitude)有明确的认识。一个句子中包含一个或多个实体,每个实体的情感极性各不相同,例如,给出一条评论“great food but the service was dreadful!”,实体“food”的情感极性为“positive”,而实体“service”的情感极性为“negative”。相比句子级别情感分析,absa能够为用户展示更加精确细粒度实体的情感关键信息。

3.情感分析任务采用机器学习、深度学习取得了显著成功。例如,kiritchenko等采用机器学习方法构建了人工特征提取模型,将提取的特征通过支持向量机(support vector machine,svm)训练情感分类模型,但是人工提取特征繁琐、效率低。为了解决人工提取特征的繁琐性,采用深度学习方法自动提取更复杂的深层次特征。例如,li等采用自适应递归神经网络,对句子中不同的目标变换依存树,得到多个不同的特征组合函数从而利用神经网络训练模型。由于句子具有序列性,许多模型采用长短期记忆网络(long short

‑

term memory,lstm)来提取句子长期依赖关系信息,tang等采用两个lstm对特定目标实体上下文特征向量拼接得到情感分类模型,但是可能会丢失长距离词的情感信息。为了能够获取文本长距离特征信息,bahdanau等首次将注意力机制运用到自然语言处理中,随后许多研究者将注意力机制引入到情感分析任务中。wang等利用lstm和注意力加权获得句子表示向量,tang等将注意力机制中加入特征词与目标实体相对距离信息,并利用多注意力得到最后的实体表示。chen等构造ram(recurrent attention on memory)结构捕获上下文语义信息以及将注意力集中,通过多注意力机制融合了长难句中的重要特征。

4.由于循环神经网络(recurrent neural network,rnn)并行度不高,vaswani等设计了transformer结构,完全抛弃了rnn结构思想提高了并行度,采用自注意力和多头注意力机制,并且加入了位置嵌入信息帮助模型理解语言的顺序,更能够捕获长距离依赖关系特征信息。devlin等用transformer结构中的encoder部分,设计了双向编码器表示(bidirectional encoder representations from transformers,bert),该结构在文本分类任务上展现了优越的结果,同时在absa任务上较其他模型有显著提升。

5.然而,深度学习模型容易受到对抗样本(adversarial examples)的攻击,从图1可看出模型在absa任务上受到对抗样本攻击后的识别效果。最近研究表明对抗样本训练可以构造健壮的神经网络模型提高模型的鲁棒性。对抗学习过程是从输入样本中,通过梯度产

生较小扰动的对抗样本,将对抗样本输入模型中继续学习。在自然语言处理领域中,传统的文本对抗样本是通过对单词或者句子进行扰动,例如,eger等选择每个字符的近邻字符进行形近字替换,jin等采用基于贪心词方法替换原始词。有对抗攻击就会有对抗防御,例如,goodfellow等提出快速梯度法(fast gradient method,fgm)对抗训练在文本分类任务上优于其他基线方法。

6.上述研究中还未将数据增强与对抗训练运用到absa任务中,并且都是从模型入手提升效果。针对目前公开absa数据集较少,很难使模型有足够的泛化能力和模型鲁棒性以及模型效率。

技术实现要素:

7.本发明旨在至少解决现有技术中存在的技术问题,特别创新地提出了一种融合词屏蔽数据增强与对抗学习的特定目标情感分析方法。

8.为了实现本发明的上述目的,本发明提供了一种融合词屏蔽数据增强与对抗学习的特定目标情感分析方法,包括以下步骤:

9.s1,运用屏蔽目标实体的方式对句子进行同义词替换和随机插入单词生成有效的样本并与原始样本进行融合,从而实现词屏蔽数据增强;

10.s2,构建了基于bert

‑

base的对抗学习特定目标情感分类模型,将s1融合后的数据作为模型的输入,运用干净样本和对抗样本一起训练情感分类模型;

11.s3,最终得到特定目标情感分析结果,使模型具有对抗防御的功能。

12.进一步地,还包括步骤:

13.s4,分别将原始样本和数据增强后的样本进行对抗学习,通过评价指标进行评价;所述评价指标包括:accuracy和/或f1值。

14.进一步地,在步骤s1中同义词替换的计算方法为:

[0015][0016]

其中,s

sr

表示同义词替换后的数据;

[0017]

f

sr

(

·

)表示同义词替换数据增强函数;

[0018]

s

in

表示原始语料库的输入;

[0019]

是一条原始样本的第i个单词;

[0020]

aspect表示特定目标实体;

[0021]

rep(

·

)表示单词替换函数;

[0022]

表示需要替换的第id个单词;

[0023]

id

sr

表示单词替换的位置;

[0024]

表示根据第i个单词在wordnet库中随机寻找num1个同义词;

[0025]

!=表示不等于。

[0026]

进一步地,在步骤s1中随机插入单词的计算方法为:

[0027][0028]

其中,s

ri

表示随机插入后的数据;

[0029]

f

ri

(

·

)表示随机插入数据增强函数;

[0030]

insert(

·

)表示在第id个的单词后面插入单词;

[0031]

表示需要插入的第id个单词;

[0032]

id

ri

表示在句子中要插入单词的前一个位置;

[0033]

ran(wordnet,num)表示在wordnet库中随机寻找num2个单词。

[0034]

进一步地,所述s2包括:

[0035]

将数据增强后的da

out

作为干净样本,da

out

=s

sr

∪s

ri

;对于干净样本的每个batch,首先使用干净样本产生词嵌入层的对抗扰动r

adv

,从而生成对抗样本;adv

‑

bert模型进行对抗样本的每个batch训练,使用bert进行干净样本的每个batch训练。

[0036]

进一步地,所述干净样本的每个batch训练的损失函数计算如下:

[0037][0038]

其中l

clean

(

·

)表示干净样本的损失函数,n

batch

表示一个batch的大小,θ表示神经网络参数,p(y

i

|e

i

,aspect

i

;θ)表示一个batch中第i个样本的情感预测概率函数;

[0039]

对抗样本每个batch的损失函数计算如下:

[0040][0041]

其中l

adv

(

·

)表示对抗样本的损失函数,n

batch

表示一个batch的大小,θ表示神经网络参数,p(y

i

|e

adv(i)

,aspect

i

;θ)表示第i个对抗样本情感预测函数。

[0042]

进一步地,还包括:

[0043]

最小化干净样本和对抗样本的每个batch的损失函数:

[0044][0045]

其中l(

·

)表示模型损失函数,表示当损失函数取得最小时,模型参数θ的取值,l

clean

(θ)表示干净样本每个batch损失函数,l

adv

(θ)表示对抗样本每个batch的损失函数。

[0046]

进一步地,所述bert模型的隐藏层采用采用高斯误差线性单元作为激活函数:

[0047][0048]

其中gelu(

·

)表示高斯误差线性单元,θ表示神经网络参数,tanh为双曲正切函数。

[0049]

进一步地,所述对抗学习包括:

[0050]

将对抗学习应用在absa任务中,在模型的嵌入层增加对抗扰动,在一个句子中目标实体aspect的情感为y的概率为p(y|s

bertin

,aspect),因此模型的嵌入层增加对抗扰动后的损失函数如下:

[0051]

‑

logp(y|e

w

+r

adv

,aspect;θ)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0052]

其中

[0053][0054]

p(y|e

w

+r

adv

,aspect;θ)表示添加对抗扰动r

adv

的情感预测概率,r

adv

表示对抗扰动,r表示对输入的一个对抗扰动,α表示扰动缩放因子,||

·

||表示范数,argmin表示使目标函数最小时的r变量,然后让这个r值赋值给radv,表示添加扰动r后的预测概率。

[0055]

进一步地,所述对抗学习还包括:

[0056]

使用快梯度下降法寻找对抗扰动,在神经网络中可以用反向传播计算对抗扰动,然后将对抗扰动与原始嵌入层的词向量相加得到对抗样本,对抗扰动r

adv

计算如下:

[0057][0058]

其中

[0059][0060][0061]

因此absa的对抗样本损失函数如下:

[0062][0063]

其中对抗样本e

adv

表示如下:

[0064][0065]

其中α表示对抗扰动缩放因子,g

w

表示模型中词嵌入层的梯度,||

·

||2表示二范数;

▽

表示梯度算子,e

w

表示干净样本的词嵌入张量,表示干净样本情感预测概率,aspect表示特定目标实体,表示神经网络分类器当前参数的常量集;λ

i

(.)表示求矩阵的特征值,表示g

w

的共轭转置;n表示样本总数,p(y

i

|e

adv(i)

,aspect

i

;θ)表示第i个对抗样本预测概率,y

i

表示第i个样本的真实标签,e

adv(i)

表示第i个对抗样本的嵌入层张量,aspect

i

表示第i个特定目标实体,θ表示神经网络参数;

[0066]

r

adv

表示对抗扰动,e

seg

表示干净样本的词嵌入张量,e

pos

表示干净样本的位置嵌入张量,表示张量相加,表示一个样本第1个词的词嵌入,一个样本对应第1个词嵌入的对抗扰动,表示一个样本第2个词的词嵌入,一个样本对应第2个词嵌入的对抗扰动,表示一个样本第i+1个词的词嵌入,一个样本对应第i+1个词嵌入的对抗扰动,表示一个样本第n个词的词嵌入,一个样本对应第n个词嵌入的对抗扰动,表示一个样本第n+1个词的词嵌入,一个样本对应第n+1个词嵌入的对抗扰动。

[0067]

综上所述,由于采用了上述技术方案,本发明的优势有:

[0068]

(1)选取bert

‑

base作为基准模型,在laptop、restaurant两个数据集上进行实验,提出了一种基于现有的特定目标情感分析语料库进行文本词屏蔽数据增强方法(保持语义

及句法结构不变的同义词替换、随机插入情感词汇等),构建了一个有效的特定目标情感分析新语料库;

[0069]

(2)提出了一种数据增强对抗训练方法,将生成的新语料库(原始语料库和数据增强语料库进行融合)输入模型中,然后对模型的词嵌入层进行细微的对抗扰动,得到具有较强鲁棒性的特定目标情感分析模型;

[0070]

(3)利用提出的融合词屏蔽数据增强与对抗学习的特定目标情感分类模型分别验证了数据增强样本能够有效提高模型的性能,只利用原始数据进行对抗训练能够提高模型的性能,最后融合两个数据特征进行对抗学习能够取得更优的结果。

[0071]

本发明的附加方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本发明的实践了解到。

附图说明

[0072]

本发明的上述和/或附加的方面和优点从结合下面附图对实施例的描述中将变得明显和容易理解,其中:

[0073]

图1是现有技术的深度学习模型对抗攻击情感识别的示意图。

[0074]

图2是本发明wmde

‑

al模型网络结构示意图。

[0075]

图3是本发明不同大小α下的对抗训练accuracy的示意图。

[0076]

图4是本发明不同大小α的对抗训练评价指标增长幅度的示意图。

具体实施方式

[0077]

下面详细描述本发明的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,仅用于解释本发明,而不能理解为对本发明的限制。

[0078]

1.相关工作

[0079]

absa也称细粒度情感分析,一直以来是国内外的研究热点。该任务主要工作为确定每个句子中特定目标实体的情感分类,尽管目前研究采用深度学习方法已经取得表现较好的结果,但是存在训练数据少导致泛化能力弱,模型的准确性和鲁棒性不能兼得等问题。

[0080]

传统的深度学习方法是采用复杂的神经网络结构提取特征,针对文本分类问题,采用递归神经网络(recursive neural network,rnn),循环神经网络(rnn),长短期记忆网络(lstm)等能够获取上下文特性信息,但是这些传统的神经网络都未考虑特定目标实体。为了将特定目标实体加入到特征编码中,tang等提出td

‑

lstm将目标实体的上文和下文分别用两个lstm进行编码,以便将目标实体考虑到特征编码中。wang等提出利用注意力机制获取lstm编码后的目标实体重要信息。chen等提出ram利用多注意力机制捕获长难句中的目标实体特征信息,解决了上下文注意力分散的问题。但是这些模型没有考虑句法约束和远距离单词依赖问题,导致错误判断目标实体情感。zhang等提出as

‑

gcn在句子依存树上建立图卷积神经网络来获取句法信息和单词依存。karimi等提出bert对抗训练体系结构,使用对抗训练微调bert模型,提升神经网络泛化能力。

[0081]

对抗学习是指利用对抗样本训练神经网络从而达到对抗防御。goodfellow等借助图像分类对抗训练方法,提出fgm对lstm模型的嵌入层对抗扰动,得到对抗样本进行对抗训

练,但是对抗扰动梯度没有受到约束。sato等提出iadvt

‑

text对抗学习方法在词嵌入层上生成对抗样本,根据词嵌入层的距离来约束梯度的改变方向,最后通过对抗学习提升模型的泛化能力。li等提出一种细粒度虚拟对抗训练方法,引入字符水平级对抗扰动改进对抗训练的初始化,并且通过字符水平级标准化强制约束扰动大小,解决了扰动约束问题。为了克服生成的对抗样本语义不一致和语言不流畅,li等提出bert

‑

attack对抗样本生成器,首先查找输入序列容易受到攻击的单词,再通过bert生成易攻击单词的替代词,利用bert能捕获上下文语义的优点,生成流畅且合理的对抗样本。以上研究可以提升模型鲁棒性,但是缺少利用对抗训练来提升模型准确性的研究。xie等提出advprop对抗训练方法,在图像分类任务中使用对抗样本和干净样本共同训练来解决特征分配不均匀的问题,验证了图像对抗样本可以提升分类准确性。

[0082]

文本数据增强思想来源于图像领域,但是与图像数据增强做法不同,数据增强应用于当数据集较小时防止网络过拟合。nlp任务中常用的数据增强方式有回译、同义词替换、句子缩写等,最近研究表明文本数据增强可以提升nlp任务的性能。例如,zhu等提出根据可答问题、原文和答案来自动生成相关的不可答问题,进而作为一种数据增强的方法来提升阅读理解系统的表现。除了在阅读理解中进行数据增强外,文本分类中也需要数据增强。wei等提出同义词替换、随机插入、随机交换、随机删除四种数据增强技术,这四种方法只对原文进行修改,并未对数据标签进行更改。如果修改后的语义发生了改变,那么就是无效数据。

[0083]

2.提出的方法

[0084]

本发明专利公式以及模型中使用的符号定义如表1所示。本发明专利所提出的融合词屏蔽数据增强与对抗学习模型(word

‑

masking data enhancement and adversarial learning,wmde

‑

al)框架图如图2所示。wmde

‑

al借鉴了简单的文本数据增强方法和文本对抗训练训练,通过改进简单的数据增强方法从而增强特定目标语料库。

[0085]

表1模型中所有符号的定义

[0086]

[0087][0088]

图2中包括词屏蔽数据增强(word

‑

masking data enhancement,wmde)和对抗学习(adversarial learning,al)两个模块。(1)wmde模块将原始语料库样本s

in

通过屏蔽aspect进行同义词替换(约束条件:保持语句流畅,语义不改变)、随机插入(约束条件:保持句子结构不变)的方法进行数据增强,然后将生成的数据和原始数据合并在一起得到bert的输入s

bertin

;(2)al模块结合bert模型和adv

‑

bert模型同时学习了干净样本和对抗样本的特征,弥补样本特征分布不均匀的问题。

[0089]

3.1absa对抗学习

[0090]

对抗学习在分类问题中是一种提高模型鲁棒性的方法,目标是在原始数据中加入对抗扰动,以最小化最大误差分类优化参数θ。将对抗学习应用在absa任务中,在模型的嵌入层增加对抗扰动,假设在一个句子中目标实体aspect的情感为y的概率为p(y|s

bertin

,aspect),因此模型的嵌入层增加对抗扰动后的损失函数如下:

[0091]

‑

logp(y|e

w

+r

adv

,aspect;θ)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0092]

其中

[0093]

[0094]

其中p(y|e

w

+r

adv

,aspect;θ)表示添加对抗扰动r

adv

的情感预测概率,e

w

表示干净样本的词嵌入张量,r

adv

表示对抗扰动,aspect表示特定目标实体,θ表示神经网络参数,r表示对输入的一个对抗扰动,α表示扰动缩放因子,||

·

||表示范数,argmin表示使目标函数最小时的r变量,然后让这个r值赋值给radv,表示添加扰动r后的预测概率;公式(2)的主要含义是随机对样本添加一个扰动,使损失函数的相反数最小,也就是在最大化损失函数的情况寻找最后的扰动变量radv。

[0095]

为了解决上面最小化问题,试图寻找最坏的样本干扰最小化损失函数,使用快梯度下降法寻找对抗扰动,在神经网络中可以用反向传播计算对抗扰动,然后将对抗扰动与原始嵌入层的词向量相加得到对抗样本,通过神经网络中的反向传播来计算对抗扰动r

adv

,计算过程如下:

[0096][0097]

其中

[0098][0099][0100]

因此absa的对抗样本损失函数如下:

[0101][0102]

其中对抗样本e

adv

表示如下:

[0103][0104]

其中α表示对抗扰动缩放因子,g

w

表示模型中词嵌入层的梯度,||

·

||2表示二范数;

▽

表示梯度算子,e

w

表示干净样本的词嵌入张量,表示干净样本情感预测概率,aspect表示特定目标实体,表示神经网络分类器当前参数的常量集;λ

i

(.)表示求矩阵的特征值,表示g

w

的共轭转置;n表示样本总数,p(y

i

|e

adv(i)

,aspect

i

;θ)表示第i个对抗样本预测概率,y

i

表示第i个样本的真实标签,e

adv(i)

表示第i个对抗样本的嵌入层张量,aspect

i

表示第i个特定目标实体,θ表示神经网络参数;

[0105]

r

adv

表示对抗扰动,e

seg

表示干净样本的词嵌入张量,e

pos

表示干净样本的位置嵌入张量,表示张量相加,表示一个样本第1个词的词嵌入,一个样本对应第1个词嵌入的对抗扰动,表示一个样本第2个词的词嵌入,一个样本对应第2个词嵌入的对抗扰动,表示一个样本第i+1个词的词嵌入,一个样本对应第i+1个词嵌入的对抗扰动,表示一个样本第n个词的词嵌入,一个样本对应第n个词嵌入的对抗扰动,表示一个样本第n+1个词的词嵌入,一个样本对应第n+1个词嵌入的对抗扰动。

[0106]

通过上述的对抗训练方法,可以得到对抗样本的损失函数,和对抗样本特征分布即将对抗样本通过模型提取的特征,探究干净样本和对抗样本联合特征分布是否能提升模

型鲁棒性和准确性,并探究如何提取有效特征是本发明专利的主要工作。接下来将介绍如何借助adv

‑

bert解决特征分布不均匀的问题。

[0107]

3.2提出的wmde

‑

al模型

[0108]

对于小数据集,数据增强是一种最简单的提升特征多样化策略,因此使用同义词替换和随机插入进行数据增强,为了保持句子中目标实体不发生改变,采取wmde方法进行数据增强,增强后的样本统计如表2所示。

[0109]

f

sr

(

·

)计算公式如下:

[0110][0111]

其中s

sr

表示同义词替换后的数据,f

sr

(

·

)表示同义词替换数据增强函数,s

in

表示原始语料库的输入,是一条原始样本的第i个单词,aspect表示特定目标实体,rep(

·

)单词替换函数,表示需要替换的第id个单词,id

sr

表示单词替换的位置,表示根据第i个单词在wordnet库中随机寻找num1个同义词;!=表示不等于。

[0112]

f

ri

(

·

)计算公式如下:

[0113][0114]

其中s

ri

表示随机插入后的数据,f

ri

(

·

)表示随机插入数据增强函数,insert(

·

)表示在第id个的单词后面插入单词,表示需要插入的第id个单词,id

ri

表示在句子中要插入单词的前一个位置,ran(wordnet,num)表示在wordnet中随机寻找num2个单词。

[0115]

表2数据增强后的样本统计

[0116][0117]

将数据增强后的da

out

作为干净样本,da

out

=s

sr

∪s

ri

;对于干净样本的每个batch,首先使用干净样本产生词嵌入层的对抗扰动r

adv

,从而生成对抗样本,再利用adv

‑

bert进行对抗样本训练。使用bert进行干净样本的每个batch训练,adv

‑

bert进行对抗样本的每个batch训练。其中干净样本每个batch损失函数计算如下:

[0118][0119]

其中l

clean

(

·

)表示干净样本的损失函数,n

batch

表示一个batch的大小,p(y

i

|e

i

,aspect

i

;θ)表示一个batch中第i个样本的情感预测概率函数,y

i

表示第i个样本的真实标签,e

i

表示第i个干净样本的嵌入层张量,aspect

i

表示第i个干净样本特定目标实体,θ表示神经网络参数,

[0120]

对抗样本每个batch的损失函数计算如下:

[0121][0122]

其中l

adv

(

·

)表示对抗样本的损失函数,n

batch

表示一个batch的大小,θ表示神经网络参数,p(y

i

|e

adv(i)

,aspect

i

;θ)表示第i个对抗样本情感预测函数,y

i

表示第i个样本的真实标签,e

adv(i)

表示第i个对抗样本的嵌入层张量,aspect

i

表示第i个干净样本特定目标实体,θ表示神经网络参数;

[0123]

最后最小化两个样本每个batch的损失函数:

[0124][0125]

其中l(

·

)表示模型损失函数,表示当损失函数取得最小时,模型参数θ的取值,l

clean

(θ)表示干净样本每个batch损失函数,l

adv

(θ)表示对抗样本每个batch的损失函数;

[0126]

本发明专利实验选取bert

‑

base的特定目标情感分类作为基线,将分别进行单独使用数据增强方式、单独使用对抗学习方式、数据增强的对抗学习方式实验,与bert

‑

base基准模型进行比较,由于bert模型的嵌入层有三个向量,分别为词嵌入(word embeddings)、段嵌入(segment embeddings)、位置嵌入(position embeddings)。实验中只针对词嵌入进行对抗攻击,从而生成词嵌入对抗样本,其余两个嵌入不发生改变。wmde

‑

al算法1所示:

[0127][0128][0129]

算法1中包括wmde和al两个函数,wmde中描述了文本词屏蔽数据增强算法过程,al

中描述了absa对抗学习过程。

[0130]

4.实验结果分析

[0131]

4.1实验准备

[0132]

(1)数据集:本发明专利实验使用semeval2014中laptop和restaurant两个数据集,特定目标实体有积极、中性、消极、冲突四种情感极性,由于冲突极性所占比例较小,借鉴了其他研究者们去除冲突极性语料的方法进行预处理,各数据集三种情感极性数量统计如表2所示。数据集使用pytorch

‑

transformers工具中的berttokenizer进行分词,使用nltk工具中的wordnet同义词库进行数据增强。

[0133]

(2)对抗攻击:本发明专利使用fgm作为对抗攻击方法,选取不同大小的α进行fgm攻击,使用fgm对bert模型的词嵌入层进行对抗扰动生成对抗样本,再通过adv

‑

bert进行对抗样本训练。

[0134]

(3)基准模型:本发明专利使用bert

‑

base(l=12,h=768,a=12,total parameters=110m)作为absa基准模型,其中l表示网络隐藏层个数(numbers of hidden layers),h表示网络隐藏层大小(hidden size),a表示自注意力头个数(numbers of self

‑

attention heads)。bert模型隐藏层的激活函数采用高斯误差线性单元(gaussian error linear units,gelu),计算公式如下:

[0135][0136]

其中gelu(

·

)表示高斯误差线性单元,θ表示神经网络参数,tanh表示双曲正切函数;

[0137]

(4)实验环境以及超参数设置:本发明专利实验使用gpu(geforce rtx 3090),24g显存,pytorch 1.8.1框架实现。超参数设置如表3所示。

[0138]

表3实验超参数统计表

[0139]

参数value批次(batch)大小16学习率2e

‑

5对抗扰动缩放因子αα∈[0.01,0.09]l2正则化0.01dropout率0.1初始化器xavier_uniform_优化器adam训练次数5最大序列长度128

[0140]

4.2结果分析

[0141]

为了验证提出的wmde方法有效性,实验分别对laptop和restaurant数据集进行数据增强,将每个句子进行屏蔽特定目标词的同义词替换、随机插入单词生成两条增强数据,然后合并原始数据输入bert

‑

base模型中进行特定目标情感分类,表5中给出了wmde方法与其他模型性能比较,以及与bert

‑

base基准模型的性能比较。当基准模型为bert

‑

base时,laptop数据集wmde增强后情感分类准确率为79.00%,相比原始数据训练准确率76.65%提

升了2.35%。同样的,restaurant数据集wmde增强后情感分类准确率为84.38%,相比原始数据训练准确率84.02%提升了0.36%。实验结果表明,针对laptop和restaurant方面级情感分类数据集进行wmde数据增强生成新的训练数据能够有效提升模型,laptop小数据集提升效果较好。

[0142]

通过上述实验结果对比,在wmde方法中,通过词屏蔽方法进行同义词替换,保持aspect不变并且替换词性相同,保证生成语句流畅,语义不发生改变。随机插入单词时,采用插入副词的方式,保证生成语句与原语句的含义和句法结构不改变,在最后样本融合时将新样本与原始样本进行相似度计算。因此wmde方法的作用是在不改变原始数据含义和句法结构的前提下,通过原始数据生成更精确的增强样本,使模型能够学习更多的有效特征。在实验过程中,分别验证了同义词替换和随机插入算法对模型特征学习的有效性,最后结合两种增强方式,结果表明结合两种增强方式效果最优。

[0143]

将数据增强样本和原始样本进行融合作为模型的输入样本,分别在laptop和restaurant数据集上使用扰动系数范围从0.01到0.09,增加步长为0.01。利用本发明专利提出的wmde

‑

al模型设置不同大小的扰动系数α与bert

‑

base模型对比实验的accuracy如图3所示,其中图3中(a)子图表示laptop数据集不同大小α下的对抗训练accuracy的示意图,图3中(b)子图表示restaurant数据集不同大小α下的对抗训练accuracy的示意图,;图3中每个子图包括bert

‑

base、bert

‑

wmde、bert

‑

al、bert

‑

wmde

‑

al四种方法的性能。基于bert

‑

base使用不同大小的α对抗训练评价指标增长幅度如图4所示,其中雷达图的刻度表示对抗扰动α的大小,图4中(a)子图表示laptop数据集accuracy和f1值的增长情况,根据该子图可以得出wmde

‑

al方法增长幅度高于al方法;图4中(b)子图表示restaurant数据集accuracy和f1值的增长情况,根据该子图可以得出wmde

‑

al方法增长幅度略低于al方法。对于laptop数据集而言,使用bert

‑

al训练方式,当α=0.02时,准确率达到最大值79.94%,比使用bert

‑

base训练方式提升3.29%;使用bert

‑

wmde

‑

al训练方式,当α=0.01时,准确率达到最大值80.88%,比使用bert

‑

base、bert

‑

wmde训练方式分别提升4.23%、1.88%,加入词屏蔽数据增强对抗训练的准确率较未加入词屏蔽数据增强对抗训练准确率提升0.94%。对于restaurant数据集而言,使用bert

‑

al训练方式,当α=0.08时,准确率达到最大值85.71%,比使用bert

‑

base训练方式提升1.69%;使用bert

‑

wmde

‑

al训练方式,当α=0.02时,准确率达到最大值85.27%,比使用bert

‑

base、bert

‑

wmde训练方式分别提升1.25%、0.89%,加入词屏蔽数据增强对抗训练的准确率较未加入词屏蔽数据增强对抗训练准确率降低0.44%。通过对抗训练实验结果表明,同样对于小数据集而言,wmde

‑

al性能较好,并且与基准模型相比有明显的提升。但是对于稍大数据集则是直接使用al方法的性能略优于wmde

‑

al方法的性能。由以上结果分析可以得出,al方法和wmde

‑

al方法都能有效提升样本特征多样性,利用对抗样本提升文本表示的质量,从而提升特定目标情感分类的性能。

[0144]

表4数据增强bert

‑

base对抗训练的accuracy值

[0145][0146]

4.3模型对比

[0147]

模型性能对比包括:(1)本发明专利提出的wmde、al、wmde

‑

al三种方法与bert

‑

base的性能进行比较,同时通过将这三种方法进行比较;(2)与当前在laptop和restaurant数据集上表现较好的模型进行比较。评价指标为accuracy和f1值,基准模型性能如表5所示,可以得出:

[0148]

(1)td

‑

lstm(tang et al.2016)采用深度学习模型提取特征,在laptop和restaurant数据集上准确率分别为71.83%和78.00%。深度学习特定目标情感分类模型解决了机器学习解决了繁琐的人工特征提取问题,并且深度学习模型的性能大多数优于最好的机器学习性能。

[0149]

(2)memnet(tang et al.2016)采用线性组合对多注意力进行结合,提取目标实体特征信息,从而达到提升特定目标情感分类性能,其准确率分别为72.20%和81.00%。

[0150]

(3)ram(chen et al.2017)采用gru网络结构组合多注意力权重,以非线性方式组合不同注意力情感特征向量,其准确率分别为74.49%和80.23%。

[0151]

(4)mgan(fan et el.2018)采用细粒度和粗粒度的注意力捕获目标实体和句子之间的词级交互关系,然后进行特定目标情感分类,其准确率分别为75.39%和81.25%。

[0152]

(5)repwalk(zheng et al.2020)采用基于语法树的随机复制游走,捕获句子信息的上下文特征,有效地利用句法结构来改善句子表示,其准确率分别为78.20%和83.80%。

[0153]

(6)bert

‑

pt(xu et al.2019)采用大规模特定目标领域语料库重新训练上下文信息bert模型,提高最终任务单词表示的质量,其准确率分别为78.07%和84.95%。

[0154]

表5 laptop和restaurant数据集上特定目标情感分类模型总体性能比较

[0155]

[0156][0157]

表5中,#表示本发明专利的实验结果,*表示其参考文献的中的实验结果

“‑”

表示未记录,其余数据表示来自原始文献。

[0158]

为了评估本发明专利提出的方法在特定目标情感分析任务上的性能,采用bert

‑

base作为对抗训练的目标模型,分别做了下述三个对比实验:(1)首先验证了wmde生成新语料的有效性,通过五次wmde实验,选取最优结果作为实验结果,在laptop和restaurant数据集上的准确率分别为79.00%和84.38%;(2)验证原始数据集进行al的有效性,利用干净样本和对抗样本进行对抗训练,其准确率分别为79.94%和85.71%,比bert

‑

pt模型准确率分别高1.87%和0.76%;(3)验证通过al生成新的训练样本以及融合原始样本进行对抗训练,即本发明专利提出的wmde

‑

al方法,其准确率分别为80.88%和85.27%,比bert

‑

pt模型准确率分别高2.81%和0.32%。

[0159]

5结论

[0160]

词屏蔽数据增强和对抗学习的特定目标情感分析模型,旨在提高干净样本特征分布多样性以及利用对抗训练提升bert

‑

base情感分类性能。在laptop和restaurant数据集上实验结果表明,bert

‑

base添加wmde、al、wmde

‑

al后比基于bert

‑

base特定目标情感分析有显著的提高,其中al、wmde

‑

al方法优于当前处于先进水平的bert

‑

pt模型。主要结论如下:(1)通过同义词替换和随机插入单词对特定目标领域语料库进行词屏蔽数据增强,保持句子语义和语法结构不改变并屏蔽实体单词不被替换,有效地对该领域数据集进行数据增强;(2)分别对原数据和数据增强后的数据进行对抗学习,利用干净样本和对抗样本提升特定目标情感分类辨识度,达到对抗防御的目的。

[0161]

尽管已经示出和描述了本发明的实施例,本领域的普通技术人员可以理解:在不脱离本发明的原理和宗旨的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由权利要求及其等同物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1