基于重构和预测的异常检测方法

1.本发明涉及视频与图像处理技术领域,具体涉及基于重构和预测的异常检测方法。

背景技术:

2.视频异常检测是计算机视觉中的一项重要研究任务,它有许多方面的应用,如交通事故检测、暴力检测和异常人群行为检测。由于异常的不确定性和多样性,尽管已经研究了数年,从正常事件中准确识别异常事件仍然是一项具有挑战性的任务。同时,在现实世界中,很难列举所有的异常事件来学习各种异常模式。因此,很多研究都是基于一类分类方法来检测异常,而不是基于监督思想的二元分类。基于一类分类的异常检测是从正常数据中学习正常模式的分布,并计算测试样本服从该分布的概率来反映异常。

3.针对现有异常检测方法对噪声和时间间隔敏感的问题,公开号为cn111680614a的中国专利公开了《一种基于视频监控中的异常行为检测方法》,其将视频帧图像中的目标对象提取特征后,先对特征进行聚类,再输入到svm分类器中,取得分最高的作为该目标对象的异常得分,最后取该视频帧图像中所有目标对象的异常得分中的最高值作为该帧图像的异常得分,利用svm分类器可以快速准确的分类,并且满足实时性要求。

4.上述现有方案中的异常(行为)检测方法利用目标检测技术将每一个视频帧中的前景目标检测出来,并输入到卷积自编码器网络框架中进行重构,通过重构误差进行分类来判断异常。然而,现有异常检测方法中,帧中的所有像素被同等地处理,模型会失去焦点,而不会优先学习和重构训练时难以重构的复杂区域,使得模型无法有效获得高质量前景的重构图像(因为简单的背景像素将控制模型的优化),进而会降低异常检测的性能,因为在异常检测中前景比静止背景更重要。同时,现有的重构方法试图最小化重构框架与其真实标签之间的差异,虽然在像素空间甚至潜在空间中保证了相似性,但它是一对一的约束,忽略了同一场景中不同正常帧的相似性,导致异常检测的准确性不高。因此,如何设计一种能够兼顾异常检测性能和准确性的异常检测方法是亟需解决的技术问题。

技术实现要素:

5.针对上述现有技术的不足,本发明所要解决的技术问题是:如何提供一种能够兼顾异常检测性能和准确性的异常检测方法,从而能够提升异常检测的效果和效率。

6.为了解决上述技术问题,本发明采用了如下的技术方案:

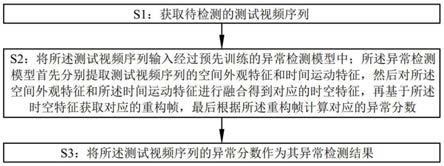

7.基于重构和预测的异常检测方法,包括以下步骤:

8.s1:获取待检测的测试视频序列;

9.s2:将所述测试视频序列输入经过预先训练的异常检测模型中;所述异常检测模型首先分别提取测试视频序列的空间外观特征和时间运动特征,然后对所述空间外观特征和所述时间运动特征进行融合得到对应的时空特征,再基于所述时空特征获取对应的重构帧,最后根据所述重构帧计算对应的异常分数;

10.s3:将所述测试视频序列的异常分数作为其异常检测结果。

11.优选的,所述异常检测模型包括用于提取空间外观特征的重构编码器,用于提取时间运动特征的预测编码器,与所述重构编码器和所述预测编码器的输出连接且用于融合得到时空特征的融合模块,以及与所述融合模块的输出连接且用于获取重构帧的译码器。

12.优选的,步骤s2中,将所述测试视频序列的当前帧输入到所述重构编码器,以提取对应的空间外观特征;将所述测试视频序列当前帧之前的若干帧输入到所述预测编码器,以提取对应的时间运动特征。

13.优选的,训练所述异常检测模型时,基于所述异常检测模型上一轮的重构误差对当前轮次输入的视频序列进行反向擦除,以去除视频序列中重构误差小于预设阈值的像素,得到对应的擦除帧。

14.优选的,i

t

表示视频序列中的第t帧,i

t

‑

δ

代表i

t

之前的第δ帧;

15.所述反向擦除是指:在除第一轮之外的每轮训练迭代之后,首先计算原始帧i

t

和重构帧之间的像素级误差;然后根据所述像素级误差的值是否大于预设阈值,来将其掩码中对应的像素值设置为1或0以获得相应的掩码;最后在当前轮次训练之前,从i

t

‑

δ

到i

t

的原始帧与掩码逐像素相乘,以得到所述异常检测模型当前轮次的擦除帧,表示为i

t

′

‑

δ

到i

t

′

。

16.优选的,训练所述异常检测模型时,在所述译码器的输出连接一个深度svdd模块;所述深度svdd模块用于寻找体积最小的超球体来包含正常事件的重构帧的全部或大部分高级特征,并利用重构帧高层特征的紧凑约束使得重构的正常帧相似,以增加正常帧与异常帧的重构距离。

17.优选的,所述深度svdd模块包括与所述译码器的输出连接的映射编码器,以及与所述映射编码器的输出连接的超球体;映射编码器首先将重构帧映射到低维潜在表示中,然后将低维表示拟合到具有最小体积的超球体中,以迫使所述异常检测模型学习提取正常事件的公共因子;

18.所述深度svdd模块的目标函数定义为:

19.式中:c和r分别表示超球体的中心和半径,n表示帧数,表示由具有参数w的网络输出的重构帧的低维表示,argmax{

·

}表示取最大值的函数。

20.优选的,通过训练损失函数优化所述异常检测模型;

21.重构帧被约束在像素空间和所述深度svdd模块的潜在空间中;

22.在像素空间中,基于强度损失和加权rgb损失优化所述异常检测模型;在潜在空间中,基于特征紧致损失优化所述异常检测模型。

23.优选的,所述训练损失函数通过如下公式表示:

24.l=λ

int

l

int

+λ

rgb

l

rgb

+λ

compact

l

compact

;式中:l

int

表示强度损失,l

rgb

表示加权rgb损失,l

compcat

表示特征紧致损失,λ

int

、λ

rgb

、λ

compact

分别对应于每个损失的超参数,它们决定了它们对总训练损失的贡献;

25.强度损失l

int

通过如下公式计算:

26.式中:t表示视频序列的第t帧,||

·

||2表示l2范数;

27.加权rgb损失l

rgb

通过如下公式计算:

28.式中:||

·

||1表示l1范数,n表示前一帧的数量,帧i

t

‑

i

的权重为(n

‑

i+1)/n;

29.特征紧致损失通过如下公式计算:

30.式中:c和r分别表示超球体的中心和半径,n表示帧数,表示由具有参数w的网络输出的重构帧的低维表示。

31.优选的,所述异常检测模型通过如下步骤计算对应异常分数:

32.s201:测试视频序列中每个图像块的部分得分定义为:

33.式中:p表示i帧中的一个图像块,i、j表示图像块中像素的空间位置,|p|表示图像块中的像素数,图像块是通过滑动步长为4的窗口来确定的;

34.s202:计算测试视频序列中帧的异常分数:

35.score=argmax{s(p1),s(p2),...,s(p

m

)};式中:p的大小被设定为16

×

16,m表示图像块的数量;

36.s203:获得测试视频序列中每一帧的分数后,将所有帧的分数归一化到[0,1]的范围,以获得如下的帧级异常分数:

[0037]

式中:min

score

和max

score

分别测试视频序列中的最小和最大分数;

[0038]

s204:采用高斯滤波器对时间维度上的帧级异常分数进行平滑处理,以得到测试视频序列对应的异常分数。

[0039]

本发明中的异常检测方法与现有技术相比,具有如下有益效果:

[0040]

在本发明中,通过重构方法和预测方法分别提取了视频序列的空间特征和时间特征,并融合得到对应的时空特征来计算重构帧,这使得模型不会失去焦点,能够优先学习和重构训练时难以重构的复杂区域,能够有效获得高质量前景的重构图像,进而提升了异常检测模型的异常检测性能;同时,提取空间特征和时间特征的方式,考虑了同一场景中不同正常帧的相似性,即能够提升异常检测模型的异常检测准确性。因此,本发明中的异常检测方法兼顾异常检测的性能和准确性,从而能够提升异常检测的效果和效率。

[0041]

在本发明中,通过反向擦除的方式从原始帧中擦除一些像素以创建模型的输入数据(即擦除帧),这能够保留训练的上一轮中重构误差较大的像素,去除重构误差较小的像素,进而迫使模型聚焦于上一轮中没有重构好的像素,使得简单的背景和复杂的前景都将被高质量地重构,被擦除的帧保留了大部分前景像素,丢弃了大部分背景像素,有助于让模型自动对前景形成关注机制,从而能够兼顾异常检测性能和准确性。

[0042]

在本发明中,通过深度svdd模块直接作用于重构帧,能够寻找一个体积最小的超球来包含正常事件的重构帧的全部或大部分高级特征,通过潜在空间中相似的低维特征来

保证正常帧重构图像之间的相似性,能够有效增加正常帧与异常帧的重构距离,从而进一步提升异常检测的准确性。

附图说明

[0043]

为了使发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明作进一步的详细描述,其中:

[0044]

图1为异常检测方法的逻辑框图;

[0045]

图2为异常检测模型测试时的网络结构图;

[0046]

图3为异常检测模型训练时的网络结构图;

[0047]

图4为三个数据集的部分示例图(异常事件由边界框标记);

[0048]

图5为编码器和译码器的网络结构图;

[0049]

图6为三个数据集的帧重构定性结果示意图(较浅颜色代表较大的误差);

[0050]

图7为异常评分的比较示意图;

[0051]

图8为正常帧和异常帧的平均分数的比较示意图;

[0052]

图9为不同训练时期下反向擦除的可视化结果示意图;

[0053]

图10为ped2上有反向擦除和没有反向擦除的模型训练损失比较示意图;

[0054]

图11为在avenue和ped2上有反向擦除和没有反向擦除的模型可视化结果示意图;

[0055]

图12为avenue和ped2中重构帧的低维表示的t

‑

sne可视化示意图。

具体实施方式

[0056]

下面通过具体实施方式进一步详细的说明:

[0057]

实施例:

[0058]

本实施例中公开了一种基于重构和预测的异常检测方法。

[0059]

如图1所示,基于重构和预测的异常检测方法,包括以下步骤:

[0060]

s1:获取待检测的测试视频序列;

[0061]

s2:将测试视频序列输入经过预先训练的异常检测模型中;异常检测模型首先分别提取测试视频序列的空间外观特征和时间运动特征,然后对空间外观特征和时间运动特征进行融合得到对应的时空特征,再基于时空特征获取对应的重构帧,最后根据重构帧计算对应的异常分数;

[0062]

s3:将测试视频序列的异常分数作为其异常检测结果。

[0063]

具体实施过程中,结合图2所示,异常检测模型(双编码器单译码器网络,dual

‑

encoder single

‑

decoder network,desdnet)包括用于提取空间外观特征的重构编码器,用于提取时间运动特征的预测编码器,与重构编码器和预测编码器的输出连接且用于融合得到时空特征的融合模块,以及与融合模块的输出连接且用于获取重构帧的译码器。具体的,异常检测模型的融合模块包括二维卷积层和tanh激活层;二维卷积层的卷积核为大小为1

×

1,通道为512。将所述测试视频序列的当前帧输入到所述重构编码器,以提取对应的空间外观特征;将所述测试视频序列当前帧之前的若干帧输入到所述预测编码器,以提取对应的时间运动特征。在测试阶段,从i

t

‑

δ

到i

t

的原始帧被输入到重构编码器和预测编码器,以分别提取视频序列的空间和时间特征。将外观特征a

t

和运动特征m

t

级联后输入融合模

块,得到对应的时空特征;与串联特征的融合方法相比,本发明的方法节省了计算量,提高了模型的表达能力。此外,时空特征被输入到译码器中,通过执行反卷积来获得重构帧

[0064]

在本发明中,通过重构方法和预测方法分别提取了视频序列的空间特征和时间特征,并融合得到对应的时空特征来计算重构帧,这使得模型不会失去焦点,能够优先学习和重构训练时难以重构的复杂区域,能够有效获得高质量前景的重构图像,进而提升了异常检测模型的异常检测性能;同时,提取空间特征和时间特征的方式,考虑了同一场景中不同正常帧的相似性,即能够提升异常检测模型的异常检测准确性。因此,本发明中的异常检测方法兼顾异常检测的性能和准确性,从而能够提升异常检测的效果和效率。

[0065]

具体实施过程中,结合图3所示,训练异常检测模型时,基于异常检测模型上一轮的重构误差对当前轮次输入的视频序列进行反向擦除,以去除视频序列中重构误差小于预设阈值的像素,得到对应的擦除帧。

[0066]

具体的,i

t

表示视频序列中的第t帧,i

t

‑

δ

代表i

t

之前的第δ帧;

[0067]

反向擦除是指:在除第一轮之外的每轮训练迭代之后,首先计算原始帧i

t

和重构帧之间的像素级误差;然后根据像素级误差的值是否大于预设阈值,来将其掩码中对应的像素值设置为1或0以获得相应的掩码;最后在当前轮次训练之前,从i

t

‑

δ

到i

t

的原始帧与掩码逐像素相乘,以得到异常检测模型当前轮次的擦除帧,表示为i

′

t

‑

δ

到i

′

t

。在训练阶段,给定从i

′

t

‑

δ

到i

′

t

的擦除帧,i

′

t

被输入到重构编码器以提取空间域中的外观特征,表示为a

t

,从i

′

t

‑

δ

到i

′

t

‑1的帧被输入到预测编码器以提取时间域中的运动特征,表示为m

t

;与使用光流捕捉运动模式相比,本发明的方法避免了光流计算带来的不准确性和高计算成本。

[0068]

在本发明中,通过反向擦除的方式从原始帧中擦除一些像素以创建模型的输入数据(即擦除帧),这能够保留训练的上一轮中重构误差较大的像素,去除重构误差较小的像素,进而迫使模型聚焦于上一轮中没有重构好的像素,使得简单的背景和复杂的前景都将被高质量地重构,被擦除的帧保留了大部分前景像素,丢弃了大部分背景像素,有助于让模型自动对前景形成关注机制,从而能够兼顾异常检测性能和准确性。同时,输入的不确定性变化也使得异常检测模型对噪声具有更强的鲁棒性,使得模型不会失去焦点,能够优先学习和重构训练时难以重构的复杂区域,能够有效获得高质量前景的重构图像,进而提升了异常检测模型的异常检测性能。

[0069]

具体实施过程中,结合图3所示,训练异常检测模型时,在译码器的输出连接一个深度svdd模块;深度svdd模块用于寻找体积最小的超球体来包含正常事件的重构帧的全部或大部分高级特征,并利用重构帧高层特征的紧凑约束使得重构的正常帧相似,以增加正常帧与异常帧的重构距离。

[0070]

具体的,深度svdd模块包括与译码器的输出连接的映射编码器,以及与映射编码器的输出连接的超球体;映射编码器首先将重构帧映射到低维潜在表示中,然后将低维表示拟合到具有最小体积的超球体中,以迫使异常检测模型学习提取正常事件的公共因子;

[0071]

深度svdd模块的目标函数定义为:

[0072]

式中:c和r分别表示超球体的中心和半径,n表示帧数,表示由具有参数w的网络输出的重构帧的低维表示,argmax{

·

}表示取

最大值的函数。在目标函数中,第一项用于最小化超球体的体积,第二项是位于超球外部的样本的惩罚项;超参数v∈(0,1]用于衡量超球体的体积和边界损失;大v意味着允许一些样本落在超球之外,如果v很小,落在超球之外会有很大的惩罚;通过块坐标下降和交替最小化方法优化网络参数w和半径r;即固定r,网络迭代k次优化参数w;在k次之后,再使用最新的w来优化r。

[0073]

在本发明中,通过深度svdd模块直接作用于重构帧,能够寻找一个体积最小的超球来包含正常事件的重构帧的全部或大部分高级特征,通过潜在空间中相似的低维特征来保证正常帧重构图像之间的相似性,能够有效增加正常帧与异常帧的重构距离,从而进一步提升异常检测的准确性。

[0074]

具体实施过程中,通过训练损失函数优化异常检测模型;

[0075]

重构帧被约束在像素空间和深度svdd模块的潜在空间中;

[0076]

在像素空间中,基于强度损失和加权rgb损失优化异常检测模型;在潜在空间中,基于特征紧致损失优化异常检测模型。

[0077]

具体的,训练损失函数通过如下公式表示:

[0078]

l=λ

int

l

int

+λ

rgb

l

rgb

+λ

compact

l

compact

;式中:l

int

表示强度损失,l

rgb

表示加权rgb损失,l

compcat

表示特征紧致损失,λ

int

、λ

rgb

、λ

compact

分别对应于每个损失的超参数,它们决定了它们对总训练损失的贡献;

[0079]

强度损失l

int

通过如下公式计算:

[0080]

式中:t表示视频序列的第t帧,||

·

||2表示l2范数;

[0081]

加权rgb损失l

rgb

通过如下公式计算:

[0082]

式中:||

·

||1表示l1范数,n表示前一帧的数量,帧i

t

‑

i

的权重为(n

‑

i+1)/n;

[0083]

特征紧致损失通过如下公式计算:

[0084]

式中:c和r分别表示超球体的中心和半径,n表示帧数,表示由具有参数w的网络输出的重构帧的低维表示。

[0085]

为了将所有正常帧的重构约束在可达范围内,将第一轮训练模型提取的重构帧的特征向量的均值作为中心c。在后续训练中,计算重构帧的特征表示与中心c之间的欧氏距离,并根据该距离得到特征紧致损失。

[0086]

在本发明中,通过最小化特征紧致损失,使得模型可以自动将正常帧的重构映射到超球中心附近,以获得正常事件的紧致描述。因此,包含正常事件的重构帧的特征靠近超球中心,而异常事件的特征远离中心甚至落在超球之外,这意味着像素空间中所有正常帧的重构图像将更加相似,而异常帧的重构图像将与正常帧的重构图像更加不同,从而能够增加异常的可区分性,进而能够提升异常检测模型的异常检测性能和准确性。

[0087]

具体实施过程中,异常检测模型通过如下步骤计算对应异常分数:

[0088]

s201:测试视频序列中每个图像块的部分得分定义为:

[0089]

式中:p表示i帧中的一个图像块,i、j表示图像块中像素的空间位置,|p|表示图像块中的像素数,图像块是通过滑动步长为4的窗口来确定的;

[0090]

s202:计算测试视频序列中帧的异常分数:

[0091]

score=argmax{s(p1),s(p2),...,s(p

m

)};式中:p的大小被设定为16

×

16,m表示图像块的数量;

[0092]

s203:获得测试视频序列中每一帧的分数后,将所有帧的分数归一化到[0,1]的范围,以获得如下的帧级异常分数:

[0093]

式中:min

score

和max

score

分别测试视频序列中的最小和最大分数;

[0094]

s204:采用高斯滤波器对时间维度上的帧级异常分数进行平滑处理,以得到测试视频序列对应的异常分数。

[0095]

在本发明中,能够通过上述步骤有效计算测试视频序列的异常分数,进而能够基于异常分数检测出测试视频序列中的异常行为或异常事件,从而能够辅助提升异常检测的效果。

[0096]

为了更好的说明本发明中异常检测方法的优势,本实施例还公开了如下实验:

[0097]

本实验在三个公开可用的数据集上进行,如图4所示,分别是cuhk avenue数据集、ucsd pedestrain数据集和某大学校园异常检测数据集。

[0098]

根据图5中的网络结构参数,本发明中的模型在pytorch上实现。

[0099]

为了训练模型,引入了初始学习率为0.0002的adam算法,并利用余弦退火方法来衰减学习率。批次大小设置为4,在cuhk avenue、ucsd ped2和某大学校园异常检测数据集上的训练轮数分别为60、60和10。对于所有数据集,帧的大小调整为256

×

256像素,像素强度标准化为[

‑

1,1]的范围。输入帧的总长度被设置为5,即δ=4。

[0100]

在训练损失函数中,超参数λ

int

、λ

rgb

、λ

compact

分别设置为1、0.2、0.01。深度svdd模块的v设置为0.1,以确保模型对各种正常模式的容差。为了减少计算所需内存,本实施例没有为训练集中的每一帧计算特殊的掩码;相反,对这些掩码执行“或”操作,以生成通用的掩码用于在下一轮训练中擦除。整个实验在运行linux ubuntu16.04操作系统的计算机上进行,采用的是intel(r)core(tm)i7

‑

7800xcpu@3.50ghz,显卡是8gb内存的geforce gtx 1080。

[0101]

cuhkavenue数据集;包含37个视频,其中16个15328帧的视频用于训练模型,其余21个15324帧的视频用于评估模型的异常检测性能;每帧的分辨率为640

×

360在这个数据集中,可以观察到47个异常事件,包括游荡、投掷物体和奔跑。

[0102]

ucsd pedestrain数据集;包含ped1(ucsd pedestrain1)数据集和ped2(ucsd pedestrain2)数据集;在ped2上进行实验,但没有在ped1上进行实验,因为ped1中158

×

238的帧分辨率相当低;在ped2中,有16个训练视频和12个测试视频,每个视频不超过200帧;视频帧的分辨率为360

×

240;ped2数据集中有12个不规则事件,主要表现为外观异常的物体,比如人行道上的自行车和卡车。

[0103]

某大学校园异常检测数据集;是一个极具挑战性的视频异常检测数据集,由13个

场景和超过27万个训练帧组成;它包含330个训练视频和107个测试视频;每帧分辨率为856

×

480;某大学校园异常检测数据集中有130个异常事件,包括自行车、滑板等的出现。

[0104]

本实施例通过auc(area under the curve,曲线下方面积)来评价异常检测的性能。

[0105]

一、关于本发明的异常检测模型

[0106]

将本发明的异常检测模型与典型的传统方法和基于深度学习的最新方法进行了比较,包括:deepoc、stacked rnn、刘等人提出的模型、鲁等人提出的模型、mesdnet、memae、stae、st

‑

caae和kim等。各个模型的auc性能如表1所示。

[0107]

表1auc性能比较结果

[0108][0109]

从表1可以看出,本发明的模型在三个不同的数据集上获得了良好的auc性能,与最先进的方法相比显示出很大的竞争力。在cuhk avenue和ucsd ped2数据集上,本发明的模型auc性能分别达到89.9%和97.5%,优于其他方法的检测性能。某大学校园异常检测数据集是视频异常检测中的一个新数据集,因此只有少数研究提供了该数据集的测试结果。

[0110]

在某大学校园异常检测数据集上,虽然本发明的模型没有达到最好的auc性能,但auc仅比最高值低1.1%。此外,为了直观地观察检测性能,图6提供了三个数据集上用于帧重构的模型的定性结果,结合图6所示,正常区域可以很好地重构,而异常区域则不能。

[0111]

二、关于本发明的重构和预测模型

[0112]

为了评估本发明中重构和预测融合的效果,将重构编码器和预测编码器与译码器相结合,得到三种不同的模型:1)由重构编码器和译码器组成的重构模型,以帧i

t

为输入;2)由预测编码器和译码器组成的预测模型,以i

t

‑

δ

到i

t

‑1的帧为输入;3)由重构编码器、预测编码器和译码器组成,以i

t

‑

δ

到i

t

的帧为输入。为了与所提出的模型保持一致,在预测模型的编码器和译码器之间使用跳跃连接。对于每个模型的训练,采用像素强度损失、加权rgb损失和特征紧凑损失来监督训练。通过这些模型,可以获得重构模型和预测模型在独立检测异常方面的性能。

[0113]

图7显示了avenue和ped2数据集的视频序列在上述三个模型上的异常分数。结果表明,本发明的模型对异常帧总是产生较大的重构误差,对正常帧总是产生较小的误差;正常和异常分数的平均值以及它们之间的差距如图8所示。总的来说,本发明模型在每个数据

集上的得分差距最大,表明本发明模型具有更好的检测性能。此外,表2所列的auc也证明了无论是重构模型还是预测模型都无法达到本发明模型结合所达到的auc性能。

[0114]

表2不同模型的auc比较

[0115][0116]

三、关于本发明的重构误差反向擦除

[0117]

图9给出了不同训练时期下用于擦除的掩码,以及擦除前后的帧图像。从图9中可以发现,每轮中被擦除的像素主要是背景像素,这有助于模型更加关注复杂的前景;并且随着训练轮数的增加,擦除帧中保留了更多的背景像素,表明前景和背景之间的重构误差差距在减小。这反映了反向擦除可以有效地指导模型降低前景像素的重构误差。这也可以在图9提供的重构误差图中得到验证。

[0118]

为了更好地展示本发明反向擦除的优势,本实施例对反向擦除进行了消融实验:在ped2上有反向擦除和没有反向擦除的模型的训练损失如图10所示;虽然图10显示具有反向擦除的模型并没有显著降低训练损失,但与图9相比,可以发现训练损失的下降主要由前景像素主导,而不是背景像素;相反地,没有反向擦除的模型失去引导,对所有区域一视同仁,导致简单背景主导的模型收敛。最后,我们在表3中列出了有反向擦除和没有反向擦除的模型的auc性能,并在图11中给出了可视化比较。结果表明,本发明的反向擦除模型具有更好的检测性能。

[0119]

表3无反向擦除和有反向擦除的模型的auc比较

[0120][0121]

四、关于本发明的深度svdd模块

[0122]

基于t分布式随机领域嵌入(t

‑

distributed stochastic neighbor embedding,t

‑

sne)方法,图12提供了avenue和ped2数据集上重构帧的低维表示的t

‑

sne可视化。可以观察到,在三维空间中,尤其是在ped2数据集中,大部分正常数据都是以接近球体的形式聚集的,异常数据分散在球体之外。这一结果归因于基于深度svdd的特征紧致损失,该方法旨在寻找一个包含正常数据但不包含异常数据的最小体积超球。

[0123]

为了验证译码器后应用深度svdd的优势,本实验探索了三种方法:1)去掉了译码器后的映射编码器,对特征没有约束,是简单的双编码单解码结构,表示为desd;2)深度svdd在编码器和译码器之间的瓶颈处执行,即输入帧的时空表示被映射成一个紧凑的超球,表示为de

‑

svdd

‑

sd;3)在译码器后面执行深度svdd,表示为desd

‑

svdd。

[0124]

不同方法的auc性能总结在表4中。在表中,特征auc是根据帧的低维特征与超球中心的距离来计算的。首先,距离定义如下:

[0125]

式中:w

*

表示预训练网络的参数;大的距离意味着帧的低

维特征偏离正常模式更严重。

[0126]

异常得分表示为

[0127]

从表4中,可以观察到,无论基于帧的auc还是基于特征的auc,desd

‑

svdd在两个数据集上都获得了最高的auc。de

‑

svdd

‑

sd的帧auc低于desd

‑

svdd,证实了即使高层特征受限,由于cnn强大的表示能力,译码器重构的异常帧也可能无法接近正常帧。

[0128]

表4潜在特征空间在不同约束下的auc比较

[0129][0130]

五、关于本发明的加权rgb损失

[0131]

通过与中计算两个相邻帧之间的rgb差异的运动损失进行比较,研究了加权rgb损失的影响。表5表明,加权rgb损失能够在ped2和avenue数据集上给出更高的auc。

[0132]

表5不同运动约束下的auc性能

[0133][0134]

此外,在实验中,发现将加权rgb损失λ

rgb

的参数固定为0.2可以在不同的数据集上获得良好的检测性能。以ped2数据集为例进行了λ

rgb

的参数分析,实验结果总结在表6中。

[0135]

表6 ped2数据集上不同权重的加权rgb损失的auc比较

[0136][0137]

六、结论

[0138]

本实验研究了传统的基于深度学习的视频异常检测中,网络优化没有重点,忽略了不同正常帧之间的相似性的问题。本发明中通过异常检测模块的双编码器单译码器网络来重构视频中的每一帧,并提出了一种训练策略,包括基于重构误差的反向擦除和深度svdd,来规范网络的训练。在训练中,根据上一轮训练的重构误差,剔除原始帧中误差较小的像素,然后将该帧输入到模型中,使模型专注于学习误差较大的像素,提高重构质量;此外,应用深度svdd将正常帧的重构映射到体积最小的超球体中,使得异常帧的重构更容易识别。在三个数据集上的实验结果表明,与现有方法相比,本发明的方法具有竞争优势。

[0139]

需要说明的是,以上实施例仅用以说明本发明的技术方案而非限制,尽管通过参照本发明的优选实施例已经对本发明进行了描述,但本领域的普通技术人员应当理解,可以在形式上和细节上对其作出各种各样的改变,而不偏离所附权利要求书所限定的本发明

的精神和范围。同时,实施例中公知的具体结构及特性等常识在此未作过多描述。最后,本发明要求的保护范围应当以其权利要求的内容为准,说明书中的具体实施方式等记载可以用于解释权利要求的内容。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1