一种遮挡感知的三维人体姿态与形状重建方法

1.本发明涉及计算机视觉领域,具体涉及一种从单张图片中进行三维人体姿态和形状重建方法。

背景技术:

2.随着计算机计算能力的增强,深度学习取得了巨大的成功,也极大的推动了计算机的理解能力。计算机在智能创造、智慧医疗、自动驾驶和游戏建模等都需要用到人体姿态估计的支持。目前在人体2d姿态检测方面已经取得了巨大的成功,能够在不同载体中较为精准的确定人体关节点,如图片、视频等。但是在3d姿态与形状重建中,由于图片中缺乏深度信息,使得3d姿态的预测缺乏一定的准确性。此外,在真实世界中,各种复杂场景的存在(如人体遮挡,物体遮挡等)都会使得现有的模型估计有所缺陷。

3.为了更好的利用计算机理解人类行为以便做成决策,一方面需要模型能够处理各种复杂的场景,都能够达到较好的估计结果。另一方面仅仅有姿态的存在仍然是不足的,迫切需要一种更加直观的、包含更多信息的表达方式。为此,研究者们提出了各种方法,有基于优化的方法、基于回归的方法以及两者结合的方法,都采用了大量的数据作为训练基准,取得了不错的结果。

4.数据的多样性以及复杂性是训练模型的关键。目前技术的限制,大多数3d 人体姿态与形状估计的数据集是在实验室中采集得到。实验室场景单一,人体动作也会有所限制。部分数据集在室外采集,一定程度上弥补了场景单一的问题,但是现实场景中会有各种遮挡存在,人与人之间的遮挡,人与物体的遮挡以及人体自身的遮挡存在。另外在各类数据集中的被测对象体型单一,并且每个数据集中可能仅仅包含几个个体,使得缺乏人体的多样性,这样训练出来的模型可能对人体缺乏敏感性,从而很难对人体的形态做出很好地重建。更加真实和多样性的数据集能够极大提高模型的精确度,也使得模型有更强的泛化能力以及抗扰动能力。

5.综上所述,如果有效的找到贴合复杂场景的数据,是本领域研究人员急需解决的技术问题。然而目前的数据集并不能满足技术需要,因此提供更加真实的数据用于满足复杂场景的需要是现在亟待解决的问题。

技术实现要素:

6.本发明实现了一种面向人体遮挡场景的三维人体姿态和形状重建方法,可以从人体遮挡场景中重建出人体模型,便于计算机理解与分析,并且不受图片场景的影响,重建出较为准确的人体模型。

7.为解决上述技术问题,本发明提供如下一种遮挡感知的三维人体姿态与形状重建方法,包括以下步骤:

8.步骤一,生成人体互相遮挡的人体轮廓图;

9.步骤二,使用步骤一生成的人体轮廓图对人体关节点进行编码作为输入数据;

10.步骤三,使用resnet编码器和回归器组成的回归网络得到人体模型参数;

11.步骤四,使用预估计的人体参数渲染生成预估计人体轮廓和人体关节点;

12.步骤五,对预估计的人体轮廓和人体关节点与真实标签进行比较,进行反向传递,并计算其loss函数;

13.步骤六,设定准确率,重复步骤二至五,直到达到预设的准确率。

14.作为优选,所述的步骤一,包括以下子步骤:

15.子步骤一,人体模型参数获取并进行前处理:

16.a、从人体模型数据库中随机选两组参数(θ1,β1),(θ2,β2),其中姿态参数

17.体形参数

18.b、θ参数中前三位参数控制人体模型的全局朝向,统一替换θ1和θ2的前三位,使得能够得到更加复杂的2d姿态;

19.c、利用生成两项和参数替换真实β1和β2,已到达更加多样的人体体型;

20.子步骤二,利用渲染方式得到对应的人体轮廓图:

21.a、随机获取一组相机参数t1,为了确保模型有交错,使用方程t2=t1+ n(μ,σ2)获取第二组相机参数,其n为标准正态分布;

22.b、利用neural 3d mesh renderer渲染模型得到两组轮廓;

23.a、子步骤三,对两组轮廓图进行后处理:先对两轮廓图进行点乘获取相同部分,然后用轮廓1减去相同部分获取最终输入轮廓,其函数为s= s1‑

s1*s2其中*表示点乘;得到轮廓图。

24.作为优选,所述的子步骤二中neural 3d mesh renderer的主要步骤包括:

25.s1,定义了目标图片a,目标是找到能够生成这张图片的3d场景b;

26.s2,制作初始的3d场景b';

27.s3,将b'送到渲染器中,渲染得到图片a’;

28.s4,生成神经网络比较a和a'的差别,计算出loss;

29.s5,将loss反向传播到场景b'中的其余参数上,修改参数获得新的场景 b1’;

30.s6,将b1’带入步骤s3并重复步骤s3至s5,进行训练,知道loss值达到设定值。

31.作为优选,所述的步骤五中的loss函数包括:

32.a.三维网格点欧氏距离:其中和p

i

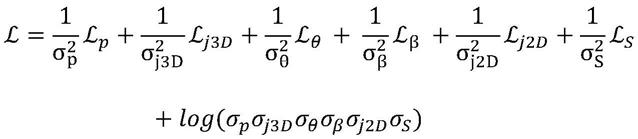

分别表示预测模型和真实模型的第i个三维网格点坐标,n为6890;

33.b.三维关节点欧氏距离:其中和j

i

分别表示预测模型和真实模型的第i个三维关节点坐标;

34.c.smpl模型参数loss函数:其中和θ分别表示预测模型和真实模型的姿态参数,和β分别表示预测模型和真实模型的形状参数;

35.d.二维关节点欧氏距离:其中ω

i

表示可见性,如果

当前二维关节点在图片内值为1,否则为0;和w

i

分别表示预测模型和真实模型的第i个二维关节点坐标;

36.e.轮廓监督loss函数:其中h,w为输入图片的高度和宽度,和s分别表示预测模型轮廓图和真实模型轮廓图;

37.总体的loss函数为:总体的loss函数为:

38.相较于现有技术,本发明具有以下有益效果:通过合成遮挡数据方法,克服了现在数据集中该特征数据短缺问题;提高了网络的鲁棒性和准确度,在人体被遮挡的情况下仍然可以得到较好的结果。引入了可微分渲染方法(neural 3d meshrenderer),增强网络对人体的感知能力后,在ssp

‑

3d数据上取得了人体体形估计的最好结果;提出了一种视角增强策略来合成无限的视角变化,在现有数据集的基础上创建全视角的训练数据;可以提高网络应对特殊视角下人体估计结果;整合了人体估计模块,用于回归人体模型参数,可以较好的屏蔽某些数据集下的偏向性,应对更加普遍场景图片;特征e用于估计人体3d姿态和体形参数。

附图说明

39.为了更清楚地说明本发明中的技术方案,下面将对本发明中的技术使用附图做出简单的说明,将会给本领域的人员更加清晰的认识本技术的性能。

40.图1为本发明中模型训练数据合成原理。

41.图2为本发明中模型训练过程结构展示。

42.图3为本发明中从图片中预测过程展示。

具体实施方式

43.本发明的核心是提供一种面向深度学习的交互可视化与可视分析方法。方便深度学习算法工程师进行深度学习算法的开发。为了更进一步对本发明做出详细说明,下面结合具体实例并参照附图。

44.参考图1,图1为本发明中一种人体互相遮挡数据的轮廓生成流程图,该流程图包括:

45.步骤1、人体模型参数获取并进行前处理:

46.d、从人体模型数据库中随机选两组参数(θ1,β1),(θ2,β2),其中姿态参数体形参数

47.e、θ参数中前三位参数控制人体模型的全局朝向,统一替换θ1和θ2的前三位,使得能够得到更加复杂的2d姿态。

48.f、利用生成两项和参数替换真实β1和β2,已到达更加多样的人体体型。

49.步骤2、利用渲染方式得到对应的人体轮廓图:

50.a、随机获取一组相机参数t1,为了确保模型有交错,使用下列方程

51.t2=t1+n(μ,σ2)

52.获取第二组相机参数,其n为标准正态分布;

53.b、利用neural 3d mesh renderer渲染模型得到两组轮廓。

54.步骤3、利用两组轮廓图进行后处理:

55.b、先对两轮廓图进行点乘获取相同部分,然后用轮廓1减去相同部分获取最终输入轮廓,其函数为

56.s=s1‑

s1*s257.其中*表示点乘。

58.参考图2,图2为本发明中一种利用生成数据的模型训练流程图,该流程图包括:

59.步骤1、利用人体轮廓生成方法生成人体轮廓,并对人体关节点进行编码作为模型的输入。

60.步骤2、利用编码器和回归器组成的回归网络得到人体模型参数。

61.步骤3、利用预估计的人体参数渲染生成预估计人体轮廓和人体关节点。

62.步骤4、对预估计的人体轮廓和人体关节点与真实标签进行比较,进行反向传递。其loss函数分别为:

63.a.三维网格点欧氏距离:

[0064][0065]

b.三维关节点欧氏距离:

[0066][0067]

c.smpl模型参数loss函数:

[0068][0069]

d.二维关节点欧氏距离:

[0070][0071]

其中ω

i

表示可见性,如果当前2d关节点在图片内值为1,否则为0。

[0072]

e.轮廓监督loss函数:

[0073][0074]

其中h,w为输入图片的高度和宽度。

[0075]

总体的loss函数为:

[0076][0077]

步骤5、重复步骤1

‑

4,直到达到预设的准确率。

[0078]

参考图3,图3为本发明中一种从单张图片中进行人体姿态与形状估计的流程图,该流程图包括:

[0079]

步骤1、利用densepose从单张图片中获取人体轮廓图。

[0080]

步骤2、利用mask

‑

rcnn检测出人体关节点。

[0081]

步骤3、利用关节点和轮廓图作为输入,通过回归网络(regressor)获取回归数据。

[0082]

步骤4、利用渲染方法可视化回归数据。

[0083]

以上所述仅为本发明的基础实施样例,以上样例只是为了帮助理解本发明的技术方案及其核心思想。应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以对本发明进行若干改进和修饰,这些改进和修饰也落入本发明权利要求的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1