基于知识蒸馏的多出口全卷积网络的目标跟踪方法

1.本发明涉及一种目标跟踪方法,尤其涉及一种知识蒸馏的多出口全卷积网络的目标跟踪方法。

背景技术:

2.卷积神经网络(cnn)凭借其在提取高层语义特征表示方面的优势,已成功应用于视觉目标跟踪任务。然而,虽然基于cnn的跟踪方法能够取得不错的定位精度,但大多数方法的处理速度偏慢。

技术实现要素:

3.为了更好地平衡基于cnn的跟踪器的速度与精度,本发明提供了一种基于知识蒸馏的多出口全卷积网络的目标跟踪方法。

4.本发明的目的是通过以下技术方案实现的:

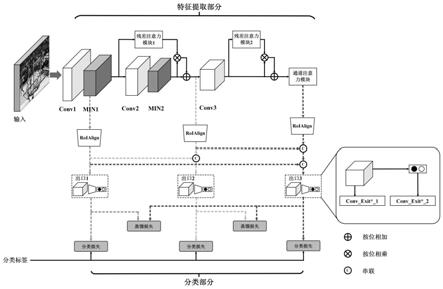

5.一种基于知识蒸馏的多出口全卷积网络的目标跟踪方法,首先选取在imagenet上预训练vgg-m模型的前三个卷积层,并将两个min模块分别嵌入到第一和第二个卷积层后,以增加特征的非线性表示并缓解relu引起的梯度消失问题。以上三个卷积层和两个min模块组成了基础网络,用于提取输入候选样本的特征表示。然后,在基础网络中引入三个注意力模块,包括两个残差注意力模块和一个通道注意力模块。最后,在基础网路中设置三个出口分别对应三种不同难度的视频帧。这三个出口拥有相同的结构,包括一个roialign层用于提取候选区域特征,以及两个卷积层(conv_exit*_1和conv_exit*_2)用于对候选区域进行分类。具体包括如下步骤:

6.步骤一、构建基于知识蒸馏的多出口全卷积网络,具体构建步骤如下:

7.(1)选取vgg-m预训练网络的前三个卷积层,将两个min模块分别嵌入到第一个卷积层和第二个卷积层来增加特征表示的非线性,同时梯度消失带来的影响,以上三个卷积层和两个min模块共同构成了基础网络;

8.min模块的整体流程如下所示:

[0009][0010][0011][0012]

其中,x

i,j

是以坐标(i,j)为中心的输入,ch是特征f的通道索引,w和b分别表示特征权重和偏置,f是通过取k个maxout隐藏层部分的最大值来构造的,maxout单元作为一个跨通道的最大池化层,它选择最大输出以输入到下一层,此外,引入归一化bn层来避免数据分布差异带来的影响;

[0013]

(2)在基础网络的基础上,增加三个注意力模块来增加特征表示的判别能力,其中

包括两个残差注意力模块和一个通道注意力模块,在第二个残差注意力模块之后增加一个通道注意力模块来增强通道对于区分目标和背景的敏感性,通道注意力模块将特征f作为其输入,并通过全局池化操作去除f的空间信息,通过两个全连接层获得通道依赖关系,利用sigmoid函数计算通道权重wc,输出fc(x)通过f(x)乘以通道权重wc得到,即:

[0014]

fc(x)=wc·

f(x);

[0015]

残差注意力模块的数学表达如下:

[0016][0017]

其中,使用sigmoid函数进行激活,fr(x)是残差注意力特征,和分别表示按位相乘和相加操作;

[0018]

(3)在整个网络中设置三个出口,每个出口拥有相同的结构,其中包含一个区域特征提取层用于提取每个roi区域对应的特征,两个卷积层conv_exit*_1和conv_exit*_2用于将候选样本区分为目标和背景;

[0019]

步骤二、基于知识蒸馏的多出口训练,具体步骤如下:

[0020]

(1)给定一个教师分类器t和从t学习的学生分类器s,该学习过程通过最小化其输出的交叉熵优化:

[0021][0022]

[s

1/temp

(x)]c=softmax(s(x)/temp),

[0023]

[t

1/temp

(x)]c=softmax(t(x)/temp),

[0024]

其中,t(x)和s(x)分别表示t和s的预测,temp是温度参数,[t

1/temp

(x)]c和[s

1/temp

(x)]c分别表示t和s的软预测,c表示类别的数量;

[0025]

(2)整个模型通过最小化分类损失l

cls

和多出口结构的蒸馏损失l

dis

进行优化:

[0026]

l=l

cls

+al

dis

,

[0027]

其中,a是一个超参数用于平衡两种损失,l

dis

定义如下:

[0028][0029]

其中,ex是出口的数量,t(e)∈ex表示教师出口的集合,cf(

·

)表示每个出口对应的分类器。

[0030]

相比于现有技术,本发明具有如下优点:

[0031]

1、本发明提出了一种基于知识蒸馏的多出口全卷积结构用于基于分类的跟踪,凭借知识蒸馏的优势,鼓励前序出口模仿学习后续出口的概率输出,从而提高前序出口的判别能力。

[0032]

2、本发明通过利用多个roialign层来提取不同尺度的区域特征,并在每个出口融合以上区域特征来提高判别能力。

[0033]

3、本发明使用不同种类的注意力模块来捕获不同的目标特定信息,提高了目标与背景及其干扰物区分能力。

[0034]

4、与主流的基于分类的跟踪方法相比,本发明在取得更高的跟踪精度的同时,还拥有相对较快的处理速度。

附图说明

[0035]

图1为本发明知识蒸馏的多出口全卷积网络的目标跟踪方法的流程图;

[0036]

图2为简单、中等以及困难帧的例子;

[0037]

图3为各出口的输出统计图;

[0038]

图4为本发明的方法和其它主流目标跟踪方法在otb-100数据集的比较;

[0039]

图5为本发明的方法和其它主流目标跟踪方法在uav123数据集的比较;

[0040]

图6为各出口在4个数据集输出的统计。

具体实施方式

[0041]

下面结合附图对本发明的技术方案作进一步的说明,但并不局限于此,凡是对本发明技术方案进行修改或者等同替换,而不脱离本发明技术方案的精神和范围,均应涵盖在本发明的保护范围中。

[0042]

本发明提供了一种基于知识蒸馏的多出口全卷积的目标跟踪方法,并命名为dmenet。在dmenet中,将不同类型的注意力机制嵌入到全卷积网络的不同层级以捕获更具判别力的特征表示。并且,在全卷积网络中增加三个额外的出口用来尽早得到当前帧中目标位置的准确估计。整个dmenet通过知识蒸馏的策略来训练以提高前序出口的准确度。每个出口都有一个置信度分数用来决策视频帧的处理需要在当前出口结束或需要传递到上层出口。

[0043]

图1所示为整个网络的总体结构,大体上可以分成三个部分,具体内容如下:

[0044]

第一部分是出口数量的确定。为了确定合适的出口数量,假设视频序列中的目标难度可分为三类:简单的(目标的外观变化相对较小)、中等的(目标的外观变化较快但并不剧烈)以及困难的(目标的外观变化相对剧烈)。这里,假设以上三类不同难度的目标可以使用低层、中层以及高层特征来分别进行定位。为了验证该假设,在otb-100数据集上进行了验证。

[0045]

在otb-100数据集中,将每个视频帧分类为:简单的、中等的以及困难的三个类别。不同类别的分类依据是12个跟踪方法的输出预测框的平均重叠率。其中,中等和困难的视频帧对应的平均重叠率阈值分别为0.7和0.5,简单难度的视频帧对应的阈值为≥0.7。如图2所示,展示了一些简单、中等以及困难帧的例子。

[0046]

为了统计每个出口的实际输出比率,在不运用知识蒸馏的情况下,对网络的三个出口进行了训练。在每个出口,设置一个可信度分数用于决定是否在此出口定位当前帧的目标(高可信度)或继续到下一个出口(低可信度)。也就是说,只有当前出口的置信度得分达到阈值时,目标的位置预测可以在此出口输出。图3展示了简单/中等/困难帧在第一/第二/第三出口输出的统计量,这证明了假设的合理性。

[0047]

第二部分是网络结构,如图1所示,首先选取在imagenet上预训练vgg-m模型的前三个卷积层,并将两个min模块分别嵌入到第一和第二个卷积层后,以增加特征的非线性表示并缓解relu引起的梯度消失问题。以上三个卷积层和两个min模块组成了基础网络,用于

提取目标的特征表示。然后,在基础网络中引入三个注意力模块,包括两个残差注意力模块和一个通道注意力模块。最后,在基础网路中设置三个出口分别对应三种难度的视频帧。这三个出口拥有相同的结构:一个roialign层用于提取候选区域特征,以及两个卷积层(conv_exit*_1和conv_exit*_2)用于对候选区域进行分类。min模块、注意力模块和出口的细节如下。

[0048]

min模块:虽然基于分类的跟踪方法拥有不错的精度,但仍存在一些问题:(1)模型的判别能力;(2)训练过程中的梯度消失和饱和度问题。在大多数基于分类的方法中,通过一个轻量级的网络来提取目标的特征表示,而这种轻量级的网络无法应对目标的非线性变化。此外,常数0将阻塞未被激活的relu的梯度,引起梯度消失。并且,在训练阶段数据分布的变化可能会使激活函数饱和,这将减慢训练过程(特别是在线更新阶段)。

[0049]

为了解决这个问题,本发明提出将两个min模块分别嵌入到第一和第二个卷积层之后。首先,采用双层多层感知器(mlp)来增加局部非线性。在每个mlp之后,都有一个maxout单元来克服使用relu时引起的消失梯度问题。其中,maxout单元的数学表达如下:

[0050][0051]

其中,x

i,j

是以(i,j)为中心的输入,ch是特征f的通道索引,w和b分别表示特征权重和偏置。f是通过取k个maxout隐藏部分的最大值来构造的。maxout单元作为一个跨通道的最大池化层,它选择最大输出以输入到下一层。此外,引入归一化bn层来避免数据分布差异带来的影响。min模块的整体流程如下所示:

[0052][0053]

注意力模块:因为本发明的最终目的是在跟踪过程尽早停止当前帧的处理,所以后面的出口应该更具判别能力,以指导前序的出口。因此,在基础网络中增加了两个残差注意力模块,以增强深层特征的判别能力。首先,最大池化层(max pooling)用于扩大感受野来捕捉全局特征。其次,使用双线性插值运算将空间分辨率扩展到原始空间分辨率。残差注意力模块的数学表达如下:

[0054][0055]

其中,使用sigmoid函数进行激活,fr(x)是残差注意力特征。和分别表示按位相乘和相加操作。

[0056]

在第二个残差注意力模块之后,增加一个通道注意力模块来增强通道对于区分目标和背景的敏感性。通道注意力模块将特征f作为其输入,并通过全局池化操作去除f的空间信息。然后,通过两个全连接层获得通道依赖关系。接着,利用sigmoid函数计算通道权重wc。输出fc(x)通过f(x)乘以通道权重wc得到,即:

[0057]

fc(x)=wc·

f(x),

ꢀꢀꢀ

(4)。

[0058]

出口:在本发明的多输出结构中,每一个出口包含一个roialign层和两个卷积层(conv_exit*_1和conv_exit*_2),其输出包含两个节点,分别对应目标和背景。每一个出口可以看成一个二元分类器。conv_exit*_1和conv_exit*_2的输出大小分别为3

×3×

128和1

×1×

2。出口的置信度分数用于决定是在该出口以高置信度定位目标还是继续到下一个出口进一步处理。

[0059]

在大多数基于分类的跟踪方法中,区域(roi)特征通常在高层特征上进行提取,然而高层缺乏精确定位目标的细节信息。为了在区域特征中补充细节特征,本发明提出将前序出口的区域特征叠加到当前出口。具体而言,区域特征可以表示为3

×3×

ch,ch表示特征通道数。对于当前出口,将前序出口的区域特征沿通道轴进行串联。

[0060]

第三部分是基于知识蒸馏的多出口训练,给定一个教师分类器t和从t学习的学生分类器s,该学习过程可以通过最小化其输出的交叉熵来优化:

[0061][0062]

其中,t(x)和s(x)分别表示t和s的预测。temp是温度参数,用来控制教师t输出的软度。[t

1/temp

(x)]c和[s

1/temp

(x)]c分别表示t和s的软预测。c表示类别的数量。之后,多出口结构的蒸馏损失定义如下:

[0063][0064]

其中,ex是出口的数量。t(e)∈ex表示教师出口的集合。这里,设置所有出口都针对最后一个出口进行学习。cf(

·

)表示每个出口对应的分类器。最后,整个模型通过最小化分类损失l

cls

和l

dis

进行优化:

[0065]

l=l

cls

+al

dis

,

ꢀꢀꢀ

(7);

[0066]

其中,a是一个超参数用于平衡两种损失。在实验过中,设置a=1。

[0067]

四、实验结果

[0068]

本发明通过pytorch实现,并在一个配有intel(r)4790k cpu和一个nvidiateslak40c gpu的机器上运行。对于离线训练阶段,使用imagenet-vid数据集进行训练。在给定视频中随机选取8个视频帧,并在每个视频帧中采集64个正样本和192个负样本。给定标记框,正样本的采集阈值为≥0.7,负样本的采集范围为0到0.5。以0.0001的学习率训练1000个周期。对于在线训练阶段,在第一帧中采集500个正样本和5000个负样本来初始化模型。并且,在获得当前帧估计的位置时,采集96个正样本和192个负样本。在每10帧后,利用采集的正负样本训练模型。

[0069]

在验证本发明性能时,将其命名为dmenet,并使用四个公开数据集(otb-100、uav123、lasot和vot2018)来评估性能。

[0070]

图4展示了本发明的方法和其他11个主流跟踪方法在otb-100数据集上的比较结果。比较的方法包括:vital、siamrpn++、mdnet、kys、dimp、prdimp、dat、dasiamrpn、atom、traca和udt。如图4所示,dmenet获得了最高的成功率(success)分数。同时,在dmenet在精

度(precision)和成功率都超过了目前基于分类的跟踪方法vital。

[0071]

不同于otb-100的视频采集自现实生活,uav123的视频都是从无人机平台采集的。在图5中展示了dmenet与其他主流方法在uav123数据集上的比较结果,由图5可以看出,dmenet在所有比较的跟踪方法中取得了有竞争力的结果。

[0072]

lasot数据集由1400个视频序列组成。在该数据集中,跟踪方法主要依据成功率(success)进行评估。所有方法在包含280个视频的测试集上进行测试。表1展示了各方法的成功率。如表1所示,dmenet的成功率值远高于其他基于分类的跟踪方法,即vital和mdnet。

[0073]

表1 lasot数据集上成功率的比较

[0074][0075]

vot2018数据集包含60个视频序列,评估标准包括:准确度(ar)、鲁棒性(rr)以及期望平均重叠率(eao)。如表2所示,dmenet在所有比较的跟踪方法中排名更高,取得了有竞争力的结果。

[0076]

表2 vot2018的比较结果

[0077][0078]

图6统计了各出口在有无知识蒸馏的输出。其中,e*表示出口,e*w/dis表示各出口通过知识蒸馏进行训练。由图6可知,在有知识蒸馏的情况下,前序出口的输出量增长较多,加快了算法的运行速度。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1