一种卷积神经网络模型的压缩方法及装置与流程

1.本发明涉及卷积神经网络技术领域,特别是涉及一种卷积神经网络模型的压缩方法及装置。

背景技术:

2.机器视觉领域是人工智能的重要分支,在自动驾驶和安防等场景下有着广泛应用。以卷积神经网络为代表的深度学习算法在目标检测等任务上表现优异,但卷积神经网络模型由于巨大的参数量和计算资源开销,难以在内存和计算资源稀缺的边缘计算平台上部署。实际应用中,除了对算法高精度的需求外,大量的应用领域还对算法的运行速度有严苛要求。在计算资源一定的条件下,卷积神经网络模型的算力消耗和运行效率存在矛盾对立,需要对网络的精度表现和运行速度进行权衡。而计算资源受限的场景下无法获得高性能gpu加速,对卷积神经网络模型进行压缩的需求十分迫切。

3.为解决此问题,学者们提出了剪枝、量化、权重分解等方法压缩网络。网络剪枝是指去除网络中不重要的权值、卷积核、卷积层等结构,从而减少卷积的计算量;权值量化是指采用更少的比特位宽的方式存储权重和参与运算,具有代表性的权值量化方法包括二值量化、三值量化、八位量化以及混合精度量化等;权重分解是指将参与存储和运算的权重矩阵以低秩矩阵进行表示,常见的权重低秩分解包括奇异值分解和张量分解等方式。

4.但上述方法均有各自的不足:上述剪枝算法通常未进行稀疏化训练或以固定正则化项约束进行稀疏化训练,无法充分挖掘卷积神经网络中的冗余,导致剪枝效率低下且压缩精度损失较大;量化方法降低了卷积神经网络权重存储的位宽,但并未降低卷积神经网络的计算量;权重分解的方法更改了网络的权重结构,难以与其他压缩方法结合形成组合压缩策略,扩展性受限。

技术实现要素:

5.为克服上述现有技术存在的不足,本发明之目的在于提供一种卷积神经网络模型的压缩方法及装置,通过动态正则化约束卷积通道重要性因子γ进行稀疏化训练,再进行全局通道剪枝的方法,从而极大地提高了剪枝效率,改善了剪枝效果。本发明中的卷积通道重要性因子γ指卷积神经网络中卷积通道对应的批归一化层(batch normalization)中的缩放因子。

6.为达上述及其它目的,本发明提出一种卷积神经网络模型的压缩方法,包括如下步骤:

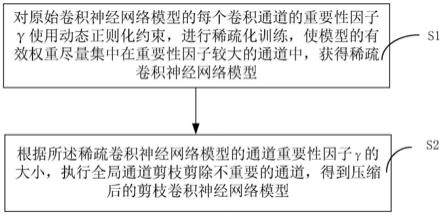

7.步骤s1,对原始卷积神经网络模型的每个卷积通道的重要性因子γ使用动态正则化约束,进行稀疏化训练,使模型的有效权重尽量集中在重要性因子较大的通道中,获得稀疏的稀疏卷积神经网络模型;

8.步骤s2,根据稀疏卷积神经网络模型的通道重要性因子γ的大小,自低向高执行全局通道剪枝剪除预设数量的通道,得到压缩后的剪枝卷积神经网络模型。

9.优选地,步骤s1进一步包括:

10.步骤s101,对所述原始卷积神经网络进行一轮稀疏化训练,得到稀疏的中间卷积神经网络模型;

11.步骤s102,对所述中间卷积神经网络模型进行测试,在验证集上运行所述中间卷积神经网络模型,得到本轮稀疏化训练后的map;

12.步骤s103,若本轮稀疏化训练后的中间卷积神经网络的map高于本轮稀疏化训练前的卷积神经网络的map,按照预设的正则化项稀疏度因子的更新策略,增大正则化项的稀疏度;若所述本轮稀疏化训练后的中间卷积神经网络的map低于本轮稀疏化训练前的卷积神经网络的map,则按照预设的正则化项稀疏度因子的更新策略,判别本轮正则化项的稀疏度是否更新;

13.步骤s104,若稀疏化训练未进行到预设的总轮数,则返回执行步骤s101继续对所述卷积神经网络进行稀疏化训练;否则,将所述经过预设总轮数稀疏化训练的卷积神经网络作为获得的所述稀疏的稀疏卷积神经网络模型。

14.优选地,于步骤s101之前,还包括如下步骤:

15.步骤s100,设定稀疏化训练的超参数、动态可变正则化函数的形式和正则化项稀疏度因子的更新策略。

16.优选地,所述设定所述稀疏化训练的超参数的方法包括:

17.设定卷积神经网络模型稀疏化训练的稀疏率r;

18.设定卷积神经网络模型预期的剪枝率s;

19.根据训练数据集的大小和卷积神经网络的预期剪枝率,得到卷积神经网络稀疏化训练的总轮数。

20.优选地,所述稀疏率略高于所述预期的剪枝率。

21.优选地,设定所述动态可变正则化函数的形式包括设定带有可变稀疏度因子的正则化项,使用其稀疏性约束通道重要性因子收缩。

22.优选地,所述正则化项稀疏度因子的更新策略包括比较并计算稀疏后的卷积神经网络的map与系数前的卷积神经网络的map的差值,根据比较结果更新正则化项的可变稀疏度因子。

23.优选地,在步骤s2之前,还包括如下步骤:

24.对卷积神经网络每个通道对应的重要性因子依照大小进行排序,以所述重要性因子从低到高的顺序作为通道的剪枝优先级。

25.优选地,步骤s2进一步包括:

26.步骤s201,根据预期通道剪枝率和卷积神经网络模型的通道总数,计算需要剪除的通道的数量n,并按照通道的重要性因子γ,对将所述稀疏卷积神经网络模型中n个通道的标志状态设置为待剪除状态;

27.步骤s202,逐卷积层判断是否该层所有的卷积通道的标志状态都为待剪除状态,若是,则将该层重要性因子最高的通道的待剪除状态标志取消,直至完成所有卷积层的判断;

28.步骤s203,对所述稀疏卷积神经网络模型按照所述通道的标志状态,删除所有被设置为待剪除状态的通道和对应的网络模型权值,完成所述卷积通道的剪枝,得到所述压

缩后的剪枝卷积神经网络模型。

29.步骤204,利用验证集,对s203获得的剪枝神经网络执行微调训练,记录微调后剪枝神经网络在验证集上的map。

30.为达到上述目的,本发明还提供一种卷积神经网络模型的压缩装置,包括:

31.稀疏化训练单元,用于对原始卷积神经网络模型的每个卷积通道的重要性因子使用动态正则化约束,进行稀疏化训练,使模型的有效权重尽量集中在重要性因子较大的通道中,获得稀疏的稀疏卷积神经网络模型;

32.全局通道剪枝单元,用于根据稀疏卷积神经网络模型的通道重要性因子的大小,执行全局通道剪枝剪除不重要的通道,得到压缩后的剪枝卷积神经网络模型。

33.与现有技术相比,本发明一种卷积神经网络模型的压缩方法及装置通过使用动态正则化约束卷积通道重要性因子进行稀疏化训练,获得稀疏的卷积神经网络模型,并使用通道重要性因子评判通道的剪枝优先级,然后根据所述剪枝优先级排序,在全局范围内执行通道剪枝,从而获得压缩的卷积神经网络模型,本发明不仅解决了目前卷积神经网络参数数量及计算量巨大的问题,而且在保证模型压缩率的同时,有效提升了网络的精度表现,为在资源有限的边缘计算平台上部署卷积神经网络模型提供了可能。

附图说明

34.图1为本发明一种卷积神经网络模型的压缩方法的步骤流程图;

35.图2为本发明一种卷积神经网络模型的压缩装置的系统架构图;

36.图3为本发明实施例中步骤一的细部流程图。

具体实施方式

37.以下通过特定的具体实例并结合附图说明本发明的实施方式,本领域技术人员可由本说明书所揭示的内容轻易地了解本发明的其它优点与功效。本发明亦可通过其它不同的具体实例加以施行或应用,本说明书中的各项细节亦可基于不同观点与应用,在不背离本发明的精神下进行各种修饰与变更。

38.图1为本发明一种卷积神经网络模型的压缩方法的步骤流程图。如图1所示,本发明一种卷积神经网络模型的压缩方法,包括如下步骤:

39.步骤s1,对原始卷积神经网络模型的每个卷积通道的重要性因子γ使用动态正则化约束,进行稀疏化训练,使模型的有效权重尽量集中在重要性因子较大的通道中,获得稀疏卷积神经网络模型。本发明中的卷积通道重要性因子γ指卷积神经网络中卷积通道对应的批归一化层(batch normalization)中的缩放因子。

40.优选地,在执行步骤s1之前,可以先基于目标检测算法训练获取所述原始卷积神经网络模型。但需说明的是,本发明并不限制获取所述原始卷积神经网络模型的目标检测算法,也不限制所述原始卷积神经网络模型的应用场景,即上述卷积神经网络模型的压缩方法可以但不限于应用于任何使用卷积神经网络模型的领域中,例如,包括但不限于图像识别、语音识别和文档分析等领域。

41.具体地,步骤s1进一步包括:

42.步骤s101,对所述原始卷积神经网络进行一轮稀疏化训练,得到稀疏的中间卷积

神经网络模型;

43.步骤s102,对所述中间卷积神经网络模型进行测试,在验证集上运行所述中间卷积神经网络模型,得到本轮稀疏化训练后的map(map:mean average precision,平均的平均精确度)。具体地,首先在一个类别内,求平均精确度ap(average precision),然后对所有类别的平均精确度再求平均(mean average precision),map在目标检测中用于判断识别的准确率,即用于衡量物品被检测出的概率。

44.步骤s103,若本轮稀疏化训练后的中间卷积神经网络的map高于本轮稀疏化训练前的卷积神经网络的map,按照预设的正则化项稀疏度因子的更新策略,增大正则化项的稀疏度;若所述本轮稀疏化训练后的中间卷积神经网络的map低于本轮稀疏化训练前的卷积神经网络的map,则按照预设的正则化项稀疏度因子的更新策略,判别本轮正则化项的稀疏度是否更新。

45.步骤s104,若稀疏化训练未进行到预设的总轮数,则返回执行步骤s101继续对所述原始卷积神经网络进行稀疏化训练;否则,将所述经过预设总轮数稀疏化训练的卷积神经网络作为获得的所述稀疏卷积神经网络模型。

46.优选地,于步骤s101之前,还包括如下步骤:

47.步骤s100,设定稀疏化训练的超参数、动态可变正则化函数的形式和正则化项稀疏度因子的更新策略。

48.在本发明具体实施例中,设定所述稀疏化训练的超参数的方法包括:

49.设定原始卷积神经网络模型稀疏化训练的稀疏率,具体地,所述稀疏率应略高于预期的剪枝率,使得模型通道获得适度的稀疏比例,在本发明具体实施例中,所述稀疏率为所述剪枝率+5%;

50.设定原始卷积神经网络模型预期的剪枝率,在本发明具体实施例中,所述剪枝率设置为90%;

51.根据训练数据集的大小和原始卷积神经网络的预期剪枝率,得到原始卷积神经网络稀疏化训练的总轮数,在本发明具体实施例中,假设采用数据集训练集图像数为70000张,共10类,根据原始卷积神经网络的剪枝预期,所述稀疏化训练总轮数应大于图像数和类别数的2000倍,因此设定所述稀疏化训练的总轮数为70000。

52.设定所述动态可变正则化函数的形式包括设定带有可变稀疏度因子的正则化项,使用其稀疏性约束通道重要性因子收缩。作为一种效果较好的方式,在本发明具体实施例中,使用l

p

正则化和tl1正则化的组合形式即tl

p

正则化作为所述动态可变正则化函数,其中p即为所述可变稀疏度因子,该动态可变正则化函数的输入值为γ,即xi=γi,γi表示第i个通道的重要性因子。

53.所述正则化项稀疏度因子的更新策略包括:比较并计算稀疏后的卷积神经网络的map与稀疏前的卷积神经网络的map的差值,按照线性调整、使用模拟退火算法调整等多种方法更新正则化项的可变稀疏度因子。作为一种效果较好的方式,在本发明具体实施例中使用模拟退火算法,依照概率接受所述可变稀疏度因子的随机调整。

54.步骤s2,根据所述稀疏卷积神经网络模型的通道重要性因子γ的大小,执行全局通道剪枝剪除不重要的通道,得到压缩后的剪枝卷积神经网络模型。即根据稀疏卷积神经网络模型的通道重要性因子的大小,按照通道的剪枝优先级顺序,执行全局剪枝剪除相应数量的通道,并判断是否完成剪枝,直至模型达到压缩率和准确率的要求,得到压缩后的剪枝卷积神经网络模型。

55.优选地,在步骤s2之前,还包括如下步骤:

56.对所述稀疏卷积神经网络每个通道对应的重要性因子γ依照大小进行排序,以所述重要性因子γ从低到高的顺序作为通道的剪枝优先级。即:重要性因子数值越低的通道,在后续剪枝中被排在更高的剪枝优先级,会被优先剪除。

57.具体地,步骤s2进一步包括:

58.步骤s201,根据预期通道剪枝率s和卷积神经网络模型的通道总数n(其中原始卷积神经网络模型的和稀疏卷积神经网络模型的通道数量一致),计算需要剪除的通道的数量n,并按照通道的重要性因子γ,自小到大将所述稀疏卷积神经网络模型中n个通道的标志状态设置为待剪除状态,在本发明具体实施例中,剪除通道的数量n=原始通道总数n*预设剪枝率s;

59.步骤s202,逐卷积层判断是否该层所有的卷积通道的标志状态都为待剪除状态,若是,则将该层重要性因子最高的通道的待剪除状态标志取消,直至完成所有卷积层的判断;

60.步骤s203,对所述稀疏卷积神经网络模型按照所述通道的标志状态,删除所有被设置为待剪除状态的通道和对应的网络模型权值,完成所述卷积通道的剪枝,得到所述压缩后的剪枝卷积神经网络模型。

61.步骤204,利用验证集,对s203获得的剪枝神经网络执行微调训练,记录微调后剪枝神经网络在验证集上的map。

62.具体地,计算剪枝神经网络在验证集上的map,判断该map是否低于预设map阈值,若是,则完成微调后训练,并记录微调后剪枝神经网络在验证集上的map。

63.图2为本发明一种卷积神经网络模型的压缩装置的系统结构图。如图2所示,本发明一种卷积神经网络模型的压缩装置,包括:

64.稀疏化训练单元20,用于对原始卷积神经网络模型的每个卷积通道的重要性因子γ使用动态正则化约束,进行稀疏化训练,使模型的有效权重尽量集中在重要性因子较大的通道中,获得稀疏的稀疏卷积神经网络模型。本发明中的卷积通道重要性因子γ指卷积神经网络中卷积通道对应的批归一化层(batch normalization)中的缩放因子。

65.优选地,稀疏化训练单元20在进行稀疏化训练前,需先基于目标检测算法训练获取所述原始卷积神经网络模型。但需说明的是,本发明并不限制获取所述原始卷积神经网络模型的目标检测算法,也不限制所述原始卷积神经网络模型的应用场景,即上述卷积神经网络模型的压缩方法可以但不限于应用于任何使用卷积神经网络模型的领域中,例如,包括但不限于图像识别、语音识别和文档分析等领域。

66.具体地,稀疏化训练单元20进一步包括:

67.中间卷积神经网络模型获取模块201,用于对所述原始卷积神经网络进行一轮稀疏化训练,得到稀疏的中间卷积神经网络模型;

68.测试模块202,用于对所述中间卷积神经网络模型进行测试,在验证集上运行所述中间卷积神经网络模型,得到本轮稀疏化训练后的map(map:mean average precision,平均的平均精确度)。具体地,首先在一个类别内,求平均精确度ap(average precision),然后对所有类别的平均精确度再求平均(mean average precision),map在目标检测中用于判断识别的准确率,即用于衡量物品被检测出的概率。

69.更新策略处理模块203,若本轮稀疏化训练后的中间卷积神经网络的map高于本轮稀疏化训练前的卷积神经网络的map,按照预设的正则化项稀疏度因子的更新策略,增大正则化项的稀疏度;若所述本轮稀疏化训练后的中间卷积神经网络的map低于本轮稀疏化训练前的卷积神经网络的map,则按照预设的正则化项稀疏度因子的更新策略,判别本轮正则化项的稀疏度是否更新。

70.迭代训练模块204,若稀疏化训练未进行到预设的总轮数,则返回执行中间卷积神经网络模型获取模块201继续对所述原始卷积神经网络进行稀疏化训练;否则,将所述经过预设总轮数稀疏化训练的卷积神经网络作为获得的所述稀疏的稀疏卷积神经网络模型。

71.优选地,稀疏化训练单元20还包括如下步骤:

72.参数设定模块200,用于设定稀疏化训练的超参数、动态可变正则化函数的形式和正则化项稀疏度因子的更新策略。

73.在本发明具体实施例中,设定所述稀疏化训练的超参数的方法包括:

74.设定卷积神经网络模型稀疏化训练的稀疏率,,具体地,所述稀疏率应略高于预期的剪枝率,使得模型通道获得适度的稀疏比例,在本发明具体实施例中,所述稀疏率为所述剪枝率+5%;

75.设定卷积神经网络模型预期的剪枝率,在本发明具体实施例中,所述剪枝率设置为90%;

76.根据训练数据集的大小和卷积神经网络的预期剪枝率,得到卷积神经网络稀疏化训练的总轮数,在本发明具体实施例中,假设采用数据集训练集图像数为70000张,共10类,根据卷积神经网络的剪枝预期,所述稀疏化训练总轮数应大于图像数和类别数的2000倍,因此设定所述稀疏化训练的总轮数为70000。

77.设定所述动态可变正则化函数的形式包括设定带有可变稀疏度因子的正则化项,使用其稀疏性约束通道重要性因子收缩。作为一种效果较好的方式,在本发明具体实施例中,使用l

p

正则化和tl1正则化的组合形式即tl

p

正则化作为所述动态可变正则化函数,其中p即为所述可变稀疏度因子。

78.所述正则化项稀疏度因子的更新策略包括:比较并计算稀疏后的卷积神经网络的map与系数前的卷积神经网络的map的差值,按照线性调整、使用模拟退火算法调整等多种方法更新正则化项的可变稀疏度因子。作为一种效果较好的方式,在本发明具体实施例中使用模拟退火算法,依照概率接受所述可变稀疏度因子的随机调整。

79.全局通道剪枝单元21,用于根据稀疏卷积神经网络模型的通道重要性因子γ的大小,执行全局通道剪枝剪除不重要的通道,得到压缩后的剪枝卷积神经网络模型。即根据稀

疏卷积神经网络模型的通道重要性因子的大小,按照通道的剪枝优先级顺序,执行全局剪枝剪除预设数量的通道,并判断是否完成剪枝,直至模型达到压缩率和准确率的要求,得到压缩后的剪枝卷积神经网络模型。

80.优选地,本发明之卷积神经网络模型的压缩装置,还包括:

81.剪枝优先级确定单元22,用于对稀疏卷积神经网络每个通道对应的重要性因子依照大小进行排序,以所述重要性因子从低到高的顺序作为通道的剪枝优先级。即:重要性因子数值越低的通道,被视为重要性越低,在后续剪枝中被排在更高的剪枝优先级,会被优先剪除。

82.具体地,全局通道剪枝单元21进一步包括:

83.标志状态设置模块210,用于根据预期通道剪枝率s和卷积神经网络模型的通道总数n(原始卷积神经网络模型的和稀疏卷积神经网络模型的通道数量一致),计算需要剪除的通道的数量n,并按照通道的重要性因子γ,自小到大将所述稀疏卷积神经网络模型中n个通道的标志状态设置为待剪除状态,在本发明具体实施例中,剪除通道的数量n=原始通道总数n*预设剪枝率s;

84.遍历处理模块211,用于逐卷积层判断是否该层所有的卷积通道的标志状态都为待剪除状态,若是,则将该层重要性因子最高的通道的待剪除状态标志取消,直至完成所有卷积层的判断;

85.剪枝模块212,用于对所述稀疏卷积神经网络模型按照所述通道的标志状态,删除所有被设置为待剪除状态的通道和对应的网络模型权值,完成所述卷积通道的剪枝,得到所述压缩后的剪枝卷积神经网络模型。

86.微调训练模块213,用于利用验证集,对剪枝模块212获得的剪枝神经网络执行微调训练,记录微调后剪枝神经网络在验证集上的map。

87.实施例

88.在本实施例,一种卷积神经网络模型的压缩方法,包括以下步骤:

89.步骤一,对原始卷积神经网络模型的每个卷积通道的重要性因子使用动态正则化约束,进行稀疏化训练,使模型的有效权重尽量集中在重要性因子较大的通道中,获得稀疏的稀疏卷积神经网络模型;

90.在本实施例中,在执行步骤一之前,可以先基于目标检测算法训练获取所述原始卷积神经网络模型。特别地,本发明并不限制获取所述原始卷积神经网络模型的目标检测算法,也不限制所述原始卷积神经网络模型的应用场景,即上述卷积神经网络模型的压缩方法可以但不限于应用于任何使用卷积神经网络模型的领域中。例如,包括但不限于图像识别、语音识别和文档分析等领域。

91.具体地,结合图3,使用动态正则化约束卷积通道重要性因子进行稀疏化训练方法说明如下,具体包括以下步骤:

92.步骤s110,设定卷积神经网络模型稀疏化训练的稀疏率,具体地,所述稀疏率应略高于预期的剪枝比率,使得模型通道获得适度的稀疏比例,在本实例中,所述稀疏率为所述剪枝率+5%。

93.步骤s120,设定卷积神经网络模型预期的剪枝率,在本实例中,所述剪枝率设置为90%。

94.步骤s130,根据训练数据集的大小和卷积神经网络的预期剪枝率,得到所述卷积神经网络稀疏化训练的总轮数,在本实例中,采用数据集训练集图像数为70000张,共10类,根据卷积神经网络的剪枝预期,所述稀疏化训练总轮数应大于图像数和类别数的2000倍,因此设定所述稀疏化训练的总轮数为70000。

95.在本实施例中,所述设定动态可变正则化函数的形式的方法包括:

96.设定带有可变稀疏度因子的正则化项,使用其稀疏性约束通道重要性因子收缩,作为一种效果较好的方式,在本实例中,使用l

p

正则化和tl1正则化的组合形式即tl

p

正则化作为所述动态可变正则化函数,其中p即为所述可变稀疏度因子。

97.在本实施例中,所述正则化项稀疏度因子的更新策略包括:

98.比较并计算稀疏后的卷积神经网络的map与系数前的卷积神经网络的map的差值,按照线性调整、使用模拟退火算法调整等多种方法更新正则化项的可变稀疏度因子,作为一种效果较好的方式,在本实例中使用模拟退火算法,依照概率接受所述可变稀疏度因子的随机调整。

99.步骤s140,对所述原始卷积神经网络进行一轮稀疏化训练,得到稀疏的中间卷积神经网络模型。

100.步骤s150,对所述中间卷积神经网络模型进行测试,在验证集上运行所述中间卷积神经网络模型,得到本轮稀疏化训练后的map。map:mean average precision,平均的平均精确度,首先是一个类别内,求平均精确度ap(average precision),然后对所有类别的平均精确度再求平均(mean average precision),map在目标检测中用于判断识别的准确率,即用于衡量物品被检测出的概率。

101.步骤s160,若所述本轮稀疏化训练后的中间卷积神经网络的map高于本轮稀疏化训练前的卷积神经网络的map,按照预设的正则化项稀疏度因子的更新策略,增大正则化项的稀疏度;若所述本轮稀疏化训练后的中间卷积神经网络的map低于本轮稀疏化训练前的卷积神经网络的map,按照预设的正则化项稀疏度因子的更新策略,判别本轮正则化项的稀疏度是否更新。在本实施实例中,使用模拟退火算法依照概率决定正则化项稀疏度因子的更新:若所述本轮稀疏化训练后的中间卷积神经网络的map高于本轮稀疏化训练前的卷积神经网络的map,按照规则接受所述可变稀疏度因子的随机调整;否则按照概率判别本轮正则化项的稀疏度是否更新。

102.步骤s170:若稀疏化训练未进行到预设的总轮数,执行步骤s140继续对所述卷积神经网络进行稀疏化训练;否则进入步骤s180。

103.步骤s180,将所述经过预设总轮数稀疏化训练的卷积神经网络作为获得的稀疏的稀疏卷积神经网络模型。

104.至此,已经完成了使用动态正则化约束卷积通道重要性因子进行的稀疏化训练。

105.步骤二,对卷积神经网络每个通道对应的重要性因子依照大小进行排序,以所述重要性因子从低到高的顺序作为通道的剪枝优先级。即:所述重要性因子数值越低的通道,

被视为重要性越低,在后续剪枝中被排在更高的剪枝优先级,高优先级的通道将被优先剪除。

106.步骤三,根据稀疏卷积神经网络模型的通道重要性因子的大小,执行全局通道剪枝剪除不重要的通道,得到压缩后的剪枝卷积神经网络模型。

107.具体地,所述步骤二中所述对所述稀疏卷积神经网络模型执行全局通道剪枝是指,按照所述的剪枝优先级顺序,对所述通道剪除预设数量的通道,判断是否完成剪枝,直至模型达到压缩率和准确率的要求,得到压缩后的剪枝卷积神经网络模型。

108.在本实施例中,步骤三中所述全局通道剪枝的方法包括以下步骤:

109.步骤s310,根据预期通道剪枝率s和卷积神经网络模型的通道总数n,计算需要剪除的通道的数量,剪除通道的数量n=原始通道总数n*预设剪枝率s,并按照通道的重要性因子γ,自小到大对将稀疏卷积神经网络模型中n个通道的标志状态设置为待剪除状态;

110.步骤s320,逐卷积层判断是否该层所有的卷积通道的标志状态都为待剪除状态,若是,则将该层重要性因子最高的通道的待剪除状态标志取消,直至完成所有卷积层的判断。这一步骤的目的,是对每一层卷积层保留最低限度的通道,从而保证特征的正常传递。

111.步骤s330,对所述稀疏卷积神经网络模型按照所述通道的标志状态,删除所有被设置为待剪除状态的通道和对应的网络模型权值,完成所述卷积通道的剪枝,得到所述压缩后的剪枝卷积神经网络模型。。

112.步骤s340,利用训练数据集,对s330获得的剪枝神经网络执行微调训练,记录微调后剪枝神经网络在验证集上的map。

113.综上所述,本发明一种卷积神经网络模型的压缩方法及装置通过使用动态正则化约束卷积通道重要性因子进行稀疏化训练,获得稀疏的卷积神经网络模型,并使用通道重要性因子评判通道的剪枝优先级,然后根据所述剪枝优先级排序,在全局范围内执行通道剪枝,从而获得压缩的卷积神经网络模型,本发明不仅解决了目前卷积神经网络参数数量及计算量巨大的问题,而且在保证模型压缩率的同时,有效提升了网络的精度表现,为在资源有限的边缘计算平台上部署卷积神经网络模型提供了可能。

114.上述实施例仅例示性说明本发明的原理及其功效,而非用于限制本发明。任何本领域技术人员均可在不违背本发明的精神及范畴下,对上述实施例进行修饰与改变。因此,本发明的权利保护范围,应如权利要求书所列。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1