基于注意力机制的传感器融合深度重建数据驱动方法

1.本发明属于数据驱动技术,具体为一种基于注意力机制的传感器融合深度重建数据驱动方法。

技术背景

2.从感知场景中推断出正确的深度信息对许多应用来说是至关重要的,例如自动驾驶、虚拟现实、增强现实和机器人技术。激光雷达是深度成像中的领先技术,目前,大多数激光雷达系统采取单点/扫描的方式,使用共轴对齐的激光二极管和单光子探测器,由激光器发射激光,探测器时间标注经场景反射回来的到达光子。扫描式激光雷达系统虽然能够获取较为准确的深度信息,但采集速度慢,通常需要花费数小时才能完成一次场景信息获取。然而,越来越多的应用要求能够对场景进行快速获取,在此需求之下,单光子雪崩二极管(spad)阵列应运而生。采用主动成像方式,spad阵列可以提供准确快速的场景深度信息。

3.目前,激光雷达的分辨率较低,尤其是spad阵列,因此,深度重建也是一个热门的研究方向。仅从激光雷达系统中获取的信息进行深度重建效果是有限的,多维信息融合,即利用高分辨率强度图与低分辨率深度图互补,是解决这一问题的方法之一。依赖于传感器融合神经网络进行深度估计的方法,已知有三种技术途径:(1)lindell等人结合常规高分辨率相机和线列spad(linospad),使用多尺度深度卷积网络,提出了一种用于效率3d成像的数据驱动方法(1.d.b.lindell,m.o’toole,and g.wetzstein,single-photon 3d imaging with deep sensor fusion.acm trans.graph,2018,vol.37(4),pp:1-12.);(2)sun等人引入了单目深度估计算法,能从强度信息中得到更可靠的相对距离信息(2.z.-h.sun,d.b.lindell,o.solgaard,and g.wetzstein,spadnet:deep rgb-spad sensor fusion assisted by monocular depth estimation.optical express.2020,vol.28(10),pp:14948-14962.);(3)ruget等人使用了相同的spad阵列传感器,基于神经网络,利用强度图和多个从直方图中提取出的特征引导深度上采样(3.a.ruget,s.mclaughlin,r.k.henderson,i.gyongy,a.halimi,and j.leach,robust super-resolution depth imaging via a multi-feature fusion deep network.optical express,2021,vol.29(8),pp:11917-11937.)。第一种方法和第二种方法分别采用线列spad探测器和单点spad探测器,需要对场景扫描成像,获取一次场景的深度信息往往需要数几个小时,无法满足越来越多应用的实时性要求;第三种方法主要针对深度超分辨问题,需要预先从探测器的原始数据中选择重要特征,即先对原始数据去噪,再输入网络,具有较多的预处理步骤,且网络只具有上采样功能。

技术实现要素:

4.本发明的目的在于提出了一种基于注意力机制的传感器融合深度重建数据驱动方法,以实现稳健提取目标清晰无噪的三维距离图像。

5.实现本发明的技术解决方案为:一种基于注意力机制的传感器融合深度重建数据

驱动方法,具体步骤为:

6.第一步,构建基于注意力机制的传感器融合网络并对其进行训练;其中,所述基于注意力机制的传感器融合网络包括特征提取模块和融合重构模块,所述特征提取模块用于提取spad测量数据和强度数据中的多尺度特征,所述融合重构模块用于对对应尺度的强度特征和深度特征在时间维度上级联,并进行特征融合操作,得到重构后的深度图;

7.第二步,从spad阵列探测器和相机中分别获取深度数据和强度数据,采用棋盘格法进行深度图和强度图的配准,得到对应同一视角下的强度数据和深度数据;针对信噪比小于设定阈值的配准后深度数据,在时间维度上截取包含信号光子的时间段,得到较高信噪比的深度数据;采用最近邻法,将较高信噪比深度数据的空间分辨率提升至四倍;

8.第三步,利用第二步得到的强度数据和深度数据,作为基于注意力机制的传感器融合网络的输入,提取不同尺度的深度特征和强度特征,将二维强度特征在时间维度上重复得到与深度数据维度一致的三维强度数据,对于各个尺度的强度特征和深度特征,在时间维度上进行级联,并进行融合重构模块提升融合质量,上采样至输入数据尺寸后,得到输出的重建深度图。

9.优选地,所述特征提取模块提取spad测量数据和强度数据中的多尺度特征的具体过程为:

10.下采样因子为2-l

,使用l个三维特征提取器,从spad测量数据中提取l个多尺度特征;

11.网络原始输入和提取得到的多尺度特征经过若干三维卷积层,获得更深层的特征;

12.使用l个二维特征提取器,从强度数据中获得与深度特征尺度相对应的强度特征,将强度数据及强度特征在时间维度上平移,获得二维至三维的映射。

13.优选地,每个三维特征提取器包括一个三维卷积层、一个三维批归一化层和修正线性单元激活函数,每个三维特征提取器中,特征首先进入三维卷积层,三维卷积层的输出作为三维批归一化层的输入,三维批归一化层的输出作为修正线性单元激活函数的输入,修正线性单元激活函数的输出作为下一尺度三维特征提取器的输入。

14.优选地,所述融合重构模块进行特征融合得到重构后的深度图的具体步骤为:

15.a、对应尺度的深度特征与经过映射得到的三维强度特征在时间维度上级联,输入至上采样算子;

16.b、经上采样算子输出的融合特征图通过注意力模块,以关注图像中带有更多特征的区域;

17.c、从注意力模块中得到的上采样后的前一级特征图与更高尺度的深度特征与强度特征级联,输入至上采样算子,返回步骤b,直至得到与网络输入特征的分辨率一致的特征图,作为重构深度图。

18.本发明与现有技术相比,其显著优点:(1)不仅能够去除探测过程中的背景噪声光子,而且可以重建出深度细节,保留物体边缘,具有更好的图像视觉质量;(2)无需复杂的预处理步骤,使用截取时间轴的方式,提升信噪比,并且采用最近邻算子,将深度数据的空间分辨率提升四倍,保留原有的深度信息,减少人工干预,使用网络完成去噪和重建;(3)对网络的重建tcspc直方图施加kl散度和序数回归损失,同时关注光子在时间维度上的总体分

布和各个时间仓间的序数关系,更加关注物体边缘重建;(4)加入注意力机制,对特征更丰富的区域给予更多关注,提升数据融合质量。

19.下面结合附图对本发明作进一步详细描述。

附图说明

20.图1是用于验证本发明的实验设备图。

21.图2是基于注意力机制的传感器融合网络框架图。

22.图3是融合重建模块的框架示意图。

23.图4是在仿真测试数据上使用最大似然估计器、he等人提出的图像引导滤波(4.k.-m.he,j.sun,and x.tang,guided image filtering.ieee trans.pattern anal.mach.intell,2013,vol.35(6),pp:1397

–

1409.)、lindell等人提出的数据驱动融合方法(1.d.b.lindell,m.o’toole,and g.wetzstein,single-photon 3d imaging with deep sensor fusion.acm trans.graph,2018,vol.37(4),pp:1-12.)和本发明方法得到的重建目标深度图。

24.图5是在仿真测试数据上使用不同损失函数组合训练网络得到的重建目标深度图。

25.图6是在仿真测试数据上使用不同网络结构得到的重建目标深度图。

26.图7是在仿真测试数据上使用不同信噪比得到的重建目标深度图。

27.图8是在真实获取数据上使用不同方法、不同损失函数和不同网络结构得到的重建目标深度图。

28.图9是在真实获取数据上对不同信噪比环境得到的重建目标深度图。

29.图10是在真实获取数据上使用不同上采样方法得到的三维重建点云图。

具体实施方式:

30.一种基于注意力机制的传感器融合深度重建数据驱动方法,适用于光子计数三维成像激光雷达系统,具体步骤为:

31.第一步,构建基于注意力机制的传感器融合网络并对其进行训练;

32.进一步的实施例中,所述基于注意力机制的传感器融合网络包括特征提取模块和融合重构模块,主要作用是在高分辨率强度信息的引导下,对输入的低分辨率有噪深度数据进行去噪和上采样。所述特征提取模块用于提取spad测量数据和强度数据中的多尺度特征,使网络可以学习不同尺度的丰富层次特征,更好地适应精细和大规模尺度的上采样;特征提取模块得到多尺度的强度特征和深度特征,分别将对应尺度的强度特征和深度特征在时间维度上级联,输入至融合重构模块,进行特征融合操作,在强度特征的引导之下,得到重构后的深度图。融合重构模块引入了注意力模型,使网络关注融合数据中特征更多的区域,逐渐上采样至输入分辨率。

33.特征提取模块,用于提取强度和深度的多尺度特征,具体过程如下:

34.下采样因子为2-l

,使用l个三维特征提取器,从网络输入的spad测量数据d0中提取l个多尺度特征d1,

…

,d

l

。

35.具体地,每个三维特征提取器包括一个三维卷积层、一个三维批归一化层和修正

线性单元激活函数。每个三维提取器中,特征首先进入三维卷积层,三维卷积层的输出作为三维批归一化层的输入,三维批归一化层的输出作为修正线性单元激活函数的输入,修正线性单元激活函数的输出作为下一尺度三维特征提取器的输入。

36.网络原始输入和提取得到的多尺度特征d1,

…

,d

l

经过若干三维卷积层,以获得更深层的特征。

37.对于强度数据i0,应用l个二维特征提取器,获得与深度特征尺度相对应的强度特征i1,

…

,i

l

,其中,每个二维特征提取器由5个二维卷积层组成。强度数据及强度特征i0,

…

,i

l

简单地在时间维度上平移,获得二维至三维的映射。该过程的表达式如下:

[0038][0039][0040]il

=φ

fc

(i

l-1

)

[0041][0042]

上式由上至下分别代表了深度特征提取、深度特征提取后处理、强度特征提取、二维-三维映射算子,其中符号σ表示修正线性单元激活函数,表示用于提取特征d

l

的三维卷积层权重,符号*代表卷积操作,表示提取特征d

l

的三维卷积层偏差值,表示提取的深度特征,φ

fc

表示二维特征提取器,表示提取的强度特征,repeat(a,b)表示将a以尺寸b进行复制操作,size()表示取尺寸操作,l=2。

[0043]

所述融合重构模块融合深度特征和强度特征,使用上采样算子进行特征融合,并输入至注意力模块,关注融合后特征中具有更丰富信息的区域,得到重构后的高分辨率干净深度图,进行融合重构的步骤如下:

[0044]

对应尺度的深度特征与经过映射得到的三维强度特征在时间维度上级联,输入至上采样算子,经上采样算子输出的融合特征图再通过注意力模块,以关注图像中带有更多特征的区域。从注意力模块中得到的上采样后的前一级特征图再与更高尺度的深度特征与强度特征级联,再次进行上采样操作,直至得到与网络输入特征的分辨率一致的特征图,得到经强度引导的高分辨率干净重构深度图。

[0045]

上采样算子为一个带有batchnorm层和relu激活函数的三维反卷积层构成。注意力模块包含了通道注意力模块和空间注意力模块。首先利用特征的内在通道关系产生通道注意力图,再利用特征的内在空间关系生成空间注意力图。这两个注意力图分别关注“特征是什么”和“特征在哪里”。该过程可以表达为:

[0046][0047][0048]

其中表示融合后的尺度l的深度特征,cbam()表示注意力机制操作,符号表示反卷积操作,cat(a,b)表示将a和b进行级联。

[0049]

训练网络,基于泊松分布仿真训练数据集,在训练过程中同时对输出三维tcspc直

方图约束kl散度和序数回归损失,不仅能够关注光子的总体分布也可以考虑各个时间仓之间的序数关系,增加了全变差正则项,保存物体边缘。

[0050]

所述基于注意力机制的传感器融合网络的总损失函数为三个主要贡献的权重相加:在网络输出直方图和干净直方图d之间约束了kl散度d

kl

和序数回归损失loss

or

,并施加了全变差正则化约束项。总的训练损失函数为:

[0051]

loss

total

=d

kl

+λ1loss

or

+λ2tv

[0052]

kullback-leibler散度:kl散度,又称相对熵,用来度量网络输出直方图和干净直方图d之间概率分布的相似性:

[0053][0054]

其中,n代表时间仓索引。概率分布越相近,kl散度值越小。

[0055]

序数回归损失:由于kl散度独立计算各个时间仓的分布,因此引入了序数回归损失,考虑每个时间仓之间的序数关系:

[0056][0057][0058]

其中,w和h为图像宽度与高度,l为地面真实检测速率峰值的时间仓索引,“cumsum”代表累计求和。

[0059]

全变差项:引入tv空间正则项的目的在于去除伪影,保留边缘等重要细节,同时防止模型过拟合:

[0060][0061][0062]

第二步,从spad阵列探测器和常规相机中分别获取低分辨率深度数据和高分辨率强度数据,对获取数据进行预处理,提升原始数据质量,采用棋盘格法进行深度图和强度图的配准,得到对应同一视角下的高分辨率强度数据和低分辨率深度数据;针对信噪比小于设定阈值的配准后深度数据,在时间维度上截取包含信号光子的时间段,得到较高信噪比的深度数据;最后采用最近邻法,将较高信噪比深度数据的空间分辨率提升至四倍,得到网络输入深度数据,即高分辨率、高信噪比、有噪深度数据。

[0063]

第三步,利用上述第二步得到的强度数据和深度数据,作为基于注意力机制的传感器融合网络的输入,首先提取不同尺度的深度特征和强度特征,将二维强度特征在时间维度上重复得到与深度数据维度一致的三维强度数据,对于各个尺度的强度特征和深度特征,在时间维度上进行级联,并输入融合重构模块提升融合质量,上采样至输入数据尺寸后,得到输出的重建深度图。

[0064]

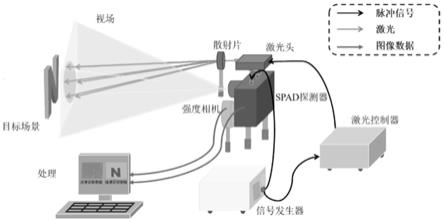

如图1所示,是用于验证本发明一种基于注意力机制的传感器融合深度重建网络方法的实验搭建示意图,可分为照明模块和感知模块。照明模块包括一个皮秒脉冲激光器

和一个散射片。激光器发射激光脉冲,激光经散射片被发散,以覆盖spad阵列的探测范围。感知模块包括一个spad探测器和常规相机。

[0065]

如图2所示,是基于注意力机制的传感器融合网络框架图。整个网络由特征提取和融合重构两个模块组成,其中特征提取模块用于提取spad测量和强度数据中的多尺度特征,使网络可以学习不同尺度的丰富层次特征,更好地适应精细和大规模尺度的上采样;融合重构模块引入了注意力模型,使网络关注融合数据中特征更多的区域,逐渐上采样至输入分辨率。损失函数由kl散度、序数回归损失和全变差正则项组成,在网络输出3d tcspc直方图上施加kl散度和序数回归损失以分别关注光子数在时间维度上的总体分布和每个时间仓之间的序数关系。为了保持重构结果的边缘,在经3d-2d映射后得到的2d深度图上施加全变差正则项。

[0066]

如图3所示,是融合重建模块的框架示意图。首先,对应尺度的深度特征与经过映射得到的3d强度特征在时间维度上级联,输入至上采样算子,经上采样输出的融合特征图再通过注意力模块,以关注图像中带有更多特征的区域。从注意力模块中得到的上采样后的前一级特征图再与更高尺度的深度特征与强度特征级联,再次进行上采样操作。

[0067]

如图4所示,是在仿真测试数据上使用最大似然估计器、he等人提出的图像引导滤波、lindell等人提出的数据驱动融合方法和本发明方法得到的重建目标深度图对比。其中,(a)为地面真实深度图和强度图,(b)为使用最大似然估计器得到的重建目标深度图,(c)为使用he等人提出的图像引导滤波方法得到的重建目标深度图,(d)为使用lindell等人提出的数据驱动融合方法得到的重建目标深度图,(e)为使用本发明方法得到的重建目标深度图。

[0068]

结合图5,是在仿真测试数据上使用不同损失函数组合训练网络得到的重建目标深度图对比。其中,(a)为地面真实深度图和强度图,(b)为损失函数仅使用kl散度训练网络得到的重建目标深度图,(c)为损失函数仅使用序数回归损失训练网络得到的重建目标深度图,(d)为使用本发明方法得到的重建目标深度图。

[0069]

结合图6,是在仿真测试数据上使用不同网络结构得到的重建目标深度图对比。其中,(a)为地面真实深度图和强度图,(b)为不含注意力机制的网络得到的重建目标深度图,(c)为不使用强度引导的网络得到的重建目标深度图,(d)为使用本发明方法得到的重建目标深度图。

[0070]

结合图7,是在仿真测试数据上使用不同信噪比得到的重建目标深度图对比。其中,(a)为信号光子数/背景光子数为2/2的情况,(b)为信号光子数/背景光子数为2/10的情况,(c)为信号光子数/背景光子数为2/50的情况。左侧为lindell等人提出的数据驱动方法得到的重建深度图,右侧为本发明方法得到的重建深度图。

[0071]

结合图8,是在真实获取数据上使用不同方法、不同损失函数和不同网络结构得到的重建目标深度图对比。其中,(a)为使用不同方法得到的重建目标深度图对比,(b)为使用不同损失函数得到的重建目标深度图对比,(c)为使用不同网络结构得到的重建目标深度图对比,(d)为本发明方法得到的重建目标深度图。

[0072]

结合图9,是在真实获取数据上对不同信噪比环境得到的重建目标深度图对比。(a)为信噪比0.05的情况,(b)为信噪比0.01的情况,(c)为信噪比0.001的情况。从左至右分别为预处理图,lindell等人提出的数据驱动方法以及本发明方法得到的重建深度图。

[0073]

结合图10,是在真实获取数据上使用不同上采样方法得到的三维重建点云图对比。其中,(a)为不进行上采样得到的三维重建点云图,(b)为使用后上采样法得到的三维重建点云图,(c)为使用预上采样法得到的三维重建点云图。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1