一种面向图像表示的深度图正则化非负矩阵分解方法

1.本发明涉及机器学习、图像处理和计算机视觉等领域,特别涉及非负矩阵分解和表征学习技术。

背景技术:

2.全球信息化迅速发展,大数据时代随之到来,非结构化的图像数据量爆发性增长和信息处理需求的增加。图像数据包含着丰富的语义信息可供各领域研究使用,但受到数据分布不均匀且数据结构复杂的影响,难以精准地获取数据中潜在的关系结构和丰富的语义信息。因此,需要针对深入挖掘海量图像数据中丰富的信息来改进传统的数据处理方法,研究一种新方法。

3.聚类是数据挖掘、图像处理和机器学习中的一种重要技术,常以无监督学习或自监督学习的方式进行数据分析。聚类能够将空间中的数据对象分成若干类,其以“人以群分,物以类聚”的思想发现数据内含的模式与特征,有效地解决数据挖掘的众多问题。传统算法非负矩阵分解将数据矩阵分解成两个低秩因子矩阵,实现了数据的低秩表示,并且非负矩阵分解算法相较于传统的一些算法而言,具有实现上的便捷性、分解形式和分解结果上的可解释性,以及占用存储空间少等诸多优点,因此,非负矩阵分解成为数据聚类的基本工具,广泛应用于数据聚类和多视图数据聚类中。

4.但是,传统的非负矩阵分解方法有一些局限性,首先作为一种线性模型很难应用于非线性实例中,另外一个限制在于非负的输入数据,因此发展非负非线性非负矩阵分解时极具挑战性的。此外,深度自动编码器作为一种流行的深度学习技术,被广泛应用于图像处理、自然语言处理等相关领域。因此,利用深度自编码器的网络结构,利用输入数据学习适当的非线性映射函数,实现非线性映射以深度聚类为基础,利用非负矩阵分解提取系统系数,并进行图正则化,提高聚类结果的准确性,是一项值得研究的内容。

5.综上,本发明提出了一种面向图像表示的深度图正则化非负矩阵分解方法,主要考虑利用深度非负矩阵分解来优化特征的学习,提高特征学习和图像聚类。

技术实现要素:

6.本发明提出一种面向图像表示的深度图正则化非负矩阵分解方法,包含以下步骤:

7.步骤1、利用编码器模块,输入数据学习非线性映射函数,将原始输入数据映射到非线性特征空间,学习数据表征;

8.步骤2、利用非负矩阵分解模块将所学的数据表征进行矩阵分解,得到系数矩阵;

9.步骤3、利用解码器模块将重构后的数据表征重新映射回到原始输入空间,对输入数据进行重构;

10.步骤4、采用k-means方法对进行非负矩阵分解后的系数矩阵进行聚类,得到图像聚类结果;

11.步骤5、更新权重,优化整体深度图正则化非负矩阵分解模型;非负矩阵分解模型由编码器模块、非负矩阵分解模块和解码器模块组成;

12.进一步的,给定输入数据矩阵x=[x1,

…

,xn]∈rm×n,包含n个样本,数据矩阵x的每一列都是一个样本向量;

[0013]

步骤1所述的编码器模块利用非线性映射函数en(x),将图像数据x∈rm投射到高维特征空间中,得到向量即即

[0014]

其中非线性映射函数en(x)由一个卷积神经网络组成的编码器网络实现,在这个卷积神经网络中,最后一个卷积层的输出特征图谱被平展成一个矢量;由于非负矩阵分解模块要求输入是非负的,所得到的向量通过激活函数relu来激活

[0015][0016]

其中,relu来保证特性的所有元素都是非负的;

[0017]

进一步的,步骤2所述的非负矩阵分解模块目的是当x映射到时,来提取系数矩阵h∈rd(d《f),并进行图正则化,这里神经网络采用梯度下降法,通过反向传播收敛到局部最优解;

[0018]

通过一个无偏全连接层获得最终提取到的系数矩阵h,同时fc的权重必须由relu激活,激活的权重为v;将系数矩阵h限制在同相同的子空间中,确保h是非负的;h之后是无偏全连接层;此外,这一层的权重必须由relu来激活,来保证训练基矩阵w是非负的,非负矩阵分解模块的输出是重构值非负矩阵分解模块的目标函数loss1具体为:

[0019][0020]

上式中的第一项为耗损函数,以此通过非负矩阵分解模块实现非负矩阵分解算法,其中w≥0,h≥0,最后一项λtr(h

t

lh)为图正则化项,其中λ为正则化参数,tr(

·

)为矩阵的迹,系数矩阵h∈rd(d《f),l为图像的拉普拉斯算子图;

[0021]

进一步的,步骤3所述的解码器模块目的是重新映射回到原始输入空间,为保证重构图像数据与原始图像数据x尽可能一致,使用最小化平方损失函数loss2,对输入数据x进行重构:

[0022][0023]

整个网络的损失函数可以表示为loss=loss1+loss2+ω,其中ω是一些正则化,用来增加隐藏表示的鲁棒性;

[0024]

进一步的,步骤5所述的更新权重是采用随机梯度下降反向传播的方式进行训练,采用adam对网络模型进行训练,使得最大程度的降低损失,生成良好的深层非负矩阵分解网络模型;

[0025]

本发明有益效果如下:

[0026]

根据本发明的方法,可以将输入数据从原始图像空间通过编码器映射到特征空间,并利用非负矩阵模块加强特征提取同时进行图正则化,再利用解码器模块对数据进行重构,最后利用k-means对图像进行聚类,实现了较好的图像聚类结果。

附图说明

[0027]

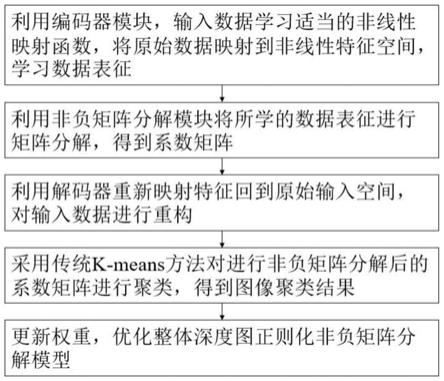

图1面向图像表示的深度图正则化非负矩阵分解方法框架图;

[0028]

图2本发明提出方法的网络结构架构。

具体实施方式

[0029]

下面结合附图对本发明的实施方式做进一步说明。

[0030]

图1为本发明编码器和深度非负矩阵分解的图像聚类方法框架图。首先利用编码器模块,输入数据学习适当的非线性映射函数,将原始数据映射到非线性特征空间,学习数据表征;其次利用非负矩阵分解模块将所学的数据表征进行矩阵分解,得到系数矩阵,同时进行图正则化;另外利用解码器重新映射特征回到原始输入空间,对输入数据进行重构;然后采用传统k-means方法对进行非负矩阵分解后的系数矩阵进行聚类,得到图像聚类结果;最终,更新权重,优化整体深度图正则化非负矩阵分解模型。具体步骤为:

[0031]

步骤1所述的编码器模块利用非线性映射函数en(x),将图像数据x∈rm投射到高维特征空间中,得到向量即即

[0032]

其中非线性映射函数en(x)由一个卷积神经网络组成的编码器网络实现,在这个卷积神经网络中,最后一个卷积层的输出特征图谱被平展成一个矢量;由于非负矩阵分解模块要求输入是非负的,所得到的向量通过激活函数relu来激活

[0033][0034]

其中,relu来保证特性的所有元素都是非负的;因此,从输入数据投影得到的高维特征向量是非负的,可以作为非负矩阵模块的输入。编码器网络结构确定后,可以从输入数据中自动学习映射函数,来实现非线性运算。

[0035]

步骤2、利用非负矩阵分解模块将所学的数据表征进行矩阵分解,得到系数矩阵,并进行图正则化;

[0036]

所述的非负矩阵分解模块目的是当x映射到时,来提取系数特征h∈rd(d《f),非负矩阵模块的两个矩阵w和h一般采用梯度下降法交替迭代求解,这里建立一个神经网络来实现非负矩阵分解算法,神经网络采用梯度下降法,通过反向传播收敛到局部最优解。

[0037]

通过一个无偏全连接层获得最终提取到的系数矩阵h,同时fc的权重必须由relu激活,激活的权重为v;将系数矩阵h限制在同相同的子空间中,确保h是非负的;h之后是无偏全连接层;此外,这一层的权重必须由relu来激活,来保证训练基矩阵w是非负的,非负矩阵分解模块的输出是重构值非负矩阵分解模块的目标函数loss1具体为:

[0038][0039]

上式中的第一项为耗损函数,以此通过非负矩阵分解模块实现非负矩阵分解算法,其中w≥0,h≥0,最后一项λtr(htlh)为图正则化项,其中,λ为正则化参数,tr(

·

)为矩阵的迹,系数矩阵h∈rd(d《f),l为图像的拉普拉斯算子图。

[0040]

步骤3、利用解码器重新映射特征回到原始输入空间,对输入数据进行重构;

[0041]

所述的解码器模块目的是重新映射回到原始输入空间,为保证重构图像数据与原始图像数据x尽可能一致,使用最小化平方损失函数loss2,对输入数据x进行重构:

[0042][0043]

解码器的网络架构和编码器几乎对称,可作为编码器的逆过程,来有效地实现无监督学习。其中,整个网络的损失函数可以表示为loss=loss1+loss2+ω,其中ω是一些正则化,用来增加隐藏表示的鲁棒性。

[0044]

步骤4、采用传统k-means方法对进行非负矩阵分解后的系数矩阵进行聚类,得到图像聚类结果。;

[0045]

步骤5、更新权重,优化整体深度图正则化非负矩阵分解模型;

[0046]

所述的更新权重是采用随机梯度下降反向传播的方式进行训练,采用adam对网络模型进行训练,使得最大程度的降低损失,生成良好的深层非负矩阵分解网络模型。

[0047]

如图2所示为本发明提出方法的网络结构架构。

[0048]

本发明包含编码器模块、非负矩阵分解模块和解码器模块。

[0049]

编码器模块利用非线性映射函数en(x),将图像数据x∈rm投射到高维特征空间f中,得到向量即

[0050]

在编码器模块中使用卷积层,来实现参数共享和更好地提取局部特征。其中,最后一个卷积层的输出特征图谱被平展成一个矢量。同时,所得到的向量可以通过激活函数relu来激活,relu来保证特性的所有元素都是非负的。此外,为了解决消梯度消失的问题和加快收敛速度,在连续的卷积层之间添加batchnorm层。

[0051]

非负矩阵分解模块目的是当x映射到时,来提系数统特征h∈rd(d《f),这里建立一个神经网络来实现非负矩阵分解算法,神经网络采用梯度下降法,通过反向传播收敛到局部最优解。通过一个无偏全连接层(fc)获得最终提取到的系统特征h。同时fc的权重必须由relu激活,激活的权重为v。同时,将h限制在同相同的子空间中,确保h是非负的。h之后是无偏fc层,这一层的权重由relu来激活。此外,设置了d《f,保证非负矩阵分解条件的满足。这里h的维数设置为16。

[0052]

解码器模块目的是重新映射回到原始输入空间,为保证重构图像数据与原始图像数据x尽可能一致,使用最小化平方损失函数loss2,对输入数据x进行重构。解码器的网络架构使用卷积层,来实现参数共享和更好地提取局部特征。同时,解码器的网络架构和编码器几乎对称,可作为编码器的逆过程,来有效地实现无监督学习。此外,为了解决消

梯度消失的问题和加快收敛速度,在连续的卷积层之间添加batchnorm层。

[0053]

根据实验,本发明所提出深度图正则化非负矩阵分解方法和传统非负矩阵聚类方法进行对比,运行20次,得到平均和标准差性能;选择数据集为cmu pie人脸数据集和手写数字数据集进行验证;选择准确率(acc)和归一化互信息(nmi)两个评价指标,其中归一化互信息用来衡量两个随机变量之间的相关程度;手写数字数据集悬着包含28x28像素的3823个手写数字图像;

[0054]

在pie数据集上,传统非负矩阵聚类方法最后得到的聚类准确率为53%左右,归一化互信息为72%左右;所提出深度图正则化非负矩阵分解方法最后得到的聚类准确率为71%左右,归一化互信息为85%;在手写数字数据集上,传统非负矩阵聚类方法最后得到的聚类准确率为65%左右,归一化互信息为61%左右;所提出深度图正则化非负矩阵分解方法最后得到的聚类准确率为83%左右,归一化互信息为85%;结果显示,所提出的深度图正则化非负矩阵分解方法在多个数据集上准确率和归一化互信息都有着更好的表现,因此表明所提出的所提出的深度图正则化非负矩阵分解方法可以学习到更好的特征表示;

[0055]

以上所述,仅为本发明的具体实施方式之一,但本发明的实施方式并不受上述实例的限制。任何未背离本发明原理下所作的改变、修饰,可理解想到的变换或者替换,均应为等效的置换方式,都包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1