虚拟场景的交互方法及装置、存储介质、电子装置与流程

1.本发明涉及计算机技术领域,具体而言,涉及一种虚拟场景的交互方法及装置、存储介质、电子装置。

背景技术:

2.相关技术中的社交,如娱乐类社交,婚恋类社交,游戏类社交等,要么是真人线下的形式,要么是采用线上语音房或直播间的真人视频的形式。两者都有很大的限制性,并且在一些场合中,用户的隐私得不到保护,这种社交形式,限制太大,适用的场合太少。

3.针对相关技术中存在的上述问题,目前尚未发现有效的解决方案。

技术实现要素:

4.本发明实施例提供了一种虚拟场景的交互方法及装置、存储介质、电子装置。

5.根据本发明的一个实施例,提供了一种虚拟场景的交互方法,包括:响应第一客户端发送的场景创建指令,创建虚拟场景,并在所述第一客户端上显示所述虚拟场景;接收第二客户端发送的虚拟社交请求,根据所述虚拟社交请求在所述第二客户端上显示所述虚拟场景;通过所述第一客户端采集包括第一对象的第一实景信息,以及通过所述第二客户端采集包括第二对象的第二实景信息;根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色,其中,所述第一虚拟角色对应所述第一对象,所述第二虚拟角色对应所述第二对象;接收所述第一客户端和/或所述第二客户端发送的互动指令,基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画。

6.根据本发明的另一个实施例,提供了一种虚拟场景的交互装置,包括:创建模块,用于响应第一客户端发送的场景创建指令,创建虚拟场景,并在所述第一客户端上显示所述虚拟场景;显示模块,用于接收第二客户端发送的虚拟社交请求,根据所述虚拟社交请求在所述第二客户端上显示所述虚拟场景;采集模块,用于通过所述第一客户端采集包括第一对象的第一实景信息,以及通过所述第二客户端采集包括第二对象的第二实景信息;第一生成模块,用于根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色,其中,所述第一虚拟角色对应所述第一对象,所述第二虚拟角色对应所述第二对象;交互模块,用于接收所述第一客户端和/或所述第二客户端发送的互动指令,基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画。

7.根据本发明的又一个实施例,还提供了一种存储介质,所述存储介质中存储有计算机程序,其中,所述计算机程序被设置为运行时执行上述任一项方法实施例中的步骤。

8.根据本发明的又一个实施例,还提供了一种电子装置,包括存储器和处理器,所述存储器中存储有计算机程序,所述处理器被设置为运行所述计算机程序以执行上述任一项方法实施例中的步骤。

9.通过本发明,响应第一客户端发送的场景创建指令,创建虚拟场景,并在第一客户端上显示虚拟场景;接收第二客户端发送的虚拟社交请求,根据虚拟社交请求在第二客户端上显示虚拟场景;通过第一客户端采集包括第一对象的第一实景信息,以及通过第二客户端采集包括第二对象的第二实景信息;根据第一实景信息和第二实景信息在虚拟场景中分别生成第一虚拟角色和第二虚拟角色,其中,第一虚拟角色对应第一对象,第二虚拟角色对应第二对象;接收第一客户端和/或第二客户端发送的互动指令,基于互动指令在虚拟场景中播放包括第一虚拟角色和/或第二虚拟角色的虚拟动画,通过创建虚拟场景作为线上社交场景,并基于社交请求将虚拟场景显示在第二客户端上,将现实世界中的第一对象和第二对象虚拟成虚拟场景中的虚拟角色并互动,通过虚拟角色的动作同步用户的社交动作,解决了相关技术在线上社交时不能保护用户隐私的技术问题,避免在社交场合中真人出境,保护用户隐私,同时不失社交的仪式感。

附图说明

10.此处所说明的附图用来提供对本发明的进一步理解,构成本技术的一部分,本发明的示意性实施例及其说明用于解释本发明,并不构成对本发明的不当限定。在附图中:

11.图1是本发明实施例的一种虚拟场景的交互服务器的硬件结构框图;

12.图2是根据本发明实施例的一种虚拟场景的交互方法的流程示意图;

13.图3是本发明实施例中虚拟场景的示意图;

14.图4是本发明实施例虚拟演唱会的场景示意图;

15.图5是根据本发明实施例的一种虚拟场景的交互装置的结构框图;

16.图6是本发明实施例的一种电子装置的结构图。

具体实施方式

17.为了使本技术领域的人员更好地理解本技术方案,下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分的实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都应当属于本技术保护的范围。需要说明的是,在不冲突的情况下,本技术中的实施例及实施例中的特征可以相互组合。

18.需要说明的是,本技术的说明书和权利要求书及上述附图中的术语“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。应该理解这样使用的数据在适当情况下可以互换,以便这里描述的本技术的实施例能够以除了在这里图示或描述的那些以外的顺序实施。此外,术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含,例如,包含了一系列步骤或单元的过程、方法、产品或设备不必限于清楚地列出的那些步骤或单元,而是可包括没有清楚地列出的或对于这些过程、方法、产品或设备固有的其它步骤或单元。

19.实施例1

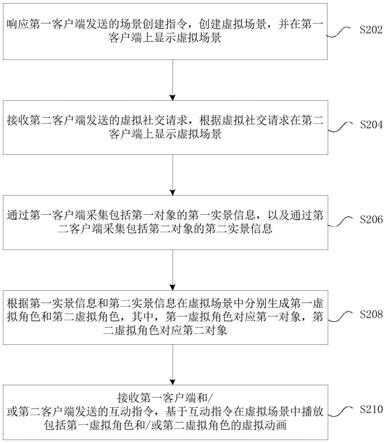

20.本技术实施例一所提供的方法实施例可以在手机、平板、服务器、计算机或者类似的电子终端中执行。以运行在服务器上为例,图1是本发明实施例的一种虚拟场景的交互服

务器的硬件结构框图。如图1所示,服务器可以包括一个或多个(图1中仅示出一个)处理器102(处理器102可以包括但不限于微处理器mcu或可编程逻辑器件fpga等的处理装置)和用于存储数据的存储器104,可选地,上述服务器还可以包括用于通信功能的传输设备106以及输入输出设备108。本领域普通技术人员可以理解,图1所示的结构仅为示意,其并不对上述服务器的结构造成限定。例如,服务器还可包括比图1中所示更多或者更少的组件,或者具有与图1所示不同的配置。

21.存储器104可用于存储服务器程序,例如,应用软件的软件程序以及模块,如本发明实施例中的一种虚拟场景的交互方法对应的服务器程序,处理器102通过运行存储在存储器104内的服务器程序,从而执行各种功能应用以及数据处理,即实现上述的方法。存储器104可包括高速随机存储器,还可包括非易失性存储器,如一个或者多个磁性存储装置、闪存、或者其他非易失性固态存储器。在一些实例中,存储器104可进一步包括相对于处理器102远程设置的存储器,这些远程存储器可以通过网络连接至服务器。上述网络的实例包括但不限于互联网、企业内部网、局域网、移动通信网及其组合。在本实施例中,处理器104用于响应人机交互指令和游戏策略,控制目标虚拟角色执行指定操作以完成游戏任务。存储器104用于存储程序脚本,配置信息,虚拟角色的属性信息等。

22.传输设备106用于经由一个网络接收或者发送数据。上述的网络具体实例可包括服务器的通信供应商提供的无线网络。在一个实例中,传输设备106包括一个网络适配器(network interface controller,简称为nic),其可通过基站与其他网络设备相连从而可与互联网进行通讯。在一个实例中,传输设备106可以为射频(radio frequency,简称为rf)模块,其用于通过无线方式与互联网进行通讯。

23.可选的,输入输出设备108还包括人机交互屏幕用于通过人机交互接口获取人机交互指令,还用于呈现流媒体画面;

24.在本实施例中提供了一种虚拟场景的交互方法,图2是根据本发明实施例的一种虚拟场景的交互方法的流程示意图,如图2所示,该流程包括如下步骤:

25.步骤s202,响应第一客户端发送的场景创建指令,创建虚拟场景,并在第一客户端上显示虚拟场景;

26.步骤s204,接收第二客户端发送的虚拟社交请求,根据虚拟社交请求在第二客户端上显示虚拟场景;

27.可选的,本实施例的虚拟社交请求可以是交友请求,游戏请求等显示世界中人与人之间的社交动作。

28.步骤s206,通过第一客户端采集包括第一对象的第一实景信息,以及通过第二客户端采集包括第二对象的第二实景信息;

29.步骤s208,根据第一实景信息和第二实景信息在虚拟场景中分别生成第一虚拟角色和第二虚拟角色,其中,第一虚拟角色对应第一对象,第二虚拟角色对应第二对象;

30.图3是本发明实施例中虚拟场景的示意图,包括虚拟场景,第一对象对应的第一虚拟角色,第二对象对应的第二虚拟角色。

31.步骤s210,接收第一客户端和/或第二客户端发送的互动指令,基于互动指令在虚拟场景中播放包括第一虚拟角色和/或第二虚拟角色的虚拟动画。

32.可选的,该第一对象或第二对象可以是客户端的摄像头采集画面中的所有用户,

如画面中包括a,b,c三个用户,则用户a,用户b,用户c均是目标用户,渲染生成三个虚拟角色,分别与用户a,用户b,用户c的实时用户体征数据对应。也可以在第一应用程序所在设备的摄像头采集画面中的所有用户中选择或者匹配一个或者多个作为目标对象,如选择人脸画面超过一定尺寸的作为目标用户,如通过人脸识别,将匹配的人脸图像作为目标用户的图像。

33.可选的,本实施例的虚拟场景可以是虚拟社交场景,虚拟游戏场景,虚拟教学场景,虚拟演示场景等,在虚拟场景中包括第一虚拟角色,第一虚拟角色可以通过用户动作实现真人实景同步和控制,并进行交互。

34.本实施例的虚拟场景可以是对真实世界的仿真环境,也可以是半仿真半虚构的虚拟环境,还可以是纯虚构的虚拟环境。虚拟场景可以是二维虚拟场景、2.5维虚拟场景或者三维虚拟场景中的任意一种。

35.可选的,在步骤s210之后,还可以包括步骤s212,第一客户端和/或第二客户端将虚拟场景和虚拟动画的流媒体推出。在一个实例中,从第一客户端将流媒体推出到视频服务器,以使视频服务器将流媒体上传至其他更多的视频播放端。

36.可选的,流媒体用于在视频播放端(如直播终端,电视,视频会议终端,游戏终端,即时通信终端)实时呈现虚拟画面,该虚拟画面中包括该虚拟场景和虚拟动画。

37.通过上述步骤,响应第一客户端发送的场景创建指令,创建虚拟场景,并在第一客户端上显示虚拟场景;接收第二客户端发送的虚拟社交请求,根据虚拟社交请求在第二客户端上显示虚拟场景;通过第一客户端采集包括第一对象的第一实景信息,以及通过第二客户端采集包括第二对象的第二实景信息;根据第一实景信息和第二实景信息在虚拟场景中分别生成第一虚拟角色和第二虚拟角色,其中,第一虚拟角色对应第一对象,第二虚拟角色对应第二对象;接收第一客户端和/或第二客户端发送的互动指令,基于互动指令在虚拟场景中播放包括第一虚拟角色和/或第二虚拟角色的虚拟动画,通过创建虚拟场景作为线上社交场景,并基于社交请求将虚拟场景显示在第二客户端上,将现实世界中的第一对象和第二对象虚拟成虚拟场景中的虚拟角色并互动,通过虚拟角色的动作同步用户的社交动作,解决了相关技术在线上社交时不能保护用户隐私的技术问题,避免在社交场合中真人出境,保护用户隐私,同时不失社交的仪式感。

38.在本实施例的一个实施方式中,根据第一实景信息和第二实景信息在虚拟场景中分别生成第一虚拟角色和第二虚拟角色包括:

39.s11,从第一实景信息中提取第一对象的第一形象特征,从第二实景信息中提取第二对象的第二形象特征;

40.其中,形象特征包括脸部特征,身材特征等,在一些示例中,在提取到第一形象特征和第二形象特征,还需要采用噪声特征混合该第一形象特征和第二形象特征,从而更新原始的第一形象特征和第二形象特征,从而保护用户隐私,防止用户特征在虚拟角色上全部还原。

41.s12,采用第一形象特征生成第一预设骨骼模型的第一纹理贴图,得到第一虚拟角色,采用第二形象特征生成第二预设骨骼模型的第二纹理贴图,得到第二虚拟角色;

42.可选的,还可以基于身材特征等数据预先生成第一预设骨骼模型和第二预设骨骼模型。

43.s13,从第一实景信息中提取第一对象的第一动作特征,从第二实景信息中提取第二对象的第二动作特征;

44.可选的,该第一动作特征和第二动作特征可以包括肢体动作,口型,表情,声音,手势等连续的动态特征。

45.s14,采用第一动作特征生成第一预设骨骼模型的第一动作参数,采用第二动作特征生成第二预设骨骼模型的第二动作参数;

46.在一个示例中,第一动作特征为声波频谱,采用第一动作特征生成第一预设骨骼模型的第一动作参数包括:根据声波频谱的分布曲线解析声波频谱对应的语气类型;在预设动作库中查找与语气类型匹配的目标动作,其中,预设动作库包括多个语气动作,每个语气动作对应一套动作参数;将目标动作的动作参数确定为第一预设骨骼模型的第一动作参数。

47.在该只能采集语音的示例中,还可以基于语音中的语气等特征,映射生成虚拟角色的响应动作(如疑问句映射成摊手动作,肯定句映射成抱胸动作,反问句映射成冷笑动作等)。在只能采集视频(不能采集语音)的场景中,基于视频中的口型等特征,映射生成语音。

48.可选的,将目标动作的动作参数确定为第一预设骨骼模型的第一动作参数包括:将目标动作的以下动作参数确定为第一预设骨骼模型的第一动作参数:起始形态,终止形态,从起始形态到终止形态的形变类型,从起始形态到终止形态的移动方向,从起始形态到终止形态的移动距离。

49.在确定起始形态,终止形态,以及起始形态到终止形态的形变参数之后,就可以得到一套完整的第一动作参数,输入至驱动引擎,即可完成对应的画面渲染和播放。

50.s15,采用第一动作参数和第二动作参数分别控制动画引擎驱动第一虚拟角色和第二虚拟角色,生成第一虚拟角色和第二虚拟角色的动态画面。

51.可选的,本实施例也可以通过物理引擎来驱动。

52.在本实施例的一个实施方式中,在根据第一实景信息和第二实景信息在虚拟场景中分别生成第一虚拟角色和第二虚拟角色之后,方法还包括:解析登录在第一客户端上的第一社交账号的第一账号类型,解析登录在第二客户端上的第二社交账号的第二账号类型;和/或,读取第一虚拟角色的第一角色类型,读取第二虚拟角色的第二角色类型;根据第一账号类型和/或第一角色类型为第一虚拟角色分配第一互动权限,根据第二账号类型和/或第二角色类型为第二虚拟角色分配第二互动权限。

53.在另外一些场景中,虚拟环境中包括主播和访客两种类型的虚拟角色,主播可以创建虚拟世界的虚拟场景,系统为其分配虚拟场景的所有操作权限,访客具备部分权限。可选的,用户可以通过编辑器制作多个场景,或者场景元素,道具等,主播在搭建自己的虚拟场景时,可以购买或者直接采用已经编辑好的场景元素。在一些示例中,有些虚拟角色只能是创建虚拟场景的客户端选择,有些可以是加入虚拟场景或者是游客所在的客户端选择,所以,从角色配置信息中读取虚拟角色的角色类型等属性信息,也可以分配互动权限。可选的,在用户使用特定道具或者用户账号的等级较高时,对应虚拟角色的角色类型属性也会提供,获得的互动权限也会增加。

54.在本实施例的一个应用场景中,应用在演唱会场景,接收第二客户端发送的互动指令,基于互动指令在虚拟场景中播放包括第一虚拟角色和/或第二虚拟角色的虚拟动画

包括:接收第二客户端发送的针对第一虚拟角色的第一互动指令,其中,第一互动指令携带用于指示互动类型的标识信息;查找与标识信息匹配的互动道具,生成包括第一虚拟角色,第二虚拟角色和互动道具的第一虚拟动画,并在第一虚拟场景中播放第一虚拟动画。图4是本发明实施例虚拟演唱会的场景示意图,包括第一虚拟角色,第二虚拟角色和互动道具的第一虚拟动画。

55.在一些示例中,在接收第二客户端发送的针对第一虚拟角色的第一互动指令之前,还包括:接收第二客户端发送的指定虚拟道具的激活指令;响应激活指令,为第二虚拟角色分配与第一虚拟角色之间的互动权限。

56.在虚拟社交的环境中,还可以使用虚拟道具等,使用虚拟道具在虚拟场环境中进行交互,可选的,该虚拟道具可以是一种付费的或者是需要特定权限才能激活的功能。

57.在一个虚拟演唱会的场景中,主播搭建演唱会的虚拟场景,自己的第一虚拟角色在舞台上进行表演,场内还包括与每个观众对应的第二虚拟角色,第一虚拟角色选择台下的某些第二虚拟角色,或者第二虚拟角色激活某些道具后,获得与第一虚拟角色交互的权限,第二虚拟角色可以在虚拟演唱会上与第一虚拟角色交互,包括上台献花,合唱,鼓掌,拥抱等,通过播放虚拟动画来呈现。

58.在本实施例的另一个应用场景中,应用在剧本杀等现实游戏中,接收第一客户端和/或第二客户端发送的互动指令,基于互动指令在虚拟场景中播放包括第一虚拟角色和/或第二虚拟角色的虚拟动画包括:接收第一客户端发送的第二互动指令,接收第二客户端发送的第三互动指令;基于第二互动指令为第一虚拟角色配置第一角色属性,基于第三互动指令为第二虚拟角色配置第二角色属性,其中,第一角色属性和第二角色属性分别用于表征第一虚拟角色和第二虚拟角色在第二虚拟场景中的扮演的玩家控制角色(pcc,player-controlled character)类型;接收第一客户端发送的第四互动指令,在第二虚拟场景中播放与第四互动指令对应的互动画面,或,接收第二客户端发送的第五互动指令,在第二虚拟场景中播放与第五互动指令对应的互动画面。

59.基于上述应用场景,在第二虚拟场景中播放与第四互动指令对应的互动画面包括:基于第四互动指令生成包括第一虚拟角色和指定虚拟元素的第二虚拟动画,其中,第四互动指令用于指示第一虚拟角色与第二虚拟场景中的以下指定虚拟元素至少之一进行交互:除第一虚拟角色之外的其他虚拟角色,第二虚拟场景中的场景元素,第二虚拟场景中的非玩家角色(npc,non-player-controlled character);将第二虚拟动画确定为互动画面的主体画面;通过第一客户端采集第一输入信息,以及通过第二客户端采集第二输入信息,其中,第一输入信息包括第一对象的第一表情和第一音频,第二输入信息包括第二对象的第二表情和第二音频;根据第一输入信息和第二输入信息分别同步控制第一虚拟角色和第二虚拟角色在第二虚拟场景中的表情和声音,并控制虚拟摄像机在第二虚拟场景中采集第一虚拟角色和第二虚拟角色的虚拟画面,将虚拟画面确定为互动画面的背景画面。

60.在剧本杀的应用场景下,可以由主播/主持人用户创建剧本杀的虚拟场景,并要求多个其他玩家参与进来,主播与多个其他玩家进入到服务器所提供的剧情副本中,进行剧本杀游戏。在剧本杀游戏过程中,主播和其他玩家的设备都可以实时采集用户的面部表情,以及实时采集用户的语音,由此在剧情副本中,控制主播对应的虚拟角色和其他玩家对应的虚拟角色的面部表情和声音;虚拟角色之间,虚拟角色和场景之间,以及虚拟角色和场景

中的npc之间均可以进行交互;系统提供数据分析功能,可以把玩家剧本杀过程中的视频剪辑后提供给玩家,把其他玩家的发言、评论、标记等作为虚拟场景的场景元素添加进去并呈现在我方视角。

61.在本实施例的一个示例中,根据虚拟社交请求在第二客户端上显示虚拟场景包括:向第二客户端发送身份评估请求,其中,身份评估请求用于请求评估第二对象是否符合预定条件;接收第二客户端基于身份评估请求返回的身份评估内容;基于身份评估内容计算第二对象与第一对象之间的匹配值;若第二对象与第一对象之间的匹配值大于预设值,根据虚拟社交请求在第二客户端上显示虚拟场景。

62.虚拟场景中增加交互之前的身份评估流程,例如游戏、测试、问卷、运动动作、唱歌才艺展示等,为后续交友的评估,提供评估匹配的依据,如让第二客户端的用户录一段歌,在线填一份问卷等;这种交互内容是会给出具体分析的结果,为用户评估是否进行社交接入做出判断,或者服务器自动判定,自动筛选和过滤匹配率过低的社交请求。

63.可选的,在基于互动指令在虚拟场景中播放包括第一虚拟角色和/或第二虚拟角色的虚拟动画之前,还包括:采集多段虚拟动画;按照互动指令对多段虚拟动画进行分类;采用键值对在素材库中存储互动指令和多段虚拟动画,其中,键为互动指令,值为虚拟动画。

64.在一个示例中,通过第一客户端采集包括第一对象的第一实景信息包括:通过第一客户端采集源实景图像,其中,源实景图像包括背景图像和/或人脸图像;对源实景图像进行对象识别,并提取指定对象的第一实景信息,其中,指定对象是允许被渲染成虚拟物或虚拟人的对象。

65.可以通过ar(增强现实,augmented reality)组件采集实景图像,手机中ar相关sdk获取到手机摄像头中的背景图像数据分析,人脸图像识别分析,进行ai计算后,识别出可能可以在图像上加载的ar虚拟物或道具,从而采用识别出的对象并与对方的虚拟人进行虚拟交互(类似于游戏的实时计算虚拟人之间的物理碰撞和动画生成),对方可以操控自己的虚拟角色进行与ar虚拟道具之间的互动,完成社交互动。

66.可选的,在根据第一实景信息和第二实景信息在虚拟场景中分别生成第一虚拟角色和第二虚拟角色之后,还包括:获取第一虚拟角色的第一角色属性信息和第二虚拟角色的第二角色属性信息;以第一角色属性信息和第二角色属性信息为搜索关键字分别生成第一虚拟角色和第二虚拟角色的搜索建议信息;接收第三客户端的搜索请求,向第三客户端返回第一虚拟角色或第二虚拟角色,其中,搜索请求携带第一角色属性信息或第二角色属性信息的属性字段。

67.本实施例在创建生成第一虚拟角色和第二虚拟角色之后,针对社交客户端发起的虚拟人或其构建虚拟物的搜索请求,可以给出搜索关键字建议(因为平台方构建的物件,平台方肯定知道其属性,可依据其属性信息形成搜索关键字等建议),然后在发起搜索请求后呈现匹配的虚拟角色。

68.通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到根据上述实施例的方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下前者是更佳的实施方式。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储

介质(如rom/ram、磁碟、光盘)中,包括若干指令用以使得一台终端设备(可以是手机,计算机,服务器,或者网络设备等)执行本发明各个实施例所述的方法。

69.实施例2

70.在本实施例中还提供了一种虚拟场景的交互装置,用于实现上述实施例及优选实施方式,已经进行过说明的不再赘述。如以下所使用的,术语“模块”可以实现预定功能的软件和/或硬件的组合。尽管以下实施例所描述的装置较佳地以软件来实现,但是硬件,或者软件和硬件的组合的实现也是可能并被构想的。

71.图5是根据本发明实施例的一种虚拟场景的交互装置的结构框图,如图5所示,该装置包括:创建模块50,显示模块52,采集模块54,第一生成模块56,交互模块58,其中,

72.创建模块50,用于响应第一客户端发送的场景创建指令,创建虚拟场景,并在所述第一客户端上显示所述虚拟场景;

73.显示模块52,用于接收第二客户端发送的虚拟社交请求,根据所述虚拟社交请求在所述第二客户端上显示所述虚拟场景;

74.采集模块54,用于通过所述第一客户端采集包括第一对象的第一实景信息,以及通过所述第二客户端采集包括第二对象的第二实景信息;

75.第一生成模块56,用于根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色,其中,所述第一虚拟角色对应所述第一对象,所述第二虚拟角色对应所述第二对象;

76.交互模块58,用于接收所述第一客户端和/或所述第二客户端发送的互动指令,基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画。

77.可选的,所述第一生成模块包括:第一提取单元,用于从所述第一实景信息中提取所述第一对象的第一形象特征,从所述第二实景信息中提取所述第二对象的第二形象特征;第一生成单元,用于采用所述第一形象特征生成第一预设骨骼模型的第一纹理贴图,得到第一虚拟角色,采用所述第二形象特征生成第二预设骨骼模型的第二纹理贴图,得到第二虚拟角色;第二提取单元,用于从所述第一实景信息中提取所述第一对象的第一动作特征,从所述第二实景信息中提取所述第二对象的第二动作特征;第二生成单元,用于采用所述第一动作特征生成所述第一预设骨骼模型的第一动作参数,采用所述第二动作特征生成所述第二预设骨骼模型的第二动作参数;第三生成单元,用于采用所述第一动作参数和所述第二动作参数分别控制动画引擎驱动所述第一虚拟角色和所述第二虚拟角色,生成所述第一虚拟角色和所述第二虚拟角色的动态画面。

78.可选的,所述第一动作特征为声波频谱,所述第二生成单元包括:解析子单元,用于根据所述声波频谱的分布曲线解析所述声波频谱对应的语气类型;查找子单元,用于在预设动作库中查找与所述语气类型匹配的目标动作,其中,所述预设动作库包括多个语气动作,每个语气动作对应一套动作参数;确定子单元,用于将所述目标动作的动作参数确定为所述第一预设骨骼模型的第一动作参数。

79.可选的,所述确定子单元还用于:将所述目标动作的以下动作参数确定为所述第一预设骨骼模型的第一动作参数:起始形态,终止形态,从所述起始形态到所述终止形态的形变类型,从所述起始形态到所述终止形态的移动方向,从所述起始形态到所述终止形态

的移动距离。

80.可选的,所述装置还包括:解析模块,用于在所述第一生成模块根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色之后,解析登录在所述第一客户端上的第一社交账号的第一账号类型,解析登录在所述第二客户端上的第二社交账号的第二账号类型;和/或,读取所述第一虚拟角色的第一角色类型,读取所述第二虚拟角色的第二角色类型;分配模块,用于根据所述第一账号类型和/或所述第一角色类型为所述第一虚拟角色分配第一互动权限,根据所述第二账号类型和/或所述第二角色类型为所述第二虚拟角色分配第二互动权限。

81.可选的,所述交互模块包括:第一接收单元,用于接收所述第二客户端发送的针对所述第一虚拟角色的第一互动指令,其中,所述第一互动指令携带用于指示互动类型的标识信息;第一播放单元,用于查找与所述标识信息匹配的互动道具,生成包括所述第一虚拟角色,所述第二虚拟角色和所述互动道具的第一虚拟动画,并在第一虚拟场景中播放所述第一虚拟动画。

82.可选的,所述交互模块还包括:第二接收单元,用于在所述第一接收单元接收所述第二客户端发送的针对所述第一虚拟角色的第一互动指令之前,接收所述第二客户端发送的指定虚拟道具的激活指令;分配单元,用于响应所述激活指令,为所述第二虚拟角色分配与所述第一虚拟角色之间的互动权限。

83.可选的,所述交互模块包括:第三接收单元,用于接收所述第一客户端发送的第二互动指令,接收所述第二客户端发送的第三互动指令;配置单元,用于基于所述第二互动指令为所述第一虚拟角色配置第一角色属性,基于所述第三互动指令为所述第二虚拟角色配置第二角色属性,其中,所述第一角色属性和所述第二角色属性分别用于表征所述第一虚拟角色和所述第二虚拟角色在第二虚拟场景中的扮演的玩家控制角色pcc类型;第二播放单元,用于接收所述第一客户端发送的第四互动指令,在第二虚拟场景中播放与所述第四互动指令对应的互动画面,或,接收所述第二客户端发送的第五互动指令,在第二虚拟场景中播放与所述第五互动指令对应的互动画面。

84.可选的,所述第二播放单元包括:生成子单元,用于基于所述第四互动指令生成包括所述第一虚拟角色和指定虚拟元素的第二虚拟动画,其中,所述第四互动指令用于指示所述第一虚拟角色与所述第二虚拟场景中的以下所述指定虚拟元素至少之一进行交互:除所述第一虚拟角色之外的其他虚拟角色,所述第二虚拟场景中的场景元素,所述第二虚拟场景中的非玩家角色npc;确定子单元,用于将所述第二虚拟动画确定为互动画面的主体画面;采集子单元,用于通过所述第一客户端采集第一输入信息,以及通过所述第二客户端采集第二输入信息,其中,所述第一输入信息包括所述第一对象的第一表情和第一音频,所述第二输入信息包括所述第二对象的第二表情和第二音频;控制子单元,用于根据所述第一输入信息和所述第二输入信息分别同步控制所述第一虚拟角色和所述第二虚拟角色在第二虚拟场景中的表情和声音,并控制虚拟摄像机在所述第二虚拟场景中采集第一虚拟角色和所述第二虚拟角色的虚拟画面,将所述虚拟画面确定为所述互动画面的背景画面。

85.可选的,所述显示模块包括:发送单元,用于向所述第二客户端发送身份评估请求,其中,所述身份评估请求用于请求评估所述第二对象是否符合预定条件;接收单元,用于接收所述第二客户端基于所述身份评估请求返回的身份评估内容;计算单元,用于基于

所述身份评估内容计算所述第二对象与所述第一对象之间的匹配值;显示单元,用于若所述第二对象与所述第一对象之间的匹配值大于预设值,根据所述虚拟社交请求在所述第二客户端上显示所述虚拟场景。

86.可选的,所述装置还包括:采集模块,用于在所述交互模块基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画之前,采集多段虚拟动画;分类模块,用于按照互动指令对所述多段虚拟动画进行分类;存储模块,用于采用键值对在素材库中存储所述互动指令和所述多段虚拟动画,其中,键为所述互动指令,值为所述虚拟动画。

87.可选的,所述采集模块包括:采集单元,用于通过所述第一客户端采集源实景图像,其中,所述源实景图像包括背景图像和/或人脸图像;提取单元,用于对所述源实景图像进行对象识别,并提取指定对象的第一实景信息,其中,所述指定对象是允许被渲染成虚拟物或虚拟人的对象。

88.可选的,所述装置还包括:获取模块,用于在所述第一生成模块根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色之后,获取所述第一虚拟角色的第一角色属性信息和所述第二虚拟角色的第二角色属性信息;第二生成模块,用于以所述第一角色属性信息和所述第二角色属性信息为搜索关键字分别生成所述第一虚拟角色和所述第二虚拟角色的搜索建议信息;搜索模块,用于接收第三客户端的搜索请求,向所述第三客户端返回所述第一虚拟角色或所述第二虚拟角色,其中,所述搜索请求携带所述第一角色属性信息或所述第二角色属性信息的属性字段。

89.需要说明的是,上述各个模块是可以通过软件或硬件来实现的,对于后者,可以通过以下方式实现,但不限于此:上述模块均位于同一处理器中;或者,上述各个模块以任意组合的形式分别位于不同的处理器中。

90.实施例3

91.本技术实施例还提供了一种电子装置,图6是本发明实施例的一种电子装置的结构图,如图6所示,包括处理器61、通信接口62、存储器63和通信总线64,其中,处理器61,通信接口62,存储器63通过通信总线64完成相互间的通信,存储器63,用于存放计算机程序;

92.处理器61,用于执行存储器63上所存放的程序时,实现如下步骤:响应第一客户端发送的场景创建指令,创建虚拟场景,并在所述第一客户端上显示所述虚拟场景;接收第二客户端发送的虚拟社交请求,根据所述虚拟社交请求在所述第二客户端上显示所述虚拟场景;通过所述第一客户端采集包括第一对象的第一实景信息,以及通过所述第二客户端采集包括第二对象的第二实景信息;根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色,其中,所述第一虚拟角色对应所述第一对象,所述第二虚拟角色对应所述第二对象;接收所述第一客户端和/或所述第二客户端发送的互动指令,基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画。

93.可选的,根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色包括:从所述第一实景信息中提取所述第一对象的第一形象特征,从所述第二实景信息中提取所述第二对象的第二形象特征;采用所述第一形象特征生成第一预设骨骼模型的第一纹理贴图,得到第一虚拟角色,采用所述第二形象特征生成

第二预设骨骼模型的第二纹理贴图,得到第二虚拟角色;从所述第一实景信息中提取所述第一对象的第一动作特征,从所述第二实景信息中提取所述第二对象的第二动作特征;采用所述第一动作特征生成所述第一预设骨骼模型的第一动作参数,采用所述第二动作特征生成所述第二预设骨骼模型的第二动作参数;采用所述第一动作参数和所述第二动作参数分别控制动画引擎驱动所述第一虚拟角色和所述第二虚拟角色,生成所述第一虚拟角色和所述第二虚拟角色的动态画面。

94.可选的,所述第一动作特征为声波频谱,采用所述第一动作特征生成所述第一预设骨骼模型的第一动作参数包括:根据所述声波频谱的分布曲线解析所述声波频谱对应的语气类型;在预设动作库中查找与所述语气类型匹配的目标动作,其中,所述预设动作库包括多个语气动作,每个语气动作对应一套动作参数;将所述目标动作的动作参数确定为所述第一预设骨骼模型的第一动作参数。

95.可选的,将所述目标动作的动作参数确定为所述第一预设骨骼模型的第一动作参数包括:将所述目标动作的以下动作参数确定为所述第一预设骨骼模型的第一动作参数:起始形态,终止形态,从所述起始形态到所述终止形态的形变类型,从所述起始形态到所述终止形态的移动方向,从所述起始形态到所述终止形态的移动距离。

96.可选的,在根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色之后,所述方法还包括:解析登录在所述第一客户端上的第一社交账号的第一账号类型,解析登录在所述第二客户端上的第二社交账号的第二账号类型;和/或,读取所述第一虚拟角色的第一角色类型,读取所述第二虚拟角色的第二角色类型;根据所述第一账号类型和/或所述第一角色类型为所述第一虚拟角色分配第一互动权限,根据所述第二账号类型和/或所述第二角色类型为所述第二虚拟角色分配第二互动权限。

97.可选的,接收所述第二客户端发送的互动指令,基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画包括:接收所述第二客户端发送的针对所述第一虚拟角色的第一互动指令,其中,所述第一互动指令携带用于指示互动类型的标识信息;查找与所述标识信息匹配的互动道具,生成包括所述第一虚拟角色,所述第二虚拟角色和所述互动道具的第一虚拟动画,并在第一虚拟场景中播放所述第一虚拟动画。

98.可选的,在接收所述第二客户端发送的针对所述第一虚拟角色的第一互动指令之前,所述方法还包括:接收所述第二客户端发送的指定虚拟道具的激活指令;响应所述激活指令,为所述第二虚拟角色分配与所述第一虚拟角色之间的互动权限。

99.可选的,接收所述第一客户端和/或所述第二客户端发送的互动指令,基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画包括:接收所述第一客户端发送的第二互动指令,接收所述第二客户端发送的第三互动指令;基于所述第二互动指令为所述第一虚拟角色配置第一角色属性,基于所述第三互动指令为所述第二虚拟角色配置第二角色属性,其中,所述第一角色属性和所述第二角色属性分别用于表征所述第一虚拟角色和所述第二虚拟角色在第二虚拟场景中的扮演的玩家控制角色pcc类型;接收所述第一客户端发送的第四互动指令,在第二虚拟场景中播放与所述第四互动指令对应的互动画面,或,接收所述第二客户端发送的第五互动指令,在第二虚拟

场景中播放与所述第五互动指令对应的互动画面。

100.可选的,在第二虚拟场景中播放与所述第四互动指令对应的互动画面包括:基于所述第四互动指令生成包括所述第一虚拟角色和指定虚拟元素的第二虚拟动画,其中,所述第四互动指令用于指示所述第一虚拟角色与所述第二虚拟场景中的以下所述指定虚拟元素至少之一进行交互:除所述第一虚拟角色之外的其他虚拟角色,所述第二虚拟场景中的场景元素,所述第二虚拟场景中的非玩家角色npc;将所述第二虚拟动画确定为互动画面的主体画面;通过所述第一客户端采集第一输入信息,以及通过所述第二客户端采集第二输入信息,其中,所述第一输入信息包括所述第一对象的第一表情和第一音频,所述第二输入信息包括所述第二对象的第二表情和第二音频;根据所述第一输入信息和所述第二输入信息分别同步控制所述第一虚拟角色和所述第二虚拟角色在第二虚拟场景中的表情和声音,并控制虚拟摄像机在所述第二虚拟场景中采集第一虚拟角色和所述第二虚拟角色的虚拟画面,将所述虚拟画面确定为所述互动画面的背景画面。

101.可选的,根据所述虚拟社交请求在所述第二客户端上显示所述虚拟场景包括:向所述第二客户端发送身份评估请求,其中,所述身份评估请求用于请求评估所述第二对象是否符合预定条件;接收所述第二客户端基于所述身份评估请求返回的身份评估内容;基于所述身份评估内容计算所述第二对象与所述第一对象之间的匹配值;若所述第二对象与所述第一对象之间的匹配值大于预设值,根据所述虚拟社交请求在所述第二客户端上显示所述虚拟场景。

102.可选的,在基于所述互动指令在所述虚拟场景中播放包括所述第一虚拟角色和/或所述第二虚拟角色的虚拟动画之前,所述方法还包括:采集多段虚拟动画;按照互动指令对所述多段虚拟动画进行分类;采用键值对在素材库中存储所述互动指令和所述多段虚拟动画,其中,键为所述互动指令,值为所述虚拟动画。

103.可选的,通过所述第一客户端采集包括第一对象的第一实景信息包括:通过所述第一客户端采集源实景图像,其中,所述源实景图像包括背景图像和/或人脸图像;对所述源实景图像进行对象识别,并提取指定对象的第一实景信息,其中,所述指定对象是允许被渲染成虚拟物或虚拟人的对象。

104.可选的,在根据所述第一实景信息和所述第二实景信息在所述虚拟场景中分别生成第一虚拟角色和第二虚拟角色之后,所述方法还包括:获取所述第一虚拟角色的第一角色属性信息和所述第二虚拟角色的第二角色属性信息;以所述第一角色属性信息和所述第二角色属性信息为搜索关键字分别生成所述第一虚拟角色和所述第二虚拟角色的搜索建议信息;接收第三客户端的搜索请求,向所述第三客户端返回所述第一虚拟角色或所述第二虚拟角色,其中,所述搜索请求携带所述第一角色属性信息或所述第二角色属性信息的属性字段。

105.上述终端提到的通信总线可以是外设部件互连标准(peripheral component interconnect,简称pci)总线或扩展工业标准结构(extended industry standard architecture,简称eisa)总线等。该通信总线可以分为地址总线、数据总线、控制总线等。为便于表示,图中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

106.通信接口用于上述终端与其他设备之间的通信。

107.存储器可以包括随机存取存储器(random access memory,简称ram),也可以包括

非易失性存储器(non-volatile memory),例如至少一个磁盘存储器。可选的,存储器还可以是至少一个位于远离前述处理器的存储装置。

108.上述的处理器可以是通用处理器,包括中央处理器(central processing unit,简称cpu)、网络处理器(network processor,简称np)等;还可以是数字信号处理器(digital signal processing,简称dsp)、专用集成电路(application specific integrated circuit,简称asic)、现场可编程门阵列(field-programmable gate array,简称fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。

109.在本技术提供的又一实施例中,还提供了一种计算机可读存储介质,该计算机可读存储介质中存储有指令,当其在计算机上运行时,使得计算机执行上述实施例中任一所述的虚拟场景的交互方法。

110.在本技术提供的又一实施例中,还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述实施例中任一所述的虚拟场景的交互方法。

111.在上述实施例中,可以全部或部分地通过软件、硬件、固件或者其任意组合来实现。当使用软件实现时,可以全部或部分地以计算机程序产品的形式实现。所述计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行所述计算机程序指令时,全部或部分地产生按照本技术实施例所述的流程或功能。所述计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。所述计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一个计算机可读存储介质传输,例如,所述计算机指令可以从一个网站站点、计算机、服务器或数据中心通过有线(例如同轴电缆、光纤、数字用户线(dsl))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、服务器或数据中心进行传输。所述计算机可读存储介质可以是计算机能够存取的任何可用介质或者是包含一个或多个可用介质集成的服务器、数据中心等数据存储设备。所述可用介质可以是磁性介质,(例如,软盘、硬盘、磁带)、光介质(例如,dvd)、或者半导体介质(例如固态硬盘solid state disk(ssd))等。

112.上述本技术实施例序号仅仅为了描述,不代表实施例的优劣。

113.在本技术的上述实施例中,对各个实施例的描述都各有侧重,某个实施例中没有详述的部分,可以参见其他实施例的相关描述。

114.在本技术所提供的几个实施例中,应该理解到,所揭露的技术内容,可通过其它的方式实现。其中,以上所描述的装置实施例仅仅是示意性的,例如所述单元的划分,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式,例如多个单元或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。另一点,所显示或讨论的相互之间的耦合或直接耦合或通信连接可以是通过一些接口,单元或模块的间接耦合或通信连接,可以是电性或其它的形式。

115.所述作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部单元来实现本实施例方案的目的。

116.另外,在本技术各个实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以两个或两个以上单元集成在一个单元中。上述集成的单

元既可以采用硬件的形式实现,也可以采用软件功能单元的形式实现。

117.所述集成的单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读取存储介质中。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分或者该技术方案的全部或部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可为个人计算机、服务器或者网络设备等)执行本技术各个实施例所述方法的全部或部分步骤。而前述的存储介质包括:u盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、移动硬盘、磁碟或者光盘等各种可以存储程序代码的介质。

118.以上所述仅是本技术的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本技术原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视为本技术的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1