一种基于深度神经网络的行人追踪监控方法及系统

1.本发明涉及图像处理技术领域,特别是涉及一种基于深度神经网络的行人追踪监控方法及系统。

背景技术:

2.传统方法主要采用卡尔曼滤波算法对行人追踪监控,对不确定性较强的情况会导致行人id跳变问题严重,因此存在追踪监控准确性低的问题。

技术实现要素:

3.本发明的目的是提供一种基于深度神经网络的行人追踪监控方法及系统,以提高追踪监控的准确性。

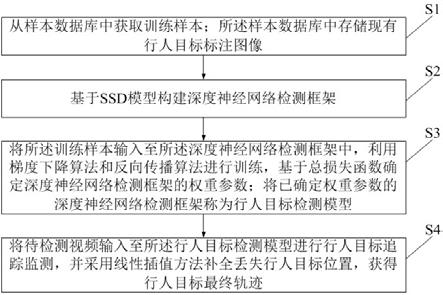

4.为实现上述目的,本发明提供了一种基于深度神经网络的行人追踪监控方法,所述方法包括:步骤s1:从样本数据库中获取训练样本;所述样本数据库中存储有现有行人目标标注图像;步骤s2:基于ssd模型构建深度神经网络检测框架;步骤s3:将所述训练样本输入至所述深度神经网络检测框架中,利用梯度下降算法和反向传播算法进行训练,基于总损失函数确定深度神经网络检测框架的权重参数;将已确定权重参数的深度神经网络检测框架称为行人目标检测模型;步骤s4:将待检测视频输入至所述行人目标检测模型进行行人目标追踪监测,并采用线性插值方法补全丢失行人目标位置,获得行人目标最终轨迹,具体包括:步骤s41:将待检测视频输入至所述行人目标检测模型中进行检测,获得各帧视频图像对应的行人目标初始位置;步骤s42:基于各帧视频图像对应的所述行人目标初始位置对目标框中的行人目标特征信息进行提取,得到行人目标的运动特征和外观特征;步骤s43:根据各帧图像中所有行人目标的运动特征和外观特征进行id匹配,获得id匹配结果以及所有行人目标在不同帧图像中的最终位置;步骤s44:采用线性插值方法将各帧图像中丢失的行人目标最终位置进行插值运算,获得行人目标最终轨迹。

5.可选地,步骤s43具体包括:步骤s431:利用卡尔曼滤波对各帧图像中所有行人目标的运动特征进行预测,获得各检测目标的行人目标运动状态;步骤s432:根据各检测目标的行人目标运动状态计算运动相似度;步骤s433:根据各检测目标的外观特征计算外观相似度;步骤s434:根据所述运动相似度和所述外观相似度计算总相似度;步骤s435:采用匈牙利匹配算法将不同帧图像之间总相似度最大的行人目标进行

id匹配,并输出id匹配结果;步骤s436:判断id匹配结果中是否存在跟踪失败行人目标;如果存在跟踪失败行人目标,则执行“步骤s44”;如果不存在跟踪失败行人目标,则输出所有行人目标在不同帧图像中的最终位置。

6.可选地,根据各检测目标的行人目标运动状态计算运动相似度的具体计算公式为:其中,表示第i个跟踪器检测第j个检测目标的运动相似度,表示第j个检测目标的目标运动状态,表示第i个追踪器的运动状态,表示检测和跟踪的协方差矩阵。

7.可选地,根据各检测目标的外观特征计算外观相似度的具体公式为:其中,表示第i个跟踪器检测第j个检测目标获得的运动特征相似度,表示第j个检测目标的外观特征,表示第k次追踪成功的特征向量集合,表示第i个跟踪器的所有目标外观特征集合。

8.本发明还提供一种基于深度神经网络的行人追踪监控系统,所述系统包括:获取模块,用于从样本数据库中获取训练样本;所述样本数据库中存储有现有行人目标标注图像;检测框架构建模块,用于基于ssd模型构建深度神经网络检测框架;训练模块,用于将所述训练样本输入至所述深度神经网络检测框架中,利用梯度下降算法和反向传播算法进行训练,基于总损失函数确定深度神经网络检测框架的权重参数;将已确定权重参数的深度神经网络检测框架称为行人目标检测模型;追踪监测模块,用于将待检测视频输入至所述行人目标检测模型进行行人目标追踪监测,并采用线性插值方法补全丢失行人目标位置,获得行人目标最终轨迹,具体包括:行人目标初始位置确定单元,用于将待检测视频输入至所述行人目标检测模型中进行检测,获得各帧视频图像对应的行人目标初始位置;特征提取单元,用于基于各帧视频图像对应的所述行人目标初始位置对目标框中的行人目标特征信息进行提取,得到行人目标的运动特征和外观特征;id匹配单元,用于根据各帧图像中所有行人目标的运动特征和外观特征进行id匹配,获得id匹配结果以及所有行人目标在不同帧图像中的最终位置;行人目标最终轨迹确定单元,用于采用线性插值方法将各帧图像中丢失的行人目标最终位置进行插值运算,获得行人目标最终轨迹。

9.可选地,所述id匹配单元具体包括:行人目标运动状态确定子单元,用于利用卡尔曼滤波对各帧图像中所有行人目标的运动特征进行预测,获得各检测目标的行人目标运动状态;

运动相似度计算子单元,用于根据各检测目标的行人目标运动状态计算运动相似度;外观相似度计算子单元,用于根据各检测目标的外观特征计算外观相似度;总相似度计算子单元,用于根据所述运动相似度和所述外观相似度计算总相似度;id匹配子单元,用于采用匈牙利匹配算法将不同帧图像之间总相似度最大的行人目标进行id匹配,并输出id匹配结果;判断子单元,用于判断id匹配结果中是否存在跟踪失败行人目标;如果存在跟踪失败行人目标,则执行“行人目标最终轨迹确定单元”;如果不存在跟踪失败行人目标,则输出所有行人目标在不同帧图像中的最终位置。

10.可选地,根据各检测目标的行人目标运动状态计算运动相似度的具体计算公式为:其中,表示第i个跟踪器检测第j个检测目标的运动相似度,表示第j个检测目标的目标运动状态,表示第i个追踪器的运动状态,表示检测和跟踪的协方差矩阵。

11.可选地,根据各检测目标的外观特征计算外观相似度的具体公式为:其中,表示第i个跟踪器检测第j个检测目标获得的运动特征相似度,表示第j个检测目标的外观特征,表示第k次追踪成功的特征向量集合,表示第i个跟踪器的所有目标外观特征集合。

12.根据本发明提供的具体实施例,本发明公开了以下技术效果:本发明基于ssd模型构建深度神经网络检测框架,并将已确定权重参数的深度神经网络检测框架称为行人目标检测模型,将待检测视频输入至所述行人目标检测模型进行行人目标追踪监测,并采用线性插值方法补全丢失行人目标位置,获得行人目标最终轨迹。本发明针对遮挡难以被检测到行人目标时,充分利用视频目标在多帧中的位置信息,采用线性插值算法补全目标的轨迹信息,进而提高了追踪监控的准确性。

附图说明

13.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

14.图1为本发明基于深度神经网络的行人追踪监控方法流程图;图2为本发明深度神经网络检测框架示意图;图3为本发明基于深度神经网络的行人追踪监控系统结构图。

具体实施方式

15.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

16.本发明的目的是提供一种基于深度神经网络的行人追踪监控方法及系统,以提高追踪监控的准确性。

17.为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

18.深度神经网络是近年来人工智能领域中非常热门的研究方向,其应用方向包括目标检测与跟踪、语音识别和推荐算法等。其中深度卷积神经网络被广泛应用于目标检测与跟踪领域。深度卷积神经网络有两个特点:(1)空间不变性。深度卷积神经网络在将原图映射为特征图的同时,尺寸发生变化,但不影响目标在图像上的位置。(2)权值共享。深度卷积神经网络通过卷积核在多层的通道上图像对应位置进行特征提取,每层通道中的卷积核的权值是相同的,与全连接神经网络相比,参数量大大减少。本发明主要利用深度神经网络对行人追踪进行监控,具体监控过程如下:实施例1如图1所示,本发明公开一种基于深度神经网络的行人追踪监控方法,所述方法包括:步骤s1:从样本数据库中获取训练样本;所述样本数据库中存储有现有行人目标标注图像。

19.步骤s2:基于ssd模型构建深度神经网络检测框架。

20.步骤s3:将所述训练样本输入至所述深度神经网络检测框架中,利用梯度下降算法和反向传播算法进行训练,基于总损失函数确定深度神经网络检测框架的权重参数;将已确定权重参数的深度神经网络检测框架称为行人目标检测模型。

21.步骤s4:将待检测视频输入至所述行人目标检测模型进行行人目标追踪监测,并采用线性插值方法补全丢失行人目标位置,获得行人目标最终轨迹。

22.下面对各个步骤进行详细论述:步骤s1:从样本数据库中获取训练样本;所述样本数据库中存储有现有行人目标标注图像,具体包括:步骤s11:通过网络爬虫方式获取现有行人目标图像。

23.步骤s12:利用labelimage软件对所述现有行人目标图像进行标注,获得现有行人目标标注图像。

24.步骤s2:基于ssd模型构建深度神经网络检测框架,具体包括:所述深度神经网络检测框架包括主干部分和检测部分,其中,主干部分包括vgg部分和附加部分。深度神经网络检测框架输入的是现有行人目标标注图像,其尺寸为300*300,通道数为3,即300*300*3维度的张量。

25.vgg部分共计包括5个卷积模块,分别为conv1~conv5。conv1包括两个卷积层,每个卷积层通过64个3*3的卷积核提取特征信息,再通过最大池化层进一步将数据尺寸缩减到

150*150;conv2包括两个卷积层,每个卷积层通过128个3*3的卷积核提取特征信息,再通过最大池化层进一步将数据尺寸缩减到75*75;conv3包括三个卷积层,每个卷积层通过256个3*3的卷积核提取特征信息,再通过最大池化层进一步将数据尺寸缩减到38*38;conv4包括三个卷积层,每个卷积层通过512个3*3的卷积核提取特征信息,再通过最大池化层进一步将数据尺寸缩减到19*19;conv5包括三个卷积层,每个卷积层通过512个3*3的卷积核提取特征信息,再通过1*1的最大池化层后尺寸不变。

26.附加部分共计包括6个卷积模块,conv6包含一个卷积层,通过1024个3*3的卷积核提取特征信息;conv7包含一个卷积层,通过1024个1*1的卷积核提取特征信息;conv8包含两个卷积层,第一个卷积层包括256个1*1卷积核,第二个卷积层包括512个3*3的卷积核,第二个卷积层还通过将卷积核步长调成为2把数据尺寸缩减到10*10; conv9包含两个卷积层,第一个卷积层包括128个1*1卷积核,第二个卷积层包括256个3*3的卷积核,第二个卷积层还通过将卷积核步长调成为2把数据尺寸缩减到5*5; conv10包含两个卷积层,第一个卷积层包括128个1*1卷积核,第二个卷积层包括256个3*3的卷积核,第二个卷积层还通过将卷积核步长调成为2把数据尺寸缩减到3*3;conv11包含两个卷积层,第一个卷积层包括128个1*1卷积核,第二个卷积层包括256个3*3的卷积核,第二层的图像尺寸与卷积核尺寸相同,故数据尺寸缩减到1*1。

27.conv4的第二层,conv7的第一层(共一层),conv8的第二层,conv9的第二层,conv10的第二层,conv11的第二层,分别输出尺寸为38*38*512,19*19*1024,10*10*512,5*5*256,3*3*256,1*1*256的特征图进入检测部分。

28.检测部分包括分类和定位两个预测器,每个预测器将六种尺寸的特征图分别送入六个卷积层,将不同尺寸的特征图进行融合,得到融合特征图。

29.步骤s3:将所述训练样本输入至所述深度神经网络检测框架中,利用梯度下降算法和反向传播算法进行训练,基于总损失函数确定深度神经网络检测框架的权重参数。

30.本实施例中,总损失函数包括置信度损失函数和位置损失函数,通过梯度下降算法和反向传播算法训练模型,以寻找差距程度最小的权重参数,优化模型的类别预测精度和位置预测精度。

31.网络的总损失函数为:其中,n表示样本数量,表示置信度损失,表示位置损失,表示平衡系数,表示网络的总损失函数,表示检测框匹配情况,用0,1表示,表示检测物体对应种类的概率;表示预测框的位置参数;表示真实框的位置参数。

32.置信度损失函数为:其中,n表示样本数量,表示第i个检测框与第j个真实框是否匹配,其值为0或

1, p表示类别的编号,表示指第i个检测框预测的种类为p的概率,表示预测结果为背景的概率,pos表示正样本集合,neg表示负样本,表示置信度损失函数。

33.位置损失函数为:其中,n表示样本数量,分别表示检测框的参数与实际框的参数,共包括四个参数,,,;,分别表示中心点坐标;,分别表示框的宽和长;表示第i个检测框与第j个真实框是否匹配,其值为0或1,k表示类别的编号;表示位置损失函数,g(.)表示smooth l1损失函数,其计算方法如下所示:其中,表示需要进行计算的变量。

34.步骤s4:将待检测视频输入至所述行人目标检测模型进行行人目标追踪监测和id匹配,并采用线性插值方法补全丢失的行人目标最终位置,获得行人目标最终轨迹和id匹配结果,具体包括:步骤s41:将待检测视频输入至所述行人目标检测模型中进行检测,获得各帧视频图像对应的行人目标初始位置,具体包括:步骤s411:将待检测视频进行逐帧拆分,获得多帧视频图像。

35.步骤s412:将各帧视频图像输入至所述行人目标检测模型进行卷积操作,获得多张融合特征图。

36.步骤s413:在各所述融合特征图上利用预设尺寸的锚框进行目标的初步检测,获得待识别目标。

37.步骤s414:判断所述待识别目标的类别是否属于行人;如果待识别目标的类别属于行人,则通过回归修正行人目标的位置,获得行人目标初始位置;如果待识别目标的类别不属于行人,则无需处理。

38.步骤s42:基于各帧视频图像对应的所述行人目标初始位置对目标框中的行人目标特征信息进行提取,得到行人目标的运动特征和外观特征。

39.步骤s43:根据各帧图像中所有行人目标的运动特征和外观特征进行id匹配,获得id匹配结果以及所有行人目标在不同帧图像中的最终位置,具体包括:步骤s431:利用卡尔曼滤波对各帧图像中所有行人目标的运动特征进行预测,获得各检测目标的行人目标运动状态。

40.步骤s432:根据各检测目标的行人目标运动状态计算运动相似度,具体公式为:

其中,表示第i个跟踪器检测第j个检测目标的运动相似度,表示第j个检测目标的目标运动状态,表示第i个追踪器的运动状态,表示检测和跟踪的协方差矩阵。

41.步骤s433:根据各检测目标的外观特征计算外观相似度,具体公式为:其中,表示第i个跟踪器检测第j个检测目标获得的运动特征相似度,表示第j个检测目标的外观特征,表示第k次追踪成功的特征向量集合,表示第i个跟踪器的所有目标外观特征集合。

42.步骤s434:根据所述运动相似度和所述外观相似度计算总相似度,具体公式为:其中,表示总相似度,为两种特征的平衡系数。

43.步骤s435:采用匈牙利匹配算法将不同帧图像之间总相似度最大的行人目标进行id匹配,并输出id匹配结果。

44.步骤s436:判断id匹配结果中是否存在跟踪失败行人目标;如果存在跟踪失败行人目标,则执行“步骤s44”;如果不存在跟踪失败行人目标,则输出所有行人目标在不同帧图像中的最终位置。

45.每个行人目标与相邻帧的两种特征总相似度最大(即加权距离最小)即被判断为同一行人目标,说明不存在跟踪失败行人目标,反之则说明存在跟踪失败行人目标。

46.步骤s44:采用线性插值方法将各帧图像中丢失的行人目标最终位置进行插值运算,获得行人目标最终轨迹;具体地,当相邻三帧中只有第一帧和第三帧中出现的行人目标时,采用线性插值方法基于第一帧和第三帧的最终位置进行中间帧位置插值运算,得到最终的行人目标最终轨迹。

47.实施例2如图3所示,本发明还公开一种基于深度神经网络的行人追踪监控系统,所述系统包括:获取模块301,用于从样本数据库中获取训练样本;所述样本数据库中存储有现有行人目标标注图像。

48.检测框架构建模块302,用于基于ssd模型构建深度神经网络检测框架。

49.训练模块303,用于将所述训练样本输入至所述深度神经网络检测框架中,利用梯度下降算法和反向传播算法进行训练,基于总损失函数确定深度神经网络检测框架的权重参数;将已确定权重参数的深度神经网络检测框架称为行人目标检测模型。

50.追踪监测模块304,用于将待检测视频输入至所述行人目标检测模型进行行人目标追踪监测,并采用线性插值方法补全丢失行人目标位置,获得行人目标最终轨迹。

51.作为一种可选的实施方式,本发明所述追踪监测模块304具体包括:行人目标初始位置确定单元,用于将待检测视频输入至所述行人目标检测模型中进行检测,获得各帧视频图像对应的行人目标初始位置。

52.特征提取单元,用于基于各帧视频图像对应的所述行人目标初始位置对目标框中的行人目标特征信息进行提取,得到行人目标的运动特征和外观特征。

53.id匹配单元,用于根据各帧图像中所有行人目标的运动特征和外观特征进行id匹配,获得id匹配结果以及所有行人目标在不同帧图像中的最终位置。

54.行人目标最终轨迹确定单元,用于采用线性插值方法将各帧图像中丢失的行人目标最终位置进行插值运算,获得行人目标最终轨迹。

55.作为一种可选的实施方式,本发明所述id匹配单元具体包括:行人目标运动状态确定子单元,用于利用卡尔曼滤波对各帧图像中所有行人目标的运动特征进行预测,获得各检测目标的行人目标运动状态。

56.运动相似度计算子单元,用于根据各检测目标的行人目标运动状态计算运动相似度。

57.外观相似度计算子单元,用于根据各检测目标的外观特征计算外观相似度。

58.总相似度计算子单元,用于根据所述运动相似度和所述外观相似度计算总相似度。

59.id匹配子单元,用于采用匈牙利匹配算法将不同帧图像之间总相似度最大的行人目标进行id匹配,并输出id匹配结果。

60.判断子单元,用于判断id匹配结果中是否存在跟踪失败行人目标;如果存在跟踪失败行人目标,则执行“行人目标最终轨迹确定单元”;如果不存在跟踪失败行人目标,则输出所有行人目标在不同帧图像中的最终位置。

61.本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

62.本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1