残差连接的轻量型去噪网络来提高对抗鲁棒性的方法

1.本发明属于深度神经网络模型的对抗防御技术领域,尤其涉及残差连接的轻量型去噪网络来提高对抗鲁棒性的方法。

背景技术:

2.凭借出色的性能,深度神经网络在人脸识别、自动驾驶、图像分类等领域得到了广泛发展,也取得了令人赞叹的成就,极大地促进了深度神经网络的发展。与此同时,由于深度神经网络的非线性和不可解释性,深度神经网络又产生了新的事物,即对抗样本,对抗样本是由在样本中添加微弱的、难以察觉的扰动产生的,人眼对于对抗样本的观察几乎不受影响,可以轻松辨别其真实类别。深度神经网络却对对抗样本表现出极大的脆弱性,对其识别准确率会大幅度地降低,由此带来的不利影响也会阻碍深度神经网络在其它领域的广泛发展。

3.对于对抗样本的防御方法可分为,(1)修改数据:包括对抗训练、梯度隐藏、数据压缩、以及数据随机化等;(2)修改模型:包括模型正则化、防御性蒸馏、特征压缩、特征去噪等。对于对抗防御,对抗训练是最直接也是最有效的一种防御方法,通过在模型的输入中引入某类对抗样本,模型可以免疫于此类对抗样本的影响,对其具有非常高的识别准确度。但对抗训练也存在着严重的不足,包括:1)泛化性差,对抗训练只对某一种对抗攻击有效,而面对不断增长的攻击方法,对抗训练就显得非常被动,要想获得足够的鲁棒性,就需要在输入样本中加入更多的对抗样本;2)计算成本消耗大,对抗训练所需的一个周期的训练时间相比于正常样本的训练时间要增加好几倍,且对抗训练的模型很难达到收敛;3)准确率降低,对抗训练在保证模型对于对抗样本具有一定鲁棒性的同时,降低了模型对正常样本的准确率,训练的最终结果往往是模型在鲁棒性和准确性之间达到一个相对满意折中。

4.解决深度神经网络模型对于对抗样本存在的脆弱性问题,目前的防御方法大多基于对抗训练,没有从根本上有效解决对抗样本中对抗扰动对于深度神经网络模型的影响。

5.受去噪技术在对抗防御中应用的启发,本发明使用具有残差连接的轻量型去噪网络(ldn-rs)作为去噪块,在此基础上引入了内部去噪块和中间去噪块分别进行特征去噪和样本去噪,利用去噪块来去除对抗样本中的对抗扰动,通过在特征处理阶段以及数据预处理阶段向网络模型中植入特定的去噪块,可以极大地缓解对抗样本中扰动对于模型预测的影响,提升模型的对抗防御能力。

技术实现要素:

6.针对现有技术不足,本发明的目的在于提供残差连接的轻量型去噪网络来提高对抗鲁棒性的方法,解决了背景技术中提出的问题。

7.本发明提供如下技术方案:

8.残差连接的轻量型去噪网络来提高对抗鲁棒性的方法,包括以下步骤:

9.s1,将原始样本的像素进行归一化;

10.s2,在原始样本中添加随机扰动,形成扰动样本;

11.所述扰动样本为:

12.s

disturb

=s

original

+(-蝌)

13.其中,s

original

表示原始样本,s

disturb

表示扰动样本,

ò

表示在原始样本中添加的扰动;

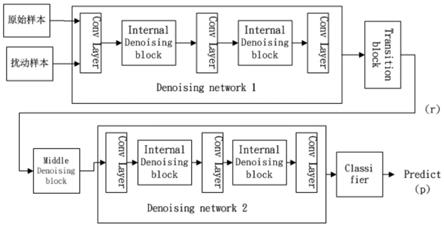

14.s3,网络模型第一阶段的训练:将所述扰动样本在含有内部去噪块的denoising network1中进行去噪处理,并通过转换块得到对应的恢复样本;

15.s4,网络模型第二阶段的训练:将所述扰动样本通过中间去噪块进行处理,然后再与所述恢复样本进行融合获得融合样本,将所述融合样本在denoising network2中进行进一步去噪处理,此时原始样本开始参与网络训练,最后得到分别包含原始样本与扰动样本的恢复样本以及各自的预测标签。

16.优选的,还包括步骤:s5,微调阶段:将所述恢复样本作为网络模型的输入,再次得到相应的第二次恢复样本和预测标签。

17.优选的,步骤s3中,转换块输出的恢复样本与对应的原始样本的均方差数值需小于设定阈值,具体实现的过程包括以下步骤:

18.a,计算扰动样本与原始样本的恢复样本及对应预测标签,具体计算过程如下:

19.r1,p1=f(s

disturb

)

20.r

′1,p

′1=f(s

original

)

21.式中,f表示网络模型,r表示恢复的样本,p表示预测标签;

22.b,计算扰动样本经转换块处理后得到的恢复样本与原始样本的均方差损失,计算公式如下:

23.l

recov1

=mse(s

origianl

,r1)

24.其中,mse表示均方差损失函数,l

recov1

表示扰动样本的均方差损失;

25.c,通过误差反向传播,直至扰动样本的均方差损失小于设定阈值。

26.优选的,步骤s3中,网络模型为深度神经网络模型,所述深度神经网络模型选择resnet50/101/152作为防御对抗攻击的原始网络模型。

27.优选的,所述深度神经网络模型以原始resnet50作为基线,采用 early-stop方法进行网络训练,并利用adversarial robustnesstoolbox(art)工具来测试在不同数据集上所训练网络模型的性能。

28.优选的,步骤s5中,微调阶段的具体实现包括以下步骤:

29.a,将步骤s3中所述的恢复样本作为微调阶段网络模型的输入,得到相应的第二次恢复样本和预测标签,

30.具体计算过程如下:

31.r2,p2=f(r1)

32.r

′2,p

′2=f(r

′1);

33.b,计算第二次恢复样本的交叉熵损失与均方差损失,具体计算过程如下:

34.l

recov2

=mse(s

original

,r2)

35.l

adv2

=ce(s

original

,p2)

36.l

orig2

=ce(s

original

,p

′2)

37.其中,l

recov2

表示第二次恢复的扰动样本与原始样本的均方差, l

adv2

表示第二次恢复的扰动样本的交叉熵损失,l

orig2

表示第二次恢复的的原始样本的交叉熵损失;

38.c,具体计算过程如下:

39.l

total2

=χl

recov2

+γl

adv2

+λl

orig2

40.其中,l

total2

表示网络模型在微调阶段的损失函数。

41.优选的,所述网络模型中采用轻量型的去噪卷积神经网络 l-dncnn作为去噪器,且l-dncnn模型的深度设为7,中间块的数量设为5。

42.优选的,步骤s4中,融合样本不仅能够减少在特征去噪中没有除掉的特殊扰动,还在体量上增加了有关原始样本的信息,提升了网络模型对于样本(扰动样本、原始样本)的检测和识别能力,具体实现步骤包括:

43.i,计算扰动样本与原始样本的预测误差,具体计算过程如下:

44.l

adv1

=ce(s

original

,p1)

45.l

orig1

=ce(s

original

,p

′1)

46.式中,ce表示交叉熵损失函数,l

adv1

表示扰动样本的交叉熵损失, l

orig1

表示原始样本的交叉熵损失,

47.ii,计算网络模型的整体损失函数,计算公式如下:

48.l

total1

=χl

recov1

+γl

adv1

+λl

orig1

49.其中,缩放因子χ=γ=λ=1,l

total1

表示网络模型第二阶段的整体损失函数;

50.iii,误差反向传播。

51.优选的,为了抑制或者阻止对抗扰动在网络模型中的负面影响,本发明在网络模型内部植入去噪块来提升网络模型的对抗鲁棒性,内部去噪块的设置步骤如下:

52.步骤一,内部去噪块中所述l-dncnn的数量设置有多个,多个所述l-dncnn之间进行串联,且串联l-dncnn的数量设定为2;通过增加去噪器的容量和数量来提升去噪块的去噪能力;

53.步骤二,对2个串联的l-dncnn进行残差连接,具有残差连接的轻量型去噪网络(ldn-rs)被用作内部去噪块。

54.与现有技术相比,本发明具有以下有益效果:

55.(1)本发明残差连接的轻量型去噪网络来提高对抗鲁棒性的方法,通过采用一种具有残差连接的轻量型去噪网络ldn-rs来构成内部去噪块和中间去噪块,在保证被植入去噪块的网络模型具有良好对抗鲁棒性以及准确性的同时,减轻了网络模型的训练消耗。

56.(2)本发明残差连接的轻量型去噪网络来提高对抗鲁棒性的方法,通过在网络模型的第一阶段训练时设定阈值的分阶段去噪方法,当网络模型中转换块输出的恢复样本与原始样本的均方差损失函数 mse值小于设定阈值时,网络模型的训练进入下一阶段,从而增加网络模型的去扰动能力。

57.(3)本发明残差连接的轻量型去噪网络来提高对抗鲁棒性的方法,通过设置微调阶段,通过设定均值损失函数和交叉熵损失函数,恢复样本变的更加逼近原始样本,且网络模型对于样本的分类准确率也得到了进一步的提升。

58.(4)本发明残差连接的轻量型去噪网络来提高对抗鲁棒性的方法,通过设置网络模型的第二阶段训练,扰动样本经过中间去噪块中ldn-rs处理,然后再与第一阶段转换块

输出的恢复样本进行融合,融合后的样本被送入denoising network2中进行进一步去噪处理,融合后的样本不仅能够减少在特征去噪中没有除掉的特殊扰动,还在体量上增加了有关原始样本的信息,提升了网络模型对于样本(扰动样本、原始样本)的检测和识别能力。

附图说明

59.为了更清楚地说明本发明实施方式的技术方案,下面将对实施方式中所需要使用的附图作简单地介绍,应当理解,以下附图仅示出了本发明的某些实施例,因此不应被看作是对范围的限定,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他相关的附图。

60.图1为本发明的网络模型的整体框架图。

61.图2为本发明的l-dncnn模型框架图。

62.图3为本发明的ldn-rs模型框架图。

具体实施方式

63.为使本发明实施方式的目的、技术方案和优点更加清楚,下面将结合本发明实施方式中的附图,对本发明实施方式中的技术方案进行清楚、完整地描述。显然,所描述的实施方式是本发明一部分实施方式,而不是全部的实施方式。基于本发明中的实施方式,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施方式,都属于本发明保护的范围。

64.因此,以下对在附图中提供的本发明的实施方式的详细描述并非旨在限制要求保护的本发明的范围,而是仅仅表示本发明的选定实施方式。基于本发明中的实施方式,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施方式,都属于本发明保护的范围。

65.实施例一

66.请参阅图1-3所示,残差连接的轻量型去噪网络来提高对抗鲁棒性的方法,包括以下步骤:

67.s1,将原始样本的像素进行归一化;

68.s2,在原始样本中添加随机扰动,形成扰动样本;

69.所述扰动样本为:

70.s

disturb

=s

original

+(-蝌)

71.其中,s

original

表示原始样本,s

disturb

表示扰动样本,

ò

表示在原始样本中添加的扰动;

72.s3,网络模型第一阶段的训练:将所述扰动样本在含有内部去噪块的denoising network1中进行去噪处理,并通过转换块得到对应的恢复样本;

73.s4,网络模型第二阶段的训练:将所述扰动样本通过中间去噪块进行处理,然后再与所述恢复样本进行融合获得融合样本,将所述融合样本在denoising network2中进行进一步去噪处理,此时原始样本开始参与网络训练,最后得到分别包含原始样本与扰动样本的恢复样本以及各自的预测标签。

74.还包括步骤:s5,微调阶段:将所述恢复样本作为网络模型的输入,再次得到相应

的第二次恢复样本和预测标签。

75.步骤s1中,对于原始样本和对抗样本的选取,具体步骤如下:

76.步骤一:制作原始样本;

77.对于mnist数据集,它是由28

×

28的灰度图像组成,包括60000 张训练图像以及10000张测试图像,对于cifar-10数据集,它是由 32

×

32的彩色样本组成,包括50000张训练图像以及10000张测试图像,对于svhn数据集,本发明选择其两种形式中的一种,由32

×ꢀ

32的彩色样本组成,包括73257张训练图像以及10000张测试图像,在使用过程中,把图像尺寸统一缩放为64

×

64,为了尽可能的不改变网络模型的设置,本发明将灰度图像的单通道重复了三次变为三通道;

78.步骤二:制作对抗样本;

79.在白盒攻击下:在mnist数据集上,在无穷范数攻击下,对抗扰动∈=0.3,对于fgsm,步幅为0.1,对于pgd,步长为100,步幅为0.1,对于c&w,步长为10。在2范数攻击下对抗扰动∈=1.5,对于fgsm,步幅为0.1,对于pgd,步长为100,步幅为0.1,对于deepfool,对抗扰动∈=1.5,步长为100,在cifar-10数据集上,本发明采用无穷范数的攻击方法,相比于2范数攻击,无穷范数攻击显得更加强劲和有效,更能评价一个模型的对抗鲁棒性,在无穷范数攻击下对抗扰动∈=8/255,对于fgsm,步幅为0.1,对于pgd,步长为40,步幅为2/255,对于c&w步长为10,在svhn数据集上,由于svhn数据集与cifar-10 数据集都为彩色样本且样本尺寸相似,因此对两个数据集的攻击方法和参数也设定一致;

80.在黑盒攻击下:在cifar-10数据集上评估原始网络模型和增强网络模型在黑盒攻击下的表现,采用l

∞-fgsm、l

∞-pgd对抗攻击方法,对抗扰动∈=8/255,对于fgsm,步幅为0.1,对于pgd,步长为40,步幅为2/255;

81.步骤s3中,网络模型为深度神经网络模型,所述深度神经网络模型选择resnet50/101/152作为防御对抗攻击的原始网络模型。

82.所述深度神经网络模型以原始resnet50作为基线,采用early-stop 方法进行网络训练,并利用adversarial robustness toolbox(art)工具来测试在不同数据集上所训练网络模型的性能

83.步骤s3中,网络模型为深度神经网络模型,选取深度神经网络模型,具体步骤如下:

84.步骤一:选择resnet50/101/152作为防御对抗攻击的原始网络模型,ldn-rs(

·

)表示使用本发明的方法进行对抗防御的网络模型;

85.步骤二:对抗防御的过程也是网络模型实现最小-最大化的过程,对抗样本使网络模型的预测结果偏离其真实标签以此来达到对网络模型的对抗攻击,对抗防御将网络模型对于对抗样本的预测误差减小到最低,优化的目标公式如下:

[0086][0087]

在(x,y)中,x是干净样本,y是对应于x的真实标签。f表示网络模型,x

′

是关于x的对抗样本,l表示损失函数例如交叉熵损失函数,θ表示网络模型的参数,

·

p

是对抗样本与干净样本间的距离例如 l1,l2,l

∞

。对抗攻击使公式(14)中内部的损失函数发生最大化,本发明实现网络模型的外部最小化;

[0088]

步骤三:将原始resnet50作为基线,网络训练采用early-stop方法来保存最佳的训练模型,利用adversarial robustness toolbox(art) 工具来测试在不同数据集上所训练网络模型的性能。

[0089]

本发明选取轻量型的去噪卷积神经网络(l-dncnn)作为去噪器。如图2所示,本发明将l-dncnn模型的深度(depth)设定为7,其中中间块的数量为5,相较于原始dncnn中间块的连接数量仅为其1/3,虽然l-dncnn中间块的数量被减少了,但其去噪能力仍然能够得到有效的保留,从另一方面看,l-dncnn在减小原始去噪器体积的同时,相应的计算成本以及训练时间能够得到明显的改善,方便去噪块与去噪块之间或者去噪块与原始网络之间进行进一步组合,扩展了去噪块的适用范围。

[0090]

实施例二

[0091]

在实施例一的基础上,步骤s3中,转换块输出的恢复样本与对应的原始样本的均方差数值需小于设定阈值,具体实现的过程包括以下步骤:

[0092]

a,计算扰动样本与原始样本的恢复样本及对应预测标签,具体计算过程如下:

[0093]

r1,p1=f(s

disturb

)

[0094]r′1,p

′1=f(s

original

)

[0095]

式中,f表示网络模型,r表示恢复的样本,p表示预测标签;

[0096]

b,计算扰动样本经转换块处理后得到的恢复样本与原始样本的均方差损失,计算公式如下:

[0097]

l

recov1

=mse(s

origianl

,r1)

[0098]

其中,mse表示均方差损失函数,l

recov1

表示扰动样本的均方差损失;

[0099]

c,通过误差反向传播,直至扰动样本的均方差损失小于设定阈值。

[0100]

步骤s5中,微调阶段的具体实现包括以下步骤:

[0101]

a,将步骤s3中所述的恢复样本作为微调阶段网络模型的输入,得到相应的第二次恢复样本和预测标签,

[0102]

具体计算过程如下:

[0103]

r2,p2=f(r1)

[0104]r′2,p

′2=f(r

′1);

[0105]

b,计算第二次恢复样本的交叉熵损失与均方差损失,具体计算过程如下:

[0106]

l

recov2

=mse(s

original

,r2)

[0107]

l

adv2

=ce(s

original

,p2)

[0108]

l

orig2

=ce(s

original

,p

′2)

[0109]

其中,l

recov2

表示第二次恢复的扰动样本与原始样本的均方差, l

adv2

表示第二次恢复的扰动样本的交叉熵损失,l

orig2

表示第二次恢复的的原始样本的交叉熵损失;

[0110]

c,具体计算过程如下:

[0111]

l

total2

=χl

recov2

+γl

adv2

+λl

orig2

[0112]

其中,l

total2

表示网络模型在微调阶段的损失函数。

[0113]

通过设定均值损失函数和交叉熵损失函数,恢复样本变的更加逼近原始样本,且网络模型对于样本的分类准确率也得到了进一步的提升。

[0114]

步骤s4中,融合样本不仅能够减少在特征去噪中没有除掉的特殊扰动,还在体量

上增加了有关原始样本的信息,提升了网络模型对于样本(扰动样本、原始样本)的检测和识别能力,具体实现步骤包括:

[0115]

i,计算扰动样本与原始样本的预测误差,具体计算过程如下:

[0116]

l

adv1

=ce(s

original

,p1)

[0117]

l

orig1

=ce(s

original

,p

′1)

[0118]

式中,ce表示交叉熵损失函数,l

adv1

表示扰动样本的交叉熵损失, l

orig1

表示原始样本的交叉熵损失,

[0119]

ii,计算网络模型的整体损失函数,计算公式如下:

[0120]

l

total1

=χl

recov1

+γl

adv1

+λl

orig1

[0121]

其中,缩放因子χ=γ=λ=1,l

total1

表示网络模型第二阶段的整体损失函数;

[0122]

iii,误差反向传播。

[0123]

融合样本被送入denoising network2中进行进一步去噪处理,融合后的样本不仅能够减少在特征去噪中没有除掉的特殊扰动,还在体量上增加了有关原始样本的信息,提升了网络模型对于样本(扰动样本、原始样本)的检测和识别能力。

[0124]

为了抑制或者阻止对抗扰动在网络模型中的负面影响,本发明在网络模型内部植入去噪块来提升网络模型的对抗鲁棒性,如图3所示,内部去噪块的设置步骤如下:

[0125]

步骤一,内部去噪块中所述l-dncnn的数量设置有多个,将多个所述l-dncnn之间进行串联,且串联l-dncnn的数量设定为2;通过增加去噪器的容量和数量来提升去噪块的去噪能力;

[0126]

步骤二,对2个串联的l-dncnn进行残差连接,具有残差连接的轻量型去噪网络(ldn-rs)被用作内部去噪块。

[0127]

对2个串联的l-dncnn进行残差连接,这样做不仅能够保留原始网络模型中被植入内部去噪块所在位置的原始连接方式,以及原始网络模型所实现的功能,此外被植入去噪块的网络模型拥有了良好的去噪能力,此时具有残差连接的轻量型去噪网络(ldn-rs)被用来当作内部去噪块,本发明旨在网络模型的浅层进行特征去噪,即将内部去噪块植入在原始网络模型的第一层后与第二层后,共2个,这样可以在尽可能不改变原始网络框架和功能的同时,提高模型的对抗鲁棒性。

[0128]

步骤s4中,由于样本中的扰动并非只包含我们手动添加的,还有样本自身携带的其它特殊噪声,为了最小化这些噪声对模型决策的影响,本发明引入了中间去噪块。中间去噪块的设置步骤如下:

[0129]

步骤一:将含有噪声的样本经过ldn-rs处理。

[0130]

步骤二:将步骤一处理后的样本与在第一阶段转换块输出的恢复样本进行融合。

[0131]

在这一时期,一方面,网络模型延续了第一阶段已经调整好的状态,具有了一定的去扰动能力,另一方面,融合后的样本丰富了关于原始样本的信息,相较于单单地处理原始样本,融合后的样本使得网络模型更能充分地提取原始样本中的关键信息,因此网络模型的准确性与对抗鲁棒性能够得到提高。

[0132]

实施例三

[0133]

在实施例二的基础上,为了验证本发明的性能,通过原始网络模型和采用ldn-rs网络模型分别对原始样本以及对抗样本进行检测,实验结果对比如表5-8所示:

[0134]

其中,表5为白盒攻击下原始网络模型以及采用ldn-rs网络模型在mnist数据集下的准确率。

[0135]

表6为在白盒攻击下原始网络模型以及采用ldn-rs网络模型在 cifar-10数据集下的准确率。

[0136]

表7为在白盒攻击下原始网络模型以及采用ldn-rs网络模型在 svhn数据集下的准确率。

[0137]

表8为在黑盒攻击下原始网络模型以及采用ldn-rs网络模型在 cifar-10数据集下的准确率。

[0138][0139][0140]

表5

[0141]

从表5中可以看出,原始的resnet50/101/152网络模型在干净样本的检测准确率上均高于ldn-rs(resnet50),ldn-rs(resnet50)比最佳的准确率低了0.07%,但在对抗防御中,通过使用ldn-rs方法加强的网络模型表现出的鲁棒性均高于原始网络模型,尤其在原始 resnet50/101网络模型对l

∞-pgd攻击完全失效的情况下,使用 ldn-rs方法增强的网络模型仍具有78.91%正确率,同样,ldn-rs (resnet50)模型在c&w和deepfool攻击下的表现也是值得肯定的。也可以发现采用l2攻击方式的fgsm、pgd的攻击强度不如在l

∞

中的强烈,也可以说明l

∞

攻击是一种强有力的攻击手段,能够使没有采取防御措施的网络模型几乎丧失对抗防御能力,当然c&w和 deepfool也都具有出色的攻击表现,能够极大的破坏原始网络模型的防御能力。通过表5中的数据,可以显示出使用ldn-rs方法增强后的ldn-rs

(resnet50)模型,不仅保持了对干净样本较高的识别准确率,还在对抗防御中显示出了强大的优势。

[0142][0143]

表6

[0144]

从表6中可以发现,使用ldn-rs方法增强的ldn-rs(resnet50),抵御各种对抗攻击的能力均优于原始的resnet50/101/152网络模型,且在l

∞-pgd攻击下,ldn-rs(resnet50)模型具有65%的准确率,远高于在相同攻击条件下原始网络模型的表现,c&w对抗攻击对所有模型的防御能力造成了极大的破坏,甚至加强的ldn-rs(resnet50) 模型对其防御效果也不是特别的显著,这也是未来需要解决的主要问题之一,值得一提的是,使用ldn-rs方法加强的ldn-rs(resnet50) 模型在干净样本的识别准确率上均高于原始网络模型,这与网络模型训练策略中分阶段的去噪方式以及微调密切相关。resnet50/101/152 网络模型在cifar-10上的总体表现性能不如在mnist上的优秀,一个重要原因可能是cifar-10数据集是彩色图像且要识别的物体是动物,而mnist数据集是由灰度的数字手写体组成的,前者比后者要复杂的多。

[0145]

[0146]

表7

[0147]

从表7中可以发现,经过加强的ldn-rs(resnet50),在干净样本分类上具有93.47%的准确率,比原始resnet50网络模型高了5.26%,在l

∞-pgd攻击下,没有采取防御措施的网络模型几乎全部失效,而 ldn-rs(resnet50)具有63.78%的准确率。同时也可以发现,在简单的数据集上,增强的网络模型(ldn-rs(resnet50))对于c&w对抗攻击具有更好的防御效果,例如将svhn数据集与cifar-10数据集由简单到复杂进行排序,ldn-rs(resnet50)在两个数据集上的准确率分别为 93.39%和13.35%,在更简单的mnist数据集上,ldn-rs(resnet50) 具有99.47%的准确率,这些实验数据与开始的结论相符。通过观察表6与表7,可以发现,使用ldn-rs的方法增强的网络模型,在干净样本分类以及对抗防御中,所表现的性能均强于原始网络模型 (resnet50/101/152)。

[0148][0149]

表8

[0150]

从表8中可以发现,在干净样本的分类准确率中,使用ldn-rs 的方法增强的网络模型ldn-rs(resnet50)具有最好的表现,比第二名高了10.35%。同时也可以发现,在l

∞-pgd攻击下,原始网络模型 (resnet50/101/152)的对抗防御准确率在2%-3%,几乎丧失了

对 l

∞-pgd对抗攻击的防御能力,而使用ldn-rs方法增强的网络模型 ldn-rs(resnet50)具有65.23%的准确率,能够有效地提升原始网络模型(resnet50)的对抗鲁棒性。

[0151]

以上所述仅为本发明的优选实施方式而已,并不用于限制本发明,对于本领域的技术人员来说,本发明可以有各种更改和变化;凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1