一种类生物体机器概率决策算法的制作方法

1.本发明属于机器行为决策算法技术领域,具体为一种类生物体机器概率决策算法。

背景技术:

2.机器人、智能体在与人类交互时,为了获得人类的亲近感,需要表现出类生物体的行为和决策。目前常用的机器行为决策算法主要有2类,一类是具有确定规则的决策机制,即通过预先编程形成机器行为序列,或预先编制外界刺激-机器反应对应关系表,实现机器的行为决策。

3.另一类则为随机决策,即预先定义每种外界刺激对应的机器行为集,以及该集合中每种机器行为的发生概率,随机决策哪种发生哪个行为。

4.对于具有固定规则的第一种行为决策算法,其主要应用于严格要求机器确定行为的场合,如工业场景。如果应用于机器人伴侣、娱乐机器人等场景下,因其行为可以被准确预测,因而不容易被人类接受为“伴侣”,仅仅会被当成机器。

5.对于第二种随机决策算法,如果不严格的对各行为发生概率进行限定,很容易形成过于随机的行为序列,使得其完全无法被预测,给人类造成恐慌。但严格的进行行为概率限定,是一项复杂耗时的工作。

6.因此需要一种通过可以通过简单调参,即能形成行为“基本”可预测的一种行为决策算法。并且,如果能通过设定不同的参数取值,根据每台机器人所处环境,形成不同“性格”的机器行为决策,将极大的降低调试工作量,丰富产品种类。

技术实现要素:

7.本发明的目的在于:本发明提供了一种类生物体机器概率决策算法,解决了严格进行概率限定的随机决策算法复杂耗时的问题。

8.本发明目的通过下述技术方案来实现:

9.一种类生物体机器概率决策算法,按照行为决策、参数调整、动作执行的顺序进行,重复运行,每一个完整动作序列称为一个执行周期;在参数调整中,对于每种行为,每被执行一次,其发生概率下降a%;如果该行为在当前周期选中执行,则a会增加;如果该行为没有在当前周期选中执行,则a会衰减。

10.进一步的,a初始取值为2~5,如果该行为在当前周期选中执行,则a会增加e,e为2~5间的随机数;如果该行为没有在当前周期选中执行,则a会衰减b%,b为10~30间的随机数。

11.进一步的,在行为决策中,存在主动行为和被动行为,主动行为存在发生概率,执行每种行为会消耗能量,机器当前总剩余能量为e,根据e的多少划分能量级,在每个能量级中,每种主动行为存在初始发生概率。

12.进一步的,所有主动行为的发生概率之和为1,在主动行为的发生概率变化后,对

所有主动行为的发生概率进行归一化处理。

13.进一步的,主动行为包括休眠行为,其发生概率随着e的减少而增加,执行休眠行为会增加能量。

14.进一步的,能量会随着休眠时间的增加而增加。

15.进一步的,动作执行包括主动行为执行和被动行为执行,被动行为执行后,需要进行惩罚调整,当e的绝对值小于th时,则增加所有能量级中,休眠行为的概率。

16.进一步的,对于m能量级,休眠行为的概率增加c%的m次方,c取值为2~5。

17.进一步的,动作执行包括主动行为执行和被动行为执行,主动行为执行后,需要进行休眠判定,判定为是则进行随机微调,该能量级中该行为的概率随机增加或衰减,判定为否则进行下一周期。

18.进一步的,该能量级中该行为的概率增加或衰减d%,d为-20~20间的随机数。

19.本发明的有益效果:

20.1.约束条件能够通过若干参数定义和限定,参数具有一定的意思,便于人类快速掌握调参原理。

21.2.算法应具有一定的自学习能力,能够根据所出环境和应用场景,在人工限定约束的基础上,动态优化行为决策。

22.前述本发明主方案及其各进一步选择方案可以自由组合以形成多个方案,均为本发明可采用并要求保护的方案;且本发明,(各非冲突选择)选择之间以及和其他选择之间也可以自由组合。本领域技术人员在了解本发明方案后根据现有技术和公知常识可明了有多种组合,均为本发明所要保护的技术方案,在此不做穷举。

附图说明

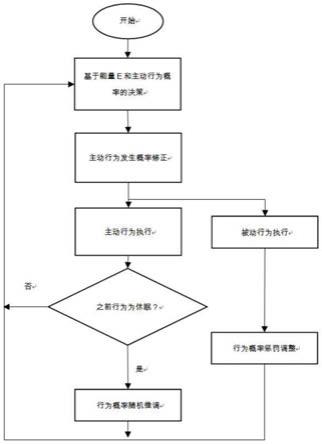

23.图1是本发明的流程示意图。

具体实施方式

24.下列非限制性实施例用于说明本发明。

25.实施例1:

26.参考图1所示,一种类生物体机器概率决策算法,按照行为决策、参数调整、动作执行的顺序进行,重复运行,每一个完整动作序列称为一个执行周期。

27.其中动作执行包括主动行为执行和被动行为执行。主动行为执行后,需要进行休眠判定,判定为是则进行随机微调,判定为否则进行下一周期。被动行为执行后,需要进行惩罚调整。

28.行为决策中,具体为基于能量e和主动行为概率的决策,存在主动行为和被动行为,主动行为是机器不用必须执行的动作,被动行为是机器必须根据外界刺激做出的反应动作。一种机器,必然存在若干确定数量的主动行为和被动行为,主动行为记为p_act_n,被动行为记为n_act_n,其中,n=0,1,2

…

。

29.主动行为存在发生概率,所有主动行为的发生概率之和为1,被动行为不存在发生概率,或者说,受到外界刺激后,需要100%的进行动作。

30.执行每种行为(除休眠行为)会消耗能量,该“能量”与真实机器消耗的能源无直接

关系,仅仅是用于进行行为决策的一个参数,每种行为的能源消耗由人工设定,每种主动行为消耗的能量设为p_act_e_n,被动行为设为n_act_e_n,其中,n=0,1,2

…

。

31.机器当前总剩余能量为e,根据e的多少划分若干能量级(0,1,2

…

),推荐划分能量级为0~3级或0~5级,0能量级为最低能量级。在每个能量级中,每种主动行为发生概率记为p_n_m,即主动行为n在e为m能量级时的发生概率。该概率的初始值为人为指定,不同的参数取值,对应不同的机器性格。

32.特别的,主动行为必然包括一种行为,即休眠行为,该行为不定义能量消耗,而是定义休眠时能量增长的速率,即机器执行该操作后,能量会随着休眠时间的增加而增加。其发生概率随着e的减少而增加,执行休眠行为会增加能量。

33.在参数调整中,对于每种主动行为,每被执行一次,其发生概率下降a%,称为主动行为发生概率修正,a初始取值推荐2~5。如果该行为在当前周期选中执行,则a会增加e,e为2~5间的随机数。如果该行为没有在当前周期选中执行,则a会发生b%程度的衰减,b推荐取值10~30。

34.即未进行概率调整前,某主动行为的发生概率为p,则调整后概率p’的计算过程为:p’=p*(1-a%)。

35.然后更新a值,则执行以下操作:

36.如果当前发生该行为:a’=a+e,如果a’》100,则令a’=100。

37.如果当前没有发生该行为:a’=a*(1-b%),如果a’《1,则令a’=0。

38.该能量级下其它行为,平均分摊多余或减少的概率,使得所有行为发生概率总和仍为1。主动行为的概率修正,是为了避免相同行为连续发生,增加机器决策系统的随机性。

39.主动行为执行后,需要进行休眠判定,判定为是则进行随机微调,随机微调,是一项可选操作,用于进一步增加决策行为的随机性。该能量级中该行为的概率增加或衰减d%。

40.即对于某个能量级内的某个行为,生成取值-20~20间的随机数d,该能量级内该行为的概率调整公式为:p’=p*(1+d%),然后归一化该能量级内所有行为发生概率,最后进行下一周期。

41.判定为否则直接进行下一周期。

42.被动行为执行后,需要进行惩罚调整,当e的绝对值小于th时,即abs(e)《th,th为人工设定的阈值,推荐th《=e最大值的10%,则增加所有能量级中,休眠行为的概率,其它行为发生概率平均减少,总行为发生概率仍保持为1。

43.第m能量级,休眠概率调整公式为:p’=p*(1+c%**m),c取值推荐2~5,p’为调整后的休眠行为概率,其中**为幂运算符,c%**m即表示c%的m次方。

44.该机制保证了,系统会倾向于保守的能量利用,以备应付随时可能出现的应激事件,具体的能量利用策略,则由实际环境中应激事件出现的概率动态调整。

45.前述本发明基本例及其各进一步选择例可以自由组合以形成多个实施例,均为本发明可采用并要求保护的实施例。本发明方案中,各选择例,与其他任何基本例和选择例都可以进行任意组合。

46.以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1