融合多层次主题特征的文本摘要自动生成方法及装置

1.本发明属于文本数据处理技术领域,特别涉及一种融合多层次主题特征的文本摘要自动生成方法及装置,是指给定一个长文本,通过模型从原文中抽取句子组成一个短文本,并且能概括源文本主要内容。

背景技术:

2.文本自动摘要不仅可以有效的降低阅读成本,而且可以缓解当前人们面临的信息过载问题。按照自动摘要的方法进行区分,主要的方法有两种:抽取式摘要和生成式摘要。文本自动摘要最开始以统计理论为基础,基于文本中的词频、句子位置等生成摘要。之后伴随着机器学习和深度学习的发展,主演演化成生成式摘要和抽取式摘要两种主流方法。

3.生成式摘要主要借助于深度学习,起初序列到序列模型在机器翻译领域取得了明显成效,后被应用于文本摘要,并取得突破性的进展。生成式摘要的编码器最初使用递归神经网络rnn,但由于rnn在处理长期依赖问题方面有欠缺,后期都将rnn变体lstm、gru用于编码器中。随后又出现将注意力机制用于序列到序列模型,大幅度提高了生成式摘要的模型效果。之后一段时间主要在注意力机制方面进行不断改进。随后有人将copy和coverage机制用于序列到序列模型,有效缓解了生成摘要出现oov词和重复字句的问题。在解决上述问题的基础上,有人用强化学习对模型进行优化,有效缓解了曝光偏差问题。近几年,在transfomer的提出后,有人将其用于生成式摘要,并取得了明显的提升,目前生成式摘要以结合transformer的方法为主。虽然生成式摘要目前已经取得了不错的成就,但仍存在信息编码不充分,生成摘要的过程缺少关键信息的指导等问题,造成生成摘要偏离文本主题的问题。

4.抽取式摘要源于上个世纪,已经存在了很长时间,技术相对软件资源要求不高,且研究技术已经相对成熟,因此得到了广泛的应用。由于抽取式摘要是从原文抽取词语和句子,因此生成的摘要一般不会偏离主题,摘要的质量也比较高。传统的抽取式摘要基于词频、位置等统计特征的方法进行摘要,之后基于图排序的方法被应用于文本摘要并取得较好的效果。在20世纪90年代,多将机器学习的方法应用于文本摘要中。在神经网络应用于抽取式摘要取得明显效果后,基于神经网络的抽取式摘要已成为主流方法。目前有将分层注意力融入其中,或将文本中的语义信息融入其中,都取得了效果上的提升。也有将transformer应用于抽取式摘要,提升了模型效果,但造成了模型参数增多,训练成本提高。

5.伴随自然语言处理和深度神经网络的发展,基于神经网络的抽取式摘要正在不断改进和提升,但目前大多数都是增加训练参数或融入全局信息,在融和多层次主题特征方面还很缺乏。

技术实现要素:

6.针对现有技术中存在的问题,本发明提出一种融合多层次主题特征的文本摘要自动生成方法及装置,在句向量输入到编码器后,基于生成的隐藏层状态提取局部主题特征

和全局信息特征,并将其融入源文本,以便在解码时充分参考文本中的上下文主题,能够在生成摘要进一步贴合主题的基础上,提高生成摘要的质量。

7.为了实现上述目的,本发明采用以下的技术方案:

8.本发明提供了一种融合多层次主题特征的文本摘要自动生成方法,包含以下步骤:

9.步骤1,基于平均词嵌入方法,将源文本对应的词向量映射成固定长度的句向量;

10.步骤2,将源文本对应的句向量输入到编码器中的双向gru网络中,并得到每个句向量所对应的隐藏层状态;

11.步骤3,基于生成的隐藏层状态,对源文本进行局部主题特征和全局信息特征提取;

12.步骤4,将提取到的局部主题特征和全局信息特征融入到源文本中进行解码,依次从源文本中选取句子组成摘要。

13.进一步地,所述句向量的计算公式如下:

[0014][0015]

其中,set代表句向量,代表句子中的第i个单词wi对应的词编码,i∈[1,n],n表示该句中包含的单词向量个数。

[0016]

进一步地,所述隐藏层状态表示为:

[0017][0018]

其中,hi由前向隐藏层状态和后向隐藏层状态拼接成,和的生成公式如下:

[0019][0020][0021]

其中,xi表示输入到双向gru网络中的第i个句向量,i∈[1,m],m表示源文本中包含的句向量的个数。

[0022]

进一步地,所述步骤3具体包含以下步骤:

[0023]

步骤3.1,基于隐藏层状态提取源文本的局部主题特征sec

t

;

[0024]

步骤3.2,基于边缘隐藏层状态提取源文本的全局信息特征doc。

[0025]

进一步地,所述步骤3.1的局部主题特征sec

t

由和拼接成,具体的计算过程如下:

[0026][0027][0028]

其中,start

t

和end

t

分别代表每个分段开始和结束的句向量索引,代表前向

局部主题特征,由分段前向隐藏层结束状态与分段前向隐藏层开始前状态相减得到,代表后向局部主题特征,由分段后向隐藏层结束状态与分段后向隐藏层开始前状态相减得到;

[0029]

再将前向局部主题特征和后向局部主题特征进行融合,得到局部主题特征sec

t

,表达式如下:

[0030][0031]

α代表融合因子,α∈(0,0.5)。

[0032]

进一步地,所述步骤3.2的全局信息特征doc表示为:

[0033][0034]

其中,代表前向隐藏层状态的最后一层状态,代表后向隐藏层状态的最后一层状态,doc由和拼接成。

[0035]

进一步地,所述步骤4具体包含以下步骤:

[0036]

步骤4.1,将局部主题特征sec

t

和全局信息特征doc融入源文本,得到包含多层次主题特征的输入编码inputi;

[0037]

步骤4.2,将包含多层次主题特征的输入编码inputi输入到解码器进行解码,并依次从源文本中选取句子组成摘要。

[0038]

进一步地,所述步骤4.1中输入编码inputi表示为:

[0039]

inputi=[seti;sec

t

;doc]

[0040]

输入编码inputi由句向量seti、局部主题特征sec

t

和全局信息特征doc融合成,输入编码inputi的计算过程如下:

[0041][0042][0043][0044][0045][0046]

inputi=[seti;gi]

[0047]

其中,wa,v

t

均是可学习的参数,和分别代表源文本融入全局信息特征和局部主题特征的所占权重,ci代表上下文信息,inputi代表融入上下文信息ci的输入编码,由seti和ci拼接成。

[0048]

进一步地,所述步骤4.2中解码的计算过程如下:

[0049][0050][0051]

其中,w

up

,w

down

,b

up

,b

down

均是可学习的参数;

[0052][0053]

outputi=dropout(relu(w*input_newi+b))

[0054]

pi=σ(whoutputi+bh)

[0055]

其中,w,wh,b,bh均是可学习的参数,σ代表sigmoid激活函数,和分别代表感知机第一层上下两层的输出结果,input_newi代表感知机第二层的输入,由和拼接成,outputi代表感知机第二层的输出结果,再利用outputi计算每个句子的置信值;pi代表一个置信值,即对一个句子被抽取为摘要的衡量度。

[0056]

本发明还提供了一种融合多层次主题特征的文本摘要自动生成装置,包括:

[0057]

句向量生成模块,用于基于平均词嵌入方法,将源文本对应的词向量映射成固定长度的句向量;

[0058]

编码器隐藏层状态计算模块,用于将源文本对应的句向量输入到编码器中的双向gru网络中,并得到每个句向量所对应的隐藏层状态;

[0059]

多层次主题特征提取模块,用于基于生成的隐藏层状态,对源文本进行局部主题特征和全局信息特征提取;

[0060]

摘要生成模块,用于将提取到的局部主题特征和全局信息特征融入到源文本中进行解码,依次从源文本中选取句子组成摘要。

[0061]

与现有技术相比,本发明具有以下优点:

[0062]

1、在传统的基于神经网络的抽取式摘要的基础上,在源文本的句向量输入到文档编码器后,基于句向量对应的隐藏层状态,对源文本的局部主题特征和全局信息特征进行提取,并在输入到解码器前按权重将多层次主题特征融入源文本,使得在生成摘要时贴合上下文信息,在提高生成摘要质量的前提下解决生成摘要可读性和主题相关性低的问题。

[0063]

2、在解码时,结合多层次主题特征对源文本的句子进行选取,并为句子计算一个置信值来衡量。将解码器的感知机第一层设置成上下两层,并将输出结果进行拼接,作为感知机第二层的输入,防止了在解码时因语义损失而造成生成摘要的主题相关度降低。

附图说明

[0064]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0065]

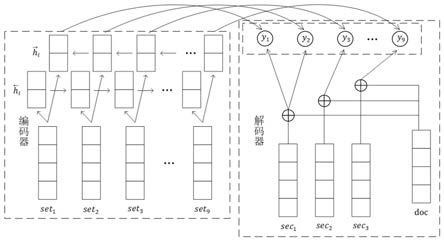

图1是本发明实施例的融合多层次主题特征的文本摘要自动生成方法的网络结构

图;

[0066]

图2是本发明实施例的融合多层次主题特征的文本摘要自动生成方法的流程示意图;

[0067]

图3是本发明实施例的提取局部主题特征和全局信息特征的流程示意图;

[0068]

图4是本发明实施例的提取局部主题特征的网络结构图;

[0069]

图5是本发明实施例的源文本融入多层次主题特征后进行解码的流程示意图;

[0070]

图6是本发明实施例的融合多层次主题特征的文本摘要自动生成装置的结构框图。

具体实施方式

[0071]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0072]

为了在模型编码-解码时可以参考更多的有效信息,使得生成的摘要具有更好的可读性和主题相关性,并使摘要质量得到进一步提升,如图1和图2所示,本实施例提出一种融合多层次主题特征的文本摘要自动生成方法,包含以下步骤:

[0073]

步骤s11,基于平均词嵌入方法,将源文本对应的词向量映射成固定长度的句向量;

[0074]

步骤s12,将源文本对应的句向量输入到编码器中的双向gru网络中,并得到每个句向量所对应的隐藏层状态;

[0075]

步骤s13,基于生成的隐藏层状态,对源文本进行局部主题特征和全局信息特征提取;

[0076]

步骤s14,将提取到的局部主题特征和全局信息特征融入到源文本中进行解码,依次从源文本中选取句子组成摘要。

[0077]

步骤s11中句向量的计算公式如下:

[0078][0079]

其中,set代表句向量,代表句子中的第i个单词wi对应的词编码,i∈[1,n],n表示该句中包含的单词向量个数。

[0080]

针对长文本摘要中常用的句编码方法,使用平均词嵌入的效果相同或优于rnn或cnn的方法,因此,在本实施例中,我们使用平均词嵌入进行句编码。

[0081]

在本实例中,所述隐藏层状态表示为:

[0082][0083]

其中,hi由前向隐藏层状态和后向隐藏层状态拼接成,和的生成公式如下:

[0084]

[0085][0086]

其中,xi表示输入到双向gru网络中的第i个句向量,i∈[1,m],m表示源文本中包含的句向量的个数。

[0087]

具体的,如图3所示,步骤s13包含步骤s131~s132:

[0088]

步骤s131,基于隐藏层状态提取源文本的局部主题特征sec

t

,局部主题特征sec

t

由和拼接成,具体的计算过程如下:

[0089][0090][0091]

其中,start

t

和end

t

分别代表每个分段开始和结束的句向量索引,代表前向局部主题特征,由分段前向隐藏层结束状态与分段前向隐藏层开始前状态相减得到,代表后向局部主题特征,由分段后向隐藏层结束状态与分段后向隐藏层开始前状态相减得到。

[0092]

这样做的目的是用分段隐藏层结束状态和分段隐藏层开始前状态的差值作为该分段主题特征的表示。

[0093]

再将前向局部主题特征和后向局部主题特征进行融合,得到局部主题特征sec

t

,表达式如下:

[0094][0095]

α代表融合因子,α∈(0,0.5);sec

t

由和拼接,并且在拼接前对前向和后向信息有一个相互融合的计算,目的是为了在训练中更好的学习局部上下文信息。如图4所示,第二分段的局部主题特征sec2由与相减后得到。

[0096]

步骤s132,基于边缘隐藏层状态提取源文本的全局信息特征doc,全局信息特征doc表示为:

[0097][0098]

其中,代表前向隐藏层状态的最后一层状态,代表后向隐藏层状态的最后一层状态,doc由和拼接成。

[0099]

这样做的目的是前后向隐藏层状态的最后一层是充分学习上文信息后的隐藏层状态,它们的拼接最能代表全文信息特征。

[0100]

具体的,如图5所示,步骤s14包含以下步骤s141~s142:

[0101]

步骤s141,将局部主题特征sec

t

和全局信息特征doc融入源文本,得到包含多层次

主题特征的输入编码inputi,输入编码inputi表示为:

[0102]

inputi=[seti;sec

t

;doc]

[0103]

输入编码inputi由句向量seti、局部主题特征sec

t

和全局信息特征doc融合成,输入编码inputi的计算过程如下:

[0104][0105][0106][0107][0108][0109]

inputi=[seti;gi]

[0110]

其中,wa,v

t

均是可学习的参数,和分别代表源文本融入全局信息特征和局部主题特征的所占权重,ci代表上下文信息,inputi代表融入上下文信息ci的输入编码,由seti和ci拼接成。

[0111]

步骤s142,将包含多层次主题特征的输入编码inputi输入到解码器进行解码,并依次从源文本中选取句子组成摘要,具体计算过程如下:

[0112][0113][0114]

其中,w

up

,w

down

,b

up

,b

down

均是可学习的参数,引入dropout层的目的是防止模型过拟合。

[0115][0116]

outputi=dropout(relu(w*input_newi+b))

[0117]

pi=σ(whoutputi+bh)

[0118]

其中,w,wh,b,bh均是可学习的参数,σ代表sigmoid激活函数,和分别代表感知机第一层上下两层的输出结果,input_newi代表感知机第二层的输入,由和拼接成,outputi代表感知机第二层的输出结果,再利用outputi计算每个句子的置信值;pi代表一个置信值,即对一个句子被抽取为摘要的衡量度。

[0119]

将解码器的感知机第一层设置成上下两层,并将输出结果进行拼接,作为感知机第二层的输入,这样做是为了防止在解码时因语义损失而造成生成摘要的主题相关度降低。

[0120]

与上述融合多层次主题特征的文本摘要自动生成方法相应地,如图6所示,本实施例提出一种融合多层次主题特征的文本摘要自动生成装置,包括句向量生成模块61、编码器隐藏层状态计算模块62、多层次主题特征提取模块63和摘要生成模块64。

[0121]

句向量生成模块61,用于基于平均词嵌入方法,将源文本对应的词向量映射成固定长度的句向量;

[0122]

编码器隐藏层状态计算模块62,用于将源文本对应的句向量输入到编码器中的双向gru网络中,并得到每个句向量所对应的隐藏层状态;

[0123]

多层次主题特征提取模块63,用于基于生成的隐藏层状态,对源文本进行局部主题特征和全局信息特征提取;

[0124]

摘要生成模块64,用于将提取到的局部主题特征和全局信息特征融入到源文本中进行解码,依次从源文本中选取句子组成摘要。

[0125]

本领域普通技术人员可以理解:实现上述方法实施例的全部或部分步骤可以通过程序指令相关的硬件来完成,前述的程序可以存储在计算机可读取的存储介质中,该程序在执行时,执行包括上述方法实施例的步骤;而前述的存储介质包括:rom、ram、磁碟或者光盘等各种可以存储程序代码的介质中。

[0126]

最后需要说明的是:以上所述仅为本发明的较佳实施例,仅用于说明本发明的技术方案,并非用于限定本发明的保护范围。凡在本发明的精神和原则之内所做的任何修改、等同替换、改进等,均包含在本发明的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1