一种基于AI助手的虚拟教学系统的工作方法

一种基于ai助手的虚拟教学系统的工作方法

技术领域

1.本发明属于虚拟现实技术的教学应用领域,更具体地,涉及一种基于ai助手的虚拟教学系统的工作方法。

背景技术:

2.随着虚拟现实、人工智能、物联网、大数据、5g网络等新兴技术的发展,出现了众多的情景化、沉浸感的虚拟教学系统,如vr+直播、vr+全息的虚拟教学系统,可从多种角度呈现教学内容,调动学习者视觉、听觉等多感官参与教学情境,营造高度沉浸的学习体验。师生可以逼真的化身形态进入虚拟教学场景,但当前的虚拟化身模型尚不能自动理解环境中其他用户化身的语言、身体动作、脸部表情和手部姿势所传达的意图,导致虚拟教学系统的智能化不足,进而难以提供自然的交互体验。通过创建智能性具有智能性的师生化身模型,开展基于ai助手的虚拟教学,可增强虚拟教学环境的的智能性和交互性,降低师生使用虚拟教学系统的门槛,有望进一步提升虚拟教学系统的应用前景。

3.但当前虚拟教学场景还存在诸多的问题:(1)虚拟教学系统中用户化身进入虚拟教室环境,较难理解虚拟教室环境和教学活动所传达的意图,缺少标准数据集的支撑;(2)目前的虚拟教学环境中化身的智能性不足,较难根据环境、教学活动或其他用户的意图实时采取相应行动,既增加系统运行的成本,也给参与其中的用户带来较高的认知负荷;(3)当前虚拟教学系统多采用预先设定交互方式,缺乏自动化的支持和引导,难以助力虚拟教学活动组织,较难提供自动化的测试反馈。这些缺陷限制了虚拟教学系统对师生教学活动的智能化支撑。

技术实现要素:

4.针对现有技术的以上缺陷或改进需求,本发明提供了一种基于ai助手的虚拟教学系统的工作方法,为虚拟教学系统提供一种新的智能形态。

5.本发明的目的是通过以下技术措施实现的。

6.一种基于ai助手的虚拟教学系统的工作方法,包括以下步骤:s1,教学场景数据集的构建;采集教室环境和教学活动的视频数据;采用多元化标签标注教室布局与教学活动视频中的特征信息,通过空间锚点实现虚实教学内容的关联;构建教学场景模型、教学活动及其语言训练集;具体的s1.1教学视频采集;教师佩戴头戴式摄像头或可穿戴式传感器360

°

采集教学环境视频;采集日常教学活动的视频数据;包括以教师第一视角注视的内容,以及师生、生生与教学屏幕之间的互动;s1.2数据标注;使用human-ai loop注释工具,标注视频中教室布局的位置和关系信息,以及教学活动信息,并赋予多元化的标签;实现虚实教学环境的空间关联,通过空间锚点检索、追踪关联内容;s1.3数据集构建;从s1.1获得的视频集中提取教学环境中单一、完整的教学场景

模型;分析教师第一视角所关注区域教学活动的标注,建立叙事、对象和场景的时空关联;采用基于megatron 530b大型语言训练模型,构建教学活动语言训练集;s2,智能化虚拟化身的生成;创建具有真实感的师生化身模型,实时绑定其表情和动作;基于saas服务架构,实现教学内容分发、场景地图分享和注视区域的共享;为虚拟化身添加智能性,感知视场范围内的内容及其意图,预测化身的关注内容、操作动作和行为轨迹;具体的s2.1,创建真实感化身模型;创建化身模型,采用无标记人面追踪算法,定位、捕捉脸部特征,生成化身的实时表情;通过在用户身体上佩戴追踪传感器,将其实时转化、映射成虚拟化身的动作;s2.2,内容共享;基于saas服务架构,支持教师通过一键配置功能分发教学内容到参与教学活动的学生终端;并能实现各终端间场景地图的分享;利用注视点追踪技术,精确确定化身注视区域,实现注视区域的共享;s2.3,智能化虚拟化身生成;融合语音ai、计算机视觉、自然语言理解、推荐引擎和三维模拟技术,为化身模型添加智能性;感知用户视场范围内的资源、化身行为,以及理解各种知识主题及其意图;使用推荐引擎,预测师生化身在虚拟教学活动中的关注内容、操作动作和行为轨迹;s3,基于ai助手的虚拟教学组织;支持语音、手势交互,采用平滑过渡方法,拟合手势移动路径;建立虚拟教学活动的会话,开展协作式教学,使用可视化方式演示知识点;构建ai测试助手,支持训练与考核模式,构建操作统计、评价和反馈机制;具体的s3.1,智能化的交互;采用语音识别引擎,生成语音导航和检索工具,创建基于语音的教学资源;识别师生用户的手部教学动作,并在虚拟教学环境中执行;采用平滑过渡方法,拟合丢失位置期间的手势移动路径;s3.2,虚拟教学活动组织;创建虚拟教学环境的会话,支持师生开展教学活动;调用、分享教学资源,采用多人协作画笔,批注教学资源,开展协作式教学;使用可视化方式,演示知识点所对应的概念模型、结构特征和变化过程;s3.3,自动化测试反馈构建;创设可视化的虚拟测试场景,构建ai测试助手,支持训练与考核模式,记录测试过程数据并能进行综合评价;构建基于ai测试助手的操作统计、评价和反馈机制,用户可查看个人或整体测试报告。

7.本发明的有益效果在于:采集教室环境和教学活动的视频数据,采用多元化标签标注视频的特征信息,通过空间锚点实现虚实教学内容的关联,构建教学场景模型、教学活动及其语言训练集。创建具有真实感的师生化身模型,实时绑定其表情和动作,基于saas服务架构,实现教学内容分发、场景地图分享和注视区域共享;为虚拟化身添加智能性,感知视场范围内的内容及其意图,预测化身的关注内容、操作动作和行为轨迹。支持语音、手势交互,采用平滑过渡方法,拟合手势移动路径,建立虚拟教学活动的会话,开展协作式教学,使用可视化方式演示知识点,构建ai测试助手,支持训练与考核模式,创建操作统计、评价和反馈机制。随着虚拟现实、人工智能、物联网、5g网络等技术在教育领域的广泛应用,融合多种技术的新型教学环境正在涌现,为虚拟教学环境中提供更加智能的功能日益迫切。本发明有助于虚拟教学系统中智能性的生成,促进人工智能、虚拟现实与教育教学的深度融合。

附图说明

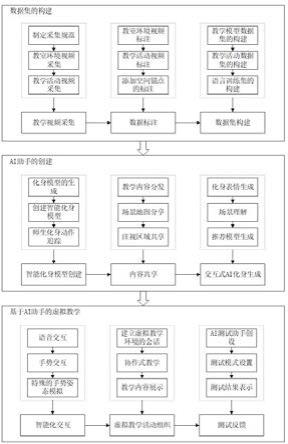

8.图1是本发明实施例中基于ai助手的虚拟教学系统的工作方法流程图。

9.图2是本发明实施例中教学场景与学生活动视频信息的采集轨迹示意图。

10.图3是本发明实施例中某智慧教室中的桌椅和电子屏幕标注示意图。

11.图4是本发明实施例中某教室中的小组讨论活动标注示意图。

12.图5是本发明实施例中基于megatron 530b的教学活动语言训练集的构建流程图。

13.图6是本发明实施例中虚拟教学环境的场景感知流程图。

14.图7是本发明实施例中基于nvdia merlin推荐引擎的师生虚拟化身交互推荐模型生成流程图。

15.图8是本发明实施例中douglas-peucker算法提取关键位置的步骤示意图。

16.图9是本发明实施例中“二氧化碳的实验室制取”实验的评分结算示意图。

17.图10是本发明实施例中“二氧化碳的实验室制取”实验的得分明细示意图。

18.图11是本发明实施例中“二氧化碳的实验室制取”实验中ai测试助手给出的操作步骤提示示意图。

19.图12是本发明实施例中ai测试助手判断“取药品”操作正确示意图。

具体实施方式

20.为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施案例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施案例仅仅用以解释本发明,并不用于限定本发明。此外,下面所描述的本发明各个实施方式中所涉及到的技术特征只要彼此之间未构成冲突就可以相互组合。

21.如图1所示,本实施例提供一种基于ai助手的虚拟教学系统的工作方法,包括如下步骤:(1)教学场景数据集的构建。采集教室环境和教学活动的视频数据;采用多元化标签标注教室布局与教学活动视频中的特征信息,通过空间锚点实现虚实教学内容的关联;构建教学场景模型、教学活动及其语言训练集。

22.(1-1)教学视频采集。教师佩戴头戴式摄像头或可穿戴式传感器,360

°

采集教学环境视频信息;选取多学段全科目的老师,采集日常教学活动的视频数据;包括以教师第一视角注视的内容,以及师生、生生与教学屏幕之间的互动。

23.(1-1-1)采集规范的制定。如图2所示,参照vr全景视频的采集规范,教师佩戴头戴式摄像头或可穿戴式传感器,从讲台位置出发,从前往后、从左往右的顺序,从正面、背面和侧面,360

°

采集教学环境中的场景与学生活动的视频信息。

24.(1-1-2)教室环境视频采集。在高校、职校、基础教育和幼教学段,选取全科目的教师,采集其所执行的真实教室中电子设备、课桌椅和四周墙壁的视频信息,教师在教室中沿路径行走,通过转动身体或头部,完成全角度的教室场景视频采集。

25.(1-1-3)教学活动视频采集。在讲授新课、小组讨论、师生互动和课堂总结的环节中,采集在常态化教学、自主探究和协作讨论活动过程中教师以第一视角注视的内容,包含教师答疑、学生提问、生生互动和教学大小屏互动。

26.(1-2)数据标注。使用human-ai loop注释工具,标注视频中教室布局的位置和关

系信息,以及教学活动信息,并赋予多元化的标签;实现虚实教学环境的空间关联,通过空间锚点检索、追踪关联内容。

27.(1-2-1)教室环境视频标注。利用human-ai loop注释工具标注所收集到视频中的教室布局信息,包括电子设备、课桌椅、讲台、地面和墙壁众多对象的位置、分布及其空间特征属性,并给出对象之间的包含、关联和邻近关系,图3展示某智慧教室中的桌椅和电子屏幕,主方向上的电子屏幕标签为“#电子屏幕#液晶显示器#教室正前方#”,将这些标注记录框、标签信息及其关联视频记录、存储为教室环境标注层。

28.(1-2-2)教学活动视频标注。从教学活动视频中排除已标注的教室环境信息,根据师生答疑、小组讨论、课堂实践或户外教学活动,使用注释工具将相应的视频内容用长方形框标注,并赋予多元化的标签,图4展示某教室中的小组讨论情形,标签为“#小组讨论#三人小组#正前方#”,记录并存储到教学活动标注层。

29.(1-2-3)添加空间锚点的标注。通过师生用户终端的空间定位器,实现虚拟教学环境与真实教学环境坐标系之间的映射和融合,教师可在真实教学环境中添加空间锚点标注,并上传到云端持久化存储,教学过程中可在虚拟教学环境中检索、追踪空间锚点。

30.(1-3)数据集构建。从步骤(1-1)获得的视频集中提取教学环境中单一、完整的教学场景模型;分析教师第一视角所关注区域教学活动的标注,建立叙事、对象和场景的时空关联;采用基于megatron 530b大型语言训练模型,构建教学活动语言训练集。

31.(1-3-1)教学模型数据集的构建。依据真实教学环境或活动中的视频标注,提取教学环境标注层中单一、完整的对象(视频中单个完整的对象,譬如完整的人体、墙壁等,而不是被视频图像剖分),将其定义为教学场景模型,将教学模型数据集上传到云端持久化存储,支持在虚拟教学环境构建过程中的检索和查询。

32.(1-3-2)教学活动数据集的构建。按照老师的学段、学科、年龄和性别属性,分析其第一视角所关注区域教学活动的标注,建立叙事、对象和场景的时空关联,使用自动化检测工具检查教室环境和教学活动之间标签的逻辑性,譬如各个子集中场景模型对象的标签一致性。

33.(1-3-3)语言训练集的构建。使用多模态语音转录的形式记录教学过程中师生、生生之间的对话,主题广泛的问题讨论、长而复杂的故事总结以及中英文互译,如图5所示,采用基于megatron 530b大型语言训练模型,切分对话、总结、讨论、互译数据,将切片数据分别送至各个训练节点,经分布式训练后,归类、构建教学活动语言训练集。

34.(2)智能化虚拟化身的生成。创建具有真实感的师生化身模型,实时绑定其表情和动作;基于saas服务架构,实现教学内容分发、场景地图分享和注视区域共享;为虚拟化身添加智能性,感知视场范围内的内容及其意图,预测化身的关注内容、操作动作和行为轨迹。

35.(2-1)创建真实感化身模型。使用激光技术或者选取动漫或历史人物创建化身模型;采用无标记人面追踪算法,定位、捕捉脸部特征,生成化身的实时表情;通过在用户身体上佩戴追踪传感器,将其实时转化、映射成虚拟化身的动作。

36.(2-1-1)化身模型生成。结合条纹、散斑和激光扫描技术,快速生成师生的三维几何模型,再将采集的纹理信息映射到几何模型,创建具有真实感的师生三维模型,或者选取动漫或历史人物的形象作为形象化的师生化身模型。

37.(2-1-2)化身表情生成。采用无标记人面追踪算法,通过计算机视觉检测技术,定位、捕捉视频中师生脸部特征点的位置和变化,根据眨眼、嘴巴运动和眉毛的ik运动特征,绑定、映射和驱动虚拟化身模型的脸部表情运动。

38.(2-1-3)师生化身动作追踪。真实教学环境中,在师生用户身体上佩戴追踪传感器,腰间、颈部各穿戴一个,手腕、胳膊、大腿与脚踝各穿戴两个,师生用户开始运动时,追踪传感器将计算并过滤所获得的运动数据,将其实时转化、映射成师生虚拟化身的动作。

39.(2-2)内容共享。基于saas服务架构,支持教师通过一键配置功能分发教学内容到参与教学活动的学生终端;并能实现各终端间场景地图的分享;利用注视点追踪技术,精确确定化身注视区域,实现注视区域的共享。

40.(2-2-1)教学内容分发。根据加入到虚拟教学教学活动的学生列表及其登录的vr终端,基于saas服务架构,支持教师通过一键配置功能将教学资源、应用工具和配套文件分发到各学生的vr终端,并配置各学生终端的主屏内容与安全设置控制。

41.(2-2-2)场景地图分享。追踪师生在虚拟教学环境中的位置、共同参与教学活动的场景空间,将所在虚拟环境、观察方向、教学资源和处以同一位置的众多师生化身,以场景地图的形式复制到所有参与师生终端的vr头显中,无须单独设置或额外校准。

42.(2-2-3)注视区域共享。依据师生化身模型在虚拟教学环境中所处位置及视线方向,利用tobii眼动追踪设备,获取师生的注视点位置,经空间定位配准,计算获取虚拟教学场景中师生ai化身的注视区域,采用自适应模式,控制渲染帧的超级采样区域,将着色器资源集中到该区域的虚拟教学画面。

43.(2-3)智能化虚拟化身生成。融合语音ai、计算机视觉、自然语言理解、推荐引擎和三维模拟技术,为化身模型添加智能性;感知用户视场范围内的资源、化身行为,以及理解各种知识主题及其意图;使用推荐引擎,预测师生化身在虚拟教学活动中的关注内容、操作动作和行为轨迹。

44.(2-3-1)创建智能化身模型。创建具有智能性的师生化身模型,融合语音ai、计算机视觉、自然语言理解、推荐引擎和三维模拟技术,使师生化身模型能够理解进入虚拟教学环境中其他用户说话的意图,并结合面部动画和渲染技术,实时模拟师生虚拟化身说话时的动作和表情。

45.(2-3-2)场景理解。如图6所示,采用nvdia metropolis计算机视觉框架,结合语音引擎,感知用户第一视角的视场范围内,虚拟教学环境中资源、其他师生化身的行为,理解化身之间谈论的各种知识主题及其表达的自身意图。

46.(2-3-3)推荐模型生成。如图7所示,使用nvdia merlin推荐引擎,基于nvtabular的gpu加速机制提取、转换师生虚拟化身交互数据,生成师生虚拟化身操作行为数据集,采用hugectr训练框架,按照多gpu和多节点分步训练推荐模型,使用nvidia tensorrt和triton server预测师生虚拟化身在虚拟教学活动中关注、停留的内容和场景,以及操作虚拟场景中ui、模型动作和行为轨迹。

47.(3)基于ai助手的虚拟教学组织。支持语音、手势交互,采用平滑过渡方法,拟合手势移动路径;建立虚拟教学活动的会话,开展协作式教学,使用可视化方式,演示知识点;构建ai测试助手,支持训练与考核模式,创建操作统计、评价和反馈机制。

48.(3-1)智能化的交互。采用语音识别引擎,生成语音导航和检索工具,创建基于语

音的教学资源;识别师生用户的手部教学动作,并在虚拟教学环境中执行;采用平滑过渡方法,拟合丢失位置期间的手势移动路径。

49.(3-1-1)语音交互。采用语音识别引擎,生成虚拟教学环境中语音导航和检索工具,支持教师创建基于语音的导航体验和语音驱动的教学资源,教学过程中采用在线语音方式实现师生、生生之间的讨论、理解和交流,支持各虚拟化身之间的交谈。

50.(3-1-2)手势交互。通过佩戴在用户头部的摄像头,采集师生用户的手部特征点,识别成对应的教学动作,通过集成unity的手部交互库,独立或组合使用grab、poke、target和select组件,在虚拟教学环境中执行抓取、选择、拖动和放置的手势动作。

51.(3-1-3)特殊的手部姿态模拟。若手部移动过快,导致视频图像中手部关键特征点的图像模糊,无法识别手部动作,此时将虚拟化身的手部停留在上次位置;当再次追踪到手部时,采用平滑过渡方法,将手部通过拟合路径移动到新位置上。

52.平滑过渡方法步骤如下:ⅰ.初始化a*算法参数,搜索手部初始与终点位置之间的可行路径。

[0053]ⅱ.利用douglas-peucker算法判断上述路径中位置的最优距离阈值ε,提取出关键位置,确保不与虚拟教学环境中其他障碍物发生碰撞,如图8所示,douglas-peucker算法提取关键位置的步骤如下:

①

连接路径首尾两个位置a和b,形成一条线段ab;

②

找出路径上距离ab最远的点c,计算c与ab的距离d;

③

如果距离d小于阈值ε,则线段ab作为该段路径的近似;

④

如果距离d大于阈值ε,则用c将线段ab分为ac和bc,c即为提取出的关键位置,并分别对线段ac和bc重复步骤

①

~

③

;

⑤

当所有可行路径处理完毕,依次连接各个关键位置形成折线,得到近似路径。

[0054]

iii.对提取出的关键位置构造三次样条函数,平滑处理近似路径,得到平滑后的手部移动路径。

[0055]

(3-2)虚拟教学活动组织。创建虚拟教学环境的会话,支持师生以多种形式开展教学活动;调用、分享教学资源,采用多人协作画笔,批注教学资源,开展协作式教学;使用可视化方式,演示知识点所对应的概念模型、结构特征和变化过程。

[0056]

(3-2-1)建立虚拟教学环境的会话。创建虚拟教学环境的会话进程,师生通过手机、平板或vr设备,以虚拟化身、视频窗口或两者混合的形式加入会话,支持在线讨论、主题教学、角色扮演、小组协作和竞争学习的开展。

[0057]

(3-2-2)协作式教学实现。师生化身在虚拟教学环境中,调用和分享视频、语音、ppt、文字和3d模型动画,使用多人协作画笔编辑、批注文本、图片和视频,共同完成实现师生的远程、异地的协作式教学、交流和讨论。

[0058]

(3-2-3)教学内容展示。教师化身在虚拟教学环境中开展一对一、一对多或多对多教学活动时,通过语音、动作和虚拟教鞭,向学习者展示三维可视化模型及动画特效,演示知识点所对应的概念模型、结构特征和变化过程。

[0059]

(3-3)自动化测试反馈构建。创设可视化的虚拟测试场景,构建ai测试助手,支持训练与考核模式,记录测试过程数据并能进行综合评价;构建基于ai测试助手的操作统计、评价和反馈机制,用户可查看个人或整体测试报告。

[0060]

(3-3-1)创设ai测试助手。根据教学计划和测试要求,创设可视化的虚拟测试场景,通过构建ai测试助手,还原真实环境下的测试过程,为参与测试活动的学习者提供操作指导、操作计时、错误反馈、报告记录、评分结算和实验练习报告服务。图9展示“二氧化碳的实验室制取”实验的评分结算,满分10分,本次操作得8分;实验错误记录显示:存在实验遗漏和答题错误,没有检查装置的气密性,二氧化碳实验室制取的主要操作问题回答错误。图10展示实验的得分明细,检查装置的气密性得0分,取药品得1分,收集气体得2分,验满得1分,填写实验报告并整理器材得4分。

[0061]

(3-3-2)测试模式的设置。在训练模式中,ai测试助手可为每个步骤的操作给出提示并判断正确与否;考核模式则屏蔽提示,并设置倒计时时间,学生在规定时间内完成测试,记录其操作步骤、错误次数、考核用时和错误详细信息,给出综合评分。图11展示“二氧化碳的实验室制取”实验中ai测试助手给出的操作步骤提示,图12展示ai测试助手判断“取药品”操作正确。

[0062]

(3-3-3)测试结果的表示。根据学习者的动作和非动作类操作、测试过程与考核结果,构建基于ai测试助手的操作统计、评价和反馈机制,将综合评分同步到云端,通过后台web评价服务,师生可查看个人测试报告或全班、全年级的整体测试报告。

[0063]

本说明书中未作详细描述的内容,属于本专业技术人员公知的现有技术。

[0064]

本领域的技术人员容易理解,以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1