图像处理装置、生成3D模型的方法、学习方法以及程序与流程

图像处理装置、生成3d模型的方法、学习方法以及程序

技术领域

1.本公开内容涉及图像处理装置、生成3d模型的方法、学习方法和程序,并且更具体地,涉及即使照明状态在每个时刻改变的情况下也能够生成高质量的3d模型和立体视频的图像处理装置、生成3d模型的方法、学习方法以及程序。

背景技术:

2.常规上已经提出了以下方法:通过使用通过感测真实3d空间而获得的信息,例如通过从不同视点对受摄体进行成像而获得的多视点视频来在观看空间中生成3d对象,并且生成对象看起来好像存在于观看空间中的视频(立体视频)(例如,专利文献1)。

3.[引文列表]

[0004]

[专利文献]

[0005]

专利文献1:wo 2017/082076 a

技术实现要素:

[0006]

[技术问题]

[0007]

然而,在专利文献1中,在诸如专用工作室的稳定照明环境中裁剪受摄体。专利文献1没有提及在照明环境时刻变化的诸如现场演出场地的环境中对受摄体的裁剪。

[0008]

照明环境的变化使得难以以高精度执行裁剪要建模的区域的处理(前景裁剪处理)。此外,由于照明状态反映在从通过对受摄体进行成像而获得的图像中生成的纹理中,所以受摄体以不同于受摄体的原始颜色的颜色而被观察。因此,存在难以消除照明影响的问题。

[0009]

本公开内容提出了即使在照明状态在每个时刻改变的情况下也能够生成高质量3d模型和立体视频的图像处理装置、生成3d模型的方法、学习方法以及程序。

[0010]

[问题的解决方案]

[0011]

为了解决上述问题,根据本公开内容的实施方式的图像处理装置包括:第一获取单元,第一获取单元获取图像,该图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得;第二获取单元,第二获取单元获取每个时刻的照明状态;裁剪单元,裁剪单元基于由第二获取单元获取的每个时刻的照明状态从图像中裁剪对象的区域;以及模型生成单元,该模型生成单元生成由裁剪单元裁剪的对象的3d模型。

[0012]

此外,根据本公开内容的实施方式的图像处理装置包括:获取单元,获取单元获取3d模型,3d模型通过基于在每个时刻改变的照明状态从图像裁剪对象而生成,该图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得;以及渲染单元,该渲染单元执行由获取单元获取的3d模型的渲染。

附图说明

[0013]

图1概述了服务器装置生成受摄体的3d模型的流程。

[0014]

图2示出了表示3d模型所需的数据的内容。

[0015]

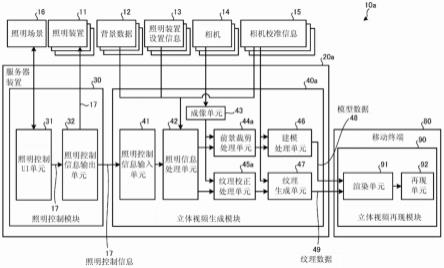

图3是示出第一实施方式的视频生成/显示装置的装置配置的一个示例的框图。

[0016]

图4是示出第一实施方式的服务器装置的硬件配置的一个示例的硬件框图。

[0017]

图5是示出第一实施方式的移动终端的硬件配置的一个示例的硬件框图。

[0018]

图6是示出第一实施方式的视频生成/显示装置的功能配置的一个示例的功能框图。

[0019]

图7示出了根据第一实施方式的视频生成/显示装置的输入/输出数据的数据格式的一个示例。

[0020]

图8示出了模拟照明的背景图像的照明信息处理单元的处理。

[0021]

图9示出了纹理校正处理的方法。

[0022]

图10示出了由第一实施方式的视频生成/显示装置显示的视频的一个示例。

[0023]

图11是示出第一实施方式中的照明信息处理的流程的一个示例的流程图。

[0024]

图12是示出第一实施方式中的前景裁剪处理的流程的一个示例的流程图。

[0025]

图13是示出第一实施方式中的纹理校正处理的流程的一个示例的流程图。

[0026]

图14是示出第二实施方式的视频生成/显示装置的功能配置的一个示例的功能框图。

[0027]

图15概述了使用深度学习的前景裁剪处理。

[0028]

图16概述了使用深度学习的纹理校正处理。

[0029]

图17是示出第二实施方式中的前景裁剪处理的流程的一个示例的流程图。

[0030]

图18是示出第二实施方式中的纹理校正处理的流程的一个示例的流程图。

[0031]

图19是示出生成学习数据的过程的一个示例的流程图。

具体实施方式

[0032]

下面将参照附图详细地描述本公开内容的实施方式。注意,在以下实施方式的每一个中,相同的附图标记被附加至相同的部分,以省略重复描述。

[0033]

此外,将根据以下项目顺序来描述本公开内容。

[0034]

1.第一实施方式

[0035]

1-1.前提说明-3d模型的生成

[0036]

1-2.前提说明-3d模型的数据结构

[0037]

1-3.视频生成/显示装置的示意配置

[0038]

1-4.服务器装置的硬件配置

[0039]

1-5.移动终端的硬件配置

[0040]

1-6.视频生成/显示装置的功能配置

[0041]

1-7.模拟照明的背景图像的方法

[0042]

1-8.前景裁剪处理

[0043]

1-9.纹理校正处理

[0044]

1-10.由第一实施方式的视频生成/显示装置执行的照明信息处理的流程

[0045]

1-11.由第一实施方式的视频生成/显示装置执行的前景裁剪处理的流程

[0046]

1-12.由第一实施方式的视频生成/显示装置执行的纹理校正处理的流程

[0047]

1-13.第一实施方式的效果

[0048]

2.第二实施方式

[0049]

2-1.第二实施方式的视频生成/显示装置的功能配置

[0050]

2-2.前景裁剪处理

[0051]

2-3.纹理校正处理

[0052]

2-4.由第二实施方式的视频生成/显示装置执行的处理的流程

[0053]

2-5.第二实施方式的变体

[0054]

2-6.第二实施方式的效果

[0055]

(1.第一实施方式)

[0056]

[1-1.前提说明-3d模型的生成]

[0057]

图1概述了服务器装置生成受摄体的3d模型的流程。

[0058]

如图1中所示,通过执行以下处理获得受摄体18的3d模型18m:利用多个相机14(14a、14b和14c)对受摄体18进行成像并且通过3d建模生成具有关于受摄体18的3d信息的3d模型18m。

[0059]

具体地,如图1中所示,多个相机14被布置在受摄体18的周围以便围绕真实世界中的受摄体18并且面向受摄体18。图1示出了围绕受摄体18布置的三个相机14a、14b和14c的示例。注意,在图1中,受摄体18是人。此外,相机14的数目不限于三个,并且可以提供更大数目的相机。

[0060]

通过使用从不同视点由三个相机14a、14b和14c同步立体地捕获的多个视点图像来执行3d建模。以三个相机14a、14b和14c的视频帧为单位来生成受摄体18的3d模型18m。

[0061]

3d模型18m具有关于受摄体18的3d信息。3d模型18m具有以例如称为多边形网格的网格数据的格式表示受摄体18的表面形状的形状信息。在网格数据中,由顶点和顶点的连接表示信息。此外,3d模型18m具有与每个多边形网格对应的表示受摄体18的表面状态的纹理信息。注意,3d模型18m的信息的格式不限于此。可以使用其他格式的信息。

[0062]

当重建3d模型18m时,执行所谓的纹理映射。在纹理映射中,根据网格位置附加表示网格的颜色、图案和感觉的纹理。在纹理映射中,期望附加视角相关(在下文中称为vd)的纹理以提高3d模型18m的真实性。这将根据在从任何虚拟视点捕获3d模型18m时的视点位置来改变纹理,使得可以获得更高质量的虚拟图像。然而,这增加了计算量,所以可以将视角无关的(在下文中称为vi)纹理附加至3d模型18m。

[0063]

包括读取的3d模型18m的内容数据被传送至用作再现装置的移动终端80并且被再现。通过渲染3d模型18m并再现包括3d模型18m的内容数据,在用户(观看者)的观看装置上显示包括3d形状的视频。

[0064]

在图1的示例中,诸如智能电话、平板终端的移动终端80被用作观看装置。也就是说,包括3d模型18m的图像被显示在移动终端80的显示器111上。

[0065]

[1-2.前提说明-3d模型的数据结构]

[0066]

接下来,将参照图2描述表现3d模型18m所需的数据的内容。图2示出了表现3d模型所需的数据的内容。

[0067]

由网格信息m和纹理信息t表现受摄体18的3d模型18m。网格信息m指示受摄体18的形状。纹理信息t指示受摄体18的表面的感觉(例如,色泽和图案)。

[0068]

网格信息m通过将3d模型18m的表面上的一些部分定义为顶点并且连接顶点(多边形网格)来表示3d模型18m的形状。此外,可以使用深度信息dp(未示出)而不是网格信息m。深度信息dp表示从用于观察受摄体18的视点位置到受摄体18的表面的距离。基于同一区域中的受摄体18的视差来计算受摄体18的深度信息dp。从由例如相邻成像装置捕获的图像中检测视差。注意,可以通过安装传感器(例如,飞行时间(tof)相机)和包括测距机构的红外(ir)相机而不是成像装置来获得到受摄体18的距离。

[0069]

在本实施方式中,两种类型的数据被用作纹理信息t。一种是不依赖于用于观察3d模型18m的视点位置(vi)的纹理信息ta。纹理信息ta是通过将3d模型18m的表面的纹理以诸如图2中的uv纹理映射的展开视图的格式存储而获得的数据。也就是说,纹理信息ta是视角无关的数据。例如,当3d模型18m是穿着衣服的人时,包括衣服以及人的皮肤和头发的图案的uv纹理映射被准备为纹理信息ta。然后,可以通过在表示3d模型18m的网格信息m的表面上附加与网格信息m对应的纹理信息ta来绘制3d模型18m(vi渲染)。然后,此时,即使当3d模型18m的观察位置改变时,相同的纹理信息ta也被附加至表示相同区域的网格。如上所述,通过将3d模型18m所穿戴的衣服的纹理信息ta附加至表示衣服的部分的所有网格来执行使用纹理信息ta的vi渲染。因此,一般而言,使用纹理信息ta的vi渲染数据量小且渲染处理的计算负荷轻。然而,要注意的是,附加的纹理信息ta是一致的,并且即使当观察位置改变时,纹理也不改变。因此,纹理的质量一般较低。

[0070]

另一种纹理信息t是依赖于用于观察3d模型18m的视点位置(vd)的纹理信息tb。纹理信息tb由通过从多个视点观察受摄体18获得的一组图像表示。也就是说,纹理信息ta是视角相关的数据。具体地,当由n个相机观察受摄体18时,通过由相应的相机同时捕获的n个图像表示纹理信息tb。然后,当在3d模型90m的任意网格中渲染纹理信息tb时,从n个图像中检测到对应于相应网格的所有区域。然后,对在多个检测到的区域中出现的每个纹理进行加权并且附加至相应的网格。如上所述,使用纹理信息tb的vd渲染一般数据量大且渲染处理的计算负荷重。然而,附加的纹理信息tb根据观察位置而改变,使得纹理的质量一般较高。

[0071]

[1-3.视频生成/显示装置的示意配置]

[0072]

接下来,将参照图3描述第一实施方式的视频生成/显示装置的示意配置。图3是示出第一实施方式的视频生成/显示装置的装置配置的一个示例的框图。

[0073]

视频生成/显示装置10a生成受摄体18的3d模型18m。此外,视频生成/显示装置10a再现通过从自由视点观看生成的受摄体18的3d模型18m而获得的立体视频。视频生成/显示装置10a包括服务器装置20a和移动终端80。注意,视频生成/显示装置10a是本公开内容中的图像处理装置的一个示例。此外,受摄体18是本公开内容中的对象的一个示例。

[0074]

服务器装置20a生成受摄体18的3d模型18m。服务器装置20a还包括照明控制模块30和立体视频生成模块40a。

[0075]

照明控制模块30给照明装置11设置每个时刻的照明控制信息17。照明控制信息17包括例如照明的位置、取向、颜色、亮度等。注意,多个照明装置11被连接以从不同的方向照明受摄体18。稍后将描述照明控制模块30的详细功能配置。

[0076]

立体视频生成模块40a基于由多个相机14捕获的相机图像来生成受摄体18的3d模型18m,所述多个相机14被安装成从不同的位置对受摄体18进行成像。稍后将描述立体视频

生成模块40a的详细功能配置。

[0077]

移动终端80接收从服务器装置20a传送的受摄体18的3d模型18m。然后,移动终端80再现通过从自由视点观看受摄体18的3d模型18m而获得的立体视频。移动终端80包括立体视频再现模块90。注意,移动终端80可以是任何类型,只要移动终端80具有视频再现功能即可,具体地例如智能电话、电视监视器和头戴式显示器(hmd)。

[0078]

立体视频再现模块90通过在当从自由视点观看到由立体视频生成模块40a生成的受摄体18的3d模型18m时的每个时刻渲染图像来生成立体视频。然后,立体视频再现模块90再现所生成的立体视频。稍后将描述立体视频再现模块90的详细功能配置。

[0079]

[1-4.服务器装置的硬件配置]

[0080]

接下来,将参照图4描述服务器装置20a的硬件配置。图4是示出第一实施方式的服务器装置的硬件配置的一个示例的硬件框图。

[0081]

服务器装置20a具有以下配置:其中,中央处理单元(cpu)50、只读存储器(rom)51、随机存取存储器(ram)52、存储单元53、输入/输出控制器54和通信控制器55通过内部总线60连接。

[0082]

cpu 50通过在ram 52上开发和执行存储在存储单元53中的控制程序p1和存储在rom 51中的各种数据文件来控制服务器装置20a的整体操作。也就是说,服务器装置20a具有由控制程序p1操作的普通计算机的配置。注意,可以经由诸如局域网、因特网和数字卫星广播的有线或无线传送介质来提供控制程序p1。此外,服务器装置20a可以利用硬件执行一系列处理。注意,由cpu 50执行的控制程序p1的处理可以按照本公开内容中描述的顺序按时间顺序执行,或者可以并行执行或在必要的定时(例如当进行调用时的定时)处执行。

[0083]

存储单元53包括例如闪存,并且存储由cpu 50执行的控制程序p1和受摄体18的3d模型18m。此外,3d模型18m可以由服务器装置20a本身生成,或者可以从另一外部装置获取。

[0084]

输入/输出控制器54经由触摸面板接口56获取触摸面板61的操作信息。触摸面板61堆叠在显示器62上,显示器62显示与照明装置11、相机14等有关的信息。此外,输入/输出控制器54经由显示接口57在显示器62上显示图像信息、与照明装置11有关的信息等。

[0085]

此外,输入/输出控制器54经由相机接口58连接至相机14。输入/输出控制器54执行相机14的成像控制以同时对受摄体18进行成像,其中多个相机14被布置成围绕受摄体18,输入/输出控制器54向服务器装置20a输入多个捕获的图像。

[0086]

此外,输入/输出控制器54经由照明接口59连接至照明装置11。输入/输出控制器54向照明装置11输出用于控制照明状态的照明控制信息17(参见图6)。

[0087]

此外,服务器装置20a经由通信控制器55与移动终端80进行通信。这使得服务器装置20a向移动终端80传送受摄体18的立体视频。

[0088]

[1-5.移动终端的硬件配置]

[0089]

接下来,将参照图5描述移动终端80的硬件配置。图5是示出第一实施方式的移动终端的硬件配置的一个示例的硬件框图。

[0090]

移动终端80具有以下配置:其中,cpu 100、rom 101、ram 102、存储单元103、输入/输出控制器104和通信控制器105通过内部总线109连接。

[0091]

cpu 100通过在ram 102上开发和执行存储单元103中所存储的控制程序p2和rom 101中所存储的各种数据文件来控制移动终端80的整体操作。也就是说,移动终端80具有由

控制程序p2操作的普通计算机的配置。注意,可以经由诸如局域网、因特网和数字卫星广播的有线或无线传送介质来提供控制程序p2。此外,移动终端80可以利用硬件执行一系列处理。注意,由cpu 100执行的控制程序p2的处理可以按照本公开内容中描述的顺序按时间顺序执行,或者可以并行执行或在必要的定时(例如当进行调用时的定时)处执行。

[0092]

存储单元103包括例如闪存,并且存储由cpu 100执行的控制程序p2和从服务器装置20a获取的3d模型18m。注意,3d模型18m是由移动终端80向服务器装置20a指示的特定受摄体18、即要绘制的受摄体18的3d模型。然后,3d模型18m包括如上所述的网格信息m、纹理信息ta和纹理信息tb。

[0093]

输入/输出控制器104经由触摸面板接口106获取触摸面板110的操作信息。触摸面板110堆叠在显示器111上,显示器111显示与移动终端80有关的信息。此外,输入/输出控制器104经由显示接口107在显示器111上显示包括受摄体18的立体视频等。

[0094]

此外,移动终端80经由通信控制器105与服务器装置20a进行通信。这使得移动终端80从服务器装置20a获取与3d模型18m等有关的信息。

[0095]

[1-6.视频生成/显示装置的功能配置]

[0096]

接下来,将参照图6描述第一实施方式的视频生成/显示装置10a的功能配置。图6是示出第一实施方式的视频生成/显示装置的功能配置的一个示例的功能框图。

[0097]

服务器装置20a的cpu 50在ram 52上开发并运行控制程序p1以实现图6中的照明控制ui单元31、照明控制信息输出单元32、照明控制信息输入单元41,照明信息处理单元42、成像单元43、前景裁剪处理单元44a、纹理校正处理单元45a、建模处理单元46和纹理生成单元47作为功能单元。

[0098]

照明控制ui单元31经由照明控制信息输出单元32向照明装置11提供诸如亮度、颜色和照明方向的照明控制信息17。具体地,照明控制ui单元31向照明控制信息输出单元32传送照明控制信息17,照明控制信息17对应于由操作触摸面板61的操作者在专用ui屏幕上设置的操作内容。注意,可以在照明控制ui单元31中预先生成并且存储照明场景16。照明场景16指示如何随时间设置照明装置11。

[0099]

照明控制信息输出单元32接收从照明控制ui单元31传送的照明控制信息17。此外,照明控制信息输出单元32向照明装置11、照明控制信息输入单元41和稍后描述的照明模拟控制单元73传送接收到的照明控制信息17。

[0100]

照明控制信息输入单元41从照明控制信息输出单元32接收照明控制信息17。此外,照明控制信息输入单元41向照明信息处理单元42传送照明控制信息17。注意,照明控制信息输入单元41是本公开内容中的第二获取单元的一个示例。

[0101]

照明信息处理单元42通过使用照明控制信息17、背景数据12、照明装置设置信息13和相机校准信息15基于那时的照明状态,即,在没有受摄体18的情况下发射照明的图像,来模拟照明背景图像。稍后将描述细节(参见图8)。

[0102]

成像单元43获取由相机14在每个时刻下对在照明状态在每个时刻改变的情形下的受摄体18(对象)进行成像而获得的图像。注意,成像单元43是本公开内容中的第一获取单元的一个示例。

[0103]

前景裁剪处理单元44a基于由照明控制信息输入单元41获取的在每个时刻的照明装置11的状态从由相机14捕获的图像中裁剪受摄体18(对象)的区域。注意,前景裁剪处理

单元44a是本公开内容中的裁剪单元的一个示例。注意,稍后将描述由前景裁剪处理单元44a执行的具体处理的内容。

[0104]

纹理校正处理单元45a基于由照明控制信息输入单元41获取的在每个时刻的照明装置11的状态根据在每个时刻的照明装置11的状态来校正在由相机14捕获的图像中出现的受摄体18的纹理。注意,纹理校正处理单元45a是本公开内容中的校正单元的一个示例。稍后将描述由纹理校正处理单元45a执行的具体处理的内容。

[0105]

建模处理单元46生成受摄体18(对象)由前景裁剪处理单元44a裁剪的3d模型。注意,建模处理单元46是本公开内容中的模型生成单元的一个示例。

[0106]

纹理生成单元47从相机14收集多条纹理信息、执行压缩和编码处理以及向立体视频再现模块90传送纹理信息。

[0107]

此外,移动终端80的cpu 100在ram 102上开发并运行控制程序p2以实现图6中的渲染单元91和再现单元92作为功能单元。

[0108]

渲染单元91绘制(渲染)从立体视频生成模块40a获取的受摄体18(对象)的3d模型和纹理。注意,渲染单元91是本公开内容中的绘制单元的一个示例。

[0109]

再现单元92在显示器111上再现由渲染单元91绘制的立体视频。

[0110]

注意,虽然图6中未示出,但是立体视频再现模块90可以被配置成从位于远处的多个立体视频生成模块40a中获取模型数据48和纹理数据49。然后,立体视频再现模块90可以用于将在远处成像的多个对象组合成一个立体视频并且再现该立体视频。在这种情况下,虽然在远处的照明环境通常不同,但是由立体视频生成模块40a生成的受摄体18的3d模型18m不受如稍后描述的模型生成时的照明的影响。立体视频再现模块90因此可以将在不同的照明环境下生成的多个3d模型18m组合并且在任何照明环境下再现多个3d模型18m。

[0111]

[1-7.模拟照明的背景图像的方法]

[0112]

接下来,将参照图7和图8描述模拟照明背景图像的照明信息处理单元的处理的内容。图7示出了根据第一实施方式的视频生成/显示装置的输入/输出数据的数据格式的一个示例。图8示出了模拟照明背景图像的照明信息处理单元的处理。

[0113]

从照明控制信息输出单元32向照明信息处理单元42输入照明控制信息17。此外,照明装置设置信息13、相机校准信息15和背景数据12被输入至照明控制信息处理单元42。

[0114]

这些输入信息具有图7中的数据格式。通过在每个时刻且针对每个照明装置11向照明装置11写入提供的各种参数值而获得照明控制信息17。

[0115]

通过针对每个照明装置11写入指示照明装置11的初始状态的各种参数值而获得照明装置设置信息13。注意,写入的参数是例如照明装置11的类型、安装位置、安装方向、颜色设置、亮度设置等。

[0116]

通过针对每个相机14写入相机14的内部校准数据和外部校准数据而获得相机校准信息15。内部校准数据与对于相机14唯一的内部参数(用于执行通过镜头或焦点设置最终获得的图像失真校正的参数)有关。外部校准数据与相机14的位置和取向有关。

[0117]

通过存储在预定照明状态下由每个相机14预先捕获的背景图像而获得背景数据12。

[0118]

然后,立体视频生成模块40a的前景裁剪处理单元44a输出模型数据48,模型数据48通过在考虑照明装置11的时间变化的情况下从由相机14捕获的图像裁剪受摄体18的区

域而获得。此外,立体视频生成单元40a的纹理校正处理单元45a输出纹理数据49,从纹理数据49去除了照明装置11的影响。

[0119]

通过针对每一帧来存储帧中的受摄体18的网格数据而获得模型数据48。

[0120]

通过针对每一帧存储每个相机14的外部校准数据和纹理图像而获得纹理数据49。注意,当相机14之间的位置关系固定时,外部校准数据需要存储在仅第一帧中。相对地,当相机14之间的位置关系改变时,外部校准数据被存储在相机14之间的位置关系已经改变的每一帧中。

[0121]

为了使前景裁剪处理单元44a在考虑照明装置11的时间变化的情况下裁剪受摄体18,照明信息处理单元42生成图8中的照明的背景图像ia。在每个时刻且针对每个相机14生成照明的背景图像ia。

[0122]

更具体地,照明信息处理单元42同时基于照明控制信息17和照明装置设置信息13来计算每个时刻的照明装置11的设置状态。

[0123]

照明信息处理单元42通过使用每个相机14的相机校准信息15对由每个相机14获得的背景数据12执行失真校正。然后,照明信息处理单元42通过针对失真校正的背景数据12基于照明装置11的设置状态在每个时刻对照明模式进行模拟来生成照明的背景图像ia。

[0124]

以这种方式生成的照明的背景图像ia被用作前景裁剪照明图像ib和纹理校正照明图像ic。前景裁剪照明图像ib和纹理校正照明图像ic实质上是相同的图像信息,但是为了方便在以下描述中将分别进行描述。

[0125]

前景裁剪照明图像ib和纹理校正照明图像ic是指示由每个相机14在每个时刻观察到的照明在什么状态下的2d图像信息。注意,信息的格式不限于图像信息,只要该信息指示在什么状态下观察到照明即可。

[0126]

[1-8.前景裁剪处理]

[0127]

上述前景裁剪照明图像ib表示照明状态,该照明状态被预测为要在相应时间由相应相机14捕获。前景裁剪处理单元44a(参见图6)通过使用前景/背景差来裁剪前景,即受摄体18的区域,前景/背景差通过从由相机14同时实际捕获的图像中减去前景裁剪照明图像ib而确定。

[0128]

注意,此时前景裁剪处理单元44a可以执行色度键处理。然而,注意,在本实施方式中,由于照明的影响,背景颜色针对每个区域而不同。因此,前景裁剪处理单元44a针对前景裁剪照明图像ib的每个区域设置要确定为背景的颜色的阈值,而没有基于通常使用的单一背景颜色执行色度键处理。然后前景裁剪处理单元44a通过将由相机14实际捕获的图像的亮度与设置的阈值进行比较,来区分颜色是否为背景并裁剪前景。

[0129]

此外,前景裁剪处理单元44a可以通过使用前景/背景差和色度键处理二者来裁剪受摄体18的区域。

[0130]

[1-9.纹理校正处理]

[0131]

接下来,将参照图9描述由视频生成/显示装置10a执行的纹理校正处理。图9示出了纹理校正处理的方法。

[0132]

纹理校正处理单元45a(参见图6)根据每个时刻照明装置11的状态对在由相机14捕获的图像中出现的受摄体18的纹理执行颜色校正。

[0133]

纹理校正处理单元45a对上述纹理校正照明图像ic和由相机14实际捕获的相机图

像id执行类似的颜色校正。然而,注意,在本实施方式中,由于照明的影响,受摄体18的纹理针对每个区域不同,使得如图9中所示,纹理校正照明图像ic和相机图像id中的每一个被划分成相同大小的多个小区域,并且针对每个小区域执行颜色校正。注意,颜色校正在数字图像处理中广泛执行,并且仅需要根据已知方法执行。

[0134]

纹理校正处理单元45a生成并且输出作为执行纹理校正处理的结果的纹理校正图像ie。也就是说,纹理校正图像ie指示被估计为要在标准照明下观察到的纹理。

[0135]

注意,纹理校正处理需要仅被应用于受摄体18的区域,使得纹理校正处理可以仅对相机图像id中的由上述前景裁剪处理裁剪的受摄体18的区域执行。

[0136]

可以通过如上所述的前景裁剪处理和纹理校正处理来获得与照明状态无关的受摄体18的3d模型18m。然后,立体视频再现模块90生成并显示图10中的立体视频iv。在立体视频iv中,再现了在相机14捕获相机图像id时同一时间的照明信息,并且绘制了受摄体18的3d模型18m。

[0137]

此外,当在不同照明状态下生成的多个对象被组合成一个立体视频时,可以去除成像时的照明的影响。

[0138]

[1-10.由第一实施方式的视频生成/显示装置执行的照明信息处理的流程]

[0139]

接下来,将参照图11描述由视频生成/显示装置10a执行的照明信息处理的流程。图11是示出第一实施方式中的照明信息处理的流程的一个示例的流程图。

[0140]

照明信息处理单元42获取由每个相机14预先获得的背景数据12(步骤s10)。

[0141]

照明信息处理单元42通过使用相机校准信息15(内部校准数据)对在步骤s10中获取的背景数据12执行失真校正(步骤s11)。

[0142]

照明信息处理单元42从照明控制信息输出单元32获取照明控制信息17。此外,照明信息处理单元42获取照明装置设置信息13(步骤s12)。

[0143]

照明信息处理单元42生成照明的背景图像ia(步骤s13)。

[0144]

照明信息处理单元42通过使用相机校准信息15(外部校准数据)对在步骤s13中生成的照明的背景图像ia执行失真校正(步骤s14)。

[0145]

照明信息处理单元42向前景裁剪处理单元44a输出照明的背景图像ia(步骤s15)。

[0146]

照明信息处理单元42向纹理校正处理单元45a输出照明的背景图像ia(步骤s16)。

[0147]

照明信息处理单元42确定这是否是最后一帧(步骤s17)。当确定这是最后一帧时(步骤s17:是),视频生成/显示装置10a结束图11中的处理。相比之下,当确定这不是最后一帧时(步骤s17:否),处理返回至步骤s10。

[0148]

[1-11.由第一实施方式的视频生成/显示装置执行的前景裁剪处理的流程]

[0149]

接下来,将参照图12描述由视频生成/显示装置10a执行的前景裁剪处理的流程。图12是示出第一实施方式中的前景裁剪处理的流程的一个示例的流程图。

[0150]

成像单元43获取在每个时刻由每个相机14捕获的相机图像id(步骤s20)。

[0151]

此外,成像单元43通过使用相机校准信息15(内部校准数据)对在步骤s20中获取的相机图像id执行失真校正(步骤s21)。

[0152]

前景裁剪处理单元44a从照明信息处理单元42获取照明的背景图像ia(步骤s22)。

[0153]

前景裁剪处理单元44a同时通过使用全景/背景差来从相机图像id中裁剪前景(受摄体18)(步骤s23)。

[0154]

前景裁剪处理单元44a确定这是否是最后一帧(步骤s24)。当确定这是最后一帧时(步骤s24:是),视频生成/显示装置10a结束图12中的处理。相比之下,当确定这不是最后一帧时(步骤s24:否),处理返回至步骤s20。

[0155]

[1-12.由第一实施方式的视频生成/显示装置执行的纹理校正处理的流程]

[0156]

接下来,将参照图13描述由视频生成/显示装置10a执行的纹理校正处理的流程。图13是示出第一实施方式中的纹理校正处理的流程的一个示例的流程图。

[0157]

成像单元43获取在每个时刻由每个相机14捕获的相机图像id(步骤s30)。

[0158]

此外,成像单元43通过使用相机校准信息15(内部校准数据)对在步骤s30中获取的相机图像id执行失真校正(步骤s31)。

[0159]

纹理校正处理单元45a从照明信息处理单元42获取照明的背景图像ia(步骤s32)。

[0160]

纹理校正处理单元45a同时将失真校正的相机图像id和照明的背景图像ia划分成相同大小的小区域(步骤s33)。

[0161]

纹理校正处理单元45a针对在步骤s33中划分的每个小区域执行纹理校正(步骤s34)。

[0162]

纹理校正处理单元45a确定这是否是最后一帧(步骤s35)。当确定这是最后一帧时(步骤s35:是),视频生成/显示装置10a结束图13中的处理。相比之下,当确定这不是最后一帧时(步骤s35:否),处理返回至步骤s30。

[0163]

[1-13.第一实施方式的效果]

[0164]

如上所述,根据第一实施方式的视频生成/显示装置10a(图像处理装置),成像单元43(第一获取单元)获取通过在照明装置11的状态在每个时刻改变的情况下在每个时刻对受摄体18(对象)进行成像而获得的图像,并且照明控制信息输入单元41(第二获取单元)获取成像单元43捕获图像时每个时刻照明装置11的状态。然后,前景裁剪处理单元44a(裁剪单元)基于由照明控制信息输入单元41获取的每个时刻照明装置11的状态从由成像单元43捕获的图像裁剪受摄体18。建模处理单元46(模型生成单元)生成由前景裁剪处理单元44a裁剪的受摄体18的3d模型。

[0165]

这允许即使如在音乐现场演出场地中照明状态在每个时刻改变时,也可以以高精度裁剪受摄体的区域。因此,可以生成高质量的3d模型和立体视频。

[0166]

此外,根据第一实施方式的视频生成/显示装置10a(图像处理装置),纹理校正处理单元45a(校正单元)基于由照明控制信息输入单元41获取的每个时刻照明装置11的状态来校正根据每个时刻照明装置11的状态的由成像单元43捕获的图像的纹理。

[0167]

这允许根据在照明状态在每个时刻改变的状态下捕获的图像中出现的受摄体18的纹理来估计在通常照明下观察到的受摄体18的纹理。

[0168]

此外,在第一实施方式的视频生成/显示装置10a(图像处理装置)中,照明装置11的状态包括照明装置11的至少位置、方向、颜色和亮度。

[0169]

这允许可靠地获取在每个时刻改变的照明装置11的详细状态。

[0170]

此外,在第一实施方式的视频生成/显示装置10a(图像处理装置)中,通过从受摄体18(对象)的周围对受摄体18的方向进行成像来获得由相机14捕获的图像。

[0171]

这允许生成通过从各种自由视点观察受摄体18而获得的3d模型18m。

[0172]

此外,在第一实施方式的视频生成/显示装置10a(图像处理装置)中,建模处理单

元46(模型生成单元)通过基于在每个时刻改变的照明装置11的状态从图像裁剪受摄体18的区域来生成受摄体18的3d模型18m,该图像通过在照明装置11的状态在每个时刻改变的情况下在每个时刻对受摄体18(对象)进行成像而获得。然后,渲染单元91(绘制单元)绘制由建模处理单元46生成的3d模型18m。

[0173]

这允许从在照明状态改变的情况下捕获的图像中裁剪受摄体18的区域以绘制从自由视点观看的视频。

[0174]

此外,在第一实施方式的视频生成/显示装置10a(图像处理装置)中,纹理校正处理单元45a(校正单元)基于在每个时刻改变的照明装置11的状态校正来自图像的根据每个时刻的照明装置11的状态的受摄体18的纹理,该图像通过在照明装置11的状态在每个时刻改变的情况下在每个时刻对受摄体18(对象)进行成像而获得。然后,渲染单元91(绘制单元)通过使用由纹理校正处理单元45a校正的纹理来绘制受摄体18。

[0175]

这允许在照明状态改变的情况下捕获的图像中出现的受摄体18的纹理被校正以绘制从自由视点观看的立体视频。

[0176]

此外,第一实施方式的视频生成/显示装置10a(图像处理装置)在每个时刻获取在照明状态在每个时刻改变的情况下通过在每个时刻对受摄体18(对象)进行成像而获得的图像和在每个时刻的照明装置11的状态,以及基于获取的在每个时刻的照明装置11的状态从受摄体18的图像中裁剪受摄体18的区域并生成受摄体18的模型数据48。

[0177]

这允许即使当照明状态在每个时刻改变时也以高精度裁剪受摄体的区域,使得可以生成高质量的3d模型。

[0178]

(2.第二实施方式)

[0179]

[2-1.第二实施方式的视频生成/显示装置的功能配置]

[0180]

第一实施方式中描述的视频生成/显示装置10a基于照明控制信息17获取每个时刻的照明状态,并且基于获取的每个时刻的照明状态执行前景裁剪和纹理校正。根据该方法,可以通过简单的计算处理来执行对象裁剪和纹理校正。为了稳定地应对更复杂的环境,需要提高通用性。以下要描述的第二实施方式的视频生成/显示装置10b通过使用经过使用深度学习创建的学习模型进一步增强了前景裁剪和纹理校正的通用性。

[0181]

将参照图14描述第二实施方式的视频生成/显示装置10b的功能配置。图14是示出第二实施方式的视频生成/显示装置的功能配置的一个示例的功能框图。注意,视频生成/显示装置10b的硬件配置与视频生成/显示装置10a的硬件配置相同(参见图4和图5)。

[0182]

视频生成/显示装置10b包括服务器装置20b和移动终端80。服务器装置20b包括照明控制模块30、立体视频生成模块40b、照明模拟模块70和学习数据生成模块75。

[0183]

照明控制模块30如第一实施方式中所述(参见图6)。

[0184]

与第一实施方式中描述的立体视频生成模块40a相比,立体视频生成模块40b包括前景裁剪处理单元44b而不是前景裁剪处理单元44a。此外,提供了纹理校正处理单元45b而不是纹理校正处理单元45a。

[0185]

前景裁剪处理单元44b基于通过学习由照明控制信息输入单元41获取的在每个时刻的照明装置11的状态与受摄体18的区域之间的关系而获得的学习数据,从由相机14捕获的图像中裁剪受摄体18(对象)的区域。

[0186]

纹理校正处理单元45b基于通过学习由照明控制信息输入单元41获取的在每个时

刻的照明装置11的状态与受摄体18的纹理之间的关系而获得的学习数据,校正根据每个时刻照明装置11的状态的在由相机14捕获的图像中出现的受摄体18的纹理。

[0187]

照明模拟模块70生成通过在背景cg数据19上模拟在每个时刻改变的照明状态而获得的照明模拟视频或基于照明控制信息17的立体视频。照明模拟模块70包括立体视频生成单元71、照明模拟生成单元72和照明模拟控制单元73。

[0188]

立体视频生成单元71基于受摄体18的模型数据48和纹理数据49以及虚拟视点位置来生成受摄体18的立体视频。

[0189]

照明模拟生成单元72基于给定的照明控制信息17、由立体视频生成单元71生成的立体视频以及虚拟视点位置来生成在被照明的状态下观察到受摄体18的模拟视频。

[0190]

照明模拟控制单元73向照明模拟生成单元72传送照明控制信息17和虚拟视点位置。

[0191]

学习数据生成模块75生成用于执行前景裁剪处理的学习模型和用于执行纹理校正处理的学习模型。学习数据生成模块75包括学习数据生成控制单元76。

[0192]

学习数据生成控制单元76基于由照明模拟模块70生成的照明模拟视频,生成用于前景裁剪的学习数据77和用于纹理校正的学习数据78。注意,学习数据77是本公开内容中的第一学习数据的一个示例。此外,学习数据78是本公开内容中的第二学习数据的一个示例。注意,稍后将描述生成学习数据77和学习数据78的具体方法。

[0193]

[2-2.前景裁剪处理]

[0194]

接下来,将参照图15描述由视频生成/显示装置10b执行的前景裁剪处理。图15概述了使用深度学习的前景裁剪处理。

[0195]

前景裁剪处理单元44b通过使用学习数据77从由相机14捕获的相机图像id中裁剪受摄体18的区域。此时基于由学习数据生成控制单元76生成的学习数据77(第一学习数据)来执行前景裁剪处理。

[0196]

学习数据77是一种由学习数据生成控制单元76生成的鉴别器,其使相机图像id、存储在背景数据12中的背景图像if、前景裁剪照明图像ib以及从其获得的受摄体18的区域之间的关系的深度学习被执行。然后,学习数据77同时响应于任何相机图像id、背景图像if和前景裁剪照明图像ib的输入而输出通过裁剪受摄体18的区域获得的受摄体图像ig。

[0197]

为了生成高度可靠的学习数据77,需要利用尽可能多的数据进行学习。因此,视频生成/显示装置10b通过照明模拟模块70尽可能详尽地生成学习数据77,照明模拟模块70向背景cg数据19模拟将基于模型数据48的3d模型布置在由照明装置11引起的照明环境中的立体视频。稍后将描述详细的处理流程(参见图19)。

[0198]

[2-3.纹理校正处理]

[0199]

接下来,将参照图16描述由视频生成/显示装置10b执行的纹理校正处理。图16概述了使用深度学习的纹理校正处理。

[0200]

纹理校正处理单元45b通过使用学习数据78将由相机14捕获的相机图像中的受摄体18的纹理校正成例如标准照明状态下的纹理。此时基于由学习数据生成控制单元76生成的学习数据78(第二学习数据)执行纹理处理。

[0201]

学习数据78是一种由学习数据生成控制单元76生成的鉴别器,其使相机图像id、纹理校正照明图像ic以及从其获得的受摄体18的纹理之间的关系的深度学习被执行。然

后,学习数据78同时响应于任何相机图像id和纹理校正照明图像ic的输入而输出对受摄体18的区域执行纹理校正的纹理校正图像ie。

[0202]

为了生成高度可靠的学习数据78,需要利用尽可能多的数据进行学习。因此,视频生成/显示装置10b通过照明模拟模块70尽可能详尽地生成学习数据78,照明模拟模块70模拟将基于模型数据48的3d模型布置在由照明装置11引起的照明环境中的立体视频。稍后将描述详细的处理流程(参见图19)。

[0203]

[2-4.由第二实施方式的视频生成/显示装置执行的处理的流程]

[0204]

接下来,将参照图17、图18和图19描述由视频生成/显示装置1b执行的处理的流程。图17是示出第二实施方式中的前景裁剪处理的流程的一个示例的流程图。图18是示出第二实施方式中的纹理校正处理的流程的一个示例的流程图。然后,图19是示出生成学习数据的具体过程的一个示例的流程图。

[0205]

首先,将参照图17描述第二实施方式中的前景裁剪处理的流程。成像单元43获取每个时刻由每个相机14捕获的相机图像id(步骤s40)。

[0206]

此外,成像单元43通过使用相机校准信息15(内部校准数据)对在步骤s40中获取的相机图像id执行失真校正(步骤s41)。

[0207]

前景裁剪处理单元44b从照明信息处理单元42获取前景裁剪照明图像ib。此外,前景裁剪处理单元44b获取背景图像if(步骤s42)。

[0208]

前景裁剪处理单元44b通过同时使用前景裁剪照明图像ib、背景图像if和失真校正的相机图像id作为输入使用学习数据77进行推断,并且从相机图像id中裁剪前景(步骤s43)。

[0209]

前景裁剪处理单元44b确定这是否是最后一帧(步骤s44)。当确定这是最后一帧时(步骤s44:是),视频生成/显示装置10b结束图17中的处理。相比之下,当确定这不是最后一帧时(步骤s44:否),处理返回至步骤s40。

[0210]

接下来,将参照图18描述第二实施方式中的纹理校正处理的流程。成像单元43获取每个时刻由每个相机14捕获的相机图像id(步骤s50)。

[0211]

此外,成像单元43通过使用相机校准信息15(内部校准数据)对在步骤s50中获取的相机图像id执行失真校正(步骤s51)。

[0212]

纹理校正处理单元45b从照明信息处理单元42与获取相机图像id同时获取纹理校正照明图像ic。此外,前景裁剪处理单元44b获取背景图像if(步骤s52)。

[0213]

纹理校正处理单元45b通过同时使用失真校正的相机图像id和纹理校正照明图像ic作为输入使用学习数据78进行推断,并且校正在相机图像id中出现的受摄体18的纹理(步骤s53)。

[0214]

纹理校正处理单元45b确定这是否是最后一帧(步骤s54)。当确定这是最后一帧时(步骤s54:是),视频生成/显示装置10b结束图18中的处理。相比之下,当确定这不是最后一帧时(步骤s54:否),处理返回至步骤s50。

[0215]

接下来,将参照图19描述生成学习数据77和78的过程。图19是示出生成学习数据的过程的一个示例的流程图。

[0216]

学习数据生成控制单元76从每个照明装置11的参数的组合中选择一个(步骤s60)。

[0217]

学习数据生成控制单元76从多条立体视频内容中选择一个(步骤s61)。

[0218]

学习数据生成控制单元76选择对象的一个布置位置和一个取向(步骤s62)。

[0219]

学习数据生成控制单元76选择一个虚拟视点位置(步骤s63)。

[0220]

学习数据生成控制单元76向照明模拟模块70提供选择的信息,并且生成模拟视频(立体视频和照明的背景图像ia(前景裁剪照明图像ib和纹理校正照明图像ic))(步骤s64)。

[0221]

学习数据生成控制单元76对在步骤s64中生成的模拟视频执行对象的裁剪处理和纹理校正处理,并且积累作为结果获得的学习数据77和学习数据78(步骤s65)。

[0222]

学习数据生成控制单元76确定所有虚拟视点位置候选是否已经选择(步骤s66)。当确定所有虚拟视点位置候选已经选择时(步骤s66:是),处理进行到步骤s67。相比之下,当确定所有虚拟视点位置候选没有选择时(步骤s66:否),处理返回至步骤s63。

[0223]

学习数据生成控制单元76确定对象的所有布置位置和取向是否已经选择(步骤s67)。当确定对象的所有布置位置和取向已经选择时(步骤s67:是),处理进行到步骤s68。相比之下,当确定对象的所有布置位置和取向没有选择时(步骤s67:否),处理返回至步骤s62。

[0224]

学习数据生成控制单元76确定所有的立体视频内容是否已经选择(步骤s68)。当确定所有的立体视频内容已经选择时(步骤s68:是),处理进行到步骤s69。相比之下,当确定所有的立体视频内容没有选择时(步骤s68:否),处理返回至步骤s61。

[0225]

学习数据生成控制单元76确定照明装置11的所有参数是否已经选择(步骤s69)。当确定照明装置11的所有参数已经选择时(步骤s69:是),视频生成/显示装置10b结束图19中的处理。相比之下,当确定照明装置11的所有参数没有选择时(步骤s69:否),处理返回至步骤s60。

[0226]

[2-5.第二实施方式的变体]

[0227]

尽管上面已经描述了第二实施方式,但是实现所描述的功能的方法可以具有各种变体。

[0228]

例如,当执行前景裁剪处理时,可以通过向学习数据生成控制单元76直接输入作为数字信息的照明控制信息17而不是使用前景裁剪照明图像ib来进行推断。此外,可以通过向学习数据生成控制单元76直接输入相机14的外部校准数据(指定相机14的位置和取向的数据)而不是输入虚拟视点位置来进行推断。此外,在标准照明下,可以在不输入背景图像if的情况下进行推断。

[0229]

此外,当执行纹理校正处理时,可以通过向学习数据生成控制单元76直接输入作为数字信息的照明控制信息17而不是使用纹理校正照明图像ic来进行推断。此外,可以通过向学习数据生成控制单元76直接输入相机14的外部校准数据(指定相机14的位置和取向的数据)而不是输入虚拟视点位置来进行推断。

[0230]

此外,可以通过使用纹理校正处理的结果通过常规的方法来执行前景裁剪处理。在这种情况下,仅需要学习数据78,并且不需要生成学习数据77。

[0231]

注意,任何格式的模型都可以用作学习数据生成控制单元76执行深度学习时使用的输入/输出模型。此外,当推断新的帧时可以反馈前一帧的推断结果。

[0232]

[2-6.第二实施方式的效果]

[0233]

如上所述,根据第二实施方式的视频生成/显示装置10b(图像处理装置),前景裁剪处理单元44b(裁剪单元)基于学习数据77(第一学习数据)从由成像单元43(第一获取单元)获取的图像中裁剪受摄体18的区域,学习数据77(第一学习数据)通过学习由照明控制信息输入单元41(第二获取单元)获取的每个时刻照明装置11的状态与受摄体18(对象)的区域之间的关系而获得。

[0234]

这允许无论使用环境如何都以高精度裁剪受摄体18(前景)。

[0235]

此外,根据第二实施方式的视频生成/显示装置10b(图像处理装置),纹理校正处理单元45b(校正单元)基于学习数据78(第二学习数据)来校正根据每个时刻照明装置11的状态的由成像单元43(第一获取单元)获取的受摄体18的纹理,学习数据78(第二学习数据)通过学习由照明控制信息输入单元41(第二获取数据)获取的每个时刻照明装置11的状态与受摄体18(对象)的纹理之间的关系而获得。

[0236]

这允许无论使用环境如何受摄体18的纹理都被稳定地校正。

[0237]

此外,根据第二实施方式的视频生成/显示装置10b(图像处理装置),建模处理单元46(模型生成单元)通过基于学习数据77(第一学习数据)从具有受摄体18的图像中裁剪受摄体18的区域来生成受摄体18的3d模型18m,学习数据77通过学习每个时刻照明装置11的状态与每个时刻获得的图像中的受摄体18(对象)的区域之间的关系而获得。

[0238]

这允许无论使用环境如何都以高精度生成受摄体18的3d模型18m。特别地,可以同时推断通过从周围同时捕获受摄体18获得的图像,这可以给从每个图像中裁剪区域的结果提供一致性。

[0239]

此外,根据第二实施方式的视频生成/显示装置10b(图像处理装置),纹理校正处理单元45b(校正单元)基于通过学习每个时刻照明装置11的状态与受摄体18(对象)的纹理之间的关系而获得的学习数据78(第二学习数据)来校正根据每个时刻照明装置11的状态的在每个时刻成像的受摄体18的纹理。

[0240]

这允许无论使用环境如何受摄体18的纹理都被稳定地校正。特别地,可以同时推断通过从周围同时捕获受摄体18获得的图像,这可以给每个图像的纹理校正的结果提供一致性。

[0241]

此外,在第二实施方式的视频生成/显示装置10b(图像处理装置)中,学习数据生成控制单元76通过以下方式生成学习数据77:在每个时刻获取通过在照明装置11的状态在每个时刻改变的情况下在每个时刻对受摄体18(对象)进行成像而获得的图像以及照明装置11的状态;基于获取的每个时刻照明装置11的状态从包括受摄体18的图像中裁剪受摄体18;以及学习每个时刻照明装置11的状态与裁剪的受摄体18的区域之间的关系。

[0242]

这允许用于裁剪受摄体18的学习数据77容易地生成。特别地,生成立体视频的视频生成/显示装置10b可以容易且详尽地生成自由地组合各种虚拟视点、各种照明条件和各种受摄体的大量学习数据77。

[0243]

此外,在第二实施方式的视频生成/显示装置10b(图像处理装置)中,学习数据生成控制单元76通过以下方式生成学习数据78:在每个时刻获取通过在照明装置11的状态在每个时刻改变的情况下在每个时刻对受摄体18(对象)进行成像而获得的图像以及照明装置11的状态;以及基于获取的每个时刻照明装置11的状态来学习每个时刻照明装置11的状态与裁剪的受摄体18的纹理之间的关系。

[0244]

这允许用于校正受摄体18的纹理的学习数据78容易地生成。特别地,生成立体视频的视频生成/显示装置10b可以容易且详尽地生成自由地组合各种虚拟视点、各种照明条件和各种受摄体的大量学习数据78。

[0245]

注意,在本说明书中阐述的效果仅仅是示例而不是限制。可以获得其他效果。此外,本公开内容的实施方式不限于上述实施方式,并且可以在不脱离本公开内容的主旨的情况下进行各种修改。

[0246]

例如,本公开内容还可以具有如下配置。

[0247]

(1)

[0248]

一种图像处理装置,包括:

[0249]

第一获取单元,第一获取单元获取图像,所述图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得;

[0250]

第二获取单元,第二获取单元获取每个时刻的照明状态;

[0251]

裁剪单元,裁剪单元基于由第二获取单元获取的每个时刻的照明状态从图像裁剪对象的区域;以及

[0252]

模型生成单元,该模型生成单元生成由裁剪单元裁剪的对象的3d模型。

[0253]

(2)

[0254]

根据(1)所述的图像处理装置,还包括:

[0255]

校正单元,校正单元基于由第二获取单元获取的在每个时刻的照明状态来校正根据每个时刻的照明状态的图像的纹理。

[0256]

(3)

[0257]

根据(1)或(2)所述的图像处理装置,其中,裁剪单元进行如下操作:

[0258]

基于通过学习由第二获取单元获取的每个时刻的照明状态与对象的区域之间的关系而获得的第一学习数据,从由第一获取单元获取的图像裁剪对象的区域。

[0259]

(4)

[0260]

根据(1)至(3)中任一项所述的图像处理装置,其中,校正单元进行如下操作:

[0261]

基于通过学习由第二获取单元获取的每个时刻的照明状态与对象的纹理之间的关系而获得的第二学习数据,校正根据每个时刻的照明状态的由第一获取单元获取的对象的纹理。

[0262]

(5)

[0263]

根据(1)至(4)中任一项所述的图像处理装置,其中,照明状态包括:

[0264]

至少照明位置、照明方向、照明颜色和照明亮度。

[0265]

(6)

[0266]

根据(1)至(5)中任一项所述的图像处理装置,其中,图像是通过从对象的周围对对象的方向进行成像而获得的。

[0267]

(7)

[0268]

一种图像处理装置,包括:

[0269]

模型生成单元,模型生成单元通过基于在每个时刻改变的照明状态从图像裁剪对象的区域来生成对象的3d模型,该图像是通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得的,以及

[0270]

绘制单元,绘制单元绘制由模型生成单元生成的3d模型。

[0271]

(8)

[0272]

根据(7)所述的图像处理装置,还包括:

[0273]

校正单元,校正单元基于在每个时刻改变的照明状态校正来自图像的根据每个时刻的照明状态的对象的纹理,该图像是通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得的,

[0274]

其中,绘制单元通过使用由校正单元校正的纹理来绘制对象。

[0275]

(9)

[0276]

根据(7)或(8)所述的图像处理装置,

[0277]

其中,模型生成单元进行如下操作:

[0278]

通过基于第一学习数据从图像裁剪对象的区域来生成对象的3d模型,所述第一学习数据是通过学习每个时刻的照明状态与来自在每个时刻捕获的图像的对象的区域之间的关系而获得的。

[0279]

(10)

[0280]

根据(7)至(9)中任一项所述的图像处理装置,

[0281]

其中,校正单元进行如下操作:

[0282]

基于通过学习每个时刻的照明状态与对象的纹理之间的关系而获得的第二学习数据,校正根据每个时刻的照明状态的在每个时刻成像的对象的纹理。

[0283]

(11)

[0284]

一种生成3d模型的方法,包括:

[0285]

获取图像,该图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得;

[0286]

获取每个时刻的照明状态;

[0287]

基于获取的每个时刻的照明状态从图像裁剪对象;以及

[0288]

生成已裁剪的对象的3d模型。

[0289]

(12)

[0290]

一种学习方法,包括:

[0291]

获取图像,该图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得;

[0292]

获取每个时刻的照明状态;

[0293]

基于已获取的每个时刻的照明状态从图像裁剪对象;以及

[0294]

学习每个时刻的照明状态与已裁剪的对象的区域之间的关系。

[0295]

(13)

[0296]

根据(12)所述的学习方法,包括:

[0297]

获取图像,该图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得;

[0298]

获得每个时刻的照明状态;以及

[0299]

基于已获取的每个时刻的照明状态,学习每个时刻的照明状态与对象的纹理之间的关系。

[0300]

(14)

[0301]

一种使计算机用作如下单元的程序:

[0302]

第一获取单元,第一获取单元获取图像,该图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得;

[0303]

第二获取单元,第二获取单元获取每个时刻的照明状态;

[0304]

裁剪单元,裁剪单元基于由第二获取单元获取的每个时刻的照明状态从图像裁剪对象的区域;以及

[0305]

模型生成单元,该模型生成单元生成由裁剪单元裁剪的对象的3d模型。

[0306]

(15)

[0307]

一种使计算机用作如下单元的程序:

[0308]

模型生成单元,模型生成单元通过基于在每个时刻改变的照明状态从图像裁剪对象的区域来生成对象的3d模型,该图像通过在照明状态在每个时刻改变的情况下在每个时刻对对象进行成像而获得。

[0309]

绘制单元,绘制单元绘制由模型生成单元生成的3d模型。

[0310]

[附图标记列表]

[0311]

10a、10b:视频生成/显示装置(图像处理装置)

[0312]

11:照明装置

[0313]

12:背景数据

[0314]

13:照明装置设置信息

[0315]

14:相机

[0316]

15:相机校准信息

[0317]

16:照明场景

[0318]

17:照明控制信息

[0319]

18:受摄体(对象)

[0320]

18m:3d模型

[0321]

20a、20b:服务器装置

[0322]

30:照明控制模块

[0323]

31:照明控制ui单元

[0324]

32:照明控制信息输出单元

[0325]

40a、40b:立体视频生成模块

[0326]

41:照明控制信息输入单元(第二获取单元)

[0327]

42:照明信息处理单元

[0328]

43:成像单元(第一获取单元)

[0329]

44a、44b:前景裁剪处理单元(裁剪单元)

[0330]

45a、45b:纹理校正处理单元(校正单元)

[0331]

46:建模处理单元(模型生成单元)

[0332]

47:纹理生成单元

[0333]

48:模型数据

[0334]

49:纹理数据

[0335]

70:照明模拟模块

[0336]

75:学习数据生成模块

[0337]

77:学习数据(第一学习数据)

[0338]

78:学习数据(第二学习数据)

[0339]

80:移动终端

[0340]

90:立体视频再现模块

[0341]

91:渲染单元(绘制单元)

[0342]

92:再现单元

[0343]

ia:照明的背景图像

[0344]

ib:前景裁剪照明图像

[0345]

ic:纹理校正照明图像

[0346]

id:相机图像

[0347]

ie:纹理校正图像

[0348]

if:背景图像

[0349]

ig:受摄体图像

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1