面向互补视角多目标协同跟踪的虚拟视频生成方法

动;

15.(2)拍摄者站在人群外部,向人群中心拍摄,相机左右摆动镜头,拍摄者跟随镜头 转动;

16.(3)拍摄者站在人群外部,向人群中心拍摄,拍摄者会围绕人群进行圆周运动,在 移动过程中相机左右摆动,拍摄者跟随镜头转动;

17.(4)拍摄者站在人群内部,向背离人群中心的位置拍摄,拍摄者不移动,但随着相 机摆动。

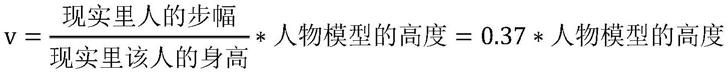

18.其中,所述行人的移动速度为:

19.n为场景中人物总数

20.赋予人物模型一个基准旋转速度ω=5

°

/帧和最大偏移旋转速度δω=10

°

/帧,并约 定每个人的旋转速度为:

21.n为场景中总人数。

22.进一步地,所述各视角视频中每帧所有人的矩形标注框位置及其id的生成方法具体 为:

23.在第一遍生成完虚拟场景视频后,会再运行(行人总数+拍摄者总数)遍,id从0到(行 人总数+拍摄者总数-1),每一遍都是第一遍运行过程的完全复现;

24.在第一遍运行时对随机生成的人物的位置、动作,相机的位置数据进行存储,保证之 后的运行与第一遍完全相同;从第二遍开始,每遍只显示一个人,通过一遍的运行得到各 视角下只包含该人物的虚拟视频;

25.第一遍运行结束后,移除场景文件,将所有拍摄相机的渲染背景设置为纯黑色,得到 每个人物在所有相机下只包含单个人物且其它背景全为黑色的虚拟视频;

26.对于背景全黑只有人物不是黑色的图片,直接遍历图片中的所有像素,找到最小非黑 像素横坐标xmin、最小非黑像素纵坐标ymin、最大非黑像素横坐标xmax、最大非黑像素 纵坐标ymax,则(xmin,ymin)和(xmax,ymax)即为该人物标注框的左上和右下坐标。

27.其中,所述去除步骤5)中得到的各视角视频中每帧中被遮挡严重人物的标注框具体 为:

28.将本帧中所有的标注框按面积大小由大到小排序,从左到右遍历所有未删除的标注框, 在遍历过程中再遍历当前选中标注框所有右侧未删除的标注框,若两者标注框的交叠面积 超过面积较小标注框面积的1/2,则删除较小面积的标注框。

29.本发明提供的技术方案的有益效果是:

30.1、本方法旨在解决针对多视角下多目标感知视频分析任务的研究需要大量数据的支 撑,而大量真实数据的采集与标注成本巨大的问题;本方法可以较为轻松的获取多视角相 机下视频分析所需的训练数据;

31.2、本发明可以为面向多视角(特别是顶视和水平视角构成的互补视角)多目标感知 的视频分析任务生成大量且丰富的数据,同时比手工标注数据所花费的人力、物力少得多, 并且更加得快速、准确;

32.3、本发明具有可调节性,可以根据任务的需求模拟场景,在生成虚拟视频数据时

式摄像机(例如google glass和gopro)安装在佩戴者的头上,可以提供同一组物体的水 平视图。本发明实施例为多视角下的多目标感知视频分析任务生成数据,其中空中有一个 顶视摄像头,而地面上有多个水平摄像头。由于俯视图和水平视图可以很好地进行信息的 互补,因此它可以为户外监视提供更好的覆盖范围和灵活性,可以有效应用于协作跟踪、 个人/团体活动识别等任务中。

43.实施例1

44.本发明实施例采用的技术方案为:

45.一种基于3d开发工具的面向多视角多目标感知的虚拟视频数据生成方法,参见图1, 该方法包括以下步骤:

46.步骤s1:加载人物模型和场景建模,创建数据存储路径,随机初始并存储行人和多视 角相机(和拍摄者)的初始位置;

47.步骤s2:设置行人和相机(和拍摄者)的初始位置,按帧控制行人和相机(和拍摄者) 的运动,并存储各视角相机下拍摄的包含行人和拍摄者的视频数据;

48.步骤s3:删除场景建模,并把各视角相机的渲染背景设置为纯黑色,设置行人和相机 (和拍摄者)的初始位置与步骤s2相同,每次只显示一人,按帧控制行人和相机(和拍摄 者)的运动,并存储各视角相机下拍摄的该人纯黑背景视频数据;

49.步骤s4:重复步骤s3,直至所有行人和拍摄者的单人纯黑背景视频数据存储完毕后结 束;

50.步骤s5:根据步骤s4中得到的所有单人纯黑背景视频计算得到步骤s2中得到的各视 角视频中每帧所有人的矩形标注框位置及其id;

51.步骤s6:去除步骤s5中得到的各视角视频中每帧中被遮挡严重人物的标注框,剩余 的标注框即为所求。

52.综上所述,本发明实施例通过上述步骤s1-s6解决了多视角下多目标感知视频分析任 务所需数据集的采集与标注成本巨大的问题。

53.实施例2

54.下面结合具体的实例对实施例1中的方案进行进一步地介绍,详见下文描述:

55.(一)行人位置的初始化

56.本发明实施例中所有行人的初始位置设定在一个圆环区域中随机产生,圆环的内径和 外径可以自行设定,通过在[内径,外径]之间随机产生半径长度,并在[0

°

,360

°

)之间随机产 生旋转角度,可以根据极坐标变换计算得到每个人物的初始位置,之后为每个人物在[0

°

,360

°

)之间随机产生一个初始朝向,即完成了行人位置初始化的操作。

[0057]

(二)相机类型及初始化

[0058]

本发明实施例中有两种类型的相机,顶视视角相机和水平视角相机,顶视视角相机模 拟无人机拍摄的画面无需放置拍摄者,而水平视角相机模拟的是手持相机或可穿戴相机拍 摄的画面需要放置拍摄者。同时总共有4种类型的水平视角相机可供选择:(1)拍摄者站 在人群外部,向人群中心拍摄,拍摄者不会移动,同时相机视野也不会移动。对于这种类 型的相机,每帧无需对拍摄者和相机进行更新。(2)拍摄者站在人群外部,向人群中心拍 摄,相机会左右摆动镜头,拍摄者跟随镜头转动。对于这种相机,在每帧进行更新时,需 将此帧相机摆动的偏移角度和摆动方向记录下来,存到数组中(因为可能存在多个水平视 角

相机),同时为了防止相机摆动幅度过大,导致视野中基本没有行人的情况发生,需对 摆动范围进行限制,在此限制摆渡范围在[-15

°

,15

°

]之间,通过设定相机每帧的摆动度数 和相机当前帧的偏移角度,来计算、更新相机的摆动方向和偏移角度,以此将相机的摆动 范围限制在规定的角度内。(3)拍摄者站在人群外部,向人群中心拍摄,同时拍摄者会围 绕人群进行圆周运动,在移动过程中相机会左右摆动,拍摄者跟随镜头转动。对于这种相 机,在每帧进行更新时,要先根据拍摄者旋转速度和圆周半径长度计算该帧下相机和拍摄 者的位置,然后再对相机和拍摄者进行左右摆动的更新,方法与类型(2)相机一致,这 里就不再赘述。(4)拍摄者站在人群内部,向背离人群中心的位置拍摄,拍摄者不会移动, 但会随着相机摆动。对于这种相机,在每帧进行更新时无需对相机的摆动范围进行限制, 360度都可以旋转,只需要根据相机摆动速度,每帧对相机和拍摄者进行转动即可。

[0059]

为了使这些相机从较大视角差异的位置进行拍摄,相机和对应的拍摄者也需要进行初 始化操作。对于顶视相机而言,初始化时只需要随机生成[0

°

,360

°

)的旋转角度,即将相机 根据竖直轴随机旋转一个角度。对于水平视角下第(1)、(2)种相机,在初始化时只需要根据 设定的相机半径长度和随机生成的初始旋转角度,即可通过极坐标变换算出初始的相机和 拍摄者位置;对于第(3)种相机在初始化时,需要每使用一个第(3)种相机就将相机半径长度 缩小一定值,这样能避免拍摄者在移动时轨迹重叠;最后第(4)种相机由于要生成在人群内 部,所以在初始化时相机半径要小于人群初始化圆环内径的长度。同时水平视角相机在初 始化时还可以进行抬头、低头、左歪头和右歪头的设置,以满足不同视角下视频研究分析 的需求。

[0060]

(三)行人轨迹控制

[0061]

人物模型可以通过每帧改变其朝向,并向自己朝向的前方移动来改变物理位置,因此 为了使生成视频中场景里的行人具有不同的行动轨迹,除了将这些行人初始化在不同的位 置外,还可以让它们具有不同的旋转速度和移动速度。在本发明实施例中赋予了人物模型 以下参数:

[0062]

基准移动速度:

[0063][0064]

最大偏移速度:

[0065]

δv=0.05*人物模型的高度

[0066]

由此每个人的移动速度为:

[0067]

n为场景中人物总数

[0068]

这样场景中的每个人便拥有了不同移动速度,接下来同样赋予人物模型一个基准旋转 速度ω=5

°

/帧和最大偏移旋转速度δω=10

°

/帧,并约定每个人的旋转速度为:

[0069]

n为场景中总人数

[0070]

这样场景中的每个人也拥有了不同的旋转速度,至此行人的轨迹控制问题得到了解决。

[0071]

(四)计算视频每帧中所有人的矩形标注框位置及id

[0072]

对于生成的虚拟视频数据,由于场景背景和其它人物干扰的存在,无法直接获取每个人物的标注框。因此为了能够生成所有人物的标注框,本发明实施例在第一遍生成完虚拟场景视频后,会再运行(行人总数+拍摄者总数)遍(id从0到(行人总数+拍摄者总数-1)),每一遍都是第一遍运行过程的完全复现,同时为了保证在每遍运行中相同相机在相同帧拍摄到的内容是完全一样的,需要在第一遍运行时对一些随机生成的数据进行存储,例如:行人的初始生成位置及朝向、拍摄者及相机的初始位置等,之后每运行一遍就使用这些保存的数据重新进行初始化,即可保证人物的位置、动作,相机的位置与第一遍完全相同。同时为了排除其它人物的干扰,从第二遍开始,每遍只显示一个人,这样通过一遍的运行就可以得到各视角下只包含目标人物的虚拟视频。

[0073]

最后为了排除场景和背景的干扰,需要在系统第一遍运行结束后,移除场景文件,同时将所有拍摄相机的渲染背景设置为纯黑色,这样最终可以得到每个人物在所有相机下只包含单个人物且其它背景全为黑色的虚拟视频。图2是原视频中一帧和经过该方法处理后其中一个人物对应帧的图片。

[0074]

接着对于背景全黑只有人物不是黑色的图片来说,直接遍历图片中的所有像素,找到最小非黑像素横坐标xmin、最小非黑像素纵坐标ymin、最大非黑像素横坐标xmax、最大非黑像素纵坐标ymax,则(xmin,ymin)和(xmax,ymax)即为该人物标注框的左上和右下坐标。

[0075]

(五)去除被遮挡严重行人的标注框

[0076]

利用上一步找到一帧中所有人物标注框的位置后,还需要解决遮挡的问题,即不应该对被挡住大部分身体的人物画出标注框。方法是将本帧中所有的标注框按面积大小由大到小排序,从左到右遍历所有未删除的标注框,在遍历过程中再遍历当前选中标注框所有右侧未删除的标注框,若两者标注框的交叠面积超过面积较小标注框面积的1/2,则删除较小面积的标注框。如图3即为视频一帧中所有人物画出标注框并去除遮挡后的结果,可以看出除了最右边的人由于身体被挡住了大部分,没有保留其标注框外,其他所有人的标注框都保留了下来并且位置正确。

[0077]

参考文献

[0078]

[1]sunx,zhengl.dissectingpersonre-identificationfromtheviewpointofviewpoint[c]//2019ieee/cvfconferenceoncomputervisionandpatternrecognition.ieee,2020.

[0079]

[2]huyt,chenhs,huik,etal.sail-vos:semanticamodalinstancelevelvideoobjectsegmentation

–

asyntheticdatasetandbaselines[c]//2019ieee/cvfconferenceoncomputervisionandpatternrecognition.ieee,2019.

[0080]

[3]zhaoj,hanr,gany,etal.humanidentificationandinteractiondetectionincross-viewmulti-personvideoswithwearablecameras[c]//acmmultimediaconference2020.acm,2020.

[0081]

本发明实施例对各器件的型号除做特殊说明的以外,其他器件的型号不做限制,只要能完成上述功能的器件均可。

[0082]

本领域技术人员可以理解附图只是一个优选实施例的示意图,上述本发明实施例

序号 仅仅为了描述,不代表实施例的优劣。

[0083]

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则 之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1