一种视频目标跟踪方法及装置与流程

1.本发明属于视频目标跟踪技术领域,具体涉及一种视频目标跟踪方法及装置。

背景技术:

2.视频目标跟踪在智能监控、视觉导航等领域得到了越来越广泛的应用。视频目标跟踪一般是指在已知视频第一帧图像给出的待跟踪目标的位置和尺寸信息的情况下,在后续的视频帧图像中,跟踪器能够准确找到目标并预测其位置尺寸。由于目标跟踪不需要知道待跟踪目标的类别信息,因此在实际应用中具有较强的灵活性。传统的目标跟踪的方法是基于手工设计的待跟踪目标特征描述子,但基于手工设计的特征描述子无法充分考虑以上各种因素的影响。

3.近几年来,随着深度学习的出现,待跟踪目标的特征描述是由深度学习网络模型自主学习待跟踪目标的特征描述。目前基于深度学习网络模型的目标跟踪方法大致可以分为粒子滤波和孪生网络匹配两类。粒子滤波的方法是在跟踪目标周围撒大量粒子(粒子的位置和尺寸是通过跟踪目标的信息进行一定的变化得到的),然后对每一个粒子进行得分判断,取得分最高的几个粒子信息的平均值,得到当前目标位置和尺寸信息。孪生网络匹配的方法是将跟踪目标进行提取特征,然后以跟踪目标为中心取一个较大的图像块(目标搜索区域)并提取特征,然后对两个特征进行匹配,取响应最大的位置和尺寸进行回归作为当前目标位置和尺寸。现有孪生网络匹配法一般没有考虑跟踪目标和搜索区域的完全交互,仅仅是基于响应最大值进行处理,导致在光照不同、遮挡、阴影、待跟踪目标形变等场景下跟丢目标的情况出现。

技术实现要素:

4.为了解决现有技术中存在的上述问题,本发明提供一种视频目标跟踪方法及装置。

5.为了实现上述目的,本发明采用以下技术方案。

6.第一方面,本发明提供一种视频目标跟踪方法,包括以下步骤:

7.将跟踪目标图像和搜索区域图像分别输入到基于注意力机制、结构和权重相同的第一特征提取模块和第二特征提取模块,进行图像特征提取;

8.将提取的跟踪目标图像特征和搜索区域图像特征输入到基于交互注意力机制的特征融合模块,进行特征融合;

9.将特征融合模块输出的融合特征输入到分类和回归模块,输出包围框内的图像类别及包围框的位置及尺寸信息,所述图像类别包括前景和背景。

10.进一步地,在特征提取前还包括:将跟踪目标图像和搜索区域图像分别输入到结构和权重相同的第一图像块编码模块和第二图像块编码模块,将输入图像分割成多个图像块,并将每个图像块中的像素值合成为一个向量。

11.更进一步地,所述第一特征提取模块和第二特征提取模块均采用transformer自

注意力机制,通过结构相似的窗口多头自注意力层和移位窗口多头自注意力层进行自注意力计算提取图像特征;窗口多头自注意力层将特征图划分成大小为m的窗口,并每个窗口上进行自注意力计算;移位窗口多头自注意力层在窗口多头自注意力层的下一层,通过将窗口整体平移1/2个m的大小,在下一层得到新的窗口以提高感受野,并将平移后的小窗口拼接以保证窗口的数目不变。

12.更进一步地,在特征融合前还包括:将第一特征提取模块和第二特征提取模块提取的特征输入到特征级联模块,将提取的两种特征分别拉长为一维向量后进行连接,将特征图由三维数据平铺为一维向量。

13.更进一步地,所述特征融合模块包括编码器和解码器,编码器通过对特征级联模块输出的一维向量进行自注意力计算,实现对两种特征的充分交互;解码器采用交叉注意力机制,通过对跟踪目标图像特征和搜索区域图像特征分别进行加权得到q、k、v,然后利用分别进行本分支和跨分支的注意力计算实现特征融合,其中,q、k、v为三个权重矩阵,dk为k的维度。

14.进一步地,所述方法还包括:在输入第一帧图像前,基于已知目标信息采用少样本学习方法对网络模型进行离线训练;在输入一定帧图像后,更新目标信息,并采用少样本学习方法对网络模型进行在线更新。

15.第二方面,本发明提供一种视频目标跟踪装置,包括:

16.注意力机制特征提取模块,用于将跟踪目标图像和搜索区域图像分别输入到基于注意力机制、结构和权重相同的第一特征提取模块和第二特征提取模块,进行图像特征提取;

17.注意力机制特征融合模块,用于将提取的跟踪目标图像特征和搜索区域图像特征输入到基于交互注意力机制的特征融合模块,进行特征融合;

18.包围框分类回归模块,用于将特征融合模块输出的融合特征输入到分类和回归模块,输出包围框内的图像类别及包围框的位置及尺寸信息,所述图像类别包括前景和背景。

19.进一步地,在特征提取前还包括:将跟踪目标图像和搜索区域图像分别输入到结构和权重相同的第一图像块编码模块和第二图像块编码模块,将输入图像分割成多个图像块,并将每个图像块中的像素值合成为一个向量。

20.更进一步地,所述第一特征提取模块和第二特征提取模块均采用transformer自注意力机制,通过结构相似的窗口多头自注意力层和移位窗口多头自注意力层进行自注意力计算提取图像特征;窗口多头自注意力层将特征图划分成大小为m的窗口,并每个窗口上进行自注意力计算;移位窗口多头自注意力层在窗口多头自注意力层的下一层,通过将窗口整体平移1/2个m的大小,在下一层得到新的窗口以提高感受野,并将平移后的小窗口拼接以保证窗口的数目不变。

21.更进一步地,在特征融合前还包括:将第一特征提取模块和第二特征提取模块提取的特征输入到特征级联模块,将提取的两种特征分别拉长为一维向量后进行连接,将特征图由三维数据平铺为一维向量。

22.与现有技术相比,本发明具有以下有益效果。

23.本发明通过将跟踪目标图像和搜索区域图像分别输入到基于注意力机制的第一

特征提取模块和第二特征提取模块进行图像特征提取,将提取的跟踪目标图像特征和搜索区域图像特征输入到基于交互注意力机制的特征融合模块进行特征融合,将特征融合模块输出的融合特征输入到分类和回归模块输出包围框内的图像类别及包围框的位置及尺寸信息,实现了基于视频图像的目标跟踪。本发明通过采用注意力机制进行图像特征提取,可获得感兴趣区域特征以提高特征提取效率;采用交互注意力机制进行特征融合使目标特征和搜索区域特征充分交互,解决了现有技术因为光照、形变、遮挡等情况跟丢目标的问题。

附图说明

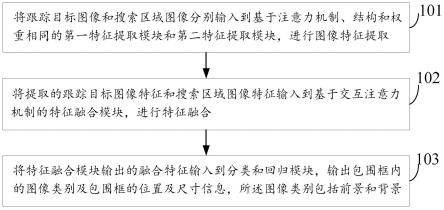

24.图1为本发明实施例一种视频目标跟踪方法的流程图。

25.图2为一种孪生网络的模型结构示意图。

26.图3为特征提取模块工作时图像块覆盖示意图。

27.图4为交叉注意力机制示意图。

28.图5为本发明实施例一种视频目标跟踪装置的方框图。

具体实施方式

29.为使本发明的目的、技术方案及优点更加清楚、明白,以下结合附图及具体实施方式对本发明作进一步说明。显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

30.图1为本发明实施例一种视频目标跟踪方法的流程图,包括以下步骤:

31.步骤101,将跟踪目标图像和搜索区域图像分别输入到基于注意力机制、结构和权重相同的第一特征提取模块和第二特征提取模块,进行图像特征提取;

32.步骤102,将提取的跟踪目标图像特征和搜索区域图像特征输入到基于交互注意力机制的特征融合模块,进行特征融合;

33.步骤103,将特征融合模块输出的融合特征输入到分类和回归模块,输出包围框内的图像类别及包围框的位置及尺寸信息,所述图像类别包括前景和背景。

34.本实施例提出一种视频目标跟踪方法。视频目标跟踪是在连续帧的视频序列中建立与待跟踪目标的位置关系,根据这些位置关系估计待跟踪目标的运动轨迹。通常情况下,目标跟踪任务中视频序列第一帧是目标检测的结果或者是给定目标的真实位置,所以其大小和位置是确定的,通过目标跟踪算法计算后续帧中目标的具体位置和大小。在基于深度学习的诸多跟踪算法中,孪生网络是最典型也是最成功的代表之一。孪生网络跟踪方法是将跟踪目标进行提取特征,然后以跟踪目标为中心取一个较大的搜索区域并提取特征,然后对两个特征进行匹配,取响应最大的位置和尺寸进行回归作为当前目标位置和尺寸。现有孪生网络跟踪方法一般没有考虑跟踪目标和搜索区域的完全交互,仅仅是基于响应最大值进行处理,导致在遮挡等场景下跟丢目标的情况出现。为此,本实施例通过设计基于注意力机制的孪生网络模型,实现目标特征和搜索区域特征充分交互,从而解决因遮挡丢失目标问题。其整体结构示意图如图2所示,主要由特征提取模块、特征融合模块、分类和回归模块等组成。

35.本实施例中,步骤101主要用于对跟踪目标图像和搜索区域图像进行特征提取。本

实施例通过将跟踪目标图像和搜索区域图像分别输入到第一特征提取模块和第二特征提取模块,实现两种图像特征的提取。跟踪目标的信息包含在输入的第一帧视频图像中,由人工标注或目标检测模型获得。搜索区域是后续视频帧图像中的一个较大的图像块区域。第一特征提取模块和第二特征提取模块采用结构和权重相同网络模型,为了便于获得图像的感兴趣区域特征,本实施例采用基于注意力机制的特征提取模块。注意力机制是在计算机能力有限的情况下,借鉴人脑的注意力机制,只关心一些关键的信息输入进行处理,来提高神经网络的效率。注意力机制的计算可分为两步:一是在所有输入信息上计算注意力分布;二是根据注意力分布计算输入信息的加权求和。加权系数即注意力分布αi=softmax(fiw

att

q),表示输入向量fi与询问向量q的相关程度。

36.本实施例中,步骤102主要用于进行特征融合。本实施例通过将提取的跟踪目标特征和搜索区域特征输入到特征融合模块,实现两种特征的充分融合。现有技术一般只是关注两种特征的匹配程度,不进行特征融合,当出现遮挡等情况时匹配度无法达到设定的阈值从而导致丢失目标。本实施例通过对两种特征进行融合,将跟踪目标信息融入搜索区域特征中,使遮挡等因素的影响相对减弱,可解决目标丢失问题。为了使两种特征能够充分融合,本实施例的特征融合模块采用交叉注意力机制。交叉注意力机制的核心思想是计算多个输入对单个输入的影响或单个输入对多个输入的影响,其目的是将多个输入融合成一个输入或将多个输入信息补充到一个输入中。因此,采用交叉注意力机制可实现跟踪目标特征和搜索区域特征的充分融合。

37.本实施例中,步骤103主要用于输出包围框内图像的类别和包围框的位置尺寸信息。本实施例通过将融合特征输入到分类和回归模块得到所述类别和位置信息。分类和回归模块由分类子模块和回归子模块两部分组成。分类子模块输出图像类别和包围框的粗略位置,图像类别包括前景和背景两个类别;包围框是一个矩形,其位置尺寸信息一般用矩形的左上角和右下角坐标表示。回归子模块对包围框的粗略位置数据进一步优化,从而得到最终的包围框结果。

38.作为一可选实施例,在特征提取前还包括:将跟踪目标图像和搜索区域图像分别输入到结构和权重相同的第一图像块编码模块和第二图像块编码模块,将输入图像分割成多个图像块,并将每个图像块中的像素值合成为一个向量。

39.本实施例给出了对输入图像进行图像块划分编码的一种技术方案。为了减小数据处理量,本实施例将输入图像分割成多个图像块,将图像的最小单位由像素变为图像块,每个图像块由多个像素组成,即用含多个像素的像素矩阵对图片进行分割,并将每个图像块中的像素值合成为一个向量。本实施例通过将跟踪目标图像和搜索区域图像分别输入到第一图像块编码模块和第二图像块编码模块,实现图像块的划分和编码。由于本实施例采用孪生网络结构,因此第一图像块编码模块和第二图像块编码模块的结构和权重参数均相同。

40.作为一可选实施例,所述第一特征提取模块和第二特征提取模块均采用transformer自注意力机制,通过结构相似的窗口多头自注意力层和移位窗口多头自注意力层进行自注意力计算提取图像特征;窗口多头自注意力层将特征图划分成大小为m的窗口,并每个窗口上进行自注意力计算;移位窗口多头自注意力层在窗口多头自注意力层的下一层,通过将窗口整体平移1/2个m的大小,在下一层得到新的窗口以提高感受野,并将平

移后的小窗口拼接以保证窗口的数目不变。

41.本实施例给出了第一特征提取模块和第二特征提取模块的一种技术方案。本实施例中,两个特征提取模块均采用transformer自注意力机制。transformer的本质上是一个encoder-decoder的结构。transformer中抛弃了传统的cnn和rnn,整个网络结构完全是由注意力机制组成。与传统自注意力机制相比,增加了多头自注意力机制,进一步完善了自注意力机制的性能。transformer的编码器和解码器都包含有以下几个组件:堆叠的自注意力层、逐点的全连接层以及位置编码等。编码器由n个相同的层组成,每一层有两个子层:多头自注意力机制和前馈全连接神经网络,并在任意子层之间使用一个残差连接,然后进行层归一化。解码器也由n个相同的层组成,每层包含三个子层:屏蔽的多头注意力机制、多头注意力机制以及前馈全连接神经网络。本实施例通过采用窗口多头自注意层(w-msa)和移位窗口多头自注意层(sw-msa)的结构,在每个窗口大小的图像块上(如图3(c))进行自注意力计算,从而得到最后的自注意力机制特征。窗口多头自注意层(w-msa)和移位窗口多头自注意层(sw-msa)的架构相似,w-msa是将特征图中划分成大小为m的窗口,每个窗口进行自注意力计算,如图3(a)所示。sw-msa是在w-msa的下一层,如图3(b)所示,通过将窗口整体平移1/2个m的大小,在下一层得到新的窗口,可大大增加感受野,在一定程度上减小遮挡等影响。为了保证窗口的数目不变,将平移后的小窗口拼接。这样可以满足窗口外的信息交互。

42.作为一可选实施例,在特征融合前还包括:将第一特征提取模块和第二特征提取模块提取的特征输入到特征级联模块,将提取的两种特征分别拉长为一维向量后进行连接,将特征图由三维数据平铺为一维向量。

43.本实施例给出了将提取的两种特征级联的一种技术方案。本实施例通过设置一个特征级联模块,将输入的跟踪目标特征和搜索区域特征分别拉长为一维向量,然后拼接在一起,最后得到一个级联的一维向量。本实施例相当于将特征图由三维数据平铺为一维向量后输入到特征融合模块,通过注意力计算实现特征融合。

44.作为一可选实施例,所述特征融合模块包括编码器和解码器,编码器通过对特征级联模块输出的一维向量进行自注意力计算,实现两种特征的充分交互;解码器采用交叉注意力机制,通过对跟踪目标图像特征和搜索区域图像特征分别进行加权得到q、k、v,然后利用分别进行本分支和跨分支的注意力计算实现特征融合,其中,q、k、v为三个权重矩阵,dk为k的维度。

45.本实施例给出了特征融合模块的一种技术方案。本实施例中,特征融合模块由编码器和解码器组成。编码器实现对跟踪目标特征和搜索区域特征的自注意力操作,使得两种特征能够充分交互。自注意力机制是注意力机制的变体,只有一个输入,将序列中的每个单元和该序列中的所有单元进行注意力计算,减少了对外部信息的依赖,更擅长捕捉数据或特征的内部相关性。自注意力机制是利用三个可学习的变量将输入线性映射为k、q与v,然后将q与k相乘得到k对q的注意力权重后,利用归一化的权重和v来生成输入的上下文信息。计算公式为解码器采用交叉注意力机制,通过对跟踪目标特征和搜索区域特征分别进行加权得到q、k、v,然后利用分别进行本分支和跨分支的注意力计算实现特

征融合。如图4所示。由于跟踪目标特征在进行交叉注意力操作时,需要将跟踪目标的特征进行复制叠加,如图4的跟踪目标原始特征中每个颜色都是像素复制叠加之后的结果。经过复制叠加后,搜索区域的窗口大小对应目标特征中的像素,实现了窗口与像素之间的交互。

46.作为一可选实施例,所述方法还包括:在输入第一帧图像前,基于已知目标信息采用少样本学习方法对网络模型进行离线训练;在输入一定帧图像后,更新目标信息,并采用少样本学习方法对网络模型进行在线更新。

47.本实施例给出了模型训练的一种技术方案。本实施例的孪生网络模型在第一帧视频图像输入前需要进行离线训练。第一帧视频图像中的目标信息是已知的(标定好的),输入第一帧视频图像后基于已知的目标信息对后续的视频图像进行目标跟踪。输入一定帧图像后(如50帧)需要对目标信息进行更新,同时对网络模型进行在线训练。为了减小训练时间提高训练速度,本实施例的离线训练和在线训练均采用少样本学习方法。少样本学习学习的是一个模型参数的更新规则,包括任务学习模型和元学习模型。元学习模型是用于学习怎样优化学习模型的优化算法模型。这样训练得到的学习模型学习到一个通用的初始化,可以使得在后续训练时收敛更快。训练集使用miniimage数据集,数据集中一共有64类,每类600个样本。训练过程中,每个训练循环中,从训练集中随机采样5类(每类5个样本)来训练学习模型。然后从训练集中随机采样的5类中剩下样本中每类采样15个样本,根据学习模型中的损失来优化元学习模型。最终训练得到的学习模型的特征提取模块作为图一中全注意力特征提取模块。

48.图5为本发明实施例一种视频目标跟踪装置的组成示意图,所述装置包括:

49.注意力机制特征提取模块11,用于将跟踪目标图像和搜索区域图像分别输入到基于注意力机制、结构和权重相同的第一特征提取模块和第二特征提取模块,进行图像特征提取;

50.注意力机制特征融合模块12,用于将提取的跟踪目标图像特征和搜索区域图像特征输入到基于交互注意力机制的特征融合模块,进行特征融合;

51.包围框分类回归模块13,用于将特征融合模块输出的融合特征输入到分类和回归模块,输出包围框内的图像类别及包围框的位置及尺寸信息,所述图像类别包括前景和背景。

52.本实施例的装置,可以用于执行图1所示方法实施例的技术方案,其实现原理和技术效果类似,此处不再赘述。后面的实施例也是如此,均不再展开说明。

53.作为一可选实施例,在特征提取前还包括:将跟踪目标图像和搜索区域图像分别输入到结构和权重相同的第一图像块编码模块和第二图像块编码模块,将输入图像分割成多个图像块,并将每个图像块中的像素值合成为一个向量。

54.作为一可选实施例,所述第一特征提取模块和第二特征提取模块均采用transformer自注意力机制,通过结构相似的窗口多头自注意力层和移位窗口多头自注意力层进行自注意力计算提取图像特征;窗口多头自注意力层将特征图划分成大小为m的窗口,并每个窗口上进行自注意力计算;移位窗口多头自注意力层在窗口多头自注意力层的下一层,通过将窗口整体平移1/2个m的大小,在下一层得到新的窗口以提高感受野,并将平移后的小窗口拼接以保证窗口的数目不变。

55.作为一可选实施例,在特征融合前还包括:将第一特征提取模块和第二特征提取

模块提取的特征输入到特征级联模块,将提取的两种特征分别拉长为一维向量后进行连接,将特征图由三维数据平铺为一维向量。

56.以上所述,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到的变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以权利要求的保护范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1