一种增强机器人抓取检测模型鲁棒性的训练方法

一种增强机器人抓取检测模型鲁棒性的训练方法

【技术领域】

1.本发明属于计算机视觉与机器人领域,具体涉及一种增强机器人抓取检测模型鲁棒性的训练方法。

背景技术:

2.伴随着信息技术与控制技术的发展,机器人不仅在在教育娱乐、医疗健康以及家庭服务等场景中有着极大的应用,并且在航空航天领域同样扮演了十分重要的角色,如空间遥操作机器人和玉兔号月球探测车。而抓取物体是机器人在完成这些任务所需要的众多功能中最关键的步骤,也是机器人与环境交互和完成复杂任务的基础。通过在机械臂末端安装各式操作夹具,机器人可实现对各种物体的抓取操作,为人类生活带来巨大帮助。

3.为实施目标抓取,抓取检测模型输入rgb信息和depth信息,输出抓取点和相应的抓取向量,通过变换矩阵将像素坐标系中的抓取向量映射到机器人坐标系中,完成最终的抓取。然而,现有的基于神经网络的抓取检测方法主要是在相同分布的高质量干净数据进行性能训练并验证,即使在公共数据集中取得了很高的成功率,这些结果也很难说明该模型在现实中也具有很高的成功率。由于各种外部因素的干扰,在实际应用中难以避免数据分布的变化,如光照条件、环境温度、相机微抖动等,直接影响图像质量,导致抓取失败。即使这些干扰非常细微,它们也不会改变数据结构和语义信息,即使是人眼也很难察觉。但事实上,神经网络很容易受到这些数据变化的影响,同时很容易被人眼忽略,并且在很多情况下,会为错误的预测提供很高的置信度分数。同时,许多研究已经证明基于神经网络的视觉算法表现出对颜色和纹理的偏好。当输入图像中形状和纹理冲突时,卷积神经网络更倾向于使用颜色和纹理进行预测,而不是形状。这也是一些干扰只改变了图像的细微纹理,从而降低了抓取检测模型的性能的根本原因。

技术实现要素:

4.本发明的目的是提供一种增强机器人抓取检测模型鲁棒性的训练方法,以解决现有机器人抓取模型在现实操纵背景下抓取成功率低下的不足。

5.本发明的技术方案是,一种增强机器人抓取检测模型鲁棒性的训练方法,包括以下内容:

6.步骤s1、抓取检测网络模型构建:采用基于轻量级的vgg网络的encoder-decoder模型;

7.步骤s2、抓取检测网络模型的训练和测试:输入抓取的原始图像和随机选择的自然图像,然后将生成的样式图像用作抓取检测网络的输入进行训练;

8.步骤s3、建立一个抓取检测现实干扰基准数据集,对改进后的抓取检测网络进行测试。

9.进一步的,步骤s1的具体内容为:

10.网络模型的结构包括编码器f、自适应实例规范化层adain模块和解码器g,编码器

f采用vgg网络relu4_1层之前的浅层卷积结构;

11.在获得抓取图像c和自然图像s的编码信息后,使用adain模块将抓取图像c和自然图像s这两种样式对齐;公式如下:

[0012][0013]

其中,σ是特征均值,μ是标准差,f(c)和f(s)分别表示抓取和自然的图像特征;

[0014]

通过adain模块,获得一个能对齐抓取图像和自然图像均值和方差的目标特征t:

[0015]

t=adain(f(c),f(s))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(9),

[0016]

获得目标特征t后,通过解码器g来将编码的信息映射回到图像空间,得到一个模仿图像p:

[0017]

p=g(t)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(10),

[0018]

在获得模仿图像p后,使用编码器f重新提取p的特征,利用特征之间的均方误差计算内容损失

[0019][0020]

将编码器f分为l个阶段提取特征,用ei表示每一个阶段的特征提取器,得到每一个阶段i的风格损失

[0021][0022]

将每个阶段风格损失相加得到总体风格损失

[0023][0024]

其中,l=4,表示每个阶段的特征分别为经过vgg的relu1_1,relu2_1,relu3_1,relu4_1后得到的特征;

[0025]

最后得到需要优化的总体损失函数为:

[0026][0027]

β为超参数,用来平衡内容损失和风格损失。

[0028]

进一步的,步骤s2中训练的具体内容为:训练对抗生成网络时,用cornell抓取公开数据作为抓取图片,另一组自然图片数据来自wikiart,用于训练;

[0029]

在训练过程中,图像缩放到256x256,初始化学习率为0.001,总的训练周期为60,在连续10个批次损失不再下降时将学习率降至原来的1/10。

[0030]

进一步的,在网络训练过程中,使用在imagenet上训练的vgg网络作为编码器并固定其参数。

[0031]

与现有技术相比,本发明具有以下有益效果:本发明能够通过改进的对抗生成网络,可以随意地从自然图像上做风格迁移,以不定性地改变训练图像数据的纹理和颜色等信息,迫使网络形成抓取的形状偏好。能够提高现有的多种机器人抓取检测网络的抓取成功率,并且不增加额外的时间开销。

【附图说明】

[0032]

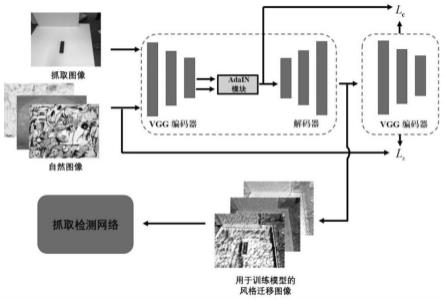

图1为本发明的一种增强机器人抓取检测模型鲁棒性的训练方法的网络框架图;

[0033]

图2-1为本发明中添加亮度干扰的测试数据示例图;

[0034]

图2-2为本发明中添加高斯噪声的测试数据示例图;

[0035]

图2-3为本发明中添加电流干扰的测试数据示例图;

[0036]

图2-4为本发明中添加脉冲噪声的测试数据示例图;

[0037]

图2-5为本发明中添加抖动干扰的测试数据示例图。

【具体实施方式】

[0038]

以下结合附图对本发明进行详细的描述。应当指出的是,所描述的实施例仅旨在便于对本发明的理解,而对其不起任何限定作用。

[0039]

本发明提出一种增强机器人抓取检测模型鲁棒性的训练方法,其主要由主网络模型构建和模型训练/测试两部分构成。该方法具体包括步骤如下:

[0040]

1.抓取检测网络模型构建:

[0041]

我们的方法采用的encoder-decoder模型基于轻量级的vgg网络,以在空间抓取数据集下实现图像知识转换,同时确保算法的实时性能,如图1所示。我们的输入是抓取原始图像和随机选择的自然图像,然后将生成的样式图像用作抓取检测网络的输入进行训练。

[0042]

网络结构主要由三部分组成:生成网络(编码器f)、自适应实例规范化层(adain)和解码器g。为了在图像数据中获得图像纹理等细节信息,编码器模块只采用vgg网络relu4_1层之前的浅层卷积结构。在获得抓取图像c和自然图像s的编码信息后,我们使用adain模块将这两种样式对齐;公式如下:

[0043][0044]

其中,σ是特征均值,μ是标准差,f(c)和f(s)分别表示抓取和自然的图像特征。过adain模块,我们能够获得一个能对齐抓取图像和自然图像均值和方差的目标特征t:

[0045]

t=adain(f(c),f(s))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(16)

[0046]

获得目标特征t后,我们需要通过解码器g来将编码的信息映射回到图像空间,得到一个模仿图像p:

[0047]

p=g(t)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(17)

[0048]

需要注意的是,在网络训练过程中,我们使用在imagenet上训练的vgg网络作为编码器并固定其参数。因为从大规模图像数据中训练出来的编码器能够有效地提取数据中底层纹理的边缘特征。因此,在训练过程中,我们只需要更新解码器的权重参数。

[0049]

在获得模仿图像p后,我们使用编码器f重新提取p的特征,利用特征之间的均方误差计算内容损失

[0050][0051]

对于风格损失,我们将编码器f分为l个阶段提取特征,用ei表示每一个阶段的特征提取器。对于每一个阶段i,我们可以得到每一个阶段的风格损失

[0052][0053]

将每个阶段风格损失相加可以得到总体风格损失

[0054][0055]

在这里l=4,其表示每个阶段的特征分别为经过vgg的relu1_1,relu2_1,relu3_1,relu4_1后得到的特征。

[0056]

最后得到我们需要优化的总体损失函数为:

[0057][0058]

β为超参数,用来平衡内容损失和风格损失,在实验中我们设置为10。

[0059]

2.模型训练/测试:

[0060]

因为改进的对抗生成网络模块与抓取模型的特征信息并不互补,我们在此选择先训练好对抗生成网络后再将其用于抓取模块。实验环境为pytorch1.5.0。实验平台设置为nvidia titan-x(pascal架构,显存为24g),ubuntu 16.04操作系统。为了实现从随机自然图片中转移其纹理信息的目的,我们在训练对抗生成网络时候是用cornell抓取公开数据作为抓取图片,另一组自然图片数据来自wikiart,用于训练。在实验中,我们使用adam优化器,batch size为8的图像对。在训练过程中,我们把图像缩放到256x256,初始化学习率为0.001,总的训练周期为60,在连续10个批次损失不再下降时将学习率将至原来的1/10。

[0061]

3、建立一个抓取检测现实干扰基准数据集,对改进后的抓取检测网络进行测试。

[0062]

为了测试改进后的方法,本发明建立了一个抓取检测现实干扰基准数据集,即在cornell公开数据集上添加了五种常见的图像干扰类型,分别为“亮度干扰(brightness)”、“高斯噪声(gaussian noise)、像素干扰(pixelate)、电流干扰(elastic transform)”以及“移动模糊(motion blur)”,示例图分别如图2-1至图2-5所示。需要注意的是,抓取干扰数据集不会用于模型的训练,而只用于测试模型。

[0063]

为了验证知识迁移模型对网络鲁棒性的提高效果,我们将其与以前的优秀方法(例如kumra et al,chen et al,redmon et al.)结合并在抓取检测现实干扰基准数据集上进行对比。表1为抓取检测原模型和经过本发明方法训练后模型的结果对比,如表1所示,经过本发明方法训练后的抓取检测模型的准确率相比原模型有巨大的提升,且不增加额外的推理时间。

[0064][0065]

表1

[0066]

本发明能够通过改进的对抗生成网络,可以随意地从自然图像上做风格迁移,以不定性地改变训练图像数据的纹理和颜色等信息,迫使网络形成抓取的形状偏好。能够提高现有的多种机器人抓取检测网络的抓取成功率,并且不增加额外的时间开销。本方法可以适用于任何机器人抓取检测网络模型。

[0067]

本发明提出一种增强机器人抓取检测模型鲁棒性的训练方法,它是一种简单高效的对抗生成网络。该网络可以用于从任何其他自然图像中传输纹理知识,以达到无限期改变抓取数据纹理风格的目的,从而引导网络在训练过程中关注对象的形状而不是颜色纹理。我们的方法对提高机器人现实抓取检测的成功率具有十分重要的意义。现有的基于神经网络的抓取检测方法主要是在相同分布的高质量干净数据进行性能训练并验证,但若用于实际的机器人抓取检测中,由于各种外部因素的干扰,如光照条件、环境温度、相机微抖动等,直接影响图像质量,导致抓取失败。即使这些干扰非常细微,它们也不会改变数据结构和语义信息,即使是人眼也很难察觉。因此,为提高抓取模型现实的鲁棒性,本发明提出一种增强机器人抓取检测模型鲁棒性的训练方法,它是一种简单高效的对抗生成网络,适用于任何抓取检测模型,且不改变原模型的任何设置,也不增加额外的训练和测试时间。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1