一种基于改进型YOLOv5模型的大豆植株表型数据统计方法

一种基于改进型yolo v5模型的大豆植株表型数据统计方法

技术领域

1.本发明涉及大豆人工智能选育技术领域,具体涉及一种基于改进型yolo v5模型的大豆植株表型数据统计方法。

背景技术:

2.大豆是我国重要粮食作物和重要经济作物。然而多年来我国大豆产业高度依赖进口,且进口来源高度集中,严重威胁国家粮油安全。

3.大豆考种工作通过获取可重复的大豆表型数据,量化分析其与大豆产量、质量等的关系,是解析大豆遗传规律和大豆育种的关键环节。大豆表型是指在基因组和种植环境的共同作用下,大豆生长发育过程和结果的所有物理、生理和性状等。通过可重复的高质量表型数据,能够量化分析表型对产量、质量、抗逆等的影响。如大豆叶片形态为大豆重要外观特征和农艺性状,能够直观地反映植物的生长状态,叶片形态既影响日光捕获效率,又影响“氮”库的吸收效率,可调节产量,大豆的荚粒数性状也与叶形密切连锁。

4.而传统的大豆考种模式主要依赖于人工,存在着数据采集量有限、人力物力成本高、数据共享能力差、测量精度低、可重复性差、客观性差等问题,这大大限制了表型数据在大豆育种决策过程中的作用发挥,也是限制大豆产业发展的原因之一。因此现代大豆育种迫切需要能够准确、快速、无损检测大豆表型参数的智能化、高通量方法,提高育种效率。

技术实现要素:

5.本发明的目的在于提供一种基于改进型yolo v5模型的大豆植株表型数据统计方法,解决以下技术问题:

6.如何提高大豆考种时大豆表型参数的检测效率和准确度。

7.本发明的目的可以通过以下技术方案实现:

8.一种基于改进型yolo v5模型的大豆植株表型数据统计方法,包括如下步骤:

9.获得目标大豆植株的采样图片;

10.通过基于指定训练方法训练完成的识别模型对所述采样图片进行识别;

11.统计并保存所述识别模型输出的关于所述大豆植株的表型特征;

12.其中,所述识别模型为基于指定改进方法改进的yolo v5模型。

13.通过上述技术方案,可将对目标大豆植株进行拍摄采样得到的采样图片,输入预先训练好的识别模型中进行识别,识别模型可以快速准确的给出该目标大豆植株的表型特征数据,然后可将表型特征数据进行统计,方便后续工作者进行查阅调取。

14.作为本发明进一步的方案:所述指定训练方法包括:

15.针对大豆植株获取训练样本集;

16.增强扩充所述训练样本集后得到训练数据集;

17.将所述训练数据集随机划分为训练集、验证集和测试集三个部分。

18.作为本发明进一步的方案:所述针对大豆植株获取训练样本集的方法包括:

19.选取不同时间段、不同天气情况、不同角度对所述大豆植株进行拍摄后得到拍摄图像;

20.对所有所述拍摄图像进行标注后进行得到所述训练样本集,所述标注包括多种类别标签。

21.作为本发明进一步的方案:所述增强扩充所述训练样本集后得到训练数据集的方法包括:

22.对所述训练样本集中的每个所述拍摄图像进行数据增强;

23.对读取的4张图像通过色域变化、裁剪、缩放、随机排布等操作进行标定框的组合和图片的组合拼接,得到训练数据集。

24.作为本发明进一步的方案:所述指定训练方法还包括:

25.设置初始超参数,改进型yolo v5模型的训练尺寸为640

×

640、批量大小为16、类别数为5、初始学习率、1e-2、迭代次数为100;

26.将所述训练集和所述验证集输入所述改进型yolo v5模型进行训练;

27.根据训练验证损失率变化曲线,当loss随着迭代次数的增加而趋于平稳时,确定最终的学习率和迭代次数。

28.作为本发明进一步的方案:所述指定改进方法包括:

29.采用mobilenetv2来替换yolo v5的主干特征提取网络backbone;

30.所述mobilenetv2结构包括:

31.针对改进型yolo v5模型的主干特征提取部分,利用1

×

1卷积进行升维;

32.利用3

×

3深度可分离卷积进行特征提取后,利用1

×

1卷积降维;

33.残差边部分输入和输出直接相连;

34.使用线性瓶颈操作,将特征投影到低维特征的表示。

35.作为本发明进一步的方案:所述指定改进方法包括:

36.引入入ecanet注意力机制;

37.所述ecanet注意力机制的结构包括:

38.通过全局平均池化获得每一个通道的全局特征,输出维度为c

×1×

1的全局特征;

39.使用一维卷积获取局部通道之间的关系;

40.将权重文件放入yolo v5模型的算法中对所述验证集进行检测,观察检测情况;

41.使用sigmoid激活函数输出维度为c

×1×

1的新权值;

42.通过新权值和输入特征图乘积运算完成对通道特征权值的重分配,抑制无效特征,增强有效特征。

43.作为本发明进一步的方案:所述引入ecanet注意力机制主要步骤包括:

44.将ecanet注意力机制放置在加强特征提取网络上,在主干网络提取出来的三个有效特征层上增加了注意力机制;

45.对fpn中上采样结果增加ecanet注意力机制,来减少信息丢失、优化每层上的整合特征。

46.作为本发明进一步的方案:所述指定改进方法包括:

47.改进损失函数:

48.用ciou_loss取代giou_loss;

49.用diou_nms取代经典的nms。

50.本发明的有益效果:

51.本发明可将对目标大豆植株进行拍摄采样得到的采样图片,输入预先训练好的识别模型中进行识别,识别模型可以快速的给出该目标大豆植株的表型特征数据,然后可将表型特征数据进行统计,方便后续工作者进行查阅调取。

附图说明

52.下面结合附图对本发明作进一步的说明。

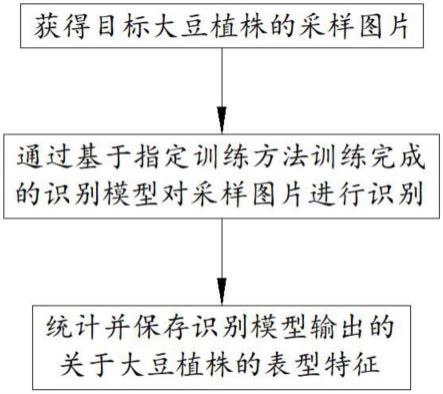

53.图1为本发明中大豆植株表型数据统计方法的基本流程示意图;

54.图2为通用的yolo v5的结构示意图;

55.图3为通用的yolo v5中特征提取网络结构示意图;

56.图4为通用的yolo v5中focus模块结构图;

57.图5为通用的yolo v5中csp模块结构图;

58.图6为深度可分离卷积过程图;

59.图7为本发明中bottleneck residual block的结构图;

60.图8为本发明中ecanet结构图;

61.图9为giou退化为iou示例图;

62.图10为本发明中改进型yolo v5模型的具体结构;

63.图11为本发明改进型yolo v5模型与其他模型性能比较图;

64.图12为本发明表型数据统计方法应用系统的检测过程示意图;

65.图13为客户端初始界面;

66.图14为叶形识别与计数显示界面;

67.图15为花朵识别与计数显示界面;

68.图16为数据管理界面。

具体实施方式

69.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其它实施例,都属于本发明保护的范围。

70.如图1所示,本发明为一种基于改进型yolo v5模型的大豆植株表型数据统计方法,包括如下步骤:

71.获得目标大豆植株的采样图片;

72.通过基于指定训练方法训练完成的识别模型对采样图片进行识别;

73.统计并保存识别模型输出的关于大豆植株的表型特征;

74.其中,识别模型为基于指定改进方法进行改进的改进型yolo v5模型。

75.本发明可将对目标大豆植株进行拍摄采样得到的采样图片,输入预先训练好的识别模型中进行识别,识别模型可以快速的给出该目标大豆植株的表型特征数据,然后可将表型特征数据进行统计,方便后续工作者进行查阅调取。

76.作为本发明进一步的方案:指定训练方法包括:

77.针对大豆植株获取训练样本集;

78.增强扩充训练样本集后得到训练数据集;

79.将训练数据集随机划分为训练集、验证集和测试集三个部分。

80.作为本发明进一步的方案:针对大豆植株获取训练样本集的方法包括:

81.选取不同时间段、不同天气情况、不同角度对大豆植株进行拍摄后得到拍摄图像;

82.对所有拍摄图像进行标注后进行得到训练样本集,标注包括多种类别标签。

83.具体的,采用相机对大豆植株进行拍摄,在拍摄时,为确保改进型yolo v5模型的适用性与泛化能力,特地充分考虑不同情况,选取不同时间段、不同天气情况、不同角度的大豆植株进行拍摄。

84.使用labelimg给5种类别信息进行人工标注,5种类别标签分别为:oval(椭圆形)、ovoid(卵圆形)、lanceolate(披针形)、white(白花)、violet(紫花)。labelimg是深度学习中常用的数据标注工具,使用qt(pyqt)作为其图形界面,在使用之前需要配置好所需的的lxml+python的环境,标注结果以pascalvoc的格式保存为xml文件。

85.作为本发明进一步的方案:增强扩充训练样本集后得到训练数据集的方法包括:

86.对训练样本集中的每个拍摄图像进行数据增强;

87.对读取的4张图像通过色域变化、裁剪、缩放、随机排布等操作进行标定框的组合和图片的组合拼接,得到训练数据集。

88.数据集是深度学习的输入和基础,数据集的质量在一定程度上决定了深度学习模型训练的质量和预测的准确率。由于大豆植株图像样本采集时间次数有限,而且标注大量的大豆植株样本图片是一件非常耗时的事,为了提高深度学习模型的泛化能力,需对大豆植株原始数据集进行包括数据增强在内的数据预处理工作。

89.yolo v5模型采用的数据增强方式为mosaic,即每次对读取的4张图像通过色域变化、裁剪、缩放、随机排布等操作进行标定框的组合和图片的组合拼接。

90.作为本发明进一步的方案:指定训练方法还包括:

91.设置初始超参数,改进型yolo v5模型的训练尺寸为640

×

640、批量大小为16、类别数为5、初始学习率、1e-2、迭代次数为100;

92.将训练集和验证集输入改进型yolo v5模型进行训练;

93.根据训练验证损失率变化曲线,当loss随着迭代次数的增加而趋于平稳时,确定最终的学习率和迭代次数。

94.作为本发明进一步的方案:指定改进方法包括:

95.采用mobilenetv2来替换yolo v5的主干特征提取网络backbone;

96.所述mobilenetv2结构包括:

97.针对改进型yolo v5模型的主干特征提取部分,利用1

×

1卷积进行升维;

98.利用3

×

3深度可分离卷积进行特征提取后,利用1

×

1卷积降维;

99.残差边部分输入和输出直接相连;

100.使用线性瓶颈操作,将特征投影到低维特征的表示。

101.具体的,如图2和图3所示,通用的yolo v5的结构,主要分为输入端(input)、主干网络(backbone)、过渡层(neck)、输出层(head)四部分。

102.其中,特征提取网络结构主要由focus、csp和spp组成,中间通过卷积层进行衔接。

103.focus模块结构如图4所示,通过切片操作,先将特征图变为320x320x12的特征图;然后使用32个卷积核卷积得到320x320x32的特征图。卷积块(cbl)由卷积层(conv)、归一化层(bn)和leaky_relu激活函数组成。

104.csp模块结构如图5所示,cspdarknet53是在darknet53的基础上进行修改的主干特征提取网络backbone结构,其修改了resblock_body结构并添加了cspnet结构。这样可以在保证网络运行准确性的同时,有效增强网络学习能力,使cnn更加的小,这样就可以有效降低计算瓶颈,也可以减小内存成本。spp模块位于特征提取主干网络之后,采用spp模块能够很大程度上扩大主干特征网络的提取范围。

105.针对大豆考种的实时性要求,本发明采用mobilenetv2来替换yolo v5的主干特征提取网络backbone,以此来减少原模型参数量、缩短模型推理时长、提升整体模型的推演能力。

106.作为轻量级网络的代表,mobilenetv2是基于深度可分离卷积构造的网络,其核心思想是将标准卷积拆分为深度卷积和逐点卷积两个部分完成,如图6所示。先进行深度卷积,对每一输入通道进行卷积操作得到和输入特征图通道数一致的输出特征图;再进行逐点卷积,利用1

×

1的卷积操作来对特征图进行升维和降维,结合所有深度卷积得到输出。其中,n、m分别为输入、输出通道数,dk×dk

为卷积核的尺寸。在保证模型性能的同时减少了模型参数量和计算量。

107.mobilenetv2在深度可分离卷积基础上使用线性瓶颈的反向残差模块提高特征提取能力。其核心由bottleneckresidualblock模块组成,结构如图7所示。可以分为两部分:主干部分首先利用1

×

1卷积进行升维,防止在经过激活函数relu时,因为维度过低,导致特征信息丢失过多的问题;然后分别利用3

×

3深度可分离卷积和1

×

1卷积进行特征提取和降维;残差边部分输入和输出直接相连,并在最后使用线性瓶颈操作,将特征投影到低维特征的表示。

108.作为本发明进一步的方案:指定改进方法包括:

109.引入入ecanet注意力机制;

110.ecanet注意力机制的结构包括:

111.通过全局平均池化获得每一个通道的全局特征,输出维度为c

×1×

1的全局特征;

112.使用一维卷积获取局部通道之间的关系;

113.将权重文件放入yolo v5模型的算法中对验证集进行检测,观察检测情况;

114.使用sigmoid激活函数输出维度为c

×1×

1的新权值;

115.通过新权值和输入特征图乘积运算完成对通道特征权值的重分配,抑制无效特征,增强有效特征。

116.作为本发明进一步的方案:引入ecanet注意力机制主要步骤包括:

117.将ecanet注意力机制放置在加强特征提取网络上,在主干网络提取出来的三个有效特征层上增加了注意力机制;

118.其中,c为通道数,对fpn中上采样结果增加ecanet注意力机制,来减少信息丢失、优化每层上的整合特征。

119.针对大豆植株数据集存在部分图像叶片数量多、叶片之间相互遮挡以及小叶片的

情况,为提高算法识别准确度和鲁棒性,引入ecanet注意力机制。

120.注意力机制模仿人脑对于视觉信息的处理行为,重点关注感兴趣的区域,提取目标更多的细节特征,提升检测效果,即增强有效特征,抑制无效特征,具有强大而有效的表现形式。

121.ecanet是在senet基础上改进的通道注意力机制。senet通过全连接实现通道信息交互,在其过程中会丢失部分信息特征表达且具有很大的计算开销。基于此,ecanet基于自适应选择卷积核大小的方法,通过一维卷积来实现通道间信息交互,从而在保持模型性能的基础上大大降低了模型复杂度。

122.如图8为ecanet结构图。首先通过全局平均池化获得每一个通道的全局特征,输出维度为c(通道数)

×1×

1的全局特征。其次直接使用一维卷积获取局部通道之间的关系,避免了降维过程造成的关键信息损失和较大的参数量计算量。接着使用sigmoid激活函数输出维度为c

×1×

1的新权值。最后通过新权值和输入特征图乘积运算完成对通道特征权值的重分配,抑制无效特征,增强有效特征。

123.为提取更多大豆植株叶片图像细节特征,本文首先将ecanet注意力机制放置在加强特征提取网络上,在主干网络提取出来的三个有效特征层上增加了注意力机制。针对yolo v5中fpn存在的融合信息过程中信息衰减、跨尺度融合的混叠效应、channelreduction的固有缺陷的问题,本发明其次对fpn中上采样结果增加ecanet注意力机制,来减少信息丢失、优化每层上的整合特征。通过以上ecanet注意力机制的引入,使模型更好地拟合小目标通道间的相关特征信息,忽略并抑制无用的信息,最终会使模型更专注于训练大豆植株叶片这一特定类别,加强训练这些特征,提高模型对本文大豆植株数据集的检测性能。

124.作为本发明进一步的方案:指定改进方法包括:

125.改进损失函数:

126.用ciou_loss取代giou_loss;

127.用diou_nms取代经典的nms。

128.其中,用ciou_loss取代giou_lossyolo v5使用giou_loss作为boundingbox(目标位置)的损失函数,使用二进制交叉熵和logits损失函数计算类概率和目标得分的损失,其定义为:

[0129][0130][0131]

上式中,a、b分别为预测框与真实框,iou为预测框与真实框的交并比,c为预测框和目标框的最小外接矩形。但是其只考虑预测框和目标框之间的重叠率这一因素,不能很好地描述目标框的回归问题,当预测框在目标框内部且预测框大小相同时,此时giou会退化为iou,无法区分每个目标框中预测框的相对位置,从而导致检测不准确,如图9所示。

[0132]

因此使用ciou_loss取代giou_loss,其计算公式如下:

[0133][0134][0135][0136]

式中,a是一个平衡参数,不参与梯度计算,v是用来衡量长宽比一致性的参数。ciou_loss综合考虑了目标框与预测框的重叠面积、中心点距离、长宽比等因素,解决了giou_loss损失函数的不足,使得目标框回归过程更加稳定,且收敛速度更快、收敛精度更高。

[0137]

其中,用diou_nms取代经典的nms非极大值抑制(non-maximum-suppres-sion,nms)是目标检测模型后处理过程中常用到的技术,用来保留最准确的检测框,去除冗余检测框,在其处理检测框过程中,iou是唯一筛选指标,每一个检测框对应一个iou值,将超过nmsthreshold设置值的检测框全部去除。但在大豆植株叶片实际情况中,叶片互相遮挡时常存在,即两个不同物体距离很近,此时由于iou值比较大,容易产生错误抑制,造成漏检的情况。为了避免发生漏检,本文用diou_nms取代经典的nms。diou损失函数定义公式为

[0138][0139]

上式中:b为预测框;b

gt

为真实框;ρ2(b,b

gt

)为预测框与真实框的中心点距离;i为2个框最小外接矩形的对角线距离。假设算法模型检测出一个候选框集为hi,对于类别置信度最高的预测框m,其diou_nms方法更新公式的pi可以定义为:

[0140][0141]

式中:diou(m,hi)为diou关于m和hi的值;ε为nms操作手动设置的阈值;pi为不同大豆植株目标类别的分类得分;iou为交并比;i为每个网格对应锚框的个数。

[0142]

diou_nms不仅关注iou,还关注预测框和真实框之间的距离、重叠面积和长宽比,认为具有更远中心点距离的2个预测框可能会位于不同的目标检测对象上,将2个矩形框(预测框与真实框)的交并比(intersectionoverunion,iou)和中心点距离结合起来,一方面优化iou损失,另一方面指引中心点的学习,能够更加精准地回归预测框,有利于遮挡重叠的目标的识别。

[0143]

本发明改进型yolo v5模型的具体结构如图10。采用轻量级网络mobilenetv2作为主干网络提取大豆植株图像52

×

52、26

×

26、13

×

13三个尺度的有效特征,然后通过ecanet注意力机制增强来有效挖掘特征图中大豆植株的深度信息并弱化无关特征;在neck部分对特征图应用fpn+panet+ecanet架构进行自下而上和自上而下的特征融合,充分利用特征图中高层语义信息和底层空间信息,最大限度聚合特征;在此基础上,ciouloss+diou_nms的引入使得网络额外关注边界框中心点的位置信息以更加精准地回归小目标、遮挡目标预测框。最终输出带有标签、置信度和框坐标信息的结果。

[0144]

为了评估改进型yolo v5模型大豆植株目标检测模型性能,特选用改进型yolo v5、yolo v5、ssd和faster-rcnn目标检测网络模型,如图11,均选取各模型最优训练参数设置,根据精确率(p)、召回率(r)、调和平均数(f1)、帧速率(fps)等指标来对比几种模型的训练结果,得到改进型yolo v5实时性最好,错检、漏检率最低。

[0145]

为了更直观地验证改进型yolo v5模型的在实际应用中可行性和鲁棒性,在测试集中选取部分大豆植株叶片图像进行测试,对比改进型yolo v5、yolo v5、ssd和faster-rcnn对于大豆植株叶片的检测结果可视化结果,改进型yolo v5检测置信度较高,4种算法中只有改进型yolo v5没有出现漏检异常情况,面对密集目标图像,4种算法中改进yolo v5错检、漏检率最低,能够很好地满足大豆考种实际需求。

[0146]

本发明在实际统计识别模型输出的关于大豆植株的表型特征时,采用改进型yolo v5模型对大豆植株叶形、叶片数量、花色、花朵数量进行识别和计数;显示并保存模型检测的结果,为进一步的育种分析提供数据基础。

[0147]

因此本发明的大豆植株表型数据统计系统具有三个主要功能:目标检测、结果显示和数据管理;

[0148]

目标检测模块基于改进yolo v5目标检测算法对大豆植株叶片形状、叶片数量、花朵颜色、花朵数量进行识别和统计的功能,并对预测结果进行保存;

[0149]

数据管理模块主要提供大豆数据的增、删、改、查功能,面向农技人员和科研工作者,为育种分析工作提供数据基础;

[0150]

系统采用前后端分离的设计模式,模型部署在web端,前端采用轻量级框架vue,后端采用基于python开发的web框架flask框架,采用b/s架构的设计。

[0151]

具体实现流程如图12所示,用户在浏览器上上传大豆植株图像后,选择对应的模块进行下一步操作,http resquest将消息发送到http server,http server发送post信息到flask server服务器,flask server调用模型动态链接库的api进行检测,检测的结果包括大豆植株叶形、叶片数量、花色、花朵数量和叶面积,以json数据的形式经由flask server服务器、http server返回浏览器,浏览器接收json数据,最终在浏览器端显示检测结果。

[0152]

本发明的大豆植株表型数据统计系统的客户端初始界面如图13所示,叶形识别与计数如图14所示,花朵识别与计数如图15所示,数据管理界面如图16所示。其中,头部信息为系统标题;中部信息包括模块组件、检测组件和检测结果显示组件组成,该大豆植株表型统计系统平台,具备大豆考种和数据存储功能,能够很好地辅助育种专家开展育种工作。

[0153]

以上对本发明的一个实施例进行了详细说明,但所述内容仅为本发明的较佳实施例,不能被认为用于限定本发明的实施范围。凡依本发明申请范围所作的均等变化与改进等,均应仍归属于本发明的专利涵盖范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1