基于协作图融合的协同目标检测方法及系统

1.本发明涉及自动驾驶技术领域,具体涉及一种基于协作图融合的协同目标检测方法及系统。

背景技术:

2.目标检测是计算机视觉的一个基础任务,目的是识别空间内目标的位置和类别。根据预测目标的维度,目标检测方法可以分为2d目标检测和3d目标检测,自动驾驶领域需要的大都是3d目标检测。根据是否生成候选框,目标检测方法可以分为单阶段目标检测和两阶段目标。单阶段目标检测直接预测目标的位置和类别,特点是模型简单,耗时短,但是精度低;两阶段目标检测先生成一系列候选框并预测它们的置信度,再在这个候选框的基础上优化最后的位置,特点是模型更庞大,耗时长,但是精度高。

3.目标检测是自动驾驶视觉领域的一个重要研究方向,自动驾驶领域的车辆在自动驾驶场景又称为智能体。传统的目标检测都是基于车载传感器的单智能体目标检测。然而,由于目标被遮挡以及车载传感器自身的局限性,单车检测存在盲区,常常不能取得很好的检测结果。为了应对单车目标检测面临的挑战,协同目标检测应运而生。协同目标检测是一种基于多智能体信息融合的检测方法,它通过把多智能体协同模块插入传统的目标检测框架来实现。自动驾驶场景下,道路上有多个车辆,一个车辆的盲区可能正处于其他车辆的检测区域,通过把其他车辆观测到的目标信息传递给中心车辆,中心车辆可以得到更全面的视野,从而完成更精确的目标检测。协同目标检测过程中,每个车辆既可以是中心车辆,也可以是其他车辆的邻居车辆。

4.协同目标检测(collaborative object detection)是自动驾驶领域的一个关键视觉技术,它指的是通过场景内的多个智能体的信息交流与数据融合,协助单个智能体完成更精确的目标检测任务,从而缓解自动驾驶场景中目标被遮挡、传感器捕获异常等问题。协同目标检测方法可以从协同阶段和融合策略两个角度讨论。协同阶段指在目标检测的哪个阶段插入协同模块,根据协同阶段的不同,协同目标检测方法可以分为数据级协同,特征级协同和决策级协同三类。其中数据级协同指融合车辆的原始观测数据,特征级协同指融合车辆的目标特征,决策级协同指融合车辆最终的检测数据。融合策略指协同模块的具体融合计算过程,可以分为简单融合,基于特征的融合和基于图的融合。简单融合采取求均值、最大值、拼接等策略,基于特征的融合选择了关联性最大的车辆,基于图的融合指把多车协同过程构造成一个图,通过图学习的过程融合多车的信息。

5.现有的基于图的协同目标检测方法主要有v2vnet和disconet。v2vnet采取了一个空间感知的图神经网络(graph neural network,gnn)完成多车信息融合。v2vnet首先补偿了不同车辆的传输时延,接着使用gnn把周边的车辆特征都聚集到中心车辆,并根据全局位置确定邻域范围的车辆。这种方法有效地扩大了车辆的视野,从而检测到被遮挡物体。disconet同样采取了一个注意力图网络(graph attention networks,gat)实现多车的协同。与v2vnet不同,disconet的融合图的边不是标量,而是一个矩阵,这个矩阵可以反映每

个像素特征的贡献度。此外,disconet引入一个教师-学生网络,教师网络是数据级协同目标检测,学生网络是特征级协同目标检测,使用教师网络的特征作为学生网络的监督,从而提升特征级协同目标检测的性能。

6.目前主流的基于融合图的协同目标检测方法存在的问题在于直接传播全局特征,即相邻车辆全局视角的目标特征。由于中心车辆本身可以确切地检测到部分视角区域,并不需要相邻车辆的所有视角信息。传输的全局特征具有体量大、信息冗余等特点,不但会占用大量的计算资源,还使重叠的部分权重增加,使得网络不能把更多的注意力放在需要协同的区域。

技术实现要素:

7.本发明的目的在于提供一种通过粗粒度的中心车辆的盲区筛选以及细粒度的局部特征协作图融合,从而通过局部特征协同,提升了中心车辆的检测性能的基于协作图融合的协同目标检测方法及系统,以解决上述背景技术中存在的至少一项技术问题。

8.为了实现上述目的,本发明采取了如下技术方案:

9.一方面,本发明提供一种基于协作图融合的协同目标检测方法,包括:

10.获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框;

11.基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征;

12.基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征;

13.基于中心车辆新的协作特征,对每个候选区域做分类和回归预测,经过阈值筛选,得到最终的检测结果。

14.优选的,获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框,包括:

15.在自动驾驶场景中,对于每个车辆目标的点云数据,利用特征提取器提取三维的点云数据,转换成二维鸟瞰图特征,作为全局特征;

16.将每个车辆的二维的鸟瞰图输入3d区域生成网络,生成相应车辆的3d候选区域框;

17.得到车辆的候选区域框后,再经过3d的感兴趣区域池化层得到每个候选区域框的二维鸟瞰图特征,作为局部特征。

18.优选的,每个3d候选区域框都有相应的分类置信度,分类置信度代表相应候选框属于每个类别以及背景类的概率,当候选区域框属于前景的概率小于预设的阈值,则该候选区域框属于当前车辆的检测盲区。

19.优选的,基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征,包括:

20.选择中心车辆周围预设范围内的近邻车辆作为协同目标;对于中心车辆的每个候选区域框判断是否为盲区;得到中心车辆及其协同车辆的一系列候选区域框及其局部特征;

21.使用交并比选择可与中心车辆盲区协同的近邻车辆区域;对于中心车辆的每个盲区候选框,遍历近邻车辆的候选区域框,如果盲区候选框与近邻候选框的iou大于阈值,则

该近邻候选框与中心车辆的盲区候选框很大概率表示同一区域,两者的协同可以增强中心车辆对该区域的识别能力。

22.优选的,对于中心车辆的每个候选区域框判断是否为盲区,包括:如果候选区域框的置信度分布差异明显,且在某类别的置信度大于预设的置信度阈值,说明该中心车辆可以明确检测到目标属于背景或者某个具体的类别,该候选框具有显著性;相反,如果候选区域框的置信度小于预设的阈值,车辆无法判断目标所属类别,则该候选框所处区域为中心车辆的盲区,是中心车辆所需协同的区域,加入中心车辆的盲区集合。

23.优选的,基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征,包括:

24.使用基于注意力图的方式融合局部特征;遍历中心车辆的每个盲区候选框,为候选框及其近邻协同框构建注意力图,并更新该盲区候选框的局部特征;为盲区候选框及其近邻协同框构建注意力图,其中图的结点是盲区候选框和协同近邻候选框的bev局部特征,方向为每个协同近邻候选框指向盲区候选框,以及盲区候选框指向自己;得到每条边的权重后,使用聚合函数更新中心车辆的盲区的局部特征。

25.第二方面,本发明提供一种基于协作图融合的协同目标检测系统,包括:

26.获取模块,用于获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框;

27.筛选模块,用于基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征;

28.协作模块,用于基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征;

29.检测模块,用于基于中心车辆新的协作特征,对每个候选区域做分类和回归预测,经过阈值筛选,得到最终的检测结果。

30.第三方面,本发明提供一种计算机设备,包括存储器和处理器,所述处理器和所述存储器相互通信,所述存储器存储有可被所述处理器执行的程序指令,所述处理器调用所述程序指令执行如上所述的基于协作图融合的协同目标检测方法。

31.第四方面,本发明提供一种电子设备,包括存储器和处理器,所述处理器和所述存储器相互通信,所述存储器存储有可被所述处理器执行的程序指令,所述处理器调用所述程序指令执行如上所述的基于协作图融合的协同目标检测方法。

32.第五方面,本发明提供一种计算机可读存储介质,其存储有计算机程序,所述计算机程序被处理器执行时实现如上所述的基于协作图融合的协同目标检测方法。

33.本发明有益效果:首次从粗粒度和细粒度两个角度考虑局部特征的协同;通过传递局部特征,协同检测可以减缓计算资源的压力,更加精准地对中心车辆的盲区进行协同,有效提升协同检测性能;有效提升了检测精度的同时,减少了通信资源的开销。

34.本发明附加的方面和优点将在下面的描述中部分给出,这些将从下面的描述中变得明显,或通过本发明的实践了解到。

附图说明

35.为了更清楚地说明本发明实施例的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本

领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

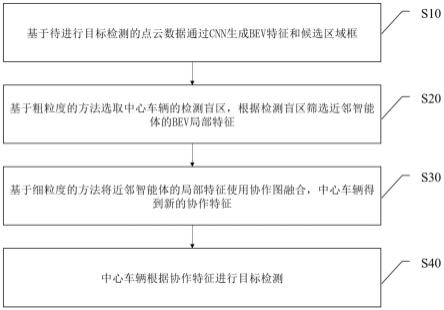

36.图1为本发明实施例所述的基于由粗到细的协作图融合的协同目标检测方法流程图。

37.图2为本发明实施例所述的基于由粗到细的协作图融合的协同目标检测框架图。

38.图3为本发明实施例所述的粗粒度协同工作流程图。

39.图4为本发明实施例所述的细粒度协同工作流程图。

具体实施方式

40.下面详细叙述本发明的实施方式,所述实施方式的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过附图描述的实施方式是示例性的,仅用于解释本发明,而不能解释为对本发明的限制。

41.本技术领域技术人员可以理解,除非另外定义,这里使用的所有术语(包括技术术语和科学术语)具有与本发明所属领域中的普通技术人员的一般理解相同的意义。

42.还应该理解的是,诸如通用字典中定义的那些术语应该被理解为具有与现有技术的上下文中的意义一致的意义,并且除非像这里一样定义,不会用理想化或过于正式的含义来解释。

43.本技术领域技术人员可以理解,除非特意声明,这里使用的单数形式“一”、“一个”、“所述”和“该”也可包括复数形式。应该进一步理解的是,本发明的说明书中使用的措辞“包括”是指存在所述特征、整数、步骤、操作、元件和/或组件,但是并不排除存在或添加一个或多个其他特征、整数、步骤、操作、元件和/或它们的组。

44.在本说明书的描述中,参考术语“一个实施例”、“一些实施例”、“示例”、“具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。而且,描述的具体特征、结构、材料或者特点可以在任一个或多个实施例或示例中以合适的方式结合。此外,在不相互矛盾的情况下,本领域的技术人员可以将本说明书中描述的不同实施例或示例以及不同实施例或示例的特征进行结合和组合。

45.为便于理解本发明,下面结合附图以具体实施例对本发明作进一步解释说明,且具体实施例并不构成对本发明实施例的限定。

46.本领域技术人员应该理解,附图只是实施例的示意图,附图中的部件并不一定是实施本发明所必须的。

47.实施例1

48.数据级协同传递原始数据带来过大的带宽压力,决策级协同的检测结果已经丢失一些目标信息,为了维持精度和带宽的平衡,本实施例1选择基于图的特征级协同目标检测。

49.首先,提供一种基于协作图融合的协同目标检测系统,包括:

50.获取模块,用于获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框;

51.筛选模块,用于基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征;

52.协作模块,用于基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征;

53.检测模块,用于基于中心车辆新的协作特征,对每个候选区域做分类和回归预测,经过阈值筛选,得到最终的检测结果。

54.其次,本实施例中,利用上述的系统,实现了基于协作图融合的协同目标检测方法,包括:

55.获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框;

56.基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征;

57.基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征;

58.基于中心车辆新的协作特征,对每个候选区域做分类和回归预测,经过阈值筛选,得到最终的检测结果。

59.获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框,包括:

60.在自动驾驶场景中,对于每个车辆目标的点云数据,利用特征提取器提取三维的点云数据,转换成二维鸟瞰图特征,作为全局特征;

61.将每个车辆的二维的鸟瞰图输入3d区域生成网络,生成相应车辆的3d候选区域框;

62.得到车辆的候选区域框后,再经过3d的感兴趣区域池化层得到每个候选区域框的二维鸟瞰图特征,作为局部特征。

63.其中,每个3d候选区域框都有相应的分类置信度,分类置信度代表相应候选框属于每个类别以及背景类的概率,当候选区域框属于前景的概率小于预设的阈值,则该候选区域框属于当前车辆的检测盲区。

64.基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征,包括:

65.选择中心车辆周围预设范围内的近邻车辆作为协同目标;对于中心车辆的每个候选区域框判断是否为盲区;得到中心车辆及其协同车辆的一系列候选区域框及其局部特征;

66.使用交并比选择可与中心车辆盲区协同的近邻车辆区域;对于中心车辆的每个盲区候选框,遍历近邻车辆的候选区域框,如果盲区候选框与近邻候选框的iou大于阈值,则该近邻候选框与中心车辆的盲区候选框很大概率表示同一区域,两者的协同可以增强中心车辆对该区域的识别能力。

67.其中,对于中心车辆的每个候选区域框判断是否为盲区,包括:如果候选区域框的置信度分布差异明显,且在某类别的置信度大于预设的置信度阈值,说明该中心车辆可以明确检测到目标属于背景或者某个具体的类别,该候选框具有显著性;相反,如果候选区域框的置信度小于预设的阈值,车辆无法判断目标所属类别,则该候选框所处区域为中心车辆的盲区,是中心车辆所需协同的区域,加入中心车辆的盲区集合。

68.基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征,包括:

69.使用基于注意力图的方式融合局部特征;遍历中心车辆的每个盲区候选框,为候选框及其近邻协同框构建注意力图,并更新该盲区候选框的局部特征;为盲区候选框及其近邻协同框构建注意力图,其中图的结点是盲区候选框和协同近邻候选框的bev局部特征,方向为每个协同近邻候选框指向盲区候选框,以及盲区候选框指向自己;得到每条边的权重后,使用聚合函数更新中心车辆的盲区的局部特征。

70.综上,本实施例1中,首次尝试从粗粒度和细粒度两个角度考虑局部特征的协同。粗粒度协同是通过检测置信度等信息判断中心车辆需要协同的区域,选择并传播协同车辆的局部特征,细粒度协同是通过融合图的方法为协同区域局部特征赋予权重,并更新盲区的局部特征。通过传递局部特征,协同检测可以减缓计算资源的压力,更加精准地对中心车辆的盲区进行协同,有效提升协同检测性能。采用了两阶段检测模型,可以有效提升检测模型精度的同时,减少通信资源的开销。

71.实施例2

72.如图1至图4所示,本实施例2中,提出一种基于由粗到细的协作图融合的协同目标检测方法,该方法通过粗粒度的中心车辆的盲区筛选,以及细粒度的局部特征协作图融合,从而通过局部特征协同,提升中心车辆的检测性能。

73.本实施例2中,在多智能体协同目标检测模型的基础上,将协同目标检测任务分为四个步骤,如图1所示,第一步是基于3d区域生成网络的候选框及其局部特征生成,第二步是基于粗粒度的中心车辆盲区筛选及协同特征传输,第三步是基于细粒度的局部特征协作图融合,第四步是基于协同得到的特征进行目标检测,得到最终的检测结果。

74.本发明实施例提供的一种基于由粗到细的协作图融合的协同目标检测方法工作流程图如图1所示,包括如下的处理步骤:

75.s10,基于待进行目标检测的点云数据通过cnn生成bev特征和候选区域框:

76.本实施例2中,面对的任务是两阶段3d点云目标检测。在自动驾驶场景中,假设一共有c个类别的物体,n个智能体(车辆),对于每个智能体ai的点云数据xi(i=1,2,3,...,n),利用特征提取器三维的点云数据,转换成二维的鸟瞰图(bird’s eye view,bev)特征fi∈rh×w×k,其中h,w,k分别代表bev特征的高、宽和通道数,这个特征是车辆的bev全局特征。

77.接下来,将每个智能体的bev特征fi输入3d区域生成网络(region proposal network,rpn),生成相应智能体的3d候选区域框其中ni代表智能体ai的候选区域框数。rpn生成的每个3d候选区域框p

ij

都有相应的分类置信度s

ij

∈r

(c+1)

,这个置信度代表该候选框属于每个类别以及背景类的概率,当该候选区域框属于前景的概率很小,则该候选区域框包含的物体很难判断,属于当前智能体的盲区。

78.使用3d rpn模块得到车辆的候选区域框后,再经过3d的roipooling层得到每个候选区域框p

ij

的bev特征f

ij

∈rm×m×d,其中m和d分别指候选区域框的特征尺寸和维度,候选区域框的bev特征为局部特征。

79.s20,基于粗粒度的方法选取中心车辆的检测盲区,根据检测盲区筛选近邻智能体的bev局部特征。

80.特征级协同目标检测需要传输智能体的特征,传统的特征级协同检测传输并融合全局特征,消耗大量的计算资源。本实施例提供的基于粗粒度的筛选盲区方法如图3所示,包括如下的处理过程:

81.协同目标检测中,不是所有的智能体都可用于协同,选择中心车辆周围范围d内的近邻车辆作为协同目标。

82.对于中心车辆ac,(c=1,2,...,n)的每个候选区域框p

cj

判断是否为盲区:如果候选区域框的置信度分布差异明显,且在某类别的置信度大于阈值t

cs

,说明该车辆可以明确检测到该目标属于背景或者某个具体的类别,该候选框具有显著性;相反,如果候选区域框的置信度分布较平缓,车辆无法判断该目标所属类别,则该候选框所处区域为中心车辆的盲区,是中心车辆所需协同的区域,加入中心车辆的盲区集合p

cn

。

83.经过上述步骤,中心车辆及其协同车辆都得到一系列候选区域框及其局部特征。为缓解传统协同检测传播及融合全局特征的资源消耗压力,本实施例中创造性地提出传播及融合局部特征,即只需传播中心车辆需要协同区域的特征。

84.本实施例中使用交并比(intersection over union,iou)选择可与中心车辆盲区协同的近邻车辆区域。对于中心车辆的每个盲区候选框遍历近邻车辆ai的候选区域框pi,如果盲区候选框与近邻候选框的iou大于阈值t

iou

,如公式(1)所示,则该近邻候选框与中心车辆的盲区候选框很大概率表示同一区域,两者的协同可以增强中心车辆对该区域的识别能力。

[0085][0086]

为中心车辆的每个盲区候选框初始化一个协同区域局部特征集si,用于存储盲区候选框的bev局部特征以及协同区域的局部bev特征。将满足公式(1)的近邻候选框的bev特征传输给中心车辆,由于每个车辆有自己的观测,协同车辆传输的特征需要转换成中心车辆的角度,然后放入协同区域局部特征集si。协同时只需要将协同区域局部特征集si中的特征融合。

[0087]

s30,基于细粒度的方法将近邻智能体的局部特征使用协作图融合,中心车辆得到新的协作特征。

[0088]

本发明使用基于注意力图的方式融合局部特征。遍历中心车辆的每个盲区候选框为候选框及其近邻协同框构建注意力图,并更新该盲区候选框的局部特征。注意力图构建过程及局部特征的更新过程如图2所示。

[0089]

为盲区候选框及其近邻协同框构建注意力图gi,其中图的结点是盲区候选框和协同近邻候选框的bev局部特征hj→i∈rm×m×d,方向为每个协同近邻候选框指向盲区候选框(j

→

i),以及盲区候选框指向自己(i

→

j)。图的边采取矩阵的形式,每条边的权重wj→i基于公式(2)计算,

[0090]

wj→i=π(hj,hi)∈rm×m#(2)

[0091]

其中π拼接了相邻两节点的特征,并使用一个1

×

1的卷积层将边特征的通道数从d降到1,通过该计算可以得到边的矩阵权重。此外,每条边的权重再输入一共softmax层正则化,边的矩阵权重可以反映bev局部特征的空间权重。

[0092]

得到每条边的权重后,本发明使用聚合函数更新中心车辆的盲区的局部特征,聚合函数如公式(3)所示,

[0093][0094]

其中,

⊙

指通道方向的点乘,m是盲区候选框的协同区域局部特征集si的特征数量,hi是盲区候选框更新后的bev特征。

[0095]

s40,中心车辆根据协作特征进行目标检测。

[0096]

经过协作图的融合,中心车辆的盲区候选框特征包含了更充分的信息,以上是两阶段3d目标检测的第一阶段。

[0097]

第二阶段对候选框做进一步的调整和识别,把中心车辆的所有候选框特征输入到检测模型的头部,对每个候选框做分类和回归预测,经过阈值筛选,可以得到更精准的检测结果。

[0098]

需要注意的是,协同目标检测的场景中,每个车辆都可以作为中心车辆,也可以作为其他车辆的协同车辆,因此,整个协同检测过程是并行的。

[0099]

综上,本实施例2中,提出的基于由粗到细的协作图融合的协同目标检测方法,基于两阶段3d目标检测框架,通过粗粒度下协同区域局部特征的选择和传播,以及细粒度下基于协作图的局部特征融合,大大节省了协同的资源消耗,同时实现准确的目标检测。从粗细粒度两个角度考虑协同,传播并融合其他智能车辆的局部特征,这里的粗粒度协同基于中心车辆盲区的置信度选择所需协同的近邻车辆区域,细粒度协同是基于协作图融合学习协同区域的权重并融合,从而解决了全局特征的资源消耗问题。

[0100]

实施例3

[0101]

本发明实施例3提供一种电子设备,包括存储器和处理器,所述处理器和所述存储器相互通信,所述存储器存储有可被所述处理器执行的程序指令,所述处理器调用所述程序指令执行基于协作图融合的协同目标检测方法,该方法包括如下流程步骤:

[0102]

获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框;

[0103]

基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征;

[0104]

基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征;

[0105]

基于中心车辆新的协作特征,对每个候选区域做分类和回归预测,经过阈值筛选,得到最终的检测结果。

[0106]

实施例4

[0107]

本发明实施例4提供一种计算机可读存储介质,其存储有计算机程序,所述计算机程序被处理器执行时实现基于协作图融合的协同目标检测方法,该方法包括如下流程步骤:

[0108]

获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框;

[0109]

基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征;

[0110]

基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征;

[0111]

基于中心车辆新的协作特征,对每个候选区域做分类和回归预测,经过阈值筛选,得到最终的检测结果。

[0112]

实施例5

[0113]

本发明实施例5提供一种计算机设备,包括存储器和处理器,所述处理器和所述存储器相互通信,所述存储器存储有可被所述处理器执行的程序指令,所述处理器调用所述程序指令执行基于协作图融合的协同目标检测方法,该方法包括如下步骤:

[0114]

获取待检测目标的点云数据,生成二维鸟瞰图和候选区域框;

[0115]

基于粗粒度的方法选取候选区域框中心车辆的检测盲区,根据检测盲区筛选近邻车辆的二维鸟瞰图局部特征;

[0116]

基于细粒度的方法将近邻车辆的二维鸟瞰图局部特征使用协作图融合,得到中心车辆新的协作特征;

[0117]

基于中心车辆新的协作特征,对每个候选区域做分类和回归预测,经过阈值筛选,得到最终的检测结果。

[0118]

综上所述,本发明实施例所述的基于协作图融合的协同目标检测方法及系统,首次尝试从粗粒度和细粒度两个角度考虑局部特征的协同。粗粒度协同是通过检测置信度判断中心车辆的盲区,以及筛选并传播近邻车辆的协同区域特征,细粒度协同是通过融合图的方法为协同区域赋予权重,并更新中心车辆盲区的特征。通过传递局部特征,可以减缓计算资源的压力,更加精准地对中心车辆的盲区进行协同,从而提升协同检测性能。针对已有的基于单阶段3d目标检测模型的精度低的问题,采取两阶段3d目标检测模型,两阶段3d检测模型相比单阶段3d目标检测精度大,同时提出的局部特征提取和协同方法减少了3d目标检测的计算时间和资源,从而进一步发挥两阶段3d目标检测的精度优势。

[0119]

本领域内的技术人员应明白,本发明的实施例可提供为方法、系统、或计算机程序产品。因此,本发明可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本发明可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。

[0120]

本发明是参照根据本发明实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0121]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0122]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方

框或多个方框中指定的功能的步骤。

[0123]

上述虽然结合附图对本发明的具体实施方式进行了描述,但并非对本发明保护范围的限制,所属领域技术人员应该明白,在本发明公开的技术方案的基础上,本领域技术人员在不需要付出创造性劳动即可做出的各种修改或变形,都应涵盖在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1