模型训练方法、物体识别方法、装置、车辆及存储介质与流程

1.本公开涉及自动驾驶技术领域,尤其涉及模型训练方法、物体识别方法、装置、车辆及存储介质。

背景技术:

2.在自动驾驶领域中,可以通过训练得到的模型实现诸多功能。例如,可以通过图像数据训练图像识别模型,从而通过图像识别模型识别车辆所处环境的图像信息。又或者,可以通过激光数据训练激光模型,从而对相关的激光数据进行处理。

3.然而,在相关模型训练方式中,可能需要较多的标注样本。但由于标注样本的数量较少,因此容易出现训练数据不足、模型效果较差的问题。

技术实现要素:

4.为克服相关技术中存在的问题,本公开提供一种模型训练方法、物体识别方法、装置、车辆及存储介质。

5.根据本公开实施例的第一方面,提供一种模型训练方法,包括:获取相机对第一对象采集得到的第一图像以及雷达对所述第一对象采集得到的第一点云数据;通过雷达特征提取网络提取所述第一点云数据的特征,得到第一特征;通过相机特征提取网络提取所述第一图像的特征,得到第二特征;将所述第一特征转换至鸟瞰图表征空间,得到对应于所述第一点云数据的第一鸟瞰图特征;将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征;根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络和所述相机特征提取网络进行训练。

6.可选地,所述根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络和所述相机特征提取网络进行训练,包括:根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算目标损失值;根据所述目标损失值对所述雷达特征提取网络和所述相机特征提取网络进行训练。

7.可选地,所述根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算目标损失值,包括:根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算中心核损失值;计算所述第一鸟瞰图特征以及所述第二鸟瞰图特征之间的对比学习损失值;其中,所述目标损失值包括所述中心核损失值以及所述对比学习损失值。

8.可选地,所述根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算目标损失

值,包括:通过如下计算式计算目标损失值loss:通过如下计算式计算目标损失值loss:通过如下计算式计算目标损失值loss:其中,loss1为中心核损失值,l为所述第一鸟瞰图特征的核函数,k为所述第二鸟瞰图特征的核函数,hsic为希尔伯特-施密特独立性指标,loss2为对比学习损失值,ce为交叉熵损失函数,le为第一鸟瞰图特征,ie为第二鸟瞰图特征,r=0,1,2,

⋯

,n;n为模型训练的批量大小值,t为超参数,α为权重系数。

9.可选地,所述通过雷达特征提取网络提取所述第一点云数据的特征,得到第一特征,包括:基于所述第一点云数据生成雷达图像;通过雷达特征提取网络提取所述雷达图像的特征,得到所述第一特征。

10.可选地,所述将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征,包括:通过特征转换网络将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征;所述根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络和所述相机特征提取网络进行训练,包括:根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络、所述相机特征提取网络以及所述特征转换网络进行训练。

11.根据本公开实施例的第二方面,提供一种物体识别方法,包括:获取相机对第二对象采集得到的第二图像以及雷达对所述第二对象采集得到的第二点云数据;通过雷达特征提取网络提取所述第二点云数据的特征,得到第三特征;通过相机特征提取网络提取所述第二图像的特征,得到第四特征;将所述第三特征和所述第四特征输入至识别网络,得到所述第二对象的识别结果;其中,所述雷达特征提取网络以及所述相机特征提取网络通过上述第一方面中任一项所述的模型训练方法训练得到。

12.根据本公开实施例的第三方面,提供一种模型训练装置,包括:第一获取模块,被配置为获取相机对第一对象采集得到的第一图像以及雷达对所述第一对象采集得到的第一点云数据;第一特征提取模块,被配置为通过雷达特征提取网络提取所述第一点云数据的特征,得到第一特征;

第二特征提取模块,被配置为通过相机特征提取网络提取所述第一图像的特征,得到第二特征;第一特征转换模块,被配置为将所述第一特征转换至鸟瞰图表征空间,得到对应于所述第一点云数据的第一鸟瞰图特征;第二特征转换模块,被配置为将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征;训练模块,被配置为根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络和所述相机特征提取网络进行训练。

13.可选地,所述训练模块,包括:第一计算子模块,被配置为根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算目标损失值;第一训练子模块,被配置为根据所述目标损失值对所述雷达特征提取网络和所述相机特征提取网络进行训练。

14.可选地,所述第一计算子模块,包括:第一计算子单元,被配置为根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算中心核损失值;第二计算子单元,被配置为计算所述第一鸟瞰图特征以及所述第二鸟瞰图特征之间的对比学习损失值;其中,所述目标损失值包括所述中心核损失值以及所述对比学习损失值。

15.可选地,所述第一计算子模块,被配置为通过如下计算式计算目标损失值loss:可选地,所述第一计算子模块,被配置为通过如下计算式计算目标损失值loss:可选地,所述第一计算子模块,被配置为通过如下计算式计算目标损失值loss:其中,loss1为中心核损失值,l为所述第一鸟瞰图特征的核函数,k为所述第二鸟瞰图特征的核函数,hsic为希尔伯特-施密特独立性指标,loss2为对比学习损失值,ce为交叉熵损失函数,le为第一鸟瞰图特征,ie为第二鸟瞰图特征,r=0,1,2,

⋯

,n;n为模型训练的批量大小值,t为超参数,α为权重系数。

16.可选地,所述第一特征提取模块,包括:雷达图像生成子模块,被配置为基于所述第一点云数据生成雷达图像;特征提取子模块,被配置为通过雷达特征提取网络提取所述雷达图像的特征,得到所述第一特征。

17.可选地,所述第二特征转换模块,包括:特征转换子模块,被配置为通过特征转换网络将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征;所述训练模块,包括:

第二训练子模块,被配置为根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络、所述相机特征提取网络以及所述特征转换网络进行训练。

18.根据本公开实施例的第四方面,提供一种模型训练装置,包括:处理器;用于存储处理器可执行指令的存储器;其中,所述处理器被配置为执行上述第一方面中任一项所述的模型训练方法的步骤。

19.根据本公开实施例的第五方面,提供一种计算机可读存储介质,其上存储有计算机程序指令,该程序指令被处理器执行时实现上述第一方面中任一项所述模型训练方法的步骤。

20.根据本公开实施例的第六方面,提供一种物体识别装置,包括:第二获取模块,被配置为获取相机对第二对象采集得到的第二图像以及雷达对所述第二对象采集得到的第二点云数据;第三特征提取模块,被配置为通过雷达特征提取网络提取所述第二点云数据的特征,得到第三特征;第四特征提取模块,被配置为通过相机特征提取网络提取所述第二图像的特征,得到第四特征;第一输入模块,被配置为将所述第三特征和所述第四特征输入至识别网络,得到所述第二对象的识别结果;其中,所述雷达特征提取网络以及所述相机特征提取网络通过上述第一方面中任一项所述的模型训练方法训练得到。

21.根据本公开实施例的第七方面,提供一种车辆,包括:处理器;用于存储处理器可执行指令的存储器;其中,所述处理器被配置为:获取相机对第二对象采集得到的第二图像以及雷达对所述第二对象采集得到的第二点云数据;通过雷达特征提取网络提取所述第二点云数据的特征,得到第三特征;通过相机特征提取网络提取所述第二图像的特征,得到第四特征;将所述第三特征和所述第四特征输入至识别网络,得到所述第二对象的识别结果;其中,所述雷达特征提取网络以及所述相机特征提取网络通过上述第一方面中任一项所述的模型训练方法训练得到。

22.根据本公开实施例的第八方面,提供一种计算机可读存储介质,其上存储有计算机程序指令,该程序指令被处理器执行时实现上述第二方面中所述方法的步骤。

23.上述技术方案中,可以通过雷达特征提取网络提取第一点云数据的第一特征,并通过相机特征提取网络提取第一图像的第二特征。之后,可以将第一特征和第二特征转换至鸟瞰图表征空间,得到对应于第一点云数据的第一鸟瞰图特征以及对应于第一图像的第二鸟瞰图特征。由于第一点云数据和第一图像针对同一对象采集得到,且第一鸟瞰图特征

和第二鸟瞰图特征处于同一表征空间。因此,第一鸟瞰图特征与第二鸟瞰图特征可以互为标签,从而实现无监督训练。通过这样的方式,能够利用相机和雷达采集到的无标签数据进行模型训练,从而减少了模型训练过程对标注样本的依赖。

24.此外,在训练过程中,雷达特征提取网络和相机特征提取网络之间可以相互传递模型信息,从而实现了雷达特征提取网络和相机特征提取网络之间的跨模态联合训练。采用这样的方式,有助于提升雷达特征提取网络和相机特征提取网络的特征提取能力,也有助于提升模型训练效果。

25.应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

附图说明

26.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。

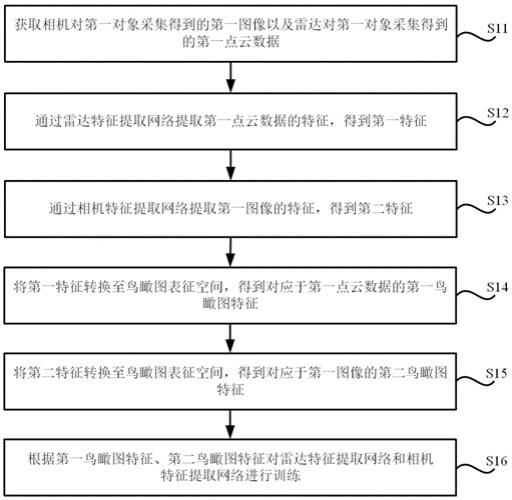

27.图1是根据一示例性实施例示出的一种模型训练方法的流程图。

28.图2是根据一示例性实施例示出的一种第一特征的获取流程图。

29.图3是根据一示例性实施例示出的一种模型训练方法的流程图。

30.图4是根据一示例性实施例示出的一种目标损失值的计算流程图。

31.图5是根据一示例性实施例示出的一种物体识别方法的流程图。

32.图6是根据一示例性实施例示出的一种模型训练装置600的框图。

33.图7是根据一示例性实施例示出的一种物体识别装置700的框图。

34.图8是根据一示例性实施例示出的一种用于模型训练的装置800的框图。

35.图9是根据一示例性实施例示出的一种车辆900的功能框图示意图。

具体实施方式

36.这里将详细地对示例性实施例进行说明,其示例表示在附图中。下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本公开相一致的所有实施方式。相反,它们仅是与如所附权利要求书中所详述的、本公开的一些方面相一致的装置和方法的例子。

37.在介绍本公开的模型训练方法、物体识别方法、装置、车辆及存储介质之前,首先对本公开的应用场景进行介绍。在诸如自动驾驶这样的领域中,可以通过训练得到的模型实现诸多功能。例如,可以通过训练图像感知模型以及激光感知模型来对车辆周围的环境进行感知识别,并通过融合两种模型的输出,得到最终的感知结果。这样,可以通过所述感知结果来辅助整车的控制决策。

38.值得注意的是,这种训练方式需要较多的标注数据。在标注数据较少时,可能难以获得较好的模型训练效果,导致模型泛化能力较差。并且,由于图像感知模型和激光感知模型之间相互独立训练,同时各自的模型也存在着缺陷。因此,训练得到的模型可能存在着性能较差的问题。例如,这样训练得到的激光感知模型可能难以准确地提取场景的语义信息,图像感知模型则可能难以准确地提取场景中物体的空间几何状态。

39.为此,本公开提供一种模型训练方法。图1是本公开一示例性实施例所示出的一种

模型训练方法的流程图,所述方法可以应用于各种静止或可移动的计算设备中,如服务器、台式电脑、笔记本电脑等等。如图1所示,所述方法包括以下步骤。

40.在步骤s11中,获取相机对第一对象采集得到的第一图像以及雷达对第一对象采集得到的第一点云数据。

41.示例地,所述相机为车载相机,所述雷达为车载激光雷达。这样,可以在车辆行驶过程中通过所述相机和所述雷达采集车辆所处环境的数据,将同一时刻采集到的图像数据和点云数据作为一组相匹配的数据对。在训练时,可以从搜集的数据对中获取一部分数据对,将数据对中的图像数据作为所述第一图像,将数据对中的点云数据作为所述第一点云数据。

42.需要注意的是,相机的数量可以是一个或多个,本公开对此不做限制。

43.在步骤s12中,通过雷达特征提取网络提取第一点云数据的特征,得到第一特征。

44.这里,在一种可能的实施方式中,可以通过pointnet(点网络)架构对第一点云数据进行处理,得到点云特征。在这种情况下,所述第一特征可以包括所述点云特征。

45.在一种可能的实施方式中,参照图2所示出的一种第一特征的获取流程图,步骤s12也可以包括:s121,基于第一点云数据生成雷达图像;s122,通过雷达特征提取网络提取雷达图像的特征,得到第一特征。

46.其中,雷达特征提取网络例如可以是通过雷达图像样本预训练得到的主干网(如残差网络),训练方式可以为监督训练,也可以为自监督训练,如mae(masked autoencoders,掩码自动编码器)训练方法。

47.作为一种示例,在获取第一特征时,可以通过对所述第一点云数据进行体素化处理,从而将第一点云数据转换为雷达图像。这样,可以将转换得到的雷达图像输入至雷达特征提取网络,从而获得第一特征。

48.在步骤s13中,通过相机特征提取网络提取第一图像的特征,得到第二特征。

49.其中,相机特征提取网络例如可以是通过相机图像样本预训练得到的主干网(如残差网络),训练方式可以为监督训练,也可以为自监督训练(如mae方法),本公开对此不做限制。

50.以2d图像为例对所述第二特征的获得流程进行说明。在一些实施方式中,可以将所述2d图像输入至相机特征提取网络,得到所述相机特征提取网络输出的第二特征:b*c*h*w。其中,b为模型训练时第一图像的批量大小值(batch size),c为图像通道数,h为图像高度,w为图像宽度。

51.此外,在相机的数量为多个的情况下,可以将各个相机采集得到的图像作为所述第一图像,并通过所述相机特征提取网络分别提取图像特征,得到第二特征:b*n*c*h*w。其中,n为相机数量。

52.在步骤s14中,将第一特征转换至鸟瞰图表征空间,得到对应于第一点云数据的第一鸟瞰图特征。

53.示例地,可以通过embedding的方式将第一特征转换至鸟瞰图表征空间(bird eye view,bev),将转换得到的向量特征作为所述第一鸟瞰图特征。

54.在步骤s15中,将第二特征转换至鸟瞰图表征空间,得到对应于第一图像的第二鸟

瞰图特征。

55.在一些实施方式中,可以对第二特征进行图像特征的深度估计,从而将第二特征转换至鸟瞰图表征空间,得到对应于第一图像的第二鸟瞰图特征。

56.在一些实施方式中,也可以通过深度学习的方式,对第二特征进行转换。例如,可以通过特征转换网络将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征。这里,特征转换网络例如可以包括transform网络架构,本公开对此不做限制。

57.在步骤s16中,根据第一鸟瞰图特征、第二鸟瞰图特征对雷达特征提取网络和相机特征提取网络进行训练。

58.在一种可能的实施方式中,将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征,包括:通过特征转换网络将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征;在这种情况下,所述根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络和所述相机特征提取网络进行训练(步骤s16),包括:根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络、所述相机特征提取网络以及所述特征转换网络进行训练。

59.上述技术方案中,可以通过雷达特征提取网络提取第一点云数据的第一特征,并通过相机特征提取网络提取第一图像的第二特征。之后,可以将第一特征和第二特征转换至鸟瞰图表征空间,得到对应于第一点云数据的第一鸟瞰图特征以及对应于所述第一图像的第二鸟瞰图特征。由于第一点云数据和第一图像针对同一对象采集得到,且第一鸟瞰图特征和第二鸟瞰图特征处于同一表征空间。因此,第一鸟瞰图特征与第二鸟瞰图特征可以互为标签,从而实现无监督训练。通过这样的方式,能够利用相机和雷达采集到的无标签数据进行模型训练,从而减少了模型训练过程对标注样本的依赖。

60.此外,在训练过程中,雷达特征提取网络和相机特征提取网络之间可以相互传递模型信息,从而实现了雷达特征提取网络和相机特征提取网络之间的跨模态联合训练。采用这样的方式,有助于提升雷达特征提取网络和相机特征提取网络的特征提取能力,也有助于提升模型训练效果。

61.值得注意的是,以上实施例仅用以说明本发明的技术方案,而非对其进行限制。本领域的普通技术人员应当理解,在具体实施时,第一特征与第二特征的获取过程并没有先后之分,第一鸟瞰图特征与第二鸟瞰图特征的获取步骤之间也并无先后之分,本公开对此不做限制。

62.图3是本公开一示例性实施例所示出的一种模型训练方法的流程图,参照图3,所述方法包括:在步骤s11中,获取相机对第一对象采集得到的第一图像以及雷达对第一对象采集得到的第一点云数据。

63.在步骤s12中,通过雷达特征提取网络提取第一点云数据的特征,得到第一特征。

64.在步骤s13中,通过相机特征提取网络提取第一图像的特征,得到第二特征。

65.在步骤s14中,将第一特征转换至鸟瞰图表征空间,得到对应于第一点云数据的第

一鸟瞰图特征。

66.在步骤s15中,将第二特征转换至鸟瞰图表征空间,得到对应于第一图像的第二鸟瞰图特征。

67.在步骤s161中,根据第一鸟瞰图特征以及第二鸟瞰图特征计算目标损失值。

68.由于第一点云数据和第一图像针对同一对象采集得到,且第一鸟瞰图特征和第二鸟瞰图特征处于同一表征空间。因此,第一鸟瞰图特征与第二鸟瞰图特征可以互为标签,进而计算损失值。图4是本公开一示例性实施例所示出的一种目标损失值的计算流程图,参照图4,步骤s161可以包括:s41,根据第一鸟瞰图特征以及第二鸟瞰图特征计算中心核损失值。

69.作为一种示例,可以通过如下计算式计算中心核损失值loss1:其中,hsic(hilbert-schmidt independence criterion)为希尔伯特-施密特独立性指标,可以度量两个变量之间的独立性。hsic的作用跟互信息类似,但是它不需要估计两个变量的概率密度,而是直接转化为采样的形式,从而计算两个变量的相关性。l为所述第一鸟瞰图特征的核函数,k为所述第二鸟瞰图特征的核函数。作为一种示例,核函数l和核函数k可以选用线性核函数。

70.s42,计算第一鸟瞰图特征以及第二鸟瞰图特征之间的对比学习损失值,目标损失值包括中心核损失值以及对比学习损失值。

71.作为一种示例,可以通过如下计算式计算对比学习损失值loss2:其中,ce为交叉熵损失函数,le为第一鸟瞰图特征,ie为第二鸟瞰图特征,r=0,1,2,

⋯

,n;n为模型训练的批量大小值,t为超参数。

72.这样,目标损失值loss可以表示为:其中,α为权重系数。在具体实施时,α的取值例如可以设为0.5。

73.也就是说,目标损失值可以包括中心核损失值以及对比学习损失值两个部分。采用这样的方式,中心核损失值有助于网络学习特征的语义信息,因而有助于提升雷达特征提取网络对于场景语义信息的提取能力。此外,对比学习损失值有助于网络学习对象的空间几何关系,因而有助于提升图像特征提取网络对于空间几何关系特征的提取能力。

74.值得说明的是,在一些可能的实施场景中,也可以为目标损失值和/或对比学习损失值设置权重系数。所述权重系数用于调整中心核损失值以及对比学习损失值在目标损失值中的占比。以使得中心核损失值的第一占比与对比学习损失值的第二占比的差值小于预设阈值,或是使得所述第一占比等于所述第二占比。其中,所述第一占比为中心核损失值占所述目标损失值的比率;所述第二占比为对比学习损失值占所述目标损失值的比率。通过这样的方式,能够调整模型的训练侧重点。

75.在步骤s162中,根据目标损失值对雷达特征提取网络和相机特征提取网络进行训练。

76.采用上述技术方案,第一鸟瞰图特征与第二鸟瞰图特征可以互为标签,从而实现无监督训练。通过这样的方式,能够利用相机和雷达采集到的无标签数据进行模型训练,从而减少了模型训练过程对标注样本的依赖。此外,在训练过程中,雷达特征提取网络和相机特征提取网络之间可以相互传递模型信息,从而实现了雷达特征提取网络和相机特征提取网络之间的跨模态联合训练。采用这样的方式,有助于提升雷达特征提取网络和相机特征提取网络的特征提取能力,提升训练效果。

77.本公开还提供一种物体识别方法。图5是本公开所示出的一种物体识别方法的流程图,参照图5,所述方法包括:在步骤s51中,获取相机对第二对象采集得到的第二图像以及雷达对第二对象采集得到的第二点云数据。

78.示例地,所述相机为车载相机,所述雷达为车载激光雷达。这样,可以在车辆行驶过程中通过所述相机和所述雷达采集车辆所处环境的数据,将同一时刻采集到的图像数据和点云数据作为一组相匹配的数据对。在物体识别时,可以将待识别的数据对中的图像数据作为所述第二图像,将所述数据对中的点云数据作为所述第二点云数据。

79.在步骤s52中,通过雷达特征提取网络提取第二点云数据的特征,得到第三特征。

80.在步骤s53中,通过相机特征提取网络提取第二图像的特征,得到第四特征。

81.在步骤s54中,将第三特征和第四特征输入至识别网络,得到第二对象的识别结果。

82.其中,所述雷达特征提取网络以及所述相机特征提取网络通过本公开所提供的模型训练方法训练得到。所述识别网络例如可以是分类网络、检测网络等等,具体请参照相关技术中的说明,本公开对此不做赘述。

83.上述技术方案能够利用相机和雷达采集到的无标签数据进行模型训练,从而减少了模型训练过程对标注样本的依赖。此外,在训练过程中,雷达特征提取网络和相机特征提取网络之间可以相互传递模型信息,从而实现了雷达特征提取网络和相机特征提取网络之间的跨模态联合训练。采用这样的方式,有助于提升雷达特征提取网络和相机特征提取网络的特征提取能力,进而有助于提升输入至识别网络的特征的准确度,最终起到提升物体识别准确度的效果。

84.本公开还提供一种模型训练装置。图6是本公开一示例性实施例所示出的一种模型训练装置600的框图,如图6所示,模型训练装置600包括:第一获取模块601,被配置为获取相机对第一对象采集得到的第一图像以及雷达对所述第一对象采集得到的第一点云数据;第一特征提取模块602,被配置为通过雷达特征提取网络提取所述第一点云数据的特征,得到第一特征;第二特征提取模块603,被配置为通过相机特征提取网络提取所述第一图像的特征,得到第二特征;第一特征转换模块604,被配置为将所述第一特征转换至鸟瞰图表征空间,得到对应于所述第一点云数据的第一鸟瞰图特征;

第二特征转换模块605,被配置为将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征;训练模块606,被配置为根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络和所述相机特征提取网络进行训练。

85.上述技术方案中,可以通过雷达特征提取网络提取第一点云数据的第一特征,并通过相机特征提取网络提取第一图像的第二特征。之后,可以将第一特征和第二特征转换至鸟瞰图表征空间,得到对应于第一点云数据的第一鸟瞰图特征以及对应于所述第一图像的第二鸟瞰图特征。由于第一点云数据和第一图像针对同一对象采集得到,且第一鸟瞰图特征和第二鸟瞰图特征处于同一表征空间。因此,第一鸟瞰图特征与第二鸟瞰图特征可以互为标签,从而实现无监督训练。通过这样的方式,能够利用相机和雷达采集到的无标签数据进行模型训练,从而减少了模型训练过程对标注样本的依赖。

86.此外,在训练过程中,雷达特征提取网络和相机特征提取网络之间可以相互传递模型信息,从而实现了雷达特征提取网络和相机特征提取网络之间的跨模态联合训练。采用这样的方式,有助于提升雷达特征提取网络和相机特征提取网络的特征提取能力,提升训练效果。

87.可选地,所述训练模块606,包括:第一计算子模块,被配置为根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算目标损失值;第一训练子模块,被配置为根据所述目标损失值对所述雷达特征提取网络和所述相机特征提取网络进行训练。

88.可选地,所述第一计算子模块,包括:第一计算子单元,被配置为根据所述第一鸟瞰图特征以及所述第二鸟瞰图特征计算中心核损失值;第二计算子单元,被配置为计算所述第一鸟瞰图特征以及所述第二鸟瞰图特征之间的对比学习损失值;其中,所述目标损失值包括所述中心核损失值以及所述对比学习损失值。

89.可选地,所述第一计算子模块,被配置为通过如下计算式计算目标损失值loss:可选地,所述第一计算子模块,被配置为通过如下计算式计算目标损失值loss:可选地,所述第一计算子模块,被配置为通过如下计算式计算目标损失值loss:其中,loss1为中心核损失值,l为所述第一鸟瞰图特征的核函数,k为所述第二鸟瞰图特征的核函数,hsic为希尔伯特-施密特独立性指标,loss2为对比学习损失值,ce为交叉熵损失函数,le为第一鸟瞰图特征,ie为第二鸟瞰图特征,r=0,1,2,

⋯

,n;n为模型训练的批量大小值,t为超参数,α为权重系数。

90.可选地,所述第一特征提取模块602,包括:

雷达图像生成子模块,被配置为基于所述第一点云数据生成雷达图像;特征提取子模块,被配置为通过雷达特征提取网络提取所述雷达图像的特征,得到所述第一特征。

91.可选地,所述第二特征转换模块605,包括:特征转换子模块,被配置为通过特征转换网络将所述第二特征转换至所述鸟瞰图表征空间,得到对应于所述第一图像的第二鸟瞰图特征;所述训练模块606,包括:第二训练子模块,被配置为根据所述第一鸟瞰图特征、所述第二鸟瞰图特征对所述雷达特征提取网络、所述相机特征提取网络以及所述特征转换网络进行训练。

92.本公开还提供一种模型训练装置,包括:处理器;用于存储处理器可执行指令的存储器;其中,所述处理器被配置为执行本公开所提供的模型训练方法的步骤。

93.本公开还提供一种计算机可读存储介质,其上存储有计算机程序指令,该程序指令被处理器执行时实现本公开所提供的模型训练方法的步骤。

94.图7是本公开一示例性实施例所示出的一种物体识别装置700的框图,参照图7,物体识别装置700包括:第二获取模块701,被配置为获取相机对第二对象采集得到的第二图像以及雷达对所述第二对象采集得到的第二点云数据;第三特征提取模块702,被配置为通过雷达特征提取网络提取所述第二点云数据的特征,得到第三特征;第四特征提取模块703,被配置为通过相机特征提取网络提取所述第二图像的特征,得到第四特征;第一输入模块704,被配置为将所述第三特征和所述第四特征输入至识别网络,得到所述第二对象的识别结果;其中,所述雷达特征提取网络以及所述相机特征提取网络通过本公开所提供的模型训练方法训练得到。

95.上述技术方案能够利用相机和雷达采集到的无标签数据进行模型训练,从而减少了模型训练过程对标注样本的依赖。此外,在训练过程中,雷达特征提取网络和相机特征提取网络之间可以相互传递模型信息,从而实现了雷达特征提取网络和相机特征提取网络之间的跨模态联合训练。采用这样的方式,有助于提升雷达特征提取网络和相机特征提取网络的特征提取能力,进而有助于提升输入至识别网络的特征的准确度,最终起到提升物体识别准确度的效果。

96.本公开还提供一种车辆,包括:处理器;用于存储处理器可执行指令的存储器;其中,所述处理器被配置为:获取相机对第二对象采集得到的第二图像以及雷达对所述第二对象采集得到的第二点云数据;

通过雷达特征提取网络提取所述第二点云数据的特征,得到第三特征;通过相机特征提取网络提取所述第二图像的特征,得到第四特征;将所述第三特征和所述第四特征输入至识别网络,得到所述第二对象的识别结果;其中,所述雷达特征提取网络以及所述相机特征提取网络通过本公开所提供的模型训练方法训练得到。

97.本公开还提供一种计算机可读存储介质,其上存储有计算机程序指令,该程序指令被处理器执行时实现本公开所提供的物体识别方法的步骤。

98.关于上述实施例中的装置,其中各个模块执行操作的具体方式已经在有关该方法的实施例中进行了详细描述,此处将不做详细阐述说明。

99.图8是根据一示例性实施例示出的一种用于模型训练的装置800的框图。例如,装置800可以是移动电话,计算机,消息收发设备,游戏控制台,平板设备等。

100.参照图8,装置800可以包括以下一个或多个组件:处理组件802,第一存储器804,电源组件806,多媒体组件808,音频组件810,输入/输出接口812,传感器组件814,以及通信组件816。

101.处理组件802通常控制装置800的整体操作,诸如与显示,电话呼叫,数据通信,相机操作和记录操作相关联的操作。处理组件802可以包括一个或多个第一处理器820来执行指令,以完成上述的模型训练方法的全部或部分步骤。此外,处理组件802可以包括一个或多个模块,便于处理组件802和其他组件之间的交互。例如,处理组件802可以包括多媒体模块,以方便多媒体组件808和处理组件802之间的交互。

102.第一存储器804被配置为存储各种类型的数据以支持在装置800的操作。这些数据的示例包括用于在装置800上操作的任何应用程序或方法的指令,训练数据,消息,图片,视频等。第一存储器804可以由任何类型的易失性或非易失性存储设备或者它们的组合实现,如静态随机存取存储器(sram),电可擦除可编程只读存储器(eeprom),可擦除可编程只读存储器(eprom),可编程只读存储器(prom),只读存储器(rom),磁存储器,快闪存储器,磁盘或光盘。

103.电源组件806为装置800的各种组件提供电力。电源组件806可以包括电源管理系统,一个或多个电源,及其他与为装置800生成、管理和分配电力相关联的组件。

104.多媒体组件808包括在所述装置800和用户之间的提供一个输出接口的屏幕。在一些实施例中,屏幕可以包括液晶显示器(lcd)和触摸面板(tp)。如果屏幕包括触摸面板,屏幕可以被实现为触摸屏,以接收来自用户的输入信号。触摸面板包括一个或多个触摸传感器以感测触摸、滑动和触摸面板上的手势。所述触摸传感器可以不仅感测触摸或滑动动作的边界,而且还检测与所述触摸或滑动操作相关的持续时间和压力。在一些实施例中,多媒体组件808包括一个前置摄像头和/或后置摄像头。当装置800处于操作模式,如拍摄模式或视频模式时,前置摄像头和/或后置摄像头可以接收外部的多媒体数据。每个前置摄像头和后置摄像头可以是一个固定的光学透镜系统或具有焦距和光学变焦能力。

105.音频组件810被配置为输出和/或输入音频信号。例如,音频组件810包括一个麦克风(mic),当装置800处于操作模式,如呼叫模式、记录模式和语音识别模式时,麦克风被配置为接收外部音频信号。所接收的音频信号可以被进一步存储在第一存储器804或经由通

信组件816发送。在一些实施例中,音频组件810还包括一个扬声器,用于输出音频信号。

106.输入/输出接口812为处理组件802和外围接口模块之间提供接口,上述外围接口模块可以是键盘,点击轮,按钮等。这些按钮可包括但不限于:音量按钮、启动按钮和锁定按钮。

107.传感器组件814包括一个或多个传感器,用于为装置800提供各个方面的状态评估。例如,传感器组件814可以检测到装置800的打开/关闭状态,组件的相对定位,例如所述组件为装置800的显示器和小键盘,传感器组件814还可以检测装置800或装置800一个组件的位置改变,用户与装置800接触的存在或不存在,装置800方位或加速/减速和装置800的温度变化。传感器组件814可以包括接近传感器,被配置用来在没有任何的物理接触时检测附近物体的存在。传感器组件814还可以包括光传感器,如cmos或ccd图像传感器,用于在成像应用中使用。在一些实施例中,该传感器组件814还可以包括加速度传感器,陀螺仪传感器,磁传感器,压力传感器或温度传感器。

108.通信组件816被配置为便于装置800和其他设备之间有线或无线方式的通信。装置800可以接入基于通信标准的无线网络,如wifi,4g或5g,或它们的组合。在一个示例性实施例中,通信组件816经由广播信道接收来自外部广播管理系统的广播信号或广播相关信息。在一个示例性实施例中,所述通信组件816还包括近场通信(nfc)模块,以促进短程通信。例如,在nfc模块可基于射频识别(rfid)技术,红外数据协会(irda)技术,超宽带(uwb)技术,蓝牙(bt)技术和其他技术来实现。

109.在示例性实施例中,装置800可以被一个或多个应用专用集成电路(asic)、数字信号处理器(dsp)、数字信号处理设备(dspd)、可编程逻辑器件(pld)、现场可编程门阵列(fpga)、控制器、微控制器、微处理器或其他电子元件实现,用于执行上述模型训练方法。

110.在示例性实施例中,还提供了一种包括指令的非临时性计算机可读存储介质,例如包括指令的第一存储器804,上述指令可由装置800的第一处理器820执行以完成上述模型训练方法。例如,所述非临时性计算机可读存储介质可以是rom、随机存取存储器(ram)、cd-rom、磁带、软盘和光数据存储设备等。

111.参阅图9,图9是一示例性实施例示出的一种车辆900的功能框图示意图。车辆900可以被配置为完全或部分自动驾驶模式。例如,车辆900可以通过感知系统920获取其周围的环境信息,并基于对周边环境信息的分析得到自动驾驶策略以实现完全自动驾驶,或者将分析结果呈现给用户以实现部分自动驾驶。

112.车辆900可包括各种子系统,例如,信息娱乐系统910、感知系统920、决策控制系统930、驱动系统940以及计算平台950。可选的,车辆900可包括更多或更少的子系统,并且每个子系统都可包括多个部件。另外,车辆900的每个子系统和部件可以通过有线或者无线的方式实现互连。

113.在一些实施例中,信息娱乐系统910可以包括通信系统911,娱乐系统912以及导航系统913。

114.通信系统911可以包括无线通信系统,无线通信系统可以直接地或者经由通信网络来与一个或多个设备无线通信。例如,无线通信系统可使用3g蜂窝通信,例如cdma、evd0、gsm/gprs,或者4g蜂窝通信,例如lte。或者5g蜂窝通信。无线通信系统可利用wifi与无线局域网(wireless local area network,wlan)通信。在一些实施例中,无线通信系统可利用

红外链路、蓝牙或zigbee与设备直接通信。其他无线协议,例如各种车辆通信系统,例如,无线通信系统可包括一个或多个专用短程通信(dedicated short range communications,dsrc)设备,这些设备可包括车辆和/或路边台站之间的公共和/或私有数据通信。

115.娱乐系统912可以包括显示设备,麦克风和音响,用户可以基于娱乐系统在车内收听广播,播放音乐;或者将手机和车辆联通,在显示设备上实现手机的投屏,显示设备可以为触控式,用户可以通过触摸屏幕进行操作。

116.在一些情况下,可以通过麦克风获取用户的语音信号,并依据对用户的语音信号的分析实现用户对车辆900的某些控制,例如调节车内温度等。在另一些情况下,可以通过音响向用户播放音乐。

117.导航系统913可以包括由地图供应商所提供的地图服务,从而为车辆900提供行驶路线的导航,导航系统913可以和车辆的全球定位系统921、惯性测量单元922配合使用。地图供应商所提供的地图服务可以为二维地图,也可以是高精地图。

118.感知系统920可包括感测关于车辆900周边的环境的信息的若干种传感器。例如,感知系统920可包括全球定位系统921(全球定位系统可以是gps系统,也可以是北斗系统或者其他定位系统)、惯性测量单元(inertial measurement unit,imu)922、激光雷达923、毫米波雷达924、超声雷达925以及摄像装置926。感知系统920还可包括被监视车辆900的内部系统的传感器(例如,车内空气质量监测器、燃油量表、机油温度表等)。来自这些传感器中的一个或多个的传感器数据可用于检测对象及其相应特性(位置、形状、方向、速度等)。这种检测和识别是车辆900的安全操作的关键功能。

119.全球定位系统921用于估计车辆900的地理位置。

120.惯性测量单元922用于基于惯性加速度来感测车辆900的位姿变化。在一些实施例中,惯性测量单元922可以是加速度计和陀螺仪的组合。

121.激光雷达923利用激光来感测车辆900所位于的环境中的物体。在一些实施例中,激光雷达923可包括一个或多个激光源、激光扫描器以及一个或多个检测器,以及其他系统组件。

122.毫米波雷达924利用无线电信号来感测车辆900的周边环境内的物体。在一些实施例中,除了感测物体以外,毫米波雷达924还可用于感测物体的速度和/或前进方向。

123.超声雷达925可以利用超声波信号来感测车辆900周围的物体。

124.摄像装置926用于捕捉车辆900的周边环境的图像信息。摄像装置926可以包括单目相机、双目相机、结构光相机以及全景相机等,摄像装置926获取的图像信息可以包括静态图像,也可以包括视频流信息。

125.决策控制系统930包括基于感知系统920所获取的信息进行分析决策的计算系统931,决策控制系统930还包括对车辆900的动力系统进行控制的整车控制器932,以及用于控制车辆900的转向系统933、油门934和制动系统935。

126.计算系统931可以操作来处理和分析由感知系统920所获取的各种信息以便识别车辆900周边环境中的目标、物体和/或特征。目标可以包括行人或者动物,物体和/或特征可包括交通信号、道路边界和障碍物。计算系统931可使用物体识别算法、运动中恢复结构(structure from motion,sfm)算法、视频跟踪等技术。在一些实施例中,计算系统931可以用于为环境绘制地图、跟踪物体、估计物体的速度等等。计算系统931可以将所获取的各种

信息进行分析并得出对车辆的控制策略。

127.整车控制器932可以用于对车辆的动力电池和引擎941进行协调控制,以提升车辆900的动力性能。

128.转向系统933可操作来调整车辆900的前进方向。例如在一个实施例中可以为方向盘系统。

129.油门934用于控制引擎941的操作速度并进而控制车辆900的速度。

130.制动系统935用于控制车辆900减速。制动系统935可使用摩擦力来减慢车轮944。在一些实施例中,制动系统935可将车轮944的动能转换为电流。制动系统935也可采取其他形式来减慢车轮944转速从而控制车辆900的速度。

131.驱动系统940可包括为车辆900提供动力运动的组件。在一个实施例中,驱动系统940可包括引擎941、能量源942、传动系统943和车轮944。引擎941可以是内燃机、电动机、空气压缩引擎或其他类型的引擎组合,例如汽油发动机和电动机组成的混动引擎,内燃引擎和空气压缩引擎组成的混动引擎。引擎941将能量源942转换成机械能量。

132.能量源942的示例包括汽油、柴油、其他基于石油的燃料、丙烷、其他基于压缩气体的燃料、乙醇、太阳能电池板、电池和其他电力来源。能量源942也可以为车辆900的其他系统提供能量。

133.传动系统943可以将来自引擎941的机械动力传送到车轮944。传动系统943可包括变速箱、差速器和驱动轴。在一个实施例中,传动系统943还可以包括其他器件,比如离合器。其中,驱动轴可包括可耦合到一个或多个车轮944的一个或多个轴。

134.车辆900的部分或所有功能受计算平台950控制。计算平台950可包括至少一个第二处理器951,第二处理器951可以执行存储在例如第二存储器952这样的非暂态计算机可读介质中的指令953。在一些实施例中,计算平台950还可以是采用分布式方式控制车辆900的个体组件或子系统的多个计算设备。

135.第二处理器951可以是任何常规的处理器,诸如商业可获得的cpu。可替换地,第二处理器951还可以包括诸如图像处理器(graphic process unit,gpu),现场可编程门阵列(field programmable gate array,fpga)、片上系统(system on chip,soc)、专用集成芯片(application specific integrated circuit,asic)或它们的组合。尽管图9功能性地图示了第二处理器951、第二存储器952、和在相同块中的计算机的其它元件,但是本领域的普通技术人员应该理解该第二处理器951、计算机、或第二存储器952实际上可以包括可以或者可以不存储在相同的物理外壳内的多个处理器、计算机、或存储器。例如,第二存储器952可以是硬盘驱动器或位于不同于计算机的外壳内的其它存储介质。因此,对第二处理器951或计算机的引用将被理解为包括对可以或者可以不并行操作的处理器或计算机或存储器的集合的引用。不同于使用单一的处理器来执行此处所描述的步骤,诸如转向组件和减速组件的一些组件每个都可以具有其自己的处理器,处理器只执行与特定于组件的功能相关的计算。

136.在本公开实施方式中,第二处理器951可以执行上述的物体识别方法。

137.在此处所描述的各个方面中,第二处理器951可以位于远离该车辆并且与该车辆进行无线通信。在其它方面中,此处所描述的过程中的一些在布置于车辆内的处理器上执行而其它则由远程处理器执行,包括采取执行单一操纵的必要步骤。

138.在一些实施例中,第二存储器952可包含指令953(例如,程序逻辑),指令953可被第二处理器951执行来执行车辆900的各种功能。第二存储器952也可包含额外的指令,包括向信息娱乐系统910、感知系统920、决策控制系统930、驱动系统940中的一个或多个发送数据、从其接收数据、与其交互和/或对其进行控制的指令。

139.除了指令953以外,第二存储器952还可存储数据,例如道路地图、路线信息,车辆的位置、方向、速度以及其它这样的车辆数据,以及其他信息。这种信息可在车辆900在自主、半自主和/或手动模式中操作期间被车辆900和计算平台950使用。

140.计算平台950可基于从各种子系统(例如,驱动系统940、感知系统920和决策控制系统930)接收的输入来控制车辆900的功能。例如,计算平台950可利用来自决策控制系统930的输入以便控制转向系统933来避免由感知系统920检测到的障碍物。在一些实施例中,计算平台950可操作来对车辆900及其子系统的许多方面提供控制。

141.可选地,上述这些组件中的一个或多个可与车辆900分开安装或关联。例如,第二存储器952可以部分或完全地与车辆900分开存在。上述组件可以按有线和/或无线方式来通信地耦合在一起。

142.可选地,上述组件只是一个示例,实际应用中,上述各个模块中的组件有可能根据实际需要增添或者删除,图9不应理解为对本公开实施例的限制。

143.在道路行进的自动驾驶汽车,如上面的车辆900,可以识别其周围环境内的物体以确定对当前速度的调整。物体可以是其它车辆、交通控制设备、或者其它类型的物体。在一些示例中,可以独立地考虑每个识别的物体,并且基于物体的各自的特性,诸如它的当前速度、加速度、与车辆的间距等,可以用来确定自动驾驶汽车所要调整的速度。

144.可选地,车辆900或者与车辆900相关联的感知和计算设备(例如计算系统931、计算平台950)可以基于所识别的物体的特性和周围环境的状态(例如,交通、雨、道路上的冰、等等)来预测识别的物体的行为。可选地,每一个所识别的物体都依赖于彼此的行为,因此还可以将所识别的所有物体全部一起考虑来预测单个识别的物体的行为。车辆900能够基于预测的识别的物体的行为来调整它的速度。换句话说,自动驾驶汽车能够基于所预测的物体的行为来确定车辆将需要调整到(例如,加速、减速、或者停止)何种稳定状态。在这个过程中,也可以考虑其它因素来确定车辆900的速度,诸如,车辆900在行驶的道路中的横向位置、道路的曲率、静态和动态物体的接近度等等。

145.除了提供调整自动驾驶汽车的速度的指令之外,计算设备还可以提供修改车辆900的转向角的指令,以使得自动驾驶汽车遵循给定的轨迹和/或维持与自动驾驶汽车附近的物体(例如,道路上的相邻车道中的车辆)的安全横向和纵向距离。

146.上述车辆900可以为各种类型的行驶工具,例如,轿车、卡车、摩托车、公共汽车等等,本公开实施例不做特别的限定。

147.在另一示例性实施例中,还提供一种计算机程序产品,该计算机程序产品包含能够由可编程的装置执行的计算机程序,该计算机程序具有当由该可编程的装置执行时用于执行上述的模型训练方法的代码部分。

148.在另一示例性实施例中,还提供一种计算机程序产品,该计算机程序产品包含能够由可编程的装置执行的计算机程序,该计算机程序具有当由该可编程的装置执行时用于执行上述的物体识别方法的代码部分。

149.本领域技术人员在考虑说明书及实践本公开后,将容易想到本公开的其它实施方案。本技术旨在涵盖本公开的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本公开的真正范围和精神由下面的权利要求指出。

150.应当理解的是,本公开并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本公开的范围仅由所附的权利要求来限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1