基于弱监督学习的多对象场景时空动作定位方法及装置与流程

1.本发明涉及计算机视觉领域,尤其涉及一种基于弱监督学习的多对象场景时空动作定位方法及装置。

背景技术:

2.利用计算机视觉方法对视频中的目标对象进行动作识别,为许多重要的下游任务(如异常行为监测)提供支持。在这种情况下,一个重要的问题是对视频中目标对象的动作进行时空定位。该问题旨在判断具体时间点及具体空间位置下目标对象的动作类别。然而,通常使用的全监督时空动作定位方法依赖大量繁琐的手工标注。

3.(1)时空动作定位(参见文献[1]):时空动作定位需要定位动作的持续时间和空间位置,并识别动作类别。早期的时空动作定位方法主要关注在一个只包含一个人或者人数较少的短视频中的动作定位,不能适用于人群密集的监控场景。

[0004]

(2)弱监督动作定位(参见文献[2]):以往关于动作定位问题的研究大多是全监督的方法,这需要在视频的每一帧进行完整和详细的标注,注释过程繁琐、成本较高。弱监督动作定位方法可以大大降低对复杂标注的依赖。但现有弱监督动作定位方法通常只关注场景中有一两个人的情况,无法解决密集多人场景下的动作定位问题。

[0005]

(3)多实例学习技术:多实例学习技术被广泛应用于多种弱监督方法中。但现有多实例学习技术存在对标注信息利用率低下的问题。

[0006]

参考文献

[0007]

[1]chunhui gu,chen sun,david a ross,carl vondrick,caroline pantofaru,yeqing li,sudheendra vijayanarasimhan,george toderici,susanna ricco,rahul sukthankar:ava:a video dataset of spatio-temporally localized atomic visual actions.cvpr 2018:6047

–

6056.

[0008]

[2]ch

é

ron,guilhem,alayrac j b,laptev i:a flexible model for training action localization with varying levels of supervision.nips 2018:942

–

953.

技术实现要素:

[0009]

本发明提供了一种基于弱监督学习的多对象场景时空动作定位方法及装置,本发明利用较少的数据标注,完成密集人群场景中的时空动作定位,有效解决了多人场景时空动作定位中缺乏大规模训练数据的问题,取得了较好的结果,详见下文描述:

[0010]

一种基于弱监督学习的多对象场景时空动作定位方法,所述方法包括:

[0011]

使用卷积神经网络作为特征提取网络,对视频进行逐帧的特征提取,对每个视频帧进行目标对象特征提取通过全连接层输出所有个体的特征向量;

[0012]

计算原始数据集中的个体集xm的多个体包标签并通过个体的特征向量计算出动作预测结果计算多个体包标签与动作预测结果间的交叉熵损失;

[0013]

对于帧t寻找与其在一定范围内的临近帧,以阈值ξ

t

进行筛选,对合格的个体生成

伪标签,考察无标签个体x,计算其最大预测值与最可能的标签值之间的交叉熵损失c,以阈值ξa,ξc为标准进行筛选,将合格的个体新增为锚定个体;

[0014]

综合考虑交叉熵损失函数,以作为总损失函数,利用原始训练集以及伪标签后的新数据集进行参数更新,在完成指定轮训练后停止;

[0015]

将待识别视频分解为若干帧,将其逐帧输入训练完成的网络中进行动作识别,输出视频帧中所有个体的动作类别。

[0016]

其中,所述计算原始数据集中的个体集xm的多个体包标签并通过个体的特征向量计算出动作预测结果具体为:

[0017]

将m个具有标签的个体xm={x1,x2,

…

,xm}组成的整体标记为多个体包多个体包的标签由下式得出:

[0018][0019]

其中,ym表示个体xm的动作标签,表示对应元素逐个做或运算;

[0020]

对于具有m个个体的包计算多个体包级的动作预测结果k表示动作类别数量,预测结果可由下式得出:

[0021][0022]

其中,φ表示聚合函数;pm∈r1×k表示个体xm的动作预测结果,通过带有roialign的inception-v3网络得到。

[0023]

其中,所述方法还包括:对动作预测结果进行训练,具体为:

[0024]

计算最小损失

[0025][0026]

其中,在计算时聚合函数φ采用min-pooling函数;

[0027]

计算中间损失

[0028][0029]

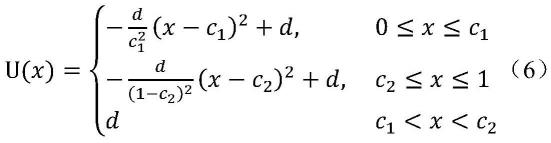

其中,表示预测值不在最大损失、最小损失中的个体集合,u函数定义为:

[0030][0031]

其中,c1,c2∈[0,1],d》0为预先设定好的参数;

[0032]

最终,改进的多个体损失函数表示为:

[0033][0034]

其中,参数α、β用于平衡不同的情况,总损失函数在各个包上求和得到;

[0035]

对于矩阵p引入不确定量计算多个体包损失

[0036][0037]

其中,所述以阈值ξ

t

进行筛选为:

[0038]

对于一锚定个体q

t

,假定其标签为动作k,对于相邻帧t-1,若同一个体q

t-1

的预测动作类别同样为k,且相应的预测分数大于阈值ξ

t

,则对于未标注个体q

t-1

生成动作类别为k的伪标签,并将其加入训练集,用同样的方法在[t-r,t+r]的区间内逐帧的将单帧的标注扩展为多帧的标注。

[0039]

其中,所述以阈值ξa,ξc为标准进行筛选阈值为:

[0040]

对于某一无标签个体xn,在其所有动作类别的预测分当中类别k的预测分最高,计算预测可信度c,c为预测值与最可能的标签值之间的交叉熵损失;当且仅当预测值与可信度c满足以下关系时,增加个体xn作为锚定个体:

[0041][0042]

其中,ξa,ξc为阈值参数。

[0043]

一种基于弱监督学习的多对象场景时空动作定位装置,所述装置包括:处理器和存储器,所述存储器中存储有程序指令,所述处理器调用存储器中存储的程序指令以使装置执行所述的方法步骤。

[0044]

本发明提供的技术方案的有益效果是:

[0045]

1、本发明首次研究了多人场景中的弱监督时空动作定位问题,能够有效的应用于视频监控和体育场景分析中,对比于全监督的时空动作定位方法,无需大规模训练数据,具有较高的应用性;

[0046]

2、本发明采用的弱监督动作定位的方法在大幅减少了所需标注量的基础上,实现了与完全监督方法类似的结果,识别效果较好;

[0047]

3、本发明可用于视频监控和体育场景分析,无需大量繁琐手工标注的情况下,对于视频中动作的种类、位置、持续时间进行识别;

[0048]

4、本发明旨在一个多人的场景中定位每个人的动作,这更符合时空动作定位在现实世界中的应用。

附图说明

[0049]

图1为一种基于弱监督学习的多对象场景时空动作定位方法的流程图;

[0050]

图2为一种基于弱监督学习的多对象场景时空动作定位装置的结构示意图。

具体实施方式

[0051]

为使本发明的目的、技术方案和优点更加清楚,下面对本发明实施方式作进一步地详细描述。

[0052]

实施例1

[0053]

本发明实施例提供了一种基于弱监督学习的多对象场景时空动作定位方法,参见图1,该方法包括以下步骤:

[0054]

步骤101:使用卷积神经网络”作为主干搭建特征提取网络,并对视频进行逐帧的特征提取,对于每个视频帧使用roialign(目标对象特征提取技术)以及全连接层得到所有个体的特征向量;

[0055]

步骤102:计算原始数据集中的个体集xm的多个体包标签并通过步骤101中个体的特征向量计算出动作预测结果计算多个体包标签与动作预测结果间的交叉熵损失;

[0056]

步骤103:首先对于帧t寻找与其在一定范围内的临近帧,考察临近帧内的对应锚定个体动作预测值,以阈值ξ

t

为标准进行筛选,对合格的个体生成伪标签,然后考察无标签个体x,计算其最大预测值与最可能的标签值之间的交叉熵损失c,以阈值ξa,ξc为标准进行筛选,将合格的个体新增为锚定个体;

[0057]

步骤104:综合考虑步骤102、103中的交叉熵损失函数,以作为总损失函数,利用原始训练集以及加入步骤103中生成的伪标签后的新数据集进行参数更新,在完成指定轮训练后停止;

[0058]

步骤105:将待识别视频分解为若干帧,将其逐帧输入步骤104中训练完成的网络中进行动作识别,网络将输出视频帧中所有个体的动作类别。

[0059]

综上所述,本发明实施例通过上述步骤101-105用于在视频监控和体育场景分析中,缺乏大规模训练数据及手工标注过程繁琐的情况下,对于视频中动作的种类、位置、持续时间进行识别。

[0060]

实施例2

[0061]

下面结合图1,具体的计算公式,实例对实施例1中的方案进行进一步地介绍,详见下文描述:

[0062]

本发明实施例采用的技术方案为:一种多人场景中的弱监督时空动作定位方法,主要从两个方面进行说明:一是问题的定义,二是基于上述定义的弱监督训练方法。

[0063]

一、问题定义:

[0064]

给定一个未剪辑的视频,该视频共具有k个动作类别,n个个体。对于视频中的个体用xn={x1,x2,

…

,xn}表示,个体的真实动作标签表示为向量yn∈r1×k。本发明实施例的目标旨在建立并训练弱监督的动作识别网络,对于每个个体预测矩阵p∈{0,1}n×k,该矩阵第n行第k列的元素表示对应个体n的k动作的预测概率。

[0065]

二、弱监督动作定位方法:

[0066]

对于数据标注较少的多人场景时空动作定位问题,本发明实施例的弱监督动作定位方法通过生成多个体包标签、帧间隔伪标签,采取对应的弱监督学习方法解决数据集中标注信息较少的问题,标签生成过程如图1所示。

[0067]

步骤201:使用卷积神经网络作为主干搭建特征提取网络,并对视频进行逐帧的特征提取,对于每个视频帧使用roialign以及全连接层得到所有个体的特征向量;

[0068]

本发明实施例采用现阶段应用非常广泛的深度学习的方法完成这一操作。具体地,使用卷积神经网络作为主干对视频进行逐帧的特征提取,使用roialign以及全连接层得到每个个体的特征。

[0069]

步骤202:计算原始数据集中的个体集xm的多个体包标签与动作预测结果

[0070]

将m个具有标签的个体xm={x1,x2,

…

,xm}组成的整体标记为多个体包多个体包的标签可由下式得出:

[0071][0072]

其中,ym表示个体xm的动作标签,表示对应元素逐个做或运算。

[0073]

对于具有m个个体的包计算多个体包级的动作预测结果k表示动作类别数量,预测结果可由下式得出:

[0074][0075]

其中,φ表示聚合函数;pm∈r1×k表示个体xm的动作预测结果,该结果通过带有roialign的inception-v3网络得到。

[0076]

计算最大损失可由下式得出:

[0077][0078]

其中,k为动作类别的数量,在计算时,聚合函数φ采用max-pooling(最大值池化)函数。

[0079]

计算最小损失可由下式得出:

[0080][0081]

其中,在计算时,聚合函数φ采用min-pooling(最小值池化)函数。

[0082]

计算中间损失可由下式得出:

[0083][0084]

其中,表示预测值不在最大损失、最小损失中的个体集合。u函数定义为:

[0085][0086][0087]

最终,改进的多个体损失函数(如图2所示)表示为:

[0088][0089]

其中,参数α、β用于平衡不同的情况,总损失函数在各个包上求和得到。

[0090]

在多个体损失的基础上,考虑到在将较大的包分解成较小的包时带来的动作标签丢失的问题,以及使用max-pooling、min-pooling聚合函数进行选择个体时难以避免的错误选择问题,实际的情况中会出现较大的噪声干扰。因此,对于矩阵p引入不确定量计算多个体包损失

[0091][0092]

步骤203:首先对于帧t寻找与其在一定范围内的临近帧,考察临近帧内的对应锚定个体动作预测值,以阈值ξ

t

为标准进行筛选,对合格的个体生成伪标签,然后考察无标签

个体x,计算其最大预测值与最可能的标签值之间的交叉熵损失c,以阈值ξa,ξc为标准进行筛选,将合格的个体新增为锚定个体。

[0093]

a)帧间隔伪标签(fpl)生成第一阶段:

[0094]

给定一个有标注的帧t,在帧t上随机选定q个有动作标签个体作为锚定个体。其中,对于一个锚定个体q

t

,假定其标签为动作k。对于相邻帧t-1,如果同一个体q

t-1

的预测动作类别同样为k,且相应的预测分数大于阈值ξ

t

,则对于未标注个体q

t-1

生成动作类别为k的伪标签,并将其加入训练集。类似地,用同样的方法在[t-r,t+r]的区间内逐帧的将单帧的标注扩展为多帧的标注。

[0095]

b)帧间隔伪标签生成第二阶段:

[0096]

对于某一无标签个体xn,假定在其所有动作类别的预测分当中类别k的预测分最高。计算预测可信度c,c为预测值与最可能的标签值之间的交叉熵损失。当且仅当预测值与可信度c满足以下关系时,增加个体xn作为锚定个体:

[0097][0098]

其中,ξa,ξc为阈值参数。

[0099]

经过阶段一、阶段二,生成若干伪标签并将其加入训练数据集。计算伪标签损失函数

[0100][0101]

其中,分别表示真实标签-个体对,伪标签-个体对,为完成伪标签生成过程后的标签值。

[0102]

步骤204:综合考虑步骤202、203中的损失函数,以作为总损失函数,利用原始训练集以及加入步骤203中生成的伪标签后的新数据集进行参数更新,在完成指定轮训练后停止;

[0103]

总损失函数由多个体包损失与伪标签损失函数给出:

[0104][0105]

使用原始训练集对动作识别网络进行30轮训练,进入帧间隔伪标签生成第一阶段,在未标注的视频帧上生成为标签。使用加入伪标签的新的训练样本池对动作识别网络进行训练,进入帧间隔伪标签生成第二阶段,增加锚定个体。使用新的训练样本池对动作识别网络进行训练。

[0106]

步骤205:将待识别视频分解为若干帧,将其逐帧输入步骤204中训练完成的网络中进行动作识别,网络将输出视频帧中所有个体的动作类别。

[0107]

将待预测视频逐帧分开,对每一帧使用动作识别网络进行识别,预测其中所有个体的动作类别。通过对视频逐帧地进行上述操作即可得到视频的时空动作定位结果。

[0108]

综上所述,本发明实施例通过上述步骤201-205实现了通过两种弱监督标注方式及弱监督学习实现弱监督时空动作定位;一方面,将单个或多个视频帧中的多个个体打包进行整体标注,得到多个体包的弱监督标签;另一方面,分两个阶段依据动作预测值筛选并生成锚定个体及帧间隔伪标签;由于标签弱监督的特点,本方法简化了数据标注过程,降低

了手工标注的工作量,有效地解决了需要大量繁琐手工标注的问题。

[0109]

实施例3

[0110]

一种基于弱监督学习的多对象场景时空动作定位装置,参见图2,该装置包括:处理器和存储器,存储器中存储有程序指令,处理器调用存储器中存储的程序指令以使装置执行以下的方法步骤:

[0111]

使用卷积神经网络作为特征提取网络,对视频进行逐帧的特征提取,对每个视频帧进行目标对象特征提取通过全连接层输出所有个体的特征向量;

[0112]

计算原始数据集中的个体集xm的多个体包标签并通过个体的特征向量计算出动作预测结果计算多个体包标签与动作预测结果间的交叉熵损失;

[0113]

对于帧t寻找与其在一定范围内的临近帧,以阈值ξ

t

进行筛选,对合格的个体生成伪标签,考察无标签个体x,计算其最大预测值与最可能的标签值之间的交叉熵损失c,以阈值ξa,ξc为标准进行筛选,将合格的个体新增为锚定个体;

[0114]

综合考虑交叉熵损失函数,以作为总损失函数,利用原始训练集以及伪标签后的新数据集进行参数更新,在完成指定轮训练后停止;

[0115]

将待识别视频分解为若干帧,将其逐帧输入训练完成的网络中进行动作识别,输出视频帧中所有个体的动作类别。

[0116]

其中,计算原始数据集中的个体集xm的多个体包标签并通过个体的特征向量计算出动作预测结果具体为:

[0117]

将m个具有标签的个体xm={x1,x2,

…

,xm}组成的整体标记为多个体包多个体包的标签由下式得出:

[0118][0119]

其中,ym表示个体xm的动作标签,表示对应元素逐个做或运算;

[0120]

对于具有m个个体的包计算多个体包级的动作预测结果k表示动作类别数量,预测结果可由下式得出:

[0121][0122]

其中,φ表示聚合函数;pm∈r1×k表示个体xm的动作预测结果,通过带有roialign的inception-v3网络得到。

[0123]

其中,该方法还包括:对动作预测结果进行训练,具体为:

[0124]

计算最小损失

[0125][0126]

其中,在计算时聚合函数φ采用min-pooling函数;

[0127]

计算中间损失

[0128]

[0129]

其中,表示预测值不在最大损失、最小损失中的个体集合,u函数定义为:

[0130][0131]

其中,c1,c2∈[0,1],d》0为预先设定好的参数;

[0132]

最终,改进的多个体损失函数表示为:

[0133][0134]

其中,参数α、β用于平衡不同的情况,总损失函数在各个包上求和得到;

[0135]

对于矩阵p引入不确定量计算多个体包损失

[0136][0137]

其中,以阈值ξ

t

进行筛选为:

[0138]

对于一锚定个体q

t

,假定其标签为动作k,对于相邻帧t-1,若同一个体q

t-1

的预测动作类别同样为k,且相应的预测分数大于阈值ξ

t

,则对于未标注个体q

t-1

生成动作类别为k的伪标签,并将其加入训练集,用同样的方法在[t-r,t+r]的区间内逐帧的将单帧的标注扩展为多帧的标注。

[0139]

其中,以阈值ξa,ξc为标准进行筛选阈值为:

[0140]

对于某一无标签个体xn,在其所有动作类别的预测分当中类别k的预测分最高,计算预测可信度c,c为预测值与最可能的标签值之间的交叉熵损失;当且仅当预测值与可信度c满足以下关系时,增加个体xn作为锚定个体:

[0141][0142]

其中,ξa,ξc为阈值参数。

[0143]

这里需要指出的是,以上实施例中的装置描述是与实施例中的方法描述相对应的,本发明实施例在此不做赘述。

[0144]

上述的处理器和存储器的执行主体可以是计算机、单片机、微控制器等具有计算功能的器件,具体实现时,本发明实施例对执行主体不做限制,根据实际应用中的需要进行选择。

[0145]

存储器和处理器之间通过总线传输数据信号,本发明实施例对此不做赘述。

[0146]

本发明实施例对各器件的型号除做特殊说明的以外,其他器件的型号不做限制,只要能完成上述功能的器件均可。

[0147]

本领域技术人员可以理解附图只是一个优选实施例的示意图,上述本发明实施例序号仅仅为了描述,不代表实施例的优劣。

[0148]

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1