一种基于多视角特征群智融合的特定行人目标匹配方法

1.本发明涉及群体智能领域,尤其涉及一种基于多视角特征群智融合的特定行人目标匹配方法。

背景技术:

2.近年来,随着视频监控的飞速发展,群体智能视频监控也将是未来视频监控的发展趋势,而行人目标匹配技术是智能安防的重要应用之一。由于监控场景中存在树木、建筑物及周围其他行人遮挡问题,不可避免的使得目标行人匹配出现漏匹配和误匹配的情况。

技术实现要素:

3.本发明的目的在于:一种基于多视角特征群智融合的特定行人目标匹配方法。克服因环境因素造成的遮挡问题出现的待匹配行人和目标被监测行人漏匹配和误匹配的情况。

4.为实现上述目的,本发明提供如下技术方案:一种基于多视角特征群智融合的特定行人目标匹配方法,基于目标区域内的行人、以及覆盖于目标区域内各个位置的多角度摄像头,根据目标区域内预设各个目标被监视行人分别对应的各角度图像,分别针对目标区域内各个待匹配行人,执行以下步骤a至步骤f,完成待匹配人的初级匹配,然后执行步骤g,实现待匹配行人相对目标被监视行人的匹配;

5.步骤a:分别针对目标区域内各个目标被监视行人,提取目标被监视行人所对应的各角度图像的sift特征和空间颜色直方图特征信息,并进行融合,获得该目标被监视行人的多视角融合特征,即获得各个目标被监视行人分别对应的多视角融合特征,并构建目标被监视行人特征集t;随后执行步骤b;

6.步骤b:针对待匹配行人的各角度图像,分别针对各角度图像提取视角sift特征和空间颜色直方图特征信息,之后对视角sift特征和空间颜色直方图特征信息融合,获得待匹配行人的各角度图像分别对应的视角融合特征;随后执行步骤c;

7.步骤c:针对待匹配行人的各角度图像,统计待匹配行人的各角度图像的像素数量,并计算该各角度图像的图像权值,获得其中权值最大的角度图像,之后进一步获得采集该角度图像对应的摄像头;并确定该摄像头为目标区域内主摄像头;随后执行步骤d;

8.步骤d:基于待匹配行人所对应各个多角度图像的图像权值、以及各个多角度图像的多视角融合特征,执行加权处理,获得待匹配行人对应主摄像头下的加权多视角融合特征;随后执行步骤e;

9.步骤e:基于被监视行人特征集t、以及待匹配行人对应主摄像头下的加权多视角融合特征,计算被监视行人特征集t与该加权多视角融合特征之间的相似度;进一步获得待匹配行人各角度图像与被监视行人特征集t 的不匹配概率;随后执行步骤f;

10.步骤f:判断步骤e所获不匹配概率qm是否大于等于匹配成功阈值 q

th

,是则初次匹配结果不成功,并返回执行步骤b;否则初次匹配结果成功,待匹配人构成初级待匹配行人;

11.步骤g:计算各个初级待匹配行人分别与各个目标被监视行人之间的相似度,并结合预设初级待匹配行人与目标被监视行人相似度阈值β

th

,获得初级待匹配行人与目标被监视行人的匹配结果。

12.进一步地,前述的一种基于多视角特征群智融合的特定行人目标匹配方法,覆盖于目标区域内各个位置的多角度摄像头针对每个行人选取k个视角进行拍摄,获得各个行人的各角度图像。

13.进一步地,前述的步骤a包括如下步骤a1至步骤a3:

14.步骤a1:基于各个行人的各角度图像,获得各个目标被监视行人的各角度图像ik,并从各个目标被监视行人各角度图像ik中分别提取各角度图像的sift特征{p

1k

,

…

,p

nk

}、以及各角度图像的空间颜色直方图特征 {z

1k

,

…

,z

nk

},其中,其中,n表示目标被监视行人的个数,i∈[1,n];

[0015]

步骤a2:根据各目标被监视行人角度图像的sift特征为{p

1k

,

…

,p

nk

}、以及各角度图像的空间颜色直方图特征{z

1k

,

…

,z

nk

},获得各被监视行人的多视角融合特征ri:

[0016]

其中,b表示sift特征的维数,

[0017]

步骤a3:根据各目标被监视行人的多视角融合特征,构成目标被监视行人特征集t,t={r1,

…

,rn},并将其录入到服务器中,其中,n表示目标被监视行人的个数。

[0018]

进一步地,前述的步骤b包括如下步骤b1至步骤b3:

[0019]

步骤b1:提取摄像头y视角的待匹配行人tm各个角度图像的sift特征其中表示维度s上的特征取值,b表示sift特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角;

[0020]

步骤b2:提取待匹配行人tm各个角度图像的空间颜色直方图特征信息其中,表示绝对亮度取值为j的像素数量;

[0021]

步骤b3:分别对待匹配行人tm的各角度图像的多视角sift特征p

my

和空间颜色直方图特征z

my

进行融合,获得待匹配行人tm的各角度图像分别对应的视角融合特征:

[0022]

其中, b表示sift特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角。

[0023]

进一步地,前述的步骤c中,包括如下步骤c1至c2;

[0024]

步骤c1:针对各个待匹配行人tm的各角度图像,统计每张待匹配行人tm的各角度图像的像素数量ny,1≤y≤y,y表示该目标域布置的摄像头个数;

[0025]

步骤c2:按如下公式:

[0026][0027]

计算每张待匹配行人tm的角度图像的权值αy;并且获得最大权值α

max

∈{α1,

…

,αy}的待匹配行人tm的角度图像,进一步获得采集到该权值最大的待匹配行人角度图像对应的摄像头y

max

∈[1,y],确定该摄像头为主摄像头。

[0028]

进一步地,前述的步骤d具体为:基于每张待匹配行人tm的角度图像权值、以及待匹配行人tm多视角融合特征进行融合,按如下公式:

[0029][0030]

获得主摄像头下的待匹配行人的加权多视角融合特征其中b表示sift 特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角。

[0031]

进一步地,前述的步骤e包括如下步骤e1至步骤e2;

[0032]

步骤e1:基于待匹配行人tm对应主摄像头下的加权多视角融合特征以及被监视行人特征集t的各目标被监视行人的多视角融合特征ri=(r

i1

,

…

,r

ib+256

),i=1,

…

,n,按如下公式:

[0033][0034]

计算被监视行人特征集t与该加权多视角融合特征之间的相似度,b表示 sift特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角n表示目标被监视行人的个数,e表示特征维度;

[0035]

步骤e2:根据待匹配行人tm的加权多视角融合特征与被监视行人特征集t相似度,按如下公式:

[0036][0037]

计算待匹配行人tm各角度图像与目标被监视行人t的不匹配概率qm。

[0038]

进一步地,前述的步骤g还包括以下步骤g1-1至步骤g1-2;

[0039]

步骤g1-1:计算各个初级待匹配行人加权多视角融合特征与各个目标被监视人的多视角融合特征的匹配相似度,获得各个初级待匹配行人在主摄像头下的加权多视角融合特征与目标被监视行人多视角融合特征相似度的最大相似度以及该最大相似

度对应的目标被监视行人;

[0040]

步骤g1-2:按如下公式:

[0041][0042]

判断各个初级待匹配行人在主摄像头下的加权多视角融合特征与被该目标监视行人td(1≤d≤n)多视角融合特征的最大相似度是否大于等于待匹配行人为目标被监视行人的相似度阈值β

th

,是则获得待匹配行人和被监视行人的匹配结果为待匹配行人为目标被监视行人;否则匹配结果为不成功。

[0043]

进一步地,前述的步骤g还包括以下步骤g2-1至步骤g2-3;

[0044]

步骤g2-1:分别计算各个初级待匹配行人在主摄像头下的加权多视角融合特征与各个目标被监视人的多视角融合特征的匹配相似度;

[0045]

步骤g2-2:基于步骤g2-1获得的匹配相似度,进一步获得各个目标被监视人的多视角融合特征与各个初级待匹配行人在主摄像头下的加权多视角融合特征的匹配相似度由大到小排序、以及被监视行人多视角融合特征与各个初级待匹配行人的最大相似度以及该最大相似度对应的目标被监视行人与初级待匹配行人;

[0046]

步骤g2-3:针对各个待匹配行人和其对应的最大相似度的目标监视行人,在目标被监视行人中剔除最大相似度的目标被监视行人、以及各个待匹配行人在主摄像头下的加权多视角融合特征与各个目标被监视人的多视角融合特征的匹配相似度,并判断初级待匹配行人与目标被监视行人是否完全剔除,是则以该最大相似度对应的目标被监视行人与初级待匹配行人完成待匹配行人相对目标被监视行人的匹配,否则返回步骤g2-1。

[0047]

利用监视区域布置的多个角度的摄像头的优势,主摄像头和辅助摄像头联动,智能的提取加权多视角融合特征,减少障碍物对特定目标行人匹配的影响,降低了漏匹配的概率;根据加权多视角融合特征与被监视目标行人特征集的多视角融合特征计算匹配相似度,进而计算不匹配概率,通过设置不匹配概率和相似度的阈值条件分层判断待匹配行人是否是监控行人目标,降低了误匹配概率,通过待匹配人与目标被监视行人匹配相似度的计算,之后找大最大相似度并剔除目标被监视行人可以精准的将待匹配人和目标被监视行人匹配成功。

附图说明

[0048]

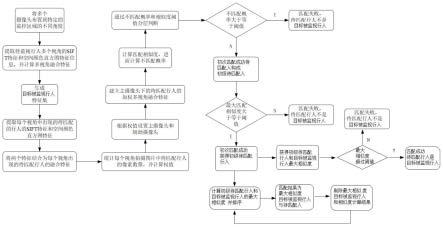

图1为本发明提供的一种基于多视角特征群智融合的特定行人目标匹配方法的流程图;

[0049]

图2为本发明提供一种基于多视角特征群智融合的特定行人目标匹配方法的场景部署示意图。

具体实施方式

[0050]

为了更了解本发明的技术内容,特举具体实施例并配合所附图式说明如下。

[0051]

在本发明中参照附图来描述本发明的各方面,附图中示出了许多说明性实施例。本发明的实施例不局限于附图所述。应当理解,本发明通过上面介绍的多种构思和实施例,以及下面详细描述的构思和实施方式中的任意一种来实现,这是因为本发明所公开的构思和实施例并不限于任何实施方式。另外,本发明公开的一些方面可以单独使用,或者与本发明公开的其他方面的任何适当组合来使用。

[0052]

如图2所示,基于目标区域内的行人、以及覆盖于目标区域内各个位置的多角度摄像头,多角度摄像头针对每个行人选取k个视角进行拍摄,获得各个行人的各角度图像根据目标区域内预设各个目标被监视行人分别对应的各角度图像,各个摄像头由太阳能板供电,并且各个摄像头通过5g 网络将图像上传到云服务及进行计算。分别针对目标区域内各个待匹配行人,执行以下步骤a至步骤f,完成待匹配人的初级匹配,然后执行步骤g, 实现待匹配行人相对目标被监视行人的匹配;,

[0053]

步骤a:分别针对目标区域内各个目标被监视行人,基于各个行人的各角度图像,获得各个目标被监视行人的各角度图像ik,从各个目标被监视行人各角度图像ik中分别提取各角度图像的sift特征{p

1k

,

…

,p

nk

}、以及各角度图像的空间颜色直方图特征{z

1k

,

…

,z

nk

},其中,},其中,其中,n表示目标被监视行人的个数,i∈[1,n];

[0054]

之后根据各目标被监视行人角度图像的sift特征为{p

1k

,

…

,p

nk

}、以及各角度图像的空间颜色直方图特征{z

1k

,

…

,z

nk

},进行融合获得各被监视行人的多视角融合特征ri:

[0055][0056]

其中,b表示sift特征的维数。根据各目标被监视行人的多视角融合特征,构成目标被监视行人特征集t,t={r1,

…

,rn},并将其录入到服务器中,其中,n表示目标被监视行人的个数,之后执行步骤b。

[0057]

步骤b:针对待匹配行人的各角度图像,提取摄像头y视角的待匹配行人tm各个角度图像的sift特征其中其中表示维度s上的特征取值,b表示sift特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角;之后提取待匹配行人tm各个角度图像的空间颜色直方图特征信息其中,表示绝对亮度取值为j的像素数量;分别针对各角度图像提取视角sift特征和空间颜色直方图特征信息,分别对待匹配行人 tm的各角度图像的多视角sift特征p

my

和空间颜色直方图特征z

my

进行融合,获得待匹配行人tm的各角度图像分别对应的视角融合特征:其中,b 表示sift特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角。随后

执行步骤c;

[0058]

步骤c:针对各个待匹配行人tm的各角度图像,统计每张待匹配行人tm的各角度图像的像素数量ny,1≤y≤y,y表示该目标域布置的摄像头个数;按如下公式:

[0059][0060]

计算每张待匹配行人tm的角度图像的权值αy;并且获得最大权值α

max

∈{α1,

…

,αy}的待匹配行人tm的角度图像,进一步获得采集到该权值最大的待匹配行人角度图像对应的摄像头y

max

∈[1,y],确定该摄像头针对待匹配行人的各角度图像,统计待匹配行人的各角度图像的像素数量,并计算该各角度图像的图像权值,获得其中权值最大的角度图像,之后进一步获得采集该角度图像对应的摄像头;并确定该摄像头为目标区域内主摄像头;随后执行步骤d;

[0061]

步骤d:基于每张待匹配行人tm的角度图像权值、以及待匹配行人tm多视角融合特征进行融合,按如下公式:

[0062][0063]

获得主摄像头下的待匹配行人的加权多视角融合特征其中b表示sift 特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角。随后执行步骤e;

[0064]

步骤e:基于待匹配行人tm对应主摄像头下的加权多视角融合特征以及被监视行人特征集t的各目标被监视行人的多视角融合特征ri=(r

i1

,

…

,r

ib+256

),i=1,

…

,n,按如下公式:

[0065][0066]

计算被监视行人特征集t与该加权多视角融合特征之间的相似度,b表示 sift特征的维数,y表示该监视区域布置的摄像头个数,且一个摄像头代表一个视角n表示目标被监视行人的个数,e表示特征维度;根据待匹配行人tm的加权多视角融合特征与被监视行人特征集t相似度,按如下公式:

[0067][0068]

计算待匹配行人tm各角度图像与目标被监视行人t的不匹配概率qm。随后执行步骤

f;

[0069]

步骤f:判断步骤e所获不匹配概率qm是否大于等于匹配成功阈值q

th

,是则初次匹配结果不成功,并返回执行步骤b;否则初次匹配结果成功,待匹配人构成初级待匹配行人;随后进入步骤g.

[0070]

步骤g:计算各个初级待匹配行人分别与各个目标被监视行人之间的相似度,并结合预设初级待匹配行人与目标被监视行人相似度阈值β

th

,获得初级待匹配行人与目标被监视行人的匹配结果。

[0071]

根据初级待匹配行人与目标被监视行人的匹配结果,本发明提供给两种后续匹配过程;第一种:执行步骤g1-1至步骤g1-2,

[0072]

步骤g1-1:计算各个初级待匹配行人加权多视角融合特征与各个目标被监视人的多视角融合特征的匹配相似度,获得各个初级待匹配行人在主摄像头下的加权多视角融合特征与目标被监视行人多视角融合特征相似度的最大相似度以及该最大相似度对应的目标被监视行人;

[0073]

步骤g1-2:按如下公式:

[0074][0075]

判断各个初级待匹配行人在主摄像头下的加权多视角融合特征与被该目标监视行人td(1≤d≤n)多视角融合特征的最大相似度是否大于等于待匹配行人为目标被监视行人的相似度阈值β

th

,是则获得待匹配行人和被监视行人的匹配结果为待匹配行人为目标被监视行人;否则匹配结果为不成功。

[0076]

第二种:步骤g2-1至步骤g2-3;

[0077]

步骤g2-1:分别计算各个初级待匹配行人在主摄像头下的加权多视角融合特征与各个目标被监视人的多视角融合特征的匹配相似度;

[0078]

步骤g2-2:基于步骤g2-1获得的匹配相似度,进一步获得各个目标被监视人的多视角融合特征与各个初级待匹配行人在主摄像头下的加权多视角融合特征的匹配相似度由大到小排序,例如有10个目标被监视行人,和5个初级待匹配行人,那么对于每个目标被监视行人相对的目标待匹配行人就有25个相似度,那就对这25个相似度进行排序,获得被监视行人多视角融合特征与各个初级待匹配行人的最大相似度以及该最大相似度对应的目标被监视行人与初级待匹配行人;

[0079]

步骤g2-3:针对各个待匹配行人和其对应的最大相似度的目标监视行人,在目标被监视行人中剔除最大相似度的目标被监视行人、以及各个待匹配行人在主摄像头下的加权多视角融合特征与各个目标被监视人的多视角融合特征的匹配相似度,也就是我们找到的被监视目标行人中和初级待匹配行人的最大相似度的那个人。并

判断初级待匹配行人与目标被监视行人是否完全剔除,是则以该最大相似度对应的目标被监视行人与初级待匹配行人完成待匹配行人相对目标被监视行人的匹配,否则返回步骤g2-1,继续执行相似度计算,并再次进行排序,之后再找到下一个

[0080]

利用监视区域布置的多个角度的摄像头的优势,主摄像头和辅助摄像头联动,智能的提取加权多视角融合特征,减少障碍物对特定目标行人匹配的影响,降低了漏匹配的概率;根据加权多视角融合特征与被监视目标行人特征集的多视角融合特征计算匹配相似度,进而计算不匹配概率,通过设置不匹配概率和相似度的阈值条件分层判断待匹配行人是否是监控行人目标,降低了误匹配概率,通过待匹配人与目标被监视行人匹配相似度的计算,之后找大最大相似度并剔除目标被监视行人可以精准的将待匹配人和目标被监视行人匹配成功。

[0081]

虽然本发明已以较佳实施例阐述如上,然其并非用以限定本发明。本发明所属技术领域中具有通常知识者,在不脱离本发明的精神和范围内,当可作各种的更动与润饰。因此,本发明的保护范围当视权利要求书所界定者为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1