一种改进SMOKE的单目视觉3D车辆目标实时检测方法

一种改进smoke的单目视觉3d车辆目标实时检测方法

技术领域

1.本发明属于图像处理技术领域,具体涉及一种改进smoke的单目视觉3d车辆目标实时检测方法。

背景技术:

2.在自动驾驶的技术中,3d目标检测能够提更加丰富的信息,如:目标的类别、位置和姿态。因此,与2d检测相比,3d目标检测的难度更大。目前很多的方法都是使用激光雷达进行3d目标检测,但激光雷达的方案成本高且寿命短,相比于使用昂贵的激光雷达等传感器,相机传感器成本低廉,且寿命长、易于安装,同时图像的检测技术相对更加成熟,有利于研究工作的快速进行。但是单目3d目标检测的难点就在于对深度信息的预测,而这也恰恰是激光雷达的优势所在。在单目的方案中,将实例从3d空间投影到2d图像平面就必然会损失图像的深度信息。因此,对于深度信息的处理一直是单目目标检测的重点研究内容。

技术实现要素:

3.本发明的目的是提供一种改进smoke的单目视觉3d车辆目标实时检测方法,用于解决现有技术中单目目标检测中存在因计算中存在形变和信息损失导致计算精度不足的技术问题。

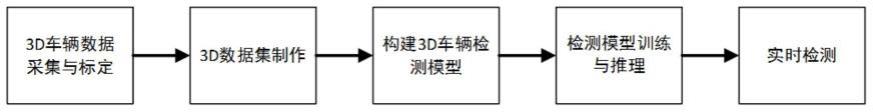

4.所述的一种改进smoke的单目视觉3d车辆目标实时检测方法,包括下列步骤:

5.步骤一、3d车辆数据采集与标定;

6.步骤二、数据集制作;

7.步骤三、构建3d车辆目标检测模型;

8.该步骤中,3d车辆目标检测模型为改进smoke的目标检测模型,包括在dla-34骨干网络后添加dlaup与idaup形成的dla-seg骨干网络,dla-seg骨干网络中使用形变卷积和下采样层组合进行信息提取,并添加注意力机制;

9.步骤四、检测模型训练与推理;

10.步骤五、将步骤四中最优的模型嵌入实时系统中,并进行实时检测。

11.优选的,所述步骤三中,在进行检测框回归时,改进smoke中的损失函数为:其中,l

cls

为关键点分类损失,为改进后的3d边界框回归损失,l

change

为改进后的总损失,回归参数为α和β,z是特征图的深度偏移;xc、yc是表示特征图的关键点x和y坐标方向的偏移量;h、w、l是目标尺寸高宽长对应的残差,α是目标旋转角,β为检测框的航向角,检测框的航向角通过上述损失函数直接回归得到。

12.优选的,所述步骤三中,采集的图像数据与标定数据联合输入模型后,经骨干网络处理后实现关键点分类,并同时进行3d检测框的回归,通过对检测框的导航角和3d坐标进

行回归,结合分类得到的关键点实现对3d检测框的预测。

13.优选的,骨干网络在dlaup和idlaup部分引入注意力机制,在网络结构中添加1个通道注意力模块和1个空间注意力模块,骨干网络中up1模块在可形变卷积后接入1个通道注意力模块和1个空间注意力模块;up2模块在可形变卷积后接入1个通道注意力模块和1个空间注意力模块。

14.优选的,通道注意力模块中,输入特征图是h

×w×

c,先分别进行一个全局平均池化和全局最大池化得到两个1

×1×

c的特征图,然后将这两个特征图分别送入两层的全连接神经网络,对应两个特征图的两层全连接神经网络是共享参数的,再将得到的两个特征图相加,通过激活函数得到归一化的权重系数,然后权重系数再与输入特征图相乘,得到最终输出特征图。

15.优选的,空间注意力模块中,输入特征图为h

×w×

c,分别进行一个通道维度的最大池化和平均池化得到两个h

×w×

1的特征图,然后将这两个特征图在通道维度拼接起来,现在特征图为h

×w×

2,然后再经过一个卷积层,降为1个通道,同时保持h、w不变,输出特征图为h

×w×

1,然后再通过激活函数生成空间权重系数,然后再与输入特征图相乘得到最终特征图。

16.优选的,步骤二中的数据分为标定数据、标签数据和单目相机rgb图像,按照9∶1划分采集到的关联数据为训练集和测试集;步骤四中,利用步骤二中数据集进行训练测试并获取最优的模型。

17.本发明具有以下优点:本方案采用的模型是改进后的基于smoke的目标检测模型,通过对骨干网络改进,一方面通过形变卷积和下采样层组合进行信息提取,能够提升空间分辨率,提升骨干网络学习空间几何形变的能力;另一方面对上采样模块改进,引入通道和空间的注意力机制,既考虑了不同通道的像素信息,又考虑了同一通道不同位置像素的信息,提升网络检测性能,克服了计算中存在形变和信息损失导致计算精度不足的技术问题。

18.本方案还对导航角回归方法进行改进,常规smoke的目标检测模型中并没有直接回归航向角,由于x、z、αz均是回归出来的结果,在进行运算会存在误差累积;而本方案改进后令目标旋转角α和检测框的航向角β成为算式的回归参数,从而能直接回归得到航向角β,避免误差累积,提高航向角的准确性。

附图说明

19.图1为本发明中一种改进smoke的单目视觉3d车辆目标实时检测方法的流程图。

20.图2为本发明中改进smoke的目标检测模型的算法结构图。

21.图3为本发明中引入注意力机制改进后的骨干网络结构图。

22.图4为图3所示骨干网络结构中的骨干网络结构组件图。

23.图5(a)、(b)分别为表示标准卷积和形变卷积的说明图。

24.图6为本发明中通道注意力模块的算法结构图。

25.图7为本发明中空间注意力模块的算法结构图。

具体实施方式

26.下面对照附图,通过对实施例的描述,对本发明具体实施方式作进一步详细的说

明,以帮助本领域的技术人员对本发明的发明构思、技术方案有更完整、准确和伸入的理解。

27.如图1-7所示,本发明提供了一种改进smoke的单目视觉3d车辆目标实时检测方法,包括下列步骤。

28.步骤一、3d车辆数据采集与标定。

29.该步骤中的数据采集内容有:截断程度、遮挡率、观察角度、图像坐标系3d长度、图像坐标系3d宽度、图像坐标系3d高度、相机坐标系3d位置x坐标、相机坐标系3d位置y坐标、相机坐标系3d位置z坐标、y轴旋转角度。

30.而采集数据所用的相关设备包括:惯性导航系统、激光雷达、左右彩色相机、左右灰度相机进行数据采集与标定。

31.所述步骤一中的标定内容有:左右彩色相机内参矩阵(大小为3x4),左右灰度相机内参矩阵(大小为3x4),左灰度相机的修正矩阵(大小为3x4),激光雷达数据到相机图像的变换矩阵(大小为3x4),惯导位置信息到相机图像的变换矩阵(大小为3x4)。

32.步骤二、数据集制作。

33.参考kitti数据格式(分为标定数据、标签数据和单目相机rgb图像),按照9∶1划分采集到的关联数据为训练集和测试集。

34.步骤三、构建3d车辆目标检测模型。3d车辆目标检测模型为改进smoke的目标检测模型,该模型包括有dla-34骨干网络,采集的图像数据与标定数据联合输入模型后,经骨干网络处理后实现关键点分类,并同时进行3d检测框的回归,通过对检测框的导航角和3d坐标进行回归,结合分类得到的关键点实现对3d检测框的预测,如图2所示。

35.目标检测模型的结构如图3-4所示,在现有smoke模型的基础上作了下列改进。

36.(1)上述dla-34骨干网络采用特征融合部分改进后的dla-seg,dlaseg是在dla的基础上使用形变卷积(deformable convolution)和下采样(upsample)层组合进行信息提取,能够提升空间分辨率,该模型中,在dla-34骨干网络后添加dlaup与idaup。dlaup主要是模块间的特征融合,类似于resnet的残差连接;idaup主要是不同层级间的特征融合,类似于densenet的connection连接。形变卷积是相对于标准卷积的概念而来,在标准卷积操作中卷积核作用区域始终为中心点周围标准卷积核大小的矩形区域内如图5(a)所示;而形变卷积则可以是不规则的区域如图5(b)所示。由于3d图像中车辆可能呈现出不同的大小、姿态、视角变化甚至非刚体形变,如何适应这些复杂的几何形变是3d检测得的难点,形变卷积能够提升骨干网络学习空间几何形变的能力,因次对于3d检测中的航向角、俯仰角等检测具有一定的提升作用。

37.(2)上述模型中还添加注意力机制。核心是在计算能力有限的情况下,将计算资源分配给更重要的任务,同时解决信息超载问题的一种资源分配方案。在神经网络学习中,一般而言模型的参数越多则模型的表达能力越强,模型所存储的信息量也越大,但这会带来信息过载的问题。那么通过引入注意力机制,在众多的输入信息中聚焦于对当前任务更为关键的信息,降低对其他信息的关注度,甚至过滤掉无关信息,就可以解决信息过载问题,并提高任务处理的效率和准确性。

38.骨干网络在dlaup和idlaup部分引入注意力机制,在网络结构中添加1个通道注意力模块和1个空间注意力模块,如图3所示。up1模块在可形变卷积后接入1个通道注意力模

块和1个空间注意力模块,形成up1-attention。将通道信息和空间信息结合起来,既考虑了不同通道的像素信息,又考虑了同一通道不同位置像素的信息。up2后的可形变卷积后接入1个通道注意力模块和1个空间注意力模块,形成up2-attention。

39.通道注意力模块结构如图6所示,通道注意力是关注哪个通道上的特征是有意义的,输入特征图是h

×w×

c,先分别进行一个全局平均池化和全局最大池化得到两个1

×1×

c的特征图,然后将这两个特征图分别送入两层的全连接神经网络,对应两个特征图的两层全连接神经网络是共享参数的,再将得到的两个特征图相加,通过激活函数得到归一化的权重系数,然后权重系数再与输入特征图相乘,得到最终输出特征图。

40.空间注意力模块结构如图7所示,输入特征图为h

×w×

c,分别进行一个通道维度的最大池化和平均池化得到两个h

×w×

1的特征图,然后将这两个特征图在通道维度拼接起来,现在特征图为h

×w×

2,然后再经过一个卷积层,降为1个通道,同时保持h、w不变,输出特征图为h

×w×

1,然后再通过激活函数生成空间权重系数,然后再与输入特征图相乘得到最终特征图。

41.(3)在进行检测框回归时,由于在现有smoke模型中的并没有直接回归航向角,而是利用公式进行计算:

[0042][0043]

其中,x、z是车体在相机坐标系xc和zc轴方向的预测值,αz是网络预测的观测角,由于x、z、αz均是回归出来的结果,在进行运算会存在误差累积,因此本发明中直接回归航向角。

[0044]

上述改进还涉及比较损失函数loss的改进。原smoke模型中损失函数loss影响关键点检测分类和3d边界框回归,总的损失函数是分类和回归两个损失函数相加,定义如下:

[0045][0046]

其中,l

cls

为关键点分类损失,为3d边界框回归损失,l为总的损失。

[0047]

在关键点分类中,图像中的每一个目标用一个关键点进行表示,这里的关键点被定义为目标3d框的中心点在图像平面上的投影点。(有关投影坐标变换的原理不是本发明的重点)

[0048][0049]

其中β和γ为可调超参数,n为一幅图中的关键点数量。为位置是(i,j)关键点的预测置的信度,为位置是(i,j)关键点的实际值的高斯核值。h、w是目标尺寸高、宽对应的残差。

[0050]

其中,包括8个参数,用向量表示为:

[0051][0052]

其中,z是特征图的深度偏移;xc、yc是表示特征图的关键点x和y坐标方向的偏移

量;

[0053]

h、w、l是目标尺寸高宽长对应的残差。α是目标旋转角,sinα、cosα是目标旋转角的向量化表示。对于上述计算航向角用到的观测角αz,有:

[0054][0055][0056]

由此可得航向角为:

[0057]

由于sinα和cosα同时回归,会造成累计误差,因此本方案中改成直接回归β。

[0058]

改进后的smoke中损失函数loss为:

[0059]

其中,l

cls

为关键点分类损失,为改进后的3d边界框回归损失,l

change

为改进后的总损失,回归参数由sinα、cosα变为α和β。

[0060]

步骤四、检测模型训练与推理。构建3d车辆目标检测模型后,利用步骤二中数据集进行训练测试并获取最优的模型。

[0061]

步骤五、将步骤四中最优的模型嵌入实时系统中,并进行实时检测。

[0062]

上面结合附图对本发明进行了示例性描述,显然本发明具体实现并不受上述方式的限制,只要采用了本发明的发明构思和技术方案进行的各种非实质性的改进,或未经改进将本发明构思和技术方案直接应用于其它场合的,均在本发明保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1