基于XR技术的沉浸式互动直播构建方法、系统及介质

基于xr技术的沉浸式互动直播构建方法、系统及介质

技术领域

1.本发明涉及xr技术领域,尤其涉及一种基于xr技术的沉浸式互动直播构建方法、系统及介质。

背景技术:

2.虚拟现实(vr)、增强现实(ar)、混合现实(mr)等技术在解决职业教育实训中的看不见、摸不着、进不去等难题有重大价值。vr、ar、mr等(简称xr,扩展现实)技术相通相融。在5g网络、wifi6等高性能无线网络技术赋能下,xr移动终端(5g手机、头显等)所需的存储、计算、渲染等服务都可以放到云端。由此,基于云存储、云计算、云渲染等云服务,单个xr终端所能拥有的计算、存储、渲染能力可以无上限。

3.目前,在实现职业教育实训的直播教学活动功能时,由于不同用户的瞳距不同,要适配所有不同瞳距的用户,并生成正确的直播画面与互动功能,需要使用巨大的计算资源,增加了实现难度。

技术实现要素:

4.本发明的主要目的在于提供一种基于xr技术的沉浸式互动直播构建方法、系统及存储介质,可以使用较少的计算资源,就能适配所有不同瞳距的用户,实现正确的直播画面与互动功能。

5.为实现上述目的,本发明提出一种基于xr技术的沉浸式互动直播构建方法,所述方法包括以下步骤:

6.步骤s10:设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系;

7.步骤s20:根据直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,计算基准观众在直播虚拟场景中的瞳距与观看位姿;

8.步骤s30:基于所述基准观众在直播虚拟场景中的瞳距与观看位姿,渲染生成直播虚拟场景的直播三维成像区间的立体视觉直播画面,并把立体视觉直播画面发送给各观众;

9.步骤s40:任意观众接收立体视觉直播画面,和/或立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成为边看虚拟场景直播边进行其它内容体验的立体视觉画面,显示给观众看。

10.其中,步骤s30生成的立体视觉直播画面带有深度信息,在所述步骤s40中,对于任意观众hk,hk接收的立体视觉直播画面与其体验空间其它体验内容的立体视觉画面合成为hk边看虚拟场景直播边进行其它内容体验的立体视觉画面,在立体视觉直播画面与hk对其它内容体验生成的立体视觉画面合成时,需要根据各画面在hk视场的深度信息进行遮挡计算。

11.其中,在所述步骤s10设定的直播虚拟场景坐标系与基准观众视场坐标系的旋转

缩放平移关系中,直播虚拟场景sm的坐标系到基准观众视场坐标系的缩放系数为λm,所述步骤s20计算出基准观众在直播虚拟场景sm中的瞳距为其中为基准观众的实际瞳距,根据直播虚拟场景sm坐标系与基准观众视场坐标系的旋转缩放平移关系,计算基准观众在直播虚拟场景中的位姿,所述步骤s30根据基准观众在直播虚拟场景sm的位姿与瞳距,生成立体视觉直播画面,其中为立体视觉画面的左眼图像,为立体视觉画面的右眼图像,为对应的深度图像,根据缩放系数λm,计算得到与在基准观众视场下的深度信息为深度图像和所述步骤s40立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成具体实现为:任意观看场景sm直播的观众hk,接收到场景sm的立体视觉直播画面,hk沉浸式体验空间内其它体验内容生成立体视觉体验画面左眼图像为右眼图像为与在hk视场的深度信息为深度图与hk与基准观众瞳距比值为场景sm的立体视觉直播画面与在基准观众视场下的深度图像与转换成hk视场的深度图像立体视觉直播画面与其它体验内容生成的立体视觉体验画面根据深度图像进行遮挡计算,生成合成画面。

12.其中,所述步骤s10,设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系具体包括:给直播虚拟场景sm选定三维包围盒ω

′m,设定包围盒ω

′m在场景sm中的位姿,包围盒ω

′m在场景sm框选出一个三维区间ωm,ωm就是场景sm的直播三维成像区间,设定包围盒ω

′m在基准观众视场的位姿与缩放关系,计算出所述虚拟场景sm的直播三维成像区间ωm在基准观众视场中对应的三维显示区间设定了包围盒ω

′m在直播虚拟场景sm中的位姿以及ω

′m在基准观众视场的位姿与缩放关系,也就是设定了直播虚拟场景sm坐标系与基准观众视场坐标系的旋转缩放平移关系。

13.其中,在所述步骤s40中,对于任意观众hk,直播虚拟场景sm在hk体验空间的三维显示区间为生成hk体验空间其它体验内容的立体视觉画面时,hk体验空间其它体验内容在三维显示区间的内容不成像。

14.其中,所述步骤s40计算出直播虚拟场景三维成像区间在任意观众体验空间的三维显示区间的具体实现为:直播虚拟场景sm在基准观众视场中的三维显示区间为ω

user

,由任意观众hk瞳距与基准观众瞳距的比值计算出sm三维成像区间ωm在hk视场中的三维显示区间为

15.其中,所述步骤s40后还有步骤s50:任意观众hk在其体验空间里与直播的虚拟场景sm进行互动,生成其体验空间里的互动操作命令ak,ak转换成直播虚拟场景sm里的互动操作命令a

′k,把a

′k发送给场景sm,场景sm对a

′k进行响应。

16.其中,所述步骤s50具体包括:

17.步骤s501:任意观众hk在自己体验空间进行互动操作,生成观众hk体验空间下的互动操作命令ak,命令ak包含的位姿参数是观众hk体验空间坐标系下位姿,判断ak是否为对直播虚拟场景sm的互动,如果是对直播虚拟场景sm的互动,就进入步骤s502,否则hk体验空间里其它内容响应互动操作命令ak,不进入步骤s502;

18.步骤s502:根据观众hk体验空间坐标系与hk视场坐标系的旋转平移关系,互动操作命令ak的位姿参数转换成hk视场坐标系下位姿参数;

19.步骤s503:根据观众hk瞳距dk与基准观众瞳距的比值,互动操作命令ak的位姿参数从hk视场坐标系下位姿参数转换成基准观众视场坐标系下位姿参数;

20.步骤s504:根据基准观众视场坐标系与直播虚拟场景sm坐标系旋转缩放平移关系,互动操作命令ak的位姿参数从基准观众视场坐标系转换到直播虚拟场景sm坐标系下位姿参数,生成互动操作命令a

′k;

21.步骤s505:互动操作命令a

′k,发送给虚拟直播场景sm,sm对a

′k响应。

22.本发明还提出一种基于xr技术的沉浸式互动直播构建系统,所述系统包括:沉浸式互动直播管理服务器、多台xr应用服务器、存储服务器,其中,用户的xr终端通过无线网络访问所述管理服务器与所有xr应用服务器,所述管理服务器部署有沉浸式互动直播管理控制中心,所述存储服务器部署有xr资源库:

23.所述xr资源库,用于存储xr应用资源;

24.所述沉浸式互动直播管理控制中心,用于接收xr终端的虚拟场景体验申请,指令xr应用服务器分配虚拟场景实例,协助xr终端与虚拟场景实例建立通信连接;接收用户直播分享的申请,指令xr应用服务器分配用于直播的虚拟场景实例;设定直播虚拟场景的直播三维成像区间;设定直播虚拟场景坐标系到基准观众视场坐标系的旋转缩放平移关系;计算基准观众在直播虚拟场景中的位姿与瞳距并发送给直播虚拟场景;

25.所述xr应用服务器,用于接收所述沉浸式互动直播管理控制中心发送的分配虚拟场景实例指令,根据所述场景实例分配指令里虚拟场景的场景id,分配相应的虚拟场景实例,当现有场景实例没有足够的计算资源时,调用对应的xr应用程序及相关的资源包,生成虚拟场景实例,并令新生成的场景实例与原有场景实例建立通信连接,同步场景状态。

26.所述xr应用服务器,还用于接收所述沉浸式互动直播管理控制中心发送的销毁场景实例指令,根据该指令销毁虚拟场景实例;

27.所述xr终端,用于向所述沉浸式互动直播管理控制中心发送虚拟场景体验申请,与分配给此xr终端用户的虚拟场景实例建立通信连接;采集xr终端的位姿参数以及互动操作信息发送给分配给此xr终端用户的虚拟场景实例;接收虚拟场景实例发送的沉浸式体验画面;向沉浸式互动直播管理控制中心申请观看直播,与直播场景建立通信连接,接收直播场景发送过来的直播画面;判断用户互动操作是否为对直播场景互动,当对直播场景互动时,把互动操作命令的位姿参数转换到直播场景坐标系,并把转换后的互动操作命令发送到直播场景;接收直播虚拟场景发送的直播立体视觉画面;合成直播立体视觉画面与体验空间其他内容的立体视觉体验画面,生成完整的边看虚拟场景直播边进行其它内容体验的互动体验画面,显示给用户看。

28.本发明还提出一种计算机可读存储介质,所述计算机可读存储介质上存储有计算

机程序,所述计算机程序被处理器调用时执行如上所述的基于xr技术的沉浸式互动直播构建方法的步骤。

29.本发明提出的一种基于xr技术的沉浸式互动直播构建方法、系统及存储介质,通过设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系;根据直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,计算基准观众在直播虚拟场景中的瞳距与观看位姿;基于所述基准观众在直播虚拟场景中的瞳距与观看位姿,渲染生成直播虚拟场景的直播三维成像区间的立体视觉直播画面,并把立体视觉直播画面发送给各观众;任意观众接收立体视觉直播画面,和/或立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成为边看虚拟场景直播边进行其它内容体验的立体视觉画面,显示给观众看。

30.基于此沉浸式互动直播系统,基于xr技术构建的单个或多个虚拟场景的沉浸式体验活动可以直播分享出来,观看沉浸式互动直播的观众边看边参与到直播虚拟场景的互动,也还可以并行进行其它内容的沉浸式体验。由于本发明指定一个基准用户瞳距,以此基准瞳距定义了一个基准视场,本发明只需渲染生成此基准视场的立体视觉画面,通过算法处理,就能使其适配不同用户的瞳距,使直播场景正确融入到用户的体验空间,提供正确地与直播虚拟场景互动的功能,从而使用较少的计算资源,就能适配所有不同瞳距的用户。

31.本系统可以应用到常规的直播活动,也可以应用到教学中,例如:在课堂里,教师在xr技术构建的虚拟实训场景里进行虚拟实操示范,本系统可以把教师的虚拟实操直播分享给课堂里所有学生,学生可以在自己体验空间里,观看教师实操立体画面,可以与教师的虚拟实操进行互动,还可以并行在自己的虚拟实操环境里进行操作,从而“学中做”、“做中学”;在课堂里,老师也可以指定某个学生的虚拟实操过程直播分享出来,供大家评价参考;还可以应用到实操竞赛中,每个参与竞赛的人或小组有一个独立的虚拟实操场景,他们可以通过直播实时立体地看到其它人或小组的虚拟实操进度,从而直观的形成竞赛对比。因此,本发明基于xr技术的沉浸式互动直播构建方法及系统具有很高的应用价值。

附图说明

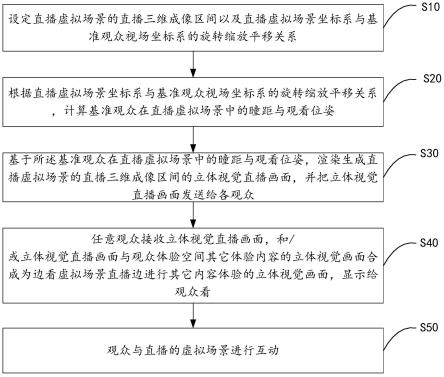

32.图1为本发明基于xr技术的沉浸式互动直播构建方法的流程示意图。

33.图2为本发明场景与场景实例示意图。

34.图3为本发明用户体验空间坐标系示意图。

35.图4为本发明用户视场坐标系示意图。

36.图5为本发明瞳距与立体视觉的示意图。

37.图6为本发明设定直播三维成像区间的示意图。

38.图7为本发明设定直播虚拟场景坐标系与基准观众视场坐标系旋转缩放平移关系示意图。

39.图8为本发明沉浸式互动直播系统硬件构成示意图。

40.图9为本发明沉浸式互动直播系统软件构成示意图。

具体实施方式

41.应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

42.参照图1,本发明提出一种基于xr技术的沉浸式互动直播构建方法,所述方法包括以下步骤:

43.步骤s10,设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系;

44.步骤s20,根据直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,计算基准观众在直播虚拟场景中的瞳距与观看位姿;

45.步骤s30,基于所述基准观众在直播虚拟场景中的瞳距与观看位姿,渲染生成直播虚拟场景的直播三维成像区间的立体视觉直播画面,并把立体视觉直播画面发送给各观众;

46.步骤s40,任意观众接收立体视觉直播画面,和/或立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成为边看虚拟场景直播边进行其它内容体验的立体视觉画面,画面显示给观众看;

47.步骤s50,观众与直播的虚拟场景进行互动。

48.其中,步骤s30生成的立体视觉直播画面带有深度信息,在所述步骤s40中,对于任意观众hk,hk接收的立体视觉直播画面与其体验空间其它体验内容的立体视觉画面合成为hk边看虚拟场景直播边进行其它内容体验的立体视觉画面,在立体视觉直播画面与hk对其它内容体验生成的立体视觉画面合成时,需要根据各画面在hk视场的深度信息进行遮挡计算。

49.其中,在所述步骤s10设定的直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系中,直播虚拟场景sm的坐标系到基准观众视场坐标系的缩放系数为λm,所述步骤s20计算出基准观众在直播虚拟场景sm中的瞳距为其中为基准观众的实际瞳距,根据直播虚拟场景sm坐标系与基准观众视场坐标系的旋转缩放平移关系,计算基准观众在直播虚拟场景中的位姿,所述步骤s30根据基准观众在直播虚拟场景sm的位姿与瞳距,生成立体视觉直播画面,其中为立体视觉画面的左眼图像,为立体视觉画面的右眼图像,为对应的深度图像,根据缩放系数λm,计算得到与在基准观众视场下的深度信息为深度图像和所述步骤s40立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成具体实现为:任意观看场景sm直播的观众hk,接收到场景sm的立体视觉直播画面,hk沉浸式体验空间内其它体验内容生成立体视觉体验画面左眼图像为右眼图像为与在hk视场的深度信息为深度图与hk与基准观众瞳距比值为场景sm的立体视觉直播画面与在基准观众视场下的深度图像与转换成hk视场的深度图像立体视觉直播画面与其它体验内容生成的立体视觉体验画面根据深度图像进行遮挡计算,生成合成画面。

50.其中,所述步骤s10,设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系具体包括:给直播虚拟场景sm选定三维包

围盒ω

′m,设定包围盒ω

′m在场景sm中的位姿,包围盒ω

′m在场景sm框选出一个三维区间ωm,ωm就是场景sm的直播三维成像区间,设定包围盒ω

′m在基准观众视场的位姿与缩放关系,计算出所述虚拟场景sm的直播三维成像区间ωm在基准观众视场中对应的三维显示区间设定了包围盒ω

′m在直播虚拟场景sm中的位姿以及ω

′m在基准观众视场的位姿与缩放关系,也就是设定了直播虚拟场景sm坐标系与基准观众视场坐标系的旋转缩放平移关系。

51.其中,在所述步骤s40中,对于任意观众hk,直播虚拟场景sm在hk体验空间的三维显示区间为生成hk体验空间其它体验内容的立体视觉画面时,hk体验空间其它体验内容在三维显示区间的内容不成像。

52.其中,所述步骤s40计算出直播虚拟场景三维成像区间在任意观众体验空间的三维显示区间的具体实现为:直播虚拟场景sm在基准观众视场中的三维显示区间为ω

user

,由任意观众hk瞳距与基准观众瞳距的比值计算出sm三维成像区间ωm在hk视场中的三维显示区间为

53.所述步骤s40后还有步骤s50:任意观众hk在其体验空间里与直播的虚拟场景sm进行互动,生成其体验空间里的互动操作命令ak,ak转换成直播虚拟场景sm里的互动操作命令a

′k,把a

′k发送给场景sm,场景sm对a

′k进行响应。

54.其中,所述步骤s50具体包括:

55.步骤s501:任意观众hk在自己体验空间进行互动操作,生成观众hk体验空间下的互动操作命令ak,命令ak包含的位姿参数是观众hk体验空间坐标系下位姿,判断ak是否为对直播虚拟场景sm的互动,如果是对直播虚拟场景sm的互动,就进入步骤s502,否则hk体验空间里其它内容响应互动操作命令ak,不进入步骤s502;

56.步骤s502:根据观众hk体验空间坐标系与hk视场坐标系的旋转平移关系,互动操作命令ak的位姿参数转换成hk视场坐标系下位姿参数;

57.步骤s503:根据观众hk瞳距dk与基准观众瞳距的比值,互动操作命令ak的位姿参数从hk视场坐标系下位姿参数转换成基准观众视场坐标系下位姿参数;

58.步骤s504:根据基准观众视场坐标系与直播虚拟场景sm坐标系旋转缩放平移关系,互动操作命令ak的位姿参数从基准观众视场坐标系转换到直播虚拟场景sm坐标系下位姿参数,生成互动操作命令a

′k;

59.步骤s505:互动操作命令a

′k,发送给虚拟直播场景sm,sm对a

′k响应。

60.由此,通过设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系;根据直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,计算基准观众在直播虚拟场景中的瞳距与观看位姿;基于所述基准观众在直播虚拟场景中的瞳距与观看位姿,渲染生成虚拟场景直播三维成像区间的立体视觉直播画面,并把立体视觉直播画面发送给各观众;任意观众接收立体视觉直播画面,和/或立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成为边看虚拟场景直播边进行其它内容体验的立体视觉画面,显示给观众看;任意观众与直播的虚拟场景还

可以进行互动。

61.基于此沉浸式互动直播系统,基于xr技术构建的单个或多个虚拟场景的沉浸式体验活动可以直播分享出来,观看沉浸式互动直播的观众边看边参与到直播虚拟场景的互动,也还可以并行进行其它内容的沉浸式体验。由于本发明指定一个基准用户瞳距,以此基准瞳距定义了一个基准视场,本发明只需渲染生成此基准视场的立体视觉画面,通过算法处理,就能使其适配不同用户的瞳距,使直播场景正确融入到用户的体验空间,提供正确地与直播虚拟场景互动的功能,从而使用较少的计算资源,就能适配所有不同瞳距的用户。

62.此外,本发明还提出一种基于xr技术的沉浸式互动直播构建系统,所述系统包括:沉浸式互动直播管理服务器、多台xr应用服务器、存储服务器,其中,用户的xr终端通过无线网络访问所述管理服务器与所有xr应用服务器,所述管理服务器部署有沉浸式互动直播管理控制中心,所述存储服务器部署有xr资源库:

63.所述xr资源库,用于存储xr应用资源;

64.所述沉浸式互动直播管理控制中心,用于接收xr终端的虚拟场景体验申请,指令xr应用服务器分配虚拟场景实例,协助xr终端与虚拟场景实例建立通信连接;接收用户直播分享的申请,指令xr应用服务器分配用于直播的虚拟场景实例;设定直播虚拟场景的直播三维成像区间;设定直播虚拟场景坐标系到基准观众视场坐标系的旋转缩放平移关系;计算基准观众在直播虚拟场景中的位姿与瞳距并发送给直播虚拟场景;

65.所述xr应用服务器,用于接收所述沉浸式互动直播管理控制中心发送的分配虚拟场景实例指令,根据所述场景实例分配指令里虚拟场景的场景id,分配相应的虚拟场景实例,当现有场景实例没有足够的计算资源时,调用对应的xr应用程序及相关的资源包,生成虚拟场景实例,并令新生成的场景实例与原有场景实例建立通信连接,同步场景状态。

66.所述xr应用服务器,还用于接收所述沉浸式互动直播管理控制中心发送的销毁场景实例指令,根据该指令销毁虚拟场景实例;

67.所述xr终端,用于向所述沉浸式互动直播管理控制中心发送虚拟场景体验申请,与分配给此xr终端用户的虚拟场景实例建立通信连接;采集xr终端的位姿参数以及互动操作信息发送给分配给此xr终端用户的虚拟场景实例;接收虚拟场景实例发送的沉浸式体验画面;向沉浸式互动直播管理控制中心申请观看直播,与直播场景建立通信连接,接收直播场景发送过来的直播画面;判断用户互动操作是否为对直播场景互动,当对直播场景互动时,把互动操作命令的位姿参数转换到直播场景坐标系,并把转换后的互动操作命令发送到直播场景;接收直播虚拟场景发送的直播立体视觉画面;合成直播立体视觉画面与体验空间其他内容的立体视觉体验画面,生成完整的边看虚拟场景直播边进行其它内容体验的互动体验画面,显示给用户看。

68.相比现有技术,本系统基于xr技术构建的单个或多个虚拟场景的沉浸式体验活动可以直播分享出来,观看沉浸式互动直播的观众边看边参与到直播虚拟场景的互动,也还可以并行进行其它内容的沉浸式体验。由于本发明指定一个基准用户瞳距,以此基准瞳距定义了一个基准视场,本发明只需渲染生成此基准视场的立体视觉画面,通过算法处理,就能使其适配不同用户的瞳距,生成正确的直播画面与互动功能,从而使用较少的计算资源,就能适配所有不同瞳距的用户。

69.本系统可以应用到常规的直播活动,也可以应用到教学中,例如:在课堂里,教师

在xr技术构建的虚拟实训场景里进行虚拟实操示范,本系统可以把教师的虚拟实操直播分享给课堂里所有学生,学生可以在自己沉浸式体验空间里,观看教师实操立体画面,可以与教师的虚拟实操进行互动,还可以并行在自己的虚拟实操环境里进行操作,从而“学中做”、“做中学”;在课堂里,老师也可以指定某个学生的虚拟实操过程直播分享出来,供大家评价参考;还可以应用到实操竞赛中,每个参与竞赛的人或小组有一个独立的虚拟实操场景,他们可以通过直播实时立体地看到其它人或小组的虚拟实操进度,从而直观的形成竞赛对比。因此,本发明基于xr技术的沉浸式互动直播构建方法及系统具有很高的应用价值。

70.本发明还提出一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序被处理器调用时执行如上所述的基于xr技术的沉浸式互动直播构建方法的步骤。

71.以下对本发明基于xr技术的沉浸式互动直播构建方法的实现原理进行详细阐述:

72.本发明涉及的技术术语包括:

[0073]“场景”与“场景实例”是两个紧密相关的名词。场景定义了一个三维空间里包含的对象、对象状态、对象自身运行逻辑、以及对象之间相互作用的逻辑;场景实例是系统调用计算机处理器、内存、显卡等计算资源根据场景定义实时运行的程序进程,此程序进程实时计算场景内各对象状态,并渲染画面。单个场景同时有多个用户体验时,单个场景实例能获得的计算资源如果不能实时为所有用户生成体验画面时,就需要为此场景生成多个场景实例并分配给用户,这些场景实例之间同步场景内对象状态,各场景实例分别为对应的用户实时生成体验画面,从而各用户共享体验此场景;同样地,当场景拥有的场景实例如果在为用户直接生成沉浸式体验外,没有足够的计算资源再生成直播画面,则需要此场景增加场景实例,增加的场景实例须与此场景的其它实例同步场景状态。

[0074]

以图2为例,有虚拟场景1,用户a与用户b对此虚拟场景进行协同体验,当单个场景实例无法同时为2个用户生成沉浸式体验时,系统生成了2个场景实例分别为虚拟场景1实例1与虚拟场景1实例2,两个实例通过通信连接,交换场景状态信息同步场景状态,实例1为用户a生成沉浸式体验画面,实例2为用户b生成沉浸式体验画面。从而实现了用户a与用户b对虚拟场景1的协同体验。进一步把虚拟场景1直播分享给其它用户,当已有的2个场景实例没有足够计算资源再生成实时直播画面时,系统就需再生成虚拟场景1的实例3,新的实例与实例2交换场景状态参数,从而与实例1、2同步场景状态,实例3生成的直播画面发送给用户c、d、e。

[0075]

用户体验空间坐标系。市面上主流的xr头显都自带定位功能,能自动在用户所处的环境建立坐标系,如图3所示,图3为本发明用户体验空间坐标系示意图,此坐标系在水平面的垂直向上方向定义y轴的正方向,在水平面上定义x轴与z轴。用户体验空间坐标系就是xr头显自动建立的这个坐标系。

[0076]

用户视场坐标系是在人眼视场定义的坐标系。以图4为例,人眼双目光心连线上,双目光心之间的中点作为坐标系的原点,人眼双目连线从左眼到右眼方向定义为x轴正方向,注意力方向定义为z轴正方向,以与x轴与z轴垂直且满足左手坐标系定义y轴正方向。

[0077]

基准瞳距与基准观众。不同人之间,双目瞳距不相同。在本发明中指定一个瞳距值为瞳距基准值,称为基准瞳距。设定或假定一个瞳距为基准瞳距的用户为基准观众。

[0078]

瞳距与立体视觉

[0079]

人眼在观看物体时,人的左眼与右眼分别对物体都进行成像,同一物点在人的左眼与右眼成像位置存在差异,此差异为视差,视差让人眼可以正确感知物点的三维信息。如图5中的(a)图所示,瞳距为d,o

l

为为人的左眼光心,or为人的右眼光心,物点c在左眼成像位置为a点,在右眼成像位置为b点。如图5中的(b)图所示,瞳距为dk,当物点在人眼成像位置不变时,仍然在左眼成像位置为a点,在右眼成像位置为b点,此时感知到的物点三维位置为三角形o

l

orc与三角形相似但不相等,大小比例为所以,相同的左右眼立体图片适配不同的人眼瞳距时,不同瞳距的人感知到的立体视觉信息不相同。

[0080]

旋转缩放平移矩阵以及旋转矩阵与欧拉角的转换

[0081]

在本实施例采用左手手坐标系,任意两个坐标系ψ到旋转缩放平移关系为:按z、x、y的顺序绕轴旋转角度分别为θ、β、α,沿x、y、z轴分别平移t

x

、ty、tz,z、x、y三个轴同比例缩放系数为λ,令任意点p在中ψ坐标值为(c

x c

y cz),在坐标值为(w

x w

y wz),从ψ到坐标值转换关系为:

[0082][0083]

其中,r为旋转矩阵,t为平移矩阵,旋转角度与旋转矩阵r的转换关系如下:

[0084]

平移量与平移矩阵t的转换关系如下:

[0085]

t=[t

x t

y tz]

t

ꢀꢀꢀ

(3)

[0086]

旋转缩放平移矩阵为:

[0087][0088]

有:

[0089]

[w

x w

y w

z 1]

t

=h[c

x c

y c

z 1]

t

ꢀꢀꢀ

(5)

[0090]

旋转矩阵r转换成旋转角度如下:

[0091]

令已知旋转缩放平移矩阵则:

[0092]

当h

13

、h

33

、h

21

、h

22

不同时为0时,

[0093][0094]

当h

13

、h

33

、h

21

、h

22

同时为0时,则则若β取值为则:

[0095]

α-θ=atan2(h

12

,h

11

)

ꢀꢀꢀ

(7)

[0096]

其中α可以取任意角度值,θ满足上面等式就可以。

[0097]

若β取值为则:

[0098]

α+θ=atan2(-h

12

,h

11

)

ꢀꢀꢀ

(8)

[0099]

其中α可以取任意角度值,θ满足上面等式就可以。

[0100]

本发明基于xr技术的沉浸式互动直播构建方法的实现场景如下:

[0101]

有多位用户参与基于xr技术的沉浸式体验活动,用户集合为p={h

0 h1ꢀ…ꢀhn-1

},任意用户hk的瞳距用dk表示,每个用户的瞳距不相同。其中,有用户hm对虚拟场景sm进行沉浸式体验,hm把对sm的沉浸式体验过程进行实时直播分享,p中任意其它用户在观看hm对sm体验的立体直播画面,可以对直播场景sm进行互动,还可以并行对其它虚拟场景进行沉浸式体验。如图1所示,此沉浸式互动直播构建方法具体包括如下步骤:

[0102]

(1)设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系

[0103]

直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系旋转缩放平移关系的设定可以正向设定或逆向设定。正向设定是人为或系统选择一个三维包围盒,设定此包围盒在直播虚拟场景的位姿,包围盒框选出来的直播虚拟场景的三维区间是直播虚拟场景的直播三维成像区间,此成像区间的场景内容将呈现给观众看,然后设定三维包围盒在基准观众视场中的位姿与缩放系数,此三维包围盒在基准观众视场中框选出来的三维区间是直播虚拟场景在基准观众视场中的三维显示区间,由设定的三维包围盒坐标系与直播虚拟场景的旋转平移关系以及三维包围盒坐标系与基准观众视场坐标系的旋转缩放平移关系,就确定了直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系;逆向设定是人为或系统选择一个三维包围盒,设定此包围盒在基准观众视场中的位姿与缩放系数,就确定了直播虚拟场景在基准观众视场中的三维显示区间,设定直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,由设定的三维显示区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,可计算得到直播虚拟场景里的直播三维成像区间。逆向设定方法很容易依照正向设定方法得到,下面只详细介绍正向设定方法:

[0104]

①

设定直播虚拟场景的直播三维成像区间

[0105]

选定一个三维包围盒ω

′m,三维包围盒形状可以任意,设定此包围盒在虚拟场景sm中的位姿。此包围盒在sm中框选的三维区间,作为给虚拟场景设定的直播三维成像区间。在进行直播过程中,此虚拟场景只有在直播三维成像区间内的内容才会直播分享给其他用户。包围盒在虚拟场景sm中的位姿可以在直播过程中根据需要进行调整。此三维成像区间只约束了直播分享,对本身就在sm中进行沉浸式体验的用户hm没有任何约束。具体如下。

[0106]

给虚拟实训场景sm选定三维包围盒ω

′m。为ω

′m定义坐标系ψ

′m,ψm为虚拟场景sm的坐标系。设定ω

′m在sm中的位姿,也就是设定坐标系ψ

′m到ψm的旋转平移关系。在ψ

′m与ψm的旋转关系中,本发明实时例限定ψ

′m只能绕ψm的y轴旋转,令ψ

′m到ψm旋转平移关系中的旋转量可以表示为绕y轴旋转角度为缩放系数为1,平移量为令坐标系ψ

′m中任意点在坐标系ψm中坐标值用(c

x c

y cz)表示,依照式(4)则得ψ

′m到ψm的旋转缩放平移矩阵hm,其中:

[0107][0108]

则:

[0109][0110]

对于三维包围盒ω

′m中任意点,把其在坐标系ψ

′m下的坐标值代入式(10)计算得到其在ψm中的坐标值,由此确定了ω

′m在sm中限定的三维成像区间ωm。以图6为例,选定一个圆柱体为包围盒,设定此圆柱体到虚拟场景里的位姿,从而框选出虚拟场景里需要直播分享的区间。

[0111]

三维包围盒也可以无限大,这样虚拟场景里所有内容都将在直播分享区间内。

[0112]

②

设定虚拟场景直播三维成像区间在基准观众视场里的三维显示区间

[0113]

设定虚拟场景直播三维成像区间ωm在用户视场里的三维显示区间方式为:设定三维包围盒ω

′m在基准观众视场的位姿与缩放关系,可计算出虚拟场景直播三维成像区间ωm在基准观众视场中对应的显示区间。具体如下。令基准观众视场坐标系用ψ

user

表示,设定三维包围盒ω

′m在基准观众视场的位姿与缩放关系,也就是设定三维包围盒ω

′m直角坐标系ψ

′m到基准观众视场坐标系ψ

user

的旋转缩放平移关系,ψ

′m到ψ

user

的缩放是各轴同比例缩放。设定ψ

′m到ψ

user

旋转缩放平移关系中的旋转量表示为[α

m β

m θm]、平移量为缩放系数表示为λm。依照式(4),可以得到坐标系ψ

′m到ψ

user

的旋转缩放平移矩阵令ω

′m中任意点在坐标系ψ

′m下坐标值为在基准观众视场坐标系ψ

user

中坐标值用(w

x w

y wz)表示,则:

[0114][0115]

把ω

′m中任意点代入式(11),可以计算出ω

′m在基准观众视场中的三维显示区间同时也是直播三维成像区间ωm在基准观众视场中对应的三维显示区间

[0116]

设定了三维包围盒ω

′m坐标系到直播虚拟场景sm坐标系的旋转平移变换关系,以及三维包围盒ω

′m坐标系到基准观众视场坐标系ψ

user

的旋转缩放平移关系,也就同步设定了直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,直播虚拟场景坐标系到基准观众视场坐标系的旋转缩放平移关系可用旋转缩放平移矩阵表征。反过来,基准观众视场坐标系到直播虚拟场景坐标系的旋转缩放平移矩阵为如图7所示,图7为本发明在基准用户视场设定直播虚拟场景坐标系与基准观众视场坐标系旋转缩放平移关系示意图。

[0117]

(2)计算基准观众在直播虚拟场景中观看位姿与瞳距

[0118]

在本发明实施例中,基准观众在基准观众视场坐标系ψ

user

中位置坐标为(0 0 0),姿态角为(0 0 0)。根据基准观众视场坐标系ψ

user

到直播虚拟场景sm坐标系ψm的旋转缩放平移矩阵任意点在ψ

user

中坐标值为(w

x w

y wz),在ψm坐标值为(c

x c

y cz),则:

[0119][0120]

把基准观众在基准观众视场坐标系ψ

user

中位置坐标(0 0 0)代入式(12)可以计算得到基准观众在场景sm坐标系ψm下的位置坐标wm。由于基准观众在基准观众视场坐标系ψ

user

中姿态角为(0 0 0),则根据式(6)、(7)、(8)从旋转缩放平移矩阵转换出来的绕轴z、x、y的三维旋转角度向量qm,就是基准观众视场在场景sm坐标系ψm下的姿态角。从而得到基准观众在ψm下位姿值由于,直播虚拟场景sm的直播三维成像区间在基准观众视场进行了缩放显示,由此直播虚拟场景为基准观众生成直播立体视觉画面所用的瞳距也发生了缩放,在sm生成直播立体视觉画面所用的瞳距为

[0121]

(3)渲染生成直播虚拟场景三维成像区间的立体视觉图片

[0122]

在视场位姿值以及瞳距下,为观众实时渲染场景sm成像区间ωm双目立体视觉画面以及对应的深度图片。其中,为立体视觉画面的左眼图像,为立体视觉画面的右眼图像,为对应的深度图像,然后深度图像还需根据缩放因素λm转换成基准观众视场下的深度图像,由此对于左眼图像任意像素其深度值为对于右眼像任意像素其深度值为发送立体视觉画面以及深度图像给各观众。

[0123]

(4)观众接收立体视觉直播画面,和/或立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成为边看虚拟场景直播边进行其它内容体验的立体视觉画面,显示给观众看

[0124]

任意观众hk实时接收到sm的直播画面,当直播画面的左右眼图片分别显示给人的左右眼看时,观众hk就会直接获得对场景sm的三维成像区间ωm里面内容的立体视觉感知。但当观众观看直播的同时还在进行其它内容的沉浸式体验,这时直播立体视觉画面需要与其它内容的立体视觉体验画面合成,生成观众hk的完整立体视觉体验画面,使直播虚拟场景融入到观众沉浸式体验空间。直播立体画面与其它内容的立体视觉体验画面合成时,需要进行图像之间遮挡计算,只有在用户相同视线上的像素才会遮挡,在本发明实施例中要求渲染生成所有立体视觉图像和深度图像时采用相同大小的视场角与分辨率,所以多幅左眼或右眼图片之间具有相同图像坐标的像素点在用户相同视线上。立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面,合成为边看虚拟场景直播边进行其它内容体验的立体视觉画面,具体实现如下。

[0125]

生成观众沉浸式体验空间其它体验内容的立体视觉画面时,计算出直播虚拟场景在观众体验空间的三维显示区间,观众体验空间其它体验内容在此三维区间的内容不成像。通过步骤(1),已经获得直播虚拟场景在基准观众视场下的显示区间ω

user

,对于任意观众用户hk,其瞳距为dk,由于瞳距的差异,直播虚拟场景sm在用户hk的视场中显示区间不是ω

user

,令ω

user

中任意点(u

x u

y uz),其在hk视场坐标系中对应坐标值为则

由此映射关系,ω

user

映射到用户hk的视场就可以获得直播场景在此用户视场下的显示区间根据则有直播虚拟场景在任意观众视场中的三维显示区间为

[0126]

对于任意用户hk,在观看场景sm直播,同时也在其它内容进行体验,例如对场景sk进行沉浸式体验。前面已经计算得到直播虚拟场景在hk视场中的三维显示区间为观众体验空间其它体验内容在三维区间u里的内容不成像,但可以保留虚拟互动工具在此区间成像,令除sm直播外,用户hk体验空间其他内容生成的体验画面左眼图像为右眼图像为在hk视场对应深度值为与接收到的场景sm的直播立体视觉图片与需要与合成为用户hk的边看虚拟场景直播边对体验空间内其它内容进行体验的完整立体视觉画面。图片合成时需要进进行遮挡计算。由于用户hk瞳距dk与基准瞳距的差异,用户hk感知到的与深度信息与基准观众视场下的深度图像有差异,用户hk感知到的与的深度图像为令合成后的体验画面左眼图片为右眼图片为对应深度图像为初始化遍历图片中任意像素,如果则否则不做处理;同样,如果则否则不做处理。按如上计算遍历完图像中所有像素,就完成了画面合成。合成画面显示给观众hk看。

[0127]

(5)观众与直播的虚拟场景进行互动

[0128]

任意观众在自己的沉浸式体验空间对直播虚拟场景互动,生成用户体验空间坐标系下的互动命令,把互动命令的位姿参数正确转换到直播虚拟场景坐标系,由此把互动命令转换成虚拟直播场景下的互动命令,把转换后的互动命令发送给直播虚拟场景,直播虚拟场景响应此互动命令,完成观众与直播虚拟场景的互动。

[0129]

任意观众用户hk,hk的沉浸式体验空间坐标系用表示。hk在其体验空间,基于sm直播画面,对sm进行互动操作,产生用户hk体验空间的互动操作命令ak,互动操作命令ak包含坐标系下的位姿参数,其中位置参数为姿态角参数为把互动操作命令ak转换成场景sm里的互动操作命令a

′k,需要把位姿ak的位姿参数转换成场景sm坐标系ψm下的的位姿参数,实时传输位姿参数转换后的互动操作命令a

′k到场景sm中,场景sm对a

′k进行响应。从而实现观众与直播虚拟场景的互动。

[0130]

观众与直播的虚拟场景进行互动具体实现如下:

[0131]

①

判断互动操作是否为对直播虚拟场景的互动

[0132]

直播虚拟场景在观众hk的视场里的显示区间为由步骤4计算出直播虚拟场景在任意观众视场中的三维显示区间当互动操作命令ak的位置参数属于区间时,则判断此命令属于对直播虚拟场景sm的互动,进入下面的步骤;否则不进入下面的步骤,用户体验空间内其它内容响应此命令。

[0133]

②

由观众视场坐标系到观众体验空间坐标系的旋转变换关系,把互动操作命令位姿参数从观众体验空间坐标系转换到观众视场坐标系;

[0134]

令xr终端实时定位出的观众hk在其沉浸式体验空间坐标系下的位姿为[w

k,0 q

k,0

],其中,q

k,0

=(α

k β

k θk)。从而在到的坐标系变换关系中,旋转角度为q

k,0

,平移量为w

k,0

,缩放系数为1,依照式(4),可得到的旋转缩放平移矩阵hk,令hk的用户体验空间坐标系中任意点在hk的视场坐标系下坐标值为则从到坐标值变换关系为:

[0135][0136]

把互动操作命令的位置参数代入式(13),可以计算得到互动操作命令ak位置参数转换到hk用户视场坐标系下的坐标值w

user

,把互动操作命令ak的姿态角当旋转角度,把位置参数当平移量,缩放系数为1,依照式(4)可以构建出一个旋转缩放平移矩阵h

′k,则hkgh

′k依照式(6)、(7)、(8)转换出旋转角度向量q

user

,q

user

就是互动操作命令ak转换到hk用户视场坐标系下的姿态角,其中hk为到的旋转缩放平移矩阵。

[0137]

③

互动命令位姿参数转换到基准观众视场坐标系下

[0138]

根据观众hk瞳距dk与基准观众瞳距的比值,互动命令位姿参数转换到基准观众视场坐标系下时姿态角不变,但坐标值发生改变,互动操作命令在hk用户视场坐标系下的坐标值w

user

,则互动操作命令在基准观众视场坐标系ψ

user

下坐标值为

[0139]

④

把互动命令位姿参数从基准用户视场坐标系转换到直播虚拟场景坐标系

[0140]

把代入式(12)可以计算得到互动操作命令ak位置参数在直播虚拟场景sm坐标系ψm对应的坐标值w,把依照式(6)、(7)、(8)可以转换得到互动操作命令ak姿态角参数在ψm对应的姿态角值q,其中为基准观众视场坐标系ψ

user

到直播虚拟场景坐标系ψm的旋转缩放平移矩阵。把[w q]赋值给互动操作命令ak的位姿参数,从而把互动操作命令ak转换成了场景sm里的互动操作命令a

′k,场景sm对a

′k响应,正确实现了任意观众用户hk基于直播画面与场景sm的互动。

[0141]

参照图8,本发明基于xr技术的沉浸式互动直播构建系统的硬件构成如图8所示,实现本发明基于xr技术的沉浸式互动直播硬件系统主要包括:云服务器集群、网络设备、以及xr终端。

[0142]

在云服务器集群中,服务器包括沉浸式互动直播管理服务器、多台xr应用服务器、存储服务器。xr应用服务器须具备高性能的图形渲染能力,服务器之间须互联互通,用户的xr终端通过无线网络访问管理服务器与所有xr应用服务器,xr终端可以为xr头盔或眼镜。

[0143]

参照图9,本发明基于xr技术的沉浸式互动直播构建系统的软件构成如图9所示,实现本发明基于xr技术的沉浸式系统软件主要包括4个模块:

[0144]

沉浸式互动直播管理控制中心、xr资源库、用户端、xr应用服务端。其中:

[0145]

沉浸式互动直播管理控制中心安装在沉浸式互动直播管理服务器,xr资源库部署在存储服务器,用户端安装在用户的xr终端上,xr应用服务端安装在每台xr应用服务器上。下面介绍各模块的主要功能。

[0146]

1、xr资源库:

[0147]

xr资源库存储了xr应用程序、xr资源包等xr应用资源。

[0148]

2、沉浸式互动直播管理控制中心:

[0149]

安装在沉浸式互动直播管理服务器上,功能包括:

[0150]

(1)接受用户端虚拟场景体验申请,命令xr应用服务端分配虚拟场景实例,并协助用户端与对应的虚拟场景实例建立通信连接。

[0151]

(2)接收用户直播分享的申请,命令xr应用服务端分配用于直播的虚拟场景实例。

[0152]

(3)用户或系统在沉浸式互动直播管理控制中心,设定虚拟场景直播分享的三维成像区间,设定直播虚拟场景坐标系与基准观众视场坐标系旋转缩放平移关系。

[0153]

(4)任意用户向管理控制中心申请观看直播,管理控制中心协助此用户与直播场景建立通信连接,基于此通信连接,此用户能接收到直播立体画面,能把对此直播场景的互动发送到直播场景。

[0154]

3、xr应用服务端:

[0155]

具体功能包括:

[0156]

接收沉浸式互动直播管理控制中心发送过来的分配虚拟场景实例指令,xr应用服务端将根据指令里虚拟场景的id,分配对应虚拟场景的实例,当现有场景实例没有足够的计算资源时,调用对应的xr应用程序及相关的资源包,生成虚拟场景实例,并令新生成的场景实例与原有场景实例建立通信连接,同步场景状态。

[0157]

接收沉浸式互动直播管理控制中心发送过来的销毁场景实例指令,销毁虚拟场景实例。

[0158]

4、用户端:

[0159]

具体功能包括:

[0160]

(1)向沉浸式互动直播管理控制中心发送虚拟场景体验申请,与分配给此用户的虚拟场景实例建立通信连接;

[0161]

(2)采集用户终端的位姿参数、互动操作信息等,发送给场景实例;

[0162]

(3)接收场景实例发送过来的沉浸式体验画面;

[0163]

(4)向沉浸式互动直播管理控制中心申请观看直播,与直播场景建立通信连接,接

收直播场景发送过来的直播画面;

[0164]

(5)判断用户互动操作是否为对直播场景互动,当对直播场景互动时,把互动操作命令的位姿参数转换到直播场景坐标系,并把转换后的互动操作命令发送到直播场景;

[0165]

(6)合成直播画面与体验空间其他内容的画面,生成完整的边看虚拟场景直播边进行体验空间里其他内容的体验的立体视觉体验画面,显示给用户看。

[0166]

基于此沉浸式互动直播系统,xr技术构建的单个或多个虚拟场景的沉浸式体验活动可以直播分享出来,观看沉浸式互动直播的观众边看边参与到直播虚拟场景的互动,也还可以并行进行其它内容的沉浸式体验。由于本发明指定一个基准用户瞳距,以此基准瞳距定义了一个基准观众视场,本发明只需渲染生成此基准观众视场的立体视觉直播画面,通过算法处理,就能使其适配不同用户的瞳距,使直播场景正确融入到用户的体验空间,提供正确地与直播虚拟场景互动的功能,从而使用较少的计算资源,就能适配所有不同瞳距的用户。

[0167]

此外,本发明还提出一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序被处理器调用时执行如上所述的基于xr技术的沉浸式互动直播构建方法的步骤。

[0168]

本发明提出的一种基于xr技术的沉浸式互动直播构建方法、系统及存储介质,通过设定直播虚拟场景的直播三维成像区间以及直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系;根据直播虚拟场景坐标系与基准观众视场坐标系的旋转缩放平移关系,计算基准观众在直播虚拟场景中的瞳距与观看位姿;基于所述基准观众在直播虚拟场景中的瞳距与观看位姿,渲染生成虚拟场景直播三维成像区间的立体视觉直播画面,并把立体视觉直播画面发送给各观众;任意观众接收立体视觉直播画面,和/或立体视觉直播画面与观众体验空间其它体验内容的立体视觉画面合成为边看虚拟场景直播边进行其它内容体验的立体视觉画面,显示给观众看。基于此沉浸式互动直播系统,xr技术构建的单个或多个虚拟场景的沉浸式体验活动可以直播分享出来,观看沉浸式互动直播的观众边看边参与到直播虚拟场景的互动,也还可以并行进行其它内容的沉浸式体验。由于本发明指定一个基准观众瞳距,以此基准瞳距定义了一个基准观众视场,本发明只需渲染生成此基准观众在直播虚拟场景里瞳距与位姿下的直播虚拟场景立体视觉直播画面,通过算法处理,就能使其适配不同用户的瞳距,使直播场景正确融入到用户的体验空间,提供正确地与直播虚拟场景互动的功能,从而使用较少的计算资源,就能适配所有不同瞳距的用户。

[0169]

以上仅为本发明的优选实施例,并非因此限制本发明的专利范围,方案利用本发明说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本发明的专利保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1