一种交通场景下异源图像融合方法

1.本发明涉及红外与可见光图像融合技术领域,具体涉及一种交通场景下异源图像融合方法。

背景技术:

2.随着计算机水平不断提升,图像处理技术不断发展,基于图像的交通信息感知应用日益增加。其中可见光传感器具备如下特点,应用较为广泛:成像与人类视觉相似,数据直观;数据中包含环境信息,语义特征丰富;分辨率高,布设成本低等。但是,可见光传感器在光线不足、天气恶劣等情况下成像效果较差。基于热像的红外图像传感器通过探测物体的热辐射成像,具备以下几个特点:具有较强的抗干扰能力,可以工作在恶劣环境中;全天候的工作特性;良好的热目标探测能力;所成图像整体较为模糊,分辨率不高,不适合观察理解。考虑到红外与可见光图像的成像特点及互补特性,利用二者协同成像并进行融合,能够在夜间、天气恶劣等情况下获得目标突出、背景信息丰富的融合图像,从而提高交通信息感知效率。

3.交通场景下的晕光指夜间灯光在可见光传感器中过曝造成的视野盲区,驾驶员视角下的晕光会影响驾驶员的路况判断,产生严重安全隐患;监控视角下的晕光会导致晕光区域内交通目标细节的丢失,影响交通数据采集与路面情况判断。为了减小晕光影响,提高驾驶安全性与监控数据采集效率,近年来许多研究从光晕去除、异源图像融合等角度尝试解决晕光问题。

4.基于可见光与红外的异源图像融合是一种可行有效的图像处理技术。已有研究中,中国专利cn202111352352.x公开了一种基于多尺度特征的红外与可见光融合技术,中国专利cn202110901665.x公开了一种基于频域规则的红外与可见光图像融合方法,但现有方法需要人工针对特定场景标定设计,整个过程计算量较大且算法普适性不强,且在包含晕光的典型交通场景下,单源图像信息损失较多,对融合图像质量产生负面影响。现有融合算法较少考虑单源信息损失情况,导致此场景下融合图像偏暗或丢失光晕内目标细节,融合效果不好。

5.图像抗晕光技术是一种可行有效的图像处理技术。已有研究中,中国专利cn202110325989.3提出一种基于nsct的图像融合的抗晕光方法,中国专利cn201810617257.x提出一种基于图像亮度梯度稀疏表示的光晕去除方法,根据图像亮度梯度与曝光质量生成融合权值去除图像中的光晕。总体来说,现有研究在抗晕光技术上取得了一定的效果,但是光晕去除技术路线需要以低曝光无光晕图像作为参考图像提取晕光区域细节,图像采集难度大,且在晕光去除步骤中直接更改图像局部亮度值,输出图像晕光区域对比度较差。异源图像融合技术路线多采用设计规则的思路融合异源图像消除晕光,整个过程计算量较大,无法应用于汽车抗晕光、监控交通信息采集等实时交通场景应用中,且普适性不强。

6.有鉴于此,需要提供一种新的方法,以期解决上述至少部分问题。

技术实现要素:

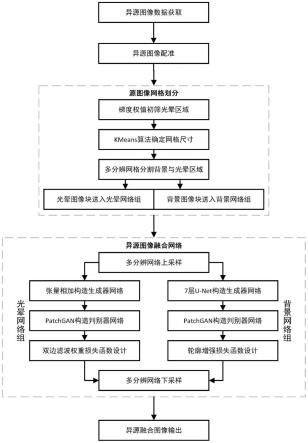

7.为了克服现有技术的不足,本发明提出了一种交通场景下异源图像融合方法,首先对异源图像实施图像配准,使源图像时空信息一致;接下来对源图像进行网格划分,将源图像切割为不同尺寸的晕光图像块与背景图像块;之后将晕光图像块与背景图像块分别输入晕光网络组与背景网络组进行图像融合;最后将融合图像块还原至源图像位置,输出具有抗晕光能力的融合图像,该方法流程简单易行,处理速度快,鲁棒性强,适用于各种包含晕光的交通场景。

8.技术方案:为解决上述技术问题,本发明采用以下技术方案:

9.一种交通场景下异源图像融合方法,包括:

10.s1:获取异源图像数据:获取相同时间、相同地点、相同拍摄场景和相同拍摄角度的源图像数据,包括可见光图像与红外图像,所述拍摄场景为常见交通场景;

11.s2:对异源图像数据进行配准:以红外源图像为参考图像,采用基于surf算子与背景鲁棒关联的配准算法完成可见光与红外源图像的配准,使可见光与红外源图像的时空信息一致;

12.s3:对源图像进行网格划分:采用像素梯度权值初筛图像场景中的晕光区域,采用k-means聚类算法获得晕光区域的尺寸信息,采用多分辨分割策略将源图像切割为不同尺寸的晕光图像块与背景图像块;

13.s4:对异源图像融合:对晕光图像块与背景图像块进行多分辨上采样,统一晕光图像块与背景图像块的尺寸;采用基于张量相加与双边滤波的晕光网络组,融合可见光与红外晕光图像块;采用基于u-net与轮廓增强的背景网络组,融合可见光与红外背景图像块;对融合后的可见光与红外晕光图像块、可见光与红外背景图像块进行多分辨下采样,还原图像块在源图像中的尺寸;

14.s5:复原图像:还原图像块至源图像所在位置,输出具有抗晕光能力的融合图像。

15.进一步的,本发明的交通场景下异源图像融合方法,s1中的常见交通场景包括:日间、夜间有路灯、夜间无路灯等光照条件下的交叉口、快速路、高速公路、交织区的道路类型,拍摄角度包括航拍视角、斜视视角与驾驶员视角。

16.进一步的,本发明的交通场景下异源图像融合方法,s2中对异源图像数据进行配准的具体步骤包括:

17.s2.1:对可见光图像进行中心对称缩放裁剪,且在不改变可见光图像视野的前提下统一可见光图像与红外图像的像素信息;

18.s2.2:使用e-net语义分割算法对源图像进行语义分割,划分道路区域与背景区域,使用surf算子寻找背景区域中的特征角点;

19.s2.3:判断背景区域中的特征角点pi是否处于密集角点簇中,判断公式如下:

[0020][0021][0022]

其中,||pi,pj||2表示特征点pi与pj的欧式距离,dis

th

为判断角点密集程度的距离阈值,d

th

为比例阈值;

[0023]

若特征角点pi不处于密集角点簇中,则将其直接计入候选特征点集cd;

[0024]

若特征角点pi处于密集角点簇中,则设密集角点簇中的角点数量为n0,并计算应保留的角点数量n:

[0025][0026]

密集角点簇中最少保留1个角点,最多保留n-1个角点;

[0027]

确定角点数量n后,遍历角点簇中所有数量为n的角点组合,选取间距最大的角点组合作为需要保留的角点,并计入候选特征点集cd;

[0028]

s2.4:对于候选特征点集cd,采用knn算法关联可见光图像与红外图像中的特征点对,将关联得到的匹配点对之间的连线表示为f(xn)=kmxn+b,其中,m为一正交2*2矩阵,行列式为1,b为2*1变换向量,k为比例系数,最小化下式寻找最优匹配点对连线斜率:

[0029][0030]

其中,λ》0为协调比例系数,σ为候选特征点集的分布标准差,(xn,yn)为特征点n的图像坐标;

[0031]

将最优的连线方程f(xn)=kmxn+b记为f(xn)=kxn+b,其中,k、b分别为直线方程的斜率与常量常数,选取连线方程常数在三倍标准差范围内的点对作为参与配准的点对,即:

[0032]

k-3σk≤ki≤k+3σk[0033]

b-3σb≤bi≤b+3σb[0034]

其中,σk为比例系数k的分布标准差,σb为变换向量b的分布标准差,ki、bi为参与配准的点对的常数;

[0035]

s2.5:获取参与配准的点对集,建立透视变换矩阵生成配准方案,生成配准后的可见光图像与红外图像。

[0036]

进一步的,本发明的交通场景下异源图像融合方法,s3中对源图像进行网格划分的具体步骤包括:

[0037]

s3.1:计算源图像的像素梯度权值,提取梯度权值变化较大的区域作为候选晕光区域,并用正方形边界框框出;

[0038]

s3.2:统计当前图像中晕光区域的边界框尺寸,采用kmeans算法进行聚类,得到当前图像中m种尺寸的边界框,其中m的取值根据交通场景与晕光区域数量确定;

[0039]

s3.3:采用多分辨分割策略将源图像划分为尺寸固定的晕光区域与背景区域。

[0040]

进一步的,本发明的交通场景下异源图像融合方法,s3.3中的多分辨分割策略的具体步骤包括:

[0041]

s3.3.1:已知晕光区域的聚类尺寸集lf{l,2l,22l,

…

,2ml},在w*h分辨率的源图像对中,采用ciou匹配某一晕光区域对应的晕光尺寸:

[0042]

[0043][0044][0045][0046]

其中,w为源图像水平方向上的像素数,h为源图像垂直方向上的像素数,a表示晕光区域外接框,b表示以a共中心点的聚类尺寸外接框,b、b

gt

分别为a、b的中心点,ρ为a、b中心点的欧氏距离,c为a、b的最小闭包区域的对角线距离;

[0047]

3.3.2:更新匹配后的图像内晕光区域外接框尺寸,记某一晕光区域外接框为lm为外接框尺寸,i为外接框在同尺寸数据集中的编号;

[0048]

3.3.3:遍历每个晕光区域外接框分割其所在网格行列的背景区域:

[0049][0050]

其中,dr代表晕光外接框的上、下、左、右方向,n

dr

代表对应方向背景区域被分割后的图像块数量,k∈{h,w}表示图像宽边与高边的边界线;

[0051]

3.3.4:计算边界填充比例r

padding

:

[0052][0053]

3.3.5:评估边界填充比例,若某一边界填充比例超出填充阈值,即r

padding

≥r

th

,则修改位置,返回3.3.2重新计算分割结果,直到r

padding

满足要求;

[0054]

3.3.6:合并背景图像块,使分割后总图像数量最少,输出最终分割结果。

[0055]

进一步的,本发明的交通场景下异源图像融合方法,s4中的晕光网络组包括生成器网络和判别器网络,其中,采用张量相加构造晕光网络组生成器网络,采用patchgan结构构造晕光网络组判别器网络,通过双边滤波权重设计晕光网络组损失函数;

[0056]

其中,双边滤波权重计算公式如下:

[0057][0058][0059][0060]

其中,p1表示可见光特征图权重,p2表示红外特征图权重,为像素权重系数,n为特征图中某一像素点,p1与p2为像素权重系数的平均,k∈{i,v}代参数源为红外或可见光,c为实常数,为双边滤波后的特征图。

[0061]

进一步的,本发明的交通场景下异源图像融合方法,生成器的损失函数如下:

[0062][0063]

其中,表示生成器对抗损失,由对抗网络中判别器给出,l

con

为内容损失,λ为调节两种损失重要性的权重系数;

[0064]

对抗损失取判别器对伪融合图像判别结果的交叉熵,即:

[0065][0066]

其中,dv(g(v,i))表示判别器dv对伪融合图像g(v,i)的判真概率,di(g(v,i))表示判别器di对伪融合图像g(v,i)的判真概率;

[0067]

内容损失l

con

定义如下:

[0068][0069][0070]

其中,为像素p点的ssim损失,表示为:

[0071][0072]

其中,表示预期图像方差,表示预期图像与伪融合图像协方差;

[0073]

判别器的损失函数如下:

[0074][0075][0076]

其中,p1、p2为反映源图像信息量的权重系数,p1代表可见光图像,p2代表红外图像,其由双边滤波权重函数计算得出。

[0077]

进一步的,本发明的交通场景下异源图像融合方法,s4中的背景网络组包括生成器网络和判别器网络,其中,采用7层u-net构造背景网络组生成器网络,采用patchgan结构构造背景网络组判别器网络,通过轮廓增强设计背景网络组损失函数。

[0078]

进一步的,本发明的交通场景下异源图像融合方法,背景网络组生成器损失函数如下:

[0079][0080]

其中,l

ssim

为结构损失,由结构相似性指标ssim计算得到,l

l1

为边缘损失,由l1范数计算得到,δ1、δ2为衡量目标网络中结构损失与边缘损失重要性的权重参数;

[0081]

结构损失l

ssim

计算方式如下:

[0082][0083]

其中,为像素p点的ssim损失,表示为:

[0084][0085]

其中表示预期图像方差,表示预期图像与伪融合图像协方差;

[0086]

边缘损失l

l1

计算方式如下:

[0087][0088][0089]

其中,权重参数w(ik)与ssim损失中的权重函数相同。

[0090]

本发明采用以上技术方案与现有技术相比,具有以下技术效果:

[0091]

1、本发明的交通场景下异源图像融合方法将双判别器生成式对抗网络应用于图像融合中以处理交通场景中晕光问题,改进了现有抗晕光算法数据采集困难、计算速度慢、应用范围窄的问题,本发明的算法实施方便,速度快,适用于各种包含晕光的交通场景,为监控数据采集、车辆抗晕光安全驾驶等交通场景应用提供了质量优秀的数据源。

[0092]

2、本发明的交通场景下异源图像融合方法在图像融合前使用多分辨上采样统一输入图像块的分辨率、在图像融合后使用多分辨下采样还原图像块至源图像大小,实现同一网络能够处理不同分辨率的图像输入,并通过自适应网络调整上采样与下采样中图像的细节关注区域,拓宽了图像融合流程的输入输出条件,为晕光区域与背景区域独立训练的实现提供了条件。

[0093]

3、本发明的交通场景下异源图像融合方法使用晕光网络组与背景网络组独立训练晕光区域图像块与背景区域图像块,在晕光网络组使用张量相加网络结构消除晕光影响,还原区域内目标细节,在背景网络组使用u-net结构融合异源图像块中结构轮廓信息,增加融合图像中的目标轮廓细节,提升融合图像观感,同时分区域独立训练的方式为图像融合抗晕光算法提供了新思路,并有效提升了融合图像抗晕光能力与全局融合效果。

附图说明

[0094]

图1为本发明的交通场景下异源图像融合方法的流程图;

[0095]

图2为本发明的交通场景下异源图像融合方法的晕光网络组生成器网络结构示意图;

[0096]

图3为本发明的交通场景下异源图像融合方法的背景网络组生成器网络结构示意图;

[0097]

图4为本发明的交通场景下异源图像融合方法的双判别器网络结构示意图;

[0098]

图5为本发明的交通场景下异源图像融合方法的实例一效果展示图;

[0099]

图6为本发明的交通场景下异源图像融合方法的实例二效果展示图。

具体实施方式

[0100]

为了进一步理解本发明,下面结合实施例对本发明优选实施方案进行描述,但是

应当理解,这些描述只是为进一步说明本发明的特征和优点,而不是对本发明权利要求的限制。

[0101]

该部分的描述只针对典型的实施例,本发明并不仅局限于实施例描述的范围。不同实施例的组合、不同实施例中的一些技术特征进行相互替换,相同或相近的现有技术手段与实施例中的一些技术特征进行相互替换也在本发明描述和保护的范围内。

[0102]

一种交通场景下异源图像融合方法的流程图,如图1所示,具体步骤如下:

[0103]

步骤1:获取异源图像数据,本实例采用flir数据集中的两组可见光图像与红外图像进行演示,该两组样例均为驾驶员视角,拍摄时间为夜间,两组样例均存在因前车车灯而导致的明显晕光现象,源图像与融合效果如图5与图6所示。

[0104]

步骤2:对异源图像实施配准操作,以红外图像为参考图像,设计基于surf(speeded up robust features)算子与背景鲁棒关联的配准算法完成可见光与红外源图像的配准,使源图像时空信息一致。具体步骤如下:

[0105]

2.1,对可见光图像进行中心对称缩放裁剪,在不改变可见光图像视野的前提下统一可见光与红外图像的像素信息;

[0106]

2.2,使用e-net(语义分割算法)对源图像进行语义分割,划分道路区域与背景区域,使用surf算子寻找背景区域中的特征角点;

[0107]

2.3,对于背景区域中的特征角点pi,首先使用下式判断pi是否处于密集角点簇中:

[0108][0109][0110]

其中||pi,pj||2为特征点pi与pj的欧式距离,dis

th

为判断角点密集程度的距离阈值,d

th

为比例阈值;

[0111]

若pi不处于密集角点簇中,则将其直接计入候选特征点集cd,若pi处于密集角点簇中,设角点簇中角点数量为n0,计算应保留的角点数量n:

[0112][0113]

即密集角点簇中最少保留1个角点,最多保留n-1个角点;

[0114]

确定角点数量n后,遍历角点簇中所有数量为n的角点组合,选取间距最大的组合作为需要保留的角点,并计入候选特征点集cd;

[0115]

2.4,对于候选特征点集cd,采用knn算法(k最近邻分类算法)关联可见光与红外源图像中的特征点对,将匹配点对间的连线表示为f(xn)=kmxn+b,其中m为一正交2*2矩阵,行列式为1,t为2*1变换向量,k为比例系数,最小化下式以寻找正确的匹配点对连线斜率:

[0116][0117]

其中λ》0,为协调比例系数,σ为候选特征点集的分布标准差,(xn,yn)为特征点n的图像坐标;

[0118]

将最优的连线方程f(xn)=kmxn+b记为f(xn)=kxn+b,其中k,b为直线方程的斜率

与常量常数,选取连线方程常数在如下范围内的点对作为参与配准的点对:

[0119]

k-3σk≤ki≤k+3σk[0120]

b-3σb≤bi≤b+3σb[0121]

2.5,获取参与配准的点对集,建立透视变换矩阵生成配准方案,生成配准后的可见光与红外源图像。

[0122]

步骤3:对源图像进行网格划分,采用像素梯度权值初筛图像场景中的晕光区域,采用kmeans算法聚类晕光区域的尺寸信息,设计多分辨分割策略将源图像切割为不同尺寸的晕光图像块与背景图像块。具体步骤如下:

[0123]

3.1,计算源图像像素梯度权值,提取梯度权值变化较大的区域作为候选晕光区域,区域用正方形边界框出;

[0124]

3.2,统计当前图像中晕光区域的边界框尺寸,采用kmeans算法进行聚类,得到当前图像中m种尺寸的边界框,m的取值视交通场景与晕光区域数量而定;

[0125]

3.3,设计一种多分辨分割策略,将源图像划分为尺寸固定的晕光区域与背景区域,具体步骤如下:

[0126]

3.3.1,已知晕光区域聚类尺寸集lf{l,2l,22l,

…

,2ml},在w*h分辨率源图像对中,采用ciou匹配某一晕光区域对应的晕光尺寸:

[0127][0128][0129][0130][0131]

a、b代表晕光区域外接框与以a共中心点的聚类尺寸外接框,b、b

gt

为a、b中心点,ρ为a、b中心点欧氏距离;

[0132]

3.3.2,更新匹配后的图像内晕光区域外接框尺寸,记某一晕光区域外接框为lm为外接框尺寸,i为外接框在同尺寸数据集中的编号;

[0133]

3.3.3,遍历每个晕光区域外接框分割其所在网格行列的背景区域:

[0134][0135]

其中dr代表晕光外接框的上、下、左、右方向,n

dr

代表对应方向背景区域被分割后的图像块数量,k∈{h,w}表示图像宽边与高边的边界线;

[0136]

3.3.4,计算边界填充比例:

[0137][0138]

3.3.5,评估边界填充比例,若某一边界填充比例超出填充阈值,即r

padding

≥r

th

,则

步进修改位置,返回3.3.2重新计算分割结果,直到r

padding

满足要求为止;

[0139]

3.3.6,合并背景图像块,使分割后总图像数量最少,输出最终分割结果。

[0140]

步骤4:实施异源图像融合,首先对两种图像块进行多分辨上采样,统一晕光图像块与背景图像块的尺寸,接下来设计基于张量相加与双边滤波的晕光网络组,融合可见光与红外晕光图像块,提升融合图像抗晕光能力,同时设计基于u-net(u型网络)与轮廓增强的背景网络组,融合可见光与红外背景图像块,提升融合图像整体观感与纹理质量,最后对图像块进行多分辨下采样,还原图像块在源图像中的尺寸。

[0141]

其中,晕光网络组有如下特征:

[0142]

1)晕光网络组生成器采用张量相加的网络结构生成融合图片。生成器网络结构示意如图2所示,网络结构参数表如表1所示。具体而言,对于输入的可见光与红外训练样本,该网络首先通过两层卷积层(conv1、conv21与conv2、conv22)分别提取样本的边缘、角点等低层特征与语义等高层特征,之后将提出的双源样本特征图f21与f22加权相加得到融合特征图f3,其中权重p1与p2通过双边滤波权重计算得到,最后通过三层卷积(conv3、conv4、conv5)从f3中重构出融合图像。

[0143]

表1晕光网络组生成器网络结构参数表

[0144][0145]

2)晕光网络组生成器中特征融合之前的双源卷积层权重完全相同,即“绑定的”。conv1与conv2的权重参数完全相同,每次训练结束调整权重参数时,conv1与conv2的权重参数改变也相同,conv21与conv22同理。这样设计的好处在于:网络能够从双源样本中学习到完全相同的特征,使融合时的加权相加操作具备理论条件;由于特征的可加性,网络倾向于学习具有不变性的特征,在本网络中,即对光线不敏感的特征,从而使网络能够处理过曝光与欠曝光的情况,生成细节丰富,抗不良光照条件的融合图片;绑定权重使网络中的参数数量减少,可以显著提升网络的收敛速度。

[0146]

3)晕光网络组采用双边滤波器计算双源特征图权重:

[0147][0148][0149][0150]

其中p1表示可见光特征图权重,p2表示红外特征图权重,为像素权重系数,n为

特征图中某一像素点,特征图权重p1与p2为像素权重系数的平均,k∈{i,v}代参数源为红外或可见光,c为实常数,经实验在本文中取70效果最好,为双边滤波后的特征图,可以下公式计算得到:

[0151][0152][0153][0154]

其中i

bf

(x,y)为双边滤波后图像,(x

′

,y

′

)为像素点(x,y)的邻域像素,与分别为几何空间与像素强度上的高斯核。

[0155]

4)晕光网络组生成器损失函数表示如下:

[0156][0157]

表示生成器对抗损失,由对抗网络中判别器给出,l

con

为内容损失,λ为调节两种损失重要性的权重系数。

[0158]

对抗损失本文对抗损失取判别器对伪融合图像判别结果的交叉熵,即:

[0159][0160]

其中,dv(g(v,i))表示判别器dv对伪融合图像g(v,i)的判真概率,di(g(v,i))表示判别器di对伪融合图像g(v,i)的判真概率。

[0161]

内容损失定义如下:

[0162][0163][0164]

其中,为像素p点的ssim损失,可以表示为:

[0165][0166]

其中表示预期图像方差,表示预期图像与伪融合图像协方差;

[0167]

5)晕光网络组判别器损失函数如下:

[0168][0169][0170]

其中p1、p2为反映源图像信息量的权重系数,p1代表可见光图像,p2代表红外图像,其由双边滤波权重函数计算得出。

[0171]

其中,背景网络组有如下特征:

[0172]

1)背景网络组生成器中采用u型网络(u-net)进行伪融合图像生成,网络结构示意如图3所示,网络参数表如表2所示。与标准u-net相比,本文生成器改进了网络深度,用于生成融合图片,需要更加精细的表达能力,将网络深度增加至7层;变更采样方式,直接使用步长为2的卷积层降低特征图分辨率,并设卷积核为4*4,padding为1,保证特征图及输入输出图像尺寸一致,避免了裁剪、镜像等额外操作带来的信息损失;变更激活函数为leaky-relu,一定程度上缓解训练后期部分神经元处于静默状态的问题。

[0173]

表2背景网络组生成器网络结构参数表

[0174][0175][0176]

2)背景网络组采用patchgan结构设计判别器网络,判别器网络结构如图4所示,网络参数表如表3所示。对于单通道输入图像,网络首先使用三层步长为2的卷积层进行下采样,获取降维后的特征图;之后对特征图边缘进行尺寸为2的零值填充(padding),增加特征图边缘关注度,并适配网络特征图尺寸;接下来使用步长为1的卷积层精确提取特征,并通过batchnorm(bn)+leakyrelu的处理归一化特征值,提高网络计算速度与收敛性;最后,再次填充特征图后,用卷积核数量为1的卷积层合并特征图维度,并通过tanh激活函数直接输出n*n的得分矩阵,对判别器网络获得的得分矩阵取平均以得到判别器最终的判真概率。

[0177]

表3双判别器网络结构参数表

[0178][0179]

3)背景网络组生成器损失函数表示如下:

[0180][0181]

其中l

ssim

为由结构相似性指标ssim计算得到的结构损失,l

l1

为由l1范数计算得到的边缘损失,δ1、δ2为衡量目标网络中结构损失与边缘损失重要性的权重参数;

[0182]

l

ssim

的计算方式与晕光网络组中相同,l

l1

计算方式如下:

[0183][0184][0185]

其中权重参数w(ik)与ssim损失中的权重函数相同。

[0186]

步骤5:复原图像,还原图像块至源图像所在位置,输出具有抗晕光能力的融合图像。

[0187]

这里本发明的描述和应用是说明性的,并非想将本发明的范围限制在上述实施例中。说明书中所涉及的效果或优点等相关描述可因具体条件参数的不确定或其它因素影响而可能在实际实验例中不能体现,效果或优点等相关描述不用于对发明范围进行限制。这里所披露的实施例的变形和改变是可能的,对于那些本领域的普通技术人员来说实施例的替换和等效的各种部件是公知的。本领域技术人员应该清楚的是,在不脱离本发明的精神或本质特征的情况下,本发明可以以其它形式、结构、布置、比例,以及用其它组件、材料和部件来实现。在不脱离本发明范围和精神的情况下,可以对这里所披露的实施例进行其它变形和改变。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1