一种基于数据压缩变换的矿区边坡预测方法与流程

1.本发明涉及露天矿边坡监测领域,具体为一种基于数据压缩变换的矿区边坡预测方法。

背景技术:

2.依据国家统计局的数据,我国近五年的滑坡灾害,约占地质灾害的50%以上,因此滑坡是我国主要的地质灾害,每年造成的大量人员伤亡和难以统计的财产损失。而边坡累积位移预测是滑坡灾害的预测的关键部分,因此如果能够露天矿边坡监测运用到生产实践中,将极大的提高滑坡灾害的预测能力。

3.现阶段的边坡累积位移预测模型分为四种,分别是确定性模型、统计模型、非线性模型和组合模型。近几年来,随着研究的深入,单一模型已经不能满足实际生产的需要,越来越多的学者,通过深度学习与其它学科相结合,来获取滑坡累积位移预测值。同时现有的滑坡位移预测模型往往需要很多的观测数据和考虑很多的滑坡影响因子,例如:像地质的岩层,断层,节理,高程,坡度,降水量,归一化植被指数,滑坡的水平累积位移等。上述的这些数据有时往往在生产实践中很难获取,从而导致预测模型构建的困难。

4.因此本文选取了在实际生产中最易获得的数据,利用滑坡的水平累积位移作为基础来构建模型,提出一种wht-vmd-lstm组合模型来降低上述各种模型对数据种类和数量的要求,选取了在实际生产中最易获得的数据,利用滑坡的水平累积位移作为基础来构建wht-vmd-lstm组合模型。

技术实现要素:

5.本发明目的是为了提供一种在数据量较少时,滑坡累积位移预测的方法和提高预测精度。

6.为实现上述目的,本发明提供了一种基于数据压缩变换的矿区边坡预测方法,包括以下步骤:

7.建立wht-vmd-lstm新模型,对滑坡进行定期监测获取原始位移观测数据;

8.根据vmd分解后的平均残差,确定出分解层数;

9.根据vmd分解的原理确定出其带宽设置、对噪声的容忍程度、第一个模态是不是直流分量、中心频率和收敛精度5个参数;

10.根据确定出vmd分解的参数,然后进行原始观测数据的分解;

11.对分解后的数据画出趋势图,分析其波动的频率;

12.通过观察数据趋势图单调性改变的次数,如果大于改变次数大于10则波动较大,该组需要进行沃尔什—阿达玛变换压缩的分组;

13.根据分组后的数据分别利用长短时记忆神经网络进行预测;

14.将其中经过沃尔什—阿达玛变换压缩的预测值进行反变换,最后将各组的预测值相加,得出滑坡累积位移预测值。

15.本发明的核心在于利用信号分解与重构和图像压缩的思想,对原始累积滑坡位移观测数据进行处理,使其能够更好的利用长短时记忆神经网络进行预测滑坡累积位移值,解决了长短时记忆神经网络在预测时需要大量训练值的问题,有利于当观测数据不足时,进行滑坡累加位移的预测。

附图说明

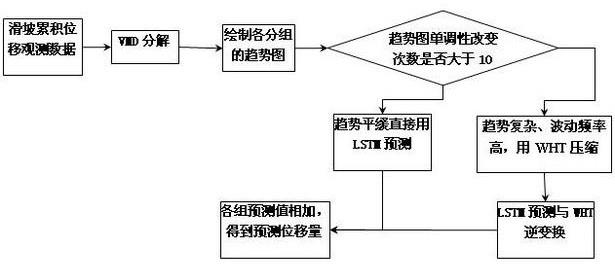

16.图1是本发明的预测滑坡累积位移流程图;

17.图2是本发明的长短时记忆神经网络的结构图;

18.图3是经过vmd分解后的各分量的第一组趋势图;

19.图4是经过vmd分解后的各分量的第二组趋势图;

20.图5是经过vmd分解后的各分量的第三组趋势图;

21.图6是经过vmd分解后的各分量的第四组趋势图;

22.图7是经过vmd分解后的各分量的第五组趋势图;

23.图8是经过vmd分解后的各分量的第六组趋势图;

24.图9是经过沃尔什—阿达玛变换的第三组与原始个分量的趋势比较图;

25.图10是经过沃尔什—阿达玛变换的第四组与原始个分量的趋势比较图;

26.图11是经过沃尔什—阿达玛变换的第五组与原始个分量的趋势比较图;

27.图12是经过沃尔什—阿达玛变换的第六组与原始个分量的趋势比较图。

具体实施方式

28.下面详细通过实例介绍一下本发明的实现过程,通过实例介绍本发明是为了有助于理解本发明,而不是局限于该实例。

29.本发明的实验原始数据来源于实地的观测数据。

30.本发明的实验流程请参考图一,具体有以下步骤:

31.建立wht-vmd-lstm新模型,对滑坡进行定期监测获取原始位移观测数据;

32.通过多次vmd分解结果累加值与原始数据进行平均残差与最大残差的比较,从表2的结果来看当分解层数为6时其平均残差值最小,且其最大残差也在1mm内,因此本实验取vmd的分解层数为6。

33.最终将vmd分解的参数设为:alpha带宽设置为104,tau对噪声的容忍程度为0,k需要分解的层数为6,dc第一个模态是不是直流分量设为0,init设为0,即每个分量的中心频率为0,tol收敛的精度为设为1e-10。

34.输入vmd的参数带入到vmd处理代码中即可得出分解后的六个分量如图3所示,其vmd的基本原理公式如下所示:

[0035][0036][0037]

[0038]

其中:k为模态分解个数、{uk}为第k个模态分量、{wk}为模态分量的中心频率、f(t)为狄拉克函数、*为卷积运算、r为拉格朗日乘法算子、a为二次惩罚因子以保证信号重构的精度、h(t)用来保持约束条件的严格性。

[0039]

表1原始累计位移数据

[0040][0041]

表2 vmd分解结果

[0042]

vmd分解层数三层四层五层六层平均残差值0.0170680.0167890.0000790.000077最大残差值2.1794811.2700001.2605320.641517。

[0043]

观察图3-图8中的六组分量趋势图,其经过vmd分解后使其每个分组具有其独特的意义,第一二组是趋势分量,第三四组是周期分量,第五六组是随机分量。除了第一二组分量外,其余组的分量波动频率都高,趋势复杂,不利于后期长短时记忆神经网络的学习,因此需要对第三-六组的分量使用图像压缩的一种方法沃尔什—阿达玛变换压缩变量,使其波动频率减少,有利于后期长短时记忆神经网络的学习。

[0044]

利用沃尔什—阿达玛变换压缩后的各组分量的图像如图9-图12所示,从图中明显的可以看出经过压缩后的图像其数据变小了,趋势变缓了,比原来的数据更有利于长短时记忆神经网络的预测,其主要利用的公式为:

[0045][0046]

其中wal(n,i)是矩阵变换核。

[0047]

然后将各组分量分别进行预测,将第一,二组的分量数据的前90%为训练集,后10%为测试集,由于沃尔什—阿达玛变换的特性,对变换数据的个数有要求,只能对2的幂次个数据进行沃尔什—阿达玛变换,否则会自动添零,因此只取需要变换的各组分量的后32组数据进行变换,然后取其中的83%为训练数据,剩余17%为测试集,训练集与测试集的大小选取根据实际的需要选取,保持每组的测试集个数一致即可,具体的长短时记忆神经网络流程如图2所示。长短时记忆神经网络主要部分为遗忘门、输入门、tanh层、输出门。

[0048]

本发明的预测模型的主体就是长短时记忆神经网络,简单的来说,就是通过遗忘门遗忘上一单元没用的信息,输入门保留当前单元的有用信息,tanh层是输入门与遗忘门工作的结果,然后通过处理器从输入门输出结果。依据设定的训练精度来进行反复的学习,最终利用训练完成后的网络进行预测。其主要运用的公式为:

[0049]ft

=σ[wf(h

t-1

,x

t

)+bf]

[0050]it

=σ[wi(h

t-1

,x

t

)+bi]

[0051][0052][0053]ht

=σ[w0(h

t-1

,x

t

)+b0]tanhc

t

[0054]

其中其中f

t

是遗忘门、σ是sigmoid函数、wf是遗忘门权重矩阵、h

t-1

是上一时刻的输出值、x

t

是当前输入值、bf是遗忘门偏置项、i

t

是输入门、wi是输入门的权重矩阵、bi是输入门的偏置项、是输入单元状态、tanh是输出激活函数、wc是单元状态权重矩阵、bc是单元状态偏置项、c

t

是新的单元状态、c

t-1

是长期记忆。w0是输出门权重矩阵,b0是输出门偏置项。

[0055]

本发明用的长短时记忆神经网络的迭代250次,学习率调度为分段,学习率为0.001。将三-六组的预测值进行沃尔什—阿达玛反变换得到真实的预测值。最后将各组的预测值累加得到最终滑坡位移累积位移预测值,用均方误差和决定系数判断预测的精度和模型的拟合度并与单独用长短时记忆神经网络lstm和只用变分模态分解vmd与长短时记忆神经网络的模型进行比较,分析发现进行沃尔什—阿达玛变换是必要的,可以极大的提高预测的精度和模型的拟合度,最终的结果如表3所示。

[0056]

表3模型精度对比结果

[0057][0058]

本发明在前人的基础上,发现变分模态分解与长短时记忆神经网络预测滑坡累积水平位移值时因数据量较少而产生的较大的误差,同时利用深度学习是强调从数据中连续的层中进行学习的原理,提出了一种利用图像压缩的新思想,通过沃尔什—阿达玛变换进行数据的压缩,从而提高预测的精度。

[0059]

本技术提供的实例之间的相似部分相互参见即可,以上提供的具体实施方式只是本技术总的构思下的一个示例,并不构成本技术保护范围的限定;对于本领域的技术人员而言,在不付出创造性劳动的前提下依据本技术方案所扩展出的任何其他实施方式都属于本技术的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1