一种智能交互式媒体展示方法及系统

1.本发明涉及一种基于人脸识别和动作识别的智能交互式媒体展示方法和系统,属于智能识别与多媒体展示领域。

背景技术:

2.建筑物外媒体墙,作为一种新兴建筑形式和媒体展示方式,越来越受到人们的喜爱。新媒体技术与实体建筑的结合使其不仅是一座建筑,还是一个可用来欣赏和倾听的多媒体。最近几年,人工智能技术得到了前所未有的发展,那么如何将人工智能技术融入建筑外媒体墙,使其具有智能化与交互性,具有深刻的意义。

3.另外,随着人们物质和精神生活水平的提高,主题乐园和户外游玩活动越来越多。在享受了游玩的乐趣之后,人们往往希望把途中的精彩瞬间记录下来,以做纪念、发朋友圈和回忆。但是在主题乐园或户外游玩漂流、激流勇进、矿山车、海盗船、太空飞梭漂流、过山车、缆车索道等项目途中,游玩者自身无法使用照相设备进行拍摄。所以现在的娱乐场所需要提供一项服务,即在不同景点都会有摄像师或摄像头对游玩的游客进行抓拍与监控,把他们在游玩过程中的各种状态记录下来汇总到电脑,游客游玩之后,可以在景点电脑上去选取自己所需的照片。这是一个很好的提议和商机,但是实现起来比较困难。因为被摄对象的不固定以及照片数量的巨大,导致人工选取照片的难度很大,效率也很低。所以需要一个对海量照片进行智能分选、显示和打印的软件系统去取代人工选取、显示和打印以提高效率和节省人力。

4.如果能结合人工智能与建筑外媒体墙技术,对游客的游玩的照片进行智能播放展示和自助打印。那么,不但能起到宣传推广的作用,还能降低人力成本提高用户体验感。因此,本发明将提出一种基于人脸识别的智能交互式媒体展示方法及系统。

技术实现要素:

5.本发明利用人工智能、建筑外墙展示和人脸分析识别技术,提出一种智能交互式媒体展示方法,包括如下步骤:

6.步骤1,离线构建游客图片库,采集游客照片,将对应的标准人脸图像作为每个游客的身份标签,并以此建立每个游客的图像文件夹,并对游客图片进行性别和年龄分类存储;

7.步骤2,利用安装在媒体墙上的摄像头抓拍站在建筑媒体墙前的人脸,并利用人脸检测技术抓取出合格的人脸图像,然后,利用人脸分析技术对提取的合格人脸图像进行属性分析,判断建筑媒体墙前的人脸性别、年龄和身份属性;

8.步骤3,结合构建的游客图片库,根据人脸检测和分析的结果进行媒体墙智能展示,并赋予每个展示的图片一个方便记忆的编号;

9.步骤4,利用手势识别技术让用户与媒体墙进行无接触交互,包括暂停、开始、前翻、后翻、删除。

10.进一步的,步骤1的具体实现方式如下:

11.步骤11,在主题乐园或游乐场所入口处安装摄像头,利用人脸检测模型采集一张标准正面的人脸图像作为每个游客的身份标签,并以此建立每个游客的图像文件夹;

12.步骤12,利用摄影师和场馆内的监控摄像头采集每个游客的游玩图片图像;

13.步骤13,对采集的海量游玩图片,按步骤11建立的身份标签分门别类存入相应的文件夹,建立游客游玩图像库,另外,对采集的海量游玩图片进行人脸的性别、年龄识别,然后按性别和年龄分类存储。

14.进一步的,步骤11中人脸检测模型的具体实现方式如下:

15.所述的人脸检测模型通过采用轻量化检测模型实现,其网络结构包括主干网络backbone、多尺度网络fpn和检测头head三大部分,首先对输入的视频图像利用主干网络进行特征提取,然后利用多尺度网络对主干网络提取的特征进行多尺度融合,最后对融合特征利用检测头进行人脸检测与定位;其中,主干网络采用mobilenetv3作为backbone,多尺度网络采用top-down结构,检测头采用4个conv+bn结构,分别输出位置中心点置信度location,检测框长宽scale,偏移offset和人脸关键点points;

16.人脸检测模型损失函数和centernet一样,由focalloss形式location分类损失和l1回归损失构成,其中,location分类损失函数为:

[0017][0018]

式中y

xyc

为真实的中心点类别,非1即0值,为预测的置信度,α,β为常数;

[0019]

scale损失函数为:

[0020][0021]

其中,sk为真实的目标框长宽尺度,为预测的目标框长宽尺度,n为训练样本数量;

[0022]

offset损失函数为:

[0023][0024]

其中,(xk,yk)为中心点坐标,smoothl1(

·

)表示平滑l1回归;

[0025]

points损失函数为:

[0026][0027]

其中,为关键点到中心点之间的距离差,为预测的关键点到中心点之间的距离差;(c

x

,cy)为中心点坐标,(p

x

,py)为人脸关键点坐标,(boxw,

boxh)为人脸检测框的长宽;最终损失函数为:

[0028]

l=l

location

+λ1l

scale

+λ2l

offset

+λ3l

points

。

[0029]

进一步的,步骤13中采用多任务神经网络mdcnn的方法进行人脸性别和年龄同时识别,其网络模型设计如下:

[0030]

假设使用n个训练样本去学习t=2个任务,用表示第t∈{1,

…

,t}个任务中第i∈{1,

…

,n}个样本和其对应的任务标签,则mdcnn学习的目标为:

[0031][0032]

其中,f(xi,θ)表示深度网络函数,θ为需要求解的网络参数,l

t

(

·

)表示不同任务的损失函数,φ(θ)为正则惩罚项;

[0033]

对于性别识别问题,由于其是二分类问题,因此,其损失函数直接采用softmax loss:lg=-(1-g)

·

log(1-p0)-g

·

log(p1),其中g=0或1表示为男或女,(p0,p1)代表各自性别的概率;

[0034]

对于人脸年龄识别问题,由于是多分类问题,因此损失函数center loss:

[0035][0036]

其中,xk表示一个mini_bach中第k个样本的深度学习特征,yk表示它对应的类别;c

yk

表示yk类的深度学习特征中心,w,b分别表示最后全连接层中的权值与偏置参数;m,n分别表示mini-batch和类别的大小,λ为平衡因子;

[0037]

因此,最终的多任务联合损失函数为:

[0038]

loss

full

=β1lg+β2la[0039]

其中,β1和β2为平衡因子。

[0040]

进一步的,步骤2的具体实现方式如下:

[0041]

人脸分析技术采用基于终身学习的多任务学习网络实现,为了进行知识迁移和避免灾难性遗忘,对每个任务,在训练完成该任务之后,计算网络中每个参数对于该任务的重要性ω

ij

,即第i行第j列的参数值占整个参数值的比例大小,并沿用到训练后续的任务中去,ω

ij

以正则项的形式添加到损失函数中去,每当进行新任务训练时:对于ω

ij

较大的参数,在梯度下降中尽量减少它的改变幅度,因为该参数对过去的某任务很重要,需要保留它的值来避免灾难性遗忘;而对于ω

ij

较小的参数,可以以较大的幅度对其进行梯度更新,以得到在新任务上较好的性能,因此,第n个任务的损失函数为:

[0042][0043]

其中,ln(θ)是当前任务的损失函数,λ是平衡因子,θ

ij

是当前的模型参数矩阵中第i行第j列的参数,是由前n-1个任务训练后得到的模型参数,每当训练完一个任务之后,ω

ij

都会进行更新,其中,n=3,3个任务训练的顺序是性别识别、年龄识别、身份识别,进行第一个任务时,取0;

[0044]

其中,多任务网络的主干网络采用restnet或efficientnet。

[0045]

进一步的,步骤3的具体实现方式如下:

[0046]

31)根据人脸检测技术,如果发现媒体墙前没有游客,媒体墙随机播放游客游玩图像,或播放宣传片或停止播放节约用电;

[0047]

32)如果媒体墙前有人脸,但为新游客,则根据其人脸性别和年龄智能播放与新游客性别和年龄相仿的游玩图片;

[0048]

33)如果媒体墙前有人脸且为游客库中的人脸,则根据其人脸身份标签智能播放此游客游玩图片。

[0049]

进一步的,步骤4的具体实现方式如下:

[0050]

采用深度协同字典学习的手势识别方法实现无接触交互,具体实现过程为:

[0051]

对输入的待识别手势图像进行特征提取,利用mobilenetv3构建轻量级特征提取网络,提出特征向量m为特征向量维数;

[0052]

对所述特征向量y使用手势完备字典d进行线性组合表示,建立深度稀疏表示模型并求解系数向量:

[0053][0054]

其中,w为需求解的稀疏表示系数,是w近似值,γ为常量平衡因子,||

·

||

1/2

表示1/2范数;

[0055]

根据上式求解的线性组合的系数向量进行手势分类识别,所述手势有5个类别,分别定义为暂停、开始、前翻、后翻、删除;

[0056]

进一步地,对所述特征向量y使用手势完备字典进行线性组合表示之前,还包括所述手势完备字典的训练步骤,为了提高模型的准确率和鲁棒性,提出深度协同学习的字典训练方法:

[0057]

根据深度学习的思想对手势训练样本x进行多层次深度分解学习得到手势子字典dc:

[0058][0059]

其中,d={d1,

…

,dc,

…

,d5},x为手势训练样本矩阵;为第c类手势中不同层的字典,为对应的系数矩阵;ds,ws分别为共享字典及其对应的系数矩阵,即待求解的参数;根据非负矩阵分解原理有:

[0060][0061]

上式可以解释为对包括有暂停、开始、前翻、后翻、删除手势信息的训练样本x进行多层次分解,找到其新的表示方式ws和新表示空间

[0062]

为了增加字典的非线性表示能力,根据深度神经网络的方法对系数矩阵进行修改:

[0063]

[0064]

其中,i表示第i层,范围[1~m],g(

·

)为非线性激活函数,因此,深度协同字典学习模型的目标为:

[0065][0066]

进一步的,深度协同字典学习模型的求解采用类似于栈式自编码网络一样的训练方法,分成逐层预训练、整体微调两个阶段:

[0067]

(1)逐层预训练阶段

[0068]

a、令求解最小化问题:完成第一层分解;

[0069]

b、对w

1c

继续分解完成第二层分解;

[0070]

如此循环下去,把所有的层都进行了预训练,通过逐层贪婪分解的方法,每一层的训练变成传统的字典学习问题,根据实际需要可以在每一层的字典学习中加入稀疏约束或监督学习;

[0071]

(2)整体微调阶段

[0072]

通过最小化损失函数和随机梯度下降法来实现。

[0073]

进一步的,还包括步骤5,自助打印,如果游客在媒体墙上看到了自己感兴趣的图片,并想打印留念,则进行如下步骤:

[0074]

51)记下自己感兴趣的图片编号;

[0075]

52)在自助打印机前输入图片编号;

[0076]

53)选择付费方式,包括网上支付、微信支付、支付宝支付、银行转账或现金支付;

[0077]

54)选择打印方式,包括现场打印、u盘下载、转发邮箱;

[0078]

55)完成确认。

[0079]

本发明还提供一种智能交互式媒体展示墙系统,包括如下模块:

[0080]

图片整理分类模块,用于离线构建游客图片库,采集游客照片,将对应的标准人脸图像作为每个游客的身份标签,并以此建立每个游客的图像文件夹,并对游客图片进行性别和年龄分类存储;

[0081]

人脸分析识别模块,用于利用安装在媒体墙上的摄像头抓拍站在建筑媒体墙前的人脸,并利用人脸检测技术抓取出合格的人脸图像,然后,利用人脸分析技术对提取的合格人脸图像进行属性分析,判断建筑媒体墙前的人脸性别、年龄和身份属性;

[0082]

媒体墙智慧展示模块,用于结合构建的游客图片库,将人脸检测和分析的结果进行媒体墙智能展示,并赋予每个展示的图片一个方便记忆的编号;

[0083]

智能交互模块,用于利用手势识别技术让用户与媒体墙进行无接触交互,包括暂停、开始、前翻、后翻、删除。

[0084]

本发明相对于现有技术具有如下的优点及效果:

[0085]

1)别出心裁的媒体展示墙:本发明创新性的将人脸识别、手势识别技术应用于建筑墙面,智能化的展示媒体墙内容,并提供无接触式交互方式,使用户不但具有存在感、惊讶感,还具有互动感和友好感。

[0086]

2)提出了一种新的人脸分析方法:本发明为了解决人脸分析模型部署中模型过多

过大和计算时间长等问题,提出基于终身学习方法利用一个模型同时进行人脸性别、年龄和身份识别,以提高模型效率和运行时间。

[0087]

3)提出了一种新的手势识别方法:本发明为了提高手势识别的准确率,提出了一种基于深度协同字典学习的手势识别方法。

附图说明

[0088]

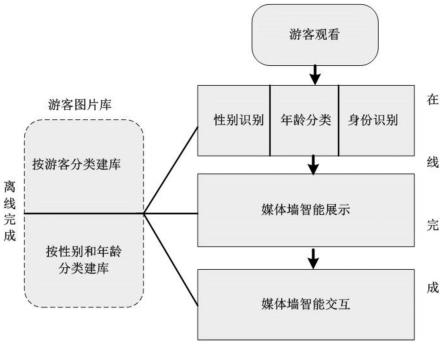

图1为一种智能交互媒体展示方法的流程图。

[0089]

图2为人脸检测模型的网络结构图。

具体实施方式

[0090]

为使本发明的目的、技术方案及优点更加清楚、明确,以下参照附图并举实施例对本发明进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

[0091]

本发明公开的一种智能交互式媒体展示方法的流程步骤如图1所示,主要包括五大步骤:

[0092]

步骤1,离线构建游客图片库,采集游客照片,将对应的标准人脸图像作为每个游客的身份标签,并以此建立每个游客的图像文件夹,并对游客图片进行性别和年龄分类存储;

[0093]

此步骤可以离线在后台进行,主要是采集与整理游客人脸图片。首先,在主题乐园或游乐场所入口处安装摄像头,对进入的游客利用人脸检测技术采集一张标准(正面,表情中性,光照良好)的人脸图像作为每个游客的身份标签,并以此建立每个游客的图像文件夹。

[0094]

然后,利用摄影师和场馆内的监控摄像头采集每个游客的游玩图片图像。

[0095]

最后,对采集的海量游玩图片,按第一步建立的身份标签分门别类存入相应的文件夹,建立游客游玩图像库。另外,对采集的海量游玩图片按图片中人脸的性别、年龄段进行性别和年龄分类存储。

[0096]

优选的,对采集的海量游玩图片可以进行过滤,挑选出分辨率高、视角好、有吸引力和有宣传力的包含人脸的图片进行存储。

[0097]

优选的,为了提高构建游客游玩图像库的速度,先对采集的海量游玩图片利用图像聚类和人脸属性分析技术进行图片聚类,在聚类的基础上再人工进行筛选和分门别类建库。

[0098]

其中,所述的人脸检测技术的特征在于采用轻量化检测模型便于终端部署,其网络结构如图2所示,主要包括主干网络backbone、多尺度网络fpn和检测头head三大部分;对输入的视频图像首先利用主干网络进行特征提取,然后利用多尺度网络对主干网络提取的特征进行多尺度融合,最后对融合特征利用检测头进行人脸检测与定位。其中,主干网络采用mobilenetv3作为backbone;多尺度网络采用top-down结构,没有使用pan;检测头采用4个conv+bn结构,分别输出位置中心点置信度location,检测框长宽scale,偏移offset和人脸关键点points。人脸检测模型损失函数和centernet一样,由focalloss形式location分类损失和l1回归损失构成。其中,location分类损失函数为:

[0099][0100]

式中y

xyc

为真实的中心点类别,非1即0值,为预测的置信度,α,β为常数;

[0101]

scale损失函数为:

[0102][0103]

其中,sk为真实的目标框长宽尺度,为预测的目标框长宽尺度,n为训练样本数量;

[0104]

offset损失函数为:

[0105][0106]

其中,(xk,yk)为中心点坐标,smoothl1(

·

)表示平滑l1回归;

[0107]

points损失函数为:

[0108][0109]

其中,为关键点到中心点之间的距离差,为预测的关键点到中心点之间的距离差;(c

x

,cy)为中心点坐标,(p

x

,py)为人脸关键点坐标,(boxw,boxh)为人脸检测框的长宽;最终损失函数为:

[0110]

l=l

location

+λ1l

scale

+λ2l

offset

+λ3l

points

。

[0111]

其中,本发明采用多任务神经网络(mdcnn)的方法进行人脸性别和年龄同时识别,其网络模型设计如下:

[0112]

假设使用n个训练样本去学习t=2个任务,用表示第t∈{1,

…

,t}个任务中第i∈{1,

…

,n}个样本和其对应的任务标签,则mdcnn学习的目标为:

[0113][0114]

其中,f(xi,θ)表示深度网络函数,θ为需要求解的网络参数,l

t

(

·

)表示不同任务的损失函数,φ(θ)为正则惩罚项;

[0115]

对于性别识别问题,由于其是二分类问题,因此,其损失函数直接采用softmax loss:lg=-(1-g)

·

log(1-p0)-g

·

log(p1),其中g=0或1表示为男或女,(p0,p1)代表各自性别的概率;

[0116]

对于人脸年龄识别问题,由于是多分类问题,因此损失函数center loss:

[0117][0118]

其中,xk表示一个mini_bach中第k个样本的深度学习特征,yk表示它对应的类别;c

yk

表示yk类的深度学习特征中心,w,b分别表示最后全连接层中的权值与偏置参数;m,n分别表示mini-batch和类别的大小,λ为平衡因子;上式中第一项是传统的softmax loss函数,第二项是center loss函数。通过引进center loss函数使提取的特征具有内聚性,且在训练样本有限的情况下依然有不错的性能。

[0119]

因此,最终的多任务联合损失函数为:

[0120]

loss

full

=β1lg+β2la[0121]

其中,β1和β2为平衡因子。

[0122]

由于不同的模态识别任务难易程度不一样,因此,用βk表示不同损失函数的权值分配;另外,由于不同模态识别任务复杂度不一样,导致网络收敛的速度也不一样。为了避免多任务学习带来的过拟合或是局部最小值问题,本发明将研究任务驱动早停止策略进行深度网络的训练优化。

[0123]

步骤2,利用安装在媒体墙上的摄像头抓拍站在建筑媒体墙前的人脸,并利用人脸检测技术抓取出合格的人脸图像,然后,利用人脸分析技术对提取的合格人脸图像进行属性分析,判断建筑媒体墙前的人脸性别、年龄和身份属性;

[0124]

此步骤现场在线完成,主要是对多媒体建筑墙的用户进行检测和分析,用于后续的智能展示。

[0125]

利用安装在媒体墙上的摄像头抓拍站在建筑媒体墙前的人脸,并利用人脸检测技术抓取出合格的人脸图像。然后,利用人脸分析技术对提取的合格人脸图像进行属性分析,判断建筑媒体墙前的人脸性别、年龄和身份属性。

[0126]

其中,所述的人脸分析技术为基于终身学习的人脸分析技术,具体如下:

[0127]

将人脸性别、年龄和身份识别三个任务放在一个模型中在进行多任务深度学习,本发明基于终身学习利用同一网络对各任务进行持续性训练学习,得到多任务学习网络。此网络利用终身学习策略学习各任务,在学习新任务时尽量不遗忘旧任务,并且将旧任务知识迁移到新任务上以提高新任务的性能,它是一种前向知识迁移策略,即怎样利用旧任务知识来提高新任务学习。

[0128]

人脸分析技术采用基于终身学习的多任务学习网络实现,为了进行知识迁移和避免灾难性遗忘,对每个任务,在训练完成该任务之后,计算网络中每个参数对于该任务的重要性ω

ij

,即第i行第j列的参数值占整个参数值的比例大小,并沿用到训练后续的任务中去,ω

ij

以正则项的形式添加到损失函数中去,每当进行新任务训练时:对于ω

ij

较大的参数,在梯度下降中尽量减少它的改变幅度,因为该参数对过去的某任务很重要,需要保留它的值来避免灾难性遗忘;而对于ω

ij

较小的参数,可以以较大的幅度对其进行梯度更新,以得到在新任务上较好的性能,因此,第n个任务的损失函数为:

[0129][0130]

其中,ln(θ)是当前任务的损失函数,λ是平衡因子,θ

ij

是当前的模型参数矩阵中第

i行第j列的参数,是由前n-1个任务训练后得到的模型参数,每当训练完一个任务之后,ω

ij

都会进行更新,其中,n=3,3个任务训练的顺序是性别识别、年龄识别、身份识别,进行第一个任务时,取0;

[0131]

多任务网络的主干网络可以采用restnet或efficientnet,利用终身学习模型进行人脸属性多任务学习时,不同属性任务的学习次序对初级网络最终性能有很大影响,本发明将采用交叉验证的策略找出各任务难易度及学习排序问题。

[0132]

步骤3,结合构建的游客图片库,根据人脸检测和分析的结果进行媒体墙智能展示,并赋予每个展示的图片一个方便记忆的编号;

[0133]

此步骤根据2人脸分析的结果进行媒体墙智能展示:

[0134]

1)根据人脸检测技术(与步骤1中采用的方法相同),如果发现媒体墙前没有游客,媒体墙随机播放游客游玩图像,或播放宣传片或停止播放节约用电。

[0135]

2)如果媒体墙前有人脸,但为新游客,则根据其人脸性别和年龄智能播放与新游客性别和年龄相仿的游玩图片。

[0136]

3)如果媒体墙前有人脸且为游客库中的人脸,则根据其人脸身份标签智能播放此游客游玩图片。

[0137]

优选的,在展示游玩图片时,给每个展示的图片一个方便记忆的编号,以方便后期游客自助打印留念。

[0138]

步骤4,利用手势识别技术让用户与媒体墙进行无接触交互,包括暂停、开始、前翻、后翻、删除。

[0139]

本步骤利用手势识别技术让用户与媒体墙进行无接触交互,用户可以与媒体墙进行暂停、开始、前翻、后翻、删除等智能交互。

[0140]

本发明采用深度协同字典学习的手势识别方法,具体为:

[0141]

对输入的待识别手势图像进行特征提取,本发明利用mobilenetv3构建轻量级特征提取网络,提出特征向量m为特征向量维数;

[0142]

对所述特征向量y使用手势完备字典d进行线性组合表示,建立深度稀疏表示模型并求解系数向量:

[0143][0144]

其中,w为需求解的稀疏表示系数,是w近似值,γ为常量平衡因子,||

·

||

1/2

表示1/2范数。

[0145]

根据上式求解的线性组合的系数向量进行手势分类识别。

[0146]

本发明所述手势有5个类别,分别定义为暂停、开始、前翻、后翻、删除。

[0147]

进一步地,对所述特征向量y使用手势完备字典进行线性组合表示之前,还包括所述手势完备字典的训练步骤,为了提高模型的准确率和鲁棒性,本发明提出深度协同学习的字典训练方法:

[0148]

根据深度学习的思想对手势训练样本x进行多层次深度分解学习得到手势子字典dc:

[0149]

[0150]

其中,x为手势训练样本矩阵;为第c类手势中不同层的字典(基矩阵),为对应的系数矩阵(编码矩阵);ds,ws分别为共享字典及其对应的系数矩阵。根据非负矩阵分解原理有:

[0151][0152]

上式可以解释为对包括有暂停、开始、前翻、后翻、删除等手势信息的训练样本x进行多层次分解,找到其新的表示方式ws和新表示空间

[0153]

为了增加字典的非线性表示能力,根据深度神经网络的方法对系数矩阵进行修改:

[0154][0155]

其中,i表示第i层,范围[1~m],g(

·

)为非线性激活函数。因此,深度协同字典学习模型的目标函数为:

[0156][0157]

深度协同字典学习模型的求解采用类似于栈式自编码网络一样的训练方法,分成逐层预训练、整体微调两个阶段:

[0158]

·

逐层预训练阶段

[0159]

a、令求解最小化问题:完成第一层分解;

[0160]

b、对继续分解完成第二层分解;

[0161]

如此循环下去,把所有的层都进行了预训练。通过逐层贪婪分解的方法,每一层的训练变成传统的字典学习问题(只不过这里加入了一项共享字典)。根据实际需要可以在每一层的字典学习中加入稀疏约束或监督学习等。为了表达方便和清晰,上述公式没有加入非线性激活函数。

[0162]

·

整体微调阶段

[0163]

通过最小化损失函数和随机梯度下降法来实现。

[0164]

步骤5,自助打印,如果游客在媒体墙上看到了自己感兴趣的图片,并想打印留念:

[0165]

1)记下自己感兴趣的图片编号;

[0166]

2)在自助打印机前输入图片编号;

[0167]

3)选择付费方式(网上支付、微信支付、支付宝支付、银行转账或现金支付等);

[0168]

4)选择打印方式(现场打印、u盘下载、转发邮箱等);

[0169]

5)完成确认。

[0170]

本发明实施例还提供一种智能交互式媒体展示墙系统,包括如下模块:

[0171]

图片整理分类模块,用于离线构建游客图片库,采集游客照片,将对应的标准人脸图像作为每个游客的身份标签,并以此建立每个游客的图像文件夹,并对游客图片进行性

别和年龄分类存储;

[0172]

人脸分析识别模块,用于利用安装在媒体墙上的摄像头抓拍站在建筑媒体墙前的人脸,并利用人脸检测技术抓取出合格的人脸图像,然后,利用人脸分析技术对提取的合格人脸图像进行属性分析,判断建筑媒体墙前的人脸性别、年龄和身份属性;

[0173]

媒体墙智慧展示模块,用于结合构建的游客图片库,将人脸检测和分析的结果进行媒体墙智能展示,并赋予每个展示的图片一个方便记忆的编号;

[0174]

智能交互模块,用于利用手势识别技术让用户与媒体墙进行无接触交互,包括暂停、开始、前翻、后翻、删除。

[0175]

各模块的具体实现方式与各步骤相应,本发明不予撰述。

[0176]

上述实施例为本发明较佳的实施方式,但本发明的实施方式并不受上述实施例的限制,其他的任何未背离本发明的精神实质与原理下所作的改变、修饰、替代、组合、简化,均应为等效的置换方式,都包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1