一种满足差分隐私的高质量轨迹深度生成方法

1.本发明属于轨迹数据生成技术领域,特别是涉及一种满足差分隐私的高质量轨迹深度生成方法。

背景技术:

2.随着智能设备和位置服务应用的普及,位置服务提供商和移动运营商产生并收集了大量的用户轨迹数据。这些轨迹包含对智能交通、疫情传播模拟等许多领域都有重要的价值。然而,由于轨迹数据涉及个人隐私,直接发布轨迹数据会对用户隐私构成威胁。因此如何确保用户的隐私得到保护的前提下,共享轨迹数据是学术和工业界关注的重要问题之一,而轨迹生成是实现这两个目标的重要方法。

3.近些年来,随着深度生成模型,特别是生成对抗网络(gan)的发展,高质量图像、视频等合成数据的生成技术已经很成熟。利用深度生成模型生成高质量的合成轨迹也成为目前的研究热点,相较于传统轨迹生成模型,这些深度生成模型可以捕获更丰富的时空信息,生成更高质量的轨迹数据。但是深度深层模型存在泄露训练数据隐私的风险,因此将差分隐私引入深度生成模型设计满足差分隐私的深度生成模型近来吸引了研究者们的广泛关注。

技术实现要素:

4.本发明的目的是提供一种满足差分隐私的高质量轨迹深度生成方法,以解决上述现有技术存在的问题。

5.为实现上述目的,本发明提供了一种满足差分隐私的高质量轨迹深度生成方法,包括:

6.构建轨迹深度生成模型,获取公共数据集与真实数据集;基于所述公共数据集、所述真实数据集以及基于差分隐私的随机梯度下降算法对所述轨迹深度生成模型进行训练,获得训练后的轨迹深度生成模型;基于训练后的轨迹深度生成模型获得轨迹数据集。

7.可选的,轨迹深度生成模型包括生成器与判别器。

8.可选的,所述训练包括:预训练与正式训练,其中,基于所述公共数据集进行预训练,通过进行预训练后的模型预测部分轨迹,基于所述真实数据集与所述部分轨迹进行正式训练,所述预训练包括轨迹预测训练与轨迹规律识别训练。

9.可选的,所述轨迹预测训练的过程包括:将所述公共数据集划分为训练数据集与测试数据集,并将每条由n个点组成的轨迹中相邻两个位置点,前一个点作为输入,后一个点作为目标,对所述生成器进行预训练。

10.可选的,所述轨迹规律识别训练的过程包括:对公共数据集进行处理,获得处理后的数据集,基于处理后的数据集与公共数据集对所述判别器进行训练,其中,对公共数据集进行处理的方式包括两种:第一轨迹改变法为随机选取轨迹中的一个位置点并且用一个物理空间距离较远的点来代替;第二轨迹改变法随机打乱轨迹中一个时间周期内位置的顺

序;对公共数据集的每条轨迹处理时,选用第一轨迹改变法或第二轨迹改变法中任一种。

11.可选的,所述正式训练的过程包括:判别器训练与生成器训练。

12.可选的,所述判别器训练的过程包括:基于预训练后的生成器补全所述部分轨迹,获得补全轨迹;基于所述补全轨迹与真实数据集中的真实轨迹计算梯度;对所述梯度进行裁剪;对处理后的梯度进行求和,并添加满足差分隐私的高斯噪声,基于梯度下降法对预训练后的判别器进行更新,并将判别器的损失返回到预训练后的生成器。

13.可选的,基于强化学习的方法进行所述生成器训练,其中,生成器作为智能体,部分轨迹作为状态,下一个生成的位置作为动作,所述损失作为奖励,基于所述梯度与梯度上升法更新生成器。

14.可选的,不断对抗训练生成器和判别器,直至所述轨迹深度生成模型收敛,获得训练后的轨迹深度生成模型。

15.本发明的技术效果为:

16.本发明是一种基于movesim和dp-sgd的轨迹数据深度生成方法dp-movesim,弥补了现有的轨迹深度生成模型隐私没有保障的不足,本发明首先利用保护数据集所在城市的公共数据集来预训练轨迹深度生成模型dp-movesim中的生成器和判别器,然后正式对抗训练生成器和判别器,并且在训练判别器的过程中基于dp-sgd对判别器的梯度加噪;与满足差分隐私的传统轨迹生成方法相比,在同样的隐私预算下更多的捕获到了原始轨迹的特征,产生有用性更高的轨迹数据集。

附图说明

17.构成本技术的一部分的附图用来提供对本技术的进一步理解,本技术的示意性实施例及其说明用于解释本技术,并不构成对本技术的不当限定。在附图中:

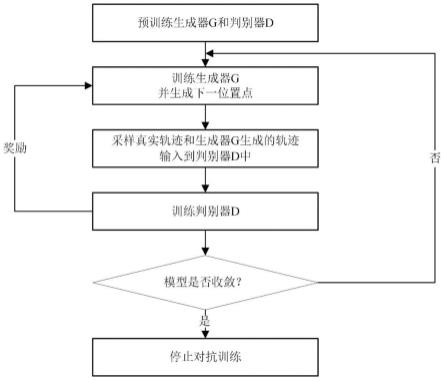

18.图1为本发明实施例中的方法流程图;

19.图2为本发明实施例中的系统模型示意图;

20.图3为本发明实施例中的预训练示意图;

21.图4为本发明实施例中的判别器训练流程图。

具体实施方式

22.需要说明的是,在不冲突的情况下,本技术中的实施例及实施例中的特征可以相互组合。下面将参考附图并结合实施例来详细说明本技术。

23.需要说明的是,在附图的流程图示出的步骤可以在诸如一组计算机可执行指令的计算机系统中执行,并且,虽然在流程图中示出了逻辑顺序,但是在某些情况下,可以以不同于此处的顺序执行所示出或描述的步骤。

24.实施例一

25.如图1-4所示,本实施例中提供一种满足差分隐私的高质量轨迹深度生成方法,包括:

26.dp-sgd是特指abadi等人在2016年在论文“deep learning with differential privacy”中提出的一种基于差分隐私的随机梯度下降算法。

27.本实施例使用公共数据集来预训练模型,基于dp-sgd对判别器的梯度加噪,

28.包括以下步骤:

29.步骤一:构造假轨迹,基于假轨迹和真实轨迹预训练生成器g和判别器d;

30.步骤二:开始对抗训练,基于生成器g以及部分轨迹预测并生成下一位置点;

31.步骤三:步骤二生成的点与该点之前的部分轨迹组成新的部分轨迹,并与真实轨迹一起输入到判别器d中;

32.步骤四:基于训练得到的新生成器g,补全部分轨迹,基于补全轨迹和真实轨迹训练更新判别器d;

33.步骤五:判别器d返回奖励给生成器,更新生成器g;

34.步骤六:重复步骤二到五,直到模型收敛。

35.具体包括如下步骤:

36.(1)使用公共数据集来预训练模型:由于movesim中的判别器和生成器都需要预训练,与对抗训练时不同,预训练阶段生成器和判别器都需要接触真实轨迹数据。然而由于预训练阶段迭代次数过多,如果添加满足差分隐私的噪声会大幅降低生成轨迹的有用性。因此,本发明通过使用与原始数据集同一城市的公共数据集来预训练生成器和判别器。

37.(2)基于dp-sgd对判别器的梯度加噪:由于gan网络的模型复杂程度较高,可能导致gan网络记住了训练样本的一些信息。因此,本发明通过dp-sgd的思想对判别器的梯度进行扰动(通过对判别器的梯度裁剪、聚合、加噪),使得判别器满足差分隐私,再根据差分隐私中的后处理定理,证明生成器及其产生的合成轨迹数据满足差分隐私。

38.本方法的模型训练包括预训练以及正式训练两个过程。

39.(1)预训练:如图3所示,直接用含隐私信息的数据集训练模型可能会导致隐私泄露,因此本发明使用同城市的公共数据集预训练来避免隐私泄露。预训练主要包含两个任务:轨迹预测和轨迹规律识别。1)轨迹预测:生成器在预训练阶段需要在已知当前位置点之前的部分轨迹去预测下个位置点。本发明通过轨迹预测来预训练生成器g。首先把整个公共轨迹数据集划分成训练数据集和测试数据集。对于每条由n个点组成的轨迹中相邻两个位置点,前一个点作为输入,后一个点作为目标,一共n-1组输入输出。2)轨迹规律识别:通过公共轨迹规律识别任务去预训练判别器d。轨迹规律识别任务本质上是一个二分类任务,用于区分输入的轨迹是否满足重要的轨迹规律,即时间周期性和空间连续性。首先通过扰乱原有的轨迹模式来构造假轨迹。本发明通过以下两种方式扰乱原有轨迹模式:a)随机从真实轨迹中选取一个位置点并且用一个物理空间距离较远的点来代替;b)随机打乱轨迹中一个时间周期内位置的顺序。因此本发明基于公共数据集构造的假轨迹及真实轨迹来预训练判别器。

40.(2)正式训练:在预训练生成器以及判别器之后,本发明基于强化学习的方法来训练生成器和判别器。如图4所示,首先基于生成器以及部分轨迹预测并生成下一位置点,将生成的位置点与该点之前的部分轨迹组成新的部分轨迹,并且与含隐私信息的真实轨迹一起输入到判别器中。判别器的更新以及差分隐私的实现(dp-sgd)主要包含以下步骤:

41.步骤1:基于最新的生成器g补全部分轨迹,基于补全的轨迹以及含隐私信息的真实轨迹来计算梯度。

42.步骤2:给定一个阈值c,对梯度进行裁剪,使得梯度的大小不超过c。

43.步骤3:对不同轨迹计算得到的梯度进行求和,并且添加满足差分隐私的高斯噪

声。

44.步骤4:基于梯度下降法更新判别器的参数。

45.在更新判别器之后,基于强化学习的方法来训练生成器。其中生成器作为智能体,部分生成轨迹作为状态,下一个生成的位置作为动作,来自判别器的损失作为奖励。基于策略梯度算法,本发明根据强化学习算法产生策略梯度通过接收来自判别器的奖励r(x),

[0046][0047]

其中θ是生成器g的参数,x是状态,奖励r(x)是来自判别器的损失。基于上面的梯度通过梯度上升法来更新参数θ。

[0048]

最后不断对抗训练生成器和判别器,直到模型收敛。

[0049]

实施例二

[0050]

本实施例中提供一种满足差分隐私的高质量轨迹深度生成方法,包括:

[0051]

构建轨迹深度生成模型,获取公共数据集与真实数据集;基于公共数据集、真实数据集以及基于差分隐私的随机梯度下降算法对轨迹深度生成模型进行训练,获得训练后的轨迹深度生成模型;基于训练后的轨迹深度生成模型获得轨迹数据集。

[0052]

在一些实施例中,轨迹深度生成模型包括生成器与判别器。

[0053]

在一些实施例中,训练包括:预训练与正式训练,其中,基于公共数据集进行预训练,通过进行预训练后的模型预测部分轨迹,基于真实数据集与部分轨迹进行正式训练,预训练包括轨迹预测训练与轨迹规律识别训练。

[0054]

在一些实施例中,轨迹预测训练的过程包括:将公共数据集划分为训练数据集与测试数据集,并将每条由n个点组成的轨迹中相邻两个位置点,前一个点作为输入,后一个点作为目标,对生成器进行预训练。

[0055]

在一些实施例中,轨迹规律识别训练的过程包括:对公共数据集进行处理,获得处理后的数据集,基于处理后的数据集与公共数据集对判别器进行训练,其中,对公共数据集进行处理的方式包括两种:第一轨迹改变法为随机选取轨迹中的一个位置点并且用一个物理空间距离较远的点来代替;第二轨迹改变法随机打乱轨迹中一个时间周期内位置的顺序;对公共数据集的每条轨迹处理时,选用第一轨迹改变法或第二轨迹改变法中任一种。

[0056]

在一些实施例中,正式训练的过程包括:判别器训练与生成器训练。

[0057]

在一些实施例中,判别器训练的过程包括:基于预训练后的生成器补全部分轨迹,获得补全轨迹;基于补全轨迹与真实数据集中的真实轨迹计算梯度;对梯度进行裁剪;对处理后的梯度进行求和,并添加满足差分隐私的高斯噪声,基于梯度下降法对预训练后的判别器进行更新,并将判别器的损失返回到预训练后的生成器。

[0058]

在一些实施例中,基于强化学习的方法进行生成器训练,其中,生成器作为智能体,部分轨迹作为状态,下一个生成的位置作为动作,损失作为奖励,基于梯度与梯度上升法更新生成器。

[0059]

在一些实施例中,不断对抗训练生成器和判别器,直至轨迹深度生成模型收敛,获得训练后的轨迹深度生成模型。

[0060]

以上所述,仅为本技术较佳的具体实施方式,但本技术的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本技术揭露的技术范围内,可轻易想到的变化或替换,

都应涵盖在本技术的保护范围之内。因此,本技术的保护范围应该以权利要求的保护范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1