一种基于层次化密集架构搜索的遥感灾害场景制图方法

1.本发明属于高分辨率遥感影像识别领域,特别涉及一种基于层次化密集架构搜索的遥感灾害场景制图方法。

背景技术:

2.高空间分辨率遥感影像提供了丰富的地表细节,使我们能够更清晰地观察地球环境。为了快速准确地获得感兴趣地物制图结果,过去几十年来大量研究提出了各种方法。传统方法侧重于手工特征和分类器的设计。然而,这些方法依赖于人类的专业知识,在面对海量数据和复杂的灾害场景时表现出制图精度低、迁移能力弱的问题。因此,先进的数据驱动算法被广泛研究,以各类深度全卷积神经网络及其变体为代表,被应用于各类遥感影像语义分割制图任务。虽然深度学习网络可以通过端到端监督自动提取和分类特征,但网络的设计仍然是手工的。深度学习网络的复杂设计过程需要大量跨学科知识,如计算机视觉和遥感解译。此外,由于大量的遥感数据和模型参数,手工设计的网络架构调整与验证周期往往很长,无法满足灾害场景下快速制图需求。

3.神经网络架构搜索能够以数据驱动的方式自动设计网络架构,降低对专业知识的要求。通过使用可学习参数对架构进行编码,神经网络架构搜索利用特定策略(梯度下降、强化学习、演化计算等)来优化参数。然而,现有的架构搜索方法在灾害场景制图任务中存在以下问题:1)它们专注于搜索编码器架构,搜索空间随着层数的加深呈指数增长。巨大的计算开销伴随着昂贵的时间成本。因此,只能搜索浅层网络,或者通过重复堆叠基本搜索单元来加深网络。这限制了模型的性能,无法适用于灾后地物分布复杂的情况。2)其对解码器的忽视导致空间细节恢复较弱,难以准确召回出灾害场景中地物细节与弱小目标。

技术实现要素:

4.为了解决这些问题,我们提出了一种基于层次化密集架构搜索的遥感灾害场景制图方法,将重点转移到自适应解码器的搜索上。通过利用和固定现有的深度编码器结构,提高了搜索效率和模型的泛化性。该方法旨在自动设计解码器,以适应于现有编码器,同时生成一组遥感预训练权重。该方法能够提升网络搜索效率、保证网络深度与鲁棒性并增强解码器对地物细节解译能力。无须人工设计深度解译架构,面对各类灾害或其他复杂场景均能实现数据到解译结果的高效全自动化,及时响应应急需求。

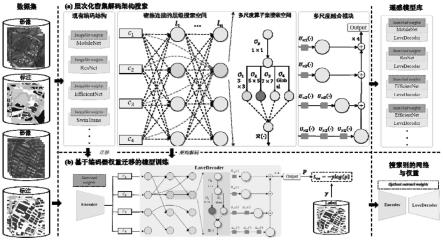

5.本发明的目的在于提出一种基于层次化密集架构搜索的遥感灾害场景制图方法。在目前发展成熟的深度编码架构背景下,聚焦于解码架构搜索。为了高效地自动搜索遥感网络,我们设计了一个级联过程,包括层次化密集架构搜索和基于编码器权重迁移的模型训练。通过固定编码器架构,基于大规模遥感数据集的分层密集搜索可以在一天内完成。该框架与不同类型的编码器兼容,具有高度的可扩展性和通用性。在搜索到最优架构后,基于编码器权重迁移的模型训练利用搜索阶段的编码器权重进行初始化,在下游灾害场景制图任务进行重新训练,从而实现特定制图任务的迁移。

6.本发明提供一种基于层次化密集架构搜索的遥感灾害场景制图方法,实现步骤如下:

7.步骤1,构建特定灾害场景地表覆盖分类影像样本库,收集洪水、飓风等灾害受击后的高分辨率遥感影像,按比例划分训练集、验证集与测试集,并对数据进行归一化,对训练集进行数据增强。

8.步骤2,构建层次化密集搜索空间用于解码架构搜索,层次化密集搜索空间包含密集连接的层级搜索空间与多尺度算子集搜索空间;通过结合现有深度编码模型,在训练集上实现解码架构可微分搜索,并利用多尺度融模块对解码架构输出的多尺度特征进行融合,获取最终制图概率输出。

9.步骤3,基于编码器权重迁移的模型训练,通过步骤2中搜索到的解码器架构参数,利用广度优先算法解码最优解码架构,结合编码器模型权重,在特定灾害任务上实现模型重训练。

10.步骤4,基于训练后的编码-解码模型,对未标记大范围灾害场景进行地表覆盖制图与损毁评估,预测分类概率获取制图结果。

11.进一步的,步骤1的具体实现包括如下子步骤,

12.步骤1.1,根据典型自然灾害:飓风、洪涝、地震、火山喷发等,利用无人机或者卫星平台收集灾后区域高分辨率遥感影像;

13.步骤1.2,根据受灾后感兴趣地物进行损毁评级,并进行像素级标注,包含但不限于以下类别:废墟、水域、未受损建筑物、中度受损建筑物、高度受损建筑物、完全损毁建筑物、车辆、船舶、道路、树木、泳池、沙土等;

14.步骤1.3,对所有影像与标注掩膜进行裁剪,并划分为训练、验证与测试集。对所有影像数据进行归一化,并利用随机翻转、随机色彩扰动、随机尺度放缩对训练集进行数据增强。

15.进一步的,步骤2的具体实现包括如下子步骤,

16.步骤2.1,设计密集连接的层级搜索空间,该空间用于寻找解码架构中最优的特征空间分辨率转移路径。现有深度学习编码器(如resnet,swin-transformer等)均具有四种尺度的特征输出,分别为:{c1,c2,c3,c4},其空间分辨率分别为原始图像的{1/4,1/8,1/16,1/32}。因此,如何包含各种尺度特征的最优交互路径是该空间设计所考虑的主要需求。我们设计密集连接的层级搜索空间,其涵盖各种尺度特征交互的所有路径。针对该空间第一层连接,可以表示为:其中α为架构参数,表示前层输出的权重或者连接强度,代表多尺度算子融合策略,每一层有四个不同尺度的节点。针对第二层或更多后续层l,则其中节点连接表达公式如下:

[0017][0018]

其中l≥2,代表当前层在搜索空间中深度,α基于softmax函数归一化, ni代表前层节点的特征输出{ni|i=5,6,7,...,4l},i代表前层输出编号。

[0019]

步骤2.2,设计多尺度算子集搜索空间,该空间中特征空间分辨率保持不变,用于搜索微观层次,即节点中多尺度算子的最优融合策略每一个节点的算子选择与融合策

略都是相互独立的,从可选算子集合中组合:全局平均池化、3

×

3可分离卷积、5

×

5可分离卷积、7

ꢀ×

7可分离卷积。因此,在某节点内部搜索空间表示如下:

[0020][0021]

其中β用来表示每个算子的重要程度,x表示节点输入特征,oj则为具体操作算子(如全局平均池化等),j代表可选搜索算子编号。附图1中的o

p

为3

×

3可分离卷积,对输入的特征做预处理,实现特征降维。r(

·

)代表对多尺度融合后的特征做后处理,由3

×

3可分离卷积、归一化层与relu激活函数组成。

[0022]

步骤2.3,设计多尺度融合模块,对解码架构的多尺度输出进行融合处理。解码架构的输出{d1,d2,d3,d4}也分为四个尺度,分别为原始图像的{1/4,1/8,1/16,1/32},针对四个尺度的输出,分别用不同数量的上采样模块u

×2(

·

)进行尺度变换。u

×2(

·

)包含3

×

3卷积、归一化层、 relu激活函数以及一个可选的

×

2双线性上采样函数。因此{d1,d2,d3,d4}分别由1个u

×1(

·

) (无上采样)、1个u

×2(

·

)、2个u

×2(

·

)、3个u

×2(

·

)处理,将尺度统一为原始图像的1/4。然后将处理后的同尺度特征进行相加融合,最终利用

×

4双线性上采样函数恢复为原始图像分辨率大小,然后利用1

×

1卷积将通道降维至类别数,通过softmax实现分割图概率输出。

[0023]

步骤2.4,在密集连接的层级搜索空间中,所有的权重与网络架构参数α与β均可微分,能够利用梯度下降算法实现端到端优化。

[0024]

进一步的,步骤3的具体实现包括如下子步骤,

[0025]

步骤3.1,根据搜索到的架构参数α与β,首先利用广度优先算法,基于α所代表的连接强度,保留每个节点输入中强度最大的c个连接,从而找到最优的特征空间分辨率转移路径;基于β所代表的算子的重要程度,保留每个节点内部最重要的p个算子用于特征融合。

[0026]

步骤3.2,利用搜索到的解码架构,结合搜索过程中的编码器,迁移其搜索过程中得到的网络权重用于初始化,在训练集上进行重训练;损失函数为:l

ce

=-ylog(p),其中y为训练真实标签,p为网络预测输出概率。

[0027]

进一步的,对于测试集归一化后的遥感影像,将其输入至重训练收敛后的网络模型中,得到输出的分类概率,通过取最大值获取分类结果,得到灾害场景地表覆盖与评估制图结果。面对新的场景与新的数据集,可以对其进行重新搜索与训练;同样也可以将现有搜索到的网络架构及训练参数迁移至新的数据集上进行微调测试。

[0028]

本发明方法具有以下显著效果:(1)通过保留现有优秀的深度编码器架构,专注于解码架构的搜索,能够同时实现提升网络搜索效率、保证网络深度与鲁棒性并增强解码器对地物细节解译能力;(2)基于编码器权重迁移的模型训练能够复用已有遥感预训练参数,加速网络模型收敛,缩短训练进程,提升下游任务应用效率。并且所得到的一系列遥感网络模型参数与网络架构泛化性高,适用于各类新场景与新制图任务。

附图说明

[0029]

图1是本发明实施例1的步骤2与3中设计的基于层次化密集架构搜索的遥感灾害场景制图方法。

[0030]

图2是本发明实施例1的步骤3中搜索得到特征空间分辨率转移路径示意图,其中

线条粗细代表其重要程度。

[0031]

图3是本发明实施例1的步骤4中模型推理得到的飓风灾害场景下地物受灾制图结果。

具体实施方式

[0032]

下面通过实施例,进一步阐明本发明的突出特点和显著进步,仅在于说明本发明而决不限制本发明。

[0033]

实施例1

[0034]

(一)使用公开数据rescunet迈克尔飓风袭击后的区域无人机采集影像作为灾害场景样本数据库,包含4494张3000

×

4000影像及对应语义分割标注。

[0035]

1.1,在2018年五级迈克尔飓风袭击墨西哥海湾后,利用大疆无人机低空飞行收集灾后场景墨西哥港湾及周边区域影像数据;

[0036]

1.2,根据受灾后感兴趣地物进行损毁评级,并进行像素级标注,包含12个类别:废墟、水域、未受损建筑物、中度受损建筑物、高度受损建筑物、完全损毁建筑物、车辆、船舶、道路、树木、泳池、沙土等;

[0037]

步骤1.3,对所有影像与标注掩膜进行裁剪,并划分为训练集(3595张)、验证集(449 张)与测试集(449张)。对所有影像数据进行归一化,并利用随机翻转、随机色彩扰动、随机尺度放缩对训练集进行数据增强。

[0038]

(二)层次化密集搜索空间用于解码器架构搜索,以适应于各类现有深度编码器架构,具体通过设计密集连接的层级搜索空间与多尺度算子集搜索空间,利用梯度下降算法同时优化网络权重与架构参数,实现高效解码器架构搜索;。

[0039]

2.1,设计密集连接的层级搜索空间,该空间用于寻找解码架构中最优的特征空间分辨率转移路径。利用现有深度学习编码器resnet50,其具有四种尺度的特征输出,分别为: {c1,c2,c3,c4},其空间分辨率分别为原始图像的{1/4,1/8,1/16,1/32}。因此,如何包含各种尺度特征的最优交互路径是该空间设计所考虑的主要需求。我们设计密集连接的层级搜索空间,其涵盖各种尺度特征交互的所有路径。针对该空间第一层连接,可以表示为:其中α为架构参数,表示前层输出的权重或者连接强度,代表多尺度算子融合策略,每一层有四个不同尺度的节点。针对第二层或更多后续层l,则其中节点连接表达公式如下:

[0040][0041]

其中l≥1,代表当前层在搜索空间中深度,α基于softmax函数归一化ni代表前层节点的特征输出{ni|i=5,6,7,...,4l},i代表前层输出编号。在搜索过程中,层数深度 l=2。

[0042]

2.2,设计多尺度算子集搜索空间,该空间中特征空间分辨率保持不变,用于搜索微观层次,即节点中多尺度算子的最优融合策略每一个节点的算子选择与融合策略都是相互独立的,从集合中选择:全局平均池化、3

×

3可分离卷积、5

×

5可分离卷积、7

×

7可分离卷积。因此,在某节点内部搜索空间表示如下:

[0043][0044]

其中β用来表示每个算子的重要程度,x表示节点输入特征,oj则为具体操作算子(如全局平均池化等),j代表可选搜索算子编号。附图1中的o

p

为3

×

3可分离卷积,对输入的特征做预处理,实现特征降维。r(

·

)代表对多尺度融合后的特征做后处理,由3

×

3可分离卷积、归一化层与relu激活函数组成。

[0045]

步骤2.3,设计多尺度融合模块,对解码架构的多尺度输出进行融合处理。解码架构的输出{d1,d2,d3,d4}也分为四个尺度,分别为原始图像的{1/4,1/8,1/16,1/32},针对四个尺度的输出,分别用不同数量的上采样模块u

×2(

·

)进行尺度变换。u

×2(

·

)包含3

×

3卷积、归一化层、 relu激活函数以及一个可选的

×

2双线性上采样函数。因此{d1,d2,d3,d4}分别由1个u

×1(

·

) (无上采样)、1个u

×2(

·

)、2个u

×2(

·

)、3个u

×2(

·

)处理,将尺度统一为原始图像的1/4。然后将处理后的同尺度特征进行相加融合,最终利用

×

4双线性上采样函数恢复为原始图像分辨率大小,然后利用1

×

1卷积将通道降维至类别数,通过softmax实现分割图概率输出。

[0046]

2.4,在密集连接的层级搜索空间中,所有的权重与网络架构参数α与β均可微分,利用梯度下降算法实现端到端优化。搜索过程中,利用随机梯度下降优化器进行优化,初始学习率设置为0.01,批次大小为16,搜索迭代步数为60000。

[0047]

(三)基于编码器权重迁移的模型训练,通过搜索到的解码器架构参数,利用广度优先算法解码最优解码架构。如图2所示,针对每个节点我们保留最重要的三个输入连接,从上到下,从左到右,我们对所有节点进行编号,则c1,c2,c3,c4为1,2,3,4。因此第一层的四个节点输入编码则为:l1=[1,3,4],[1,3,4],[0,0,0],[0,0,0],其中0代表无任何输入。第二层的四个节点输入编码为:l2=[1,3,4],[3,4,6],[1,3,4],[3,4,5]。结合编码器模型权重,在训练集上实现模型重训练。

[0048]

3.1,根据搜索到的架构参数α与β,首先利用广度优先算法,基于α所代表的连接强度,保留每个节点输入中强度最大的3个连接,从而找到最优的特征空间分辨率转移路径;基于β所代表的算子的重要程度,保留每个节点内部最重要的2个算子用于特征融合。

[0049]

3.2,利用搜索到的解码架构,结合搜索过程中的编码器,迁移其搜索过程中得到的网络权重用于初始化,在训练集上进行重训练。初始学习率设置为0.01,批次大小为16,重训练迭代步数为30000。损失函数为:l

ce

=-ylog(p),其中y为训练真实标签,p为网络预测输出概率。

[0050]

(四)对于测试集归一化后的遥感影像,将其输入至重训练收敛后的网络模型中,得到输出的分类概率,通过取最大值获取分类结果,得到灾害场景地表覆盖与评估制图结果,如图3。

[0051]

本文中所描述的具体实施例仅仅是对本发明精神作举例说明。本发明所属技术领域的技术人员可以对所描述的具体实施例做各种各样的修改或补充或采用类似的方式替代,但并不会偏离本发明的精神或者超越所附权利要求书所定义的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1