搜索提醒补全的生成和重排序方法、装置、设备及介质与流程

1.本技术涉及搜索技术领域,特别是涉及到一种搜索提醒补全的生成和重排序方法、装置、设备及存储介质。

背景技术:

2.站内知识库就是聚合多维度的知识文档,形成完整且统一的知识库体系,方便用户进行快速实时的搜索来获取知识信息。对于站内知识库搜索来说,使用文档的标题信息或者其他有用的文本信息,如文档标签,作者信息等来构建搜索提醒模块,确实是可行的办法,但仅依靠这些信息远远不够,因为这个办法没有充分挖掘文档内部的文本信息。国内的大多数站内搜索系统,都仅能机械的对用户的搜索进行文档的标题提醒。方法虽然简单,但辅助用户搜索的能力有限。另一种方法是使用搜索历史的搜索信息进行补全,可以对搜索提醒模块的内容进行补充。但相对于通用搜索引擎,站内知识库搜索系统的可搜索空间是非常小的。也就是说,有相当多的历史搜索不能在本次搜索中搜索到相关内容。所以这部分的历史搜索,对于用户来说是无效的。因此使用搜索历史的搜索信息进行补全的方法也不适用于站内知识库搜索的搜索提醒补全。

技术实现要素:

3.本技术的主要目的为提供一种搜索提醒补全的生成和重排序方法、装置、设备及存储介质,旨在解决现有技术中站内知识库搜索提醒补全效果不佳,导致用户搜索效率不高的技术问题。

4.为了实现上述发明目的,本技术提出一种搜索提醒补全的生成和重排序方法,所述方法包括:

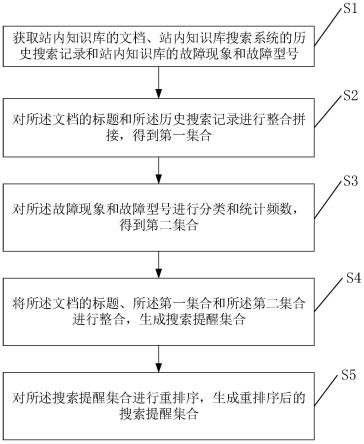

5.获取站内知识库的文档、站内知识库搜索系统的历史搜索记录和站内知识库的故障现象和故障型号;

6.对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合;

7.对所述故障现象和故障型号进行分类和统计频数,得到第二集合;

8.将所述文档的标题、所述第一集合和所述第二集合进行整合,生成搜索提醒集合;

9.对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合。

10.进一步地,所述对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合的步骤之前,包括:

11.从所述文档中解析出文本数据,进行分句和分词,用分句和分词后的解析文本数据训练n-gram语言模型。

12.进一步地,所述对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合的步骤,包括:

13.将所述文档的标题和所述历史搜索记录进行整合和分词,用所述n-gram语言模型进行频率统计排序,得到后缀候选子串集合;

14.根据所述历史搜索记录生成多个前缀子串,根据多个所述前缀子串在所述后缀候选子串集合中进行遍历,寻求与每个所述前缀子串相匹配的所有后缀子串,并进行拼接;

15.用所述n-gram语言模型过滤拼接后的前缀子串和相匹配的所有后缀子串,得到第一集合。

16.进一步地,所述对所述故障现象和故障型号进行分类和统计频数,得到第二集合的步骤,包括:

17.获取站内知识库的故障型号的故障现象,得到故障现象对应的句子,并统计句频;

18.通过层次聚类对每一个故障现象对应的句子进行聚类,得到分蔟结果和蔟内句频最高的句子;

19.用训练好的bertflow模型分别对句子进行表征,以所述蔟内句频最高的句子为基准,分别和蔟内其他的句子进行相似度计算;

20.根据相似度计算结果对所述蔟内其他的句子进行筛选,得到第二集合。

21.进一步地,所述对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合的步骤,包括:

22.计算bm25得分、句频得分和匹配高亮得分;

23.按照所述bm25得分、句频得分和匹配高亮得分,对所述搜索提醒集合进行重排序。

24.进一步地,所述计算匹配高亮得分的步骤,包括:

25.句子的匹配高亮的得分计算如下公式:

[0026][0027]

其中,ci是句子si的关键词字数统计,wi为句子si的关键词个数,是每个词的平均高亮长度score为句子s的高亮得分。

[0028]

进一步地,所述对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合的步骤之后,包括:

[0029]

对所述搜索提醒集合和所述重排序后的搜索提醒集合进行测试。本技术还提供了一种搜索提醒补全的生成和重排序装置,所述装置包括:

[0030]

知识库信息获取模块,用于获取站内知识库的文档、站内知识库搜索系统的历史搜索记录和站内知识库的故障现象和故障型号;

[0031]

第一集合生成模块,用于对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合;

[0032]

第二集合生成模块,用于对所述故障现象和故障型号进行分类和统计频数,得到第二集合;

[0033]

搜索提醒集合生成模块,用于将所述文档的标题、所述第一集合和所述第二集合进行整合,生成搜索提醒集合;

[0034]

重排序模块,用于对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合。

[0035]

本技术还提供一种计算机设备,包括存储器和处理器,所述存储器中存储有计算机程序,其特征在于,所述处理器执行所述计算机程序时实现上述任一项所述方法的步骤。

[0036]

本技术还提供一种计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现上述任一项所述的方法的步骤。

[0037]

本技术提供的一种搜索提醒补全的生成和重排序方法,从站内搜索知识库中挖掘适合用于搜索自动提醒的信息,得到搜索提醒集合,辅助用户进行知识库内容搜索。使得用户在输入更少的内容的情况下,能更快更好的得到想要的搜索内容。这是一套适用于站内搜索的完整的从搜索提醒集合生成到重排序的方案,而现阶段的搜索自动提醒方案,大多数都是针对通用搜索引擎的搜索自动提醒功能。本方案简单实用且方便自动化更新,适用于大部分基于文档知识库的站内搜索引擎的搜索自动提醒功能的构建。

附图说明

[0038]

图1为本技术一实施例的搜索提醒补全的生成和重排序方法的流程示意图;

[0039]

图2为本技术一实施例的搜索提醒补全的生成和重排序装置的结构示意框图;

[0040]

图3为本技术一实施例的计算机设备的结构示意框图。

[0041]

本技术目的的实现、功能特点及优点将结合实施例,参照附图做进一步说明。

具体实施方式

[0042]

为了使本技术的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本技术进行进一步详细说明。应当理解,此处描述的具体实施例仅仅用以解释本技术,并不用于限定本技术。

[0043]

参照图1,本技术实施例中提供一种搜索提醒补全的生成和重排序方法,包括步骤s1-s5,具体地:

[0044]

s1、获取站内知识库的文档、站内知识库搜索系统的历史搜索记录和站内知识库的故障现象和故障型号。

[0045]

具体地,对于步骤s1,不同的站内知识库包含不同的文档、产品的故障现象和对应的故障型号等信息,需要对站内知识库中的信息进行充分的挖掘,使得根据用户输入的搜索关键词生成的搜索提醒的内容,符合用户预期搜索内容的可能性更大,改善站内知识库搜索提醒效率,提升用户体验。

[0046]

s2、对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合。

[0047]

具体地,对于步骤s2,文档的类型是pdf,docx,txt,xlsx和pptx等类型文件。将所有文档的标题以及搜索系统的历史搜索记录进行整合,用根据站内知识库的文档内容训练好的n-gram语言模型统计文档的标题以及搜索系统的历史搜索记录中的所有句子频率,根据预设阈值截取特定频率的句子,得到后缀候选子串集合s

suf

。根据历史搜索记录在s

suf

中查找尾词相匹配的所有后缀子串,并进行拼接,拼接后再使用n-gram语言模型进行过滤,得到第一集合。保证根据集合生成的搜索提醒内容都是正确的,在用户检索时能够检索到相应的搜索提醒内容。

[0048]

s3、对所述故障现象和故障型号进行分类和统计频数,得到第二集合。

[0049]

具体地,对于步骤s3,当站内知识库包含有不同故障型号产品以及不同故障型号产品的故障现象时,以故障型号为类别对故障现象进行分类和统计频数,方便用户根据故障产品的型号快速找到对应故障现象的解决方法,提升搜索的效率,改善用户体验。

[0050]

s4、将所述文档的标题、所述第一集合和所述第二集合进行整合,生成搜索提醒集合。

[0051]

s5、对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合。

[0052]

具体地,对于步骤s4和s5,将根据站内知识库的文档、所述文档对应的标题和站内知识库搜索系统的历史搜索记录生成的第一集合,与根据站内知识库的故障现象和故障型号生成的第二集合进行整合,生成搜索提醒集合。该搜索提醒集合包括该站内知识库所有的搜索提醒的信息。再将搜索提醒集合根据bm25得分、句频得分和匹配高亮得分进行重排序,根据用户输入的搜索信息,对相关的搜索提醒信息进行排序,与该搜索信息关联性更大的搜索提醒信息排在更靠前的地方。其中,bm25得分是计算搜索内容与文档相似度得分。bm25是目前信息索引领域最主流的计算搜索内容与文档相似度得分的算法。bm是best match最佳匹配的缩写,25指的是第25次算法迭代。

[0053]

在一个实施例中,上述对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合的步骤s2之前,包括:

[0054]

s200、从所述文档中解析出文本数据,进行分句和分词,用分句和分词后的解析文本数据训练n-gram语言模型。

[0055]

具体地,对于步骤s200,对文档进行内容的提取和文档拆解,从文档中解析出文本数据,逐段分句和分词,训练并保存n-gram语言模型。n-gram语言模型是一种语言模型,语言模型是一个基于概率的判别模型,它的输入是一句话(单词的顺序序列),输出是这句话的概率,即这些单词的联合概率。对分词之后的文本数据进行计数,计算1-gram,2-gram,...,n-gram等,这里的阶数n是预先给定的,本方案中训练到1-6-gram。训练好的n-gram语言模型用于筛除语法有问题的搜索内容和统计搜索内容的句子频率。

[0056]

在一个实施例中,上述对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合的步骤s2,包括:

[0057]

s201、将所述文档的标题和所述历史搜索记录进行整合和分词,用所述n-gram语言模型进行频率统计排序,得到后缀候选子串集合;

[0058]

s202、根据所述历史搜索记录生成多个前缀子串,根据多个所述前缀子串在所述后缀候选子串集合中进行遍历,寻求与每个所述前缀子串相匹配的所有后缀子串,并进行拼接;

[0059]

s203、用所述n-gram语言模型过滤拼接后的前缀子串和相匹配的所有后缀子串,得到第一集合。

[0060]

具体地,对于步骤s201、s202和s203,将所有文档标题和搜索系统的历史搜索记录进行整合并分词。这样就得到了类似于:“无线传屏、问题”这样的搜索内容。用训练好的n-gram语言模型进行频率统计排序,排序后,取前10万保存,得到后缀候选子串集合。例如对于“产品a、无线传屏、配对失败”这个搜索内容,可得一元字符串:“配对失败”,二元字符串:“无线传屏、配对失败”以及三元字符串:“产品a、无线传屏、配对失败”。然后利用每一个搜索内容的尾词,来匹配后缀字串的首词,来寻找出潜在的候选搜索内容,例如:对于搜索内容:“一体机、无线传屏”,可以通过上述二元字符串拼接为:“一体机、无线传屏、配对失败”。然而,上述拼接办法不一定能得到正确的搜索内容。因此需要使用训练好的n-gram语言模型,对候选搜索内容进行过滤,保证只有共同出现于文档的搜索内容才能被保留,得到第一

集合set1。通过这个步骤可以过滤一些语法有问题的拼接搜索内容,如:“触摸、pc、无法触摸”。以及一些不符合逻辑的搜索内容。保留更多像:“产品b、与、传屏器、怎么、配对”这样的有用搜索内容。

[0061]

在一个实施例中,上述对所述故障现象和故障型号进行分类和统计频数,得到第二集合的步骤s3,包括:

[0062]

s301、获取站内知识库的故障型号的故障现象,得到故障现象对应的句子,并统计句频;

[0063]

s302、通过层次聚类对每一个故障现象对应的句子进行聚类,得到分蔟结果和蔟内句频最高的句子;

[0064]

s303、用训练好的bertflow模型分别对句子进行表征,以所述蔟内句频最高的句子为基准,分别和蔟内其他的句子进行相似度计算;

[0065]

s304、根据相似度计算结果对所述蔟内其他的句子进行筛选,得到第二集合。

[0066]

具体地,对于步骤s301、s302、s303和s304,第二集合是包含故障现象-故障型号关联的搜索提醒集合,方便用户在搜索时使用。首先抽取所有故障型号的故障现象,并以故障型号为类别对故障现象进行分类和统计频数。例如,经统计产品c有426种自然语言下的不同故障现象,并且“pc无信号”为最常见的故障现象,频数是1782。然后,本方案使用层次聚类方法,对426种故障现象进行聚类,形成若干个蔟。通过聚类分析,蔟中的故障现象是相似的,例如“前置usb不识别”,为蔟中频数最大的这个故障现象。将本蔟中与其相似的频数低的故障现象进行舍弃。例如:“机器前置usb不识别”和“前置usb口不识别u盘”等。这里通过对频数阈值来过滤,阈值经对比实验后,设为0.3。同时本方案还使用bert-flow训练的语义表征模型,以蔟内句频最高的句子为基准,分别和蔟内其他的句子进行相似度计算,进一步对语义相似的故障现象进行过滤。例如:在实验中本方案发现,“前置usb不识别”和“前置usb无法识别”频数都非常高,表述的是同一个故障现象,本方案通过语义相似度阈值0.85,找到这些频数接近但语义相似的句子,进行故障现象的进一步过滤。最终可以得到第二集合set2。

[0067]

在一个实施例中,上述对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合的步骤s5,包括:

[0068]

s501、计算bm25得分、句频得分和匹配高亮得分;

[0069]

s502、按照所述bm25得分、句频得分和匹配高亮得分,对所述搜索提醒集合进行重排序。

[0070]

具体地,对于步骤s501和s502,bm25得分是在elast icsearch初召得到的得分,为搜索内容与文档相似度得分。句频得分为文档的访问数统计和故障现象的句频的做归一化频数。匹配高亮得分是提醒的搜索内容有多少字符和用户输入的搜索内容匹配上,使用公式:

[0071][0072]

其中,ci是句子si的关键词字数统计,wi为句子si的关键词个数,是每个词的平均高亮长度score为句子s的高亮得分。以此得到句子的得分,归一化后,作为重排序特征

之一。

[0073]

在一个实施例中,上述所述计算匹配高亮得分的步骤,包括:

[0074]

s503、句子的匹配高亮的得分计算如下公式:

[0075][0076]

其中,ci是句子si的关键词字数统计,wi为句子si的关键词个数,是每个词的平均高亮长度score为句子s的高亮得分。

[0077]

具体地,对于步骤s503,例如用户输入:“红灯不亮”,匹配到的搜索内容为:“机器红灯转蓝灯亮”。这里就有三个词匹配高亮,分别为:“红灯”和“灯”和“亮”。根据公式得到上述的句子匹配高亮得分:5*5/2=12.5。用匹配高亮得分特征的目的是让匹配到了相同高亮字符长度的搜索内容,关键词更少的搜索内容能排在前面。例如,对于用户输入:“红灯不亮”,搜索内容1:“机器红灯转蓝灯亮”和搜索内容2:“红灯不亮,黑屏”。同样匹配到4个字符高亮,但搜索内容2只有一个连续关键词匹配。

[0078]

在一个实施例中,上述对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合的步骤s5之后,包括:

[0079]

s504、对所述搜索提醒集合和所述重排序后的搜索提醒集合进行测试。

[0080]

具体地,对于步骤s504,输入搜索内容,输出对应搜索内容的top3提醒作为标签。并且,这三个输出根据重要程度也有先后顺序。本方案从三个维度指标进行实验测试。

[0081]

第一个维度指标是top-k的召回率,recall@k召回率是指前topk结果中检索出的相关结果数和库中所有的相关结果数的比率,衡量的是检索系统的查全率,用于测试重排序前后的召回率变化。如下表所示:

[0082][0083]

上表为recall@k召回率测试结果的示例,ori-ranking表示没有重排序的方案,re-ranking表示重排序方案。从上述测试结果发现在相同的搜索集合情况下,对于top1的召回,重排序方案要比没有重排序的方案有1.91的提升,但在top3的召回却下降了0.77个点。说明重排序方案更可能把用户想要的结果排在首位,但用户同样想关注的前三个搜索内容并没有优势。并且从top10召回来看,两种方案旗鼓相当。

[0084]

第二个指标,我们考虑加搜索内容对应的标签的顺序加入进来,使用map@k(mean average precision,平均检索精度)来进行测试,如下表所示:

[0085][0086]

上表为map@k测试结果的示例,ori-ranking表示没有重排序的方案,re-ranking表示重排序方案。根据上述map@k测试结果,重排序方案的效果是明显的,无论从首位,前三位还是前十位来看,都更能将用户关注的搜索内容尽可能排在更前的位置。

[0087]

第三,将本方案应用于线上,提供给用户进行真实体验,并与历史线上方案进行对比。具体的做法是,提取近7天和近7-14天的线上搜索日志信息做对比。近7天是本方案生成的搜索提醒数据,7-14天利用的是历史线上方案所生成的搜索提醒数据。并使用recall值探究生成的搜索提醒内容和用户搜索时输入的搜索内容的重合度。

[0088][0089]

上表为本方案与历史线上方案提供给用户进行真实体验的recall值测试结果的示例,从上述测试结果可知,本方案对于用户的搜索提醒效果要明显优于历史线上方案,通过测试步骤可以确定本方案生成的搜索提醒效果,对用户的搜索提供了更大帮助。

[0090]

参照图2,是本技术一实施例中搜索提醒补全的生成和重排序装置结构框图,装置包括:

[0091]

搜索信息获取模块100,用于获取站内知识库的文档、站内知识库搜索系统的历史搜索记录和站内知识库的故障现象和故障型号;

[0092]

第一集合生成模块200,用于对所述文档的标题和所述历史搜索记录进行整合拼接,得到第一集合;

[0093]

第二集合生成模块300,用于对所述故障现象和故障型号进行分类和统计频数,得到第二集合;

[0094]

搜索提醒集合生成模块400,用于将所述文档的标题、所述第一集合和所述第二集合进行整合,生成搜索提醒集合;

[0095]

重排序模块500,用于对所述搜索提醒集合进行重排序,生成重排序后的搜索提醒集合。

[0096]

在一个实施例中,上述搜索提醒补全的生成和重排序装置,还包括:

[0097]

n-gram语言模型训练模块,用于从所述文档中解析出文本数据,进行分句和分词,用分句和分词后的解析文本数据训练n-gram语言模型

[0098]

在一个实施例中,上述搜索提醒补全的生成和重排序装置,还包括:

[0099]

第一集合生成子模块,用于将所述文档的标题和所述历史搜索记录进行整合和分词,用所述n-gram语言模型进行频率统计排序,得到后缀候选子串集合;根据所述历史搜索记录生成多个前缀子串,根据多个所述前缀子串在所述后缀候选子串集合中进行遍历,寻求与每个所述前缀子串相匹配的所有后缀子串,并进行拼接;用所述n-gram语言模型过滤拼接后的前缀子串和相匹配的所有后缀子串,得到第一集合。

[0100]

在一个实施例中,上述搜索提醒补全的生成和重排序装置,还包括:

[0101]

第二集合生成子模块,用于获取站内知识库的故障型号的故障现象,得到故障现象对应的句子,并统计句频;通过层次聚类对每一个故障现象对应的句子进行聚类,得到分蔟结果和蔟内句频最高的句子;用训练好的bertflow模型分别对句子进行表征,以所述蔟内句频最高的句子为基准,分别和蔟内其他的句子进行相似度计算;根据相似度计算结果对所述蔟内其他的句子进行筛选,得到第二集合。

[0102]

在一个实施例中,上述搜索提醒补全的生成和重排序装置,还包括:

[0103]

重排序子模块,用于计算bm25得分、句频得分和匹配高亮得分;按照所述bm25得分、句频得分和匹配高亮得分,对所述搜索提醒集合进行重排序。

[0104]

在一个实施例中,上述搜索提醒补全的生成和重排序装置,还包括:

[0105]

匹配高亮计算模块,用于句子的匹配高亮的得分计算如下公式:

[0106][0107]

其中,ci是句子si的关键词字数统计,wi为句子si的关键词个数,是每个词的平均高亮长度score为句子s的高亮得分。

[0108]

在一个实施例中,上述搜索提醒补全的生成和重排序装置,还包括:

[0109]

测试模块,用于对所述搜索提醒集合和所述重排序后的搜索提醒集合进行测试。

[0110]

参照图3,本技术实施例中还提供一种计算机设备,该计算机设备可以是服务器,其内部结构可以如图3所示。该计算机设备包括通过系统总线连接的处理器、存储器、网络接口和数据库。其中,该计算机设计的处理器用于提供计算和控制能力。该计算机设备的存储器包括非易失性存储介质、内存储器。该非易失性存储介质存储有操作系统、计算机程序和数据库。该内存储器为非易失性存储介质中的操作系统和计算机程序的运行提供环境。该计算机设备的数据库用于存储搜索提醒补全的生成和重排序方法过程中的使用数据等。该计算机设备的网络接口用于与外部的终端通过网络连接通信。该计算机程序被处理器执行时以实现上述任一实施例的一种搜索提醒补全的生成和重排序方法。

[0111]

本领域技术人员可以理解,图3中示出的结构,仅仅是与本技术方案相关的部分结构的框图,并不构成对本技术方案所应用于其上的计算机设备的限定。

[0112]

本技术一实施例还提供一种计算机可读存储介质,其上存储有计算机程序,计算机程序被处理器执行时实现一种搜索提醒补全的生成和重排序方法。可以理解的是,本实施例中的计算机可读存储介质可以是易失性可读存储介质,也可以为非易失性可读存储介质。

[0113]

本技术提供的一种搜索提醒补全的生成和重排序方法,从站内搜索知识库中挖掘适合用于搜索自动提醒的信息,来辅助用户进行知识库内容搜索。目的是让用户在输入更少的内容的情况下,能更快更好的得到想要的搜索内容。和现有方案的不同点在于,这是一套完整的从搜索提醒集合生成到重排序的方案,适用于站内搜索。而现阶段的搜索自动提醒方案,大多数都是针对通用搜索引擎的搜索自动提醒功能。本方案简单实用且方便自动化更新,适用于大部分基于文档知识库的站内搜索引擎的搜索自动提醒功能的构建。

[0114]

本领域普通技术人员可以理解实现上述实施例方法中的全部或部分流程,是可以通过计算机程序来指令相关的硬件来完成,所述的计算机程序可存储于一非易失性计算机可读取存储介质中,该计算机程序在执行时,可包括如上述各方法的实施例的流程。其中,本技术所提供的和实施例中所使用的对存储器、存储、数据库或其它介质的任何引用,均可包括非易失性和/或易失性存储器。非易失性存储器可以包括只读存储器(rom)、可编程rom(prom)、电可编程rom(eprom)、电可擦除可编程rom(eeprom)或闪存。易失性存储器可包括随机存取存储器(ram)或者外部高速缓冲存储器。作为说明而非局限,ram以多种形式可得,诸如静态ram(sram)、动态ram(dram)、同步dram(sdram)、双速据率sdram(ssrsdram)、增强

型sdram(esdram)、同步链路(synchlink)dram(sldram)、存储器总线(rambus)直接ram(rdram)、直接存储器总线动态ram(drdram)、以及存储器总线动态ram(rdram)等。

[0115]

需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、装置、物品或者方法不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、装置、物品或者方法所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、装置、物品或者方法中还存在另外的相同要素。

[0116]

以上所述仅为本技术的优选实施例,并非因此限制本技术的专利范围,凡是利用本技术说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本技术的专利保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1