一种基于注意力机制的OCR文字识别方法和系统与流程

一种基于注意力机制的ocr文字识别方法和系统

技术领域

1.本发明属于文本识别技术领域,具体涉及一种基于注意力机制的ocr文字识别方法和系统。

背景技术:

2.目前,用户上传营业执照是其获取认证的一种手段,一般需要填写营业执照的内容,对于内容比较多的文本,填写过程耗时又耗力,还容易填错,并且,现有技术对营业执照的文本识别的步骤比较繁杂且计算量较大,降低了文本识别的效率。

3.ocr文字识别技术是指电子设备(例如扫描仪或数码相机)检查纸上打印的字符,然后用字符识别方法将形状翻译成计算机文字的过程。现有基于ocr的识别方法大都是基于传统模型实现的,对于传统模型而言,往往检测时间消耗比较大,检测长文本效果不好,对于多尺度文本小尺度文本的常会出现漏检,或者在背景复杂的情况下,比如图像模糊不清时,准确率低下。

4.对图片文本进行检测时,以往的技术对于小尺度的文本常常出现漏检的情况,对于文本行较长的情况下通常检测到多个边界框,且当图片清晰度不够时检测效果不好,模型的鲁棒性不好,推理时间过长。

技术实现要素:

5.有鉴于此,本发明旨在解决传统ocr文字识别技术存在的文本漏检及边界框检测效果差的问题。

6.为了解决上述技术问题,本发明提供以下技术方案:

7.第一方面,本发明提供了一种基于注意力机制的ocr文字识别方法,包括如下步骤:

8.将输入待识别的图片进行图像预处理,并构建所需要的词库;

9.将处理后的图片送入文本检测网络,得到文本边界框坐标,文本检测网络基于注意力机制对处理后的图片进行文本特征检测;

10.根据文本边界框的坐标对输入图像进行裁剪,得到一系列仅包含一行文本行的图片;

11.将裁剪后的图片依次送入文本识别网络,经词库对比后得到最终的文本识别结果。

12.进一步的,将输入待识别的图片进行图像预处理,并构建所需要的词库,具体包括:

13.读取输入的图像并解码成具有rgb格式的图像矩阵;

14.保持图像的宽、高比,将图像中的短边缩放至736像素;

15.对图像矩阵进行归一化;

16.对所需要识别的文字构建对应的词库。

17.进一步的,将处理后的图片送入文本检测网络,得到文本边界框坐标,文本检测网络基于注意力机制对处理后的图片进行文本特征检测,具体包括:

18.将处理后的图像送入残差骨干网络进行特征的初步提取;

19.残差网络共有四个残差模块,取出每一个残差模块的最后一层特征图,构建成特征金字塔,从上到下分别记为第1、2、3、4层;

20.先对第1、2层的特征进行注意力特征融合并进行卷积操作,得到矫正后的第1、2层特征图;

21.将矫正之后的第2层特征图与第3层特征图进行上述注意力特征融合操作,之后将得到的矫正之后的第3层特征图与第4层特征图进行注意力特征融合操作;

22.对矫正之后特征金字塔的各层上采样至低层特征图的尺度进行拼接;

23.将得到拼接之后的特征图经过坐标注意力进行特征的二次重矫正;

24.设置像素阈值为0.2,将最终的特征图中大于0.2的值置为1,小于等于0.2的值置为0,得到二值化图;

25.在二值化图中1表示文本区域,0表示非文本区域,使用opencv中的函数得到文本轮廓,选取置信度最大的文本框作为最终的文本轮廓,从而得到文本边界框的坐标。

26.进一步的,根据文本边界框的坐标对输入图像进行裁剪,得到一系列仅包含一行文本行的图片,具体包括:

27.根据文本边界框的坐标对输入图像进行裁剪;

28.对裁剪后的图像按照从上到下,从左至右的顺序进行排列;

29.对这些图片缩放至大小为32x100像素。

30.进一步的,将裁剪后的图片依次送入文本识别网络,经词库对比后得到最终的文本识别结果,具体包括:

31.将裁剪后的图片依次送入文本识别网络;

32.经过cnn网络提取文本特征,并将特征图转换为特征序列;

33.送入rnn循环网络中进行文本的预测识别;

34.将预测识别结果输入到ctc算法网络中,经过词库比对后得到最终的识别结果。

35.第二方面,本发明提供了一种基于注意力机制的ocr文字识别系统,包括:

36.预处理单元,用于将输入待识别的图片进行图像预处理,并构建所需要的词库;

37.第一处理单元,用于将处理后的图片送入文本检测网络,得到文本边界框坐标,文本检测网络基于注意力机制对处理后的图片进行文本特征检测;

38.第二处理单元,用于根据文本边界框的坐标对输入图像进行裁剪,得到一系列仅包含一行文本行的图片;

39.识别单元,用于将裁剪后的图片依次送入文本识别网络,经词库对比后得到最终的文本识别结果。

40.进一步的,在预处理单元中,将输入待识别的图片进行图像预处理,并构建所需要的词库,具体包括:

41.读取输入的图像并解码成具有rgb格式的图像矩阵;

42.保持图像的宽、高比,将图像中的短边缩放至736像素;

43.对图像矩阵进行归一化;

44.对所需要识别的文字构建对应的词库。

45.进一步的,在第一处理单元中,将处理后的图片送入文本检测网络,得到文本边界框坐标,文本检测网络基于注意力机制对处理后的图片进行文本特征检测,具体包括:

46.将处理后的图像送入残差骨干网络进行特征的初步提取;

47.残差网络共有四个残差模块,取出每一个残差模块的最后一层特征图,构建成特征金字塔,从上到下分别记为第1、2、3、4层;

48.先对第1、2层的特征进行注意力特征融合并进行卷积操作,得到矫正后的第1、2层特征图;

49.将矫正之后的第2层特征图与第3层特征图进行上述注意力特征融合操作,之后将得到的矫正之后的第3层特征图与第4层特征图进行注意力特征融合操作;

50.对矫正之后特征金字塔的各层上采样至低层特征图的尺度进行拼接;

51.将得到拼接之后的特征图经过坐标注意力进行特征的二次重矫正;

52.设置像素阈值为0.2,将最终的特征图中大于0.2的值置为1,小于等于0.2的值置为0,得到二值化图;

53.在二值化图中1表示文本区域,0表示非文本区域,使用opencv中的函数得到文本轮廓,选取置信度最大的文本框作为最终的文本轮廓,从而得到文本边界框的坐标。

54.进一步的,在第二处理单元中,根据文本边界框的坐标对输入图像进行裁剪,得到一系列仅包含一行文本行的图片,具体包括:

55.根据文本边界框的坐标对输入图像进行裁剪;

56.对裁剪后的图像按照从上到下,从左至右的顺序进行排列;

57.对这些图片缩放至大小为32x100像素。

58.进一步的,在识别单元中,将裁剪后的图片依次送入文本识别网络,经词库对比后得到最终的文本识别结果,具体包括:

59.将裁剪后的图片依次送入文本识别网络;

60.经过cnn网络提取文本特征,并将特征图转换为特征序列;

61.送入rnn循环网络中进行文本的预测识别;

62.将预测识别结果输入到ctc算法网络中,经过词库比对后得到最终的识别结果。

63.综上,本发明提供了一种基于注意力机制的ocr文字识别方法和系统,通过使用带有注意力机制的多尺度特征融合方法能够保留更多文本特征,从而改善文本的漏检情况。另外在获得最终特征图时使用坐标注意力来捕捉远距离的特征相关性,更有利于长文本的检测。同时采用了简单的后处理,提高了文本检测的准确度与推理速度,进而使文本的识别结果更准确。

附图说明

64.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其它的附图。

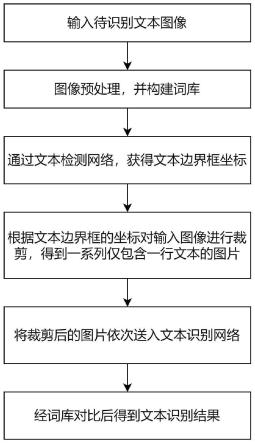

65.图1为本发明实施例提供的一种基于注意力机制的ocr文字识别方法的流程示意

图;

66.图2为本发明实施例提供的文本检测网络的结构示意图;

67.图3为本发明实施例提供的注意力特征融合结构图;

68.图4为本发明实施例提供的卷积操作的示意图;

69.图5为本发明实施例提供的坐标注意力结构图。

具体实施方式

70.为使得本发明的目的、特征、优点能够更加的明显和易懂,下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,下面所描述的实施例仅仅是本发明一部分实施例,而非全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其它实施例,都属于本发明保护的范围。

71.目前,用户上传营业执照是其获取认证的一种手段,一般需要填写营业执照的内容,对于内容比较多的文本,填写过程耗时又耗力,还容易填错,并且,现有技术对营业执照的文本识别的步骤比较繁杂且计算量较大,降低了文本识别的效率。

72.ocr文字识别技术是指电子设备(例如扫描仪或数码相机)检查纸上打印的字符,然后用字符识别方法将形状翻译成计算机文字的过程。现有基于ocr的识别方法大都是基于传统模型实现的,对于传统模型而言,往往检测时间消耗比较大,检测长文本效果不好,对于多尺度文本小尺度文本的常会出现漏检,或者在背景复杂的情况下,比如图像模糊不清时,准确率低下。

73.对图片文本进行检测时,以往的技术对于小尺度的文本常常出现漏检的情况,对于文本行较长的情况下通常检测到多个边界框,且当图片清晰度不够时检测效果不好,模型的鲁棒性不好,推理时间过长。

74.基于此,本发明提供了一种基于注意力机制的ocr文字识别方法和系统。

75.以下对本发明的一种基于注意力机制的ocr文字识别方法的实施例进行详细的介绍。

76.请参阅图1,本实施例提供一种基于注意力机制的ocr文字识别方法,包括:

77.步骤1:将输入待识别的图片进行图像预处理,并构建所需要的词库。

78.步骤2:将处理后的图片送入文本检测网络,得到文本边界框坐标,文本检测网络基于注意力机制对处理后的图片进行文本特征检测。

79.步骤3:根据文本边界框的坐标对输入图像进行裁剪,得到一系列仅包含一行文本行的图片。

80.步骤4:将裁剪后的图片依次送入文本识别网络,经词库对比后得到最终的文本识别结果。

81.在一个可选的实施例中,步骤1所述的预处理并构建词库包括:

82.1.1:读取输入的图像解码成具有rgb格式的图像矩阵。

83.1.2:保持图像的宽、高比,将图像中的短边缩放至736像素。

84.1.3:对图像矩阵进行归一化。

85.1.4:对所需要识别的文字进行构建词库。

86.在一个可选的实施例中,步骤2所述的文本检测网络结构如图2所示。利用该文本检测网络进行进一步处理的过程如下:

87.2.1:将处理后的图像送入残差骨干网络进行特征的初步提取。

88.2.2:残差网络共有四个残差模块,取出每一个残差模块的最后一层特征图,构建成特征金字塔,从上到下分别记为第1、2、3、4层。

89.2.3:先对第1、2层的特征进行注意力特征融合,融合后的结构如图3所示。

90.对第1层的特征图进行上采样,使其宽高同于第2层的特征图,并进行逐像素相加,之后通过两条支路,一条支路为先通过全局池化压缩空间像素至1,再进行卷积模块操作,另一条支路则直接进行卷积模块操作。

91.卷积操作如图4所示:先进行1x1卷积对通道进行压缩以减少内存消耗,归一化之后进行激活函数增加特征间的非线性关系,之后再进行1x1卷积将通道扩展至原通道数量,并再次进行归一化。

92.对经过俩条支路后得到的特征图进行逐像素相加,使用sigmoid激活函数计算出注意力权重,之后使用该权重分别逐像素乘上第1、2层的特征图,得到矫正之后的第1、2层特征图。

93.2.4:将矫正之后的第2层特征图与第3层特征图进行上述注意力特征融合操作,之后将得到的矫正之后的第3层特征图与第4层特征图进行注意力特征融合操作。

94.2.5:对矫正之后特征金字塔的各层上采样至低层特征图的尺度进行拼接。

95.2.6:将得到拼接之后的特征图经过坐标注意力进行特征的二次重矫正。坐标注意力如图5所示:

96.将特征图沿x轴和y轴分别进行全局池化,经过reshape操作之后沿空间维度进行拼接,之后经过卷积模块增加其非线性,随后使用split操作拆分为两路,再经过卷积操作与sigmoid激活函数得到x轴和y轴的注意力权重,依次进行逐像素相乘得到二次矫正后的特征图。

97.2.7:设置像素阈值为0.2,将最终的特征图中大于0.2的值置为1,小于等于0.2的值置为0,得到二值化图。

98.2.8:二值图中1表示文本区域,0表示非文本区域,使用opencv中的函数得到文本轮廓,选取置信度最大的文本框作为最终的文本轮廓。由此可以确定文本边界框的坐标。

99.在一个可选的实施例中,步骤3的具体流程如下:

100.3.1:根据步骤2得到的坐标点对输入图像进行裁剪。

101.3.2:对裁剪后的图像按照从上到下,从左至右的顺序进行排列。

102.3.3:对这些图片缩放至大小为32x100像素。

103.在一个可选的实施例中,步骤4的具体流程如下:

104.4.1:将步骤3中的图片依次送入文本识别网络。

105.4.2:经过cnn网络提取文本特征,并将特征图转换为特征序列。

106.4.3:送入rnn循环网络中进行文本的预测识别。

107.本实施例提供一种基于注意力机制的ocr文字识别方法,通过使用带有注意力机制的多尺度特征融合方法能够保留更多文本特征,从而改善文本的漏检情况。另外在获得最终特征图时使用坐标注意力来捕捉远距离的特征相关性,更有利于长文本的检测。同时

采用了简单的后处理,提高了文本检测的准确度与推理速度,进而使文本的识别结果更准确。

108.相较于现有技术,本实施例提供的文字识别方法具有如下优点:

109.1、采用了新的深度学习模型,与传统采用光学字符识别方法效率更高,所耗时间更少,需要消耗的训练数量更少,文本识别精度更高。

110.2、将融合注意力嵌入到多尺度特征金字塔中,在特征融合时,通过注意力机制来纠正尺度间的不一致性,保留更多的尺度信息,因而对于不同尺度的文本检测效果更好

111.3、在最后使用坐标注意力来得到最终的特征图,该注意力能过够在更远的距离捕捉特征间的相关性,尤其是对于长文本,能够减少边界的检测错误,因此对于不同长度的文本检测效果更好。

112.4、使用了简单的二值化后处理操作,提高了模型的推理时间

113.以上是对本发明的一种基于注意力机制的ocr文字识别方法的实施例进行的详细介绍,以下将对本发明的一种基于注意力机制的ocr文字识别系统的实施例进行详细的介绍。

114.本实施例提供了一种基于注意力机制的ocr文字识别系统,包括:预处理单元、第一处理单元、第二处理单元和识别单元。

115.在本实施例中,预处理单元用于将输入待识别的图片进行图像预处理,并构建所需要的词库。

116.具体的,在预处理单元中,将输入待识别的图片进行图像预处理,并构建所需要的词库,具体包括:

117.读取输入的图像并解码成具有rgb格式的图像矩阵;

118.保持图像的宽、高比,将图像中的短边缩放至736像素;

119.对图像矩阵进行归一化;

120.对所需要识别的文字构建对应的词库。

121.在本实施例中,第一处理单元用于将处理后的图片送入文本检测网络,得到文本边界框坐标,文本检测网络基于注意力机制对处理后的图片进行文本特征检测。

122.具体的,在第一处理单元中,将处理后的图片送入文本检测网络,得到文本边界框坐标,具体包括:

123.将处理后的图像送入残差骨干网络进行特征的初步提取;

124.残差网络共有四个残差模块,取出每一个残差模块的最后一层特征图,构建成特征金字塔,从上到下分别记为第1、2、3、4层;

125.先对第1、2层的特征进行注意力特征融合并进行卷积操作,得到矫正后的第1、2层特征图;

126.将矫正之后的第2层特征图与第3层特征图进行上述注意力特征融合操作,之后将得到的矫正之后的第3层特征图与第4层特征图进行注意力特征融合操作;

127.对矫正之后特征金字塔的各层上采样至低层特征图的尺度进行拼接;

128.将得到拼接之后的特征图经过坐标注意力进行特征的二次重矫正;

129.设置像素阈值为0.2,将最终的特征图中大于0.2的值置为1,小于等于0.2的值置为0,得到二值化图;

130.在二值化图中1表示文本区域,0表示非文本区域,使用opencv中的函数得到文本轮廓,选取置信度最大的文本框作为最终的文本轮廓,从而得到文本边界框的坐标。

131.在本实施例中,第二处理单元用于根据文本边界框的坐标对输入图像进行裁剪,得到一系列仅包含一行文本行的图片。

132.具体的,在第二处理单元中,根据文本边界框的坐标对输入图像进行裁剪,得到一系列仅包含一行文本行的图片,具体包括:

133.根据文本边界框的坐标对输入图像进行裁剪;

134.对裁剪后的图像按照从上到下,从左至右的顺序进行排列;

135.对这些图片缩放至大小为32x100像素。

136.在本实施例中,识别单元用于将裁剪后的图片依次送入文本识别网络,经词库对比后得到最终的文本识别结果。

137.具体的,在识别单元中,将裁剪后的图片依次送入文本识别网络,经词库对比后得到最终的文本识别结果,具体包括:

138.将裁剪后的图片依次送入文本识别网络;

139.经过cnn网络提取文本特征,并将特征图转换为特征序列;

140.送入rnn循环网络中进行文本的预测识别;

141.将预测识别结果输入到ctc算法网络中,经过词库比对后得到最终的识别结果。

142.以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1