一种基于全尺度融合和流场注意力的图像分割方法与流程

1.本发明涉及图像分割领域,特别是涉及一种基于全尺度融合和流场注意力的图像分割方法。

背景技术:

2.近年来,基于深度学习的分割方法在图像分割任务上的应用取得了显著的进展。深度学习分割方法的成功得益于深度神经网络有强大的图像特征提取能力,并通过对图像特征信息的处理得到精细化的分割结果。深度神经网络模型包括有卷积神经网络(convolutional neural networks,cnn)、多层感知机(multilayer perceptron,mlp)、以及transfomer等。现今卷积神经网络已经在图像分割领域取得了一定成就,例如全卷积网络(fcn)、u-net和segnet等。其中u-net是一个具有代表性的图像分割网络。u-net在编码阶段利用分级cnn提取图像特征,解码阶段则通过反卷积和跳跃连接以实现编解码器的特征交互融合,从而得到较好的图像分割预测图。基于u-net,研究者们分别提出了结合注意力机制的attention u-net和增加特征精细化处理的dfm,均使得分割精度有所提升。然而,基于卷积神经网络的方法中的卷积运算的内在局部性,造成它缺乏对全局特征相关性建模的能力。transformer和多层感知机能够利用自注意力机制和全连接网络来捕获图像的全局信息,能提取到卷积神经网络较难获取的图像特征。例如transunet通过将u-net编码器中最深层次的特征替换为从vit中提取的特征。unetxt集成了卷积和多层感知机的医学图像分割网络提升了分割预测精度。然而目前大多基于深度学习的图像分割方法仍存在不足之处:第一,网络输入图像的尺寸要求存有限制。大多数基于transformer的方法都需要数据集有大小规整方正的训练与测试图像,但是广泛收集的真实图像数据大多是尺寸任意的,而图像大小的调整将导致图像变形失真并影响分割结果。第二,编码解码阶段中单一网络挖掘的图像特征信息可能不足。多层感知机网络提取的是全局特征信息,卷积神经网络的优势是聚焦局部的信息。故可以通过合理地结合不同类型网络来获得更全面的特征信息,以提升网络性能。第三,u-net的简单跳跃连接结构难以将各尺度跳连接特征中的粗粒度信息和细粒度信息进行有效融合,各尺度跳连接特征间存在语义差异,从而限制了网络的分割性能,存在一定的缺陷。

3.因此,亟需提出一种基于全尺度融合和流场注意力的图像分割方法,以解决上述问题。

技术实现要素:

4.本发明的目的在于,提供一种基于全尺度融合和流场注意力的图像分割方法,以提高图像分割任务的适用性以及分割精度,同时提高图像分割的鲁棒性。

5.为解决上述技术问题,本发明提供一种基于全尺度融合和流场注意力的图像分割方法,包括如下步骤:

6.获取图像数据集,对数据图像进行预处理;

7.以u-net为骨干网络,构建图像分割模型;

8.将数据集中的训练图像输入至图像分割模型中进行训练;

9.通过选择合适的参数和损失函数调整模型至最优效果并进行保存;

10.将数据集中的验证图像输入到训练好的图像分割模型中,得到分割预测结果。

11.进一步的,所述图形分割模型包括依次连接的特征编码器、全尺度特征融合模块以及特征解码器。

12.进一步的,所述图像分割模型数据处理包括如下步骤:

13.所述特征编码器提取图像的层次特征信息和全局特征信息;

14.所述全尺度特征融合模块将所述特征编码器提取的各层次特征信息以及全局特征信息进行交互融合;

15.所述特征解码器细化各尺度特征映射,得到分割结果。

16.进一步的,所述特征编码器包括依次连接的u-net骨干网络以及卷积mlp模块。

17.进一步的,所述u-net骨干网络用于获取输入图像5层不同尺度的特征映射所述卷积mlp模块用于提取输入图像的全局特征信息并将其与底层特征映射f1级联得到融合特征t1。

18.进一步的,所述全尺度特征融合模块沿着特征高度、宽度和通道维度进行特征融合,生成各支路融合特征其中生成第层的融合特征公式为:

[0019][0020]

其中表示第i层卷积操作用来调整特征映射的通道数,dc和uc分别表示卷积下采样和卷积上采样,cat表示通道叠加操作。

[0021]

进一步的,所述特征解码器将所述特征编码器的输出t1和全尺度特征融合模块的输出逐级输入,输出逐级精细的特征图

[0022]

进一步的,所述特征解码器处理流程包括如下步骤:

[0023]

将特征图p

i-1

上采样至的相同尺寸的融合特征ti,两者级联后通过卷积运算得到特征流场来指导特征图p

i-1

进行形变;

[0024]

将形变后的特征图p

i-1

与ti级联并输入并输入到特征解码器,输出特征pi;

[0025]

将特征图p5的通道数映射为分割的类别数,得到最终的分割结果。

[0026]

进一步的,所述损失函数为gdl损失函数和交叉熵损失函数进行融合构建,所述损失函数为:

[0027]

l=l

ce

+1.1l

gdl

;

[0028]

其中,l

ce

为交叉熵损失函数;l

gdl

为gdl损失函数。

[0029]

进一步的,所述gdl损失函数以及交叉熵损失函数分别为:

[0030][0031][0032]

其中:表示在m个类别中第m个类别的权重,g

mn

表示类别m在第n和位

置像素的真值,而p

mn

表示相应的预测值。

[0033]

相比于现有技术,本发明至少具有以下有益效果:

[0034]

本发明改进了传统网络的编码器和解码器结构,通过结合特定功能的网络结构以及对网络结构的改进,弥补了一般u型网络对于捕捉图像全局特征信息能力不足、图像特征上采样过程中失真等问题,提高了本方法对于不同分割任务的适应性以及图像分割精度。

[0035]

同时,本发明提出的全尺度特征融合模块通过在各级跳跃连接上融合了粗粒度特征和细粒度特征,减小了各尺度特征间的语义差异,突出图像的关键特征信息,使得网络的性能与鲁棒性均显著提高。

附图说明

[0036]

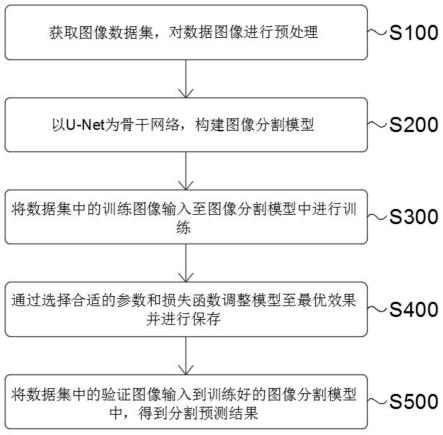

图1为本发明基于全尺度融合和流场注意力的图像分割方法流程图;

[0037]

图2为本发明基于全尺度融合和流场注意力的图像分割方法的图像分割模型网络结构示意图;

[0038]

图3为本发明基于全尺度融合和流场注意力的图像分割方法的卷积mlp模块结构示意图;

[0039]

图4为本发明基于全尺度融合和流场注意力的图像分割方法的全尺度特征融合模块单支示意图;

[0040]

图5为本发明基于全尺度融合和流场注意力的图像分割方法的流场注意力模块结构示意图。

具体实施方式

[0041]

下面将结合示意图对本发明的基于全尺度融合和流场注意力的图像分割方法进行更详细的描述,其中表示了本发明的优选实施例,应该理解本领域技术人员可以修改在此描述的本发明,而仍然实现本发明的有利效果。因此,下列描述应当被理解为对于本领域技术人员的广泛知道,而并不作为对本发明的限制。

[0042]

在下列段落中参照附图以举例方式更具体地描述本发明。根据下面说明和权利要求书,本发明的优点和特征将更清楚。需说明的是,附图均采用非常简化的形式且均使用非精准的比例,仅用以方便、明晰地辅助说明本发明实施例的目的。

[0043]

如图1所示,本发明实施例提出了一种基于全尺度融合和流场注意力的图像分割方法,包括如下步骤:

[0044]

获取图像数据集,对数据图像进行预处理;

[0045]

以u-net为骨干网络,构建图像分割模型;

[0046]

将数据集中的训练图像输入至图像分割模型中进行训练;

[0047]

通过选择合适的参数和损失函数调整模型至最优效果并进行保存;

[0048]

将数据集中的验证图像输入到训练好的图像分割模型中,得到分割预测结果。

[0049]

以下列举所述基于全尺度融合和流场注意力的图像分割方法在医学图像分割中的较优实施例,以清楚的说明本发明的内容,应当明确的是,本发明的内容并不限制于以下实施例,其他通过本领域普通技术人员的常规技术手段的改进亦在本发明的思想范围之内。

[0050]

s100、获取医学图像数据集,对数据图像进行预处理。

[0051]

具体的,若医学图像数据集是三维图像时,可以沿着图像的轴位方向切片采样1mm形成二维切片;若医学图像数据集是二维图像时,则不做切片操作;若获取的脑医学图像带有脑壳结构,可以通过算法处理去除脑壳;预处理后对数据图像进行归一化处理,使得输入图像像素均值为0,方差为1,且采用随机旋转和随机翻转等方式扩充数据量。数据集全部按照6:4的比例划分为训练集和测试集。

[0052]

s200、以u-net为骨干网络,构建包含有卷积mlp模块,全尺度特征融合以及流场注意力解码模块的图像分割模型。

[0053]

具体的,如图2所示,该方法图像分割模型分为三个处理阶段:第一阶段采用集成u-net骨干网络和卷积mlp模块的特征编码器来提取图像的层次特征信息和全局特征信息;第二阶段全尺度特征融合模块将一阶段提取的各层次信息特征进行交互融合,生成各级用于跳连接的特征映射;第三阶段利用了包含流场变换和注意力机制的流场注意力模块(flow and attention decoding unit,fadu),构成的特征解码器细化了各尺度输入的特征映射,通过通道映射得到预测分割结果。

[0054]

特征编码器分为u-net骨干网络以及卷积mlp模块两部分。给定输入图像经过u-net得到5层不同尺度的特征映射同时利用卷积mlp模块提取输入图像i的全局特征信息并将其与底层特征映射f1级联得到t1。如图3所示,卷积mlp模块包含一组由3

×

3卷积下采样、3

×

3深度可分离卷积和池化下采样组成的卷积块,以及三组包含mlp和卷积下采样的卷积mlp块。特征编码器在提取图像的局部空间特征信息同时保留了图像全局特征信息。

[0055]

全尺度特征融合模块由四条独立分支组成,按照特定的特征高度、宽度和通道维度进行特征融合,生成各支路融合特征即各级用于跳连接的特征映射。参阅图4,来阐述单分支结构工作流程,down和up分别表示将特征图下采样和上采样到特征f2的高度和宽度,null表示不做采样操作。c表示卷积操作,这里统一均为3

×

3卷积,输出通道数为64。经过cat操作,输入的5层特征按通道级联叠加为单一特征映射(通道数为320),表示卷积操作用来调整特征映射的通道数,将通道数调整为对应特征映射f2的通道大小,最后再与特征映射f2相加得到跳连接特征t2。故生成第i层的融合特征ti公式为:

[0056][0057]

其中公式(1)中表示第i层卷积操作用来调整特征映射的通道数,将通道数调整为对应特征映射fi的通道大小,dc和uc分别表示卷积下采样和卷积上采样,cat表示通道叠加操作。

[0058]

特征解码器由流场注意力模块(fadu)构成,该解码器将特征编码器的输出t1和全尺度特征融合模块的输出逐级输入,输出逐级精细的特征图实现特征细化的同时避免信息冗余。如图5所示,流场注意力解码模块工作方式如下:首先将输入特征p

i-1

上采样至ti的相同尺寸,两者级联后通过卷积运算得到特征流场来指导特征p

i-1

进行形

变,其形变公式如下:

[0059]

warp(p

i-1

)=p

i-1

(p

x

+φ(p)

x

,p

x

+φ(p)

x

)

[0060]

(2)

[0061]

其中公式(2)中p下标的x和y是像素点的坐标,流场形变减少了特征图在上采样过程中失真的问题;再将形变后的特征p

i-1

与ti级联输入3

×

3卷积块输出特征pi′

。卷积运算公式为:

[0062]

pi′

=σ(c(w

p

p

i-1

)+c(w

t

ti))

[0063]

(3)

[0064]

其中公式(3)中σ表示relu激活函数,c表示卷积运算,w

p

和w

t

分别表示隐藏状态p

i-1

和跳连接特征ti的权重矩阵。由于简单将高层特征和浅层特征融合的方式通常会带来信息的冗余和混乱,故将特征pi

′

输入卷积注意力模块(cbam)得到pi,注意力机制提高了模块对有效信息的利用效率。总的来看,pi可以逐层通过输入的p

i-1

和ti来生成,公式如下所示:

[0065]

pi=fadu(p

i-1

,ti;φ)

[0066]

(4)

[0067]

其中公式(4)中i的取值为1到5,p0则是初始化为0的张量。编码过程的最后利用3

×

3卷积将特征图p5的通道数映射为分割的类别数,得到最终的分割结果。

[0068]

s300、将数据集中的训练图像输入至图像分割模型中进行训练。

[0069]

具体的,在训练过程中,模型采用的是adam优化算法促使损失函数趋向最小来更新网络参数,初始学习率设置为0.0006,权重衰减值为0.0005。同时,训练中的每批数据量大小设置为1以及总的迭代次数是30000。

[0070]

s400、通过选择合适的参数和损失函数调整模型至最优效果并进行保存。

[0071]

具体的,影响图像分割模型总体性能结果的因素不仅有网络结构设计,还有损失函数也发挥着关键作用。该网络的损失函数为交叉熵损失函数和gdl损失函数进行融合构建,其中交叉熵损失函数为其中g

mn

表示类别m在第n和位置像素的真值,而p

mn

表示相应的预测值,而gdl的损失函数为:其中表示在m类别中第m类别的权重,最终形成的融合损失函数公式为:l=l

ce

+1.1l

gdl

。

[0072]

s500、将数据集中的验证图像输入到训练好的图像分割模型中,得到分割预测结果。

[0073]

相比于现有技术,本发明至少具有以下有益效果:

[0074]

本发明改进了传统网络的编码器和解码器结构,通过结合特定功能的网络结构以及对网络结构的改进,弥补了一般u型网络对于捕捉图像全局特征信息能力不足、图像特征上采样过程中失真等问题,提高了本方法对于不同分割任务的适应性以及图像分割精度。

[0075]

同时,本发明提出的全尺度特征融合模块通过在各级跳跃连接上融合了粗粒度特征和细粒度特征,减小了各尺度特征间的语义差异,突出图像的关键特征信息,使得网络的性能与鲁棒性均显著提高。

[0076]

显然,本领域的技术人员可以对本发明进行各种改动和变型而不脱离本发明的精

神和范围。这样,倘若本发明的这些修改和变型属于本发明权利要求及其等同技术的范围之内,则本发明也意图包含这些改动和变型在内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1