一种基于无监督的单目深度估计构建方法及系统

1.本发明涉及计算机视觉场景感知领域,尤其涉及一种基于无监督的单目深度估计构建方法及系统。

背景技术:

2.单目深度估计旨在令计算机从单张图像中获取每一像素点到摄像机的距离信息,然而从三维的现实世界投影到二维图像会丢失掉原有的深度信息。从图像恢复深度信息并不简单,重新获取深度信息主要存在两种方式:主动深度获取和被动测距。主动深度获取是依赖于设备(激光雷达、深度相机等)对场景深度信息的捕获。依赖设备的主动方式需要昂贵的设备仪器。被动测距包含从单幅图像的深度估计。由于普通相机便携且价格低廉,实施起来更为可行而具有广阔的应用前景。

3.目前单目深度估计取得很大的进步,其是否依赖深度真值可分为有监督方式和无监督方式。无监督不需要深度真值就能获得较好的深度估计的效果。但目前基于无监督的深度估计方法由于训练集的限制只能考虑单一环境,这就导致无监督的深度估计无法泛化到更复杂多样的环境下。目前,复杂环境对视觉感知仍旧构成巨大的挑战,基于学习的方法无法完美的泛化到不同的环境。

技术实现要素:

4.本发明提供了一种基于无监督的单目深度估计构建方法,用于解决现有自监督单目深度估计泛化性不足和深度估计的准确性不高的问题。

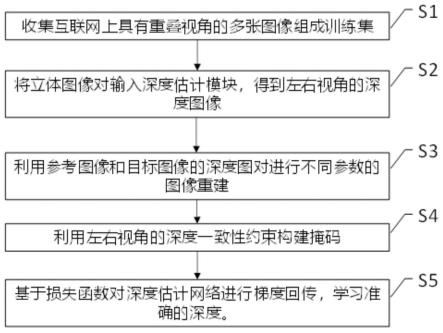

5.本发明提供了一种基于无监督的单目深度估计构建方法,包括以下步骤:

6.步骤s1,收集互联网上具有重叠视角的多张图像组成训练集。

7.步骤s2:将立体图像对输入深度估计模块m2,以获得估计的深度。

8.步骤s3:利用参考图像和目标图像的深度图对进行不同参数的图像重建。

9.步骤s4,利用左右视角的深度一致性约束构建掩码。

10.步骤s5,基于损失函数对深度估计网络进行梯度回传,以学习准确的深度。

11.作为本发明的进一步改进,在所述步骤s1中,具体还包括:

12.步骤s10,在互联网收集具有重叠视角的图像,并将收集到的图像缩放裁剪到设定尺寸和分辨率。

13.步骤s11,估计各个图像之间的相机内外参数。

14.步骤s12,筛选符合条件的立体图像对组成训练集。

15.作为本发明的进一步改进,在所述步骤s11中,首先利用sfm技术求取相机内参{k}和相机外参{r,t},然后根据相机外参{r,t}对具有重叠视角的立体图像对进行符合条件的筛选,筛选立体图像对的条件为:图像间的旋转角度限制为3

°

之内,并将每个立体图像对的平移距离限制为0.3之内,再将满足条件的立体图像对加入训练集之中,获得筛选后的立体图像。

16.作为本发明的进一步改进,在所述步骤s2中,利用深度估计模块m2中的encode网络提取图像特征,利用深度估计模块m2中的decode网络融合多尺度图像特征,分别输入左右视图,通过encode网络提取每幅图像的多尺度深度特征,利用decode对多尺度图像特征进行融合,输出左右视图的深度图。

17.作为本发明的进一步改进,在所述步骤s3中,由得到的深度图以及参考图像来合成目标图像,不同视角下的两幅图像的对应点存在以下关系:

18.x2~h

∞

x1+e

′

/z

ꢀꢀꢀꢀꢀꢀ

(1)

19.其中,x1,x2分别为左右图像的对应点,为无穷单应,e

′

=k2t2,是另外一幅图像的对极点,z为物体在三维空间的真实深度;

20.由(1)式,重建合成图像i2→1:

21.i2→1(x1)=i2(x2)

ꢀꢀꢀꢀꢀꢀꢀ

(2)。

22.作为本发明的进一步改进,在所述步骤s4中,具体包括:

23.步骤s40,根据参考视角下估计出来的深度图重建目标视角下的合成深度图,数学公式表示为:

[0024][0025]

其中,mi为第i个相机参数左边3

×

3的矩阵,为mi矩阵的第3行,为第i个相机参数pi的伪逆矩阵的第四行。

[0026]

步骤s41,比较目标视角下的合成深度图和深度估计模型的目标深度图的差异,筛选出差异较小的像素点,同时剔除超出投影超出图像边界的像素点,具体形式为:

[0027][0028]

其中,δ是衡量是否存在遮挡的阈值,d1为图1的深度图,d2→1是用图2的深度图,输入深度一致性模块估计出来的在图1视角下的深度图。

[0029]

作为本发明的进一步改进,在所述步骤s5中,具体还包括:

[0030]

步骤s50,计算目标图像和重建的目标图像的光度损失,其公式如下:

[0031][0032]

其中,ssim为图像结构相似性度量,α为衡量图像间ssim和l1范数之间的权重,i1是图像1,i2→1是用图2重建出的图1视角下的合成图。

[0033]

步骤s51,计算目标图像和估计深度图的平滑损失,其公式如下:

[0034][0035]

其中,分别为深度图d

*

沿x轴,y轴的梯度,分别为深度图i沿x轴,y轴的梯度。

[0036]

步骤s52,计算左右视角下估计深度图的一致性损失,其公式如下:

[0037]

lc=|d

1-d2→1|

ꢀꢀꢀ

(7)

[0038]

最终,自监督算法的总训练损失为:

[0039]

l=l

p

⊙

mask+ls+lcꢀꢀꢀ

(8)

[0040]

其中,

⊙

为哈达玛积。

[0041]

本发明还公开了一种基于无监督的单目深度估计构建系统,包括:

[0042]

数据处理模块m1:用于收集互联网上具有重叠视角的多张图像,并将其组成训练集。

[0043]

深度估计模块m2:用于将立体图像对输入深度估计模块,以获得估计的深度。

[0044]

图像重建模块m3:用于利用参考图像和目标图像的深度图对进行不同参数的图像重建。

[0045]

左右深度一致模块m4:用于利用左右视角的深度一致性约束构建掩码。

[0046]

掩码模块m5:用于基于损失函数对深度估计网络进行梯度回传,以学习准确的深度。

[0047]

作为本发明的进一步改进,在所述数据处理模块m1中,还包括:

[0048]

图像收集及处理单元:用于在互联网收集具有重叠视角的图像,并将收集到的图像缩放裁剪到设定尺寸和分辨率。

[0049]

参数单元:用于估计各个图像之间的相机内外参数。

[0050]

筛选单元:用于筛选符合条件的立体图像对组成训练集。

[0051]

在所述深度估计模块m2中,利用所述深度估计模块m2中的encode网络提取图像特征,利用所述深度估计模块m2中的decode网络融合多尺度图像特征,分别输入左右视图,通过encode网络提取每幅图像的多尺度深度特征,利用decode对多尺度图像特征进行融合,输出左右视图的深度图。

[0052]

在所述图像重建模块m3中,由得到的深度图以及参考图像来合成目标图像,不同视角下的两幅图像的对应点存在以下关系:

[0053]

x2~h

∞

x1+e

′

/z

ꢀꢀꢀꢀꢀ

(1)

[0054]

其中,x1,x2分别为左右图像的对应点,为无穷单应,e

′

=k2t2,是另外一幅图像的对极点,z为物体在三维空间的真实深度;

[0055]

由(1)式,重建合成图像i2→1:

[0056]

i2→1(x1)=i2(x2)

ꢀꢀꢀꢀꢀꢀꢀ

(2)。

[0057]

在所述左右深度一致模块m4中,根据参考视角下估计出来的深度图重建目标视角下的合成深度图,数学公式表示为:

[0058][0059]

其中,mi为第i个相机参数左边3

×

3的矩阵,为mi矩阵的第3行,为第i个相机参数pi的伪逆矩阵的第四行。

[0060]

比较目标视角下的合成深度图和深度估计模型的目标深度图的差异,筛选出差异较小的像素点,同时剔除超出投影超出图像边界的像素点,具体形式为:

[0061][0062]

其中,δ是衡量是否存在遮挡的阈值,d1为图1的深度图,d2→1是用图2的深度图,输

入深度一致性模块估计出来的在图1视角下的深度图。

[0063]

在所述掩码模块m5中,具体还包括:

[0064]

光度损失单元:用于计算目标图像和重建的目标图像的光度损失,其公式如下:

[0065][0066]

其中,ssim为图像结构相似性度量,α为衡量图像间ssim和l1范数之间的权重,i1是图像1,i2→1是用图2重建出的图1视角下的合成图。

[0067]

平滑损失单元:用于计算目标图像和估计深度图的平滑损失,其公式如下:

[0068][0069]

其中,分别为深度图d

*

沿x轴,y轴的梯度,分别为深度图i沿x轴,y轴的梯度。

[0070]

一致性损失单元:用于计算左右视角下估计深度图的一致性损失,其公式如下:

[0071]

lc=|d

1-d2→1|

ꢀꢀꢀ

(7)

[0072]

最终,自监督算法的总训练损失为:

[0073]

l=l

p

⊙

mask+ls+lcꢀꢀꢀ

(8)

[0074]

其中,

⊙

为哈达玛积。

[0075]

作为本发明的进一步改进,在所述参数单元中,首先利用sfm技术求取相机内参{k}和相机外参{r,t},然后根据相机外参{r,t}对具有重叠视角的立体图像对进行符合条件的筛选,筛选立体图像对的条件为:图像间的旋转角度限制为3

°

之内,并将每个立体图像对的平移距离限制为0.3之内,再将满足条件的立体图像对加入训练集之中,获得筛选后的立体图像。

[0076]

本发明的有益效果是:本发明的单目深度估计构建方法能利用海量的互联网图像扩充数据集并加强内在几何一致约束,从而有效提高模型对图像深度估计的准确性和应对复杂多变环境的鲁棒性。

附图说明

[0077]

图1是本发明单目深度估计构建方法流程图;

[0078]

图2是本发明单目深度估计构建方法损失函数的组成示意图;

[0079]

图3是本发明单目深度估计构建系统原理框图;

[0080]

图4是本发明单目深度估计训练框架图。

具体实施方式

[0081]

名词解释:

[0082]

sfm:structure from motion的缩写,是一种三维重建的技术,利用多张图像来估计三维结构,同时估计出相机的内外参数。

[0083]

本发明公开了一种基于无监督的单目深度估计构建方法,该方法收集互联网上具有重叠视角的多张图像,对收集到的图像进行筛选和裁剪,基于此,利用sfm技术对图像进行标定,获得图像对应的内外参数,利用得到的图像以及标定的内外参数对图像数据集进行两两重组,筛选出满足预设条件的立体图像对,将左右视角下形成的图像立体对加入训

练:以resnet18作为encode网络提取图像特征,利用decode网络融合多尺度图像特征并估计出深度图像,利用右视角的深度值估算左视角的深度值。基于左右一致损失函数加强其内在一致性,将左右深度图输入掩码模块,以得到图像有效点,基于重建图像计算光度损失和平滑项损失对网络进行训练监督,以获得准确的深度值。与现有技术相比,本发明的单目深度估计构建方法能利用海量的互联网图像扩充数据集并加强内在几何一致约束,从而有效提高模型对图像深度估计的准确性和应对复杂多变环境的鲁棒性。

[0084]

本发明公开的一种基于无监督的单目深度估计构建方法将rgb域表示为e3×h×w,h和w分别表示图像高度和宽度,深度域表示为dh×w,本发明旨在学习非线性映射φ:r3×h×w→dh

×w。

[0085]

如图1所示,本发明公开的一种基于无监督的单目深度估计构建方法,包括以下步骤:

[0086]

步骤s1,收集互联网上具有重叠视角的多张图像组成训练集。

[0087]

具体地,在互联网收集一系列具有重叠视角的图像,并将收集到的图像缩放裁剪到尺寸为560

×

720的分辨率,利用sfm技术求取相机内参{k}和相机外参{r,t}。并根据相机外参{r,t}对具有重叠视角的立体图像对进行符合条件的筛选,筛选立体图像对的条件为:图像间的旋转角度限制为3

°

之内,并将每立体图像对的平移距离限制为0.3之内。将满足条件的立体图像对加入训练集之中,获得87344对立体图像。在训练期间,将图像输入分辨率缩放到192

×

640,内参矩阵k除以相应的比例因子。

[0088]

步骤s2:将立体图像对输入深度估计模块,以获得估计的深度。

[0089]

将神经网络分为两个部分,前一个部分是encode,编码层,由多层神经网络组合而成,用于提取图像特征,后一个部分是decode,解码层,由多层神经网络组合而成,将encode提取到的图像信息进行融合,输出深度图。具体地,利用深度估计模块中的encode网络提取图像特征,利用深度估计模块中的decode网络融合多尺度图像特征,分别输入左右视图,通过encode网络提取每幅图像的多尺度深度特征;利用decode对多尺度图像特征进行融合,输出左右视图的深度图。

[0090]

步骤s3,利用参考图像和目标图像的深度图对进行不同参数的图像重建;

[0091]

具体地,由得到的深度图以及参考图像来合成目标图像,不同视角下的两幅图像的对应点存在以下关系:

[0092]

x2~h

∞

x1+e

′

/z

ꢀꢀꢀꢀꢀꢀ

(1)

[0093]

其中,x1,x2分别为左右图像的对应点,为无穷单应,e

′

=k2t2,是另外一幅图像的对极点,z为物体在三维空间的真实深度。

[0094]

由(1)式,重建合成图像i2→1:

[0095]

i2→1(x1)=i2(x2)

ꢀꢀ

(2)。

[0096]

步骤s4,利用左右视角的深度一致性约束构建掩码;

[0097]

具体地,根据参考视角下估计出来的深度图重建目标视角下的合成深度图,数学公式表示为:

[0098]

[0099]

其中,mi为第i个相机参数左边3

×

3的矩阵,为mi矩阵的第3行,为第i个相机参数pi的伪逆矩阵的第四行,i代表1或2,表示第一个相机和第二个相机相应的参数。

[0100]

如图4所示,比较目标视角下的合成深度图和深度估计模型的目标深度图的差异,筛选出差异较小的像素点,同时剔除超出投影超出图像边界的像素点。具体形式为:

[0101][0102]

其中,δ是衡量是否存在遮挡的阈值,d1为图1的深度图,d2→1是用图2的深度图,输入深度一致性模块估计出来的在图1视角下的深度图。

[0103]

步骤s5,基于损失函数对深度估计网络进行梯度回传,以学习准确的深度。

[0104]

如图2所示,在所述步骤s5中,具体还包括:

[0105]

步骤s50,计算目标图像和重建的目标图像的光度损失,其公式如下:

[0106][0107]

其中,ssim为图像结构相似性度量,α为衡量图像间ssim和l1范数之间的权重,i1是图像1,i2→1是用图2重建出的图1视角下的合成图;

[0108]

步骤s51,计算目标图像和估计深度图的平滑损失,其公式如下:

[0109][0110]

其中,分别为深度图d

*

沿x轴,y轴的梯度,分别为深度图i沿x轴,y轴的梯度;

[0111]

步骤s52,计算左右视角下估计深度图的一致性损失,其公式如下:

[0112]

lc=|d

1-d2→1|

ꢀꢀꢀ

(7)

[0113]

最终,自监督算法的总训练损失为:

[0114]

l=l

p

⊙

mask+ls+lcꢀꢀꢀ

(8)

[0115]

其中,

⊙

为哈达玛积。

[0116]

本发明的一种基于无监督的单目深度估计构建方法通过将尽可能多的数据加入到模型的训练之中,可以提高模型的泛化性;引入掩码,可以在训练过程中减弱训练集中遮挡或超出边界的不良影响,进一步提高深度估计的准确性;在此基础上,进一步引入左右深度一致损失,深度挖掘左右视角下的深度约束,与其他传统方案相比,该约束有助于估计更合理的深度,从而得到更加精准的深度图。

[0117]

如图3所示,本发明还公开了一种基于无监督的单目深度估计构建系统,包括数据处理模块m1、深度估计模块m2、图像重建模块m3、左右深度一致模块m4、掩码模块m5,其中,

[0118]

数据处理模块m1:用于收集互联网上具有重叠视角的多张图像,并将其组成训练集。

[0119]

在所述数据处理模块m1中,还包括:

[0120]

图像收集及处理单元:用于在互联网收集具有重叠视角的图像,并将收集到的图像缩放裁剪到设定尺寸和分辨率。

[0121]

参数单元:用于估计各个图像之间的相机内外参数。

[0122]

在所述参数单元中,首先利用sfm技术求取相机内参{k}和相机外参{r,t},然后根

据相机外参{r,t}对具有重叠视角的立体图像对进行符合条件的筛选,筛选立体图像对的条件为:图像间的旋转角度限制为3

°

之内,并将每个立体图像对的平移距离限制为0.3之内,再将满足条件的立体图像对加入训练集之中,获得87344对立体图像。

[0123]

筛选单元:用于筛选符合条件的立体图像对组成训练集。

[0124]

深度估计模块m2:用于将立体图像对输入深度估计模块,以获得估计的深度。

[0125]

在所述深度估计模块m2中,利用所述深度估计模块m2中的encode网络提取图像特征,利用所述深度估计模块m2中的decode网络融合多尺度图像特征,分别输入左右视图,通过encode网络提取每幅图像的多尺度深度特征,利用decode对多尺度图像特征进行融合,输出左右视图的深度图。

[0126]

图像重建模块m3:用于利用参考图像和目标图像的深度图对进行不同参数的图像重建。

[0127]

在所述图像重建模块m3中,由得到的深度图以及参考图像来合成目标图像,不同视角下的两幅图像的对应点存在以下关系:

[0128]

x2~h

∞

x1+e

′

/z

ꢀꢀꢀꢀꢀꢀ

(1)

[0129]

其中,x1,x2分别为左右图像的对应点,为无穷单应,e

′

=k2t2,是另外一幅图像的对极点,z为物体在三维空间的真实深度;

[0130]

由(1)式,重建合成图像i2→1:

[0131]

i2→1(x1)=i2(x2)

ꢀꢀꢀꢀꢀꢀ

(2)。

[0132]

左右深度一致模块m4:用于利用左右视角的深度一致性约束构建掩码。

[0133]

在所述左右深度一致模块m4中,根据参考视角下估计出来的深度图重建目标视角下的合成深度图,数学公式表示为:

[0134][0135]

其中,mi为第i个相机参数左边3

×

3的矩阵,为mi矩阵的第3行,为第i个相机参数pi的伪逆矩阵的第四行。

[0136]

比较目标视角下的合成深度图和深度估计模型的目标深度图的差异,筛选出差异较小的像素点,同时剔除超出投影超出图像边界的像素点,具体形式为:

[0137][0138]

其中,δ是衡量是否存在遮挡的阈值,d1为图1的深度图,d2→1是用图2的深度图,输入深度一致性模块估计出来的在图1视角下的深度图。

[0139]

掩码模块m5:用于基于损失函数对深度估计网络进行梯度回传,以学习准确的深度。

[0140]

在所述掩码模块m5中,具体还包括:

[0141]

光度损失单元:用于计算目标图像和重建的目标图像的光度损失,其公式如下:

[0142][0143]

其中,ssim为图像结构相似性度量,α为衡量图像间ssim和l1范数之间的权重,i1是

图像1,i2→1是用图2重建出的图1视角下的合成图。

[0144]

平滑损失单元:用于计算目标图像和估计深度图的平滑损失,其公式如下:

[0145][0146]

其中,分别为深度图d

*

沿x轴,y轴的梯度,分别为深度图i沿x轴,y轴的梯度。

[0147]

一致性损失单元:用于计算左右视角下估计深度图的一致性损失,其公式如下:

[0148]

lc=|d

1-d2→1|

ꢀꢀꢀ

(7)

[0149]

最终,自监督算法的总训练损失为:

[0150]

l=l

p

⊙

mask+ls+lcꢀꢀꢀ

(8)

[0151]

其中,

⊙

为哈达玛积。

[0152]

本发明的有益效果是:本发明的单目深度估计构建方法能利用海量的互联网图像扩充数据集并加强内在几何一致约束,从而有效提高模型对图像深度估计的准确性和应对复杂多变环境的鲁棒性。

[0153]

以上内容是结合具体的优选实施方式对本发明所作的进一步详细说明,不能认定本发明的具体实施只局限于这些说明。对于本发明所属技术领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干简单推演或替换,都应当视为属于本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1