融合情感资源的多模态情感分析模型的制作方法

文档序号:32847374发布日期:2023-01-06 22:30阅读:52来源:国知局

导航: X技术> 最新专利>计算;推算;计数设备的制造及其应用技术

1.本发明涉及情感分析技术领域,具体为融合情感资源的多模态情感分析模型。

背景技术:

2.情感是人际交流中最为重要的信息之一,情感表达有助于人们了解到彼此对于事物的态度,促进人与人之间的沟通和理解。随着人工智能技术的发展,特别是以facebook、youtube等为代表的社交媒体平台的迅速兴起以及智能客服、餐饮服务机器人等人工智能产品的普及,情感分析技术越来越被重视。通过情感分析技术,各类产品和媒体平台能够对用户的情感和意图拥有更加精准的理解能力,正因为如此,情感分析受到了学术界和工业界广泛的关注和深入研究。

3.情感分析旨在识别用户对于事物或人的看法和态度,该类研究在理解不同群体的人及其意图方面发挥着重要的作用。传统的情感分析主要通过单模态数据来对研究对象的情绪进行分析和识别,但是由于单模态数据鲁棒性不足,容易受到主观意识和外界环境的影响,因此往往导致识别率不高。例如在面部遮挡、语音受到噪声干扰等场景下,单一模态包含的有效信息会减少,导致情感分析准确率下降。

4.为了充分利用多种模态数据内蕴含的信息,提高情感分析的准确率,多模态情感分析引起了广泛的关注。多模态情感分析旨在通过语音信号、视觉信号等多种维度的信息来判断人的态度或情绪的倾向性。与单模态数据相比,多模态数据含有更为丰富的情感信息,通过有效的融合手段来挖掘多种模态数据间的互补信息,从而可以有效地提高情感分析的准确率,减少分类错误。目前,针对多模态数据进行融合的方法有很多,如基于图的多模态融合,基于lstm的多模态融合等,近年来一些研究和实验表明,基于注意力的多模态融合方法在性能和效率方面更加占有优势,其中,以文本为中心进行的多模态注意力融合方法效果显著。

5.尽管上述研究已经在多模态情感分析方面已经取得了进展,但是多模态情感分析仍然存在挑战。情感资源(如正面词、负面词、程度副词)作为文本中表达情感极性的重要信息,在句子级别情感分类、方面级别情感分类以及意见提取等文本情感分类领域发挥了重要作用,然而在多模态情感分析领域,很少有研究注意到情感资源的有用性,并将文本模态中包含的情感知识作为关键信息纳入到多模态情感分析任务中,以至于无法充分挖掘和利用情感信息。

6.为了解决上述问题,本技术设计了一种基于注意力的以情感资源作为主导信息来进行模态融合的多模态情感分析模型,从文本中充分挖掘情感资源信息,并其作为增强信息与文本模态进行融合,通过基于多头注意力的架构来建模不同模态间复杂的依赖关系,学习不同模态间的信息差异,以实现多模态特征的学习和融合。

技术实现要素:

7.本发明的目的在于提供融合情感资源的多模态情感分析模型,以解决上述背景技

术中提出的问题。

8.为实现上述目的,本发明提供如下技术方案:融合情感资源的多模态情感分析模型,包括:

9.用来进行文本、视觉与听觉模态特征初步提取的单一模态特征提取层模块;

10.利用transformer捕捉模态内部的动力,并设计情感词分类预测任务进行情感嵌入学习和提取的单一模态特征深度提取层模块;

11.利用情感嵌入来完成多模态特征交互学习,使得其他模态特征能够感知文本中情感信息的跨模态交互学习层模块;

12.将前三层学习到的情感特征表示最终输入深度神经网络完成最终预测任务的预测层模块。

13.进一步的,所述单一特征深度提取层模块包括以观点词典为依据获取情感资源对资源进行分类然后通过公式进行分析并将情感词分类预测的情感资源的获取与表达模块与可捕获单一模态长距离中相互依赖特征的单峰语言特征学习模块。

14.进一步的,所述跨模态交互学习层模块包括用情感嵌入代替文本特征的多模态情感感知模块、利用视觉模块进行模态间学习情感特征的视觉模态学习模块与利用听觉模块进行模态间学习情感特征的听觉模态学习模块。

15.进一步的,多模态情感分析方法包括如下步骤:

16.s1:单一模态特征提取:

17.对于给定的话语,通常包含文本、视觉与听觉三种模态话语,对于文本模态,考虑到大型预训语音模型bert具有强大语言表征能力与特征提取能力,使用bert进行初始特征提取,对于声学模态和视觉模态,考虑到模态内部的上下相关性和时序性,本技术使用bi-lstm来进行特征提取;

18.s2:深度特征提取:

19.a1:情感资源的获取与表达:除了传统的多模态情感分析普遍采用的文本、视觉和声学三个模态之外,本技术认为情感词也可以为特征学习提供更加精确的识别方向,通过对情感知识的学习,初始文本特征向量能够学习到自身所包含的情感词信息,从而使得其富含更加明确的语义信息以及更少的噪声干扰;

20.本技术选择以刘冰观点词典为情感资源的主要依据,为实验数据集的文本模态进行情感词标签标注,刘冰观点词典中列举了正面和负面两类英文情感词,并且包含了拼写错误、俚语变形等非正常情感词,因此本技术根据观点词典对原始文本中的情感词和非情感词的位置进行标注,并在短句末尾填充0字符以保证标签长度的一致性;

21.此外,本技术设计了用于情感词预测的分类辅助任务。为了确保能够有效地将情感信息融合至高维度的特征表示中,本技术选择在遵循非线性的基础上进行特征压缩,确保情感特征值在0~1之间,符合概率规律,达到降低信息损失的目的;

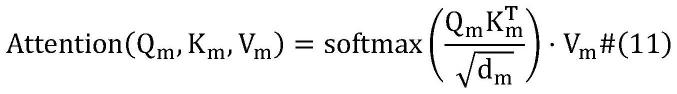

22.a2:单峰语言特征学习:transformer改进了rnn训练慢的特点,并且可以提高计算的并行性,非常适合用于非对齐模态的特征学习,在自然语言处理领域发挥着举足轻重的作用,因此为了捕获单一模态长距离中相互依赖的特征,从上下文表示中提取到更加丰富的语义信息,本技术没有选择基于rnn的结构来捕获模态序列信息,而是选择采用基于transformer的结构分别生成每个模态的序列特征。此外,与单头注意力机制不同,多头自

注意力机制作为transformer的关键组件能够通过引入多个query来捕获模态内部的多种相关性;

23.a3:跨膜态交互学习:考虑到文本并不能包含所有的情感信息,并且由于观点词典的局限性,本技术对于情感词的标注工作仅标注了情感词,并未对语气助词、语气副词等同样会对模态表达情感产生影响的词语进行标注,同时无法保证完全覆盖所有的网络新词。因此对于准确的情感分析而言,仅仅使用情感嵌入作为主导来进行模态间的特征学习是不够的。此外,视觉模态和声学模态中蕴含着文本模态所不具有的额外信息,有助于情感信息的学习和提取。考虑到以上几点点,本技术将另外两种模态间的信息也进行引入,以此来补充情感嵌入表示的不足之处;

24.a4:预测层:将得到的特征表示进行拼接,并送入深度神经网络完成最终的预测;

25.s3:实验结构与分析:

26.b1:数据集的统计:选择了三个公共多模态情感分析的数据集来进行实验,mosi,mosei和iemocap;

27.cmu-mosi:该数据集由来自youtube的2199个视频独白片段组成,每个片段均有一个情感强度标签,强度在[-3,+3]范围内,+3为稳固的积极情绪,-3为稳固的消极情绪。此外,该数据集的训练集、测试集和验证集分别包含1284个、229个和686个视频片段;

[0028]

cmu-mosei:该数据集是对cmu-mosi的改进,它的视频片段更多、人物主题等种类更丰富。该数据集包含22856个来自于youtube的视频独白片段,训练集、验证集和测试集分别由16326个、1871个和4659个视频片段组成;

[0029]

iemocap:该数据集包含4453个对话片段,由快乐、愤怒、悲伤、中性等九种情绪类别标记,由于一些情绪标签存在不平衡性,本技术选择采用前四种情绪标签来进行实验。此外,该数据集的训练集、验证集和测试集分别由2717个、798个和938个视频片段组成;

[0030]

b2:baselines:

[0031]

tfn:tfn融合了单模态、双模态和三模态的相互作用,并用笛卡尔积来进行张量融合;

[0032]

lmf:lmf在tfn的基础上进行了改进,利用低秩分解因子来减少多模态张量融合时的计算内存;

[0033]

mult:mult在transformer编码器的基础上利用跨模态注意力模块来进行模态间的信息交互;

[0034]

iccn:iccn将声学模态和视觉模态信息附加在文本模态上,通过探究语言信息和非语言信息的隐藏关系来进行多模态融合;

[0035]

tcsp:tcsp以文本为中心,利用跨模态预测任务来学习模态的共享和私有语义,并融合语义特征来进行多模态情感预测;

[0036]

bimha:bimha探讨了成对模态键的相对重要性和关系,并扩展多头注意力来进行信息增强;

[0037]

hemt:hemt提出了一种基于全息约化表示的方法,该方法是外积模型的压缩版本,以促进跨模态的高阶融合;

[0038]

pmr:pmr在跨模态transformer的基础上引入了一个信息中心来与每种模态进行信息交互,并在重复循环的过程中完成共同信息和模态内部特征的互补,并使用最终生成

的特征进行情感预测;

[0039]

b3:参数设置:本技术使用768维的bert预训练词向量作为文本特征,多头注意力的头数为8,多任务学习的dropout为0.2,预测层的dropout为0.5,对mosi数据集而言,本技术设置数据集的初始学习率为3e-5,批大小为16,文本、声学和视觉模态的隐藏单元数分别为128,16和32,对于mosei而言,数据集的初始学习率为1e-5,批大小为32,文本、声学和视觉模态的隐藏单元数分别为128,32和64,对于iemocap数据集而言,快乐、愤怒、悲伤和中立四种情绪的初始学习率分别为3e-3,4e-4,7e-4和6e-4,批大小均为32,文本、声学和视觉模态的隐藏单元数分别为128,32和16;

[0040]

本技术使用adam优化器进行训练,并使用提前停止策略(early-stopping),本技术使用6个不同的评价指标来评估模型的性能:对于多分类任务,本技术使用二分类准确率(acc-2)、三分类准确率(acc-5)、五分类准确率(acc-7)和f1值(f1-score)作为评价指标,对于回归任务,本技术使用平均绝对误差(mean absolute error-mae)和皮尔逊相关系数(pearson correlation-corr)作为评价指标,除了平均绝对误差之外,所有的评价指标均是数值越高越好;

[0041]

s3:结果分析:

[0042]

c1:模型在cmu-mosi上的实验结果,分析实验结果可以发现,tfn和lmf的性能表现较差,这是由于两种方法没有考虑到模态间有效信息比例的差异性;mult和bimha均注意到模态间交互信息的重要性,并分别结合transformer框架和多头注意力机制来挖掘和捕获模态之间的信息,因此这两种方法较之以往工作在结果上有所提升,但并没有达到预期水平,在这些方法中,表现较为突出的是iccn和pmr,iccn利用文本模态与非文本模态间的隐藏关系来为跨模态融合提供有用指导,pmr则是注意到非对齐多模态数据的异步性,并引入消息中心来辅助多种模态的信息交互过程,尽管两种方法均取得了较好的性能表现,但是由于本技术的方法在考虑到不同模态间互补性和差异性的同时,还注意到了情感资源对于模态融合的重要意义,通过情感知识嵌入的参与提高了模态间的信息融合和提取的效率,因此上述方法在各项评估指标上仍旧逊色于本技术的方法;

[0043]

此外,本技术的模型在分类任务和回归任务上均展现出了极好的性能。对于分类任务,本技术的方法在f1分数和二分类准确率上均达到最优结果,与最好的baseline结果相比,分别提高了0.82%和0.75%。对于回归任务,本技术的模型同样表现出了极其突出的性能,尤其是在相关性(corr)上提高了8.3%,这是显著的改进和提升;

[0044]

c2:模型在cmu-mosei上的实验结果,分别汇报了模型在回归任务和分类任务上的表现,可以注意到,对于回归任务,本技术的方法在平均绝对误差(mae)和相关性(corr)两个回归指标上均展现出了极其突出的性能,与最好的baseline结果相比,分别高出1.3%和7.9%,对于分类任务,本技术的方法也取得了最优结果,相较于最优baseline结果,其f1分数和准确率分别高出0.55%和0.6%,其五分类和七分类准确率分别高出0.51%和0.09%,此外,表现最为不理想的方法是tfn,其各项评估指标均远远低于本技术的方法,尤其是在f1分数和二分类准确率上,本技术的方法分别比tfn高出5.74%和6.28%,这是由于tfn在模态融合时忽略了不同模态的贡献差异;而与本技术的方法最为接近的是iccn和bimha,这两种方法虽然展现出了较好的实验结果,但是在各项评价指标上仍旧逊色于本技术的方法,这可能是由于本技术的方法不仅考虑到了bimha所注重的模态交互信息差异性,同时也

考虑到了iccn所注重的文本信息,此外本技术的方法还使用多任务联合学习框架来提升模型的泛化性,并将情感知识嵌入融入到模态间的特征学习过程中,因此本技术的方法取得了更为优异的表现;

[0045]

c3:模型在iemocap数据集上的结果,方法在angry、sad等偏向于负面的情绪上展现出了较强的竞争力,尤其在angry情绪的二分类准确率和f1分数上分别高出了0.54%和0.24%,这说明相比于其他方法,本技术的方法对于偏向负面的情绪更加敏感,更易感知到负面情绪,而在happy情绪标签下,本技术的方法也取得了第二名的好成绩,虽然iccn和bimha分别在二分类准确率和f1分数上超出了本技术的方法,但是本技术的方法与这两种方法的差距极其细微,本技术认为本技术的方法未达到最优的原因可能是本技术在进行情感词分类预测时,所使用的标签是侧重于粗粒度的情感词汇标签,而非细粒度的情绪标签,因此造成模型对于情感知识的学习不够精准,影响到了后续情绪分类的结果;

[0046]

s4:消融实验:首先,在单峰情感预测任务中,使用文本模态来进行预测的性能远远高于其他两种模态,这可能是由于文本模态是使用大规模语料库学习得到的特征向量,而其他两种模态是通过手动提取得到的,因此文本模态中可能包含有更加丰富的信息,非常适合应用到的特征学习和情感预测任务中;

[0047]

其次,在双峰情感预测任务中,可以得知,在使用声学和视觉模态时,模型的性能会差很多,这证明了使用文本模态的必要性,文本模态比其他模态包含更多的有用信息。

[0048]

与现有技术相比,本发明的有益效果是:

[0049]

1、提出了一种针对非对齐多模态语言序列的基于情感资源的多头注意力增强模型,该模型使用情感嵌入替代文本来来主导跨模态信息融合,据本技术所知,这是首个将情感资源作为主导信息来进行多模态情感分析的模型;

[0050]

2、对文本信息进行情感词标签标注,并设计了一种情感词分类预测任务进行情感知识学习,并探讨了情感嵌入与文本嵌入的关系;

[0051]

3、在cmu-mosi,cmu-mosei和iemocap三个数据集上进行实验,实验表明,相较于现有的多模态情感分析方法,本技术的方法具有明显优势和较好的泛化性。

附图说明

[0052]

图1为本发明多模态情感分析模型原理框图;

[0053]

图2为本发明mansel模型整体架构;

[0054]

图3为本发明多模态情感感知模块原理框图。

[0055]

图中:1、单一模态特征提取层模块;2、单一模态特征深度提取层模块;21、情感资源的获取与表达模块;22、单峰语言特征学习模块;3、跨模态交互学习层模块;31、多模态情感感知模块;32、视觉模态学习模块;33、听觉模态学习模块;4、预测层模块。

具体实施方式

[0056]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0057]

请参阅图1-3,本发明提供一种技术方案:融合情感资源的多模态情感分析模型,包括:

[0058]

用来进行文本、视觉与听觉模态特征初步提取的单一模态特征提取层模块1;

[0059]

利用transformer捕捉模态内部的动力,并设计情感词分类预测任务进行情感嵌入学习和提取的单一模态特征深度提取层模块2;

[0060]

利用情感嵌入来完成多模态特征交互学习,使得其他模态特征能够感知文本中情感信息的跨模态交互学习层模块3;

[0061]

将前三层学习到的情感特征表示最终输入深度神经网络完成最终预测任务的预测层模块4。

[0062]

单一特征深度提取层模块2包括以观点词典为依据获取情感资源对资源进行分类然后通过公式进行分析并将情感词分类预测的情感资源的获取与表达模块21与可捕获单一模态长距离中相互依赖特征的单峰语言特征学习模块22。

[0063]

跨模态交互学习层模块3包括用情感嵌入代替文本特征的多模态情感感知模块31、利用视觉模块进行模态间学习情感特征的视觉模态学习模块32与利用听觉模块进行模态间学习情感特征的听觉模态学习模块33。

[0064]

多模态情感分析方法包括如下步骤:

[0065]

s1:单一模态特征提取:

[0066]

对于给定的话语,通常包含文本、视觉与听觉三种模态话语,对于文本模态,考虑到大型预训语音模型bert具有强大语言表征能力与特征提取能力,使用bert进行初始特征提取,对于声学模态和视觉模态,考虑到模态内部的上下相关性和时序性,本技术使用bi-lstm来进行特征提取;

[0067]

使用公式:

[0068]ht

=bert(x

t

;θ

t

)#(1)

[0069]

ha=bilstm(xa;θa)#(2)

[0070]hv

=bilstm(xv;θv)#(3)

[0071]

表示bi-lstm最终隐藏层的输出结果,为bert最后一层第一个单词向量的输出结果。d

t

、da和dv分别表示文本、声学和视觉特征向量的维度,θ

t

表示bert的可学习参数,θa和θv分别表示用于声学和视觉特征向量提取的lstm的可学习参数;

[0072]

s2:深度特征提取:

[0073]

a1:情感资源的获取与表达:除了传统的多模态情感分析普遍采用的文本、视觉和声学三个模态之外,本技术认为情感词也可以为特征学习提供更加精确的识别方向,通过对情感知识的学习,初始文本特征向量能够学习到自身所包含的情感词信息,从而使得其富含更加明确的语义信息以及更少的噪声干扰;

[0074]

本技术选择以刘冰观点词典为情感资源的主要依据,为实验数据集的文本模态进行情感词标签标注,刘冰观点词典中列举了正面和负面两类英文情感词,并且包含了拼写错误、俚语变形等非正常情感词,因此本技术根据观点词典对原始文本中的情感词和非情感词的位置进行标注,并在短句末尾填充0字符以保证标签长度的一致性;

[0075]

此外,本技术设计了用于情感词预测的分类辅助任务。为了确保能够有效地将情感信息融合至高维度的特征表示中,本技术选择在遵循非线性的基础上进行特征压缩,确保情感特征值在0~1之间,符合概率规律,达到降低信息损失的目的;

[0076]

如公式(4)-(6)所示,将文本特征h

t

放入全连接层进行维度统一,并将全连接层捕获到的特征表示h进行平方求和,随后使用非线性函数对其进行特征压缩,从而确保短向量收缩到几乎零长度,而长向量收缩到略低于1的长度;

[0077]

h=w

sht

+bs#(4)

[0078][0079][0080]

其中ws和bs分别为全连接层的权重和偏置,全连接层的输出结果为h平方求和后的特征向量表示为t={ti:1≤i≤l},ti表示第i个单词hi平方求和后的输出结果,ds表示特征向量h的维度,l表示序列长度,表示最终学习到的情感特征向量,||

·

||表示范数;

[0081]

将学习到的情感特征向量es送入到情感词分类预测层,获得对情感词位置的最终预测结果如公式(7)所示,其中w

sent

和b

sent

分别为该层的权重和偏置;

[0082][0083]

a2:单峰语言特征学习:transformer改进了rnn训练慢的特点,并且可以提高计算的并行性,非常适合用于非对齐模态的特征学习,在自然语言处理领域发挥着举足轻重的作用,因此为了捕获单一模态长距离中相互依赖的特征,从上下文表示中提取到更加丰富的语义信息,本技术没有选择基于rnn的结构来捕获模态序列信息,而是选择采用基于transformer的结构分别生成每个模态的序列特征,此外,与单头注意力机制不同,多头自注意力机制作为transformer的关键组件能够通过引入多个query来捕获模态内部的多种相关性;

[0084]

具体如公式(8)-(13)所示。

[0085][0086][0087][0088]

[0089][0090]em

=multiheadattention(qm,km,vm)=concat(head1,...,headh)

·

wo#(13)

[0091]

其中,模态m∈{l,v,a},l,v,a分别表示文本模态、视觉模态和声学模态,和分别表示模态m在注意力机制的第i个头headi上学习到的向量query,key和value,且的向量query,key和value,且和均为可学习投影矩阵,qi,ki,vi分别表示headi上的query,key和value,dq=dk=dv=dm/h,h为头数,concat(

·

)为串联操作;

[0092]

a3:跨膜态交互学习:在以往多模态情感分析工作中,情感嵌入是作为文本模态、视觉模态和声学模态的融合过程中的辅助信息。但本技术认为,文本在经过浅层情感知识学习后可以降低自身非情感特征所带来的干扰,由此得来的情感嵌入含有更多的语义信息,更加适合代替文本进行模态间的特征学习。因此在跨模态交互学习层,本技术设计了用于跨模态特征融合的多模态情感感知模块。

[0093]

多模态情感感知模块的结构如图2所示,本技术在情感嵌入的特征空间下,使用跨模态多头注意力机制来引导声学和视觉特征,以此使得情感信息能够在跨模态交互学习的过程中得到感知和表达。本技术令f∈{sa,sv},则跨模态多头注意力机制公式如下所示:

[0094][0095][0096]

其中,和均为可学习投影矩阵,dq=dk=dv=ds/h,h为头数,1≤i≤h,concat(

·

)为串联操作,sa,sv分别表示情感嵌入-声学模态和情感嵌入-视觉模态,ef表示多模态情感感知模块的输出,

[0097]

此外,考虑到文本并不能包含所有的情感信息,并且由于观点词典的局限性,本技术对于情感词的标注工作仅标注了情感词,并未对语气助词、语气副词等同样会对模态表达情感产生影响的词语进行标注,同时无法保证完全覆盖所有的网络新词。因此对于准确的情感分析而言,仅仅使用情感嵌入作为主导来进行模态间的特征学习是不够的。此外,视觉模态和声学模态中蕴含着文本模态所不具有的额外信息,有助于情感信息的学习和提取。考虑到以上几点点,本技术将另外两种模态间的信息也进行引入,以此来补充情感嵌入表示的不足之处;

[0098]eat

=multiheadattention(q

at

,k

at

,v

at

)#(16)

[0099]evt

=multiheadattention(q

vt

,k

vt

,v

vt

)#(17)

[0100]eo

=concat(e

sa

,e

sv

,e

at

,e

vt

)#(18)

[0101]

其中eo为跨模态交互学习层的最终输出,e

at

和e

vt

为声学模态-文本模态和视觉模态-文本模态的跨模态多头注意力表示,concat(

·

)为串联操作。

[0102]

a4:预测层:将得到的特征表示进行拼接,并送入深度神经网络完成最终的预测;本技术将得到的特征表示进行拼接,并送入深度神经网络完成最终的预测任务,如公式(19)-(20)所示,hfusion为预测层的输入特征,为最终的预测结果:

[0103]

hfusion=concat(eo,e

t

)#(19)

[0104][0105]

此外,在模型训练时,本技术选择使用回归损失函数l1loss进行训练,训练损失由两部分组成,如公式(21)所示:

[0106][0107]

s3:实验结构与分析:

[0108]

b1:数据集的统计:选择了三个公共多模态情感分析的数据集来进行实验,mosi,mosei和iemocap;

[0109]

数据集的基本统计信息如表1所示。

[0110]

表1 mosi,mosei和iemocap的数据集统计

[0111][0112]

cmu-mosi:该数据集由来自youtube的2199个视频独白片段组成,每个片段均有一个情感强度标签,强度在[-3,+3]范围内,+3为稳固的积极情绪,-3为稳固的消极情绪。此外,该数据集的训练集、测试集和验证集分别包含1284个、229个和686个视频片段;

[0113]

cmu-mosei:该数据集是对cmu-mosi的改进,它的视频片段更多、人物主题等种类更丰富。该数据集包含22856个来自于youtube的视频独白片段,训练集、验证集和测试集分别由16326个、1871个和4659个视频片段组成;

[0114]

iemocap:该数据集包含4453个对话片段,由快乐、愤怒、悲伤、中性等九种情绪类别标记,由于一些情绪标签存在不平衡性,本技术选择采用前四种情绪标签来进行实验。此外,该数据集的训练集、验证集和测试集分别由2717个、798个和938个视频片段组成;

[0115]

b2:baselines:

[0116]

tfn:tfn融合了单模态、双模态和三模态的相互作用,并用笛卡尔积来进行张量融合;

[0117]

lmf:lmf在tfn的基础上进行了改进,利用低秩分解因子来减少多模态张量融合时的计算内存;

[0118]

mult:mult在transformer编码器的基础上利用跨模态注意力模块来进行模态间的信息交互;

[0119]

iccn:iccn将声学模态和视觉模态信息附加在文本模态上,通过探究语言信息和非语言信息的隐藏关系来进行多模态融合;

[0120]

tcsp:tcsp以文本为中心,利用跨模态预测任务来学习模态的共享和私有语义,并融合语义特征来进行多模态情感预测;

[0121]

bimha:bimha探讨了成对模态键的相对重要性和关系,并扩展多头注意力来进行信息增强;

[0122]

hemt:hemt提出了一种基于全息约化表示的方法,该方法是外积模型的压缩版本,以促进跨模态的高阶融合;

[0123]

pmr:pmr在跨模态transformer的基础上引入了一个信息中心来与每种模态进行信息交互,并在重复循环的过程中完成共同信息和模态内部特征的互补,并使用最终生成的特征进行情感预测;

[0124]

b3:参数设置:本技术使用768维的bert预训练词向量作为文本特征,多头注意力的头数为8,多任务学习的dropout为0.2,预测层的dropout为0.5,对mosi数据集而言,本技术设置数据集的初始学习率为3e-5,批大小为16,文本、声学和视觉模态的隐藏单元数分别为128,16和32,对于mosei而言,数据集的初始学习率为1e-5,批大小为32,文本、声学和视觉模态的隐藏单元数分别为128,32和64,对于iemocap数据集而言,快乐、愤怒、悲伤和中立四种情绪的初始学习率分别为3e-3,4e-4,7e-4和6e-4,批大小均为32,文本、声学和视觉模态的隐藏单元数分别为128,32和16;

[0125]

本技术使用adam优化器进行训练,并使用提前停止策略(early-stopping),本技术使用6个不同的评价指标来评估模型的性能:对于多分类任务,本技术使用二分类准确率(acc-2)、三分类准确率(acc-5)、五分类准确率(acc-7)和f1值(f1-score)作为评价指标,对于回归任务,本技术使用平均绝对误差(meanabsolute error-mae)和皮尔逊相关系数(pearsoncorrelation-corr)作为评价指标,除了平均绝对误差之外,所有的评价指标均是数值越高越好;

[0126]

s3:结果分析:

[0127]

c1:模型在cmu-mosi上的实验结果,分析实验结果可以发现,tfn和lmf的性能表现较差,这是由于两种方法没有考虑到模态间有效信息比例的差异性;mult和bimha均注意到模态间交互信息的重要性,并分别结合transformer框架和多头注意力机制来挖掘和捕获模态之间的信息,因此这两种方法较之以往工作在结果上有所提升,但并没有达到预期水平,在这些方法中,表现较为突出的是iccn和pmr,iccn利用文本模态与非文本模态间的隐藏关系来为跨模态融合提供有用指导,pmr则是注意到非对齐多模态数据的异步性,并引入消息中心来辅助多种模态的信息交互过程,尽管两种方法均取得了较好的性能表现,但是由于本技术的方法在考虑到不同模态间互补性和差异性的同时,还注意到了情感资源对于模态融合的重要意义,通过情感知识嵌入的参与提高了模态间的信息融合和提取的效率,因此上述方法在各项评估指标上仍旧逊色于本技术的方法;

[0128]

此外,本技术的模型在分类任务和回归任务上均展现出了极好的性能。对于分类任务,本技术的方法在f1分数和二分类准确率上均达到最优结果,与最好的baseline结果

相比,分别提高了0.82%和0.75%。对于回归任务,本技术的模型同样表现出了极其突出的性能,尤其是在相关性(corr)上提高了8.3%,这是显著的改进和提升;

[0129]

表2 cmu-mosi上的实验结果(

↑

表示该指标数值越高越好,

↓

表示该指标数值越低越好)

[0130][0131][0132]

表2展示了模型在cmu-mosi上的实验结果。从表中可以看出,本技术的方法在所有指标上均优于其他模型;

[0133]

c2:模型在cmu-mosei上的实验结果,分别汇报了模型在回归任务和分类任务上的表现,可以注意到,对于回归任务,本技术的方法在平均绝对误差(mae)和相关性(corr)两个回归指标上均展现出了极其突出的性能,与最好的baseline结果相比,分别高出1.3%和7.9%,对于分类任务,本技术的方法也取得了最优结果,相较于最优baseline结果,其f1分数和准确率分别高出0.55%和0.6%,其五分类和七分类准确率分别高出0.51%和0.09%,此外,表现最为不理想的方法是tfn,其各项评估指标均远远低于本技术的方法,尤其是在f1分数和二分类准确率上,本技术的方法分别比tfn高出5.74%和6.28%,这是由于tfn在模态融合时忽略了不同模态的贡献差异;而与本技术的方法最为接近的是iccn和bimha,这两种方法虽然展现出了较好的实验结果,但是在各项评价指标上仍旧逊色于本技术的方法,这可能是由于本技术的方法不仅考虑到了bimha所注重的模态交互信息差异性,同时也考虑到了iccn所注重的文本信息,此外本技术的方法还使用多任务联合学习框架来提升模型的泛化性,并将情感知识嵌入融入到模态间的特征学习过程中,因此本技术的方法取得了更为优异的表现;

[0134]

表3 cmu-mosei上的实验结果(

↑

表示该指标数值越高越好,

↓

表示该指标数值越低越好)

[0135][0136]

c3:模型在iemocap数据集上的结果,方法在angry、sad等偏向于负面的情绪上展现出了较强的竞争力,尤其在angry情绪的二分类准确率和f1分数上分别高出了0.54%和0.24%,这说明相比于其他方法,本技术的方法对于偏向负面的情绪更加敏感,更易感知到负面情绪,而在happy情绪标签下,本技术的方法也取得了第二名的好成绩,虽然iccn和bimha分别在二分类准确率和f1分数上超出了本技术的方法,但是本技术的方法与这两种方法的差距极其细微,本技术认为本技术的方法未达到最优的原因可能是本技术在进行情感词分类预测时,所使用的标签是侧重于粗粒度的情感词汇标签,而非细粒度的情绪标签,因此造成模型对于情感知识的学习不够精准,影响到了后续情绪分类的结果;

[0137]

表4 iemocap上的实验结果(

↑

表示该指标数值越高越好,

↓

表示该指标数值越低越好)

[0138][0139][0140]

表4展示了模型在iemocap数据集上的结果。除了tcsp、hemt没有在该数据集上的实验结果,也没有公开实现细节无法给出结果外,本技术对比了在前两个数据集上的其他现有方法,最好的前两种结果分别用加粗和来表示。从表4可以看出,本技术的方法在所有性能指标上均为前两名,总体性能明显优于其他方法;

[0141]

s4:消融实验:为了验证模型的有效性,本技术进行了从两个方面进行了实验。一方面探究了不同模态组合的贡献,如表5所示。另一个方面探究了不同模块组合的贡献,如表6所示;

[0142]

首先,在单峰情感预测任务中,使用文本模态来进行预测的性能远远高于其他两种模态,这可能是由于文本模态是使用大规模语料库学习得到的特征向量,而其他两种模

态是通过手动提取得到的,因此文本模态中可能包含有更加丰富的信息,非常适合应用到的特征学习和情感预测任务中;

[0143]

表5不同模态组合的实验结果(

↑

表示该指标数值越高越好,

↓

表示该指标数值越低越好)

[0144][0145][0146]

其次,在双峰情感预测任务中,可以得知,在使用声学和视觉模态时,模型的性能会差很多,这证明了使用文本模态的必要性,文本模态比其他模态包含更多的有用信息;

[0147]

表6不同模块组合的实验结果。(最高的实验结果为加粗数据。”w/o u”表示没有使用单一模态深度特征提取层。”w/o e”表示情感嵌入提取层被废除。”w/o n”表示没有使用多模态情感感知层。)

[0148][0149]

总结:考虑到情感知识可以为情感判断提供依据,本技术提出了一种基于注意力的多模态情感资源感知模型,并设计了词级分类预测任务捕获情感嵌入表示,并用其替代文本模态来指导跨模态间的融合,本技术在cmu-mosi、cmu-mosei以及iemocap三个公开数据集上进行了广泛实验,结果表明,本技术的模型是有效的,其性能优于现有模型。

[0150]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

- 该技术已申请专利。仅供学习研究,如用于商业用途,请联系技术所有人。

- 技术研发人员:彭俊杰 李爱国 李松 李璐

- 技术所有人:徐州达希能源技术有限公司

- 我是此专利的发明人

- 上一篇:一种新式撒粉机的制作方法

- 上一篇:疲劳驾驶提醒装置及系统

- 该领域下的技术专家

- 如您需求助技术专家,请点此查看客服电话进行咨询。

- 1、李老师:1.计算力学 2.无损检测

- 2、毕老师:机构动力学与控制

- 3、袁老师:1.计算机视觉 2.无线网络及物联网

- 4、王老师:1.计算机网络安全 2.计算机仿真技术

- 5、王老师:1.网络安全;物联网安全 、大数据安全 2.安全态势感知、舆情分析和控制 3.区块链及应用

- 如您是高校老师,可以点此联系我们加入专家库。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1

精彩留言,会给你点赞!

专利分类正在加载中....