开放环境中行为演化的时空融合推理与终身认知学习方法

1.本发明属于人工智能机器人技术领域,具体涉及一种开放环境中行为演化的时空融合推理与终身认知学习方法。

背景技术:

2.近年来,人工智能(ai)在围棋、自动驾驶等诸多与环境实时交互中学习解决复杂问题能力的应用中,以及在机器人跳跃和抓握等技能的自主学习方面,得到了广泛的研究。神经科学指出,智能的本质体现在:一是适应环境的学习能力;二是对未知变化的认知预判性。为了使人工智能及机器人系统能够成功地在现实世界中运作并适应,依赖于层级化的认知机制,包括组合式抽象(compositional abstraction) 和预测处理(predictive processing)。

3.可持续终身学习在开放环境下存在着双重困难,即如何彻底探索稀疏的环境并抽象成可执行任务,以及如何评估当前状态转移的可信度。进化生物学表明,生物智能体先进的解决问题技能的发展,是一个在漫长演化过程中不断整合认知机制进而适应环境、提高技能的过程,以此获得了适应性和终身学习的智能动作模式。人类解决复杂问题认知任务时,首先凭直觉回溯大容量的记忆,基于时间证据将先前学习到的经验进行缜密推理。因此人类对不断变化的环境的适应能力仍然比许多ai系统要强大。研究结果表明,很多现有的基于强化学习的方法,试图进行零样本问题解决和迁移学习,目前只适用于与之前的任务相同或者相近的任务,或是在简单生成域中的任务,但始终缺乏一个针对开放性环境的统一认知架构来整合所有能够生成环境适应性动作的演化机制。

技术实现要素:

4.本发明是为解决上述问题而进行的,目的在于提供一种学习开放环境中行为演化的时空融合推理与终身认知架构以及基于该统一认知架构的终身认知学习方法,针对连续学习问题中难以从过往经验中提炼适应变化环境的可资借鉴的信息,提出了协同场景迁移、类比推理及分层决策的模型框架,降低了学习方案中对经验信息的大规模存储要求,能够平稳持续的适应环境变化。本研究方案采用理论算法设计与实物仿真系统验证相结合,提供了一个新的综合视角,构建开放环境下的终身认知学习,能够集大成地形成统一地架构来完成对环境快速有效地适应,引导受更复杂的认知结构启发的层级化机器学习架构,进一步可将其应用到诸如机器人之间协作、自博弈动作学习、自适应动态场景、自动驾驶、智能无人系统等典型应用领域。

5.本发明采用了如下技术方案:

6.本发明提供了一种开放环境中行为演化的时空融合推理与终身认知学习方法,其特征在于,包括以下步骤:

7.步骤s1,系统中的各个智能体通过其计算机视觉装置对开放环境进行实时性观测,基于实时性观测结果及半马尔可夫决策模型得到累积奖励动作库,并对该累积奖励动

作库进行蒙特卡罗采样,得到观测-动作历史序列;

8.步骤s2,在预定时刻,所述智能体将所述实时性观测结果与所述观测-动作历史序列进行回放得到历史动作-观测经验序列,并基于该序列生成围绕所述开放环境中目标的时空融合视角的n步联合系统级策略,其中,所述历史动作-观测经验序列包含有所述开放环境的条件随机场的置信度;

9.步骤s3,各个所述智能体实时评估所述条件随机场的置信分布水平,并基于该置信分布水平调整其自主学习的自由度;

10.步骤s4,各个所述智能体在其自主学习过程中,提取置信度及奖励高于预定值的动作模式,将该动作模式映射到所述开放环境中的任务,在所述智能体的联合空间内,基于所述条件随机场构建层级主导联合策略;

11.步骤s5,重复步骤s1~s4,基于所述联合系统级策略和所述层级主导联合策略推理出不同层次间的内在动机驱动,并构造当前所述开放环境下所述系统的最优联合策略。

12.本发明提供的开放环境中行为演化的时空融合推理与终身认知学习方法,还可以具有这样的技术特征,其中,步骤s1中,利用半马尔可夫决策过程进行建模,所述半马尔可夫决策模型的六元组表示为其中,s为环境状态空间;a为动作空间;为

……

,依赖于历史序列ω产生外部系统级策略其中(ω

×a→

[0,1])(ω

→

[0,1]),初始集内部任务级策略π依赖于当前状态(s

×a→

[0,1])(s

→

[0,1]),β是t=t

terminal

或时的终止条件;为状态转移概率矩阵;为即时奖励函数;γ∈[0,1]为折扣因子。

[0013]

本发明提供的开放环境中行为演化的时空融合推理与终身认知学习方法,还可以具有这样的技术特征,其中,步骤s2包括以下子步骤:

[0014]

步骤s2-1,在时刻t,基于概率推理的局部视角状态so、自身观测的分布式联合视角状态s

sg

、过去经验的高级表征的稳定回放视角状态s

er

确定所述开放环境下的可观测状态;

[0015]

步骤s2-2,提取0~t时刻内的所述观测-动作历史序列,记为:

[0016][0017]

式中,是将o(s,a)中状态i

→

j的采样序列进行提取整合;

[0018]

步骤s2-3,对0~t时刻的观测-动作历史序列进行重放,在重放阶段时刻c,通过重放所述经验动作库结合局部观测效用函数所述经验动作库结合局部观测效用函数得到历史动作-观测经验序列,记为:

[0019][0020]

式中,置信度

[0021]

步骤s2-4,建立马尔可夫蒙特卡罗链,在其达到平稳分布后进行多次随机游走,从而生成围绕所述开放环境中目标的时空融合视角的 n步联合系统级策略:

[0022][0023]

本发明提供的开放环境中行为演化的时空融合推理与终身认知学习方法,还可以具有这样的技术特征,其中,步骤s3包括以下子步骤:

[0024]

步骤s3-1,基于实时观测的状态变化与所述联合系统级策略定义所述智能体自主学习的自由度:

[0025][0026]

式中,ai→j为用于演化的可学习参数;

[0027]

步骤s3-2,根据所述条件随机场的状态转移概率来定义所述观测

ꢀ‑

动作历史序列的置信度b,使得每个动作的预期回报不受所述开放环境中噪声的影响,该置信度b通过不断实时观测所述开放环境进行迭代,与不同层次的最佳响应相匹配,构建非先验的完美贝叶斯条件;

[0028]

步骤s3-3,以回归模型来校准所述联合系统级策略的置信区间,所述联合系统级策略的条件分布概率表示为:

[0029][0030]

式中,t

l

是结合风险激活下的联合优势策略的转移概率分布而得出的置信比例因子,通过调节t

l

相应降低未知风险下的条件分布概率

[0031]

本发明提供的开放环境中行为演化的时空融合推理与终身认知学习方法,还可以具有这样的技术特征,其中,步骤s3-1中,可学习参数ai→j的迭代更新过程表示为:

[0032][0033]

式中,∑i的求和是遍历所有共享观测中的可类比参照物,∑g的求和是将所有可能

的有限联合系统级策略都依次过滤。

[0034]

本发明提供的开放环境中行为演化的时空融合推理与终身认知学习方法,还可以具有这样的技术特征,其中,步骤s4包括以下子步骤:

[0035]

步骤s4-1,设计可调因子根据不同动作带来的效用函数分辨的难易程度给对应的联合系统级策略添加不同权重;

[0036]

步骤s4-2,使用随机梯度上升法设计用于评估期望回报的指标,并利用该指标更新所述联合优势策略的参数,从而最大化最佳响应动作出现的概率,其中,所述联合优势策略的梯度表示为:

[0037][0038]

式中,θ是遍历了所有动作与状态空间的策略参数;

[0039]

步骤s4-3,在若干个所述智能体的联合空间(u

t

|τ

t

)内,基于实时观测的所述条件随机场分布构建层级主导联合策略,

[0040]

当动作观测历史不在当前所述观测-动作历史序列中可检索时,即时,更新低层任务级策略记为:

[0041][0042]

式中,δ为步骤s3-2中的

[0043]

当t≤t且时,将任务切割成k阶子任务并分别提取其优势函数,选取当前能获得最大即时奖励的动作序列来更新高层任务级策略,记为:

[0044]

πh(u

t

|τ

t

)=argmaxk[ak(s,uk∣τ

t

,u

t

),k]。

[0045]

本发明提供的开放环境中行为演化的时空融合推理与终身认知学习方法,还可以具有这样的技术特征,其中,步骤s5中,基于所述联合系统级策略和所述层级主导联合策略推理得到所述最优联合策略表示为:

[0046][0047]

式中,第一项是通过实时观测开放环境得到的潜在状态置信特征,用于刻画实时观测序列对不同层级的响应动作的概率分布,

[0048]

第二项是建立在不同风险认知条件下的转移高斯核函数,利用跨层级的响应动作与置信区间将风险系数整合进所述联合优势策略中,微调推理出更新即时战略与自由度,从而实现长期稳定认知的自主学习模式。

[0049]

发明作用与效果

[0050]

根据本发明的开放环境中行为演化的时空融合推理与终身认知学习方法,构建了“多目标全局感知、多维度决策部署”的可演绎终身学习架构,提高了智能机器人对未知场景的风险探索与认知的效率。本方案提供了一个新的范式,利用跨层级的最佳响应动作与条件随机场置信区间来促进自主学习的有效性,构造与组合抽象相对应的可演绎的推理框架,并以此定义自主学习的自由度与系统迭代动量,通过简单子任务的高回报逐渐形成层级化的适应当前环境的联合动作策略。进一步在开放系统进行挑战式环境任务的动态模拟调整,设计逐步增长的复杂化环境的机制,使得智能体通过学习和进化形成可持续的终身学习能力。

附图说明

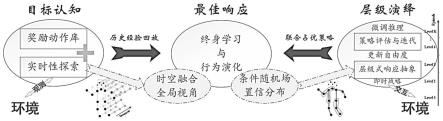

[0051]

图1是本发明实施例中开放环境中行为演化的时空融合推理与终身认知学习方法的原理图;

[0052]

图2是本发明实施例中开放环境中行为演化的时空融合推理与终身认知学习方法的流程图;

[0053]

图3是本发明实施例中智能机器人的结构示意图。

具体实施方式

[0054]

为了使本发明实现的技术手段、创作特征、达成目的与功效易于明白了解,以下结合实施例及附图对本发明的基于通用认知架构的开放环境中行为演化学习方法作具体阐述。

[0055]

除非另有定义,本文所使用的所有的技术和科学术语与属于本发明的技术领域的技术人员通常理解的含义相同。本文在本发明的说明书中所使用的优选实施例只是描述性的,不是限定性的,不能以此限定本发明的保护范围。

[0056]

《实施例》

[0057]

图3是本实施例中智能机器人的结构示意图。

[0058]

如图3所示,本实施例中,选用jetson nano系统平台下智能机器人组装套件作为模型训练和微调推理的示例应用场景,开放环境为设置有多处障碍物及目标物的房间,该智能机器人事先没有该房间的信息。

[0059]

该智能机器人具有稳定的低延迟系统,支持多个传感器接入,共用一套麦克纳姆轮全向底盘。全向底盘主要由底盘主体、四个麦克纳姆轮、和底盘运动控制器组成,配合图传系统(其包含雷达或摄像头等计算机视觉装置)提供第一人称视角以实现自主行进控制。全向底盘上方配备升降灵活的可伸缩环抱式夹爪和云台发射器,云台发射器可准确、稳定、连续地发射红外光束,根据红外光束实现导航,能够在实现智能避障及环境感知的同时,高性能舵机的驱动夹爪进行抓取或定位动作。

[0060]

本实施例中,智能机器人为三个,均具有自主学习模块,自主学习任务为学习到如何实现智能避障、定位并抓取预定目标物,目标物分别为具有心形图案的卡片(卡纸片状)、长方体纸箱(规则物体)、塑料水瓶(不规则物体)。将目标物的图片输入自主学习模块。这三个可自主学习的智能机器人即构成终身认知学习架构(或称系统)。

[0061]

图1、图2分别是本实施例中开放环境中行为演化的时空融合推理与终身认知学习方法的原理图和流程图。

[0062]

如图1-2所示,本实施例的开放环境中行为演化的时空融合推理与终身认知学习方法具体包括如下步骤:

[0063]

步骤s1,机会式探索:

[0064]

系统中的各个智能体通过其计算机视觉装置对开放环境进行实时性观测,基于实时性观测结果及半马尔可夫决策模型得到累积奖励动作库,并对累积奖励动作库进行蒙特卡罗采样,得到观测-动作历史序列。

[0065]

具体地,利用半马尔可夫决策过程对智能体的动作及任务进行建模,该模型的六元组可表示为其中s为环境状态空间;a为动作空间;为options,多次和环境交互后(一系列的actions) 后,状态才会发生变化,一般将这一系列action视为一个option,依赖于历史序列ω产生外部系统级策略其中(ω

×a→

[0,1])(ω

→

[0,1]),初始集内部任务级策略π依赖于当前状态(s

×a→

[0,1])(s

→

[0,1]),β是t=t

terminal

或时的终止条件;表示状态转移概率矩阵;代表即时奖励函数;γ∈[0,1]表示折扣因子。

[0066]

在实时性观测中,根据计算机视觉装置实时获得的影像,基于上述模型及特征提取算法得到实时观测o(s,a),并通过外部系统级策略μ得到累积奖励生成奖励动作库,再对其进行蒙特卡罗采样,得到观测-动作历史序列。

[0067]

步骤s2,记忆性回放:

[0068]

在预定时刻,智能体将实时性观测结果与观测-动作历史序列进行回放,从而形成对当前开放环境的目标感知并生成围绕目标的时空融合视角的n步联合系统级策略。

[0069]

其中,目标即为观测到需要采取动作的环境客体,本实施例中,目标包括环境中的目标物及障碍物。目标感知过程就是通过动作是否得到奖励来判断对应位置是否存在目标物/障碍物。

[0070]

步骤s2包括如下子步骤:

[0071]

步骤s2-1,将开放环境下的可观测状态分为三类。

[0072]

在任意时刻t,开放环境下的可观测状态为确定性的知识或统计概率,不需要进一步的探索,只需要概率推理的局部视角状态so;基于自身观测的分布式联合视角状态s

sg

;以及与新学习内容相似的旧记忆,或过去经验的高级表征的稳定回放视角状态s

er

。

[0073]

步骤s2-2,提取0~t时刻内的观测-动作历史序列,记为:

[0074][0075]

式中,是将o(s,a)中状态i

→

j的采样序列进行提取整合。

[0076]

步骤s2-3,对0~t时刻的观测-动作历史序列进行重放(回放),在重放阶段时刻c,通过偶发重放经验动作库结合局部观测效用函数得到历史动作-观测经验序列,记为:

[0077][0078]

式中,置信度即,根据开放环境的条件随机场转移概率分布进入下一个状态s

t+1

(s

t+1

∈s)。

[0079]

步骤s2-4,建立马尔可夫蒙特卡罗链(mcmc)用于求得在n步内得到下一状态的条件随机场转移概率分布在其达到平稳分布后一次随机游走等同于吉布斯抽样的高维分布采样,以此生成围绕开放环境中目标的时空融合视角的n步联合系统级策略,记为:

[0080][0081]

对于一个严格意义上的遍历过程,不可约、非周期且正常返的马尔可夫链,有唯一平稳分布存在,并且转移概率的极限分布是马尔可夫链的平稳分布。在这个条件下,提出n步非周期性马尔可夫蒙特卡罗转移概率分布条件,作为组成非平稳环境遍历随机过程的必要条件。

[0082]

通过建立随机条件场转移概率分布使得可学习的经验a

t

(s,u

t

|τ

t

)能够结合累积回报的置信度从而生成非平稳条件下的合适响应通过求取不同层级维度的状态转移概率分布,可以预计的是,马尔可夫蒙特卡罗链达到平稳后的一次随机游走等同于吉布斯抽样的高维分布采样。

[0083]

步骤s3,评估自由度:

[0084]

各个智能体实时评估条件随机场的置信分布水平,并基于此调整其自主学习的自由度。通过即时战略将探索开放环境中的目标这一学习任务分解成多个小任务并逐一予以强化,并通过不同层级间的、条件反射式的动作组合,逐步完成学习任务。

[0085]

步骤s3具体包括如下子步骤:

[0086]

步骤s3-1,基于实时观测的状态变化与系统的联合系统级策略定义智能体自主学习的自由度。

[0087]

为了加速适应外部的复杂环境,个体所能学习的自由度依赖于观测的状态变化学习与系统的联合系统级策略因此,该机制的自主学习的自由度记为:

[0088][0089]

其中,ai→j为用于演化的可学习参数,给定紧空间内任意输入,且zi→j=xiw

ij

+b

ij

,其中和分别为k阶处的可训练的逐元素加权和偏置参数。

[0090]

可加速的学习参数ai→j的迭代更新过程为:

[0091][0092]

式中,∑i的求和是遍历所有共享观测中的可类比参照物,而∑g是将所有可能的有限联合系统级策略都依次过滤。这种并行的梯度更新策略,是通过探索高维度的策略梯度方向而实现的,因此对前向和后向传播的时间复杂性没有影响。

[0093]

本实施例中,如上所述,系统包括三个可自主学习的智能机器人,该系统具有对外执行的策略,系统内部还有针对每一个子任务/子步骤的序贯策略。

[0094]

步骤s3-2,根据条件随机场状态转移概率来定义观测-动作历史序列的置信度b,使得每个动作的预期回报不受开放环境中噪声的影响,该置信度通过不断实时观测开放环境进行迭代,与不同层次的最佳响应相匹配,构建非先验的完美贝叶斯条件。

[0095]

具体地,置信度b的迭代公式为:

[0096][0097]

其中,pr可表示为:

[0098][0099]

步骤s3-3,进一步地,针对开放环境,以回归模型来校准联合系统级策略的置信区间。

[0100]

时空融合策略的条件分布概率可表示为:

[0101][0102]

其中,t

l

是结合风险激活下的联合优势策略的转移概率分布而得出的置信比例因

子,由上式可以直观地看到,通常未知风险具有高度不确定性,通过t

l

可相应降低该未知风险下的时空融合策略的条件分布概率进而完善适应环境的适应性动作配置。

[0103]

步骤s4,组合式抽象:

[0104]

各智能体在其自主学习过程中,提取具有高置信度、高奖励的动作模式,并将其映射到开放环境中的具体任务,完成基于半马尔可夫决策模型的相关学习任务。

[0105]

步骤s4包括如下子步骤:

[0106]

步骤s4-1,为了提高未知环境的适应性,设计可调因子1,为了提高未知环境的适应性,设计可调因子根据不同动作带来的效用函数分辨的难易程度给对应的联合系统级策略添加不同权重,有效增加置信度很高的联合优势策略在随机采样的比重,从而使得高层级策略收益具有更高的稳定可信度。

[0107]

本实施例中,智能机器人对当前开放环境中的物体进行定位,并定位该物体的实时距离,根据实时观测改变可调因子并建立自主学习认知,从而学会控制机械臂及夹爪的开合程度来完成抓取不同物体的迁移任务。

[0108]

步骤s4-2,使用随机梯度上升法设计用于评估期望回报的指标,并利用该指标更新策略参数,从而最大化最佳响应动作出现的概率。

[0109]

具体地,根据sutton给出的遍历状态分布的折现因子假设d

π

(s),则联合优势策略梯度表征如下:

[0110][0111]

其中,θ是遍历了所有动作与状态空间的策略参数,即,其中,θ是遍历了所有动作与状态空间的策略参数,即,如果大于零,意味着未知环境风险的变化的方向会增加当前联合优势策略在当前状态的概率,如果回报是具有边际递增效益的,梯度更新的幅度越大,当前的最佳响应动作出现的概率增加得也就越大。

[0112]

步骤s4-3,在多个智能体的联合空间(u

t

|τ

t

)内,基于实时观测的条件随机场分布构建层级主导联合策略。

[0113]

具体地,当动作观测历史不在当前实时观测序列(即上述观测-动作历史序列)中可检索时的策略为低层任务级策略,即,当时,智能机器人无法从实时观测到的目标匹配到历史经验动作库中的固有模式,则更新低层任务级策略记为:

[0114][0115]

式中,δ为步骤s3-2中的

[0116]

当t≤t且时,意味着智能机器人在满足当前风险认知后,将任务切割成k阶子任务并分别提取其优势函数,选取当前能获得最大即时奖励的动作序列来更新高层任务级策略,记为:

[0117]

πh(u

t

|τ

t

)=argmaxk[ak(s,uk∣τ

t

,u

t

),k]

[0118]

步骤s5,构造开放环境中动态交互与微调推理的动作演化:

[0119]

各个智能体通过与外部开放环境的协同互动,从认知的角度建立高层次经验和高效探索机制(即重复上述步骤s1~s4),并基于此推理出不同层次间的内在动机驱动并构造当前环境下获得稳定收益的最优联合策略。也即,基于步骤s2得到的联合系统级策略以及步骤 s4得到的层级主导联合策略进行推理,得到系统中多个智能体的最优联合策略。

[0120]

采用二元均衡势函数来整合可演绎的终身学习认知框架。基于步骤s2-4中的吉布斯分布的可数条件随机场转移矩阵,可以将每个t时刻在局部观测下的高阶占优策略(即上述更新后的高层任务级策略) 的映射并求得当前层级组合的微调推理响应,表示为:

[0121][0122]

其中,第一项是通过机会式探索开放环境得到的潜在状态置信特征,用于刻画观测序列对不同层级的响应动作的概率分布;而第二项则是建立在不同风险认知的条件下的转移高斯核函数,利用跨层级的响应动作与置信区间将风险系数整合进联合优势策略中,微调推理出更新即时战略与自由度,从而实现长期稳定认知的自主学习模式。

[0123]

本实施例中,三个智能机器人基于上述方法进行自主终身认知学习,在初始状态时,三个智能机器人随机设置位置,中心处的一个智能机器人随机游走,两边的两个智能机器人通过红外激光实时检测其与中心处智能机器人的相对距离,并利用其麦克纳姆轮转向、移动,三个智能机器人形成相对v字型。

[0124]

进一步地,随着三个智能机器人不断调整其位置及朝向,另外两个智能机器人也加入随机游走之后,利用历史动作库能够快速定位中心点的位置并形成全局的时空视角,逐渐以中心处机器人的相对位置自发形成多样化的定格动作,例如形成圆圈阵列和人字形阵列。

[0125]

本实施例中,通过自主学习,智能机器人能够定位开放环境中的障碍物及目标物的位置,并设计最短路径通过其麦克纳姆轮向目标物靠近,再控制其机械臂及夹爪的开合角度及转向角度,从而抓取上述目标物,经测试,对三种目标物(带图案的卡纸片状、规则物体、不规则物体)均能实现很好的定位及抓取。

[0126]

实施例作用与效果

[0127]

根据本实施例提供的开放环境中行为演化的时空融合推理与终身认知学习方法,智能体能够根据对未知场景的风险探索与认知,高效地优化层级化的动作响应与置信区间,并以此配置联合优势策略的转移概率分布,达到适应环境的效果。通过持续地自主学习适应环境的过程中,以最大似然估计法在梯度方向上估计多变量高斯核,即,被采用的组合式联合策略的风险置信度越高,则该条件下的整体期望奖励也能够在环境中获得稳定高收益。以此增加对当前高层级的联合优势策略组合在当前环境风险下的相关性采样,优化组

合配置使之可行、有效。

[0128]

因此,实施例所的学习开放环境中行为演化的时空融合推理与终身认知架构,有效构建了“多目标全局感知、多维度决策部署”的可演绎终身学习架构,提高了智能机器人对未知场景的风险探索与认知的效率。本实施例提供了一个新的范式,利用跨层级的最佳响应动作与条件随机场置信区间来促进自主学习的有效性,构造与组合抽象相对应的可演绎的推理框架,并以此定义自主学习的自由度与系统迭代动量,通过简单子任务的高回报逐渐形成层级化的适应当前环境的联合动作策略。进一步在开放系统进行挑战式环境任务的动态模拟调整,设计逐步增长的复杂化环境的机制,使得智能体通过学习和进化形成可持续的终身学习能力。证明了在开放环境的随机稀疏奖励反馈下,推理微调联合策略和终身认知学习范式之间的内在量化,从而使其在人工智能机器人领域产生影响。

[0129]

上述实施例仅用于举例说明本发明的具体实施方式,而本发明不限于上述实施例的描述范围。

[0130]

在上述实施例中,本发明的方法应用于多个智能机器人定位目标、抓取目标的任务,实际上本发明的方法也可以应用于其他智能体的其他任务,例如多个工业智能机器人之间的协作、智能汽车的自动驾驶等。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1