基于联邦学习的注意力机制聚合优化系统

1.本发明属于计算机领域,涉及基于联邦学习的注意力机制聚合优化系统。

背景技术:

2.在通信领域,大数据技术对海量用户数据进行采集、分析和处理,在客户需求分析、用户行为预测等方面发挥着越来越重要的作用。但是通信“大数据”由众多个体用户数据聚合而成,必然伴随着个体用户数据本地化、离散化现象。如果仅使用本地离散数据训练学习并获取信息,容易导致得到过拟合的结果;而将网络中的离散数据整合形成“大数据”训练学习,却不可避免地会遇到个人隐私安全问题。为了保护个人隐私,网络中的用户往往不愿意将自己的数据与他人共享,这为大数据技术在通信领域的进一步应用带来了数据孤岛和隐私保护的瓶颈。

3.谷歌科学家brendan mcmahan在2016年提出了一个新的机器学习范式:联邦学习(federated learning,fl)。与传统集中式学习相比,联邦学习提出了一种去中心化的思路,私有数据只能在每个本地客户端上进行交流,没有客户端之间的数据共享。它实际上是一种分布式的训练方式,可以使得个体用户在不共享数据集的基础上,通过共享模型参数比如梯度参数,进行协同训练的机器学习方式。这种方式可以有效解决目前集中式训练造成的隐私泄露问题。

4.目前联邦学习的相关研究尚处于起步阶段,重点在数据的分布式处理方案。2016年brendan mcmahan等人首次提出了一种基于迭代的联邦平均算法(federated averaging algorithm,fedavg),使用随机梯度下降的加权平均训练数据,在客户端本地训练更新模型参数,将共享模型集中发送到服务器端进行聚合更新。2020年h.wang等人提出了联邦匹配平均算法(federated matched averaging algorithm,fedma),算法核心在于客户端的网络中可能包含相似的神经元,可以非参数的形式聚集在一起,使用同一簇中所有神经元的平均值来产生全局神经元。这种匹配平均将相似研究对象划分为一组进行训练,能够有效的减少训练过程的通信成本,提高总体的模型精度,但是,fedavg并未考虑客户数据不同的特征分布,存在次优解的局限,而fedma匹配平均的方式更加剧了通信过程中数据的不平衡问题。2021年s.ek等人提出了联邦距离算法(federated distance algorithm,feddist)。feddist借鉴了fedma中的分组思想,通过计算客户端中相似单元之间的欧氏距离进行相似性分组,能够将训练环境中的不平衡数据进行归一化预处理,可以减少通信的总体成本,提高模型精度。

5.联邦学习的分布式训练方式使得设备之间以高度不一致的方式产生和收集数据,而客户端与服务器端不直接交流具体数据,交流的是模型参数比如梯度参数等。这种情况往往会导致网络中存在大量的异构数据,使得训练过程复杂化。

6.在数据科学领域,主要采用两种代表性方法解决数据不平衡问题:(1)重采样方法:采样方法和混合策略等。(2)多分类器集成方法:集成学习,成本敏感学习、决策阈值调整等。已有方案在解决数据不平衡问题中,存在两个主要难点(1)如何保持数据分布结构和

重要的样本信息。(2)如何解决边界过拟合问题,进而提高模型的泛化能力。因而,这些已有方案在fl网络中是否适用还有待进一步验证。

技术实现要素:

7.有鉴于此,本发明的目的在于提供基于联邦学习的注意力机制聚合优化系统。

8.为达到上述目的,本发明提供如下技术方案:

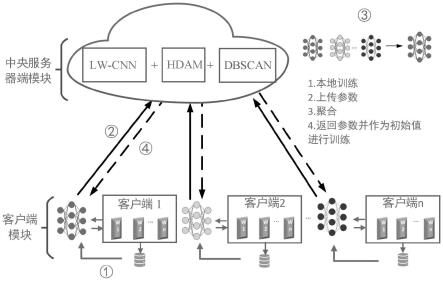

9.基于联邦学习的注意力机制聚合优化系统,由中央服务器模块和客户端模块构成;

10.其中中央服务器模块包括lw-cnn、hdam、dbscan三个部分;

11.客户端模块和中央服务器模块构成amaop模块;

12.amaop中:首先在客户端模块处输入参与训练的k个用户的数据模型参数,客户端模块通过使用客户更新函数client pdate(k,w

t

)对于模型进行本地训练生成共享模型;客户端再将训练好的模型上传至中央服务器端的优化函数serveroptimization处进行统一聚合训练;共享模型分别通过中央服务器端的lw-cnn、hdam和dbscan模块进行参数的迭代更新;更新后的模型参数将会被发送回客户端作为下一轮的初始参数参与联邦学习的训练流程中;

13.lw-cnn中:首先通过一维卷积层对于输入的一维数据进行卷积操作,输入为196个卷积核,输出为16个卷积核,并且在一维卷积层中使用的激活函数为relu函数;然后通过一维最大池化层,其中池化窗口的大小pool_size为4;然后通过卷平层实现将多维输入一维化,实现从卷积层到全连接层的过渡,并且卷平层不会影响实验批处理的大小;最后通过两层全连接层和dropout层,其中第一层全连接层使用relu作为激活函数,第二层全连接层使用softmax作为激活函数;全连接层在整个网络中起到了特征提取的作用,能够将输入的特征表示映射到样本的标记空间;使用两层的全连接层,一层作为输入层,一层作为输出层,其中输入层输入1024个神经元;在两层全连接层中间加入一层dropout层能够防止网络过拟合,并且能够提升模型的泛化能力;

14.hdam包括深度可分离卷积模块和注意力机制模块;其中深度可分离卷积模块由下采样和深度可分离卷积组成,深度可分离卷积包括逐点卷积和深度卷积;注意力机制模块由通道注意力模块、空间注意力模块、上采样组成;输入的模块先通过下采样操作,后通过深度可分离卷积提取特征;下采样操作是深度神经网络中常用于增加感受野并减少计算量的方法;深度可分离卷积分为逐点卷积和深度卷积,深度卷积用来处理长宽方向的空间信息,逐点卷积用来处理通道方向的信息;

15.通道注意力模块获取不同通道在总体模型中所占的权重,增强具体特征之间的表达;首先对于输入的模型参数特征w使用最大池化和平均池化操作提取权重,再将权重值送入共享mlp多层感知中,得到两个不同的描述符:w

max

和w

avg

;将这两个特征值进行特征相加后输入到sigmoid激活函数中生成通道注意力特征wc;最后将最初的模型参数特征w与得到的通道注意力特征wc进行特征相乘,得到通道注意力模块输出的模型参数特征w’;用公式表示如下:

16.w

max

=mlp(maxpool(w))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

17.w

avg

=mlp(avgpool(w))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

18.wc=w

max

+w

avg

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

19.w

′

=σ(wc)*w

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

20.其中w

max

表示为最大池化后进行mlp后的特征,w

avg

表示平均池化后进行mlp后的特征,wc表示将两个输出特征进行加权后得到的特征,w表示最初输入的模型参数特征,w’表示最终通过通道注意力模块后输出的模型参数特征;

21.空间注意力模块用于获取多维空间位置信息,突出模型关键特征的位置,增强模型特征的表达能力;在空间注意力模块中,首先输入通道注意力模块训练后的模型参数特征w’,进行最大池化和平均池化提取权重信息,得到两个新的特征;使用3*3的深度可分离卷积将这两个特征值进行拼接,并使用sigmoid激活函数得到空间注意力特征;最后将最初的模型参数特征w’与得到的空间注意力特征进行特征相乘,得到空间注意力模块输出的模型参数特征;用公式表示如下:

22.w

′

max

=maxpool(w)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

23.w

′

avg

=avgpool(w

′

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

24.ws=f[w

max

,w

avg

]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0025]w″

=σ(ws)*w

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(8)

[0026]

其中w

′

max

表示为经过最大池化后的模型参数特征,w

′

avg

表示为经过平均池化后的模型参数特征,f[w

′

max

,w

′

avg

]表示为将这两个特征进行深度卷积操作拼接,ws表示为经过激活函数后的模型参数特征,w”表示为最后通过空间注意力模块后输出的模型参数特征。

[0027]

本发明的有益效果在于:本发明将具有不同权重的数据模型进行相似性分组聚合的方式,能够改进联邦学习中的数据不平衡问题,提高总体的联邦训练精度。

[0028]

本发明的其他优点、目标和特征在某种程度上将在随后的说明书中进行阐述,并且在某种程度上,基于对下文的考察研究对本领域技术人员而言将是显而易见的,或者可以从本发明的实践中得到教导。本发明的目标和其他优点可以通过下面的说明书来实现和获得。

附图说明

[0029]

为了使本发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明作优选的详细描述,其中:

[0030]

图1为amaop完整迭代结构框图;

[0031]

图2为lw-cnn结构框图;

[0032]

图3为hdam总体架构;

[0033]

图4为通道注意力模块的总体示意图;

[0034]

图5为空间注意力模块的总体示意图;

[0035]

图6为feddist算法和amaop算法的模型精度;(a)为feddist的模型精度;(b)为amaop的模型精度;

[0036]

图7为feddist算法和amaop算法的模型损失;(a)为feddist的模型损失;(b)为amaop的模型损失;

[0037]

图8为feddist算法和amaop算法客户端达到最佳精度的收敛速度;(a)为feddist的收敛速度;(b)为amaop的收敛速度。

具体实施方式

[0038]

以下通过特定的具体实例说明本发明的实施方式,本领域技术人员可由本说明书所揭露的内容轻易地了解本发明的其他优点与功效。本发明还可以通过另外不同的具体实施方式加以实施或应用,本说明书中的各项细节也可以基于不同观点与应用,在没有背离本发明的精神下进行各种修饰或改变。需要说明的是,以下实施例中所提供的图示仅以示意方式说明本发明的基本构想,在不冲突的情况下,以下实施例及实施例中的特征可以相互组合。

[0039]

其中,附图仅用于示例性说明,表示的仅是示意图,而非实物图,不能理解为对本发明的限制;为了更好地说明本发明的实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;对本领域技术人员来说,附图中某些公知结构及其说明可能省略是可以理解的。

[0040]

本发明实施例的附图中相同或相似的标号对应相同或相似的部件;在本发明的描述中,需要理解的是,若有术语“上”、“下”、“左”、“右”、“前”、“后”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此附图中描述位置关系的用语仅用于示例性说明,不能理解为对本发明的限制,对于本领域的普通技术人员而言,可以根据具体情况理解上述术语的具体含义。

[0041]

图1为所提amaop算法完整迭代结构。amaop主要由中央服务器模块和客户端模块构成。其中中央服务器模块主要包括lw-cnn、hdam、dbscan三个部分。客户端模块和中央服务器模块构成了amaop模块。amaop大体流程为:首先在客户端模块处输入参与训练的k个用户的数据模型参数,客户端模块通过使用客户更新函数client pdate(k,w

t

)对于模型进行本地训练生成共享模型。客户端再将训练好的模型上传至中央服务器端的优化函数serveroptimization处进行统一聚合训练。共享模型分别通过中央服务器端的lw-cnn、hdam和dbscan模块进行参数的迭代更新。更新后的模型参数将会被发送回客户端作为下一轮的初始参数参与联邦学习的训练流程中。

[0042]

图2为lw-cnn结构框图。首先通过一维卷积层对于输入的一维数据进行卷积操作,输入为196个卷积核,输出为16个卷积核,并且在一维卷积层中使用的激活函数为relu函数。然后通过一维最大池化层,其中池化窗口的大小pool_size为4。然后通过卷平层实现将多维输入一维化,实现从卷积层到全连接层的过渡,并且卷平层不会影响实验批处理的大小。最后通过两层全连接层和dropout层,其中第一层全连接层使用relu作为激活函数,第二层全连接层使用softmax作为激活函数。全连接层在整个网络中起到了特征提取的作用,能够将输入的特征表示映射到样本的标记空间。使用两层的全连接层,一层作为输入层,一层作为输出层,其中输入层输入1024个神经元。在两层全连接层中间加入一层dropout层能够防止网络过拟合,并且能够提升模型的泛化能力。

[0043]

图3为本发明所提出的hdam架构,主要包括深度可分离卷积模块和注意力机制模块。其中深度可分离卷积模块由下采样和深度可分离卷积组成,深度可分离卷积包括逐点卷积和深度卷积。注意力机制模块由通道注意力模块、空间注意力模块、上采样组成。输入的模块先通过下采样操作,后通过深度可分离卷积提取特征。下采样操作是深度神经网络中常用于增加感受野并减少计算量的方法。深度可分离卷积分为逐点卷积和深度卷积,深

度卷积用来处理长宽方向的空间信息,逐点卷积用来处理通道方向的信息。

[0044]

图4为hdam的通道注意力子模块。通道注意力模块可以获取不同通道在总体模型中所占的权重,增强具体特征之间的表达。首先对于输入的模型参数特征w使用最大池化和平均池化操作提取权重,再将权重值送入共享mlp多层感知中,得到两个不同的描述符:w

max

和w

avg

。将这两个特征值进行特征相加后输入到sigmoid激活函数中生成通道注意力特征wc。最后将最初的模型参数特征w与得到的通道注意力特征wc进行特征相乘,得到通道注意力模块输出的模型参数特征w’。用公式表示如下:

[0045]wmax

=mlp(maxpool(w))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0046]wavg

=mlp(avgpool(w))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0047]

wc=w

max

+w

avg

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0048]w′

=σ(wc)*w

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0049]

其中w

max

表示为最大池化后进行mlp后的特征,w

avg

表示平均池化后进行mlp后的特征,wc表示将两个输出特征进行加权后得到的特征,w表示最初输入的模型参数特征,w’表示最终通过通道注意力模块后输出的模型参数特征。

[0050]

图5为hdam的空间注意力子模块。空间注意力模块主要用于获取多维空间位置信息,突出模型关键特征的位置,能够增强模型特征的表达能力。在空间注意力模块中,首先输入通道注意力模块训练后的模型参数特征w’,进行最大池化和平均池化提取权重信息,得到两个新的特征。使用3*3的深度可分离卷积将这两个特征值进行拼接,并使用sigmoid激活函数得到空间注意力特征。最后将最初的模型参数特征w’与得到的空间注意力特征进行特征相乘,得到空间注意力模块输出的模型参数特征。用公式表示如下:

[0051]w′

max

=maxpool(w

′

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0052]w′

avg

=avgpool(w)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0053]ws

=f[w

max

,w

avg

]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0054]w″

=σ(ws)*w

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(8)

[0055]

其中w

′

max

表示为经过最大池化后的模型参数特征,w

′

avg

表示为经过平均池化后的模型参数特征,f[w

′

max

,w

′

avg

]表示为将这两个特征进行深度卷积操作拼接,ws表示为经过激活函数后的模型参数特征,w”表示为最后通过空间注意力模块后输出的模型参数特征。

[0056]

图6为基于模型精度的对比。(a)为feddist的模型精度;(b)为amaop的模型精度;两种算法所训练出的模型精度都是随着训练回合的增加接近最佳收敛,而达到最佳精度值。其中本文所提出的amaop达到最佳模型精度的变化速度大于feddist算法,并且最终达到的最佳精度也优于feddist算法。

[0057]

图7为基于模型损失的对比。(a)为feddist的模型损失;(b)为amaop的模型损失;两种算法所训练出的模型损失都是随着训练回合的增加而收敛,达到最低模型损失。其中本文所提出的amaop达到最低模型损失的变化速度快于feddist算法。

[0058]

以客户端和服务器端的训练中得到的欧式距离作为最佳精度的收敛速度,图8的对比图可以看出客户端训练收敛的速度与模型精度成正比的关系。(a)为feddist的收敛速度;(b)为amaop的收敛速度。相比于feddist,本文所提出的amaop能够在更短的通信回合中达到最佳收敛。

[0059]

本文使用f-score分数和浮点运算次数flops衡量模型精度及计算复杂度。表1给

出了客户端最佳精度及时间复杂度的对比情况。

[0060]

表1客户端最佳精度及计算复杂度

[0061][0062]

作为参照的feddist的客户端在第97轮的通信回合达到最佳精度96.31%,相比于fedavg有0.19%的性能提升。而amaop的客户端在第99轮的通信回合达到最佳精度97.06%,在feddist的基础上优化了0.75%。本文所提的amaop模型的flops为17.73m,作为参考的基准算法feddist和fedavg的计算复杂度分别为17.61m,17.54m。综上,amaop在牺牲一定时间复杂度的基础上能够有效地提升模型的性能。

[0063]

最后说明的是,以上实施例仅用以说明本发明的技术方案而非限制,尽管参照较佳实施例对本发明进行了详细说明,本领域的普通技术人员应当理解,可以对本发明的技术方案进行修改或者等同替换,而不脱离本技术方案的宗旨和范围,其均应涵盖在本发明的权利要求范围当中。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1